Que sont les performances du modèle Python ROC et AUC

Texte

ROC L'analyse et l'aire sous la courbe (AUC) sont des outils largement utilisés en science des données, empruntés au traitement du signal, pour évaluer la qualité des modèles sous différents paramétrages, ou pour comparer deux ou performances. de plusieurs modèles. ROC 分析和曲线下面积 (AUC) 是数据科学中广泛使用的工具,借鉴了信号处理,用于评估不同参数化下模型的质量,或比较两个或多个模型的性能。

传统的性能指标,如准确率和召回率,在很大程度上依赖于正样本的观察。因此,ROC 和 AUC 使用真阳性率和假阳性率来评估质量,同时考虑到正面和负面观察结果。

从分解问题到使用机器学习解决问题的过程有多个步骤。它涉及数据收集、清理和特征工程、构建模型,最后是,评估模型性能。

当您评估模型的质量时,通常会使用精度和召回率等指标,也分别称为数据挖掘领域的置信度和灵敏度。

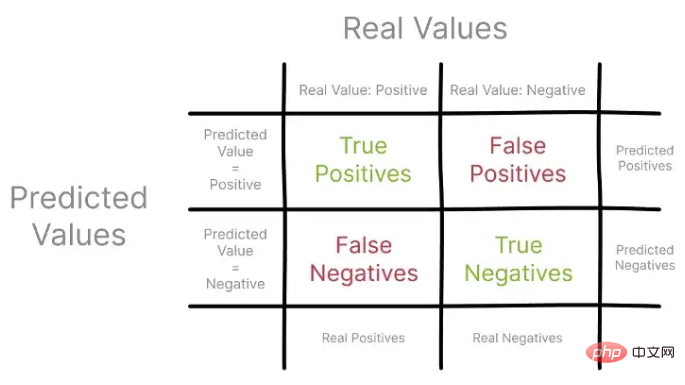

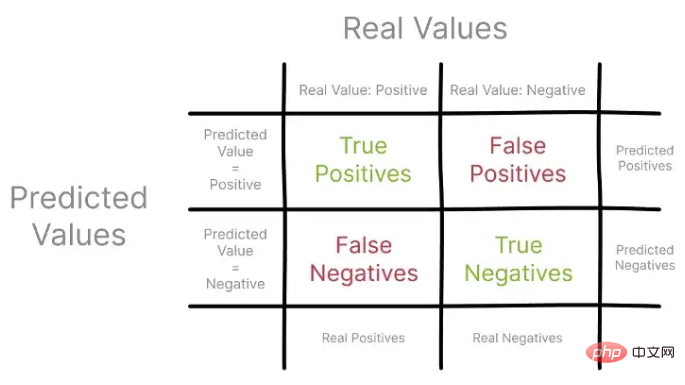

这些指标将预测值与通常来自保留集的实际观察值进行比较,使用混淆矩阵进行可视化。

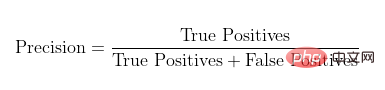

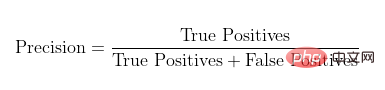

让我们首先关注精度,也称为阳性预测值。使用混淆矩阵,您可以将 Precision 构建为所有真实阳性与所有预测阳性的比率。

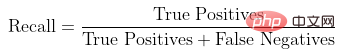

召回率,也称为真阳性率,表示真阳性与观察到的和预测的所有阳性的比率。

使用混淆矩阵中的不同观察集来描述 Precision 和 Recall

Voyons d'abord Concentrez-vous sur la précision, également appelée valeur prédictive positive. À l’aide d’une matrice de confusion, vous pouvez construire la précision comme le rapport de tous les vrais positifs à tous les positifs prédits.

Voyons d'abord Concentrez-vous sur la précision, également appelée valeur prédictive positive. À l’aide d’une matrice de confusion, vous pouvez construire la précision comme le rapport de tous les vrais positifs à tous les positifs prédits.

Taux de rappel, Également connu sous le nom de taux de vrais positifs, il représente le rapport entre les vrais positifs et tous les positifs observés et prédits.

Utiliser la matrice de confusion En décrivant les différents ensembles d'observations dans Precision et Recall, vous pouvez commencer à comprendre comment ces métriques fournissent une vue des performances du modèle.

Il convient de noter que la précision et le rappel se concentrent uniquement sur des exemples et des prédictions positifs, sans prendre en compte les exemples négatifs. De plus, ils ne comparent pas les performances du modèle au scénario médian, qui n’est qu’une estimation aléatoire.

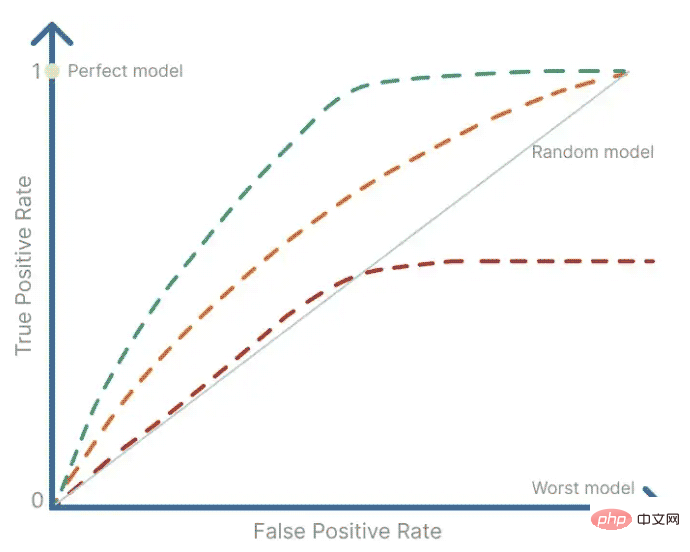

1. Courbe ROC

ROC sert d'outil récapitulatif pour visualiser le compromis entre précision et rappel. L'analyse ROC utilise une courbe ROC pour déterminer dans quelle mesure la valeur d'un signal binaire est contaminée par le bruit, c'est-à-dire le caractère aléatoire. Il fournit un résumé de la sensibilité et de la spécificité d'un prédicteur continu sur une gamme de points de fonctionnement. La courbe ROC est obtenue en traçant le taux de faux positifs sur l’axe des x par rapport au taux de vrais positifs sur l’axe des y.

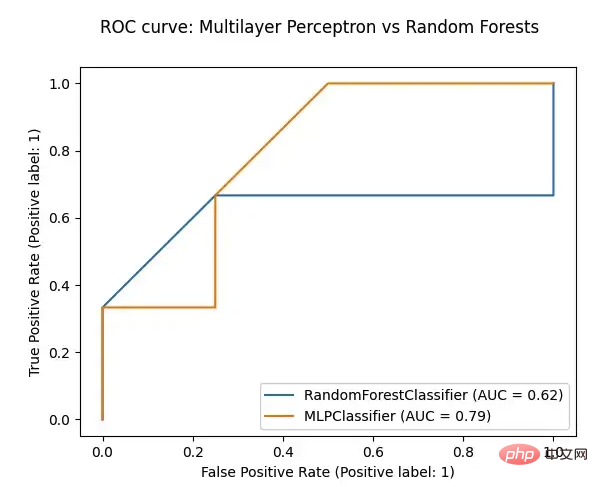

import matplotlib.pyplot as plt

from sklearn.ensemble import RandomForestClassifier

from sklearn.metrics import roc_auc_score, RocCurveDisplay

def plot_roc(model, test_features, test_targets):

"""

Plotting the ROC curve for a given Model and the ROC curve for a Random Forests Models

"""

# comparing the given model with a Random Forests model

random_forests_model = RandomForestClassifier(random_state=42)

random_forests_model.fit(train_features, train_targets)

rfc_disp = RocCurveDisplay.from_estimator(random_forests_model, test_features, test_targets)

model_disp = RocCurveDisplay.from_estimator(model, test_features, test_targets, ax=rfc_disp.ax_)

model_disp.figure_.suptitle("ROC curve: Multilayer Perceptron vs Random Forests")

plt.show()

# using perceptron model as input

plot_roc(ml_percetron_model, test_features, test_targets)Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1207

1207

24

24

PHP et Python: différents paradigmes expliqués

Apr 18, 2025 am 12:26 AM

PHP et Python: différents paradigmes expliqués

Apr 18, 2025 am 12:26 AM

PHP est principalement la programmation procédurale, mais prend également en charge la programmation orientée objet (POO); Python prend en charge une variété de paradigmes, y compris la POO, la programmation fonctionnelle et procédurale. PHP convient au développement Web, et Python convient à une variété d'applications telles que l'analyse des données et l'apprentissage automatique.

Choisir entre PHP et Python: un guide

Apr 18, 2025 am 12:24 AM

Choisir entre PHP et Python: un guide

Apr 18, 2025 am 12:24 AM

PHP convient au développement Web et au prototypage rapide, et Python convient à la science des données et à l'apprentissage automatique. 1.Php est utilisé pour le développement Web dynamique, avec une syntaxe simple et adapté pour un développement rapide. 2. Python a une syntaxe concise, convient à plusieurs champs et a un écosystème de bibliothèque solide.

Python vs JavaScript: la courbe d'apprentissage et la facilité d'utilisation

Apr 16, 2025 am 12:12 AM

Python vs JavaScript: la courbe d'apprentissage et la facilité d'utilisation

Apr 16, 2025 am 12:12 AM

Python convient plus aux débutants, avec une courbe d'apprentissage en douceur et une syntaxe concise; JavaScript convient au développement frontal, avec une courbe d'apprentissage abrupte et une syntaxe flexible. 1. La syntaxe Python est intuitive et adaptée à la science des données et au développement back-end. 2. JavaScript est flexible et largement utilisé dans la programmation frontale et côté serveur.

Le code Visual Studio peut-il être utilisé dans Python

Apr 15, 2025 pm 08:18 PM

Le code Visual Studio peut-il être utilisé dans Python

Apr 15, 2025 pm 08:18 PM

VS Code peut être utilisé pour écrire Python et fournit de nombreuses fonctionnalités qui en font un outil idéal pour développer des applications Python. Il permet aux utilisateurs de: installer des extensions Python pour obtenir des fonctions telles que la réalisation du code, la mise en évidence de la syntaxe et le débogage. Utilisez le débogueur pour suivre le code étape par étape, trouver et corriger les erreurs. Intégrez Git pour le contrôle de version. Utilisez des outils de mise en forme de code pour maintenir la cohérence du code. Utilisez l'outil de liaison pour repérer les problèmes potentiels à l'avance.

L'extension VScode est-elle malveillante?

Apr 15, 2025 pm 07:57 PM

L'extension VScode est-elle malveillante?

Apr 15, 2025 pm 07:57 PM

Les extensions de code vs posent des risques malveillants, tels que la cachette de code malveillant, l'exploitation des vulnérabilités et la masturbation comme des extensions légitimes. Les méthodes pour identifier les extensions malveillantes comprennent: la vérification des éditeurs, la lecture des commentaires, la vérification du code et l'installation avec prudence. Les mesures de sécurité comprennent également: la sensibilisation à la sécurité, les bonnes habitudes, les mises à jour régulières et les logiciels antivirus.

PHP et Python: une plongée profonde dans leur histoire

Apr 18, 2025 am 12:25 AM

PHP et Python: une plongée profonde dans leur histoire

Apr 18, 2025 am 12:25 AM

PHP est originaire en 1994 et a été développé par Rasmuslerdorf. Il a été utilisé à l'origine pour suivre les visiteurs du site Web et a progressivement évolué en un langage de script côté serveur et a été largement utilisé dans le développement Web. Python a été développé par Guidovan Rossum à la fin des années 1980 et a été publié pour la première fois en 1991. Il met l'accent sur la lisibilité et la simplicité du code, et convient à l'informatique scientifique, à l'analyse des données et à d'autres domaines.

Peut-on exécuter le code sous Windows 8

Apr 15, 2025 pm 07:24 PM

Peut-on exécuter le code sous Windows 8

Apr 15, 2025 pm 07:24 PM

VS Code peut fonctionner sur Windows 8, mais l'expérience peut ne pas être excellente. Assurez-vous d'abord que le système a été mis à jour sur le dernier correctif, puis téléchargez le package d'installation VS Code qui correspond à l'architecture du système et l'installez comme invité. Après l'installation, sachez que certaines extensions peuvent être incompatibles avec Windows 8 et doivent rechercher des extensions alternatives ou utiliser de nouveaux systèmes Windows dans une machine virtuelle. Installez les extensions nécessaires pour vérifier si elles fonctionnent correctement. Bien que le code VS soit possible sur Windows 8, il est recommandé de passer à un système Windows plus récent pour une meilleure expérience de développement et une meilleure sécurité.

Comment exécuter des programmes dans Terminal Vscode

Apr 15, 2025 pm 06:42 PM

Comment exécuter des programmes dans Terminal Vscode

Apr 15, 2025 pm 06:42 PM

Dans VS Code, vous pouvez exécuter le programme dans le terminal via les étapes suivantes: Préparez le code et ouvrez le terminal intégré pour vous assurer que le répertoire de code est cohérent avec le répertoire de travail du terminal. Sélectionnez la commande Run en fonction du langage de programmation (tel que Python de Python your_file_name.py) pour vérifier s'il s'exécute avec succès et résoudre les erreurs. Utilisez le débogueur pour améliorer l'efficacité du débogage.