Périphériques technologiques

Périphériques technologiques

IA

IA

NVIDIA lance le GPU dédié ChatGPT, augmentant la vitesse d'inférence de 10 fois

NVIDIA lance le GPU dédié ChatGPT, augmentant la vitesse d'inférence de 10 fois

NVIDIA lance le GPU dédié ChatGPT, augmentant la vitesse d'inférence de 10 fois

Il était une fois, l'intelligence artificielle est entrée dans un goulot d'étranglement qui a duré des décennies en raison d'une puissance de calcul insuffisante, et le GPU a déclenché l'apprentissage profond. À l'ère de ChatGPT, l'IA est à nouveau confrontée au problème de la puissance de calcul insuffisante en raison des grands modèles. Existe-t-il un moyen pour NVIDIA de le faire cette fois-ci ?

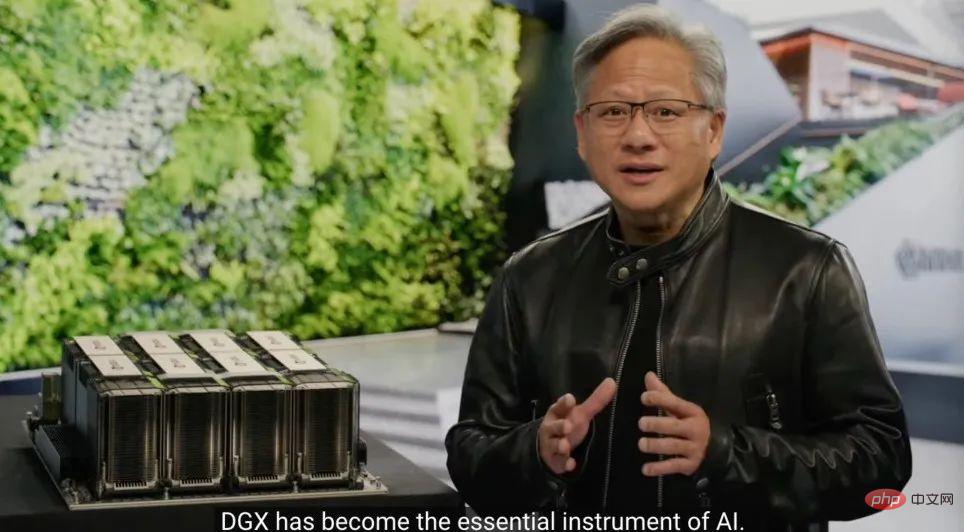

Le 22 mars, la conférence GTC a eu lieu officiellement lors de la Keynote qui vient de se tenir, le PDG de NVIDIA, Jensen Huang, a sorti les puces préparées pour ChatGPT.

"Accélérer l'informatique n'est pas facile. En 2012, le modèle de vision par ordinateur AlexNet utilisait GeForce GTX 580 et pouvait traiter 262 PetaFLOPS par seconde. Ce modèle a déclenché une révolution dans l'IA technologie Explosion", a déclaré Huang. "Dix ans plus tard, Transformer est apparu. GPT-3 a utilisé 323 ZettaFLOPS de puissance de calcul, 1 million de fois celle d'AlexNet, pour créer ChatGPT, une IA qui a choqué le monde. Une nouvelle plate-forme informatique est apparue et l'ère de l'IA sur iPhone est arrivée. ”

Le boom de l'IA a fait grimper le cours de l'action de Nvidia de 77 % cette année. est de 6 400 milliards, soit près de cinq fois celui d'Intel. Cependant, la sortie d’aujourd’hui nous indique que Nvidia ne s’est pas encore arrêté.

Concevoir une puissance de calcul dédiée pour l'AIGC

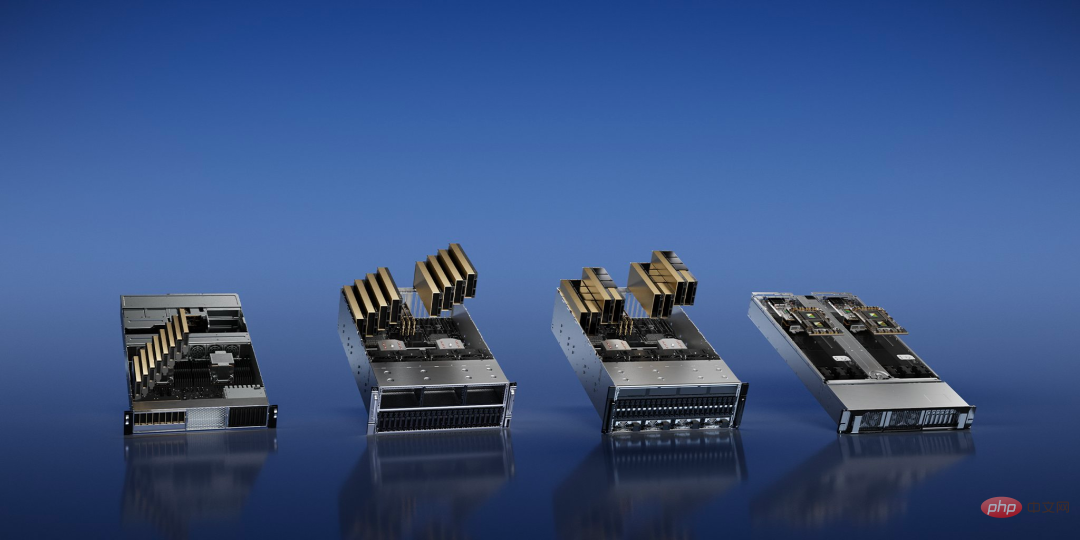

Le développement de l'IA générative (AIGC) change les besoins des entreprises technologiques en matière de puissance de calcul, NVIDIA une fois de plus, quatre plates-formes d'inférence pour les tâches d'IA sont présentées, qui utilisent toutes une architecture unifiée.

Parmi eux, NVIDIA L4 offre « des performances vidéo pilotées par l'IA 120 fois supérieures à celles du processeur, et 99 % de moins » L'« efficacité » énergétique peut être utilisée pour le streaming vidéo, l'encodage et le décodage, ainsi que pour la génération de vidéos AI ; le NVIDIA L40 avec une puissance de calcul plus élevée est spécialement utilisé pour la génération d'images 2D/3D.

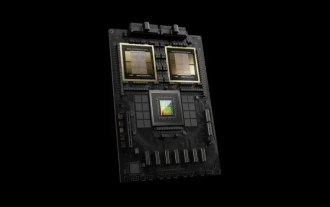

En réponse à ChatGPT, qui nécessite une énorme puissance de calcul, NVIDIA a publié NVIDIA H100 NVL, un grand modèle de langage (LLM) avec 94 Go de mémoire et un Transformer Engine accéléré. Solution, GPU PCIE H100 équipé du double GPU NVLINK.

"Le seul GPU actuel capable de gérer ChatGPT est le NVIDIA HGX A100. Par rapport au premier, maintenant Un serveur standard équipé de quatre paires de H100 et d'un double NVLINK peut être 10 fois plus rapide, ce qui peut réduire d'un ordre de grandeur le coût de traitement des grands modèles de langage", a déclaré Huang.

Enfin, il y a NVIDIA Grace Hopper pour les modèles de recommandation, qui en plus d'être optimisé pour les tâches de recommandation, peut également alimenter les réseaux de neurones graphiques et les bases de données vectorielles.

Laissez la puce franchir les limites physiques

Actuellement, le processus de production de semi-conducteurs s'approche des limites que la physique peut atteindre. Après le processus 2 nm, quel est le point de rupture ? NVIDIA a décidé de commencer par l'étape la plus primitive de la fabrication des puces : la photolithographie.

Fondamentalement parlant, il s'agit d'un problème d'imagerie à la limite physique. Dans le cadre de processus avancés, de nombreuses caractéristiques de la puce seront plus petites que la longueur d'onde de la lumière utilisée dans le processus d'impression, et la conception du masque doit être constamment modifiée, une étape appelée correction optique de proximité. La lithographie informatique simule le comportement de la lumière lorsqu'elle interagit avec la résine photosensible à travers l'original. Ces comportements sont décrits selon les équations de Maxwell. Il s'agit de la tâche la plus exigeante en termes de calcul dans le domaine de la conception et de la fabrication de puces.

Jen-Hsun Huang a annoncé une nouvelle technologie appelée CuLitho au GTC pour accélérer la conception et la fabrication de semi-conducteurs. Le logiciel utilise des puces Nvidia pour accélérer les étapes entre la conception logicielle de la puce et la fabrication physique des masques de photolithographie utilisés pour imprimer le motif sur la puce.

CuLitho fonctionne sur des GPU et offre des performances 40 fois supérieures à celles des technologies de lithographie actuelles, accélérant ainsi les charges de travail informatiques à grande échelle qui consomment actuellement des dizaines de milliards d'heures CPU par an. "La construction du H100 nécessite 89 masques. Lorsqu'il est exécuté sur le processeur, un masque prend deux semaines, mais si le H100 est utilisé pour fonctionner sur CuLitho, cela ne prend que 8 heures", a déclaré Huang.

Cela signifie que 500 systèmes NVIDIA DGX H100 peuvent remplacer le travail de 40 000 systèmes CPU et exécuter toutes les parties du processus de lithographie informatique, contribuant ainsi à réduire les besoins en énergie et l'impact potentiel sur l'environnement.

Cette avancée permettra aux transistors et aux circuits des puces d’être plus petits qu’aujourd’hui, tout en accélérant les délais de commercialisation des puces et en améliorant l’efficacité énergétique dans les énormes centres de données qui fonctionnent 24 heures sur 24 pour piloter le processus de fabrication.

Nvidia a déclaré qu'elle travaillait avec ASML, Synopsys et TSMC pour mettre la technologie sur le marché. Selon certaines informations, TSMC commencera à préparer la production d'essai de cette technologie en juin.

"L'industrie des puces constitue le fondement de presque toutes les autres industries dans le monde", a déclaré Huang. "Avec la technologie de lithographie aux limites de la physique, grâce à CuLitho et en collaboration avec nos partenaires TSMC, ASML et Synopsys, les usines de fabrication peuvent augmenter leur production, réduire leur empreinte carbone et jeter les bases du 2 nm et au-delà

Le premier GPU-." système informatique quantique accéléré

Lors de l'événement d'aujourd'hui, NVIDIA a également annoncé un nouveau système construit à l'aide de machines quantiques, qui offre aux chercheurs travaillant sur l'informatique classique quantique hautes performances et à faible latence une nouvelle architecture révolutionnaire.

En tant que premier système informatique quantique accéléré par GPU au monde, NVIDIA DGX Quantum combine la plate-forme informatique accélérée la plus puissante au monde (implémentée par la super puce NVIDIA Grace Hopper et le modèle de programmation open source CUDA Quantum) avec le plus puissant au monde, combiné à la plate-forme de contrôle quantique avancée OPX (fournie par Quantum Machines). Cette combinaison permet aux chercheurs de créer des applications d'une puissance sans précédent qui combinent l'informatique quantique avec l'informatique classique de pointe pour permettre l'étalonnage, le contrôle, la correction d'erreurs quantiques et les algorithmes hybrides.

Au cœur de DGX Quantum se trouve un système NVIDIA Grace Hopper connecté par PCIe aux Quantum Machines OPX+, permettant une latence inférieure à la microseconde entre le GPU et l'unité de traitement quantique (QPU).

Tim Costa, directeur du HPC et du quantique chez NVIDIA, a déclaré : « Le supercalcul accéléré quantique a le potentiel de remodeler la science et l'industrie, et NVIDIA DGX Quantum permettra aux chercheurs de repousser les limites de l'informatique quantique classique. »

Oui Par conséquent, NVIDIA a intégré le GPU à architecture Hopper hautes performances avec le nouveau processeur Grace de la société dans "Grace Hopper" pour fournir une super puissance aux applications géantes d'IA et HPC. Il offre des performances jusqu'à 10 fois supérieures pour les applications exécutant des téraoctets de données, donnant ainsi aux chercheurs quantiques classiques plus de puissance pour résoudre les problèmes les plus complexes au monde.

DGX Quantum équipe également les développeurs avec NVIDIA CUDA Quantum, une puissante pile logicielle unifiée désormais open source. CUDA Quantum est une plate-forme informatique hybride quantique-classique qui intègre et programme des QPU, des GPU et des CPU dans un seul système.

37 000 $ par mois pour former votre propre ChatGPT sur la page WebMicrosoft a dépensé des centaines de millions de dollars pour acheter des dizaines de milliers d'A100 afin de construire un superordinateur dédié à GPT. Vous souhaiterez peut-être maintenant louer OpenAI et Microsoft pour former ChatGPT. et vous devez rechercher le même GPU pour entraîner votre propre grand modèle.

Le DGX Cloud proposé par NVIDIA fournit un cluster de supercalcul IA NVIDIA DGX dédié, associé au logiciel NVIDIA AI. Ce service permet à chaque entreprise d'accéder au supercalcul IA à l'aide d'un simple navigateur Web, éliminant ainsi le besoin d'acquisition, de déploiement et de gestion. complexité de l’infrastructure sur site.

Selon les rapports, chaque instance DGX Cloud dispose de huit GPU Tensor Core H100 ou A100 de 80 Go, avec un total de 640 Go de mémoire GPU par nœud. Une structure hautes performances et à faible latence construite avec NVIDIA Networking garantit que les charges de travail peuvent évoluer sur des clusters de systèmes interconnectés, permettant à plusieurs instances d'agir comme un GPU géant pour répondre aux exigences de performances de la formation avancée en IA.

Désormais, les entreprises peuvent louer un cluster DGX Cloud sur une base mensuelle pour faire évoluer rapidement et facilement le développement de grandes charges de travail de formation multi-nœuds sans attendre des ressources informatiques accélérées qui sont souvent très demandées.

Le prix de location mensuel, selon Huang Renxun, commence à 36 999 $ par instance et par mois.

"Nous sommes à l'heure de l'intelligence artificielle sur iPhone", a déclaré Huang. "Les startups se précipitent pour créer des produits et des modèles commerciaux révolutionnaires, et les opérateurs historiques cherchent à réagir. DGX Cloud offre aux clients un accès instantané au supercalcul NVIDIA AI à l'échelle mondiale. dans le cloud. "

Pour aider les entreprises à adopter la vague de l'IA générative, NVIDIA a également annoncé une série de services cloud qui permettent aux entreprises de créer et d'améliorer des modèles de langage personnalisés à grande échelle et des modèles d'IA générative.

Les utilisateurs peuvent désormais utiliser les services linguistiques NVIDIA NeMo et les services d'image, vidéo et 3D NVIDIA Picasso pour créer des applications d'IA générative propriétaires et spécifiques à un domaine pour une conversation intelligente et un support client, la création de contenu professionnel, la simulation numérique, etc. Par ailleurs, NVIDIA a annoncé de nouveaux modèles du service cloud de biologie NVIDIA BioNeMo.

"L'IA générative est un nouveau type d'ordinateur qui peut être programmé en langage humain naturel. Cette capacité est considérable : tout le monde peut commander des ordinateurs pour résoudre des problèmes, ce qui était il n'y a pas si longtemps le domaine des programmeurs. Brevet," » dit Huang.

À en juger par la publication d’aujourd’hui, NVIDIA améliore non seulement continuellement la conception matérielle pour les charges de travail d’IA des entreprises technologiques, mais propose également de nouveaux modèles économiques. Aux yeux de certains, Nvidia veut être « TSMC dans le domaine de l'IA » : en fournissant des services de fonderie de productivité avancés, comme une usine de plaquettes, en aidant d'autres entreprises à former des algorithmes d'IA pour leurs scénarios spécifiques.

Utiliser la formation sur les supercalculateurs de NVIDIA pour éliminer directement le besoin d'intermédiaires pour gagner la différence de prix, sera-ce l'orientation du futur développement de l'IA ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1393

1393

52

52

1207

1207

24

24

NVIDIA lance la fonction RTX HDR : les jeux non pris en charge utilisent des filtres AI pour obtenir de superbes effets visuels HDR

Feb 24, 2024 pm 06:37 PM

NVIDIA lance la fonction RTX HDR : les jeux non pris en charge utilisent des filtres AI pour obtenir de superbes effets visuels HDR

Feb 24, 2024 pm 06:37 PM

Selon les informations de ce site Web du 23 février, NVIDIA a mis à jour et lancé hier soir l'application NVIDIA, offrant aux joueurs un nouveau centre de contrôle GPU unifié, permettant aux joueurs de capturer des moments merveilleux grâce au puissant outil d'enregistrement fourni par le flotteur du jeu. fenêtre. Dans cette mise à jour, NVIDIA a également introduit la fonction RTXHDR. L'introduction officielle est jointe à ce site : RTXHDR est un nouveau filtre Freestyle basé sur l'IA qui peut introduire de manière transparente les superbes effets visuels de la plage dynamique élevée (HDR) dans les jeux qui ne le font pas. prend en charge à l'origine le HDR. Tout ce dont vous avez besoin est un moniteur compatible HDR pour utiliser cette fonctionnalité avec une large gamme de jeux basés sur DirectX et Vulkan. Une fois que le lecteur a activé la fonction RTXHDR, le jeu fonctionnera même s'il ne prend pas en charge la HD.

Il est rapporté que les cartes graphiques NVIDIA RTX série 50 sont nativement équipées d'une interface d'alimentation PCIe Gen 6 à 16 broches.

Feb 20, 2024 pm 12:00 PM

Il est rapporté que les cartes graphiques NVIDIA RTX série 50 sont nativement équipées d'une interface d'alimentation PCIe Gen 6 à 16 broches.

Feb 20, 2024 pm 12:00 PM

Selon les informations de ce site Web du 19 février, dans la dernière vidéo de la chaîne LawisDead de Moore, le présentateur Tom a révélé que les cartes graphiques de la série Nvidia GeForce RTX50 seront nativement équipées d'une interface d'alimentation PCIeGen6 à 16 broches. Tom a déclaré qu'en plus des séries haut de gamme GeForceRTX5080 et GeForceRTX5090, le GeForceRTX5060 de milieu de gamme permettra également de nouvelles interfaces d'alimentation. Il est rapporté que Nvidia a fixé des exigences claires selon lesquelles, à l'avenir, chaque série GeForce RTX50 sera équipée d'une interface d'alimentation PCIeGen6 à 16 broches pour simplifier la chaîne d'approvisionnement. Les captures d'écran jointes à ce site sont les suivantes : Tom a également dit que GeForceRTX5090

Le modèle de dialogue NVIDIA ChatQA a évolué vers la version 2.0, avec la longueur du contexte mentionnée à 128 Ko

Jul 26, 2024 am 08:40 AM

Le modèle de dialogue NVIDIA ChatQA a évolué vers la version 2.0, avec la longueur du contexte mentionnée à 128 Ko

Jul 26, 2024 am 08:40 AM

La communauté ouverte LLM est une époque où une centaine de fleurs fleurissent et s'affrontent. Vous pouvez voir Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 et bien d'autres. excellents interprètes. Cependant, par rapport aux grands modèles propriétaires représentés par le GPT-4-Turbo, les modèles ouverts présentent encore des lacunes importantes dans de nombreux domaines. En plus des modèles généraux, certains modèles ouverts spécialisés dans des domaines clés ont été développés, tels que DeepSeek-Coder-V2 pour la programmation et les mathématiques, et InternVL pour les tâches de langage visuel.

Les cartes graphiques NVIDIA RTX 4070 et 4060 Ti FE sont tombées en dessous du prix de détail recommandé, respectivement 4599/2999 yuans

Feb 22, 2024 pm 09:43 PM

Les cartes graphiques NVIDIA RTX 4070 et 4060 Ti FE sont tombées en dessous du prix de détail recommandé, respectivement 4599/2999 yuans

Feb 22, 2024 pm 09:43 PM

Selon les informations de ce site du 22 février, d'une manière générale, NVIDIA et AMD ont des restrictions sur les prix des chaînes, et certains revendeurs qui réduisent considérablement les prix en privé seront également punis. Par exemple, AMD a récemment puni les revendeurs qui vendaient des cartes graphiques 6750GRE à des prix inférieurs. le prix minimum. Le commerçant a été puni. Ce site a remarqué que les NVIDIA GeForce RTX 4070 et 4060 Ti sont tombées à des niveaux record. La version de leur fondateur, c'est-à-dire la version publique de la carte graphique, peut actuellement recevoir un coupon de 200 yuans dans la boutique auto-gérée de JD.com, avec. prix de 4 599 yuans et 2 999 yuans. Bien sûr, si l’on considère les magasins tiers, les prix seront plus bas. En termes de paramètres, la carte graphique RTX4070 possède un cœur 5888CUDA, utilise 12 Go de mémoire GDDR6X et une largeur de bits de 192bi.

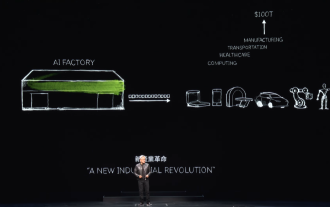

« AI Factory » favorisera la refonte de l'ensemble de la pile logicielle, et NVIDIA fournit des conteneurs Llama3 NIM que les utilisateurs peuvent déployer

Jun 08, 2024 pm 07:25 PM

« AI Factory » favorisera la refonte de l'ensemble de la pile logicielle, et NVIDIA fournit des conteneurs Llama3 NIM que les utilisateurs peuvent déployer

Jun 08, 2024 pm 07:25 PM

Selon les informations de ce site le 2 juin, lors du discours d'ouverture du Huang Renxun 2024 Taipei Computex, Huang Renxun a présenté que l'intelligence artificielle générative favoriserait la refonte de l'ensemble de la pile logicielle et a démontré ses microservices cloud natifs NIM (Nvidia Inference Microservices). . Nvidia estime que « l'usine IA » déclenchera une nouvelle révolution industrielle : en prenant comme exemple l'industrie du logiciel lancée par Microsoft, Huang Renxun estime que l'intelligence artificielle générative favorisera sa refonte complète. Pour faciliter le déploiement de services d'IA par les entreprises de toutes tailles, NVIDIA a lancé les microservices cloud natifs NIM (Nvidia Inference Microservices) en mars de cette année. NIM+ est une suite de microservices cloud natifs optimisés pour réduire les délais de commercialisation

Après de multiples transformations et coopération avec le géant de l'IA Nvidia, pourquoi Vanar Chain a-t-il augmenté de 4,6 fois en 30 jours ?

Mar 14, 2024 pm 05:31 PM

Après de multiples transformations et coopération avec le géant de l'IA Nvidia, pourquoi Vanar Chain a-t-il augmenté de 4,6 fois en 30 jours ?

Mar 14, 2024 pm 05:31 PM

Récemment, la blockchain Layer1 VanarChain a attiré l'attention du marché en raison de son taux de croissance élevé et de sa coopération avec le géant de l'IA NVIDIA. Derrière la popularité de VanarChain, en plus de subir de multiples transformations de marque, des concepts populaires tels que les jeux principaux, le métaverse et l'IA ont également valu au projet beaucoup de popularité et de sujets. Avant sa transformation, Vanar, anciennement TerraVirtua, a été fondée en 2018 en tant que plate-forme prenant en charge les abonnements payants, fournissant du contenu de réalité virtuelle (VR) et de réalité augmentée (AR) et acceptant les paiements en crypto-monnaie. La plateforme a été créée par les cofondateurs Gary Bracey et Jawad Ashraf, Gary Bracey possédant une vaste expérience dans la production et le développement de jeux vidéo.

Le RTX 4080 est 15 % plus rapide que le RTX 4070 Ti Super et la version non Super est 8 % plus lente.

Jan 24, 2024 pm 01:27 PM

Le RTX 4080 est 15 % plus rapide que le RTX 4070 Ti Super et la version non Super est 8 % plus lente.

Jan 24, 2024 pm 01:27 PM

Selon l'actualité de ce site du 23 janvier, selon le média technologique étranger Videocardz, sur la base des résultats des tests 3DMark, la carte graphique Nvidia GeForce RTX4070TiSuper est 15 % plus lente que la RTX4080 et 8 % plus rapide que la carte graphique RTX4070Ti. Selon les médias, plusieurs testeurs testent la carte graphique GeForce RTX4070TiSuper et annonceront les résultats détaillés des tests dans les prochains jours. L'un des évaluateurs a annoncé la nouvelle de manière anonyme sur le portail VideoCardz et a partagé les informations sur les performances de la carte graphique lors du test synthétique 3DMark. Ce site cite l’opinion des médias selon laquelle les scores suivants ne peuvent pas refléter pleinement les performances du RTX4070TiSuper. R.

TrendForce : les produits de la plate-forme Blackwell de Nvidia permettent d'augmenter la capacité de production CoWoS de TSMC de 150 % cette année

Apr 17, 2024 pm 08:00 PM

TrendForce : les produits de la plate-forme Blackwell de Nvidia permettent d'augmenter la capacité de production CoWoS de TSMC de 150 % cette année

Apr 17, 2024 pm 08:00 PM

Selon les informations de ce site du 17 avril, TrendForce a récemment publié un rapport estimant que la demande pour les nouveaux produits de la plate-forme Blackwell de Nvidia est haussière et devrait entraîner une augmentation de la capacité totale de production d'emballages CoWoS de TSMC de plus de 150 % en 2024. Les nouveaux produits de la plate-forme Blackwell de NVIDIA comprennent des GPU de série B et des cartes accélératrices GB200 intégrant le propre processeur GraceArm de NVIDIA. TrendForce confirme que la chaîne d'approvisionnement est actuellement très optimiste quant au GB200. On estime que les livraisons en 2025 devraient dépasser le million d'unités, représentant 40 à 50 % des GPU haut de gamme de Nvidia. Nvidia prévoit de livrer des produits tels que le GB200 et le B100 au second semestre, mais le conditionnement des plaquettes en amont doit encore adopter des produits plus complexes.