Opération et maintenance

Opération et maintenance

Nginx

Nginx

Comment installer le serveur nginx et configurer l'équilibrage de charge sous Linux

Comment installer le serveur nginx et configurer l'équilibrage de charge sous Linux

Comment installer le serveur nginx et configurer l'équilibrage de charge sous Linux

1. Créez un environnement de test

L'environnement de test ici est constitué de deux machines virtuelles Lubuntu 19.04 installées via Virtualbox. La méthode d'installation du système Linux ne sera pas décrite dans. détail.

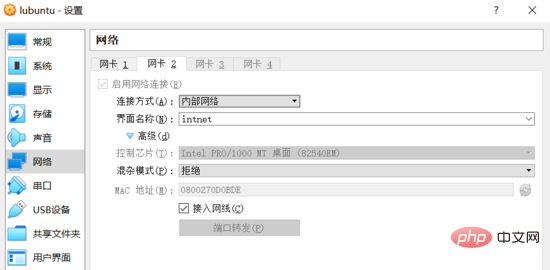

Afin d'assurer un accès mutuel entre deux machines virtuelles Linux, en plus de la méthode nat par défaut, la configuration réseau de la machine virtuelle utilise également la méthode de mise en réseau réseau interne (interne) fournie par le logiciel virtualbox .

De plus, les cartes réseau associées au "réseau interne" dans les deux machines virtuelles doivent être liées à l'adresse IP statique du même segment de réseau, puis les deux hôtes formeront une zone locale réseau et communiquer les uns avec les autres.

Configuration du réseau

Ouvrez le logiciel Virtualbox, entrez dans l'interface des paramètres des deux machines virtuelles et ajoutez un réseau avec la connexion réseau interne Méthode de connexion, la capture d'écran est la suivante (les deux machines virtuelles ont la même configuration) :

Réseau interne

# 🎜🎜#Connectez-vous au système de la machine virtuelle et utilisez la commande ip addr pour afficher les informations de connexion réseau actuelles :$ ip addr ... 2: enp0s3: <broadcast,multicast,up,lower_up> mtu 1500 qdisc fq_codel state up group default qlen 1000 link/ether 08:00:27:38:65:a8 brd ff:ff:ff:ff:ff:ff inet 10.0.2.15/24 brd 10.0.2.255 scope global dynamic noprefixroute enp0s3 valid_lft 86390sec preferred_lft 86390sec inet6 fe80::9a49:54d3:2ea6:1b50/64 scope link noprefixroute valid_lft forever preferred_lft forever 3: enp0s8: <broadcast,multicast,up,lower_up> mtu 1500 qdisc fq_codel state up group default qlen 1000 link/ether 08:00:27:0d:0b:de brd ff:ff:ff:ff:ff:ff inet6 fe80::2329:85bd:937e:c484/64 scope link noprefixroute valid_lft forever preferred_lft forever

/etc/network/interfaces n'est plus pris effet. /etc/network/interfaces 不再生效。

所以为网卡设置静态 ip 时需要修改 /etc/netplan/01-network-manager-all.yaml 配置文件,示例如下:

network: version: 2 renderer: networkmanager ethernets: enp0s8: dhcp4: no dhcp6: no addresses: [192.168.1.101/24] # gateway4: 192.168.1.101 # nameservers: # addresses: [192.168.1.101, 8.8.8.8]

由于两台主机处于同一子网,网关和 dns 服务器未配置的情况下仍可以互相访问。对应的配置项暂时先注释掉(后续可以尝试自行搭建 dns 服务器)。

编辑完成后运行 sudo netplan apply 命令,前面配置的静态 ip 即可生效。

$ ip addr

...

3: enp0s8: <broadcast,multicast,up,lower_up> mtu 1500 qdisc fq_codel state up group default qlen 1000

link/ether 08:00:27:0d:0b:de brd ff:ff:ff:ff:ff:ff

inet 192.168.1.101/24 brd 192.168.1.255 scope global noprefixroute enp0s8

valid_lft forever preferred_lft forever

inet6 fe80::a00:27ff:fe0d:bde/64 scope link

valid_lft forever preferred_lft forever登录进另一台虚拟机中,执行同样的操作(注意配置文件中的 addresses 项改为 [192.168.1.102/24] )。两台虚拟机的网络即配置完成。

此时有 linux 虚拟机 server1,ip 地址为 192.168.1.101;linux 虚拟机 server2,ip 地址为 192.168.1.102。两台主机可相互访问。测试如下:

starky@server1:~$ ping 192.168.1.102 -c 2 ping 192.168.1.102 (192.168.1.102) 56(84) bytes of data. 64 bytes from 192.168.1.102: icmp_seq=1 ttl=64 time=0.951 ms 64 bytes from 192.168.1.102: icmp_seq=2 ttl=64 time=0.330 ms --- 192.168.1.102 ping statistics --- 2 packets transmitted, 2 received, 0% packet loss, time 2ms rtt min/avg/max/mdev = 0.330/0.640/0.951/0.311 ms skitar@server2:~$ ping 192.168.1.101 -c 2 ping 192.168.1.101 (192.168.1.101) 56(84) bytes of data. 64 bytes from 192.168.1.101: icmp_seq=1 ttl=64 time=0.223 ms 64 bytes from 192.168.1.101: icmp_seq=2 ttl=64 time=0.249 ms --- 192.168.1.101 ping statistics --- 2 packets transmitted, 2 received, 0% packet loss, time 29ms rtt min/avg/max/mdev = 0.223/0.236/0.249/0.013 ms

二、安装 nginx 服务器

nginx 的安装方式主要有两种:

预编译的二进制程序。这是最简单和最快速的安装方式,各主流操作系统都可以通过包管理器(如 ubuntu 的 apt-get)安装。此种方式会安装几乎所有的 官方 模块或插件。

从源代码编译安装。这种方式相对于前者更加灵活,可以自行选择需要安装的模块或第三方插件。

本示例并没有特殊的需求,所以直接选择第一种安装方式。命令如下:

$ sudo apt-get update $ sudo apt-get install nginx

安装成功后,通过 systemctl status nginx 命令查看 nginx 服务的运行状态:

$ systemctl status nginx

● nginx.service - a high performance web server and a reverse proxy server

loaded: loaded (/lib/systemd/system/nginx.service; enabled; vendor preset: en

active: active (running) since tue 2019-07-02 01:22:07 cst; 26s ago

docs: man:nginx(8)

main pid: 3748 (nginx)

tasks: 2 (limit: 1092)

memory: 4.9m

cgroup: /system.slice/nginx.service

├─3748 nginx: master process /usr/sbin/nginx -g daemon on; master_pro

└─3749 nginx: worker process通过 curl -i 127.0.0.1 命令验证 web 服务器是否可以正常访问:

$ curl -i 127.0.0.1 http/1.1 200 ok server: nginx/1.15.9 (ubuntu) ...

三、负载均衡配置

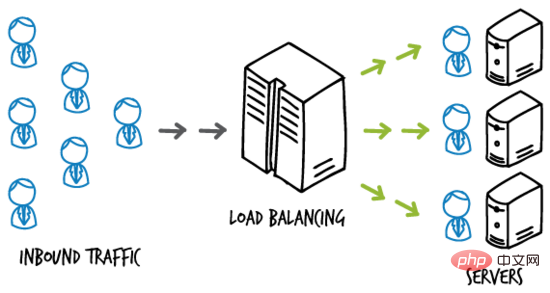

负载均衡(load-balancing)即按照一定的规则将负载分摊到多个操作单元上执行,从而提高服务的可用性和响应速度。

简单的示例图如下:

load-balancing

如某网站应用部署在多台主机构成的服务器集群上,负载均衡服务器位于终端用户和服务器集群之间,负责接收终端用户的访问流量,并根据一定的规则将用户访问 分发 给后端的服务器主机,从而提高在高并发状态下的响应速度。

负载均衡服务器

nginx 可以通过 upstream 选项配置负载均衡。这里使用虚拟机 server1 作为负载均衡服务器。

修改 serve1 上默认站点的配置文件( sudo vim /etc/nginx/sites-available/default ),改为如下内容:

upstream backend {

server 192.168.1.102:8000;

server 192.168.1.102;

}

server {

listen 80;

location / {

proxy_pass http://backend;

}

}基于测试的目的,当前只有两台虚拟机。server1(192.168.1.101)已经作为负载均衡服务器,所以使用 server2(192.168.1.102)作为应用服务器。

这里借助 nginx 的虚拟主机功能,分别将 192.168.1.102 和 192.168.1.102:8000 “模拟”为两台不同的应用服务器。

应用服务器

修改 server2 上默认站点的配置文件( sudo vim /etc/nginx/sites-available/default ),改为如下内容:

server {

listen 80;

root /var/www/html;

index index.html index.htm index.nginx-debian.html;

server_name 192.168.1.102;

location / {

try_files $uri $uri/ =404;

}

}在 /var/www/html 目录下创建 index.html 文件,作为 default 站点的 index 页面,内容如下:

<html>

<head>

<title>index page from server1</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server1, address 192.168.1.102.</h1>

</body>

</html>运行 sudo systemctl restart nginx Ainsi, lors de la définition d'une IP statique pour la carte réseau, vous devez modifier le fichier de configuration /etc/netplan/01-network-manager-all.yaml. L'exemple est le suivant : #🎜🎜. #

$ curl 192.168.1.102

<html>

<head>

<title>index page from server1</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server1, address 192.168.1.102.</h1>

</body>

</html>sudo netplan apply et l'adresse IP statique configurée précédemment prendra effet. #🎜🎜#server {

listen 8000;

root /var/www/html;

index index2.html index.htm index.nginx-debian.html;

server_name 192.168.1.102;

location / {

try_files $uri $uri/ =404;

}

}<html>

<head>

<title>index page from server2</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server2, address 192.168.1.102:8000.</h1>

</body>

</html>Binaires précompilés. Il s'agit de la méthode d'installation la plus simple et la plus rapide. Tous les principaux systèmes d'exploitation peuvent être installés via des gestionnaires de packages (tels que apt-get d'Ubuntu). Cette méthode installera presque tous les modules ou plug-ins officiels.

#🎜🎜#

Compilez et installez à partir du code source. Cette méthode est plus flexible que la précédente et vous pouvez choisir les modules ou plug-ins tiers à installer.

#🎜🎜#

$ curl 192.168.1.102:8000

<html>

<head>

<title>index page from server2</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server2, address 192.168.1.102:8000.</h1>

</body>

</html> systemctl status nginx pour vérifier l'état d'exécution du service nginx : #🎜🎜#$ curl http://backend

<html>

<head>

<title>index page from server1</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server1, address 192.168.1.102.</h1>

</body>

</html>

$ curl http://backend

<html>

<head>

<title>index page from server2</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server2, address 192.168.1.102:8000.</h1>

</body>

</html>

$ curl http://backend

<html>

<head>

<title>index page from server1</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server1, address 192.168.1.102.</h1>

</body>

</html>

$ curl http://backend

<html>

<head>

<title>index page from server2</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server2, address 192.168.1.102:8000.</h1>

</body>

</html>curl - i 127.0.0.1 pour vérifier si le serveur web est accessible normalement : #🎜🎜#upstream backend {

server backend1.example.com weight=5;

server backend2.example.com;

} #🎜🎜##🎜🎜#load-balancing#🎜🎜##🎜🎜# Par exemple, une application de site Web est déployée sur un serveur cluster composé de plusieurs hôtes Le serveur d'équilibrage de charge est situé entre l'utilisateur final et le cluster de serveurs. Il est responsable de la réception du trafic d'accès de l'utilisateur final et de la distribution de l'accès de l'utilisateur à l'hôte du serveur back-end selon certaines règles. améliorer la vitesse de réponse dans des conditions de concurrence élevée. #🎜🎜##🎜🎜##🎜🎜#Le serveur d'équilibrage de charge#🎜🎜##🎜🎜##🎜🎜#nginx peut configurer l'équilibrage de charge via l'option en amont. Ici, le serveur de machine virtuelle 1 est utilisé comme serveur d'équilibrage de charge. #🎜🎜##🎜🎜#Modifiez le fichier de configuration du site par défaut sur serve1 ( sudo vim /etc/nginx/sites-available/default ) avec le contenu suivant : #🎜🎜#

#🎜🎜##🎜🎜#load-balancing#🎜🎜##🎜🎜# Par exemple, une application de site Web est déployée sur un serveur cluster composé de plusieurs hôtes Le serveur d'équilibrage de charge est situé entre l'utilisateur final et le cluster de serveurs. Il est responsable de la réception du trafic d'accès de l'utilisateur final et de la distribution de l'accès de l'utilisateur à l'hôte du serveur back-end selon certaines règles. améliorer la vitesse de réponse dans des conditions de concurrence élevée. #🎜🎜##🎜🎜##🎜🎜#Le serveur d'équilibrage de charge#🎜🎜##🎜🎜##🎜🎜#nginx peut configurer l'équilibrage de charge via l'option en amont. Ici, le serveur de machine virtuelle 1 est utilisé comme serveur d'équilibrage de charge. #🎜🎜##🎜🎜#Modifiez le fichier de configuration du site par défaut sur serve1 ( sudo vim /etc/nginx/sites-available/default ) avec le contenu suivant : #🎜🎜#upstream backend {

least_conn;

server backend1.example.com;

server backend2.example.com;

}upstream backend {

ip_hash;

server backend1.example.com;

server backend2.example.com;

}upstream backend {

hash $request_uri consistent;

server backend1.example.com;

server backend2.example.com;

}sudo systemctl restart nginx pour redémarrer le service nginx. À ce moment, vous pouvez accéder à la page index.html que vous venez de créer : #🎜🎜#.$ curl 192.168.1.102

<html>

<head>

<title>index page from server1</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server1, address 192.168.1.102.</h1>

</body>

</html>配置“另一台主机”上的站点,在 server2 上创建 /etc/nginx/sites-available/server2 配置文件,内容如下:

server {

listen 8000;

root /var/www/html;

index index2.html index.htm index.nginx-debian.html;

server_name 192.168.1.102;

location / {

try_files $uri $uri/ =404;

}

}注意监听端口和 index 页面的配置变化。在 /var/www/html 目录下创建 index2.html 文件,作为 server2 站点的 index 页面,内容如下:

<html>

<head>

<title>index page from server2</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server2, address 192.168.1.102:8000.</h1>

</body>

</html>ps:为了测试目的,default 站点和 server2 站点配置在同一个主机 server2 上,且页面稍有不同。实际环境中通常将这两个站点配置在不同的主机上,且内容一致。

运行 sudo ln -s /etc/nginx/sites-available/server2 /etc/nginx/sites-enabled/ 命令启用刚刚创建的 server2 站点。

重启 nginx 服务,此时访问 即可获取刚刚创建的 index2.html 页面:

$ curl 192.168.1.102:8000

<html>

<head>

<title>index page from server2</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server2, address 192.168.1.102:8000.</h1>

</body>

</html>负载均衡测试

回到负载均衡服务器即虚拟机 server1 上,其配置文件中设置的 反向代理 url 为 。

由于未曾配置域名解析服务,无法将 urlhttp://backend 定位到正确的位置。

可以修改 server1 上的 /etc/hosts 文件,添加如下一条记录:

127.0.0.1 backend

即可将该域名解析到本地 ip ,完成对负载均衡服务器的访问。

重启 nginx 服务,在 server1 上访问 ,效果如下:

$ curl http://backend

<html>

<head>

<title>index page from server1</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server1, address 192.168.1.102.</h1>

</body>

</html>

$ curl http://backend

<html>

<head>

<title>index page from server2</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server2, address 192.168.1.102:8000.</h1>

</body>

</html>

$ curl http://backend

<html>

<head>

<title>index page from server1</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server1, address 192.168.1.102.</h1>

</body>

</html>

$ curl http://backend

<html>

<head>

<title>index page from server2</title>

</head>

<body>

<h1 id="this-nbsp-is-nbsp-server-nbsp-address-nbsp">this is server2, address 192.168.1.102:8000.</h1>

</body>

</html>从输出中可以看出,server1 对负载均衡服务器 的访问,完成了对应用服务器 server2 上两个 web 站点的 轮询 ,起到负载均衡的作用。

四、负载均衡方法

nginx 开源版本提供四种负载均衡的实现方式,简单介绍如下。

1. round robin

用户请求 均匀 地分配给后端服务器集群(可以通过 weight 选项设置轮询的 权重 ),这是 nginx 默认使用的负载均衡方式:

upstream backend {

server backend1.example.com weight=5;

server backend2.example.com;

}2. least connections

用户请求会优先转发给集群中当前活跃连接数最少的服务器。同样支持 weight 选项。

upstream backend {

least_conn;

server backend1.example.com;

server backend2.example.com;

}3. ip hash

用户请求会根据 客户端 ip 地址 进行转发。即该方式意图保证某个特定的客户端最终会访问 同一个 服务器主机。

upstream backend {

ip_hash;

server backend1.example.com;

server backend2.example.com;

}4. generic hash

用户请求会根据一个 自定义键值 确定最终转发的目的地,该键值可以是字符串、变量或者组合(如源 ip 和端口号)。

upstream backend {

hash $request_uri consistent;

server backend1.example.com;

server backend2.example.com;

}权重

参考下面的示例配置:

upstream backend {

server backend1.example.com weight=5;

server backend2.example.com;

server 192.0.0.1 backup;

}默认权重(weight)为 1 。 backup 服务器 只有在所有其他服务器全部宕机的情况下才会接收请求。

如上面的示例,每 6 个请求会有 5 个转发给 backend1.example.com,1 个转发给 backend2.example.com。只有当 backend1 和 backend2 全部宕机时,192.0.0.1 才会接收并处理请求。

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Quelle configuration de l'ordinateur est requise pour VScode

Apr 15, 2025 pm 09:48 PM

Quelle configuration de l'ordinateur est requise pour VScode

Apr 15, 2025 pm 09:48 PM

Vs Code Système Exigences: Système d'exploitation: Windows 10 et supérieur, MacOS 10.12 et supérieur, processeur de distribution Linux: minimum 1,6 GHz, recommandé 2,0 GHz et au-dessus de la mémoire: minimum 512 Mo, recommandée 4 Go et plus d'espace de stockage: Minimum 250 Mo, recommandée 1 Go et plus d'autres exigences: connexion du réseau stable, xorg / wayland (Linux) recommandé et recommandée et plus

Comment exécuter le code Java dans le bloc-notes

Apr 16, 2025 pm 07:39 PM

Comment exécuter le code Java dans le bloc-notes

Apr 16, 2025 pm 07:39 PM

Bien que le bloc-notes ne puisse pas exécuter directement le code Java, il peut être réalisé en utilisant d'autres outils: à l'aide du compilateur de ligne de commande (Javac) pour générer un fichier bytecode (filename.class). Utilisez l'interpréteur Java (Java) pour interpréter ByteCode, exécuter le code et sortir le résultat.

Peut-on utiliser pour mac

Apr 15, 2025 pm 07:36 PM

Peut-on utiliser pour mac

Apr 15, 2025 pm 07:36 PM

VS Code est disponible sur Mac. Il a des extensions puissantes, l'intégration GIT, le terminal et le débogueur, et offre également une multitude d'options de configuration. Cependant, pour des projets particulièrement importants ou un développement hautement professionnel, le code vs peut avoir des performances ou des limitations fonctionnelles.

Comment utiliser vscode

Apr 15, 2025 pm 11:21 PM

Comment utiliser vscode

Apr 15, 2025 pm 11:21 PM

Visual Studio Code (VSCODE) est un éditeur de code Open Source, Open Source et gratuit développé par Microsoft. Il est connu pour son léger, l'évolutivité et le support pour une large gamme de langages de programmation. Pour installer VScode, veuillez visiter le site officiel pour télécharger et exécuter l'installateur. Lorsque vous utilisez VSCODE, vous pouvez créer de nouveaux projets, modifier le code, déboguer le code, naviguer dans les projets, développer VSCODE et gérer les paramètres. VScode est disponible pour Windows, MacOS et Linux, prend en charge plusieurs langages de programmation et fournit diverses extensions via Marketplace. Ses avantages incluent le léger, l'évolutivité, le support linguistique étendu, les fonctionnalités riches et la version

Quel est le but principal de Linux?

Apr 16, 2025 am 12:19 AM

Quel est le but principal de Linux?

Apr 16, 2025 am 12:19 AM

Les principales utilisations de Linux comprennent: 1. Système d'exploitation du serveur, 2. Système intégré, 3. Système d'exploitation de bureau, 4. Environnement de développement et de test. Linux excelle dans ces domaines, offrant des outils de stabilité, de sécurité et de développement efficaces.

Comment vérifier l'adresse de l'entrepôt de Git

Apr 17, 2025 pm 01:54 PM

Comment vérifier l'adresse de l'entrepôt de Git

Apr 17, 2025 pm 01:54 PM

Pour afficher l'adresse du référentiel GIT, effectuez les étapes suivantes: 1. Ouvrez la ligne de commande et accédez au répertoire du référentiel; 2. Exécutez la commande "git Remote -v"; 3. Affichez le nom du référentiel dans la sortie et son adresse correspondante.

Architecture Linux: dévoiler les 5 composants de base

Apr 20, 2025 am 12:04 AM

Architecture Linux: dévoiler les 5 composants de base

Apr 20, 2025 am 12:04 AM

Les cinq composants de base du système Linux sont: 1. Kernel, 2. Bibliothèque système, 3. Utilitaires système, 4. Interface utilisateur graphique, 5. Applications. Le noyau gère les ressources matérielles, la bibliothèque système fournit des fonctions précompilées, les utilitaires système sont utilisés pour la gestion du système, l'interaction GUI fournit une interaction visuelle et les applications utilisent ces composants pour implémenter des fonctions.

Code d'installation de Laravel

Apr 18, 2025 pm 12:30 PM

Code d'installation de Laravel

Apr 18, 2025 pm 12:30 PM

Pour installer Laravel, suivez ces étapes dans Séquence: Installer Composer (pour MacOS / Linux et Windows) Installez Laravel Installer Créer une nouvelle application d'accès au service de démarrage du projet (URL: http://127.0.0.1:8000) Configurer la connexion de la base de données (si nécessaire)