Opération et maintenance

Opération et maintenance

Nginx

Nginx

Comment configurer l'équilibrage de charge pour TCP sur le serveur Nginx

Comment configurer l'équilibrage de charge pour TCP sur le serveur Nginx

Comment configurer l'équilibrage de charge pour TCP sur le serveur Nginx

1. Installez nginx

1. Téléchargez nginx

# wget http://nginx.org/download/nginx-1.2.4.tar.gz

2. Téléchargez le patch du module TCP

# wget https://github.com/yaoweibin/nginx_tcp_proxy_module/tarball/master

Page d'accueil du code source : https://github.com/yaoweibin/nginx_tcp_proxy_module

3.

# tar xvf nginx-1.2.4.tar.gz # tar xvf yaoweibin-nginx_tcp_proxy_module-v0.4-45-ga40c99a.tar.gz # cd nginx-1.2.4 # patch -p1 < ../yaoweibin-nginx_tcp_proxy_module-a40c99a/tcp.patch #./configure --prefix=/usr/local/nginx --with-pcre=../pcre-8.30 --add-module=../yaoweibin-nginx_tcp_proxy_module-ae321fd/ # make # make install

2. Modifiez le fichier de configuration

Modifiez le fichier de configuration nginx.conf

# cd /usr/local/nginx/conf # vim nginx.conf

worker_processes 1;

events {

worker_connections 1024;

}

tcp {

upstream mssql {

server 10.0.1.201:1433;

server 10.0.1.202:1433;

check interval=3000 rise=2 fall=5 timeout=1000;

}

server {

listen 1433;

server_name 10.0.1.212;

proxy_pass mssql;

}

}3. Démarrez nginx

# cd /usr/local/nginx/sbin/ # ./nginx

#lsof :1433

4. Test

# telnet 10.0.1.201 1433

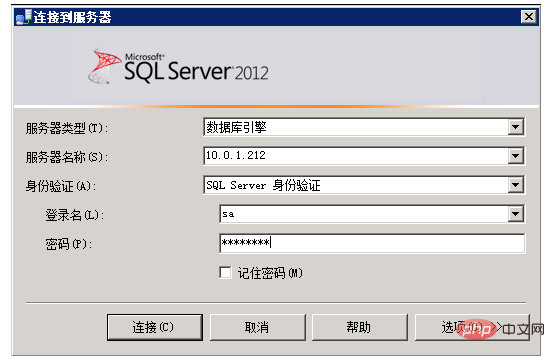

5. Utilisez le test de l'outil client SQL Server

6. Principe d'exécution de l'équilibrage de charge TCP

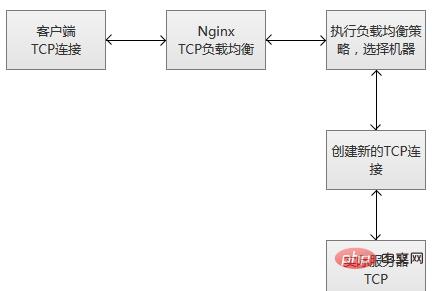

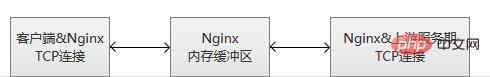

Lorsque nginx reçoit un nouveau lien client du port d'écoute, il exécute immédiatement l'algorithme de planification de routage et obtient le spécifié. IP du service qui doit être connecté, puis créez une nouvelle connexion en amont au serveur spécifié.

ps : Surveillance de la robustesse du service

Le module d'équilibrage de charge TCP prend en charge la détection de robustesse intégrée. Si un serveur en amont refuse une connexion TCP pendant plus que le temps configuré proxy_connect_timeout, il sera considéré comme ayant échoué. Dans ce cas, nginx essaie immédiatement de se connecter à un autre serveur normal du groupe en amont. Les informations sur l'échec de la connexion seront enregistrées dans le journal des erreurs nginx.(2) Préparez à l'avance les données « couramment utilisées », « préchauffez » le service de manière proactive, puis ouvrez l'accès au serveur une fois le préchauffage terminé.

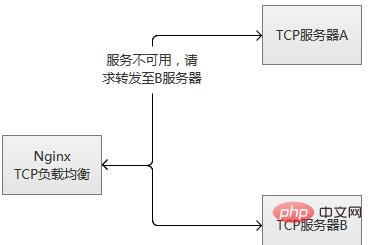

Le module d'équilibrage de charge TCP prend en charge la détection de robustesse intégrée. Si un serveur en amont refuse une connexion TCP pendant plus que la durée configurée proxy_connect_timeout, il sera considéré comme ayant échoué. Dans ce cas, nginx essaie immédiatement de se connecter à un autre serveur normal du groupe en amont. Les informations sur l'échec de la connexion seront enregistrées dans le journal des erreurs nginx.

Si un serveur échoue à plusieurs reprises (dépassant les paramètres configurés par max_fails ou fail_timeout), nginx kickera également le serveur. 60 secondes après le démarrage du serveur, nginx tentera occasionnellement de s'y reconnecter pour vérifier s'il est revenu à la normale. Si le serveur revient à la normale, nginx le rajoutera au groupe en amont et augmentera lentement la proportion de demandes de connexion.

La raison de "l'augmentation lente" est que généralement un service a des "données chaudes", c'est-à-dire que plus de 80 %, voire plus, des requêtes seront en fait bloquées dans le "cache de données chaudes" avant que le traitement réel ne soit effectué. . Il n'y a que quelques demandes. Lorsque la machine vient de démarrer, le « cache de données chaudes » n'a pas réellement été établi. À ce moment-là, un grand nombre de requêtes sont transmises de manière explosive, ce qui est susceptible d'empêcher la machine de « supporter » et de raccrocher à nouveau. . En prenant MySQL comme exemple, plus de 95 % de nos requêtes MySQL tombent généralement dans le cache mémoire, et peu de requêtes sont réellement exécutées.

En fait, qu'il s'agisse d'une seule machine ou d'un cluster, le redémarrage ou la commutation dans un scénario de requêtes simultanées élevées comportera ce risque. Il existe deux manières principales de le résoudre :

(1) Augmenter progressivement le nombre de requêtes, de moins en plus, accumulez progressivement des données de point d'accès et atteignez enfin l'état de service normal.

(2) Préparez à l'avance les données « couramment utilisées », « préchauffez » le service de manière proactive, puis ouvrez l'accès au serveur une fois le préchauffage terminé.

Le principe de l'équilibrage de charge TCP est le même que celui de lvs, etc. Il fonctionne à un niveau inférieur et ses performances seront bien supérieures à l'équilibrage de charge http d'origine. Cependant, ce ne sera pas mieux que lvs soit placé dans le module du noyau, alors que nginx fonctionne en mode utilisateur et que nginx est relativement lourd. Un autre point, très regrettable, est que ce module est une fonction payante.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Comment configurer le nom de domaine du serveur cloud dans nginx

Apr 14, 2025 pm 12:18 PM

Comment configurer le nom de domaine du serveur cloud dans nginx

Apr 14, 2025 pm 12:18 PM

Comment configurer un nom de domaine NGINX sur un serveur cloud: Créez un enregistrement A pointant vers l'adresse IP publique du serveur cloud. Ajoutez des blocs d'hôtes virtuels dans le fichier de configuration Nginx, en spécifiant le port d'écoute, le nom de domaine et le répertoire racine du site Web. Redémarrez Nginx pour appliquer les modifications. Accéder à la configuration du test de nom de domaine. Autres notes: Installez le certificat SSL pour activer HTTPS, assurez-vous que le pare-feu autorise le trafic Port 80 et attendez que la résolution DNS prenne effet.

Comment vérifier le nom du conteneur Docker

Apr 15, 2025 pm 12:21 PM

Comment vérifier le nom du conteneur Docker

Apr 15, 2025 pm 12:21 PM

Vous pouvez interroger le nom du conteneur Docker en suivant les étapes: répertorier tous les conteneurs (Docker PS). Filtrez la liste des conteneurs (à l'aide de la commande grep). Obtient le nom du conteneur (situé dans la colonne "Noms").

Comment vérifier si Nginx est démarré

Apr 14, 2025 pm 01:03 PM

Comment vérifier si Nginx est démarré

Apr 14, 2025 pm 01:03 PM

Comment confirmer si Nginx est démarré: 1. Utilisez la ligne de commande: SystemCTl Status Nginx (Linux / Unix), netStat -ano | Findstr 80 (Windows); 2. Vérifiez si le port 80 est ouvert; 3. Vérifiez le message de démarrage NGINX dans le journal système; 4. Utilisez des outils tiers, tels que Nagios, Zabbix et Icinga.

Comment configurer Nginx dans Windows

Apr 14, 2025 pm 12:57 PM

Comment configurer Nginx dans Windows

Apr 14, 2025 pm 12:57 PM

Comment configurer Nginx dans Windows? Installez Nginx et créez une configuration d'hôte virtuelle. Modifiez le fichier de configuration principale et incluez la configuration de l'hôte virtuel. Démarrer ou recharger nginx. Testez la configuration et affichez le site Web. Activer sélectivement SSL et configurer les certificats SSL. Définissez sélectivement le pare-feu pour permettre le trafic Port 80 et 443.

Comment vérifier la version nginx

Apr 14, 2025 am 11:57 AM

Comment vérifier la version nginx

Apr 14, 2025 am 11:57 AM

Les méthodes qui peuvent interroger la version Nginx sont: utilisez la commande nginx -v; Afficher la directive de version dans le fichier nginx.conf; Ouvrez la page d'erreur Nginx et affichez le titre de la page.

Comment démarrer un conteneur par Docker

Apr 15, 2025 pm 12:27 PM

Comment démarrer un conteneur par Docker

Apr 15, 2025 pm 12:27 PM

Étapes de démarrage du conteneur Docker: Tirez l'image du conteneur: Exécutez "Docker Pull [Mirror Name]". Créer un conteneur: utilisez "Docker Create [Options] [Mirror Name] [Commandes et paramètres]". Démarrez le conteneur: exécutez "docker start [nom de conteneur ou id]". Vérifiez l'état du conteneur: vérifiez que le conteneur s'exécute avec "Docker PS".

Comment démarrer le serveur Nginx

Apr 14, 2025 pm 12:27 PM

Comment démarrer le serveur Nginx

Apr 14, 2025 pm 12:27 PM

Le démarrage d'un serveur Nginx nécessite différentes étapes en fonction des différents systèmes d'exploitation: Système Linux / Unix: Installez le package NGINX (par exemple, en utilisant Apt-Get ou Yum). Utilisez SystemCTL pour démarrer un service NGINX (par exemple, sudo systemctl start nginx). Système Windows: téléchargez et installez les fichiers binaires Windows. Démarrer Nginx à l'aide de l'exécutable Nginx.exe (par exemple, nginx.exe -c conf \ nginx.conf). Peu importe le système d'exploitation que vous utilisez, vous pouvez accéder au serveur IP

Comment créer des conteneurs pour Docker

Apr 15, 2025 pm 12:18 PM

Comment créer des conteneurs pour Docker

Apr 15, 2025 pm 12:18 PM

Créer un conteneur dans Docker: 1. Tirez l'image: docker pull [Nom du miroir] 2. Créer un conteneur: docker run [Options] [Nom du miroir] [Commande] 3. Démarrez le conteneur: docker start [Nom du conteneur]