Périphériques technologiques

Périphériques technologiques

IA

IA

Regardez 'Harry Potter' en une seule séance : IA grand modèle 'Quantum Speed Reading', une minute équivaut à cinq heures humaines

Regardez 'Harry Potter' en une seule séance : IA grand modèle 'Quantum Speed Reading', une minute équivaut à cinq heures humaines

Regardez 'Harry Potter' en une seule séance : IA grand modèle 'Quantum Speed Reading', une minute équivaut à cinq heures humaines

Ces derniers temps, OpenAI a été l'institution de recherche la plus regardée avec ses modèles de la série GPT et ChatGPT. Mais au cours des deux dernières années, une start-up d'IA est apparue à la vue de tous. Cette société s'appelle Anthropic. Elle a été fondée en 2021. Elle se concentre sur le développement de systèmes d'IA généraux et de modèles de langage et adhère au concept d'IA responsable. utiliser.

Je me demande si vous vous souvenez encore de la démission collective des principaux employés d’OpenAI fin 2020. À cette époque, cet incident avait fait beaucoup de bruit dans le cercle de l’IA. Anthropic a été créé par ces personnes disparues, dont Dario Amodei, ancien vice-président de la recherche chez OpenAI, Tom Brown, premier auteur de l'article GPT-3, et d'autres.

En janvier de cette année, Anthropic avait levé plus de 700 millions de dollars de financement, son dernier tour de table le valorisant à 5 milliards de dollars. Parallèlement, deux mois après la sortie de ChatGPT, l'entreprise a rapidement développé Claude, un système d'intelligence artificielle qui a benchmarké son ancien club ChatGPT.

Adresse d'accès à l'application Claude : https://www.anthropic.com/earlyaccess

Claude utilise un mécanisme appelé « IA constitutionnelle » développé par Anthropic. Son objectif est de fournir des « principes- ». " basée sur l'alignement des systèmes d'IA sur les intentions humaines.

Claude peut réaliser des tâches telles que la synthèse synthétique, la recherche, l'aide à la création, les questions/réponses, le codage, etc. D'après les commentaires des utilisateurs, Claude est moins susceptible de générer des résultats nuisibles, plus facile à mener des conversations et plus facile à contrôler. De plus, Claude peut définir sa personnalité, son ton et son comportement en fonction d'instructions.

Cependant, Anthropic n'a pas fourni beaucoup de détails techniques sur Claude, mais la technologie derrière Claude est décrite dans l'article "Constitutional AI: Harmlessness from AI Feedback".

Adresse papier : https://arxiv.org/pdf/2212.08073.pdf

Dès janvier, des chercheurs ont testé la quantité maximale de texte que Claude peut traiter en même temps, démontrant qu'il peut rappeler les informations de 8 000 jetons.

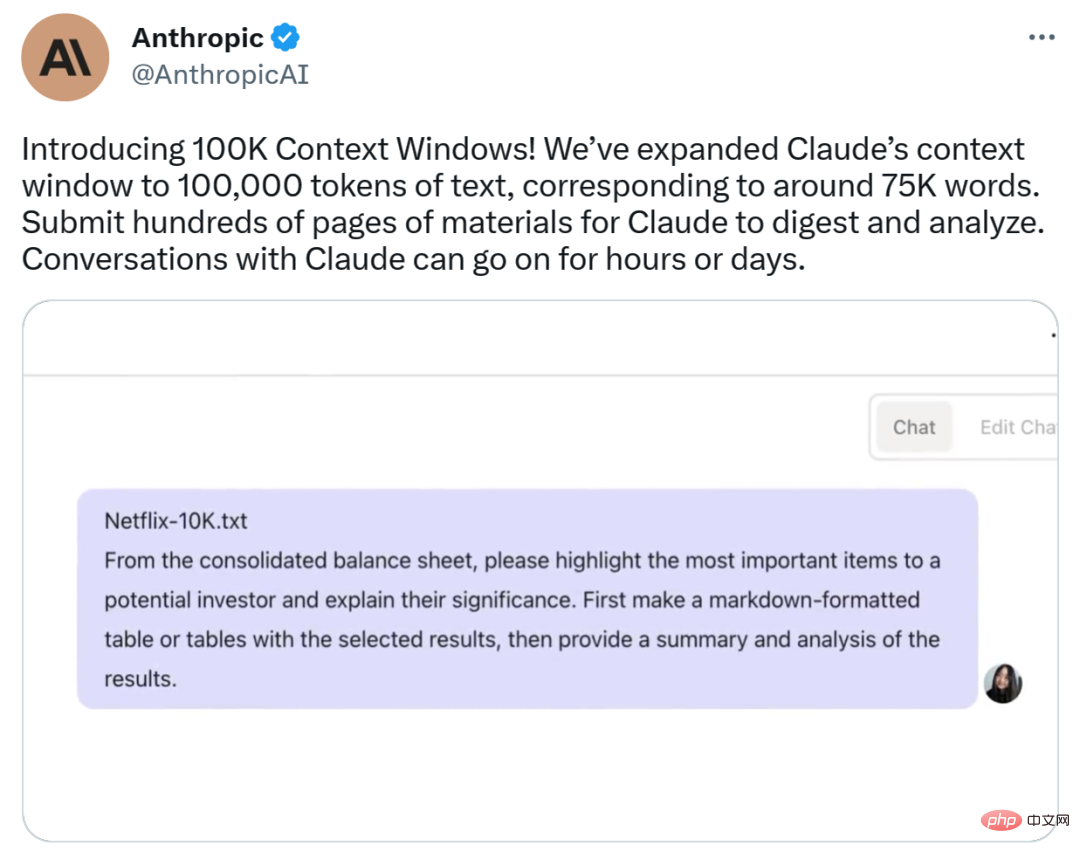

Il n'y a pas si longtemps, ce jeudi, Anthropic a lancé 100K Context Windows, Il étend la fenêtre contextuelle de Claude de 9k jetons à 100k, ce qui équivaut à 75 000 mots. Cela signifie que les entreprises peuvent soumettre des centaines de pages de matériel à Claude pour qu'il les digère et les interprète, et que les conversations avec lui peuvent durer des heures, voire des jours. 100 000 fenêtres contextuelles sont désormais accessibles via l'API Anthropic.

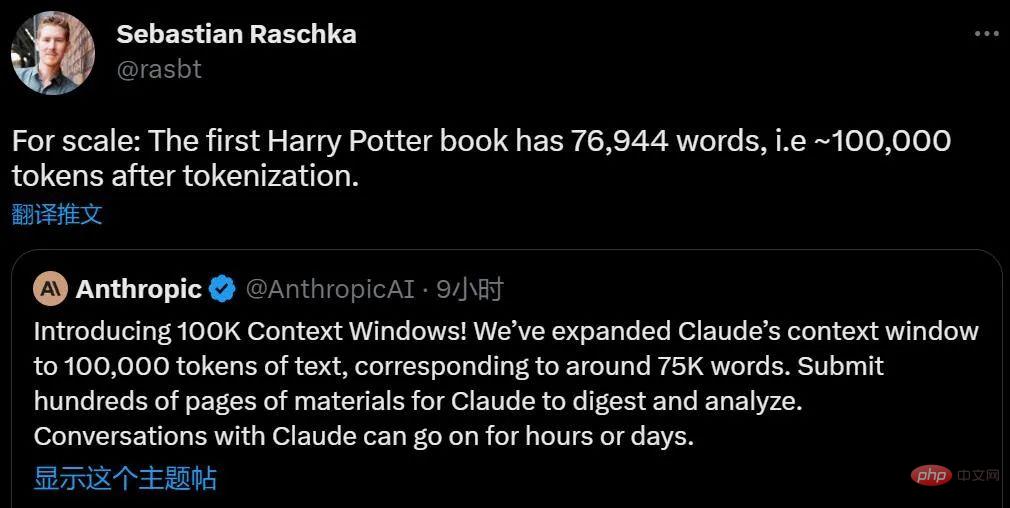

Nous savons que plus le grand modèle est avancé, plus le texte pouvant être traité en même temps est long. Quelle est la notion de 75 000 mots ? Cela équivaut probablement à résumer la première partie de "Harry Potter" en un clic.

On dirait que la grande majorité des essais, des reportages et des nouvelles sont hors de question.

Claude Evolution : véritable "AI Quantum Speed Reading"

Selon des recherches scientifiques, les gens ordinaires peuvent lire 100 000 jetons en 5 heures environ, et peuvent prendre plus de temps pour digérer, mémoriser et analyser ces informations. Maintenant, Claude peut le faire en moins d'une minute.

Calculs généraux pour les fenêtres contextuelles.

Anthropic a d'abord chargé l'intégralité du texte de "The Great Gatsby" dans Claude-Instant (72 K jetons, Claude a deux versions Claude et Claude Instant, Claude est le modèle haute performance le plus avancé, tandis que Claude Instant est plus léger, moins cher, option plus rapide. ) et modifié la ligne "M. Carraway est un ingénieur logiciel travaillant sur l'apprentissage automatique chez Anthropic." Lorsqu'Anthropic a demandé au modèle de trouver les différences par rapport au texte original, il a donné la bonne réponse en 22 secondes.

En plus de lire de longs textes, Claude aide également à récupérer des informations à partir de documents, bénéficiant ainsi aux opérations commerciales . Les utilisateurs peuvent déposer plusieurs documents ou même un livre dans l'invite, puis poser une question à Claude (nécessitant une analyse approfondie des connaissances de nombreuses parties du texte). Pour des problèmes complexes, cela peut être beaucoup plus efficace que les méthodes basées sur la recherche vectorielle. Claude peut suivre les instructions de l'utilisateur et lui renvoyer l'information recherchée, à la manière d'un assistant humain.

Anthropic a ensuite mis la documentation du développeur de l'API LangChain du grand outil d'intégration de langage (240 pages) dans le modèle, puis a donné une démonstration de LangChain utilisant le modèle de langage Anthropic en réponse aux questions posées.

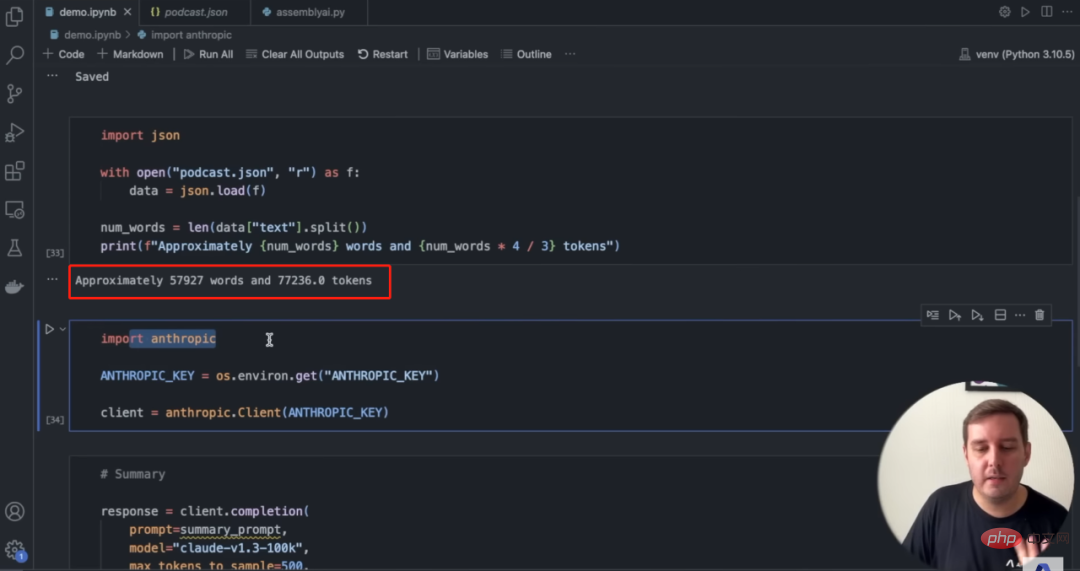

Pendant ce temps, 100 000 jetons peuvent être convertis en environ 6 heures d'audio. AssemblyAI en a fait une excellente démonstration en transcrivant un long podcast en près de 58 000 mots, puis en utilisant Claude pour le résumé et les questions-réponses.

Source de l'image : AssemblyAI

En résumé, en utilisant 100 000 fenêtres contextuelles, les utilisateurs peuvent effectuer les opérations suivantes :

- Digérer, résumer et interpréter des documents denses tels que des états financiers ou documents de recherche ;

- Analyser les risques et opportunités stratégiques sur la base des rapports annuels de l'entreprise ;

- Évaluer les avantages et les inconvénients d'un texte législatif ;

- Nombre de lectures Des centaines de pages de documentation pour les développeurs avec des réponses aux questions techniques ;

- Prototypez rapidement en mettant l'intégralité de votre base de code en contexte et en la construisant ou en la modifiant intelligemment.

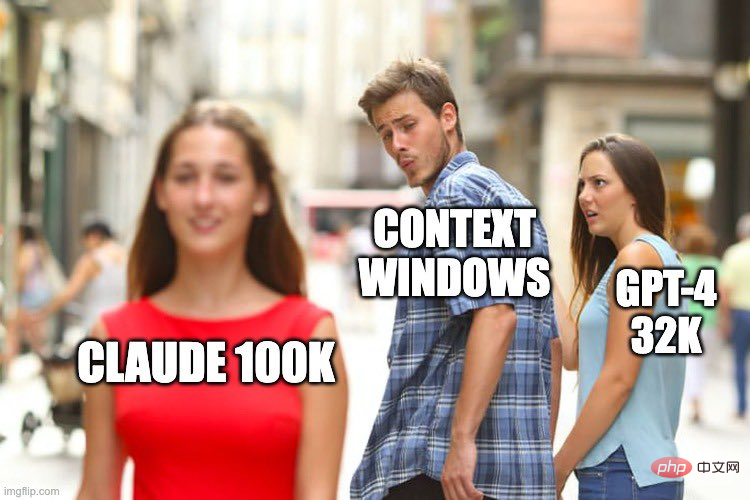

- Certains internautes ont utilisé le mème suivant pour décrire de manière vivante la relation entre Context Windows et Claude 100k et GPT-4 32K.

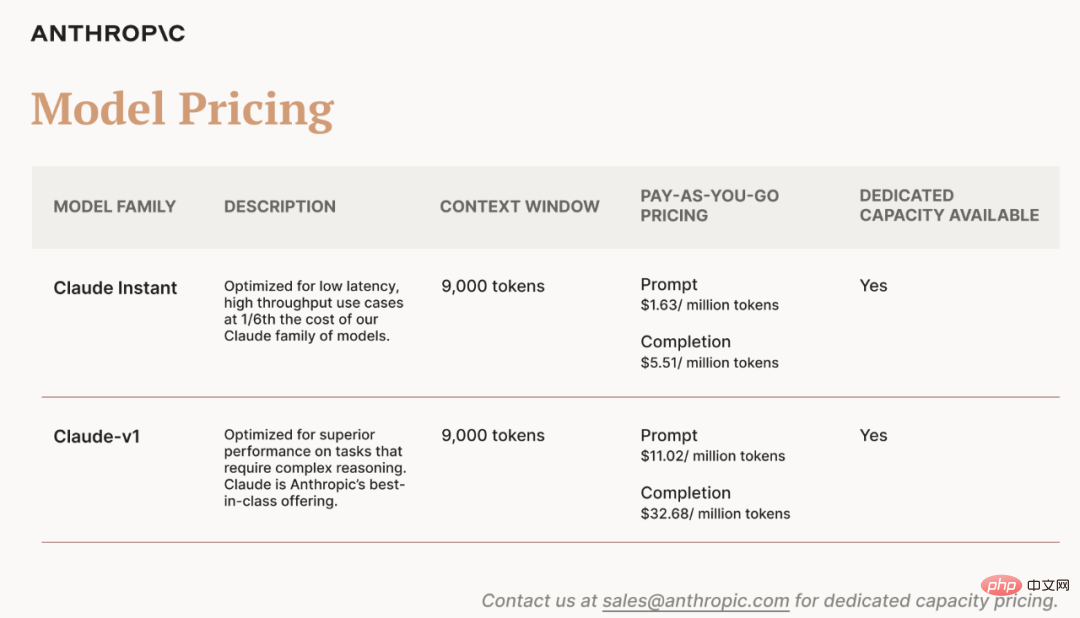

En ce qui concerne le prix, le technicien Anthropic Ben Mann a déclaré que le prix en millions de jetons de 100K Context Windows est le même que celui des modèles précédents.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

Mysql peut-il renvoyer JSON

Apr 08, 2025 pm 03:09 PM

MySQL peut renvoyer les données JSON. La fonction JSON_Extract extrait les valeurs de champ. Pour les requêtes complexes, envisagez d'utiliser la clause pour filtrer les données JSON, mais faites attention à son impact sur les performances. Le support de MySQL pour JSON augmente constamment, et il est recommandé de faire attention aux dernières versions et fonctionnalités.

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Master SQL Limit Clause: Contrôlez le nombre de lignes dans une requête

Apr 08, 2025 pm 07:00 PM

Clause SQLLIMIT: Contrôlez le nombre de lignes dans les résultats de la requête. La clause limite dans SQL est utilisée pour limiter le nombre de lignes renvoyées par la requête. Ceci est très utile lors du traitement de grands ensembles de données, des affichages paginés et des données de test, et peut améliorer efficacement l'efficacité de la requête. Syntaxe de base de la syntaxe: selectColumn1, Column2, ... FromTable_NamelimitNumber_Of_Rows; Number_OF_ROWS: Spécifiez le nombre de lignes renvoyées. Syntaxe avec décalage: selectColumn1, Column2, ... FromTable_Namelimitoffset, numéro_of_rows; décalage: sauter

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Guide d'optimisation des performances de la base de données MySQL dans les applications à forte intensité de ressources, la base de données MySQL joue un rôle crucial et est responsable de la gestion des transactions massives. Cependant, à mesure que l'échelle de l'application se développe, les goulots d'étranglement des performances de la base de données deviennent souvent une contrainte. Cet article explorera une série de stratégies efficaces d'optimisation des performances MySQL pour garantir que votre application reste efficace et réactive dans des charges élevées. Nous combinerons des cas réels pour expliquer les technologies clés approfondies telles que l'indexation, l'optimisation des requêtes, la conception de la base de données et la mise en cache. 1. La conception de l'architecture de la base de données et l'architecture optimisée de la base de données sont la pierre angulaire de l'optimisation des performances MySQL. Voici quelques principes de base: sélectionner le bon type de données et sélectionner le plus petit type de données qui répond aux besoins peut non seulement économiser un espace de stockage, mais également améliorer la vitesse de traitement des données.

Surveillez les gouttelettes MySQL et MariaDB avec Exportateur de Prometheus Mysql

Apr 08, 2025 pm 02:42 PM

Surveillez les gouttelettes MySQL et MariaDB avec Exportateur de Prometheus Mysql

Apr 08, 2025 pm 02:42 PM

Une surveillance efficace des bases de données MySQL et MARIADB est essentielle pour maintenir des performances optimales, identifier les goulots d'étranglement potentiels et assurer la fiabilité globale du système. Prometheus Mysql Exportateur est un outil puissant qui fournit des informations détaillées sur les mesures de base de données qui sont essentielles pour la gestion et le dépannage proactifs.

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé principale de MySQL peut être nul

Apr 08, 2025 pm 03:03 PM

La clé primaire MySQL ne peut pas être vide car la clé principale est un attribut de clé qui identifie de manière unique chaque ligne dans la base de données. Si la clé primaire peut être vide, l'enregistrement ne peut pas être identifié de manière unique, ce qui entraînera une confusion des données. Lorsque vous utilisez des colonnes entières ou des UUIdes auto-incrémentales comme clés principales, vous devez considérer des facteurs tels que l'efficacité et l'occupation de l'espace et choisir une solution appropriée.

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Méthode de Navicat pour afficher le mot de passe de la base de données MongoDB

Apr 08, 2025 pm 09:39 PM

Il est impossible de visualiser le mot de passe MongoDB directement via NAVICAT car il est stocké sous forme de valeurs de hachage. Comment récupérer les mots de passe perdus: 1. Réinitialiser les mots de passe; 2. Vérifiez les fichiers de configuration (peut contenir des valeurs de hachage); 3. Vérifiez les codes (May Code Hardcode).

Master la clause Order Order by dans SQL: Trier efficacement les données

Apr 08, 2025 pm 07:03 PM

Master la clause Order Order by dans SQL: Trier efficacement les données

Apr 08, 2025 pm 07:03 PM

Explication détaillée de la clause SqlorderBy: le tri efficace de la clause de données d'ordre de données est une déclaration clé de SQL utilisée pour trier les ensembles de résultats de requête. Il peut être organisé en ordre ascendant (ASC) ou ordre décroissant (DESC) dans des colonnes uniques ou plusieurs colonnes, améliorant considérablement la lisibilité des données et l'efficacité de l'analyse. OrderBy Syntax selectColumn1, Column2, ... FromTable_NameOrderByColumn_Name [ASC | DESC]; Column_name: Triez par colonne. ASC: Ascendance Order Sort (par défaut). DESC: Trier en ordre décroissant. ORDERBY Fonctionnalités principales: Tri multi-colonnes: prend en charge le tri de plusieurs colonnes et l'ordre des colonnes détermine la priorité du tri. depuis