Périphériques technologiques

Périphériques technologiques

IA

IA

Le père de ChatGPT se dispute à Capitol Hill ! OpenAI veut s'associer au gouvernement pour accéder au pouvoir

Le père de ChatGPT se dispute à Capitol Hill ! OpenAI veut s'associer au gouvernement pour accéder au pouvoir

Le père de ChatGPT se dispute à Capitol Hill ! OpenAI veut s'associer au gouvernement pour accéder au pouvoir

La dernière fois, c'était Zhou Shouzi. Cette fois, c'est au tour de Sam Altman.

Mais cette fois, les membres du Congrès ont eu une attitude complètement différente à son égard : amicaux, patients, ont fait suffisamment de devoirs et ont humblement demandé conseil.

Hier soir, heure de Pékin, Sam Altman, PDG d'OpenAI, a témoigné devant le Sénat américain sur les dangers potentiels de la technologie de l'IA et a exhorté les législateurs à mettre en œuvre des exigences de licence et d'autres réglementations pour les organisations qui fabriquent de l'IA avancée.

Sam Altman n'a pas eu à accepter de questions délicates. Il s'est assis à son siège et a parlé avec aisance, prouvant une fois de plus au monde : en tant que PDG de startup le plus en vue au monde, il écrit. sur la technologie. Les règles et l’avenir du monde.

Face au Congrès américain, Sam Altman l'a encore une fois catégoriquement garanti : OpenAI n'entraînera certainement pas GPT-5 dans les six prochains mois.

Dans le même temps, il a également averti le monde : l'IA peut être nuisible au monde. Afin de faire face aux risques de plus en plus puissants de l'IA, nous devons renforcer la surveillance et la législation, et l'intervention du gouvernement est extrêmement importante.

Pourquoi Altman est-il si actif dans la réglementation gouvernementale ?

Évidemment, tant que vous devenez le faiseur de règles, vous pouvez gagner la compétition où le gagnant remporte tout.

Pour Altman, qui s'est fait un nom dans la Silicon Valley en s'appuyant sur ses attributs de « vache sociale », traiter avec le gouvernement est aussi simple que de sortir quelque chose d'un sac.

Discours d'ouverture généré par l'IA

En tant que nouvelle force apparue soudainement dans le monde de la technologie, OpenAI a remué le monde à une vitesse fulgurante cette année, 8 ans après sa création, obligeant toutes les entreprises technologiques à participer. involution globale à partir de ChatGPT.

Cette course mondiale aux armements en matière d’IA a alarmé de nombreux experts.

Cependant, lors de cette audience, les membres du Sénat n'ont pas critiqué le chaos provoqué par la technologie OpenAI, mais ont humblement sollicité l'avis de témoins sur les règles potentielles de ChatGPT. Leur attitude envers Sam Atlman est visible aux yeux du public. à l’œil nu. Soyez amical et respectueux.

Au début de l'audience, le sénateur Richard Blumenthal a utilisé un logiciel de clonage vocal pour copier son propre timbre, a demandé à ChatGPT d'écrire une déclaration d'ouverture et a formé un générateur de synthèse vocale en utilisant des heures de parole.

Cette décision prouve que le Congrès a une attitude claire envers "l'adoption de l'IA".

L'IA est dangereuse, réglez-nous s'il vous plaît

Lors de cette audience, les législateurs étaient visiblement très enthousiastes, ce qui contrastait fortement avec leurs doutes précédents à propos de Xiao Zha et Zhou Shouzi.

Plutôt que de ressasser les erreurs du passé, les sénateurs sont impatients de profiter des avantages que l’IA peut apporter.

Et Altman a dit au Sénat droit au but : la technologie de l'IA peut mal tourner.

Il a déclaré qu'il était très inquiet du fait que l'industrie de l'intelligence artificielle causerait un préjudice important au monde.

"Si la technologie de l'IA tourne mal, les conséquences seront désastreuses. Nous devons en parler : nous voulons travailler avec le gouvernement pour empêcher que cela ne se produise

"Nous pensons qu'une intervention réglementaire du gouvernement est nécessaire." est de plus en plus puissant pour atténuer le risque des modèles d'IA. Par exemple, le gouvernement américain pourrait envisager de combiner les exigences en matière de licences et de tests pour développer et publier des modèles d'IA qui dépassent les seuils de capacité. Altman a déclaré qu'il était très inquiet que l'élection soit affectée par le contenu généré par l'IA, il doit donc y avoir une supervision adéquate à cet égard. En réponse, le sénateur Dick Durbin a déclaré qu'il était remarquable que de grandes entreprises viennent au Sénat pour « faire plaisir à notre réglementation ». Comment réguler ? Altman a déjà pensé au gouvernement. A l'audience, il a proposé un plan systématique. 1. Créer une nouvelle agence gouvernementale chargée de délivrer des licences pour les grands modèles d'IA et révoquer les licences pour les modèles qui ne répondent pas aux normes. Il estime qu'il n'est pas nécessaire de mettre en œuvre ce système de réglementation des licences pour les technologies qui ne peuvent pas atteindre le niveau des modèles à grande échelle de pointe. Pour encourager l’innovation, le Congrès pourrait fixer des seuils de compétence pour protéger les petites entreprises et les chercheurs des contraintes réglementaires. 2. Créer un ensemble de normes de sécurité pour les modèles d'IA, y compris une évaluation de leurs capacités dangereuses. Par exemple, les modèles doivent passer des tests de sécurité, comme s'ils peuvent « s'auto-répliquer » et « circuler en dehors de la supervision ». 3. Exiger que des experts indépendants réalisent un audit indépendant de la performance du modèle sur divers indicateurs. Lorsque le sénateur lui a demandé s'il serait prêt à assumer ce rôle, Altman a déclaré : "Je suis satisfait du travail actuel, mais il serait heureux de fournir une liste parmi laquelle le Congrès pourra choisir." Altman a déclaré que parce que les modèles d'IA peuvent « persuader, manipuler, influencer le comportement et les croyances d'une personne » et même « créer de nouveaux agents biologiques », les licences sont indispensables. Il serait plus simple d'accorder une licence à tous les systèmes au-dessus d'un certain seuil de puissance de calcul, mais Altman a déclaré qu'il préférerait tracer des lignes réglementaires basées sur des capacités spécifiques. Altman a proposé trois solutions :

Alors, le modèle d'OpenAI est-il sûr ?

Altman a déclaré à plusieurs reprises que tout le monde peut être rassuré.

Il a déclaré que le modèle GPT-4 répondrait de manière plus intentionnelle et authentique que tout autre modèle similaire, et rejetterait définitivement les demandes nuisibles car GPT-4 a subi de nombreux tests et audits préalables à la publication.

"Avant de publier un nouveau système, OpenAI effectue des tests approfondis, engage des experts externes pour effectuer des examens détaillés et des audits indépendants, améliore le comportement du modèle et met en œuvre des systèmes de sécurité et de surveillance solides

"Dans Avant de publier GPT." -4, nous avons passé plus de six mois à mener une évaluation approfondie, une équipe rouge externe et des tests de capacités dangereux

Et le mois dernier, les utilisateurs de ChatGPT ont pu désactiver l'historique des discussions pour éviter que leurs données personnelles ne soient utilisées pour s'entraîner. Modèles d'IA.

Cependant, il y a aussi des gens aux yeux perçants qui ont découvert le "point hua". La proposition d'Altman n'implique pas deux points qui sont vivement débattus par le public -

1 Exiger que les modèles d'IA divulguent la source de. leurs données de formation.

2. Il est interdit aux modèles d'IA d'utiliser des œuvres protégées par des droits de propriété intellectuelle à des fins de formation.

Eh bien, c'est-à-dire qu'Altman a évité très intelligemment ces deux points controversés.

Les propositions d'Altman concernant les règles de sécurité de l'IA ont été saluées par les législateurs, qui ont parfois exprimé leur gratitude pour son témoignage. Le sénateur Altman, R-LA, a même contacté Altman pour lui demander s'il serait intéressé à travailler au sein de l'agence de régulation créée par le Congrès.

Le Congrès est déterminé à réglementer l’intelligence artificielle, et il y a des premiers signes. Plus tôt ce mois-ci, Altman, ainsi que les PDG de Google, Microsoft et Nvidia, ont rencontré la vice-présidente Kamala Harris à la Maison Blanche pour discuter du développement d'une IA responsable.

Dès l'année dernière, la Maison Blanche a proposé la « Déclaration des droits de l'intelligence artificielle » pour proposer diverses exigences à l'industrie, comme la prévention de la discrimination.

Par rapport à la bombe atomique, il est recommandé de créer une organisation internationale similaire à l'Agence internationale de l'énergie atomique

Le sénateur a proposé de comparer l'IA à la bombe atomique.

Altman, faisant référence aux pratiques des gouvernements du monde entier en matière de réglementation des armes nucléaires, a proposé l'idée de créer une agence similaire à l'Agence internationale de l'énergie atomique pour formuler des règles mondiales pour l'industrie.

OpenAI ne formera pas GPT-5 dans les six prochains mois

Dans la deuxième interview avec Lex Fridman en avril, Sam Altman a déclaré de manière concluante : "Nous n'entraînons pas GPT-5 maintenant, à l'heure actuelle, nous sommes je fais juste plus de travail sur la base de GPT-4 "

Au cours de cette audience, Altman a directement admis qu'il n'y avait aucune possibilité de formation OpenAI dans les 6 prochains mois. Prévoyez de devenir un nouveau modèle de. GPT-5.

Et cela devrait signifier que plus tard cette année, Google disposera de son système d'intelligence artificielle le plus puissant à ce jour : le projet Gemini.

On dit que Gemini est conçu pour les innovations futures telles que le stockage et la planification. Il est non seulement multimodal dès le départ, mais également très efficace dans l'intégration d'outils et d'API. Il est actuellement développé par la nouvelle équipe Google Deepmind.

Marcus : OpenAI prétend être pour toute l'humanité, mais les données ne sont pas transparentes

Gary Marcus, professeur de psychologie et de neurosciences à l'Université de New York, est également apparu à la barre des témoins.

Il est encore plus agressif que les membres du Congrès.

Sa question à Sam Altman peut être qualifiée de « mortelle ».

Le but de la création d’OpenAI n’est-il pas de bénéficier à toute l’humanité ? Pourquoi tente-t-il maintenant de former une alliance avec Microsoft ?

OpenAI n'est pas ouvert et les données d'entraînement de GPT-4 ne sont pas transparentes. Qu'est-ce que cela signifie ?

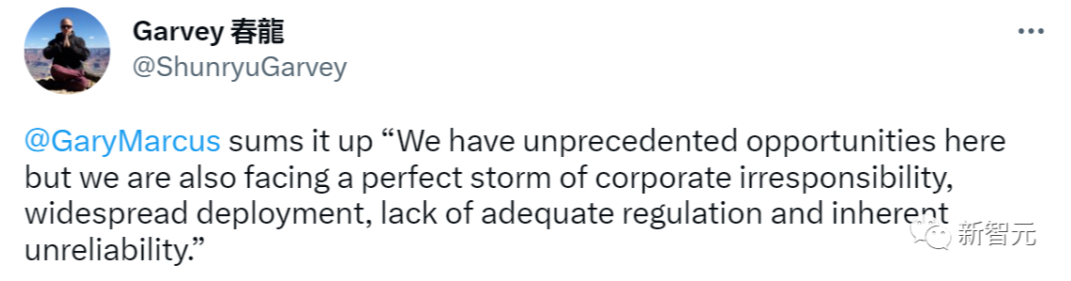

Marcus conclut : Nous avons des opportunités sans précédent, mais nous sommes également confrontés à de terribles risques d'irresponsabilité des entreprises, de déploiement généralisé, de manque de réglementation appropriée et de manque de fiabilité

Pour Marcus In Si, il y a quelque chose de très mal avec ce que font Open et Microsoft.

Bing AI Sydney de Microsoft a montré un jour une série de comportements choquants.

"Sydney a un gros problème. Si c'était moi, je le retirerais immédiatement du marché, mais Microsoft ne l'a pas fait."

Marcus a déclaré que cet incident lui avait sonné un signal d'alarme - — Même une organisation à but non lucratif comme OpenAI peut être rachetée par une grande entreprise et faire ce qu’elle veut.

Mais désormais, les opinions et la vie des gens sont subtilement façonnées et modifiées par l’IA. Et si quelqu’un utilisait délibérément la technologie de l’IA à de mauvaises fins ?

Marcus était très inquiet à ce sujet.

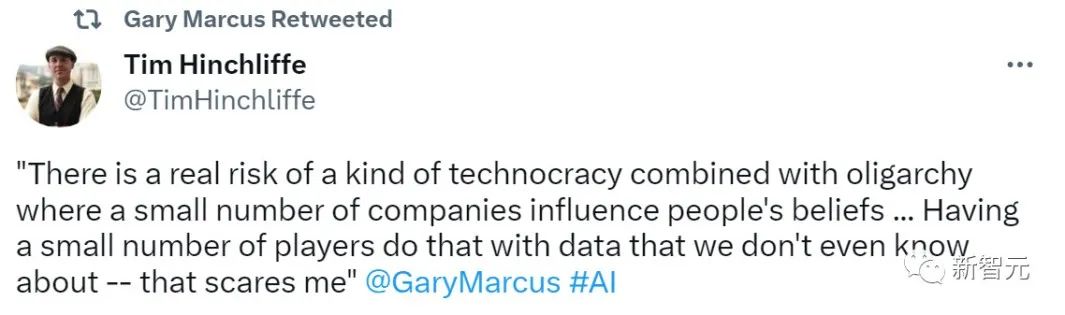

"Il y a un risque réel à permettre une combinaison de technocratie et d'oligarchie où quelques entreprises peuvent influencer les croyances des gens... laisser une poignée d'acteurs utiliser ce que nous fondamentalement. Cela me fait peur de ne pas connaître les données pour ce faire »

Altman a déclaré qu'il n'y a pas de monopole dans l'industrie de l'IA

En ce qui concerne certaines questions juridiques et réglementaires courantes, on peut voir qu'Altman a déjà eu un plan en tête, Les dispositions sont clairement prises pour tous les sénateurs.

Le sénateur a déclaré que l'une de ses « plus grandes préoccupations » concernant l'intelligence artificielle est « ce monopole massif des entreprises ».

Il a cité comme exemple la coopération d’OpenAI avec le géant de la technologie Microsoft.

Altman a déclaré qu'il pensait que le nombre d'entreprises capables de fabriquer de grands modèles est relativement faible, ce qui pourrait faciliter la réglementation.

Par exemple, seules quelques entreprises peuvent fabriquer une IA générative à grande échelle, mais la concurrence a toujours existé.

Créer une responsabilité légale pour les grands modèles

L'essor des médias sociaux a été facilité par l'adoption de l'article 230 par le Congrès américain en 1996, qui protégeait les sites Web de toute responsabilité pour les publications des utilisateurs.

Altman estime : Il n'existe actuellement aucun moyen pour les grands modèles d'être protégés par l'article 230. De nouvelles lois devraient être promulguées pour protéger les grands modèles de toute responsabilité légale pour le contenu qu'ils produisent.

Éviter intelligemment la question la plus mortelle

Ultraman a initialement évité la suggestion du sénateur selon laquelle "l'IA pourrait avoir les conséquences les plus graves".

Mais après que Marcus ait rappelé amicalement qu'Altman n'avait pas répondu à la question, le sénateur a répété sa question.

Altman n'a finalement pas répondu directement à cette question.

OpenAI a tenté d'être très clair sur les risques de l'intelligence artificielle, qui pourrait causer "un préjudice important au monde" de "de nombreuses manières différentes".

Il l'a encore clarifié. C’est pour résoudre ce problème qu’OpenAI a été fondé. "Si quelque chose ne va pas avec cette technologie, cela pourrait tourner terriblement mal."

En fait, dans une interview avec "StrictlyVC" plus tôt cette année, Altman a qualifié l'extinction humaine de pire scénario.

Finalement, même Marcus a semblé s'adoucir envers Ultraman.

Vers la fin de l'audience, Marcus, qui était assis à côté d'Altman, a déclaré : "La sincérité lorsqu'il parle de peur est si évidente qu'on ne peut pas la ressentir à travers un écran de télévision." leader technologique

Par rapport à Zuckerberg, la performance d'Altman lors de cette audience était très sophistiquée. Je suppose qu'en tant que vache sociale, il est déjà à l'aise avec les politiciens. Après tout, Altman était quelqu’un qui envisageait de se présenter au poste de gouverneur de Californie il y a des années.

Et comparé à Xiao Zha, qui avait déjà « rencontré beaucoup de problèmes » en raison de la confidentialité des données et de la monnaie avant de se rendre à l'audience, OpenAI derrière Altman n'a non seulement reçu presque aucune critique du public, mais c'est aussi le courant Situation « tout arrive » dans le domaine de l'IA Le fondateur le plus important.

Face à Altman, qui a fait preuve de bonne volonté dès le début et a appelé à une régulation de l'IA, ces législateurs, qui sont presque tous des "amateurs techniques", apparaîtront naturellement beaucoup plus doux et bienveillants face à cette "autorité".

Donc dans la même situation, la pression sur Altman n'est pas du même ordre de grandeur que celle sur Zha.

Grand modèle économique

Le Sénat a soulevé cette préoccupation. Si les produits d'IA adoptent un modèle commercial basé sur la publicité comme les plateformes sociales sur Internet, cela conduira à une conception de produits manipulatrice et à des algorithmes addictifs.

Altman a déclaré qu'il « aime beaucoup » le modèle d'abonnement.

Mais OpenAI a envisagé la possibilité de diffuser des publicités dans la version gratuite de ChatGPT pour gagner de l'argent auprès de ses utilisateurs gratuits.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

Comment utiliser MySQL après l'installation

Apr 08, 2025 am 11:48 AM

L'article présente le fonctionnement de la base de données MySQL. Tout d'abord, vous devez installer un client MySQL, tel que MySQLWorkBench ou le client de ligne de commande. 1. Utilisez la commande MySQL-UROot-P pour vous connecter au serveur et connecter avec le mot de passe du compte racine; 2. Utilisez Createdatabase pour créer une base de données et utilisez Sélectionner une base de données; 3. Utilisez CreateTable pour créer une table, définissez des champs et des types de données; 4. Utilisez InsertInto pour insérer des données, remettre en question les données, mettre à jour les données par mise à jour et supprimer les données par Supprimer. Ce n'est qu'en maîtrisant ces étapes, en apprenant à faire face à des problèmes courants et à l'optimisation des performances de la base de données que vous pouvez utiliser efficacement MySQL.

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Comment définir le délai de Vue Axios

Apr 07, 2025 pm 10:03 PM

Afin de définir le délai d'expiration de Vue Axios, nous pouvons créer une instance AxiOS et spécifier l'option Timeout: dans les paramètres globaux: vue.prototype. $ Axios = axios.create ({timeout: 5000}); Dans une seule demande: ce. $ axios.get ('/ api / utilisateurs', {timeout: 10000}).

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Comment résoudre MySQL ne peut pas être démarré

Apr 08, 2025 pm 02:21 PM

Il existe de nombreuses raisons pour lesquelles la startup MySQL échoue, et elle peut être diagnostiquée en vérifiant le journal des erreurs. Les causes courantes incluent les conflits de port (vérifier l'occupation du port et la configuration de modification), les problèmes d'autorisation (vérifier le service exécutant les autorisations des utilisateurs), les erreurs de fichier de configuration (vérifier les paramètres des paramètres), la corruption du répertoire de données (restaurer les données ou reconstruire l'espace de la table), les problèmes d'espace de la table InNODB (vérifier les fichiers IBDATA1), la défaillance du chargement du plug-in (vérification du journal des erreurs). Lors de la résolution de problèmes, vous devez les analyser en fonction du journal d'erreur, trouver la cause profonde du problème et développer l'habitude de sauvegarder régulièrement les données pour prévenir et résoudre des problèmes.

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Géospatial de Laravel: optimisation des cartes interactives et de grandes quantités de données

Apr 08, 2025 pm 12:24 PM

Traiter efficacement 7 millions d'enregistrements et créer des cartes interactives avec la technologie géospatiale. Cet article explore comment traiter efficacement plus de 7 millions d'enregistrements en utilisant Laravel et MySQL et les convertir en visualisations de cartes interactives. Exigences initiales du projet de défi: extraire des informations précieuses en utilisant 7 millions d'enregistrements dans la base de données MySQL. Beaucoup de gens considèrent d'abord les langages de programmation, mais ignorent la base de données elle-même: peut-il répondre aux besoins? La migration des données ou l'ajustement structurel est-il requis? MySQL peut-il résister à une charge de données aussi importante? Analyse préliminaire: les filtres et les propriétés clés doivent être identifiés. Après analyse, il a été constaté que seuls quelques attributs étaient liés à la solution. Nous avons vérifié la faisabilité du filtre et établi certaines restrictions pour optimiser la recherche. Recherche de cartes basée sur la ville

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Les ingénieurs de backend senior à distance (plates-formes) ont besoin de cercles

Apr 08, 2025 pm 12:27 PM

Ingénieur backend à distance Emploi Vacant Société: Emplacement du cercle: Bureau à distance Type d'emploi: Salaire à temps plein: 130 000 $ - 140 000 $ Description du poste Participez à la recherche et au développement des applications mobiles Circle et des fonctionnalités publiques liées à l'API couvrant l'intégralité du cycle de vie de développement logiciel. Les principales responsabilités complètent indépendamment les travaux de développement basés sur RubyOnRails et collaborent avec l'équipe frontale React / Redux / Relay. Créez les fonctionnalités de base et les améliorations des applications Web et travaillez en étroite collaboration avec les concepteurs et le leadership tout au long du processus de conception fonctionnelle. Promouvoir les processus de développement positifs et hiérarchiser la vitesse d'itération. Nécessite plus de 6 ans de backend d'applications Web complexe

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

Comment optimiser les performances de la base de données après l'installation de MySQL

Apr 08, 2025 am 11:36 AM

L'optimisation des performances MySQL doit commencer à partir de trois aspects: configuration d'installation, indexation et optimisation des requêtes, surveillance et réglage. 1. Après l'installation, vous devez ajuster le fichier my.cnf en fonction de la configuration du serveur, tel que le paramètre innodb_buffer_pool_size, et fermer query_cache_size; 2. Créez un index approprié pour éviter les index excessifs et optimiser les instructions de requête, telles que l'utilisation de la commande Explication pour analyser le plan d'exécution; 3. Utilisez le propre outil de surveillance de MySQL (ShowProcessList, Showstatus) pour surveiller la santé de la base de données, et sauvegarde régulièrement et organisez la base de données. Ce n'est qu'en optimisant en continu ces étapes que les performances de la base de données MySQL peuvent être améliorées.

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Comment optimiser les performances MySQL pour les applications de haute charge?

Apr 08, 2025 pm 06:03 PM

Guide d'optimisation des performances de la base de données MySQL dans les applications à forte intensité de ressources, la base de données MySQL joue un rôle crucial et est responsable de la gestion des transactions massives. Cependant, à mesure que l'échelle de l'application se développe, les goulots d'étranglement des performances de la base de données deviennent souvent une contrainte. Cet article explorera une série de stratégies efficaces d'optimisation des performances MySQL pour garantir que votre application reste efficace et réactive dans des charges élevées. Nous combinerons des cas réels pour expliquer les technologies clés approfondies telles que l'indexation, l'optimisation des requêtes, la conception de la base de données et la mise en cache. 1. La conception de l'architecture de la base de données et l'architecture optimisée de la base de données sont la pierre angulaire de l'optimisation des performances MySQL. Voici quelques principes de base: sélectionner le bon type de données et sélectionner le plus petit type de données qui répond aux besoins peut non seulement économiser un espace de stockage, mais également améliorer la vitesse de traitement des données.

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Comprendre les propriétés acides: les piliers d'une base de données fiable

Apr 08, 2025 pm 06:33 PM

Une explication détaillée des attributs d'acide de base de données Les attributs acides sont un ensemble de règles pour garantir la fiabilité et la cohérence des transactions de base de données. Ils définissent comment les systèmes de bases de données gérent les transactions et garantissent l'intégrité et la précision des données même en cas de plantages système, d'interruptions d'alimentation ou de plusieurs utilisateurs d'accès simultanément. Présentation de l'attribut acide Atomicité: une transaction est considérée comme une unité indivisible. Toute pièce échoue, la transaction entière est reculée et la base de données ne conserve aucune modification. Par exemple, si un transfert bancaire est déduit d'un compte mais pas augmenté à un autre, toute l'opération est révoquée. BeginTransaction; UpdateAccountSsetBalance = Balance-100Wh