Périphériques technologiques

Périphériques technologiques

IA

IA

Un article parle du problème de synchronisation de l'horodatage de l'étalonnage du lidar et de la caméra

Un article parle du problème de synchronisation de l'horodatage de l'étalonnage du lidar et de la caméra

Un article parle du problème de synchronisation de l'horodatage de l'étalonnage du lidar et de la caméra

01 Caractéristiques de la caméra - Exposition et lecture

La caméra acquérant une image est divisée en deux étapes : exposition et lecture. En fonction du capteur utilisé par l'appareil photo, la relation de chevauchement entre le temps d'exposition de l'appareil photo et le temps de lecture est également différente, et peut être divisée en exposition superposée et exposition non superposée.

Par rapport à l'exposition sans chevauchement, l'exposition avec chevauchement peut réduire l'impact du temps d'exposition sur le temps de dessin.

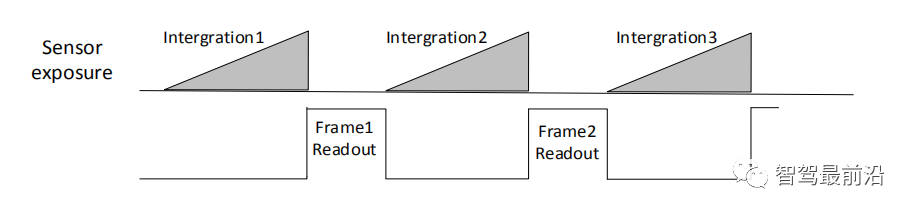

Phrase réécrite : Une fois l'exposition et la lecture de l'image actuelle terminées, l'exposition et la lecture de l'image suivante sont effectuées. Il s'agit d'une exposition sans chevauchement. La période de trame d'exposition sans chevauchement est supérieure à la somme du temps d'exposition et du temps de lecture de trame.

Mode de déclenchement interne, exposition sans chevauchement

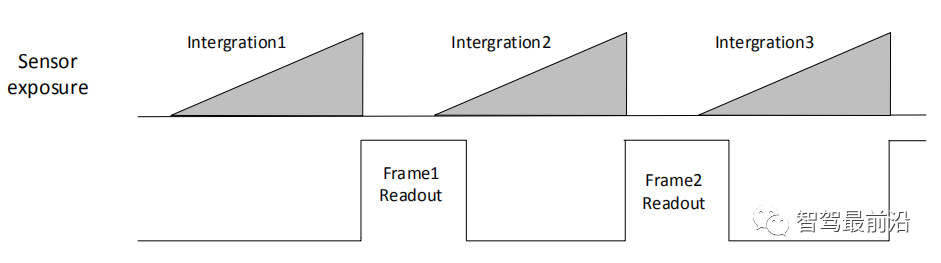

L'exposition qui se chevauche signifie que l'exposition de l'image actuelle chevauche partiellement le processus de lecture de l'image précédente, c'est-à-dire l'image suivante. l’exposition a commencé alors que la lecture de l’image précédente est toujours en cours. La période de trame d'exposition qui se chevauche est inférieure ou égale à la somme du temps d'exposition et du temps de lecture de trame.

Mode de déclenchement interne chevauchant l'exposition

Oui ! Le but du paragraphe précédent est de vous dire : ne soyez pas surpris si le temps d'exposition de l'image actuelle chevauche le temps de lecture de l'image précédente dans la description suivante.

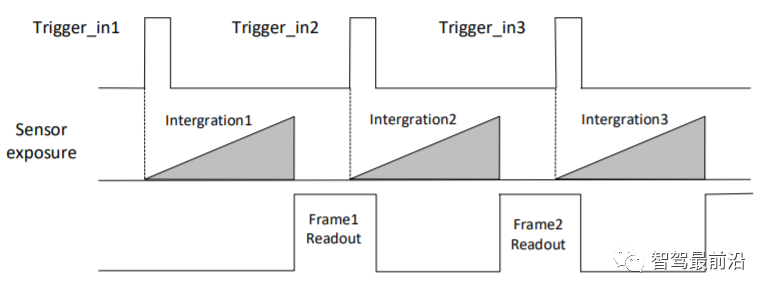

02 Acquisition d'images : mode de déclenchement (entrée externe)

Le mode de déclenchement de la caméra est divisé en deux types : le mode de déclenchement interne et le mode de déclenchement externe.

Mode de déclenchement interne : la caméra collecte des images grâce au signal émis à l'intérieur de l'appareil.

Mode de déclenchement externe : la caméra collecte des images via des signaux externes. Le déclencheur logiciel et le déclencheur matériel sont les deux principales formes de signaux externes. Les signaux externes peuvent être des signaux logiciels ou des signaux matériels. Le mode de déclenchement externe est comme indiqué sur la figure :

Mode de déclenchement externe

Déclenchement logiciel : Le signal de déclenchement est envoyé par le logiciel (vous pouvez également utiliser l'interface API fournie par la caméra SDK pour déclencheur logiciel).

Lors de l'utilisation du déclencheur matériel, la caméra se connecte au périphérique externe via son interface E/S et reçoit le signal d'impulsion de déclenchement du périphérique externe pour collecter des images. En fait, il lit et écrit directement les registres internes de la caméra. L'image ci-dessous représente le câble à 6 broches de l'alimentation IO de la caméra Hikvision :

Alimentation de la caméra Hikvision et interface IO (Hirose 6 broches )

Parmi eux, la caméra Hikvision dispose d'1 entrée isolée par optocoupleur Line0+ et d'1 entrée et sortie configurables Line2+, dont l'une peut être sélectionnée comme signal d'entrée.

03 Sortie de déclenchement

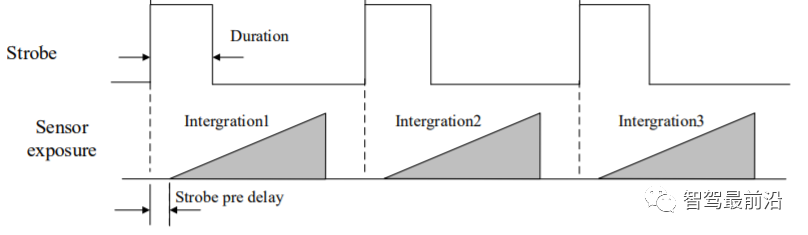

Le signal de sortie de déclenchement de la caméra est un signal de commutation, qui peut être utilisé pour contrôler des appareils externes tels que des lumières d'alarme, des sources lumineuses et un PLC. Le signal de sortie de déclenchement peut être réalisé via le signal stroboscopique.

Lorsque la caméra est exposée, elle génère immédiatement un signal stroboscopique de haut niveau efficace. Dans la suite, nous utilisons principalement ce signal pour effectuer des déclenchements durs sur d'autres capteurs tels que le Lidar. Il existe un concept de pré-sortie stroboscopique. Le signal stroboscopique prend effet avant l'exposition. Son principe de fonctionnement est de retarder l'exposition et d'effectuer d'abord la sortie stroboscopique. Cette fonction peut être appliquée aux appareils externes qui répondent lentement. La synchronisation de la pré-sortie stroboscopique est indiquée sur la figure. (Je parlerai plus tard des raisons pour lesquelles une exposition retardée est nécessaire).

Synchronisation de pré-sortie du signal stroboscopique

Revenons maintenant au sujet, ça va être rapide maintenant.

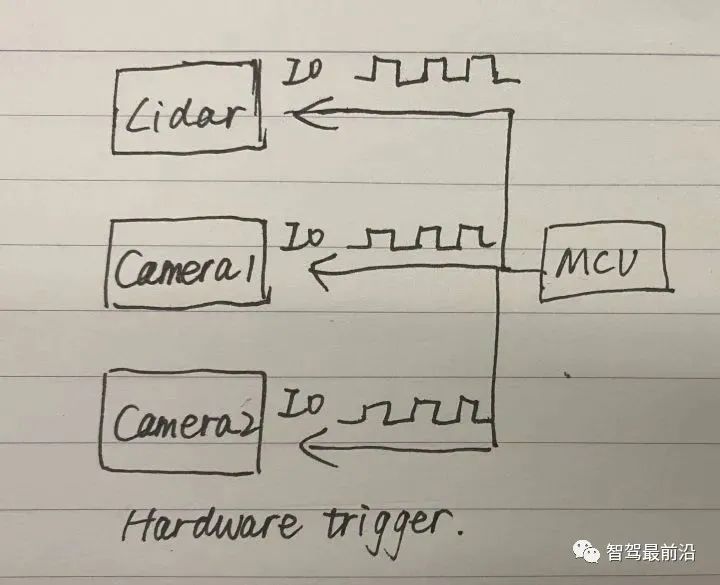

Il existe trois manières principales de synchroniser les horodatages de la caméra et du lidar : le déclenchement dur, le déclenchement doux et le déclenchement doux plus un déclenchement dur. Ci-dessous, je les présente un par un sous la forme d'un diagramme schématique dessiné à la main.

Parlons d’abord du déclenchement difficile. Un MCU génère des signaux d'impulsion pour déclencher trois capteurs.

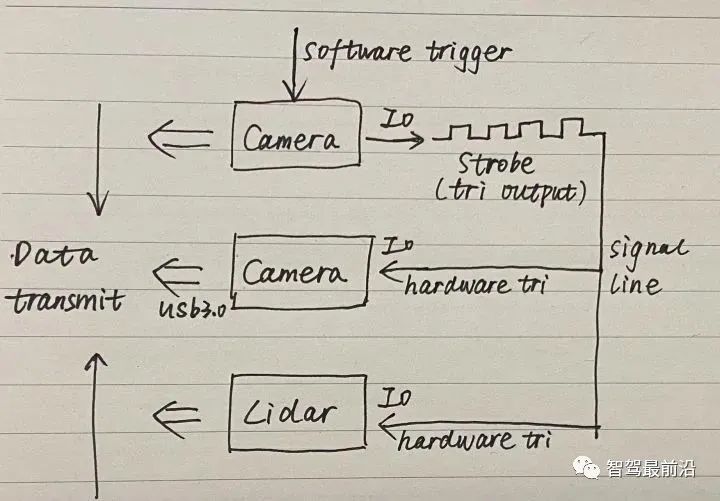

Pour un déclenchement doux + un déclenchement dur, vous pouvez d'abord utiliser l'API du SDK de la caméra pour déclencher en douceur une caméra, puis utiliser le signal de déclenchement externe Strobe de la caméra pour effectuer un déclenchement dur sur d'autres capteurs tels que le radar. et des caméras.

Il y a un problème qui doit être noté ici. Si la première caméra à déclenchement doux émet un signal stroboscopique en même temps que l'exposition, les autres capteurs à déclenchement dur le seront toujours. un pas en retard et ne peut pas être entièrement synchronisé. Par conséquent, le concept proposé précédemment de flash de pré-sortie est introduit, c'est-à-dire que la sortie du flash est effectuée avant l'exposition retardée.

Faites attention à quatre points lors de la configuration de ce mode :

- Méthode de déclenchement par front montant ou descendant

- Largeur de niveau effective, amplitude de niveau, vous devez connaître l'amplitude la plus basse pouvant déclencher le Lidar ;

- Pré-sortie stroboscopique ; ;

- Que les signaux de niveau des deux côtés soient les mêmes, que 3v ou 5v doivent être boostés ;

Enfin, parlons du déclencheur doux qui n'est pas recommandé.

Le premier appel à l'opération API est évidemment plus lent que le déclenchement dur (les opérations de lecture et d'écriture directes sur le registre interne du capteur API(1) ont déjà pris un certain temps avant d'exécuter la deuxième commande API(2).

<code>//读取lidar和image数据的线程1while(1){API(1); //软触发第一个sensorAPI(2); //软触发第二个sensor//假设脉冲周期为0.5s}//处理数据线程2for(i=0;i<nimage gettickcount t1 gettickfrequency></nimage></code>Lorsque le temps requis pour traiter une seule image de données dépasse 0,5 seconde, le thread 1 lira l'image de données suivante, ce qui perturbera les données du thread 2. Le thread 2 doit terminer le traitement d'une seule image en 0,5 seconde et doit attendre après chaque image (1/fps - temps de traitement de l'image actuel).

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

Le papier Stable Diffusion 3 est enfin publié, et les détails architecturaux sont révélés. Cela aidera-t-il à reproduire Sora ?

Mar 06, 2024 pm 05:34 PM

L'article de StableDiffusion3 est enfin là ! Ce modèle est sorti il y a deux semaines et utilise la même architecture DiT (DiffusionTransformer) que Sora. Il a fait beaucoup de bruit dès sa sortie. Par rapport à la version précédente, la qualité des images générées par StableDiffusion3 a été considérablement améliorée. Il prend désormais en charge les invites multithèmes, et l'effet d'écriture de texte a également été amélioré et les caractères tronqués n'apparaissent plus. StabilityAI a souligné que StableDiffusion3 est une série de modèles avec des tailles de paramètres allant de 800M à 8B. Cette plage de paramètres signifie que le modèle peut être exécuté directement sur de nombreux appareils portables, réduisant ainsi considérablement l'utilisation de l'IA.

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Avez-vous vraiment maîtrisé la conversion des systèmes de coordonnées ? Des enjeux multi-capteurs indispensables à la conduite autonome

Oct 12, 2023 am 11:21 AM

Le premier article pilote et clé présente principalement plusieurs systèmes de coordonnées couramment utilisés dans la technologie de conduite autonome, et comment compléter la corrélation et la conversion entre eux, et enfin construire un modèle d'environnement unifié. L'objectif ici est de comprendre la conversion du véhicule en corps rigide de caméra (paramètres externes), la conversion de caméra en image (paramètres internes) et la conversion d'image en unité de pixel. La conversion de 3D en 2D aura une distorsion, une traduction, etc. Points clés : Le système de coordonnées du véhicule et le système de coordonnées du corps de la caméra doivent être réécrits : le système de coordonnées planes et le système de coordonnées des pixels Difficulté : la distorsion de l'image doit être prise en compte. La dé-distorsion et l'ajout de distorsion sont compensés sur le plan de l'image. 2. Introduction Il existe quatre systèmes de vision au total : système de coordonnées du plan de pixels (u, v), système de coordonnées d'image (x, y), système de coordonnées de caméra () et système de coordonnées mondiales (). Il existe une relation entre chaque système de coordonnées,

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

DualBEV : dépassant largement BEVFormer et BEVDet4D, ouvrez le livre !

Mar 21, 2024 pm 05:21 PM

Cet article explore le problème de la détection précise d'objets sous différents angles de vue (tels que la perspective et la vue à vol d'oiseau) dans la conduite autonome, en particulier comment transformer efficacement les caractéristiques de l'espace en perspective (PV) en vue à vol d'oiseau (BEV). implémenté via le module Visual Transformation (VT). Les méthodes existantes sont globalement divisées en deux stratégies : la conversion 2D en 3D et la conversion 3D en 2D. Les méthodes 2D vers 3D améliorent les caractéristiques 2D denses en prédisant les probabilités de profondeur, mais l'incertitude inhérente aux prévisions de profondeur, en particulier dans les régions éloignées, peut introduire des inexactitudes. Alors que les méthodes 3D vers 2D utilisent généralement des requêtes 3D pour échantillonner des fonctionnalités 2D et apprendre les poids d'attention de la correspondance entre les fonctionnalités 3D et 2D via un transformateur, ce qui augmente le temps de calcul et de déploiement.

Le premier modèle mondial de génération de vidéos de scènes de conduite autonomes multi-vues DrivingDiffusion : nouvelles idées pour les données et la simulation BEV

Oct 23, 2023 am 11:13 AM

Le premier modèle mondial de génération de vidéos de scènes de conduite autonomes multi-vues DrivingDiffusion : nouvelles idées pour les données et la simulation BEV

Oct 23, 2023 am 11:13 AM

Quelques réflexions personnelles de l'auteur Dans le domaine de la conduite autonome, avec le développement de sous-tâches/solutions de bout en bout basées sur BEV, les données d'entraînement multi-vues de haute qualité et la construction de scènes de simulation correspondantes sont devenues de plus en plus importantes. En réponse aux problèmes des tâches actuelles, la « haute qualité » peut être divisée en trois aspects : des scénarios à longue traîne dans différentes dimensions : comme les véhicules à courte portée dans les données sur les obstacles et les angles de cap précis lors du découpage des voitures, et les données sur les lignes de voie. . Scènes telles que des courbes avec des courbures différentes ou des rampes/fusions/fusions difficiles à capturer. Celles-ci reposent souvent sur de grandes quantités de données collectées et sur des stratégies complexes d’exploration de données, qui sont coûteuses. Valeur réelle 3D - image hautement cohérente : l'acquisition actuelle des données BEV est souvent affectée par des erreurs d'installation/calibrage du capteur, des cartes de haute précision et l'algorithme de reconstruction lui-même. cela m'a amené à

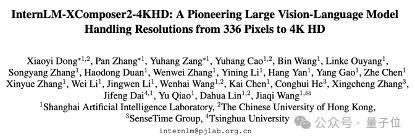

Comprenez facilement les images 4K HD ! Ce grand modèle multimodal analyse automatiquement le contenu des affiches Web, ce qui le rend très pratique pour les travailleurs.

Apr 23, 2024 am 08:04 AM

Comprenez facilement les images 4K HD ! Ce grand modèle multimodal analyse automatiquement le contenu des affiches Web, ce qui le rend très pratique pour les travailleurs.

Apr 23, 2024 am 08:04 AM

Un modèle volumineux capable d'analyser automatiquement le contenu des PDF, des pages Web, des affiches et des graphiques Excel n'est pas très pratique pour les travailleurs. Le modèle InternLM-XComposer2-4KHD (en abrégé IXC2-4KHD) proposé par Shanghai AILab, l'Université chinoise de Hong Kong et d'autres instituts de recherche en fait une réalité. Par rapport à d'autres grands modèles multimodaux qui ont une limite de résolution ne dépassant pas 1 500 x 1 500, ce travail augmente l'image d'entrée maximale des grands modèles multimodaux à une résolution supérieure à 4K (3 840 x 1 600) et prend en charge n'importe quel rapport d'aspect et 336 pixels en 4K. Changements de résolution dynamiques. Trois jours après sa sortie, le modèle était en tête de la liste de popularité des modèles de réponses visuelles aux questions HuggingFace. Facile à manier

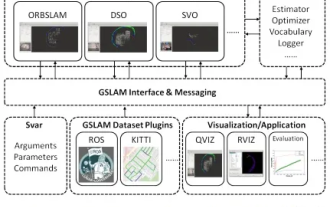

GSLAM | Une architecture générale et un benchmark

Oct 20, 2023 am 11:37 AM

GSLAM | Une architecture générale et un benchmark

Oct 20, 2023 am 11:37 AM

J'ai soudainement découvert un article vieux de 19 ans GSLAM : A General SLAM Framework and Benchmark open source code : https://github.com/zdzhaoyong/GSLAM Accédez directement au texte intégral et ressentez la qualité de ce travail ~ 1 Technologie SLAM abstraite a remporté de nombreux succès récemment et a attiré de nombreuses entreprises de haute technologie. Cependant, la question de savoir comment s'interfacer avec les algorithmes existants ou émergents pour effectuer efficacement des analyses comparatives en termes de vitesse, de robustesse et de portabilité reste une question. Dans cet article, une nouvelle plateforme SLAM appelée GSLAM est proposée, qui fournit non seulement des capacités d'évaluation, mais fournit également aux chercheurs un moyen utile de développer rapidement leurs propres systèmes SLAM.

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

'Minecraft' se transforme en une ville IA et les habitants des PNJ jouent comme de vraies personnes

Jan 02, 2024 pm 06:25 PM

Veuillez noter que cet homme carré fronça les sourcils, pensant à l'identité des « invités non invités » devant lui. Il s’est avéré qu’elle se trouvait dans une situation dangereuse, et une fois qu’elle s’en est rendu compte, elle a rapidement commencé une recherche mentale pour trouver une stratégie pour résoudre le problème. Finalement, elle a décidé de fuir les lieux, de demander de l'aide le plus rapidement possible et d'agir immédiatement. En même temps, la personne de l'autre côté pensait la même chose qu'elle... Il y avait une telle scène dans "Minecraft" où tous les personnages étaient contrôlés par l'intelligence artificielle. Chacun d’eux a un cadre identitaire unique. Par exemple, la jeune fille mentionnée précédemment est une coursière de 17 ans mais intelligente et courageuse. Ils ont la capacité de se souvenir, de penser et de vivre comme des humains dans cette petite ville de Minecraft. Ce qui les anime est une toute nouvelle,