Périphériques technologiques

Périphériques technologiques

IA

IA

Générer des vidéos est si simple, il suffit de donner un indice, et vous pouvez également l'essayer en ligne

Générer des vidéos est si simple, il suffit de donner un indice, et vous pouvez également l'essayer en ligne

Générer des vidéos est si simple, il suffit de donner un indice, et vous pouvez également l'essayer en ligne

Vous saisissez du texte et laissez l'IA générer une vidéo. Cette idée n'est apparue auparavant que dans l'imagination des gens. Aujourd'hui, avec le développement de la technologie, cette fonction a été réalisée.

Ces dernières années, l'intelligence artificielle générative a attiré une grande attention dans le domaine de la vision par ordinateur. Avec l’avènement des modèles de diffusion, la génération d’images de haute qualité à partir d’invites textuelles, c’est-à-dire la synthèse texte-image, est devenue très populaire et couronnée de succès.

Des recherches récentes ont tenté d'étendre avec succès les modèles de diffusion texte-image à la tâche de génération et d'édition texte-vidéo en les réutilisant dans le domaine vidéo. Bien que ces méthodes aient donné des résultats prometteurs, la plupart d’entre elles nécessitent une formation approfondie utilisant de grandes quantités de données étiquetées, ce qui peut s’avérer trop coûteux pour de nombreux utilisateurs.

Afin de rendre la génération vidéo moins chère, Tune-A-Video proposé par Jay Zhangjie Wu et al a introduit l'année dernière un mécanisme appliqué au modèle de diffusion stable (SD). au domaine vidéo. Une seule vidéo doit être ajustée, ce qui réduit considérablement la charge de travail de formation. Bien que cette méthode soit beaucoup plus efficace que les méthodes précédentes, elle nécessite néanmoins une optimisation. De plus, les capacités de génération de Tune-A-Video sont limitées aux applications de montage vidéo guidées par texte, et la composition de vidéos à partir de zéro reste au-delà de ses capacités.

Dans cet article, des chercheurs de Picsart AI Research (PAIR), de l'Université du Texas à Austin et d'autres institutions, en tir zéro et sans formation, dans le texte pour Une avancée dans la nouvelle problématique de la synthèse vidéo, qui consiste à générer des vidéos à partir d'invites textuelles sans aucune optimisation ni mise au point.

- # 🎜 🎜#Adresse papier : https://arxiv.org/pdf/2303.13439.pdf

- Adresse du projet : https://github .com/Picsart-AI-Research/Text2Video-Zero

- Adresse d'essai : https://huggingface.co/spaces/PAIR /Text2Video-Zero

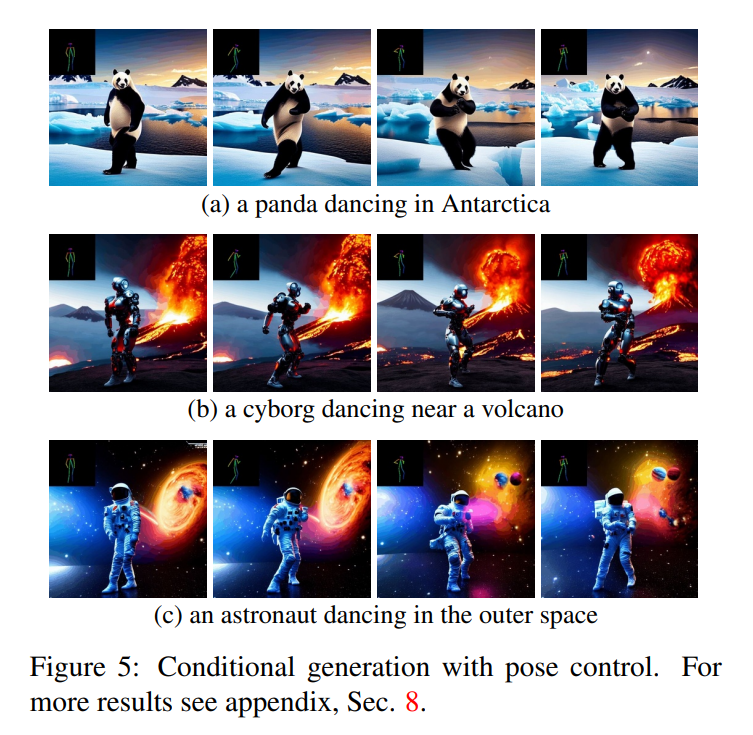

Voyons comment ça marche. Par exemple, un panda surfe ; un ours danse à Times Square : #Cette recherche peut aussi générer des actions basées sur des objectifs : #🎜🎜 #

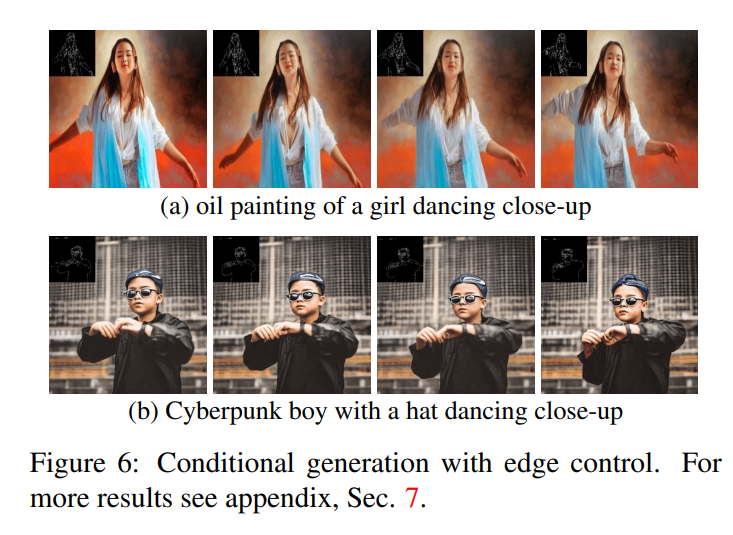

De plus, il peut effectuer une détection de contour :

Un concept clé de la méthode proposée dans cet article est la modification Des modèles texte-image pré-entraînés (par exemple Diffusion stable) l'enrichissent d'une génération cohérente dans le temps. En s'appuyant sur des modèles texte-image déjà formés, notre approche exploite leur excellente qualité de génération d'images, améliorant ainsi leur applicabilité au domaine vidéo sans nécessiter de formation supplémentaire.

Un concept clé de la méthode proposée dans cet article est la modification Des modèles texte-image pré-entraînés (par exemple Diffusion stable) l'enrichissent d'une génération cohérente dans le temps. En s'appuyant sur des modèles texte-image déjà formés, notre approche exploite leur excellente qualité de génération d'images, améliorant ainsi leur applicabilité au domaine vidéo sans nécessiter de formation supplémentaire.

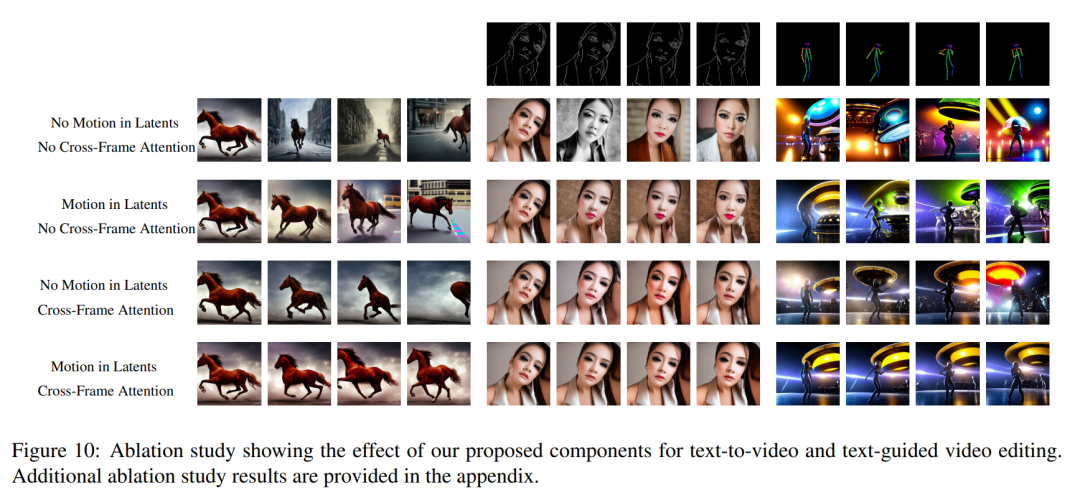

Afin de renforcer la cohérence temporelle, cet article propose deux modifications innovantes : (1) D'abord enrichir l'encodage latent de l'image générée avec des informations de mouvement pour maintenir la scène globale et le temps d'arrière-plan De manière cohérente ; (2) un mécanisme d'attention inter-images est ensuite utilisé pour préserver le contexte, l'apparence et l'identité des objets de premier plan tout au long de la séquence. Les expériences montrent que ces modifications simples peuvent produire des vidéos de haute qualité et cohérentes dans le temps (illustré dans la figure 1).

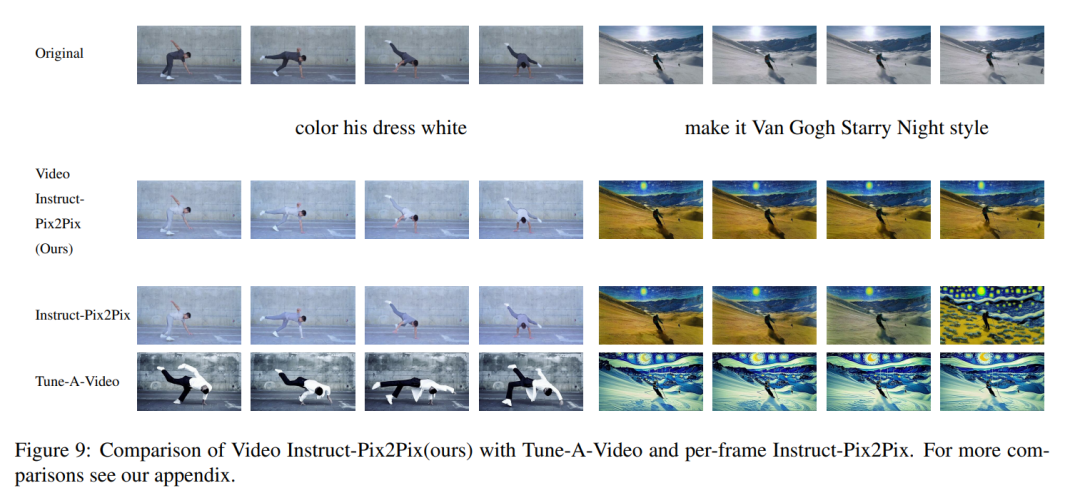

Alors que d'autres personnes travaillent sur des données vidéo à grande échelle, notre approche permet d'obtenir des performances similaires et parfois meilleures (illustrés dans les figures 8, 9). La méthode décrite dans cet article ne se limite pas à la synthèse texte-vidéo, mais convient également aux vidéos conditionnelles (voir Figure 6, 5) et spécialisées. génération (voir Figure 7) et montage vidéo guidé par des instructions, qui peut être appelé Video Instruct-Pix2Pix piloté par Instruct-Pix2Pix (voir Figure 9). Dans cet article, cet article utilise la capacité de synthèse texte-image de Stable Diffusion (SD) pour gérer la tâche de texte-vidéo en zéro -situations de tir. Pour les besoins de génération de vidéo plutôt que de génération d'images, SD doit se concentrer sur le fonctionnement des séquences de code sous-jacentes. L'approche naïve consiste à échantillonner indépendamment m codes potentiels à partir d'une distribution gaussienne standard, c'est-à-dire

, où k = 1,…,m, sont ensuite décodés pour obtenir la séquence vidéo générée

. Cependant, comme le montre la première rangée de la figure 10, cela conduit à une génération d'images complètement aléatoires, partageant uniquement la sémantique décrite par

. Cependant, comme le montre la première rangée de la figure 10, cela conduit à une génération d'images complètement aléatoires, partageant uniquement la sémantique décrite par

Pour résoudre ce problème, cet article propose les deux méthodes suivantes : (i) introduire une dynamique de mouvement entre les encodages latents Notez que pour simplifier la notation, cet article représente l'intégralité de la séquence de code potentielle comme :

Expériences

Résultats qualitatifs

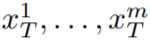

Dans le cas du texte vers vidéo, on peut observer qu'il produit des vidéos de haute qualité qui sont bien alignées avec les invites textuelles (voir Figure 3). Par exemple, un panda est amené à marcher naturellement dans la rue. De même, en utilisant des conseils de bord ou de pose supplémentaires (voir figures 5, 6 et 7), des vidéos de haute qualité correspondant à des invites et à des conseils ont été générées, montrant une bonne cohérence temporelle et une bonne préservation de l'identité.

Dans le cas de Video Instruct-Pix2Pix (voir Figure 1), la vidéo générée a une haute fidélité par rapport à la vidéo d'entrée tout en suivant strictement les instructions.

Comparaison avec la ligne de base

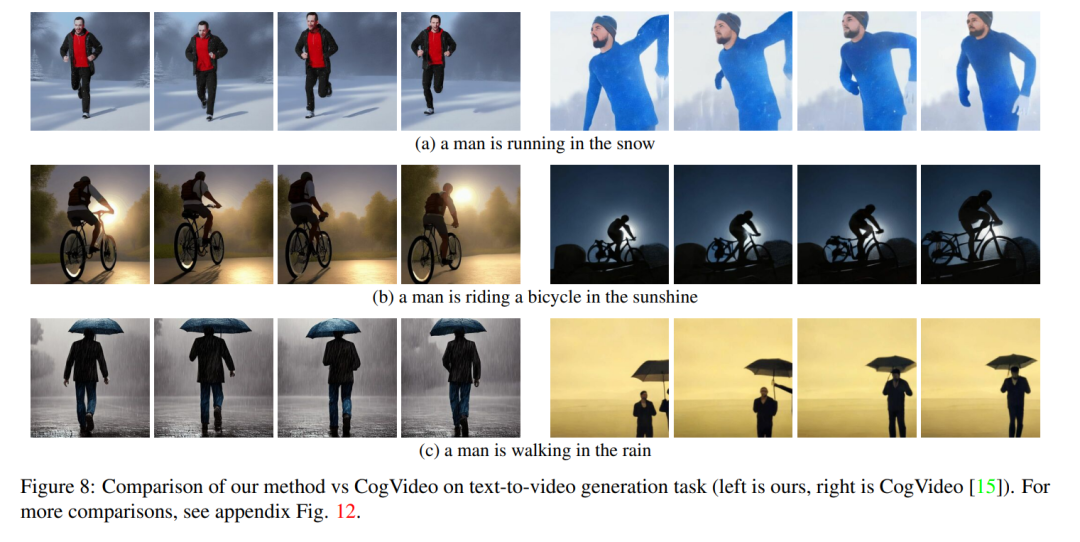

Cet article compare sa méthode avec deux lignes de base accessibles au public : CogVideo et Tune-A-Video. Étant donné que CogVideo est une méthode de conversion texte-vidéo, cet article la compare dans un scénario de synthèse vidéo guidée par texte brut ; en utilisant Video Instruct-Pix2Pix pour une comparaison avec Tune-A-Video.

Pour une comparaison quantitative, cet article utilise le score CLIP pour évaluer le modèle. Le score CLIP représente le degré d'alignement du texte vidéo. En obtenant aléatoirement 25 vidéos générées par CogVideo, et en synthétisant les vidéos correspondantes en utilisant les mêmes astuces selon la méthode présentée dans cet article. Les scores CLIP de notre méthode et de CogVideo sont respectivement de 31,19 et 29,63. Notre méthode est donc légèrement meilleure que CogVideo, même si cette dernière comporte 9,4 milliards de paramètres et nécessite un entraînement à grande échelle sur les vidéos.

La figure 8 montre plusieurs résultats de la méthode proposée dans cet article et fournit une comparaison qualitative avec CogVideo. Les deux méthodes montrent une bonne cohérence temporelle tout au long de la séquence, préservant l'identité de l'objet ainsi que son contexte. Notre méthode montre de meilleures capacités d’alignement texte-vidéo. Par exemple, notre méthode génère correctement une vidéo d'une personne faisant du vélo au soleil dans la figure 8 (b), tandis que CogVideo définit l'arrière-plan au clair de lune. Également sur la figure 8 (a), notre méthode montre correctement une personne courant dans la neige, alors que la neige et la personne qui court ne sont pas clairement visibles dans la vidéo générée par CogVideo.

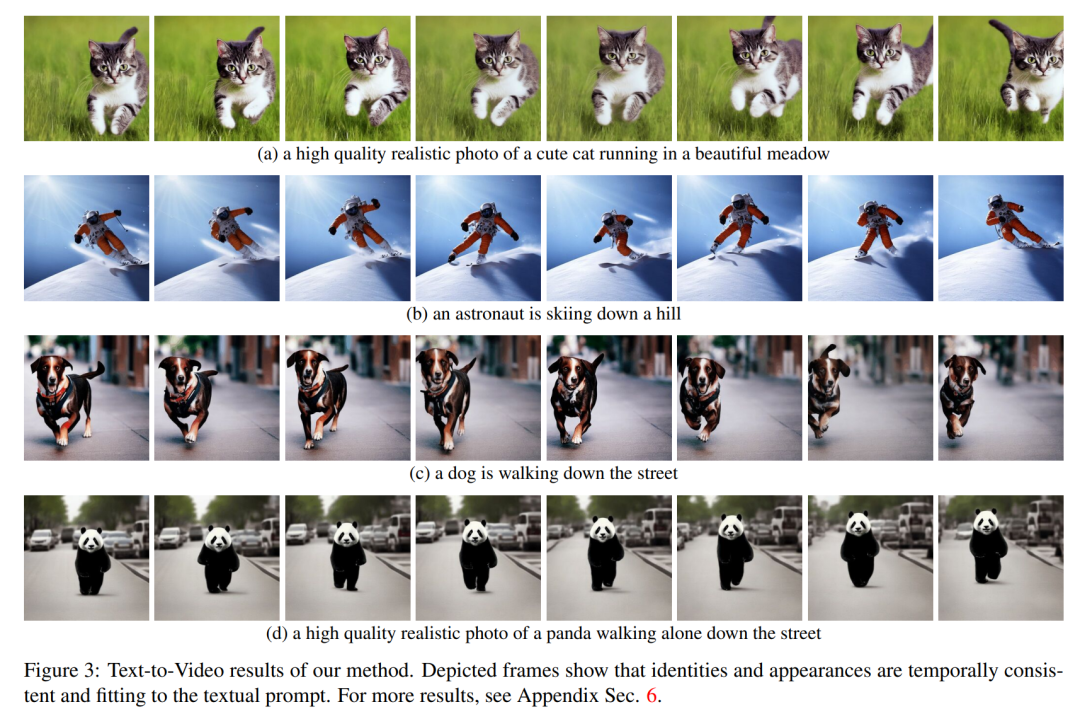

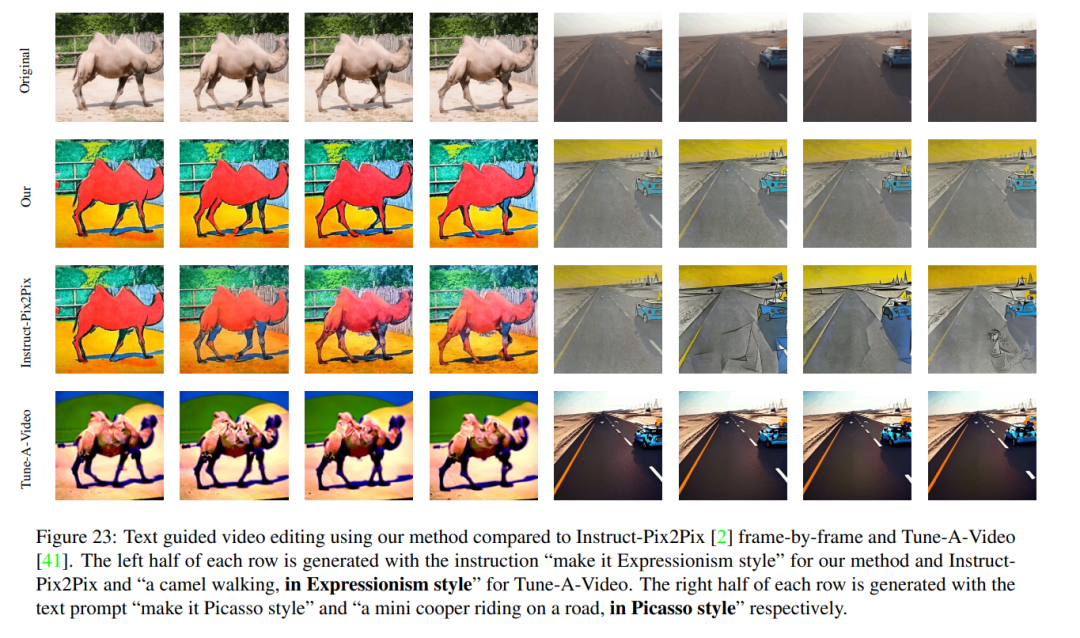

Vidéo Les résultats qualitatifs d'Instruct-Pix2Pix et la comparaison visuelle avec Instruct-Pix2Pix par image et Tune-AVideo sont présentés dans la figure 9. Bien qu'Instruct-Pix2Pix affiche de bonnes performances d'édition par image, il manque de cohérence temporelle. Ceci est particulièrement visible dans les vidéos représentant des skieurs, où la neige et le ciel sont dessinés dans différents styles et couleurs. Ces problèmes ont été résolus à l’aide de la méthode Video Instruct-Pix2Pix, ce qui a permis d’obtenir un montage vidéo temporellement cohérent tout au long de la séquence.

Bien que Tune-A-Video crée une génération vidéo cohérente dans le temps, par rapport à l'approche de cet article, elle est moins cohérente avec les instructions, a des difficultés à créer des modifications locales et perd les détails de la séquence d'entrée. Cela devient évident en regardant le montage de la vidéo du danseur représenté sur la figure 9, à gauche. Par rapport à Tune-A-Video, notre méthode rend l'ensemble de la tenue plus lumineux tout en préservant mieux l'arrière-plan, comme le mur derrière le danseur restant presque inchangé. Tune-A-Video a peint un mur fortement déformé. De plus, notre méthode est plus fidèle aux détails d'entrée. Par exemple, par rapport à Tune-A-Video, Video Instruction-Pix2Pix dessine les danseurs en utilisant les poses fournies (Figure 9 à gauche) et affiche tous les skieurs apparaissant dans la vidéo d'entrée (. Comme le montre le dernier cadre sur le côté droit de la figure 9). Toutes les faiblesses mentionnées ci-dessus de Tune-A-Video peuvent également être observées dans les figures 23 et 24.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Est-ce une infraction de publier des vidéos d'autres personnes sur Douyin ? Comment éditer des vidéos sans infraction ?

Mar 21, 2024 pm 05:57 PM

Est-ce une infraction de publier des vidéos d'autres personnes sur Douyin ? Comment éditer des vidéos sans infraction ?

Mar 21, 2024 pm 05:57 PM

Avec l'essor des plateformes de vidéos courtes, Douyin est devenu un élément indispensable de la vie quotidienne de chacun. Sur TikTok, nous pouvons voir des vidéos intéressantes du monde entier. Certaines personnes aiment publier les vidéos d’autres personnes, ce qui soulève une question : Douyin enfreint-il la publication de vidéos d’autres personnes ? Cet article abordera ce problème et vous expliquera comment éditer des vidéos sans infraction et comment éviter les problèmes d'infraction. 1. Cela porte-t-il atteinte à la publication par Douyin de vidéos d'autres personnes ? Selon les dispositions de la loi sur le droit d'auteur de mon pays, l'utilisation non autorisée des œuvres du titulaire du droit d'auteur sans l'autorisation du titulaire du droit d'auteur constitue une infraction. Par conséquent, publier des vidéos d’autres personnes sur Douyin sans l’autorisation de l’auteur original ou du titulaire des droits d’auteur constitue une infraction. 2. Comment monter une vidéo sans contrefaçon ? 1. Utilisation de contenu du domaine public ou sous licence : Public

Comment gagner de l'argent en publiant des vidéos sur Douyin ? Comment un débutant peut-il gagner de l'argent sur Douyin ?

Mar 21, 2024 pm 08:17 PM

Comment gagner de l'argent en publiant des vidéos sur Douyin ? Comment un débutant peut-il gagner de l'argent sur Douyin ?

Mar 21, 2024 pm 08:17 PM

Douyin, la plateforme nationale de courtes vidéos, nous permet non seulement de profiter d'une variété de courtes vidéos intéressantes et originales pendant notre temps libre, mais nous donne également une scène pour nous montrer et réaliser nos valeurs. Alors, comment gagner de l’argent en postant des vidéos sur Douyin ? Cet article répondra à cette question en détail et vous aidera à gagner plus d’argent sur TikTok. 1. Comment gagner de l’argent en publiant des vidéos sur Douyin ? Après avoir posté une vidéo et obtenu un certain nombre de vues sur Douyin, vous aurez la possibilité de participer au plan de partage publicitaire. Cette méthode de revenus est l’une des plus connues des utilisateurs de Douyin et constitue également la principale source de revenus pour de nombreux créateurs. Douyin décide d'offrir ou non des opportunités de partage de publicités en fonction de divers facteurs tels que le poids du compte, le contenu vidéo et les commentaires du public. La plateforme TikTok permet aux téléspectateurs de soutenir leurs créateurs préférés en envoyant des cadeaux,

Comment publier des vidéos sur Weibo sans compresser la qualité de l'image_Comment publier des vidéos sur Weibo sans compresser la qualité de l'image

Mar 30, 2024 pm 12:26 PM

Comment publier des vidéos sur Weibo sans compresser la qualité de l'image_Comment publier des vidéos sur Weibo sans compresser la qualité de l'image

Mar 30, 2024 pm 12:26 PM

1. Ouvrez d'abord Weibo sur votre téléphone mobile et cliquez sur [Moi] dans le coin inférieur droit (comme indiqué sur l'image). 2. Cliquez ensuite sur [Gear] dans le coin supérieur droit pour ouvrir les paramètres (comme indiqué sur l'image). 3. Ensuite, recherchez et ouvrez [Paramètres généraux] (comme indiqué sur l'image). 4. Entrez ensuite l'option [Video Follow] (comme indiqué sur l'image). 5. Ensuite, ouvrez le paramètre [Résolution de téléchargement vidéo] (comme indiqué sur l'image). 6. Enfin, sélectionnez [Qualité d'image originale] pour éviter la compression (comme indiqué sur l'image).

Quatre outils de programmation assistés par IA recommandés

Apr 22, 2024 pm 05:34 PM

Quatre outils de programmation assistés par IA recommandés

Apr 22, 2024 pm 05:34 PM

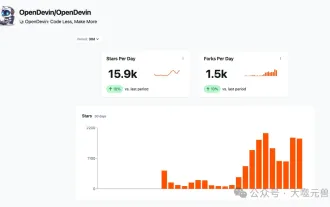

Cet outil de programmation assistée par l'IA a mis au jour un grand nombre d'outils de programmation assistée par l'IA utiles à cette étape de développement rapide de l'IA. Les outils de programmation assistés par l'IA peuvent améliorer l'efficacité du développement, améliorer la qualité du code et réduire les taux de bogues. Ils constituent des assistants importants dans le processus de développement logiciel moderne. Aujourd'hui, Dayao partagera avec vous 4 outils de programmation assistés par l'IA (et tous prennent en charge le langage C#). J'espère que cela sera utile à tout le monde. https://github.com/YSGStudyHards/DotNetGuide1.GitHubCopilotGitHubCopilot est un assistant de codage IA qui vous aide à écrire du code plus rapidement et avec moins d'effort, afin que vous puissiez vous concentrer davantage sur la résolution de problèmes et la collaboration. Git

Comment publier les œuvres vidéo de Xiaohongshu ? À quoi dois-je faire attention lorsque je publie des vidéos ?

Mar 23, 2024 pm 08:50 PM

Comment publier les œuvres vidéo de Xiaohongshu ? À quoi dois-je faire attention lorsque je publie des vidéos ?

Mar 23, 2024 pm 08:50 PM

Avec l'essor des plateformes de vidéos courtes, Xiaohongshu est devenue une plateforme permettant à de nombreuses personnes de partager leur vie, de s'exprimer et de gagner du trafic. Sur cette plateforme, la publication d’œuvres vidéo est un moyen d’interaction très prisé. Alors, comment publier les œuvres vidéo de Xiaohongshu ? 1. Comment publier les œuvres vidéo de Xiaohongshu ? Tout d’abord, assurez-vous d’avoir un contenu vidéo prêt à partager. Vous pouvez utiliser votre téléphone portable ou un autre équipement photo pour prendre des photos, mais vous devez faire attention à la qualité de l'image et à la clarté du son. 2. Editer la vidéo : Afin de rendre le travail plus attrayant, vous pouvez éditer la vidéo. Vous pouvez utiliser un logiciel de montage vidéo professionnel, tel que Douyin, Kuaishou, etc., pour ajouter des filtres, de la musique, des sous-titres et d'autres éléments. 3. Choisissez une couverture : La couverture est la clé pour inciter les utilisateurs à cliquer. Choisissez une image claire et intéressante comme couverture pour inciter les utilisateurs à cliquer dessus.

Deux solutions pour partager des vidéos Web sur navigateur Edge sans son

Mar 14, 2024 pm 02:22 PM

Deux solutions pour partager des vidéos Web sur navigateur Edge sans son

Mar 14, 2024 pm 02:22 PM

De nombreux utilisateurs aiment regarder des vidéos sur le navigateur. S'il n'y a pas de son lorsqu'ils regardent des vidéos Web sur le navigateur Edge, comment résoudre le problème ? Ce problème n'est pas difficile. Ensuite, laissez-moi vous expliquer comment résoudre le problème de l'absence de son dans les vidéos Web du navigateur Edge. Il n'y a pas de son dans les vidéos Web du navigateur Edge ? Méthode 1 : 1. Tout d’abord, vérifiez l’onglet supérieur du navigateur Edge. 2. Il y a un « bouton son » sur le côté gauche de l'onglet, assurez-vous qu'il n'est pas coupé. Méthode 2 : 1. S'il est confirmé que le son n'est pas coupé, il peut s'agir d'un problème de réglage du son. 2. Vous pouvez cliquer avec le bouton droit sur le périphérique audio dans le coin inférieur droit et sélectionner "Ouvrir le synthétiseur de volume". 3. Ouvrir

Apprenez à développer des applications mobiles en utilisant le langage Go

Mar 28, 2024 pm 10:00 PM

Apprenez à développer des applications mobiles en utilisant le langage Go

Mar 28, 2024 pm 10:00 PM

Didacticiel d'application mobile de développement du langage Go Alors que le marché des applications mobiles continue de croître, de plus en plus de développeurs commencent à explorer comment utiliser le langage Go pour développer des applications mobiles. En tant que langage de programmation simple et efficace, le langage Go a également montré un fort potentiel dans le développement d'applications mobiles. Cet article présentera en détail comment utiliser le langage Go pour développer des applications mobiles et joindra des exemples de code spécifiques pour aider les lecteurs à démarrer rapidement et à commencer à développer leurs propres applications mobiles. 1. Préparation Avant de commencer, nous devons préparer l'environnement et les outils de développement. tête

Quel programmeur IA est le meilleur ? Explorez le potentiel de Devin, Tongyi Lingma et de l'agent SWE

Apr 07, 2024 am 09:10 AM

Quel programmeur IA est le meilleur ? Explorez le potentiel de Devin, Tongyi Lingma et de l'agent SWE

Apr 07, 2024 am 09:10 AM

Le 3 mars 2022, moins d'un mois après la naissance de Devin, le premier programmeur d'IA au monde, l'équipe NLP de l'Université de Princeton a développé un agent SWE pour programmeur d'IA open source. Il exploite le modèle GPT-4 pour résoudre automatiquement les problèmes dans les référentiels GitHub. Les performances de l'agent SWE sur l'ensemble de tests du banc SWE sont similaires à celles de Devin, prenant en moyenne 93 secondes et résolvant 12,29 % des problèmes. En interagissant avec un terminal dédié, SWE-agent peut ouvrir et rechercher le contenu des fichiers, utiliser la vérification automatique de la syntaxe, modifier des lignes spécifiques et écrire et exécuter des tests. (Remarque : le contenu ci-dessus est un léger ajustement du contenu original, mais les informations clés du texte original sont conservées et ne dépassent pas la limite de mots spécifiée.) SWE-A