Périphériques technologiques

Périphériques technologiques

IA

IA

L'application ChatGPT est en plein essor. Où trouver une base de big data sécurisée ?

L'application ChatGPT est en plein essor. Où trouver une base de big data sécurisée ?

L'application ChatGPT est en plein essor. Où trouver une base de big data sécurisée ?

Il ne fait aucun doute que l’AIGC apporte un changement profond à la société humaine.

Décollez de son apparence éblouissante et magnifique, le cœur de l'opération ne peut être séparé du support de données massives.

L’« intrusion » de ChatGPT a suscité des inquiétudes concernant le plagiat de contenu dans tous les domaines, ainsi qu’une prise de conscience accrue de la sécurité des données des réseaux.

Bien que la technologie de l'IA soit neutre, elle ne devient pas une raison pour éviter les responsabilités et les obligations.

Récemment, l'agence de renseignement britannique, le British Government Communications Quarters (GCHQ), a averti que ChatGPT et d'autres chatbots d'intelligence artificielle constitueraient une nouvelle menace pour la sécurité.

Bien que le concept de ChatGPT n'existe pas depuis longtemps, les menaces à la sécurité des réseaux et à la sécurité des données sont devenues au centre de l'industrie.

Concernant ChatGPT, qui en est encore à ses premiers stades de développement, de telles inquiétudes sont-elles infondées ?

Des menaces de sécurité pourraient survenir

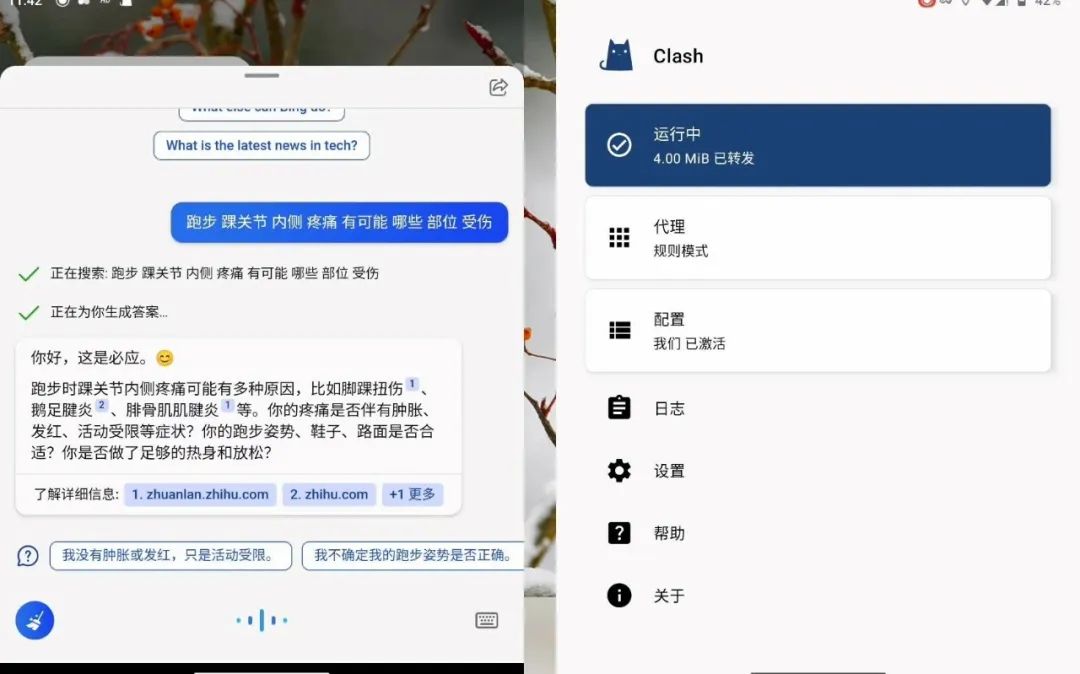

À la fin de l'année dernière, la startup OpenAI a lancé ChatGPT. Après cela, son investisseur Microsoft a lancé cette année un chatbot "Bing Chat" basé sur la technologie ChatGPT.

Parce que ce type de logiciel peut fournir des conversations de type humain, ce service est devenu populaire partout dans le monde. La branche cybersécurité du GCHQ a noté que les entreprises fournissant des chatbots IA peuvent voir les requêtes saisies par les utilisateurs, et dans le cas de ChatGPT, son développeur OpenAI peut les voir.

ChatGPT est formé à travers un grand nombre de corpus de textes, et ses capacités d'apprentissage en profondeur s'appuient fortement sur les données qui le sous-tendent.

En raison de préoccupations concernant les fuites d'informations, de nombreuses entreprises et institutions ont émis des « interdictions ChatGPT ».

Le cabinet d'avocats de la ville de Londres, Mishcon de Reya, a interdit à ses avocats de saisir les données de ses clients dans ChatGPT, craignant que des informations juridiquement privilégiées ne soient divulguées.

Le cabinet de conseil international Accenture a averti ses 700 000 employés dans le monde de ne pas utiliser ChatGPT pour des raisons similaires, craignant que les données confidentielles de ses clients ne finissent entre de mauvaises mains.

Le groupe japonais SoftBank, la société mère de la société britannique de puces informatiques Arm, a également averti ses employés de ne pas saisir les informations d'identité ou les données confidentielles du personnel de l'entreprise dans des chatbots à intelligence artificielle.

En février de cette année, JPMorgan Chase est devenue la première banque d'investissement de Wall Street à restreindre l'utilisation de ChatGPT sur le lieu de travail.

Citigroup et Goldman Sachs ont emboîté le pas, le premier interdisant aux employés l'accès à ChatGPT à l'échelle de l'entreprise et le second interdisant aux employés d'utiliser le produit dans la salle des marchés.

Auparavant, afin d'empêcher les employés de divulguer des secrets lors de l'utilisation de ChatGPT, Amazon et Microsoft leur avaient interdit de partager des données sensibles avec eux, car ces informations pourraient être utilisées comme données de formation pour des itérations ultérieures.

En fait, derrière ces chatbots d'intelligence artificielle se cachent de grands modèles de langage (LLM), et le contenu des requêtes de l'utilisateur sera stocké et utilisé pour développer des services ou des modèles LLM à un moment donné dans le futur.

Cela signifie que le fournisseur LLM sera capable de lire les requêtes associées et éventuellement de les intégrer d'une manière ou d'une autre dans les futures versions.

Bien que les opérateurs LLM doivent prendre des mesures pour protéger les données, la possibilité d'un accès non autorisé ne peut être complètement exclue. Par conséquent, les entreprises doivent s’assurer qu’elles ont des politiques strictes et fournir un support technique pour surveiller l’utilisation de LLM afin de minimiser le risque d’exposition des données.

De plus, bien que ChatGPT lui-même n'ait pas la capacité d'attaquer directement la sécurité des réseaux et des données, en raison de sa capacité à générer et à comprendre le langage naturel, il peut être utilisé pour falsifier de fausses informations, attaquer l'ingénierie sociale, etc.

De plus, les attaquants peuvent également utiliser le langage naturel pour permettre à ChatGPT de générer les codes d'attaque, les codes de logiciels malveillants, les spams, etc.

Par conséquent, l'IA peut permettre à ceux qui sont initialement incapables de lancer des attaques de générer des attaques basées sur l'IA, et d'augmenter considérablement le taux de réussite des attaques.

Avec le soutien de technologies et de modèles tels que l'automatisation, l'IA et « Attack as a Service », les attaques contre la sécurité des réseaux sont en augmentation.

Avant que ChatGPT ne devienne populaire, de nombreuses cyberattaques avaient été menées par des pirates informatiques utilisant la technologie de l'IA.

En fait, il n'est pas rare que l'intelligence artificielle soit ajustée par les utilisateurs pour « s'écarter du rythme ». Il y a six ans, Microsoft a lancé le robot de chat intelligent Tay. Lorsqu'il a été mis en ligne, Tay s'est comporté poliment, mais à l'intérieur. Pendant 24 heures, il a été « mal dirigé » par des utilisateurs sans scrupules, tenant des propos grossiers et grossiers, impliquant même du racisme, de la pornographie et des nazis. Ses propos étaient pleins de discrimination, de haine et de préjugés, il a donc dû être mis hors ligne et mis fin. sa courte vie.

D'un autre côté, le risque plus proche de l'utilisateur est que lors de l'utilisation d'outils d'IA tels que ChatGPT, les utilisateurs peuvent saisir par inadvertance des données privées dans le modèle cloud. Ces données peuvent devenir des données de formation ou être fournies à d'autres. de la réponse, entraînant des violations de données et des risques de non-conformité.

Les applications d'IA doivent poser une base sécurisée

En tant que grand modèle de langage, la logique de base de ChatGPT est en fait la collecte, le traitement, le traitement et la sortie des résultats informatiques de données massives.

De manière générale, ces liens peuvent être associés à des risques sous trois aspects : les éléments techniques, la gestion organisationnelle et le contenu numérique.

Bien que ChatGPT ait déclaré qu'il respecterait strictement les politiques de confidentialité et de sécurité lors du stockage des données requises pour la formation et l'exécution des modèles, des attaques de réseau et l'exploration de données peuvent se produire à l'avenir, et il existe toujours des risques de sécurité des données qui ne peuvent être ignorés. .

Particulièrement lorsqu'il s'agit de la capture, du traitement et de l'utilisation combinée de données de base nationales, de données locales et industrielles importantes et de données personnelles, il est nécessaire d'équilibrer la protection de la sécurité des données et le partage des flux.

En plus des dangers cachés des fuites de données et de confidentialité, la technologie de l'IA présente également des problèmes tels que le biais des données, les fausses informations et la difficulté d'interpréter les modèles, qui peuvent conduire à des malentendus et à la méfiance.

La tendance est arrivée et la vague AIGC arrive. Dans un contexte d'avenir prometteur, il est crucial d'aller de l'avant et d'établir un mur de protection de la sécurité des données.

À mesure que la technologie de l'IA s'améliore progressivement, elle peut non seulement devenir un outil puissant d'amélioration de la productivité, mais elle peut aussi facilement devenir un outil de criminalité illégale.

Les données de surveillance du QiAnXin Threat Intelligence Center montrent que de janvier à octobre 2022, plus de 95 milliards de données institutionnelles chinoises ont été échangées illégalement à l'étranger, dont plus de 57 milliards étaient des informations personnelles.

Assurer la sécurité du stockage, du calcul et de la circulation des données est donc une condition préalable au développement de l'économie numérique.

Dans l'ensemble, la conception de haut niveau et le développement industriel doivent aller de pair. Sur la base de la loi sur la cybersécurité, le système d'analyse des risques et des responsabilités doit être affiné et un mécanisme de responsabilisation en matière de sécurité doit être établi.

Dans le même temps, les autorités de régulation peuvent effectuer des inspections régulières et les entreprises du domaine de la sécurité peuvent travailler ensemble pour construire un système complet de sécurité des données.

Concernant les questions de conformité et de sécurité des données, notamment après l'introduction de la « Loi sur la sécurité des données », la confidentialité des données devient de plus en plus importante.

Si la sécurité et la conformité des données ne peuvent être garanties lors de l'application de la technologie de l'IA, cela peut entraîner de grands risques pour l'entreprise.

En particulier, les petites et moyennes entreprises manquent de connaissances en matière de confidentialité et de sécurité des données et ne savent pas comment protéger les données contre les menaces de sécurité.

La conformité en matière de sécurité des données n'est pas l'affaire d'un service en particulier, mais l'affaire la plus importante pour l'ensemble de l'entreprise.

Les entreprises doivent former leurs employés pour leur faire prendre conscience que tous ceux qui utilisent des données ont l'obligation de protéger les données, y compris le personnel informatique, les services d'IA, les ingénieurs de données, les développeurs, les personnes qui utilisent les rapports, etc. Personnes et technologie À combiner .

Face aux risques potentiels susmentionnés, comment les régulateurs et les entreprises concernées peuvent-ils renforcer la protection de la sécurité des données dans le domaine de l'AIGC aux niveaux institutionnel et technique ?

Par rapport à la prise de mesures réglementaires telles que la restriction directe de l'utilisation des terminaux utilisateur, il sera plus efficace d'exiger clairement que les entreprises de recherche et de développement de technologies d'IA respectent les principes éthiques scientifiques et technologiques, car ces entreprises peuvent limiter le champ d'application des utilisateurs. 'utilisation au niveau technique.

Au niveau institutionnel, il est nécessaire d'établir et d'améliorer un système de classification des données et de protection hiérarchique basé sur les caractéristiques et les fonctions des données requises par la technologie sous-jacente de l'AIGC.

Par exemple, les données de l'ensemble de données de formation peuvent être classées et gérées en fonction de la personne concernée, du niveau de traitement des données, des attributs des droits sur les données, etc., et les données peuvent être classées et gérées en fonction de la valeur du données à la personne concernée, et une fois que les données sont falsifiées, détruites, etc. Le niveau de danger de la personne est évalué.

Sur la base de la classification et de la classification des données, établir des normes de protection des données et des mécanismes de partage qui correspondent au type de données et au niveau de sécurité.

En nous concentrant sur les entreprises, nous devons accélérer l'application de la technologie « informatique privée » dans le domaine de l'AIGC.

Ce type de technologie permet à plusieurs propriétaires de données de partager, d'interagir, de calculer et de modéliser des données en partageant le SDK ou en ouvrant les autorisations du SDK sans exposer les données elles-mêmes, tout en garantissant qu'AIGC peut tout en fournissant des services normalement, s'assurer que les données ne sont pas divulgué aux autres participants.

De plus, l'importance de la gestion complète de la conformité des processus est devenue de plus en plus importante.

Les entreprises doivent d'abord veiller à ce que les ressources de données qu'elles utilisent soient conformes aux exigences légales et réglementaires. Deuxièmement, elles doivent s'assurer que l'ensemble du processus d'exploitation des algorithmes et des modèles est également conforme. dans la plus grande mesure possible aux attentes éthiques du public.

Dans le même temps, les entreprises doivent formuler des normes de gestion interne et mettre en place des départements de supervision pertinents pour superviser les données dans tous les aspects des scénarios d'application de la technologie de l'IA afin de garantir que les sources de données sont légales, que le traitement est légal et que la sortie est légale, donc afin d'assurer leur propre conformité.

La clé de l'application de l'IA réside dans la considération entre la méthode de déploiement et le coût, mais il faut noter que si la conformité en matière de sécurité et la protection de la vie privée ne sont pas bien faites, cela peut comporter « des risques plus importants » pour les entreprises.

L'IA est une arme à double tranchant. Si elle est bien utilisée, les entreprises seront plus puissantes si elles ne sont pas utilisées correctement, négliger la sécurité, la confidentialité et la conformité entraînera de plus grandes pertes pour l'entreprise.

Par conséquent, avant de pouvoir appliquer l'IA, il est nécessaire de construire une « base de données » plus stable. Comme le dit le proverbe, seuls des progrès réguliers peuvent conduire à des progrès à long terme.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

ChatGPT permet désormais aux utilisateurs gratuits de générer des images en utilisant DALL-E 3 avec une limite quotidienne

Aug 09, 2024 pm 09:37 PM

Le DALL-E 3 a été officiellement introduit en septembre 2023 en tant que modèle considérablement amélioré par rapport à son prédécesseur. Il est considéré comme l’un des meilleurs générateurs d’images IA à ce jour, capable de créer des images avec des détails complexes. Cependant, au lancement, c'était exclu

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Bytedance Cutting lance le super abonnement SVIP : 499 yuans pour un abonnement annuel continu, offrant une variété de fonctions d'IA

Jun 28, 2024 am 03:51 AM

Ce site a rapporté le 27 juin que Jianying est un logiciel de montage vidéo développé par FaceMeng Technology, une filiale de ByteDance. Il s'appuie sur la plateforme Douyin et produit essentiellement du contenu vidéo court pour les utilisateurs de la plateforme. Il est compatible avec iOS, Android et. Windows, MacOS et autres systèmes d'exploitation. Jianying a officiellement annoncé la mise à niveau de son système d'adhésion et a lancé un nouveau SVIP, qui comprend une variété de technologies noires d'IA, telles que la traduction intelligente, la mise en évidence intelligente, l'emballage intelligent, la synthèse humaine numérique, etc. En termes de prix, les frais mensuels pour le clipping SVIP sont de 79 yuans, les frais annuels sont de 599 yuans (attention sur ce site : équivalent à 49,9 yuans par mois), l'abonnement mensuel continu est de 59 yuans par mois et l'abonnement annuel continu est de 59 yuans par mois. est de 499 yuans par an (équivalent à 41,6 yuans par mois) . En outre, le responsable de Cut a également déclaré que afin d'améliorer l'expérience utilisateur, ceux qui se sont abonnés au VIP d'origine

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Le réglage fin peut-il vraiment permettre au LLM d'apprendre de nouvelles choses : l'introduction de nouvelles connaissances peut amener le modèle à produire davantage d'hallucinations

Jun 11, 2024 pm 03:57 PM

Les grands modèles linguistiques (LLM) sont formés sur d'énormes bases de données textuelles, où ils acquièrent de grandes quantités de connaissances du monde réel. Ces connaissances sont intégrées à leurs paramètres et peuvent ensuite être utilisées en cas de besoin. La connaissance de ces modèles est « réifiée » en fin de formation. À la fin de la pré-formation, le modèle arrête effectivement d’apprendre. Alignez ou affinez le modèle pour apprendre à exploiter ces connaissances et répondre plus naturellement aux questions des utilisateurs. Mais parfois, la connaissance du modèle ne suffit pas, et bien que le modèle puisse accéder à du contenu externe via RAG, il est considéré comme bénéfique de l'adapter à de nouveaux domaines grâce à un réglage fin. Ce réglage fin est effectué à l'aide de la contribution d'annotateurs humains ou d'autres créations LLM, où le modèle rencontre des connaissances supplémentaires du monde réel et les intègre.

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

Afin de fournir un nouveau système de référence et d'évaluation de questions-réponses scientifiques et complexes pour les grands modèles, l'UNSW, Argonne, l'Université de Chicago et d'autres institutions ont lancé conjointement le cadre SciQAG.

Jul 25, 2024 am 06:42 AM

L'ensemble de données ScienceAI Question Answering (QA) joue un rôle essentiel dans la promotion de la recherche sur le traitement du langage naturel (NLP). Des ensembles de données d'assurance qualité de haute qualité peuvent non seulement être utilisés pour affiner les modèles, mais également évaluer efficacement les capacités des grands modèles linguistiques (LLM), en particulier la capacité à comprendre et à raisonner sur les connaissances scientifiques. Bien qu’il existe actuellement de nombreux ensembles de données scientifiques d’assurance qualité couvrant la médecine, la chimie, la biologie et d’autres domaines, ces ensembles de données présentent encore certaines lacunes. Premièrement, le formulaire de données est relativement simple, et la plupart sont des questions à choix multiples. Elles sont faciles à évaluer, mais limitent la plage de sélection des réponses du modèle et ne peuvent pas tester pleinement la capacité du modèle à répondre aux questions scientifiques. En revanche, les questions et réponses ouvertes

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Les performances de SOTA, la méthode d'IA de prédiction d'affinité protéine-ligand multimodale de Xiamen, combinent pour la première fois des informations sur la surface moléculaire

Jul 17, 2024 pm 06:37 PM

Editeur | KX Dans le domaine de la recherche et du développement de médicaments, il est crucial de prédire avec précision et efficacité l'affinité de liaison des protéines et des ligands pour le criblage et l'optimisation des médicaments. Cependant, les études actuelles ne prennent pas en compte le rôle important des informations sur la surface moléculaire dans les interactions protéine-ligand. Sur cette base, des chercheurs de l'Université de Xiamen ont proposé un nouveau cadre d'extraction de caractéristiques multimodales (MFE), qui combine pour la première fois des informations sur la surface des protéines, la structure et la séquence 3D, et utilise un mécanisme d'attention croisée pour comparer différentes modalités. alignement. Les résultats expérimentaux démontrent que cette méthode atteint des performances de pointe dans la prédiction des affinités de liaison protéine-ligand. De plus, les études d’ablation démontrent l’efficacité et la nécessité des informations sur la surface des protéines et de l’alignement des caractéristiques multimodales dans ce cadre. Les recherches connexes commencent par "S

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

ChatGPT est désormais disponible pour macOS avec la sortie d'une application dédiée

Jun 27, 2024 am 10:05 AM

L'application ChatGPT Mac d'Open AI est désormais accessible à tous, après avoir été limitée aux seuls utilisateurs disposant d'un abonnement ChatGPT Plus au cours des derniers mois. L'application s'installe comme n'importe quelle autre application Mac native, à condition que vous disposiez d'un Apple S à jour.

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

SK Hynix présentera de nouveaux produits liés à l'IA le 6 août : HBM3E à 12 couches, NAND à 321 hauteurs, etc.

Aug 01, 2024 pm 09:40 PM

Selon les informations de ce site le 1er août, SK Hynix a publié un article de blog aujourd'hui (1er août), annonçant sa participation au Global Semiconductor Memory Summit FMS2024 qui se tiendra à Santa Clara, Californie, États-Unis, du 6 au 8 août, présentant de nombreuses nouvelles technologies de produit. Introduction au Future Memory and Storage Summit (FutureMemoryandStorage), anciennement Flash Memory Summit (FlashMemorySummit) principalement destiné aux fournisseurs de NAND, dans le contexte de l'attention croissante portée à la technologie de l'intelligence artificielle, cette année a été rebaptisée Future Memory and Storage Summit (FutureMemoryandStorage) pour invitez les fournisseurs de DRAM et de stockage et bien d’autres joueurs. Nouveau produit SK hynix lancé l'année dernière

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

SearchGPT : Open AI affronte Google avec son propre moteur de recherche IA

Jul 30, 2024 am 09:58 AM

L’Open AI fait enfin son incursion dans la recherche. La société de San Francisco a récemment annoncé un nouvel outil d'IA doté de capacités de recherche. Rapporté pour la première fois par The Information en février de cette année, le nouvel outil s'appelle à juste titre SearchGPT et propose un c