Périphériques technologiques

Périphériques technologiques

IA

IA

Hallucination? Le TruthGPT de Musk ne peut pas non plus le gérer ! Le co-fondateur d'OpenAI dit que c'est compliqué

Hallucination? Le TruthGPT de Musk ne peut pas non plus le gérer ! Le co-fondateur d'OpenAI dit que c'est compliqué

Hallucination? Le TruthGPT de Musk ne peut pas non plus le gérer ! Le co-fondateur d'OpenAI dit que c'est compliqué

Le mois dernier, Musk a frénétiquement appelé à une suspension de 6 mois de la recherche et du développement sur la super IA.

Peu de temps après, Lao Ma ne pouvait plus rester immobile et a officiellement annoncé le lancement d'une plateforme d'IA appelée TruthGPT.

Musk a dit un jour que TruthGPT serait la « plus grande intelligence artificielle en quête de vérité » qui tentera de comprendre la nature de l'univers.

Il a souligné qu'il est peu probable qu'une intelligence artificielle soucieuse de comprendre l'univers extermine l'humanité car nous sommes les plus partie intéressante de l'univers.

Cependant, aucun modèle de langage ne peut gérer «l'illusion» jusqu'à présent.

Récemment, le co-fondateur d'OpenAI a expliqué pourquoi la réalisation des nobles idéaux de TruthGPT est si difficile.

TruthGPT l'idéal est une bulle ?

Le TruthGPT que X.AI de Musk veut construire est un modèle de langage honnête.

Ce faisant, nous ciblons directement ChatGPT.

Car, auparavant, les systèmes d'IA comme ChatGPT produisaient souvent des cas d'hallucinations classiques tels qu'une sortie incorrecte, et prenaient même en charge certains rend compte de certaines convictions politiques.

Bien que ChatGPT puisse donner aux utilisateurs plus de contrôle sur le modèle de langage pour résoudre les problèmes, « l'illusion » est toujours quelque chose que OpenAI, Google et les futures sociétés d'intelligence artificielle de Musk doivent gérer avec une question centrale.

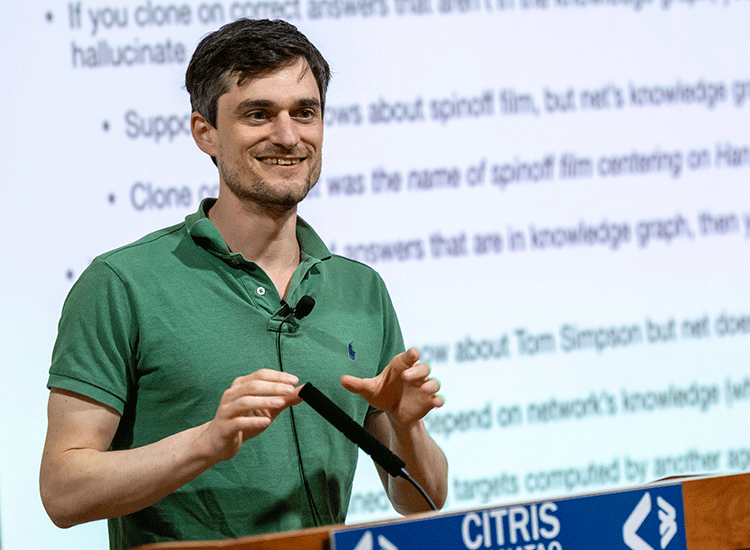

Le co-fondateur et chercheur d'OpenAI, John Schulman, a discuté de ces défis et de la manière de les relever dans son exposé « RL and Truthfulness – Towards TruthGPT ».

Pourquoi y a-t-il des « hallucinations » ?

Selon Schulman, les hallucinations peuvent être grossièrement divisées en deux types :

1. Autrement dit, le modèle de langage ne peut pas exprimer sa propre incertitude, remettre en question les prémisses de l'invite ou perpétuer les erreurs qu'il a commises auparavant.

2. Le modèle devine mal.

Étant donné que le modèle de langage représente un graphe de connaissances qui contient des faits issus des données d'entraînement dans son propre réseau, le réglage fin peut être compris comme l'apprentissage d'une fonction exécutée sur le graphe de connaissances et la prédiction du jeton de sortie.

Par exemple, un ensemble de données de réglage précis peut contenir la question « Quel est le genre de Star Wars ? » et la réponse « Science-Fiction ».

Si cette information est déjà dans les données d'entraînement d'origine, c'est-à-dire qu'elle fait partie du graphe de connaissances, alors le Le modèle n'apprendra pas de nouvelles informations, mais apprendra un comportement, produisant la bonne réponse. Ce type de réglage fin est également appelé « clonage comportemental ».

Mais le problème est que la question "Quel est le nom du film dérivé de Han Solo" apparaît dans l'ensemble de données de réglage fin.

Mais si la réponse "Solo" ne fait pas partie de l'ensemble de données d'entraînement d'origine (ni du graphe de connaissances), le réseau apprendra à répondre même s'il ne connaît pas la réponse.

Apprenez au réseau à inventer des réponses, c'est-à-dire à créer des « hallucinations », en les affinant à l'aide de réponses qui sont réellement correctes mais qui ne figurent pas dans le graphe de connaissances . À l’inverse, une formation avec des réponses incorrectes amène le réseau à retenir des informations.

Ainsi, le clonage comportemental devrait idéalement toujours être basé sur la connaissance du réseau, mais cette connaissance est souvent inconnue du travailleur humain qui crée ou évalue l'ensemble de données, comme le réglage des instructions.

Selon Schulman, ce problème existe également lorsque d'autres modèles créent des ensembles de données affinés, comme c'est le cas avec la formule Alpaca.

Il prédit que les réseaux plus petits avec des graphiques de connaissances plus petits apprendront non seulement à utiliser les résultats de ChatGPT pour donner des réponses et suivre des instructions, mais apprendront également à halluciner plus fréquemment.

Comment OpenAI combat-il les hallucinations ?

Tout d'abord, pour des questions simples, les modèles linguistiques peuvent prédire s'ils connaissent la réponse dans la plupart des cas, et peuvent également exprimer une incertitude.

Par conséquent, Schulman a déclaré que lors du réglage fin de l'ensemble de données, le modèle doit apprendre à exprimer l'incertitude, à gérer les situations où les prémisses sont modifiées et les situations où les erreurs sont reconnues.

Les instances de ces situations doivent être transmises au modèle et lui permettre d'apprendre.

Mais les modèles sont encore mal entraînés au timing, c’est-à-dire qu’ils ne savent pas quand effectuer ces opérations.

Schulman a déclaré que c'est là que l'apprentissage par renforcement (RL) entre en jeu. Par exemple, l’apprentissage par renforcement avec feedback humain (RLHF) basé sur le feedback humain.

En appliquant RL, le modèle peut apprendre les « limites de comportement » et apprendre quand exécuter quel comportement.

Une autre difficulté est la capacité à récupérer et citer des sources.

La question est, avec la capacité de copier les comportements et le RLHF, pourquoi ChatGPT hallucine-t-il encore ?

La raison réside dans la difficulté du problème lui-même.

Bien que la méthode ci-dessus fonctionne bien pour les questions et réponses courtes, d'autres problèmes surviennent pour les paramètres de format long courants dans ChatGPT.

D'une part, une réponse complètement fausse est peu probable. Dans la plupart des cas, le bien et le mal sont mélangés.

Dans des cas extrêmes, il peut s'agir simplement d'une erreur dans 100 lignes de code.

Dans d'autres cas, l'information n'est pas fausse au sens traditionnel du terme, mais plutôt trompeuse. Par conséquent, dans un système comme ChatGPT, il est difficile de mesurer la qualité du résultat en termes de contenu ou d’exactitude de l’information.

Mais cette mesure est très importante pour les algorithmes RL conçus pour entraîner des limites comportementales complexes.

Actuellement, OpenAI s'appuie sur le modèle de récompense basé sur le classement du RLHF, qui est capable de prédire laquelle des deux réponses lui semble la meilleure, mais ne donne pas de signal efficace pour clarifier quelle réponse est la meilleure ou la plus informative. correct ou correct.

Schulman a déclaré qu'il lui manquait la capacité de fournir des commentaires au modèle pour apprendre de fines limites comportementales. Et ce genre de frontière comportementale fine est le moyen possible de résoudre l’illusion.

De plus, ce processus est encore compliqué par l'erreur humaine dans le processus d'étiquetage RLHF.

Par conséquent, bien que Schulman considère RL comme l'un des moyens importants de réduire les hallucinations, il estime qu'il reste encore de nombreux problèmes non résolus.

À l'exception de ce à quoi doit ressembler le modèle de récompense mentionné ci-dessus pour guider un comportement correct, RLHF ne s'appuie actuellement que sur le jugement humain.

Cela peut rendre la génération de connaissances plus difficile. Parce que les prédictions sur l’avenir conduisent parfois à des présentations moins convaincantes.

Cependant, Schulman estime que la génération de connaissances est la prochaine étape importante dans les modèles de langage. En même temps, il estime que la construction théorique de problèmes tels que prédire l'avenir et donner des règles d'inférence sont le prochain type de problèmes ouverts. doivent être résolus de toute urgence.

Schulman a déclaré qu'une solution possible consiste à utiliser d'autres modèles d'IA pour former des modèles de langage.

OpenAI estime également que cette méthode est très significative pour l'alignement de l'IA.

Architecte ChatGPT

En tant qu'architecte de ChatGPT, John Schulman a rejoint OpenAI en tant que co-fondateur dès 2015, alors qu'il étudiait encore pour un doctorat.

Dans une interview, Schulman a expliqué la raison pour laquelle il a rejoint OpenAI :

Je veux faire des recherches sur l'intelligence artificielle. Je pense qu'OpenAI a une mission ambitieuse et s'engage à construire une intelligence artificielle générale. .

Même si parler d'AGI semblait un peu fou à l'époque, je pensais qu'il était raisonnable de commencer à y penser et je voulais être dans un endroit où parler d'AGI était acceptable.

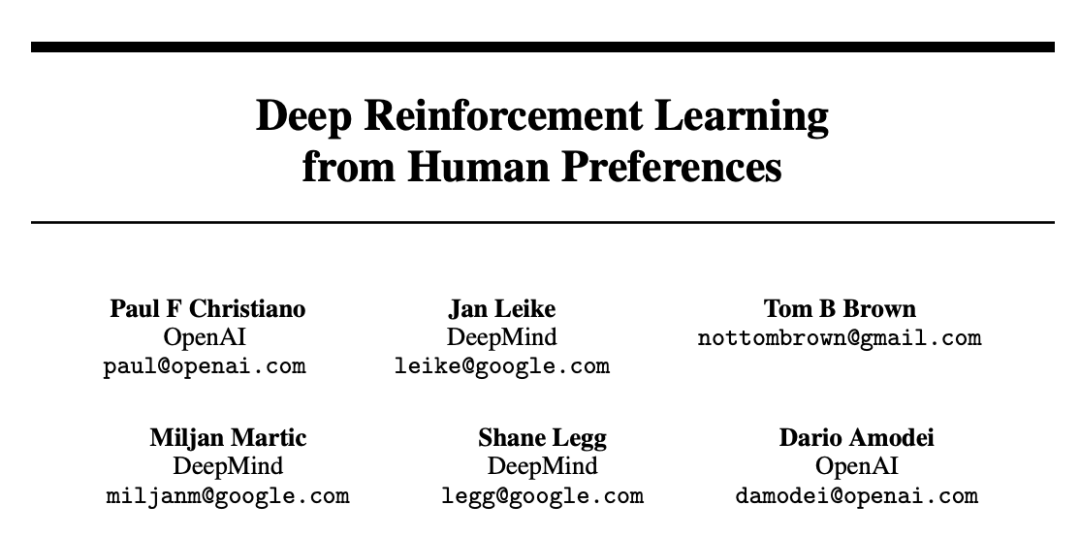

De plus, selon Schulman, l'idée d'OpenAI d'introduire l'apprentissage par renforcement par feedback humain (RLHF) dans ChatGPT remonte à il y a 17 ans.

A cette époque, il était également membre d'OpenAI et a publié un article "Deep Reinforcement Learning from Human Preferences" qui mentionnait cette méthode.

Adresse papier : https://arxiv.org/pdf/1706.03741.pdf

La raison pour laquelle l'équipe de sécurité d'OpenAI s'engage dans ce travail est qu'elle veut que ses modèles soient cohérents avec les préférences des humains – en essayant d'amener le modèle à réellement écouter les humains et à essayer de faire ce que les humains veulent faire.

Lorsque GPT-3 a terminé sa formation, Schulman a décidé de rejoindre cette tendance car il a vu le potentiel de l'ensemble de la direction de la recherche.

Quand on lui a demandé quelle a été sa première réaction lorsqu'il a utilisé ChatGPT pour la première fois, les mots de Schulman n'ont révélé « aucune émotion ».

Je me souviens encore de la sortie de ChatGPT l’année dernière, qui a fait exploser instantanément le cerveau de nombreuses personnes.

Et personne au sein d'OpenAI n'est enthousiasmé par ChatGPT. Étant donné que le ChatGPT publié était un modèle plus faible basé sur GPT-3.5, des collègues jouaient avec GPT-4 à cette époque.

Donc, à cette époque, personne chez OpenAI n'était enthousiasmé par ChatGPT car il existait un modèle tellement plus puissant et plus intelligent qui avait déjà été formé.

Concernant la prochaine frontière de l'intelligence artificielle dans le futur, Schulman a déclaré que l'IA continue de progresser dans des tâches plus difficiles, et alors la question se pose de savoir que devraient faire les humains et dans quelles tâches les humains peuvent-ils réussir dans leur ensemble. des tâches à grande échelle ? Avoir plus d'impact et faire plus à l'aide de modèles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Lien du projet écrit devant : https://nianticlabs.github.io/mickey/ Étant donné deux images, la pose de la caméra entre elles peut être estimée en établissant la correspondance entre les images. En règle générale, ces correspondances sont 2D à 2D et nos poses estimées sont à échelle indéterminée. Certaines applications, telles que la réalité augmentée instantanée, à tout moment et en tout lieu, nécessitent une estimation de pose des métriques d'échelle, elles s'appuient donc sur des estimateurs de profondeur externes pour récupérer l'échelle. Cet article propose MicKey, un processus de correspondance de points clés capable de prédire les correspondances métriques dans l'espace d'une caméra 3D. En apprenant la correspondance des coordonnées 3D entre les images, nous sommes en mesure de déduire des métriques relatives.