Périphériques technologiques

Périphériques technologiques

IA

IA

Interprétation approfondie de la technologie d'étalonnage des capteurs de voiture intelligente

Interprétation approfondie de la technologie d'étalonnage des capteurs de voiture intelligente

Interprétation approfondie de la technologie d'étalonnage des capteurs de voiture intelligente

L'étalonnage des capteurs est un maillon nécessaire du système de perception de la conduite autonome, et constitue une étape nécessaire et une condition préalable à la fusion ultérieure des capteurs. Son objectif est de transformer deux ou plusieurs capteurs en un système de coordonnées spatio-temporelles unifié afin que la fusion des capteurs ait un sens. La perception est un préalable clé à la prise de décision. Tout capteur doit être calibré par des expériences après la fabrication et l'installation pour garantir qu'il répond aux spécifications de conception et garantit l'exactitude des valeurs de mesure.

Une fois le capteur installé sur le véhicule autonome, il doit être calibré en même temps, pendant le processus de conduite du véhicule, en raison des vibrations et d'autres raisons, la position du capteur s'écartera de la position d'origine, il est donc nécessaire de le calibrer à certains intervalles de temps pour calibrer le capteur. Les voitures autonomes fonctionnent simultanément grâce à plusieurs types de capteurs pour la perception environnementale et la conscience de soi. La robustesse et la précision des capteurs sont particulièrement importantes dans le processus de perception des voitures autonomes.

01 Calibrage de la caméra

La caméra montée sur le véhicule est installée sur le véhicule à un certain angle et dans une certaine position afin de faire correspondre les données environnementales collectées par la caméra montée sur le véhicule aux objets réels dans la conduite du véhicule. environnement, c'est-à-dire pour trouver les données générées par la caméra montée sur véhicule. La relation de conversion entre les coordonnées de point dans le système de coordonnées de pixels de l'image et les coordonnées de point dans le système de coordonnées de l'environnement de la caméra nécessite un étalonnage de la caméra.

1. Étalonnage des paramètres internes de la caméra

1.1 Établissement du modèle de caméra

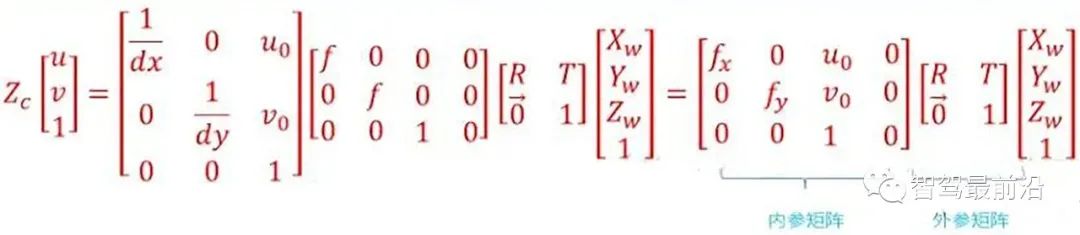

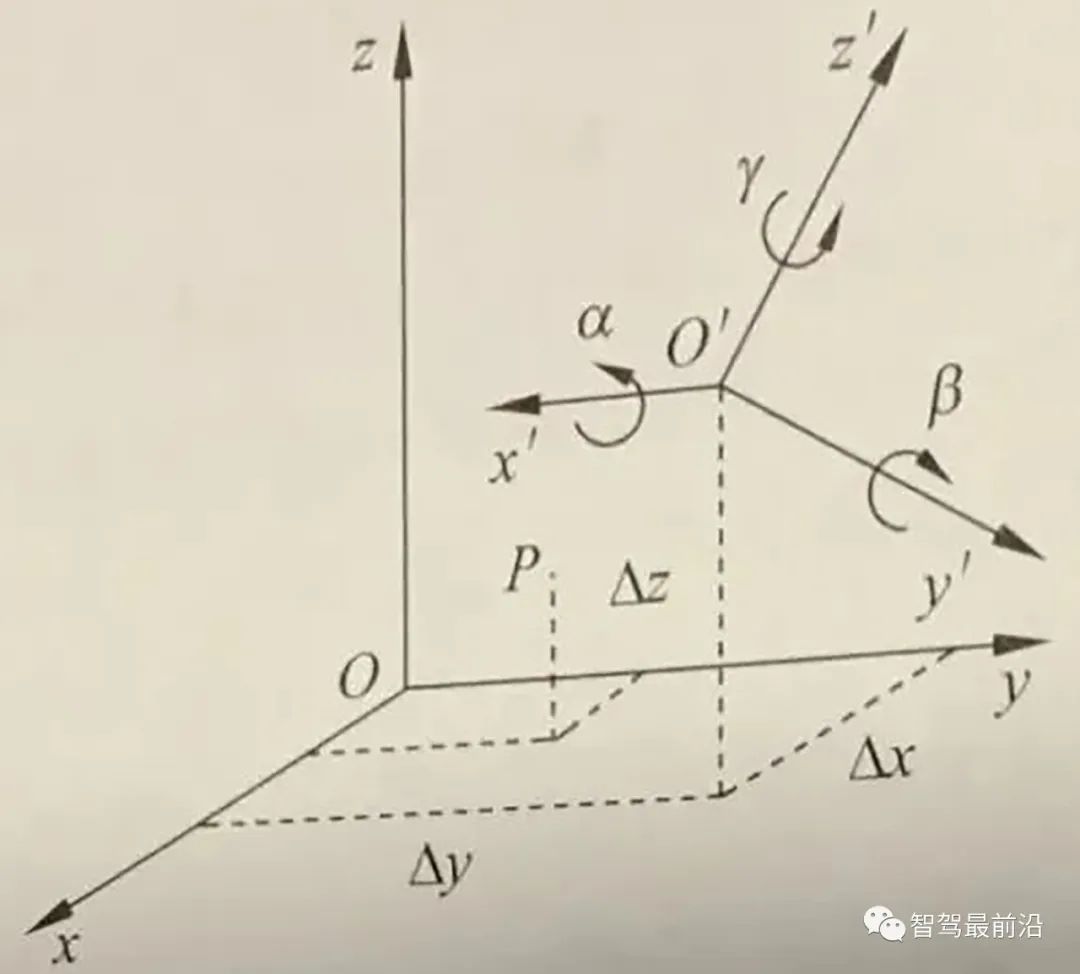

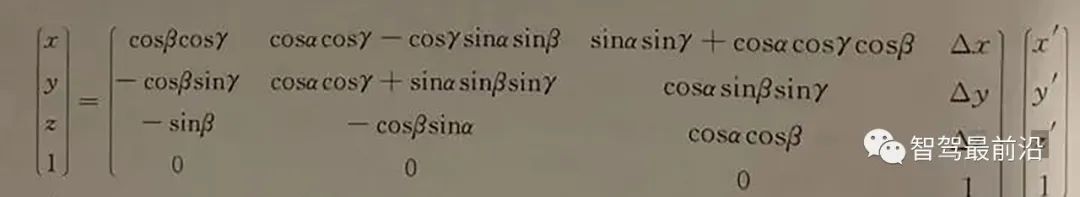

Grâce à la relation de conversion mutuelle entre le système de coordonnées de l'environnement, le système de coordonnées de la caméra, le système de coordonnées physiques de l'image et le système de coordonnées des pixels de l'image , nous pouvons trouver la relation de conversion entre le système de coordonnées de l'environnement et le système de coordonnées des pixels de l'image, c'est-à-dire le point P de

dans le monde réel. Ses coordonnées dans le système de coordonnées environnementales sont (La relation de conversion entre les systèmes de coordonnées de pixels de l'image

vers la matrice de paramètres interne, ses quatre constantes fx, fy, Uo, Vo. Il est lié aux indicateurs techniques de conception tels que la distance focale, le point principal et le capteur de la caméra, et n'a rien à voir avec des facteurs externes (tels que l'environnement, la position de la caméra), c'est pourquoi on l'appelle le paramètre interne de la caméra. La référence interne est déterminée lorsque la caméra quitte l'usine. Cependant, en raison du processus de fabrication et d'autres problèmes, même les caméras produites sur la même ligne de production ont des paramètres internes légèrement différents. Il est donc souvent nécessaire de déterminer les paramètres internes de la caméra par le biais d'expériences. L'étalonnage d'une caméra monoculaire fait généralement référence à la détermination des paramètres internes de la caméra par des moyens expérimentaux.

vers la matrice de paramètres interne, ses quatre constantes fx, fy, Uo, Vo. Il est lié aux indicateurs techniques de conception tels que la distance focale, le point principal et le capteur de la caméra, et n'a rien à voir avec des facteurs externes (tels que l'environnement, la position de la caméra), c'est pourquoi on l'appelle le paramètre interne de la caméra. La référence interne est déterminée lorsque la caméra quitte l'usine. Cependant, en raison du processus de fabrication et d'autres problèmes, même les caméras produites sur la même ligne de production ont des paramètres internes légèrement différents. Il est donc souvent nécessaire de déterminer les paramètres internes de la caméra par le biais d'expériences. L'étalonnage d'une caméra monoculaire fait généralement référence à la détermination des paramètres internes de la caméra par des moyens expérimentaux.

La matrice des paramètres externes comprend la matrice de rotation et la matrice de traduction. La matrice de rotation et la matrice de traduction décrivent conjointement comment convertir le point du système de coordonnées mondial en système de coordonnées de la caméra. En vision par ordinateur, le processus de détermination de la matrice des paramètres externes est généralement appelé localisation visuelle. Une fois la caméra embarquée installée dans une voiture autonome, la position de la caméra doit être calibrée dans le système de coordonnées du véhicule. De plus, en raison des chocs et des vibrations de la voiture, la position de la caméra embarquée changera lentement au fil du temps, de sorte que les voitures autonomes doivent recalibrer régulièrement la position de la caméra, un processus appelé calibrage.

1.2 Correction de la distorsion de la caméra

En utilisation réelle, la caméra ne peut pas effectuer une projection en perspective de manière complètement précise selon le modèle de caméra sténopé idéal. Il y a généralement une distorsion de l'objectif, c'est-à-dire que le point de l'objet est imagé dans l'image. caméra réelle Il existe une certaine erreur de distorsion optique entre l'image générée sur le plan et l'imagerie idéale, et l'erreur de distorsion est principalement une erreur de distorsion radiale et une erreur de distorsion tangentielle.

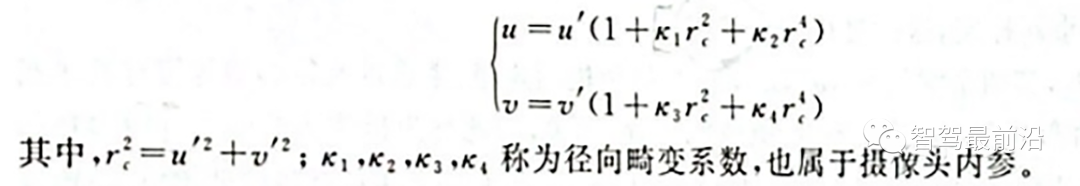

Distorsion radiale : en raison des caractéristiques de l'objectif, la lumière a tendance à se plier dans une faible ou grande mesure au bord de l'objectif de l'appareil photo, ce que l'on appelle distorsion radiale. Ce type de distorsion est plus évident dans les objectifs ordinaires bon marché. La distorsion radiale comprend principalement la distorsion en barillet et la distorsion en coussinet. La distorsion en barillet est une expansion en forme de tonneau de l'image imagée provoquée par l'objet de l'objectif et la structure du groupe de lentilles dans l'objectif. La distorsion en barillet est généralement plus facile à détecter lors de l'utilisation d'un objectif grand angle ou lors de l'utilisation de l'extrémité grand angle d'un objectif zoom. La distorsion en coussin est le phénomène de « rétrécissement » de l’image vers le centre provoqué par l’objectif. Les gens sont plus susceptibles de remarquer une distorsion en coussin lorsqu’ils utilisent l’extrémité téléobjectif d’un objectif zoom. En vision par ordinateur, la distorsion radiale a un impact très important sur la reconstruction de la scène. La perception de l'environnement par le système de conduite autonome nécessite que la caméra réalise une reconstruction de haute précision de l'environnement environnant. Si la distorsion n'est pas corrigée, des informations environnementales précises ne peuvent pas être obtenues. Par exemple, des cibles dans l'environnement peuvent apparaître dans n'importe quelle zone de l'image. Si la distorsion n'est pas corrigée, l'emplacement et la taille de la cible obtenus grâce à la technologie de vision sont souvent inexacts, ce qui affectera directement la sécurité de conduite des véhicules autonomes. De plus, les voitures autonomes sont équipées de plusieurs caméras à différents endroits. Si la distorsion radiale n'est pas prise en compte, pendant le processus d'assemblage des images, l'effet de flou des images assemblées sera provoqué par une non-concordance des caractéristiques correspondantes. Pour les appareils photo généraux, la distorsion radiale de l'image est souvent décrite comme un modèle polynomial d'ordre inférieur. Supposons que (u, v) soit la coordonnée du point corrigé, (u', u') soit la coordonnée du point non corrigé, alors la transformation entre les deux peut être déterminée par la formule suivante :

Modèle polynomial d'ordre faible de distorsion radiale

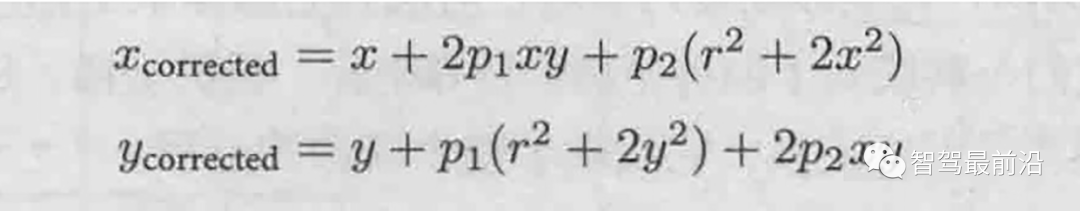

En revanche, pour la distorsion tangentielle, deux autres paramètres p1, p2 peuvent être utilisés pour corriger :

Distorsion tangentielle Faible- modèle polynomial d'ordre

1.3 Méthode d'étalonnage des paramètres internes de la caméra

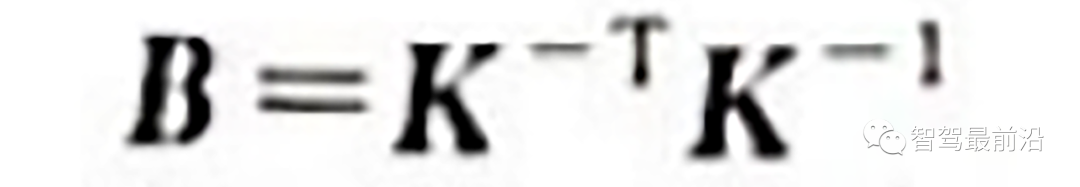

A ce stade, l'étalonnage des paramètres de distorsion est généralement effectué simultanément avec d'autres paramètres internes. La méthode d’étalonnage la plus largement utilisée à l’heure actuelle est celle de Zhang Zhengyou proposée par Zhang Zhengyou en 2000. La méthode d'étalonnage de Zhang Zhengyou trouve les points d'angle internes de l'échiquier dans chaque image en photographiant l'échiquier à différentes positions, et établit des contraintes sur la matrice  grâce à la correspondance entre les points d'angle internes, restaurant ainsi le paramètre interne. matrice K.

grâce à la correspondance entre les points d'angle internes, restaurant ainsi le paramètre interne. matrice K.

2. Calibrage des paramètres externes entre les caméras

Dans les voitures autonomes, afin de minimiser la zone aveugle de perception, un mode multi-caméras est souvent utilisé. La détermination de la relation de position relative entre plusieurs caméras est appelée étalonnage des paramètres externes de la caméra.

D'un autre point de vue, l'étalonnage des paramètres externes de la caméra peut également être appelé problème « d'estimation de pose ». La pose relative [R|t] entre les deux caméras a 6 degrés de liberté (position spatiale et relation de rotation). Théoriquement, tant que les deux caméras acquièrent 3 points dans l'espace en même temps, la relation entre les deux peut être obtenue. être restaurée. Le problème de la récupération de la posture relative entre les caméras à partir de trois paires de points correspondants est appelé « Problème de Perspective à 3 Points, P3P ». En réalité, plus de 3 points sont souvent utilisés pour restaurer la posture relative afin d'améliorer la robustesse, et le problème P3P est généralisé comme problème PnP.

Au départ, les chercheurs ont utilisé la méthode de transformation linéaire directe (DLT) pour résoudre le problème PnP. Plus tard, afin d'améliorer la précision, les chercheurs ont proposé l'erreur de reprojection de linéarisation robuste et ont commencé à utiliser la méthode alternative pour résoudre le problème. problème PnP, et a ainsi proposé la fameuse méthode d'ajustement de bundle (Bundle Adjustment, BA) dans l'estimation d'attitude.

02 Calibrage Lidar

Le Lidar est l'un des principaux capteurs de la plateforme de conduite autonome et joue un rôle important dans la perception et le positionnement. Comme les caméras, le lidar doit également calibrer ses paramètres internes et externes avant utilisation. L'étalonnage des paramètres internes fait référence à la relation de conversion entre son système de coordonnées d'émetteur laser interne et le propre système de coordonnées du radar. Il a été calibré avant de quitter l'usine et peut être utilisé directement. Ce que le système de conduite autonome doit effectuer, c'est l'étalonnage des paramètres externes, c'est-à-dire la relation entre le système de coordonnées du lidar et le système de coordonnées de la carrosserie du véhicule.

Le lidar et la carrosserie du véhicule sont reliés rigidement, et l'attitude et le déplacement relatifs entre les deux sont fixes. Afin d'établir la relation de coordonnées relative entre les lidars et entre les lidars et les véhicules, il est nécessaire de calibrer l'installation lidar et de convertir les données lidar du système de coordonnées lidar en système de coordonnées de la carrosserie du véhicule.

Système de coordonnées du véhicule et système de coordonnées lidar

Les coordonnées réelles du même point dans deux systèmes de coordonnées, c'est-à-dire le même point, sont établies par des expériences Une série d'équations permet de calculer ces 16 paramètres inconnus. De plus, dans les véhicules autonomes, il est généralement nécessaire d'étalonner le radar laser et le système de coordonnées de l'unité de navigation inertielle (IMU) pour établir la relation entre le radar laser et le système de coordonnées de la carrosserie du véhicule.

1. Calibrage entre lidar et lidar

Pour les véhicules autonomes, il existe parfois plusieurs lidars, et l'environnement externe acquis par chaque lidar doit être cartographié avec précision sous le système de coordonnées de la carrosserie du véhicule. Par conséquent, lorsqu'il existe plusieurs lidars, les positions relatives de plusieurs lidars doivent être calibrées et étalonnées.

Il existe de nombreuses idées pour l'étalonnage des paramètres externes entre les lidars. La plus couramment utilisée consiste à dériver indirectement la relation de transformation de coordonnées entre les lidars via la relation de transformation de coordonnées entre les différents lidars et la carrosserie de la voiture.

2. Calibrage du lidar et de la caméra

Sur un véhicule autonome, le lidar et la voiture sans conducteur sont rigidement connectés, et l'attitude et le déplacement relatifs entre les deux sont donc fixes. les points ont des coordonnées de position uniques qui leur correspondent dans le système de coordonnées de l'environnement. De même, la caméra possède également des coordonnées de position uniques dans le système de coordonnées de l'environnement, il existe donc une transformation de coordonnées fixe entre le lidar et la caméra. L'étalonnage conjoint du lidar et de la caméra consiste à compléter l'unification de plusieurs coordonnées de capteur telles que les coordonnées lidar à ligne unique, les coordonnées de caméra, les coordonnées de pixels d'image, etc. en extrayant les points caractéristiques correspondants de l'objet d'étalonnage sur le lidar à ligne unique et image, et réaliser l'étalonnage spatial du lidar et de la caméra.

Après avoir terminé l'étalonnage des paramètres externes de la caméra et l'étalonnage des paramètres externes du lidar, la relation entre les deux peut en fait être complètement déterminée. Le point de balayage lidar peut être projeté sur le système de coordonnées des pixels de l'image.

Semblable à la méthode d'étalonnage des paramètres internes de la caméra, la méthode d'étalonnage de la plaque d'étalonnage peut également être utilisée pour l'étalonnage des paramètres externes du lidar et de la caméra.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

Wow génial! Expérience Samsung Galaxy Ring : 2999 yuans de véritable bague intelligente

Jul 19, 2024 pm 02:31 PM

Wow génial! Expérience Samsung Galaxy Ring : 2999 yuans de véritable bague intelligente

Jul 19, 2024 pm 02:31 PM

Samsung a officiellement lancé la version nationale du Samsung Galaxy Ring le 17 juillet, au prix de 2 999 yuans. Le vrai téléphone du Galaxy Ring est en réalité la version 2024 de "WowAwesome, c'est mon moment exclusif". C'est le produit électronique qui nous fait sentir le plus frais ces dernières années (même si cela ressemble à un drapeau) ces dernières années. (Sur la photo, les anneaux à gauche et à droite sont Galaxy Ring↑) Spécifications du Samsung Galaxy Ring (données du site officiel de la Banque de Chine) : système ZephyrRTOS, stockage 8 Mo étanche 10 ATM + capacité de la batterie 18 mAh à 23,5 ; mAh (différentes tailles

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Comment résoudre le problème de la longue traîne dans les scénarios de conduite autonome ?

Jun 02, 2024 pm 02:44 PM

Hier, lors de l'entretien, on m'a demandé si j'avais posé des questions à longue traîne, j'ai donc pensé faire un bref résumé. Le problème à longue traîne de la conduite autonome fait référence aux cas extrêmes dans les véhicules autonomes, c'est-à-dire à des scénarios possibles avec une faible probabilité d'occurrence. Le problème perçu de la longue traîne est l’une des principales raisons limitant actuellement le domaine de conception opérationnelle des véhicules autonomes intelligents à véhicule unique. L'architecture sous-jacente et la plupart des problèmes techniques de la conduite autonome ont été résolus, et les 5 % restants des problèmes à longue traîne sont progressivement devenus la clé pour restreindre le développement de la conduite autonome. Ces problèmes incluent une variété de scénarios fragmentés, de situations extrêmes et de comportements humains imprévisibles. La « longue traîne » des scénarios limites dans la conduite autonome fait référence aux cas limites dans les véhicules autonomes (VA). Les cas limites sont des scénarios possibles avec une faible probabilité d'occurrence. ces événements rares

Passez en plein écran ! iPhone SE4 avancé à septembre

Jul 24, 2024 pm 12:56 PM

Passez en plein écran ! iPhone SE4 avancé à septembre

Jul 24, 2024 pm 12:56 PM

Récemment, de nouvelles nouvelles concernant l'iPhone SE4 ont été révélées sur Weibo. On dit que le processus de couverture arrière de l'iPhone SE4 est exactement le même que celui de la version standard de l'iPhone 16. En d'autres termes, l'iPhone SE4 utilisera un panneau arrière en verre et un. écran droit et conception à bord droit. Il est rapporté que l’iPhone SE4 sortira avant septembre de cette année, ce qui signifie qu’il sera probablement dévoilé en même temps que l’iPhone 16. 1. D'après les rendus exposés, le design avant de l'iPhone SE4 est similaire à celui de l'iPhone 13, avec une caméra frontale et un capteur FaceID sur l'écran à encoche. L'arrière utilise une disposition similaire à celle de l'iPhoneXr, mais il n'a qu'un seul appareil photo et n'a pas de module de caméra global.

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

Quelle est la taille du capteur de 1 pouce d'un téléphone portable ? Il est en fait plus grand que le capteur de 1 pouce d'un appareil photo ?

May 08, 2024 pm 06:40 PM

Quelle est la taille du capteur de 1 pouce d'un téléphone portable ? Il est en fait plus grand que le capteur de 1 pouce d'un appareil photo ?

May 08, 2024 pm 06:40 PM

L'article d'hier ne mentionnait pas la "taille du capteur". Je ne m'attendais pas à ce que les gens aient autant de malentendus... Combien fait 1 pouce ? En raison de certains problèmes historiques*, qu'il s'agisse d'un appareil photo ou d'un téléphone portable, « 1 pouce » dans la diagonale du capteur n'est pas 25,4 mm. *En ce qui concerne les tubes à vide, il n’y a pas d’expansion ici. C’est un peu comme la crosse d’un cheval qui décide de la largeur d’une voie ferrée. Afin d'éviter tout malentendu, l'écriture la plus rigoureuse est « Type 1.0 » ou « Type1.0 ». De plus, lorsque la taille du capteur est inférieure au type 1/2, type 1 = 18 mm et lorsque la taille du capteur est supérieure ou égale au type 1/2, type 1 = ;

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

Cet article vous suffit pour en savoir plus sur la conduite autonome et la prédiction de trajectoire !

Feb 28, 2024 pm 07:20 PM

La prédiction de trajectoire joue un rôle important dans la conduite autonome. La prédiction de trajectoire de conduite autonome fait référence à la prédiction de la trajectoire de conduite future du véhicule en analysant diverses données pendant le processus de conduite du véhicule. En tant que module central de la conduite autonome, la qualité de la prédiction de trajectoire est cruciale pour le contrôle de la planification en aval. La tâche de prédiction de trajectoire dispose d'une riche pile technologique et nécessite une connaissance de la perception dynamique/statique de la conduite autonome, des cartes de haute précision, des lignes de voie, des compétences en architecture de réseau neuronal (CNN&GNN&Transformer), etc. Il est très difficile de démarrer ! De nombreux fans espèrent se lancer dans la prédiction de trajectoire le plus tôt possible et éviter les pièges. Aujourd'hui, je vais faire le point sur quelques problèmes courants et des méthodes d'apprentissage introductives pour la prédiction de trajectoire ! Connaissances introductives 1. Existe-t-il un ordre d'entrée pour les épreuves de prévisualisation ? R : Regardez d’abord l’enquête, p

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

SIMPL : un benchmark de prédiction de mouvement multi-agents simple et efficace pour la conduite autonome

Feb 20, 2024 am 11:48 AM

Titre original : SIMPL : ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Lien article : https://arxiv.org/pdf/2402.02519.pdf Lien code : https://github.com/HKUST-Aerial-Robotics/SIMPL Affiliation de l'auteur : Université des sciences de Hong Kong et technologie Idée DJI Paper : cet article propose une base de référence de prédiction de mouvement (SIMPL) simple et efficace pour les véhicules autonomes. Par rapport au cent agent traditionnel