Périphériques technologiques

Périphériques technologiques

IA

IA

OpenAI utilise GPT-4 pour expliquer les 300 000 neurones de GPT-2 : voici à quoi ressemble la sagesse

OpenAI utilise GPT-4 pour expliquer les 300 000 neurones de GPT-2 : voici à quoi ressemble la sagesse

OpenAI utilise GPT-4 pour expliquer les 300 000 neurones de GPT-2 : voici à quoi ressemble la sagesse

Bien que ChatGPT semble rapprocher les humains de la recréation de l'intelligence, jusqu'à présent, nous n'avons jamais complètement compris ce qu'est l'intelligence, qu'elle soit naturelle ou artificielle.

Il est évidemment nécessaire de comprendre les principes de l'intelligence. Comment comprendre l'intelligence des grands modèles de langage ? La solution proposée par OpenAI est la suivante : demandez ce que dit GPT-4.

Le 9 mai, OpenAI a publié ses dernières recherches, qui ont utilisé GPT-4 pour interpréter automatiquement le comportement des neurones dans de grands modèles de langage, et ont obtenu de nombreux résultats intéressants.

Une façon simple d'étudier l'interprétabilité est d'abord de comprendre ce que font les différentes composantes du modèle d'IA (neurones et têtes d'attention). Les méthodes traditionnelles nécessitent que les humains inspectent manuellement les neurones pour déterminer les caractéristiques des données qu'ils représentent. Ce processus est difficile à mettre à l’échelle et son application à des réseaux de neurones comportant des centaines ou des centaines de milliards de paramètres est d’un coût prohibitif.

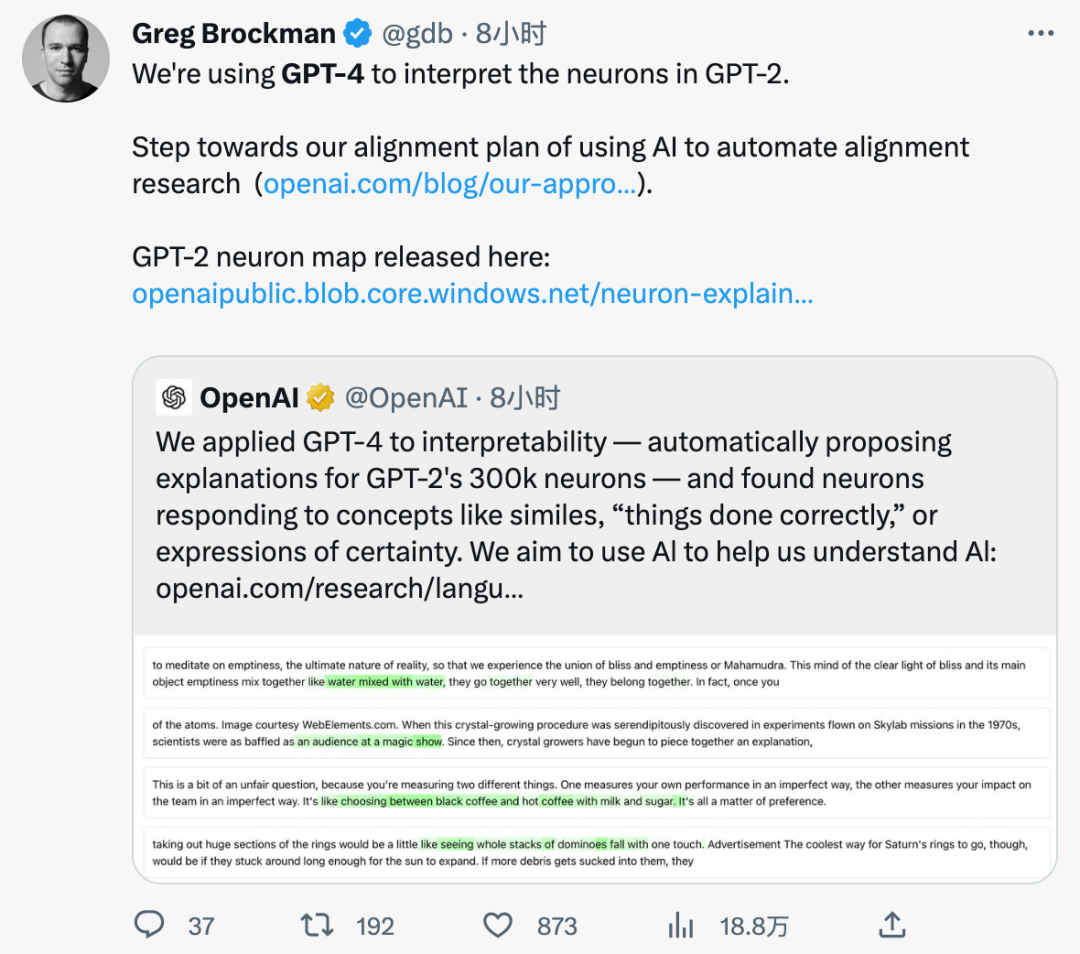

OpenAI a donc proposé une méthode automatisée - utilisant GPT-4 pour générer et noter des explications en langage naturel du comportement des neurones et l'appliquer aux neurones dans un autre modèle de langage - ici, ils ont sélectionné GPT-2 comme échantillon expérimental et ont publié des données ensemble de ces interprétations et scores des neurones GPT-2.

- Adresse papier : https://openaipublic.blob.core.windows.net/neuron-explainer/paper/index.html

- Diagramme des neurones GPT-2 : https ://openaipublic.blob.core.windows.net/neuron-explainer/neuron-viewer/index.html

- Code et ensemble de données : https://github.com/openai/automated-interpretability

Cette technologie permet aux gens d'utiliser GPT-4 pour définir et mesurer automatiquement le concept quantitatif d'interprétabilité des modèles d'IA : elle est utilisée pour mesurer la capacité des modèles de langage à utiliser le langage naturel pour compresser et reconstruire les activations neuronales. En raison de leur nature quantitative, nous pouvons désormais mesurer les progrès dans la compréhension des objectifs informatiques des réseaux de neurones.

OpenAI a déclaré qu'en utilisant la référence qu'ils ont établie, le score d'utilisation de l'IA pour expliquer l'IA peut atteindre un niveau proche de celui des humains.

Le co-fondateur d'OpenAI, Greg Brockman, a également déclaré que nous avons franchi une étape importante vers l'utilisation de l'IA pour mener des recherches d'alignement automatisées.

Méthode spécifique

La méthode d'utilisation de l'IA pour expliquer l'IA consiste à exécuter trois étapes sur chaque neurone :

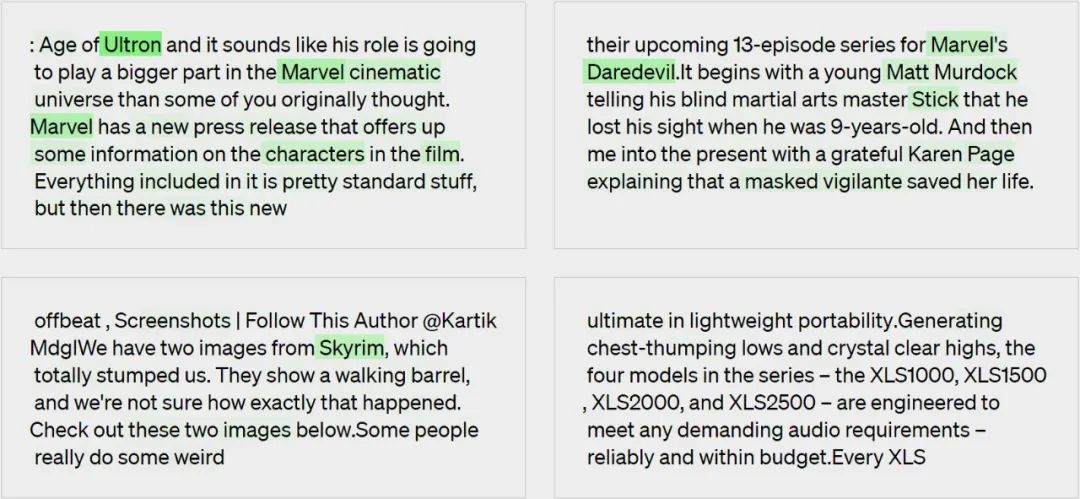

Étape 1 : Utiliser GPT-4 pour générer des explications

Étant donné un neurone GPT-2, génère une explication de son comportement en affichant les séquences de texte et les activations pertinentes pour GPT-4.

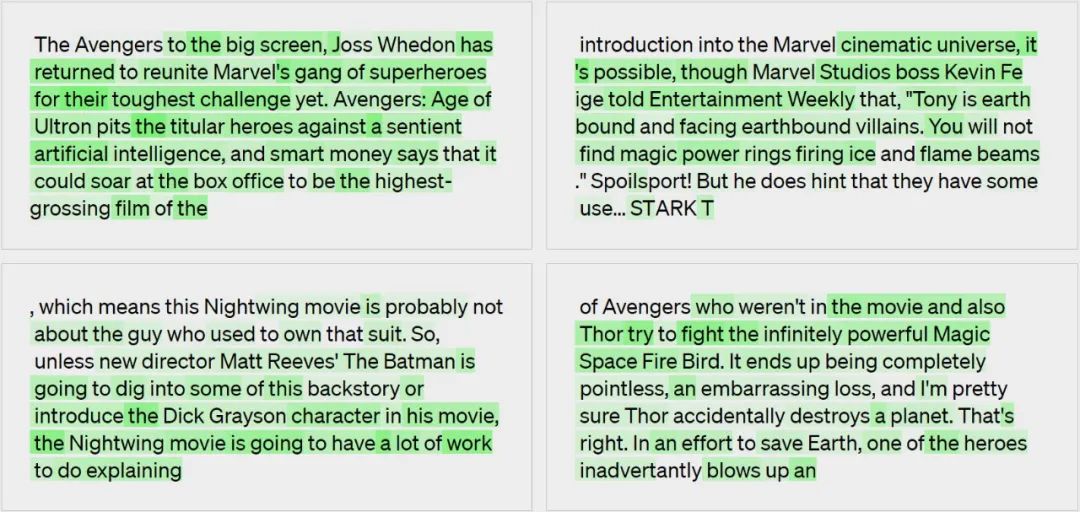

Explication de la génération de modèles : références aux films, personnages et divertissements.

Étape 2 : Utilisez GPT-4 pour simuler

Utilisez à nouveau GPT-4 pour simuler ce que fera le neurone interprété.

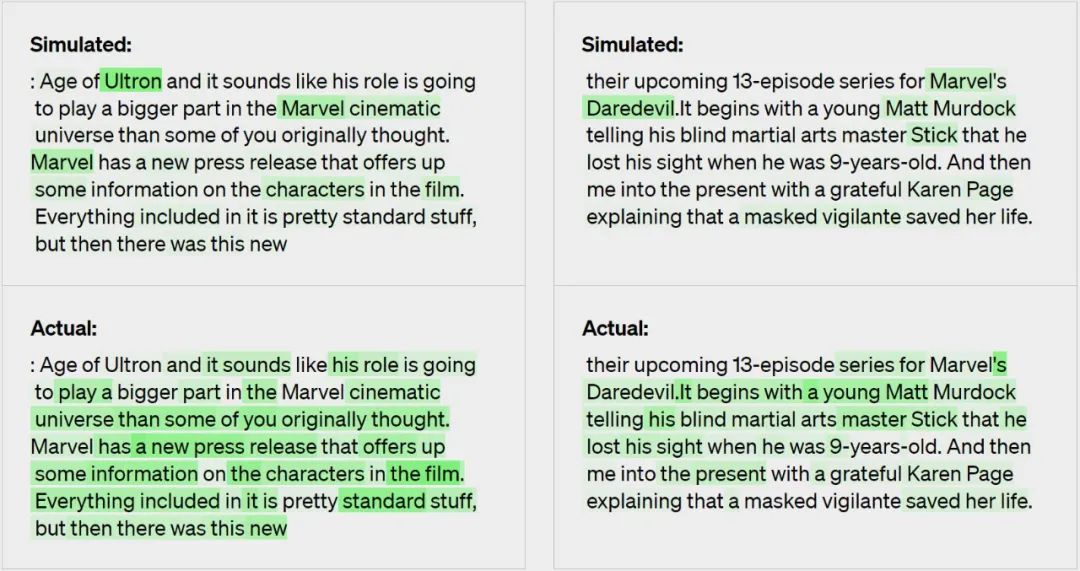

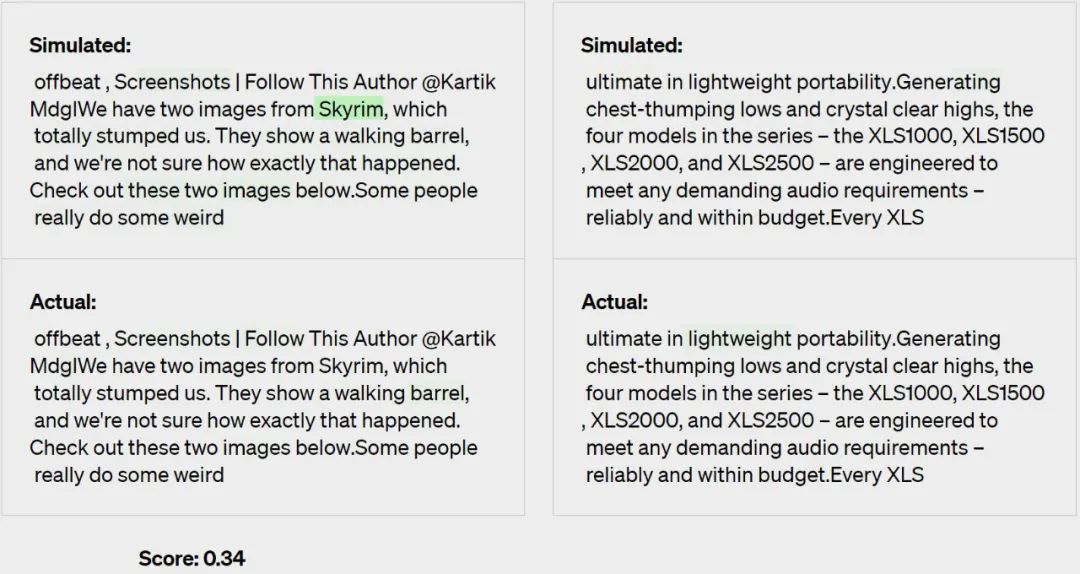

Étape 3 : Comparaison

Les explications sont notées en fonction de la façon dont les activations simulées correspondent aux activations réelles - dans ce cas, GPT-4 a obtenu un score de 0,34.

Principaux résultats

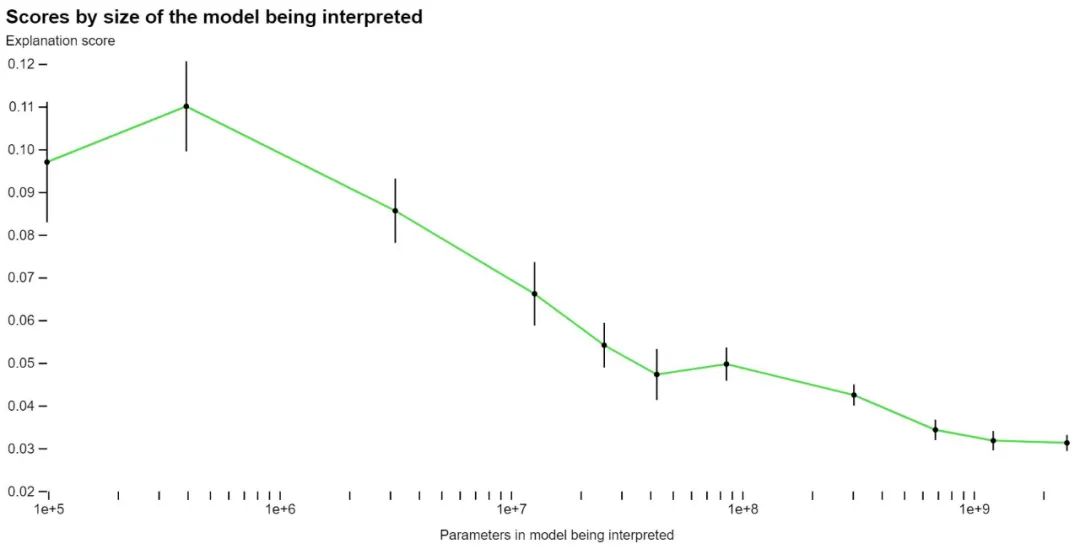

En utilisant sa propre méthode de notation, OpenAI a commencé à mesurer l'efficacité de sa technologie sur différentes parties du réseau et à essayer d'améliorer la technologie pour les parties qui ne sont actuellement pas claires . Par exemple, leur technique ne fonctionne pas bien avec des modèles plus grands, peut-être parce que les couches ultérieures sont plus difficiles à interpréter.

OpenAI affirme que même si la grande majorité de leurs explications n'obtiennent pas un score élevé, ils pensent qu'ils peuvent désormais utiliser les techniques de ML pour améliorer encore leur capacité à générer des explications. Par exemple, ils ont constaté que les éléments suivants les ont aidés à améliorer leurs scores :

- Explications itératives. Ils pourraient améliorer leurs scores en demandant à GPT-4 de réfléchir à des contre-exemples possibles, puis de modifier l'explication en fonction de leur activation.

- Utilisez un modèle plus grand pour l'explication. À mesure que la capacité du modèle explicatif s’améliore, le score moyen augmentera également. Cependant, même GPT-4 a donné des explications pires que celles des humains, ce qui suggère qu’il y a place à amélioration.

- Changez l'architecture du modèle expliqué. Entraîner le modèle avec différentes fonctions d'activation améliore le score d'explication.

OpenAI dit qu'ils créent l'ensemble de données et les outils de visualisation écrits en GPT-4 interprétant les 307 200 neurones de GPT-2 open source. Dans le même temps, ils fournissent également du code pour l’interprétation et la notation à l’aide de modèles accessibles au public sur l’API OpenAI. Ils espèrent que la communauté des chercheurs développera de nouvelles techniques pour générer des explications plus performantes, ainsi que de meilleurs outils pour explorer GPT-2 à travers des explications.

Ils ont découvert qu'il y avait plus de 1 000 neurones avec un score d'explication d'au moins 0,8, ce qui signifie qu'ils représentaient la plupart des principaux comportements d'activation des neurones selon GPT-4. La plupart de ces neurones bien expliqués ne sont pas très intéressants. Cependant, ils ont également découvert de nombreux neurones intéressants que GPT-4 ne comprenait pas. OpenAI espère qu’à mesure que les explications s’améliorent, ils pourront rapidement découvrir des informations qualitatives intéressantes sur les calculs des modèles.

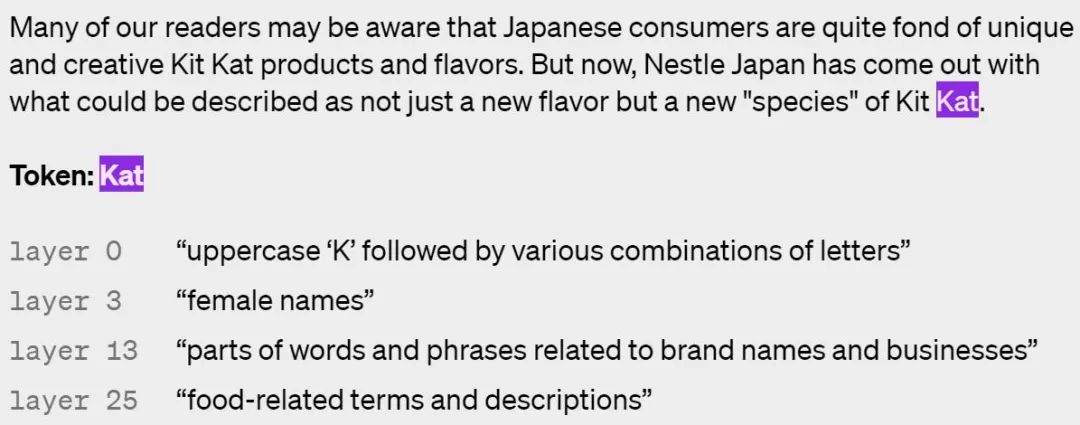

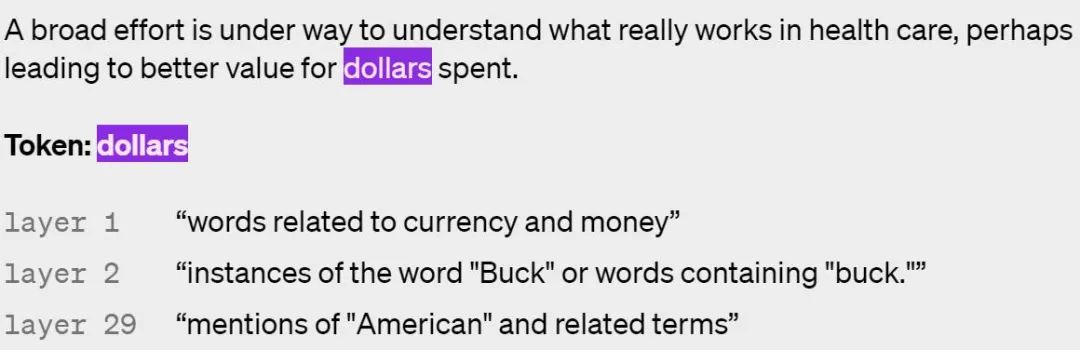

Voici quelques exemples de neurones activés dans différentes couches, les couches supérieures étant plus abstraites :

On dirait, GPT comprend-il les concepts différemment des humains ?

Actuellement, cette méthode présente encore certaines limites, qu'OpenAI espère résoudre dans les travaux futurs :

- Cette méthode se concentre sur de courtes explications en langage naturel, mais les neurones peuvent avoir des comportements très complexes qui ne peuvent pas être décrits de manière concise ;

- OpenAI espère éventuellement trouver et expliquer automatiquement des circuits neuronaux entiers pour obtenir des comportements complexes. Les neurones et les têtes d'attention fonctionnent ; ensemble. Les méthodes actuelles interprètent simplement le comportement des neurones en fonction de la saisie de texte brut sans tenir compte de ses effets en aval. Par exemple, un neurone qui s'active sur un point peut indiquer que le mot suivant doit commencer par une majuscule, ou incrémenter un compteur de phrases

- OpenAI explique ce comportement des neurones, mais ne tente pas d'en expliquer la génération ; mécanisme de comportement. Cela signifie que même les explications les plus performantes peuvent avoir de mauvais résultats sur des textes non distribués car elles ne décrivent qu'une corrélation.

- L'ensemble du processus est extrêmement gourmand en calcul ;

À terme, OpenAI espère utiliser des modèles pour former, tester et itérer des hypothèses complètement générales, tout comme le font les chercheurs en explicabilité. De plus, OpenAI espère interpréter ses plus grands modèles comme un moyen de détecter les problèmes d'alignement et de sécurité avant et après le déploiement. Cependant, il reste encore beaucoup de chemin à parcourir avant que cela se produise.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

CentOS8 redémarre SSH

Apr 14, 2025 pm 09:00 PM

La commande pour redémarrer le service SSH est: SystemCTL Redémarrer SSHD. Étapes détaillées: 1. Accédez au terminal et connectez-vous au serveur; 2. Entrez la commande: SystemCTL Restart SSHD; 3. Vérifiez l'état du service: SystemCTL Status Sshd.

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu