Périphériques technologiques

Périphériques technologiques

IA

IA

Progrès de la puce IA auto-développée par Meta : la première puce IA sera lancée en 2025, et il y aura également une puce IA vidéo

Progrès de la puce IA auto-développée par Meta : la première puce IA sera lancée en 2025, et il y aura également une puce IA vidéo

Progrès de la puce IA auto-développée par Meta : la première puce IA sera lancée en 2025, et il y aura également une puce IA vidéo

Le 19 mai, selon le média étranger Techcrunch, lors d'un événement en ligne ce matin, la société mère de Facebook Meta a divulgué pour la première fois les progrès de sa puce d'IA auto-développée, qui peut prendre en charge ses outils de conception et de création publicitaires récemment lancés. technologie.

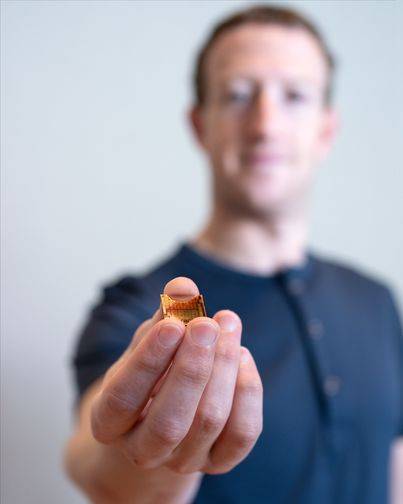

△Le PDG de Meta, Zuckerberg, présente la première puce d'IA auto-développée MTIA

Le vice-président de l'infrastructure de Meta, Alexis Bjorlin, a déclaré : « Construire nos propres capacités [matérielles] nous permet de contrôler chaque couche de la pile, de la conception du centre de données au cadre de formation. Ce niveau d'intégration verticale est nécessaire pour percer à grande échelle. Les limites de la recherche sur l’intelligence artificielle. »

La première puce IA auto-développée MTIA

Au cours de la dernière décennie, Meta a dépensé des milliards de dollars pour recruter les meilleurs scientifiques des données et créer de nouveaux types d'intelligence artificielle, notamment en alimentant désormais des moteurs de découverte, des filtres de modération et des recommandations de publicités dans ses applications et services d'intelligence artificielle. Cette entreprise s’efforce de transformer ses nombreuses innovations ambitieuses en matière de recherche en IA en produits, notamment dans le domaine de l’IA générative.

Depuis 2016, les principales sociétés Internet développent activement des puces d'IA cloud. Google a conçu et déployé des puces d'IA auto-développées appelées Tensor Processing Units (TPU) pour la formation de systèmes d'IA génératifs tels que PaLM-2, Imagen, etc. Amazon fournit aux clients AWS deux puces d'IA auto-développées, AWS Trainium et AWS ; Inférence. Puce pour application. Selon certaines rumeurs, Microsoft travaillerait également avec AMD pour développer une puce IA appelée Athena.

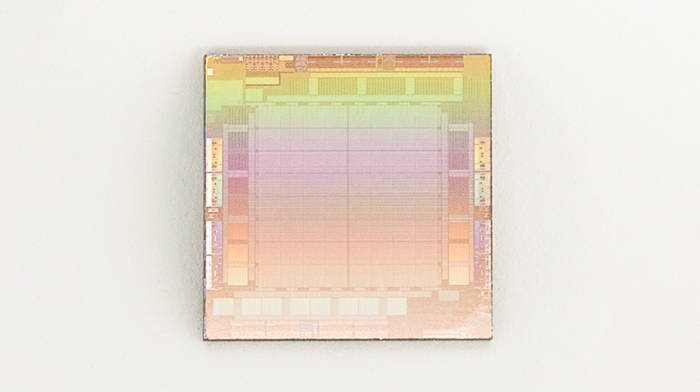

Auparavant, Meta utilisait principalement une combinaison de processeurs tiers et de puces personnalisées conçues pour accélérer les algorithmes d'IA afin d'exécuter ses charges de travail d'IA - les processeurs ont tendance à être moins efficaces que les GPU pour traiter de telles tâches. Afin de renverser la situation, Meta a développé sa puce d'IA auto-développée de première génération MTIA (MTIA v1) basée sur le processus 7 nm en 2020.

Meta appelle la puce AI Meta Training and Inference Accelerator, ou MTIA en abrégé, et la décrit comme faisant partie d'une « famille » de puces IA qui accélèrent les charges de travail de formation et d'inférence de l'IA. Un MTIA est un ASIC, une puce qui combine différents circuits sur un seul substrat, lui permettant d'être programmé pour effectuer une ou plusieurs tâches en parallèle.

« Pour atteindre des niveaux d'efficacité et de performances plus élevés dans nos charges de travail importantes, nous avions besoin d'une solution personnalisée conçue conjointement avec le modèle, la pile logicielle et le matériel système pour améliorer les différents services pour l'expérience de nos utilisateurs », a expliqué Bjorlin.

Selon l'introduction, MTIA v1 est fabriqué à l'aide d'un processus de 7 nm et sa mémoire interne de 128 Mo peut être étendue jusqu'à 128 Go. Meta a déclaré que MTIA peut être spécialement utilisé pour gérer les travaux liés aux systèmes de recommandation d'IA, aidant les utilisateurs à trouver le meilleur contenu de publication et à le présenter aux utilisateurs plus rapidement, et ses performances de calcul et son efficacité de traitement sont meilleures que celles du processeur. De plus, dans le test de référence de Meta design, MTIA est également plus efficace que le GPU dans le traitement des modèles d'IA de « faible complexité » et de « complexité moyenne »

.Meta a déclaré qu'il reste encore du travail à faire dans les domaines de la mémoire et du réseau des puces MTIA. À mesure que l'échelle des modèles d'IA augmente, cela créera des goulots d'étranglement et nécessitera que la charge de travail soit répartie sur plusieurs puces. Récemment, Meta a acquis à cet effet l'équipe de technologie de réseau IA de la licorne britannique de puces Graphcore, basée à Oslo. Actuellement, MTIA se concentre davantage sur les capacités d'inférence que sur les capacités de formation pour les « charges de travail recommandées » de la famille d'applications Meta.

Meta a souligné qu'elle continuerait à améliorer MTIA, ce qui a « considérablement » amélioré l'efficacité de l'entreprise en termes de performances par watt lors de l'exécution des charges de travail recommandées - permettant ainsi à Meta d'exécuter des charges de travail d'intelligence artificielle « plus améliorées » et « de pointe ». .

Selon le plan, Meta lancera officiellement sa puce MTIA auto-développée en 2025.

Le supercalculateur IA RSC de Meta

Les rapports indiquent que Meta avait initialement prévu de lancer à grande échelle ses puces d'IA personnalisées auto-développées en 2022, mais l'a finalement retardé et a plutôt commandé pour des milliards de dollars de GPU Nvidia pour son supercalculateur Research SuperCluster (RSC). ses multiples centres de données étaient nécessaires.

Selon les rapports, RSC a fait ses débuts en janvier 2022 et a été assemblé en partenariat avec Penguin Computing, Nvidia et Pure Storage, et a achevé la deuxième phase d'expansion. Meta indique qu'il contient désormais un total de 2 000 systèmes Nvidia DGX A100, équipés de 16 000 GPU Nvidia A100.

Bien que la puissance de calcul actuelle de RSC soit à la traîne par rapport aux supercalculateurs IA de Microsoft et de Google. Google affirme que son supercalculateur axé sur l'IA est alimenté par 26 000 GPU Nvidia H100. Meta note que l’avantage de RSC est qu’il permet aux chercheurs de former des modèles à l’aide d’exemples réels issus des systèmes de production de Meta. Contrairement à l'infrastructure d'IA précédente de l'entreprise, qui exploitait des ensembles de données open source et accessibles au public, cette infrastructure est désormais disponible.

Les supercalculateurs RSC AI font progresser la recherche sur l’IA dans plusieurs domaines, y compris l’IA générative, repoussant les limites de la recherche. "Il s'agit vraiment de la productivité de la recherche sur l'IA", a déclaré un porte-parole de Meta. Nous souhaitons fournir aux chercheurs en IA une infrastructure de pointe qui leur permet de développer des modèles et leur fournir une plateforme de formation pour faire progresser l’IA. »

Meta affirme qu'à son apogée, RSC pourrait atteindre près de 5 exaflops de puissance de calcul, ce qui en ferait l'un des plus rapides au monde.

Meta utilise RSC pour la formation LLaMA, où RSC fait référence à l'acronyme de « Large Scale Language Model Meta Artificial Intelligence ». Meta indique que le plus grand modèle LLaMA a été formé sur 2 048 GPU A100 et a pris 21 jours.

« Construire nos propres capacités de calcul intensif nous permet de contrôler chaque couche de la pile ; de la conception du centre de données aux cadres de formation », a ajouté un porte-parole de Meta : « RSC aidera les chercheurs en IA de Meta à créer de nouveaux et meilleurs modèles d'IA capables d'apprendre à partir de milliers de milliards de données. des exemples ; travaillez dans des centaines de langues différentes ; travaillez ensemble pour analyser de manière transparente du texte, des images et des vidéos ; développez de nouveaux outils de réalité augmentée et bien plus encore.

À l'avenir, Meta pourrait introduire sa puce d'IA auto-développée MTIA dans RSC pour améliorer encore ses performances d'IA.

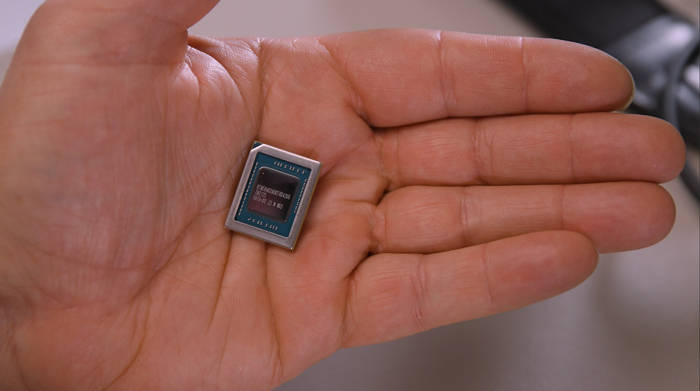

Puce AI MSVP pour le traitement vidéo

En plus de MTIA, Meta développe également une autre puce d'IA appelée Meta Scalable Video Processor (MSVP), qui est principalement conçue pour répondre aux besoins croissants de traitement de données de la vidéo à la demande et du streaming en direct, Meta espère finalement devenir mature et. Un travail de traitement de contenu audio et vidéo stable est effectué par MSVP.En fait, Meta a commencé à concevoir des puces de traitement vidéo personnalisées côté serveur il y a de nombreuses années et a annoncé le lancement d'ASIC pour les travaux de transcodage et d'inférence vidéo en 2019. C’est le point culminant de certains de ces efforts et une nouvelle poussée vers un avantage concurrentiel. Surtout dans le domaine du streaming vidéo en direct.

« Rien que sur Facebook, les gens passent 50 % de leur temps à regarder des vidéos », ont écrit Harikrishna Reddy et Yunqing Chen, directeurs techniques de Meta, dans un article de blog publié le 19 au matin : « Afin de servir les gens du monde entier, les vidéos téléchargées sur Facebook ou Instagram sont transcodés en plusieurs flux binaires avec différents formats d'encodage, résolutions et qualités pour divers appareils (mobile, ordinateur portable, TV, etc.)… MSVP est programmable et évolutif, et peut être configuré pour prendre en charge efficacement le transcodage de haute qualité requis pour VOD ainsi que la faible latence et les temps de traitement plus rapides requis pour la diffusion en direct. »

Meta indique que son plan est de décharger à terme la plupart des charges de travail de traitement vidéo « stables et matures » vers MSVP et d'utiliser uniquement l'encodage vidéo logiciel pour les charges de travail qui nécessitent une personnalisation spécifique et une qualité « considérablement » supérieure. Meta indique que nous continuerons à améliorer la qualité vidéo avec MSVP en utilisant des méthodes de pré-traitement telles que la réduction intelligente du bruit et l'amélioration de l'image, ainsi que des méthodes de post-traitement telles que la suppression des artefacts et la super-résolution.

« À l'avenir, MSVP nous permettra de prendre en charge davantage de cas d'utilisation et de besoins les plus importants de Meta, y compris la vidéo courte – permettant une diffusion efficace de l'IA générative, de l'AR/VR et d'autres contenus Metaverse », ont déclaré Reddy et Chen.

Éditeur : Épée Xinzhixun-Ruruuni

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Nouveau titre : lancement du NVIDIA H200 : capacité du HBM augmentée de 76 %, la puce IA la plus puissante qui améliore considérablement les performances des grands modèles de 90 %

Nov 14, 2023 pm 03:21 PM

Nouveau titre : lancement du NVIDIA H200 : capacité du HBM augmentée de 76 %, la puce IA la plus puissante qui améliore considérablement les performances des grands modèles de 90 %

Nov 14, 2023 pm 03:21 PM

Selon les informations du 14 novembre, Nvidia a officiellement lancé le nouveau GPU H200 lors de la conférence "Supercomputing23" le matin du 13, heure locale, et a mis à jour la gamme de produits GH200. Parmi eux, le H200 est toujours construit sur l'architecture Hopper H100 existante. Cependant, une mémoire à bande passante plus élevée (HBM3e) a été ajoutée pour mieux gérer les grands ensembles de données nécessaires au développement et à la mise en œuvre de l'intelligence artificielle, ce qui améliore de 60 à 90 % les performances globales d'exécution de grands modèles par rapport à la génération précédente H100. . Le GH200 mis à jour alimentera également la prochaine génération de supercalculateurs IA. En 2024, plus de 200 exaflops de puissance de calcul de l’IA seront en ligne. H200

Selon certaines rumeurs, MediaTek aurait remporté une grosse commande de Google pour des puces d'IA de serveur et fournirait des puces Serdes à haut débit.

Jun 19, 2023 pm 08:23 PM

Selon certaines rumeurs, MediaTek aurait remporté une grosse commande de Google pour des puces d'IA de serveur et fournirait des puces Serdes à haut débit.

Jun 19, 2023 pm 08:23 PM

Le 19 juin, selon les médias de Taiwan, en Chine, Google (Google) a contacté MediaTek pour coopérer afin de développer la dernière puce d'IA orientée serveur et prévoit de la confier au processus 5 nm de TSMC pour la fonderie, avec des plans pour production de masse au début de l’année prochaine. Selon le rapport, des sources ont révélé que cette coopération entre Google et MediaTek fournirait à MediaTek des solutions de sérialisation et de désérialisation (SerDes) et aiderait à intégrer le processeur tenseur (TPU) auto-développé par Google pour aider Google à créer les dernières puces Server AI qui seront plus puissantes. que les architectures CPU ou GPU. L’industrie souligne que de nombreux services actuels de Google sont liés à l’IA. Elle a investi dans la technologie d’apprentissage profond il y a de nombreuses années et a constaté que l’utilisation de GPU pour effectuer des calculs d’IA était très coûteuse. Google a donc décidé de le faire.

La prochaine grande nouveauté en matière d'IA : performances maximales de la puce NVIDIA B100 et du modèle OpenAI GPT-5

Nov 18, 2023 pm 03:39 PM

La prochaine grande nouveauté en matière d'IA : performances maximales de la puce NVIDIA B100 et du modèle OpenAI GPT-5

Nov 18, 2023 pm 03:39 PM

Après le lancement de la NVIDIA H200, connue comme la puce d'IA la plus puissante au monde, l'industrie a commencé à attendre avec impatience la puce B100, plus puissante de NVIDIA. Dans le même temps, OpenAI, la start-up d'IA la plus populaire cette année, a démarré. pour développer un modèle GPT-5 plus puissant et plus complexe. Guotai Junan a souligné dans le dernier rapport de recherche que les B100 et GPT5 aux performances illimitées devraient être commercialisés en 2024 et que les mises à niveau majeures pourraient générer une productivité sans précédent. L’agence s’est déclarée optimiste quant au fait que l’IA entrera dans une période de développement rapide et que sa visibilité se poursuivra jusqu’en 2024. Par rapport aux générations de produits précédentes, quelle est la puissance du B100 et du GPT-5 ? Nvidia et OpenAI ont déjà donné un aperçu : le B100 pourrait être plus de 4 fois plus rapide que le H100, et le GPT-5 pourrait atteindre un super

Selon des rumeurs en ligne, Vivo lancerait un grand modèle d'IA auto-développé : similaire à Microsoft Copilot

Oct 17, 2023 pm 05:57 PM

Selon des rumeurs en ligne, Vivo lancerait un grand modèle d'IA auto-développé : similaire à Microsoft Copilot

Oct 17, 2023 pm 05:57 PM

Vivo a officiellement annoncé qu'elle organiserait la conférence des développeurs 2023 sur le thème « Ensemble » au Centre international des congrès et des expositions de Shenzhen le 1er novembre 2023. Elle lancera son grand modèle d'IA auto-développé et son système d'exploitation auto-développé. et le système OriginOS4. Récemment, le célèbre blogueur numérique "Digital Chat Station" a annoncé que le grand modèle d'IA auto-développé par Vivo serait lancé sur OriginOS4, similaire à Microsoft Copilot, avec une fenêtre flottante séparée appelée depuis la barre latérale et un mode intégré. dans l'assistant vocal. Ce n'est pas pareil. Le volume de données d'IA et l'intégration du système sont bien faits, et tous les employés disposent d'un système intelligent. À en juger par l’image, le grand modèle d’IA auto-développé par Vivo s’appellera « JoviCopilot ». Il est rapporté que JoviCopilot peut

Révélation approfondie : le secret du développement du FAI de la caméra Apple !

Nov 11, 2023 pm 02:45 PM

Révélation approfondie : le secret du développement du FAI de la caméra Apple !

Nov 11, 2023 pm 02:45 PM

Selon les informations du 11 novembre, récemment, l'autorité dans le domaine des puces pour téléphones mobiles, @手机 Chip Daren, a révélé dans son dernier Weibo qu'Apple lancerait bientôt deux nouvelles puces de la série M3 pour consolider davantage sa force technique dans le domaine des mobiles. puces de l'appareil. Ces deux puces utiliseront la technologie avancée 3 nm pour offrir aux utilisateurs d’excellentes performances et efficacité énergétique. Les détails sur ces deux puces restent encore mystérieux. Cependant, selon les experts en puces de téléphonie mobile, la quatrième puce de la série M3 s'appelle M3 Ultra et utilisera la technologie avancée « UltraFusion ». La caractéristique de cette technologie est que deux puces M3Max sont intelligemment assemblées pour fournir à l'appareil une puissance de calcul et une vitesse de traitement plus puissantes. Quant au cinquième noyau de la série M3

Kneron lance la dernière puce AI KL730 pour piloter l'application à grande échelle de solutions GPT légères

Aug 17, 2023 pm 01:37 PM

Kneron lance la dernière puce AI KL730 pour piloter l'application à grande échelle de solutions GPT légères

Aug 17, 2023 pm 01:37 PM

Les progrès en matière d'efficacité énergétique du KL730 ont résolu le plus gros goulot d'étranglement dans la mise en œuvre des modèles d'intelligence artificielle : le coût énergétique. Par rapport à l'industrie et aux puces Kneron précédentes, la puce KL730 a augmenté de 3 à 4 fois. Des modèles de langage GPT légers à grande échelle, tels que nanoGPT, et fournissent une puissance de calcul effective de 0,35 à 4 téra par seconde. La société d'IA Kneron a annoncé aujourd'hui la sortie de la puce KL730, qui intègre un NPU de qualité automobile et un traitement du signal d'image (ISP). pour apporter une IA sûre et à faible consommation d'énergie. Les capacités sont renforcées dans divers scénarios d'application tels que les serveurs de périphérie, les maisons intelligentes et les systèmes de conduite assistée automobile. Kneron, basé à San Diego, est connu pour ses unités de traitement neuronal (NPU) révolutionnaires, et sa dernière puce, la KL730, vise à atteindre

NVIDIA lance la nouvelle puce AI H200, performances améliorées de 90% ! La puissance informatique de la Chine réalise une percée indépendante !

Nov 14, 2023 pm 05:37 PM

NVIDIA lance la nouvelle puce AI H200, performances améliorées de 90% ! La puissance informatique de la Chine réalise une percée indépendante !

Nov 14, 2023 pm 05:37 PM

Alors que le monde est toujours obsédé par les puces NVIDIA H100 et les achète follement pour répondre à la demande croissante de puissance de calcul de l'IA, lundi, heure locale, NVIDIA a discrètement lancé sa dernière puce AI H200, qui est utilisée pour entraîner de grands modèles d'IA par rapport à d'autres. Les performances des produits de génération précédente H100 et H200 ont été améliorées d'environ 60 à 90 %. Le H200 est une version améliorée du Nvidia H100. Il est également basé sur l'architecture Hopper comme le H100. La mise à niveau principale comprend 141 Go de mémoire vidéo HBM3e, et la bande passante de la mémoire vidéo est passée de 3,35 To/s du H100 à 4,8. To/s. Selon le site officiel de Nvidia, la H200 est également la première puce de la société à utiliser la mémoire HBM3e. Cette mémoire est plus rapide et a une plus grande capacité, elle est donc plus adaptée aux grands langages.

Kneron annonce le lancement de sa dernière puce AI KL730

Aug 17, 2023 am 10:09 AM

Kneron annonce le lancement de sa dernière puce AI KL730

Aug 17, 2023 am 10:09 AM

Selon les mots originaux, il peut être réécrit comme suit : (Global TMT 16 août 2023) La société d'IA Kneron, dont le siège est à San Diego et connue pour ses unités de traitement neuronal (NPU) révolutionnaires, a annoncé la sortie de la puce KL730. La puce intègre un NPU de qualité automobile et un traitement du signal d'image (ISP) et fournit des capacités d'IA sûres et à faible consommation d'énergie pour divers scénarios d'application tels que les serveurs de périphérie, les maisons intelligentes et les systèmes de conduite assistée automobile. La puce KL730 a obtenu d'excellents résultats. termes d'efficacité énergétique. Une percée, par rapport aux puces Nerner précédentes, son efficacité énergétique a augmenté de 3 à 4 fois et est de 150 % à 200 % supérieure à celle des produits similaires dans les grandes industries. La puce a une puissance de calcul effective de 0,35 à 4 téra par seconde et peut prendre en charge le grand GPT léger le plus avancé.