base de données

base de données

Redis

Redis

Comment Redis+Caffeine implémente les composants de cache distribués de deuxième niveau

Comment Redis+Caffeine implémente les composants de cache distribués de deuxième niveau

Comment Redis+Caffeine implémente les composants de cache distribués de deuxième niveau

Le cache dit de deuxième niveau

Le cache consiste à lire les données à partir d'un support à lecture plus lente et à les placer sur un support à lecture plus rapide, tel qu'un disque -> mémoire.

Habituellement, nous stockons les données sur disque, comme une base de données. Si vous lisez la base de données à chaque fois, la vitesse de lecture sera affectée par les E/S du disque lui-même, il existe donc un cache mémoire comme Redis. Les données peuvent être lues et mises en mémoire, de sorte que lorsque les données doivent être obtenues, les données peuvent être renvoyées directement depuis la mémoire, ce qui peut considérablement améliorer la vitesse.

Mais généralement redis est déployé séparément dans un cluster, il y aura donc une consommation d'E/S réseau. Bien que la connexion avec le cluster redis dispose déjà d'outils tels que des pools de connexions, il y aura quand même une certaine consommation de transmission de données. Il existe donc un cache en cours de processus, comme la caféine. Lorsque le cache intégré à l'application contient des données qualifiées, il peut être utilisé directement sans avoir à les obtenir de Redis via le réseau. Cela forme un cache à deux niveaux. Le cache intégré à l'application est appelé cache de premier niveau et le cache distant (tel que Redis) est appelé cache de deuxième niveau.

Le système doit-il mettre en cache l'utilisation du processeur : Si certaines applications doivent consommer beaucoup de processeur pour calculer et obtenir des résultats.

Si votre pool de connexions à la base de données est relativement inactif, vous ne devez pas utiliser le cache pour occuper les ressources IO de la base de données. Pensez à utiliser la mise en cache lorsque le pool de connexions à la base de données est occupé ou signale fréquemment des avertissements concernant des connexions insuffisantes.

Avantages du cache distribué de deuxième niveau

Redis est utilisé pour stocker des données chaudes, et les données qui ne sont pas dans Redis sont directement accessibles depuis la base de données.

Nous avons déjà Redis, pourquoi avons-nous encore besoin de connaître les caches de processus tels que Guava et Caffeine :

Si Redis n'est pas disponible, nous ne pouvons accéder qu'à Dans la base de données à l'heure actuelle, il est facile de provoquer une avalanche, mais cela n'arrive généralement pas.

L'accès à Redis entraînera une certaine surcharge d'E/S réseau et de sérialisation et de désérialisation. Bien que les performances soient très élevées, elles ne sont pas aussi rapides que la méthode locale après tout. . Il peut convertir les données les plus chaudes. Les données sont stockées localement pour accélérer encore l'accès. Cette idée n'est pas propre à notre architecture Internet. Nous utilisons des caches multiniveaux L1, L2 et L3 dans les systèmes informatiques pour réduire l'accès direct à la mémoire et ainsi accélérer l'accès.

Donc, si nous utilisons simplement Redis, il peut répondre à la plupart de nos besoins, mais lorsque nous devons rechercher des performances et une disponibilité plus élevées, nous devons en apprendre davantage sur plusieurs mise en cache de niveau.

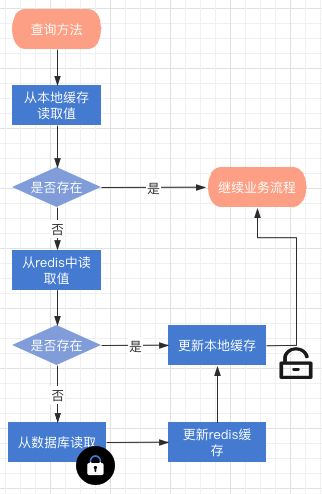

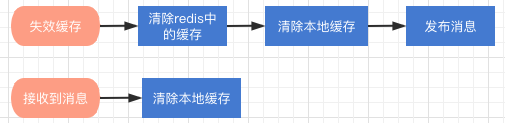

Description du processus de lecture des données du processus d'opération de cache de niveau 2

Lorsque ni Redis ni le cache local ne peuvent interroger la valeur, il déclenchera le processus de mise à jour. L'ensemble du processus est une description du processus d'invalidation du cache verrouillé

redis la mise à jour et la suppression des clés de cache seront déclenchées. cache redis#🎜🎜 #

Comment utiliser les composants ? Le composant est modifié en fonction du framework Spring Cache. Pour utiliser le cache distribué dans le projet, il vous suffit d'ajouter : cacheManager = "L2_CacheManager", ou cacheManager = CacheRedisCaffeineAutoConfiguration #. 🎜🎜#//这个方法会使用分布式二级缓存来提供查询

@Cacheable(cacheNames = CacheNames.CACHE_12HOUR, cacheManager = "L2_CacheManager")

public Config getAllValidateConfig() {

}Si vous souhaitez utiliser à la fois le cache distribué et les composants de cache distribué de deuxième niveau, vous devez alors injecter un bean @Primary CacheManager dans Spring

@Primary

@Bean("deaultCacheManager")

public RedisCacheManager cacheManager(RedisConnectionFactory factory) {

// 生成一个默认配置,通过config对象即可对缓存进行自定义配置

RedisCacheConfiguration config = RedisCacheConfiguration.defaultCacheConfig();

// 设置缓存的默认过期时间,也是使用Duration设置

config = config.entryTtl(Duration.ofMinutes(2)).disableCachingNullValues();

// 设置一个初始化的缓存空间set集合

Set<String> cacheNames = new HashSet<>();

cacheNames.add(CacheNames.CACHE_15MINS);

cacheNames.add(CacheNames.CACHE_30MINS);

// 对每个缓存空间应用不同的配置

Map<String, RedisCacheConfiguration> configMap = new HashMap<>();

configMap.put(CacheNames.CACHE_15MINS, config.entryTtl(Duration.ofMinutes(15)));

configMap.put(CacheNames.CACHE_30MINS, config.entryTtl(Duration.ofMinutes(30)));

// 使用自定义的缓存配置初始化一个cacheManager

RedisCacheManager cacheManager = RedisCacheManager.builder(factory)

.initialCacheNames(cacheNames) // 注意这两句的调用顺序,一定要先调用该方法设置初始化的缓存名,再初始化相关的配置

.withInitialCacheConfigurations(configMap)

.build();

return cacheManager;

}Alors :#🎜🎜 #

//这个方法会使用分布式二级缓存

@Cacheable(cacheNames = CacheNames.CACHE_12HOUR, cacheManager = "L2_CacheManager")

public Config getAllValidateConfig() {

}

//这个方法会使用分布式缓存

@Cacheable(cacheNames = CacheNames.CACHE_12HOUR)

public Config getAllValidateConfig2() {

}package com.axin.idea.rediscaffeinecachestarter.support;

import com.axin.idea.rediscaffeinecachestarter.CacheRedisCaffeineProperties;

import com.github.benmanes.caffeine.cache.Caffeine;

import com.github.benmanes.caffeine.cache.stats.CacheStats;

import lombok.extern.slf4j.Slf4j;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.cache.Cache;

import org.springframework.cache.CacheManager;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.util.CollectionUtils;

import java.util.*;

import java.util.concurrent.ConcurrentHashMap;

import java.util.concurrent.ConcurrentMap;

import java.util.concurrent.TimeUnit;

@Slf4j

public class RedisCaffeineCacheManager implements CacheManager {

private final Logger logger = LoggerFactory.getLogger(RedisCaffeineCacheManager.class);

private static ConcurrentMap<String, Cache> cacheMap = new ConcurrentHashMap<String, Cache>();

private CacheRedisCaffeineProperties cacheRedisCaffeineProperties;

private RedisTemplate<Object, Object> stringKeyRedisTemplate;

private boolean dynamic = true;

private Set<String> cacheNames;

{

cacheNames = new HashSet<>();

cacheNames.add(CacheNames.CACHE_15MINS);

cacheNames.add(CacheNames.CACHE_30MINS);

cacheNames.add(CacheNames.CACHE_60MINS);

cacheNames.add(CacheNames.CACHE_180MINS);

cacheNames.add(CacheNames.CACHE_12HOUR);

}

public RedisCaffeineCacheManager(CacheRedisCaffeineProperties cacheRedisCaffeineProperties,

RedisTemplate<Object, Object> stringKeyRedisTemplate) {

super();

this.cacheRedisCaffeineProperties = cacheRedisCaffeineProperties;

this.stringKeyRedisTemplate = stringKeyRedisTemplate;

this.dynamic = cacheRedisCaffeineProperties.isDynamic();

}

//——————————————————————— 进行缓存工具 ——————————————————————

/**

* 清除所有进程缓存

*/

public void clearAllCache() {

stringKeyRedisTemplate.convertAndSend(cacheRedisCaffeineProperties.getRedis().getTopic(), new CacheMessage(null, null));

}

/**

* 返回所有进程缓存(二级缓存)的统计信息

* result:{"缓存名称":统计信息}

* @return

*/

public static Map<String, CacheStats> getCacheStats() {

if (CollectionUtils.isEmpty(cacheMap)) {

return null;

}

Map<String, CacheStats> result = new LinkedHashMap<>();

for (Cache cache : cacheMap.values()) {

RedisCaffeineCache caffeineCache = (RedisCaffeineCache) cache;

result.put(caffeineCache.getName(), caffeineCache.getCaffeineCache().stats());

}

return result;

}

//—————————————————————————— core —————————————————————————

@Override

public Cache getCache(String name) {

Cache cache = cacheMap.get(name);

if(cache != null) {

return cache;

}

if(!dynamic && !cacheNames.contains(name)) {

return null;

}

cache = new RedisCaffeineCache(name, stringKeyRedisTemplate, caffeineCache(name), cacheRedisCaffeineProperties);

Cache oldCache = cacheMap.putIfAbsent(name, cache);

logger.debug("create cache instance, the cache name is : {}", name);

return oldCache == null ? cache : oldCache;

}

@Override

public Collection<String> getCacheNames() {

return this.cacheNames;

}

public void clearLocal(String cacheName, Object key) {

//cacheName为null 清除所有进程缓存

if (cacheName == null) {

log.info("清除所有本地缓存");

cacheMap = new ConcurrentHashMap<>();

return;

}

Cache cache = cacheMap.get(cacheName);

if(cache == null) {

return;

}

RedisCaffeineCache redisCaffeineCache = (RedisCaffeineCache) cache;

redisCaffeineCache.clearLocal(key);

}

/**

* 实例化本地一级缓存

* @param name

* @return

*/

private com.github.benmanes.caffeine.cache.Cache<Object, Object> caffeineCache(String name) {

Caffeine<Object, Object> cacheBuilder = Caffeine.newBuilder();

CacheRedisCaffeineProperties.CacheDefault cacheConfig;

switch (name) {

case CacheNames.CACHE_15MINS:

cacheConfig = cacheRedisCaffeineProperties.getCache15m();

break;

case CacheNames.CACHE_30MINS:

cacheConfig = cacheRedisCaffeineProperties.getCache30m();

break;

case CacheNames.CACHE_60MINS:

cacheConfig = cacheRedisCaffeineProperties.getCache60m();

break;

case CacheNames.CACHE_180MINS:

cacheConfig = cacheRedisCaffeineProperties.getCache180m();

break;

case CacheNames.CACHE_12HOUR:

cacheConfig = cacheRedisCaffeineProperties.getCache12h();

break;

default:

cacheConfig = cacheRedisCaffeineProperties.getCacheDefault();

}

long expireAfterAccess = cacheConfig.getExpireAfterAccess();

long expireAfterWrite = cacheConfig.getExpireAfterWrite();

int initialCapacity = cacheConfig.getInitialCapacity();

long maximumSize = cacheConfig.getMaximumSize();

long refreshAfterWrite = cacheConfig.getRefreshAfterWrite();

log.debug("本地缓存初始化:");

if (expireAfterAccess > 0) {

log.debug("设置本地缓存访问后过期时间,{}秒", expireAfterAccess);

cacheBuilder.expireAfterAccess(expireAfterAccess, TimeUnit.SECONDS);

}

if (expireAfterWrite > 0) {

log.debug("设置本地缓存写入后过期时间,{}秒", expireAfterWrite);

cacheBuilder.expireAfterWrite(expireAfterWrite, TimeUnit.SECONDS);

}

if (initialCapacity > 0) {

log.debug("设置缓存初始化大小{}", initialCapacity);

cacheBuilder.initialCapacity(initialCapacity);

}

if (maximumSize > 0) {

log.debug("设置本地缓存最大值{}", maximumSize);

cacheBuilder.maximumSize(maximumSize);

}

if (refreshAfterWrite > 0) {

cacheBuilder.refreshAfterWrite(refreshAfterWrite, TimeUnit.SECONDS);

}

cacheBuilder.recordStats();

return cacheBuilder.build();

}

}package com.axin.idea.rediscaffeinecachestarter.support;

import com.axin.idea.rediscaffeinecachestarter.CacheRedisCaffeineProperties;

import com.github.benmanes.caffeine.cache.Cache;

import lombok.Getter;

import org.slf4j.Logger;

import org.slf4j.LoggerFactory;

import org.springframework.cache.support.AbstractValueAdaptingCache;

import org.springframework.data.redis.core.RedisTemplate;

import org.springframework.util.StringUtils;

import java.time.Duration;

import java.util.HashMap;

import java.util.Map;

import java.util.Set;

import java.util.concurrent.Callable;

import java.util.concurrent.ConcurrentHashMap;

import java.util.concurrent.TimeUnit;

import java.util.concurrent.locks.ReentrantLock;

public class RedisCaffeineCache extends AbstractValueAdaptingCache {

private final Logger logger = LoggerFactory.getLogger(RedisCaffeineCache.class);

private String name;

private RedisTemplate<Object, Object> redisTemplate;

@Getter

private Cache<Object, Object> caffeineCache;

private String cachePrefix;

/**

* 默认key超时时间 3600s

*/

private long defaultExpiration = 3600;

private Map<String, Long> defaultExpires = new HashMap<>();

{

defaultExpires.put(CacheNames.CACHE_15MINS, TimeUnit.MINUTES.toSeconds(15));

defaultExpires.put(CacheNames.CACHE_30MINS, TimeUnit.MINUTES.toSeconds(30));

defaultExpires.put(CacheNames.CACHE_60MINS, TimeUnit.MINUTES.toSeconds(60));

defaultExpires.put(CacheNames.CACHE_180MINS, TimeUnit.MINUTES.toSeconds(180));

defaultExpires.put(CacheNames.CACHE_12HOUR, TimeUnit.HOURS.toSeconds(12));

}

private String topic;

private Map<String, ReentrantLock> keyLockMap = new ConcurrentHashMap();

protected RedisCaffeineCache(boolean allowNullValues) {

super(allowNullValues);

}

public RedisCaffeineCache(String name, RedisTemplate<Object, Object> redisTemplate,

Cache<Object, Object> caffeineCache, CacheRedisCaffeineProperties cacheRedisCaffeineProperties) {

super(cacheRedisCaffeineProperties.isCacheNullValues());

this.name = name;

this.redisTemplate = redisTemplate;

this.caffeineCache = caffeineCache;

this.cachePrefix = cacheRedisCaffeineProperties.getCachePrefix();

this.defaultExpiration = cacheRedisCaffeineProperties.getRedis().getDefaultExpiration();

this.topic = cacheRedisCaffeineProperties.getRedis().getTopic();

defaultExpires.putAll(cacheRedisCaffeineProperties.getRedis().getExpires());

}

@Override

public String getName() {

return this.name;

}

@Override

public Object getNativeCache() {

return this;

}

@Override

public <T> T get(Object key, Callable<T> valueLoader) {

Object value = lookup(key);

if (value != null) {

return (T) value;

}

//key在redis和缓存中均不存在

ReentrantLock lock = keyLockMap.get(key.toString());

if (lock == null) {

logger.debug("create lock for key : {}", key);

keyLockMap.putIfAbsent(key.toString(), new ReentrantLock());

lock = keyLockMap.get(key.toString());

}

try {

lock.lock();

value = lookup(key);

if (value != null) {

return (T) value;

}

//执行原方法获得value

value = valueLoader.call();

Object storeValue = toStoreValue(value);

put(key, storeValue);

return (T) value;

} catch (Exception e) {

throw new ValueRetrievalException(key, valueLoader, e.getCause());

} finally {

lock.unlock();

}

}

@Override

public void put(Object key, Object value) {

if (!super.isAllowNullValues() && value == null) {

this.evict(key);

return;

}

long expire = getExpire();

logger.debug("put:{},expire:{}", getKey(key), expire);

redisTemplate.opsForValue().set(getKey(key), toStoreValue(value), expire, TimeUnit.SECONDS);

//缓存变更时通知其他节点清理本地缓存

push(new CacheMessage(this.name, key));

//此处put没有意义,会收到自己发送的缓存key失效消息

// caffeineCache.put(key, value);

}

@Override

public ValueWrapper putIfAbsent(Object key, Object value) {

Object cacheKey = getKey(key);

// 使用setIfAbsent原子性操作

long expire = getExpire();

boolean setSuccess;

setSuccess = redisTemplate.opsForValue().setIfAbsent(getKey(key), toStoreValue(value), Duration.ofSeconds(expire));

Object hasValue;

//setNx结果

if (setSuccess) {

push(new CacheMessage(this.name, key));

hasValue = value;

}else {

hasValue = redisTemplate.opsForValue().get(cacheKey);

}

caffeineCache.put(key, toStoreValue(value));

return toValueWrapper(hasValue);

}

@Override

public void evict(Object key) {

// 先清除redis中缓存数据,然后清除caffeine中的缓存,避免短时间内如果先清除caffeine缓存后其他请求会再从redis里加载到caffeine中

redisTemplate.delete(getKey(key));

push(new CacheMessage(this.name, key));

caffeineCache.invalidate(key);

}

@Override

public void clear() {

// 先清除redis中缓存数据,然后清除caffeine中的缓存,避免短时间内如果先清除caffeine缓存后其他请求会再从redis里加载到caffeine中

Set<Object> keys = redisTemplate.keys(this.name.concat(":*"));

for (Object key : keys) {

redisTemplate.delete(key);

}

push(new CacheMessage(this.name, null));

caffeineCache.invalidateAll();

}

/**

* 取值逻辑

* @param key

* @return

*/

@Override

protected Object lookup(Object key) {

Object cacheKey = getKey(key);

Object value = caffeineCache.getIfPresent(key);

if (value != null) {

logger.debug("从本地缓存中获得key, the key is : {}", cacheKey);

return value;

}

value = redisTemplate.opsForValue().get(cacheKey);

if (value != null) {

logger.debug("从redis中获得值,将值放到本地缓存中, the key is : {}", cacheKey);

caffeineCache.put(key, value);

}

return value;

}

/**

* @description 清理本地缓存

*/

public void clearLocal(Object key) {

logger.debug("clear local cache, the key is : {}", key);

if (key == null) {

caffeineCache.invalidateAll();

} else {

caffeineCache.invalidate(key);

}

}

//————————————————————————————私有方法——————————————————————————

private Object getKey(Object key) {

String keyStr = this.name.concat(":").concat(key.toString());

return StringUtils.isEmpty(this.cachePrefix) ? keyStr : this.cachePrefix.concat(":").concat(keyStr);

}

private long getExpire() {

long expire = defaultExpiration;

Long cacheNameExpire = defaultExpires.get(this.name);

return cacheNameExpire == null ? expire : cacheNameExpire.longValue();

}

/**

* @description 缓存变更时通知其他节点清理本地缓存

*/

private void push(CacheMessage message) {

redisTemplate.convertAndSend(topic, message);

}

}Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment construire le mode Cluster Redis

Apr 10, 2025 pm 10:15 PM

Comment construire le mode Cluster Redis

Apr 10, 2025 pm 10:15 PM

Le mode Redis Cluster déploie les instances Redis sur plusieurs serveurs grâce à la rupture, à l'amélioration de l'évolutivité et de la disponibilité. Les étapes de construction sont les suivantes: Créez des instances de redis étranges avec différents ports; Créer 3 instances Sentinel, Moniteur Redis Instances et basculement; Configurer les fichiers de configuration Sentinel, ajouter des informations d'instance Redis de surveillance et des paramètres de basculement; Configurer les fichiers de configuration d'instance Redis, activer le mode de cluster et spécifier le chemin du fichier d'informations de cluster; Créer un fichier nœuds.conf, contenant des informations de chaque instance redis; Démarrez le cluster, exécutez la commande CREATE pour créer un cluster et spécifiez le nombre de répliques; Connectez-vous au cluster pour exécuter la commande d'informations de cluster pour vérifier l'état du cluster; faire

Comment effacer les données redis

Apr 10, 2025 pm 10:06 PM

Comment effacer les données redis

Apr 10, 2025 pm 10:06 PM

Comment effacer les données Redis: utilisez la commande flushall pour effacer toutes les valeurs de clé. Utilisez la commande flushdb pour effacer la valeur clé de la base de données actuellement sélectionnée. Utilisez SELECT pour commuter les bases de données, puis utilisez FlushDB pour effacer plusieurs bases de données. Utilisez la commande del pour supprimer une clé spécifique. Utilisez l'outil Redis-CLI pour effacer les données.

Comment utiliser la commande redis

Apr 10, 2025 pm 08:45 PM

Comment utiliser la commande redis

Apr 10, 2025 pm 08:45 PM

L'utilisation de la directive Redis nécessite les étapes suivantes: Ouvrez le client Redis. Entrez la commande (Verbe Key Value). Fournit les paramètres requis (varie de l'instruction à l'instruction). Appuyez sur Entrée pour exécuter la commande. Redis renvoie une réponse indiquant le résultat de l'opération (généralement OK ou -err).

Comment lire la file d'attente redis

Apr 10, 2025 pm 10:12 PM

Comment lire la file d'attente redis

Apr 10, 2025 pm 10:12 PM

Pour lire une file d'attente à partir de Redis, vous devez obtenir le nom de la file d'attente, lire les éléments à l'aide de la commande LPOP et traiter la file d'attente vide. Les étapes spécifiques sont les suivantes: Obtenez le nom de la file d'attente: Nommez-le avec le préfixe de "Fitre:" tel que "Fitre: My-Quyue". Utilisez la commande LPOP: éjectez l'élément de la tête de la file d'attente et renvoyez sa valeur, telle que la file d'attente LPOP: My-Queue. Traitement des files d'attente vides: si la file d'attente est vide, LPOP renvoie NIL et vous pouvez vérifier si la file d'attente existe avant de lire l'élément.

Comment utiliser Redis Lock

Apr 10, 2025 pm 08:39 PM

Comment utiliser Redis Lock

Apr 10, 2025 pm 08:39 PM

L'utilisation des opérations Redis pour verrouiller nécessite l'obtention du verrouillage via la commande setnx, puis en utilisant la commande Expire pour définir le temps d'expiration. Les étapes spécifiques sont les suivantes: (1) Utilisez la commande setnx pour essayer de définir une paire de valeurs de clé; (2) Utilisez la commande Expire pour définir le temps d'expiration du verrou; (3) Utilisez la commande del pour supprimer le verrouillage lorsque le verrouillage n'est plus nécessaire.

Comment implémenter le redis sous-jacent

Apr 10, 2025 pm 07:21 PM

Comment implémenter le redis sous-jacent

Apr 10, 2025 pm 07:21 PM

Redis utilise des tables de hachage pour stocker les données et prend en charge les structures de données telles que les chaînes, les listes, les tables de hachage, les collections et les collections ordonnées. Redis persiste les données via des instantanés (RDB) et ajoutez les mécanismes d'écriture uniquement (AOF). Redis utilise la réplication maître-esclave pour améliorer la disponibilité des données. Redis utilise une boucle d'événement unique pour gérer les connexions et les commandes pour assurer l'atomicité et la cohérence des données. Redis définit le temps d'expiration de la clé et utilise le mécanisme de suppression paresseux pour supprimer la clé d'expiration.

Comment lire le code source de Redis

Apr 10, 2025 pm 08:27 PM

Comment lire le code source de Redis

Apr 10, 2025 pm 08:27 PM

La meilleure façon de comprendre le code source redis est d'aller étape par étape: familiarisez-vous avec les bases de Redis. Sélectionnez un module ou une fonction spécifique comme point de départ. Commencez par le point d'entrée du module ou de la fonction et affichez le code ligne par ligne. Affichez le code via la chaîne d'appel de fonction. Familiez les structures de données sous-jacentes utilisées par Redis. Identifiez l'algorithme utilisé par Redis.

Comment faire du message middleware pour redis

Apr 10, 2025 pm 07:51 PM

Comment faire du message middleware pour redis

Apr 10, 2025 pm 07:51 PM

Redis, en tant que Message Middleware, prend en charge les modèles de consommation de production, peut persister des messages et assurer une livraison fiable. L'utilisation de Redis comme Message Middleware permet une faible latence, une messagerie fiable et évolutive.