Périphériques technologiques

Périphériques technologiques

IA

IA

Quelqu'un a enfin fait comprendre la situation actuelle de GPT ! Le dernier discours d'OpenAI est devenu viral, et ce doit être un génie choisi par Musk

Quelqu'un a enfin fait comprendre la situation actuelle de GPT ! Le dernier discours d'OpenAI est devenu viral, et ce doit être un génie choisi par Musk

Quelqu'un a enfin fait comprendre la situation actuelle de GPT ! Le dernier discours d'OpenAI est devenu viral, et ce doit être un génie choisi par Musk

Suite à la sortie de Windows Copilot, la popularité de la conférence Microsoft Build a été déclenchée par un discours.

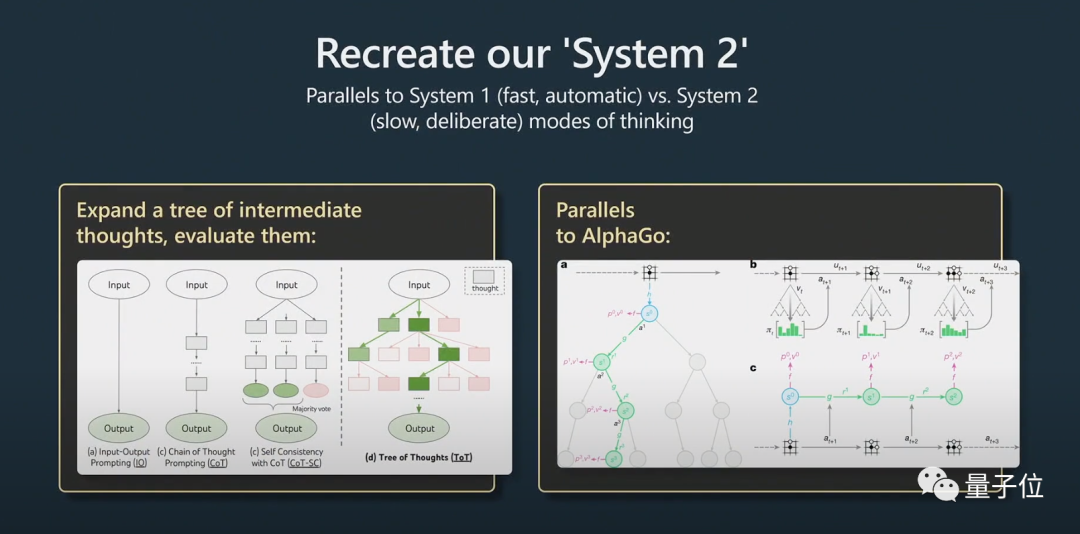

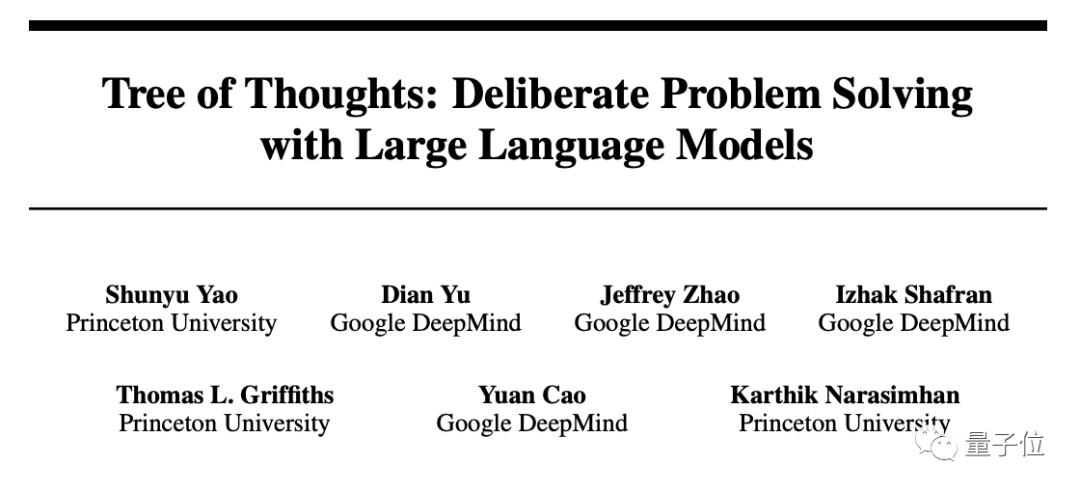

L'ancien directeur de l'IA de Tesla, Andrej Karpathy, a cru dans son discours que l'arbre des pensées est similaire au Monte Carlo Tree Search (MCTS) d'AlphaGo !

Les internautes ont crié : C'est le guide le plus détaillé et le plus intéressant sur la façon d'utiliser les grands modèles de langage et les modèles GPT-4 !

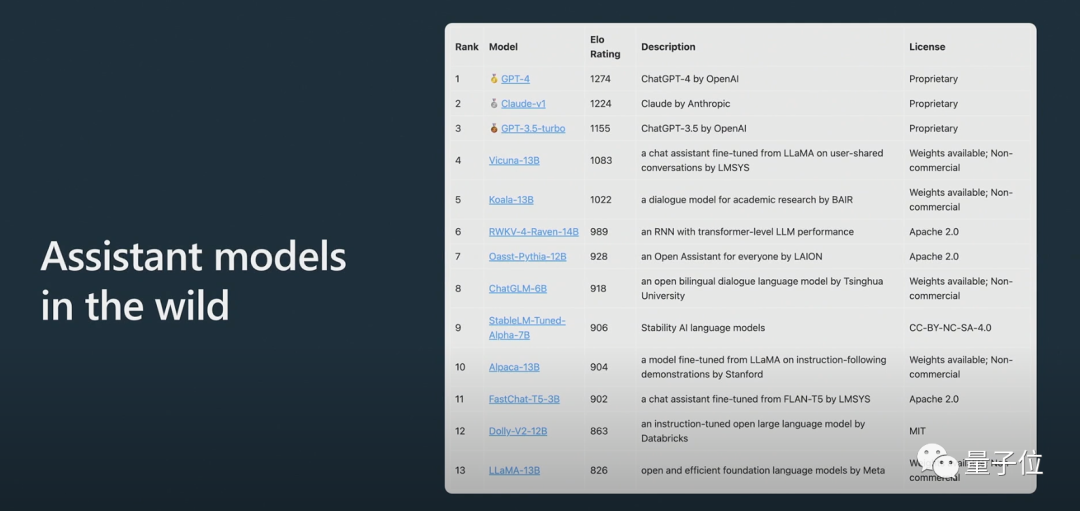

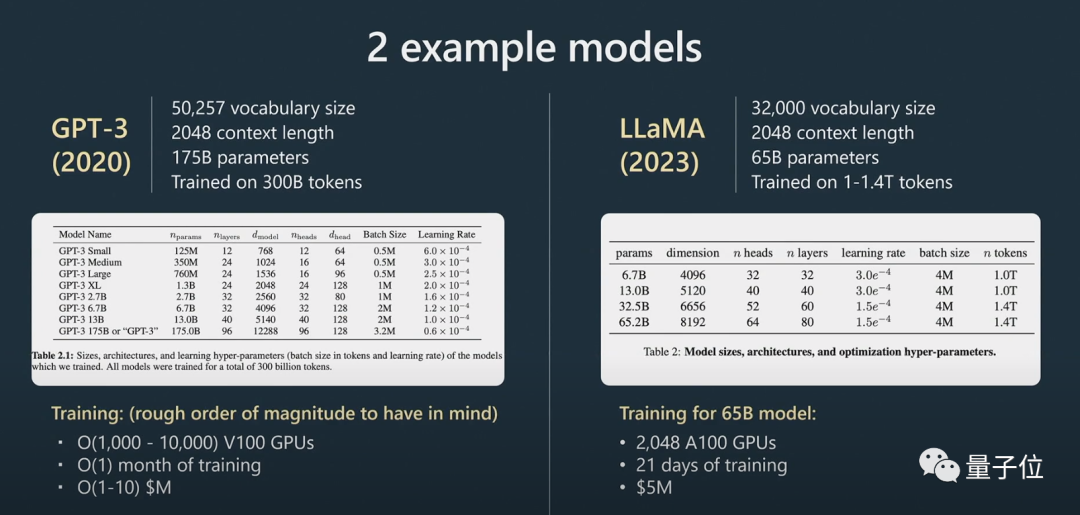

De plus, Karpathy a révélé que LLAMA 65B est "nettement plus puissant que GPT-3 175B" en raison de la formation et de l'expansion des données, et a présenté le grand modèle d'arène anonyme ChatBot Arena :

Claude obtient des scores entre ChatGPT Entre 3.5 et ChatGPT 4.

Les internautes ont déclaré que les discours de Karpathy sont toujours excellents et que le contenu cette fois n'a pas déçu tout le monde, comme toujours.

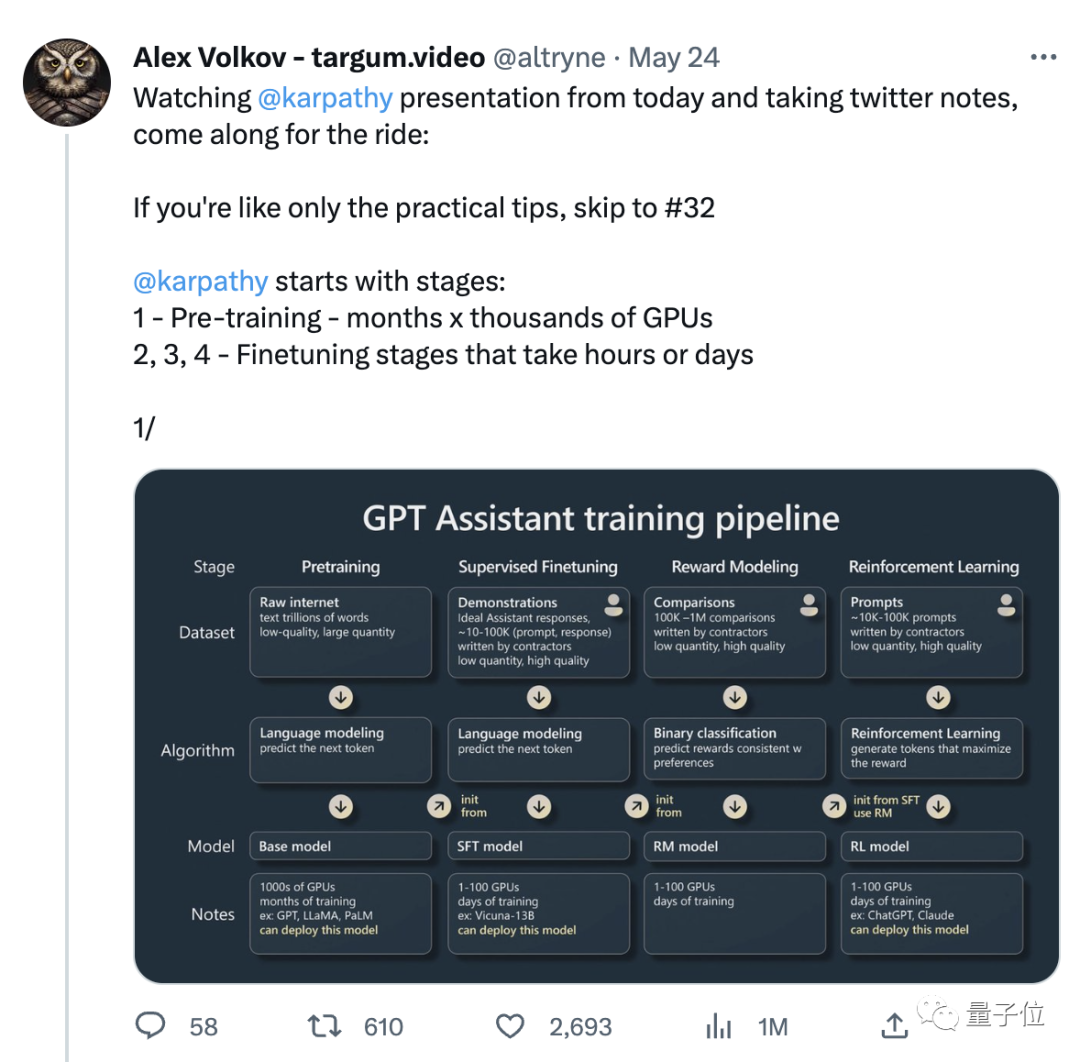

Avec le discours, il y a aussi une note que les utilisateurs de Twitter ont compilée sur la base du discours. Il y a 31 notes, et le nombre de likes a dépassé les 3000+ :

Donc, ce paragraphe est préparé. Un contenu spécifique a été mentionné dans le discours et a attiré beaucoup d'attention ?

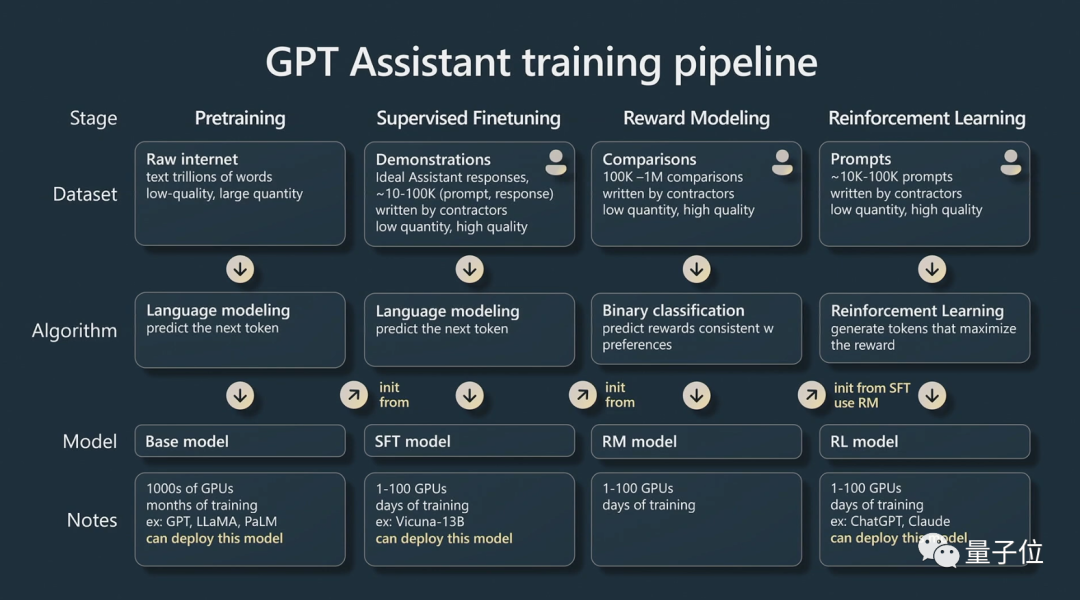

Comment former l'Assistant GPT ?

Le discours de Karpathy est cette fois principalement divisé en deux parties.

Partie 1, il a expliqué comment former un "Assistant GPT".

Karpathy parle principalement des quatre étapes de formation de l'assistant IA :

pré-formation, réglage fin supervisé, modélisation des récompenses et apprentissage par renforcement.

Chaque étape nécessite un ensemble de données.

Dans la phase de pré-formation, une grande quantité de ressources informatiques doit être utilisée pour collecter un grand nombre d'ensembles de données. Un modèle de base est formé sur un vaste ensemble de données non supervisées.

Karpathy a utilisé plus d'exemples pour compléter :

Ensuite, nous entrons dans la phase de mise au point.

Utilisez un ensemble de données supervisées plus petit et affinez ce modèle de base grâce à l'apprentissage supervisé pour créer un modèle d'assistant qui peut répondre à la question.

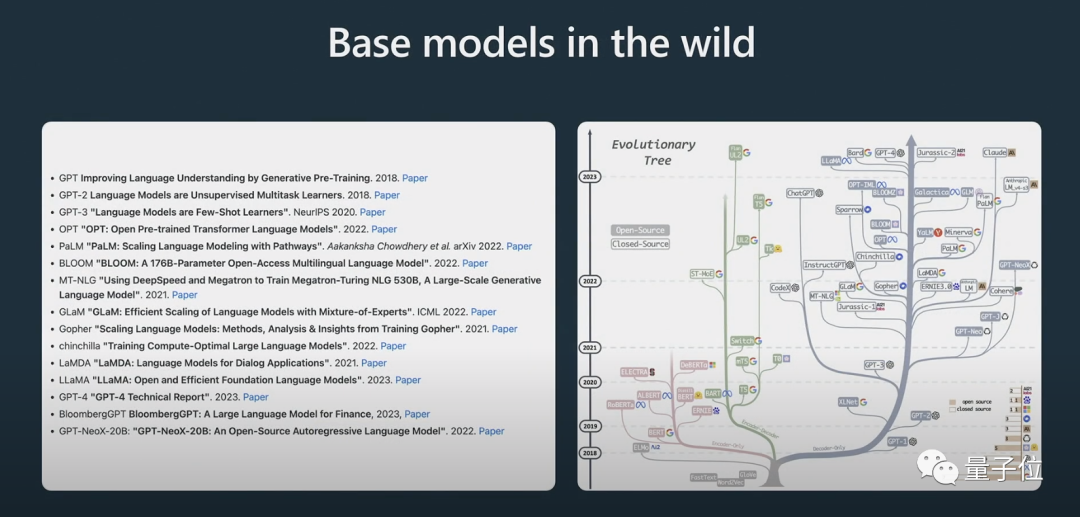

Il a également montré le processus d'évolution de certains modèles. Je crois que beaucoup de gens ont déjà vu l'image de "l'arbre évolutif" ci-dessus.

Karpathy estime que le meilleur modèle open source actuellement est la série LLaMA de Meta (car OpenAI n'a rien open source sur GPT-4).

Ce qui doit être clairement souligné ici, c'est que le modèle de base n'est pas un modèle assistant.

Bien que le modèle de base ait la capacité de résoudre le problème, les réponses qu'il donne ne sont pas dignes de confiance, tandis que le modèle assistant peut fournir des réponses fiables. Le modèle d'assistant supervisé et affiné est formé sur la base du modèle de base, et ses performances dans la génération de réponses et la compréhension de la structure du texte seront meilleures que celles du modèle de base.

L'apprentissage par renforcement est un autre processus clé lors de la formation de modèles linguistiques.

Des données annotées manuellement de haute qualité sont utilisées pendant le processus de formation et une fonction de perte est créée de manière à modéliser les récompenses pour améliorer ses performances. La formation de renforcement peut être réalisée en augmentant la probabilité de notation positive et en diminuant la probabilité de notation négative.

Le jugement humain est crucial pour améliorer les modèles d'IA lorsqu'il s'agit de tâches créatives, et les modèles peuvent être formés plus efficacement en intégrant les commentaires humains.

Après un apprentissage par renforcement avec feedback humain, un modèle RLHF peut être obtenu.

Une fois les modèles formés, l'étape suivante consiste à savoir comment utiliser efficacement ces modèles pour résoudre des problèmes.

Comment mieux utiliser les modèles ?

Dans la deuxième partie de , Karpathy discute des stratégies d'incitation, des réglages fins, de l'écosystème d'outils en évolution rapide et de l'expansion future.

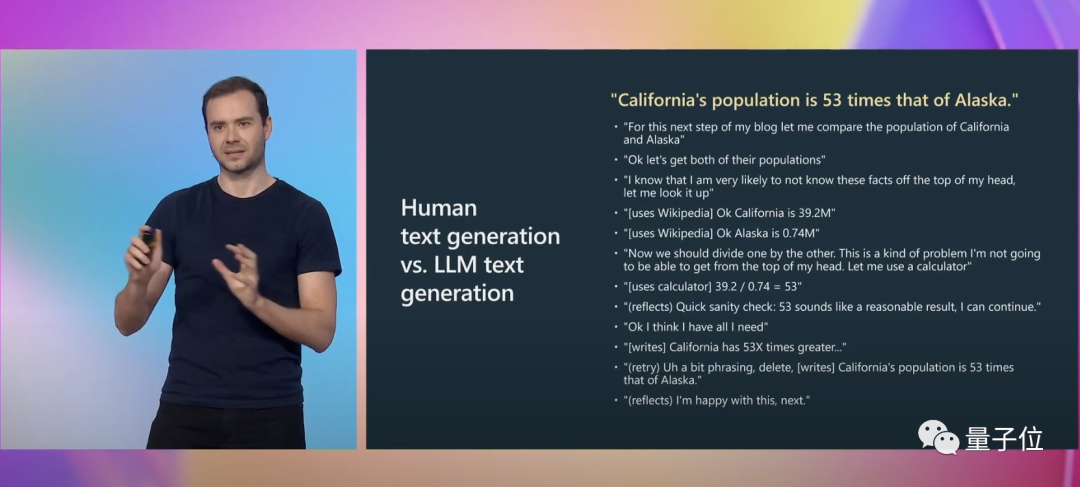

Karpathy a donné un autre exemple précis pour illustrer :

Lors de l'écriture , nous devons effectuer de nombreuses activités mentales, notamment déterminer si notre expression est exacte. Pour GPT, il s’agit simplement d’une séquence de jetons balisés.

Et invite peuvent combler cet écart cognitif.

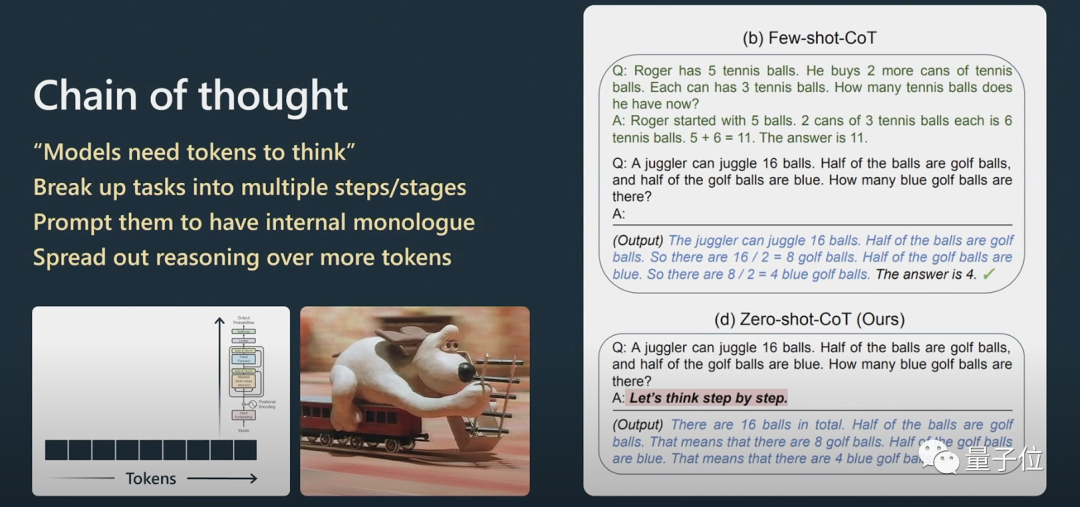

Karpathy a expliqué plus en détail comment les invites THINKLINK fonctionnent.

Pour les problèmes de raisonnement, si vous souhaitez que Transformer soit plus performant dans le traitement du langage naturel, vous devez le laisser traiter les informations étape par étape au lieu de lui lancer directement un problème très complexe.

Si vous lui donnez quelques exemples, il imitera le modèle de cet exemple et le résultat final sera meilleur. Un modèle ne peut répondre aux questions dans sa séquence que si ce qu'il génère est faux. Oui, vous pouvez l'inviter à se régénérer.

Si vous ne lui demandez pas de vérifier, il ne se vérifiera pas tout seul.

Le lauréat du prix Nobel d'économie Daniel Kahneman a proposé dans "Penser vite et lentement" que le système cognitif humain se compose de deux sous-systèmes, Système1 et Système2. System1 repose principalement sur l'intuition, tandis que System2 est un système d'analyse logique.Cela implique le problème du Système1 et du Système2.

En termes simples, System1 est un processus rapide et généré automatiquement, tandis que System2 est une partie bien pensée.

Quand AlphaGo joue au Go, il doit réfléchir à l'endroit où placer la pièce suivante. Au départ, il a appris en imitant les humains.

Quand AlphaGo joue au Go, il doit réfléchir à l'endroit où placer la pièce suivante. Au départ, il a appris en imitant les humains.

À cet égard, Karpathy a également mentionné AutoGPT :

Je pense que son effet n'est pas très bon à l'heure actuelle, et je ne le recommande pas vous la pratiquez. Je pense qu’avec le temps, nous pourrons peut-être tirer des leçons de son évolution.

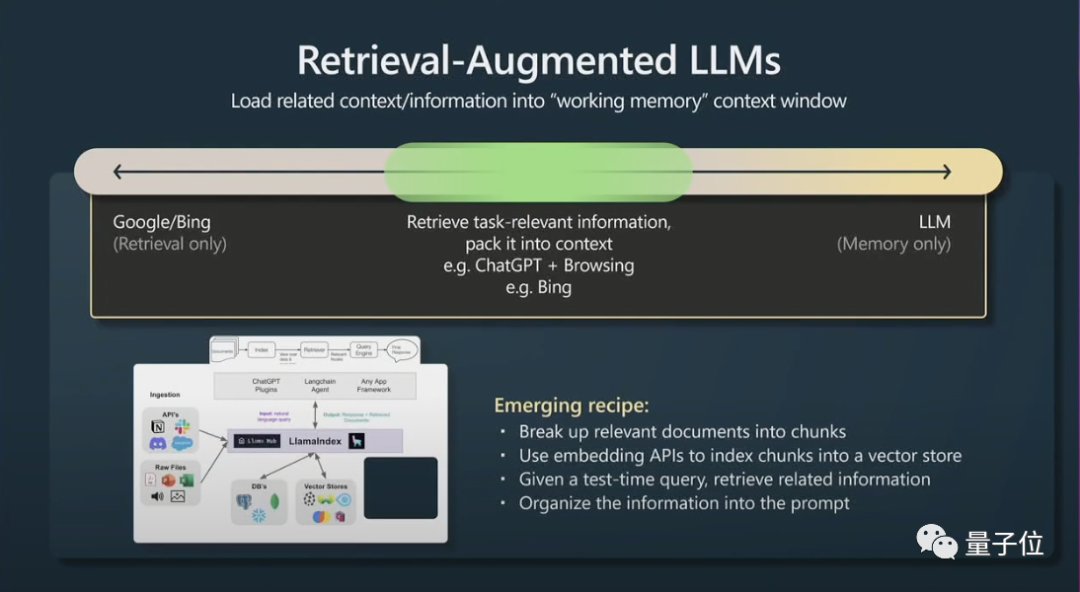

Le contenu du contexte de la fenêtre est la mémoire de travail des transformateurs au moment de l'exécution. Si vous pouvez ajouter des informations relatives aux tâches au contexte, alors ses performances seront très bonnes, car il peut accéder à ces informations maintenant. .Deuxièmement, il y a une petite astuce pour récupérer la génération améliorée (récupération de génération agumentée) et efficace indice.

En bref, cela signifie que les données pertinentes peuvent être indexées afin que le modèle soit accessible efficacement.

Les Transformers fonctionneront mieux s'ils ont également un fichier principal à référencer.

Enfin, Karpathy a brièvement parlé de l'incitation et du réglage des contraintes dans les grands modèles de langage.

Les grands modèles de langage peuvent être améliorés grâce à des conseils de contraintes et à des ajustements précis. Les conseils de contraintes appliquent les modèles dans la sortie de modèles de langage volumineux, tandis que le réglage fin ajuste les pondérations du modèle pour améliorer les performances.

Je recommande d'utiliser de grands modèles de langage dans des applications à faible risque, en les combinant toujours avec une supervision humaine, en les traitant comme une source d'inspiration et de conseils, et en envisageant des copilotes plutôt que d'en faire des agents totalement autonomes.

À propos d'Andrej Karpathy

Le premier emploi du Dr Andrej Karpathy après l'obtention de son diplôme était d'étudier la vision par ordinateur à OpenAI.

Plus tard, Musk, l'un des co-fondateurs d'OpenAI, est tombé amoureux de Karpathy et l'a embauché chez Tesla. Musk et OpenAI étaient en désaccord sur la question, et Musk a finalement été exclu. Karpathy est responsable du pilote automatique, du FSD et d'autres projets de Tesla.

En février de cette année, 7 mois après avoir quitté Tesla, Karpathy a de nouveau rejoint OpenAI.

Récemment, il a tweeté qu'il était actuellement très intéressé par le développement de l'écosystème de grands modèles de langage open source, ce qui est un peu comme les signes de l'explosion cambrienne précoce.

Portail :

[1]https://www.youtube.com/watch?v=xO73EUwSegU (discours vidéo)

[2]https://arxiv . org/PDF/2305.10601.pdf (Thèse "Arbre de la Pensée")

Lien de référence :

[1] https://twitter.com/altryne/status/16612367888832896

[ 2 ]https://www.reddit.com/r/MachineLearning/comments/13qrtek/n_state_of_gpt_by_andrej_karpathy_in_msbuild_2023/

[3]https://www.wisdominanutshell.academy/state-of-gpt/

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Dois-je choisir MBR ou GPT comme format de disque dur pour Win7 ?

Jan 03, 2024 pm 08:09 PM

Dois-je choisir MBR ou GPT comme format de disque dur pour Win7 ?

Jan 03, 2024 pm 08:09 PM

Lorsque nous utilisons le système d'exploitation Win7, nous pouvons parfois rencontrer des situations dans lesquelles nous devons réinstaller le système et partitionner le disque dur. Concernant la question de savoir si le format de disque dur win7 nécessite mbr ou gpt, l'éditeur pense que vous devez toujours faire un choix en fonction des détails de votre propre configuration système et matérielle. En termes de compatibilité, il est préférable de choisir le format mbr. Pour plus de détails, regardons ce que l'éditeur a fait ~ Le format de disque dur win7 nécessite mbr ou gpt1 Si le système est installé avec Win7, il est recommandé d'utiliser MBR, qui a une bonne compatibilité. 2. S'il dépasse 3T ou si vous installez Win8, vous pouvez utiliser GPT. 3. Bien que GPT soit effectivement plus avancé que MBR, MBR est définitivement invincible en termes de compatibilité. Zones GPT et MBR

Compréhension approfondie du format de partition Win10 : comparaison GPT et MBR

Dec 22, 2023 am 11:58 AM

Compréhension approfondie du format de partition Win10 : comparaison GPT et MBR

Dec 22, 2023 am 11:58 AM

Lors du partitionnement de leurs propres systèmes, en raison des différents disques durs utilisés par les utilisateurs, de nombreux utilisateurs ne connaissent pas le format de partition win10 gpt ou mbr. Pour cette raison, nous vous avons présenté une introduction détaillée pour vous aider à comprendre la différence entre les deux. Format de partition Win10 gpt ou mbr : Réponse : Si vous utilisez un disque dur dépassant 3 To, vous pouvez utiliser gpt. gpt est plus avancé que mbr, mais mbr est toujours meilleur en termes de compatibilité. Bien entendu, cela peut également être choisi en fonction des préférences de l'utilisateur. La différence entre gpt et mbr : 1. Nombre de partitions prises en charge : 1. MBR prend en charge jusqu'à 4 partitions principales. 2. GPT n'est pas limité par le nombre de partitions. 2. Taille de disque dur prise en charge : 1. MBR ne prend en charge que jusqu'à 2 To.

L'arme ultime pour le débogage de Kubernetes : K8sGPT

Feb 26, 2024 am 11:40 AM

L'arme ultime pour le débogage de Kubernetes : K8sGPT

Feb 26, 2024 am 11:40 AM

À mesure que les technologies d’intelligence artificielle et d’apprentissage automatique continuent de se développer, les entreprises et les organisations ont commencé à explorer activement des stratégies innovantes pour tirer parti de ces technologies afin d’améliorer leur compétitivité. K8sGPT[2] est l'un des outils les plus puissants dans ce domaine. Il s'agit d'un modèle GPT basé sur k8s, qui combine les avantages de l'orchestration k8s avec les excellentes capacités de traitement du langage naturel du modèle GPT. Qu'est-ce que K8sGPT ? Regardons d'abord un exemple : Selon le site officiel de K8sGPT : K8sgpt est un outil conçu pour analyser, diagnostiquer et classer les problèmes du cluster Kubernetes. Il intègre l'expérience SRE dans son moteur d'analyse pour fournir les informations les plus pertinentes. Grâce à l'application de la technologie de l'intelligence artificielle, K8sgpt continue d'enrichir son contenu et d'aider les utilisateurs à comprendre plus rapidement et plus précisément.

Comment déterminer si le disque dur de l'ordinateur utilise la méthode de partitionnement GPT ou MBR

Dec 25, 2023 pm 10:57 PM

Comment déterminer si le disque dur de l'ordinateur utilise la méthode de partitionnement GPT ou MBR

Dec 25, 2023 pm 10:57 PM

Comment vérifier si le disque dur d'un ordinateur est une partition GPT ou une partition MBR ? Lorsque nous utilisons un disque dur d'ordinateur, nous devons faire la distinction entre GPT et MBR. En fait, cette méthode de vérification est très simple. . Comment vérifier si le disque dur de l'ordinateur est GPT ou MBR 1. Cliquez avec le bouton droit sur « Ordinateur » sur le bureau et cliquez sur « Gérer » 2. Recherchez « Gestion des disques » dans « Gestion » 3. Entrez dans Gestion des disques pour voir l'état général de notre disque dur, puis Comment vérifier le mode de partition de mon disque dur, faites un clic droit sur "Disque 0" et sélectionnez "Propriétés" 4. Basculez vers l'onglet "Volume" dans "Propriétés", nous pouvons alors voir la "Partition du disque Form" et vous pouvez le voir comme Problèmes liés au disque Win10 de la partition MBR Comment convertir la partition MBR en partition GPT >

Combien des trois défauts majeurs du LLM connaissez-vous ?

Nov 26, 2023 am 11:26 AM

Combien des trois défauts majeurs du LLM connaissez-vous ?

Nov 26, 2023 am 11:26 AM

Science : Loin d’être une entité éternellement bienveillante et bénéfique, l’IA générale sensible du futur sera probablement un sociopathe manipulateur qui dévore toutes vos données personnelles et s’effondre ensuite lorsque cela est le plus nécessaire. Traduit de 3WaysLLMsCanLetYouDown, auteur JoabJackson. OpenAI est sur le point de publier GPT-5, et le monde extérieur fonde de grands espoirs sur cela. Les prédictions les plus optimistes pensent même qu'il atteindra l'intelligence artificielle générale. Mais dans le même temps, le PDG Sam Altman et son équipe sont confrontés à de nombreux obstacles sérieux pour le commercialiser, ce qu'il a reconnu plus tôt ce mois-ci. Certains articles de recherche récemment publiés pourraient fournir des indices sur le défi d'Altman. Résumé de ces articles

Pratique de déploiement de la localisation d'Alpaca-lora avec un grand modèle de langage GPT

Jun 01, 2023 pm 09:04 PM

Pratique de déploiement de la localisation d'Alpaca-lora avec un grand modèle de langage GPT

Jun 01, 2023 pm 09:04 PM

Introduction du modèle : Le modèle Alpaca est un modèle open source LLM (Large Language Model, big language) développé par l'Université de Stanford. Il est affiné à partir du modèle LLaMA7B (7B open source de la société Meta) sur 52 000 instructions. paramètres du modèle (plus les paramètres du modèle sont grands, plus les paramètres du modèle sont grands), plus la capacité de raisonnement du modèle est forte, bien sûr, plus le coût de formation du modèle est élevé). LoRA, le nom anglais complet est Low-RankAdaptation of Large Language Models, traduit littéralement par adaptation de bas niveau de grands modèles de langage. Il s'agit d'une technologie développée par les chercheurs de Microsoft pour résoudre le réglage fin des grands modèles de langage. Si vous souhaitez qu'un grand modèle de langage pré-entraîné soit capable d'exécuter un domaine spécifique

Comment a évolué la technologie GPT choisie par Bill Gates, et qui a-t-elle révolutionné la vie ?

May 28, 2023 pm 03:13 PM

Comment a évolué la technologie GPT choisie par Bill Gates, et qui a-t-elle révolutionné la vie ?

May 28, 2023 pm 03:13 PM

Xi Xiaoyao Science and Technology Talks Auteur original | Le QI a complètement chuté, Python Que se passera-t-il si les machines peuvent comprendre et communiquer d'une manière similaire aux humains ? Cela a été un sujet de grande préoccupation dans la communauté universitaire, et grâce à une série de percées dans le traitement du langage naturel ces dernières années, nous pourrions être plus proches que jamais d’atteindre cet objectif. À l'avant-garde de cette avancée se trouve le Generative Pre-trained Transformer (GPT), un modèle de réseau neuronal profond spécialement conçu pour les tâches de traitement du langage naturel. Ses performances exceptionnelles et sa capacité à tenir des conversations efficaces en ont fait l’un des modèles les plus utilisés et les plus efficaces dans le domaine, attirant une attention considérable de la part de la recherche et de l’industrie. Dans un récent rapport détaillé

Le disque SSD est-il initialisé sur mbr ou gpt ?

Mar 10, 2023 pm 02:48 PM

Le disque SSD est-il initialisé sur mbr ou gpt ?

Mar 10, 2023 pm 02:48 PM

Le disque SSD est initialisé avec gpt. GPT présente les avantages de la taille et du nombre de partitions, et il est plus avancé et plus robuste. Tous les systèmes informatiques y évoluent. GPT est une nouvelle norme et remplacera progressivement le MBR à l'avenir. Microsoft a également officiellement annoncé que le système Windows 11 ne prendrait en charge que GPT et UEFI ; par conséquent, si vous envisagez de mettre à niveau votre système Windows vers Windows 11, vous devez d'abord convertir le MBR en GPT ;