Comment configurer la limitation de courant Nginx

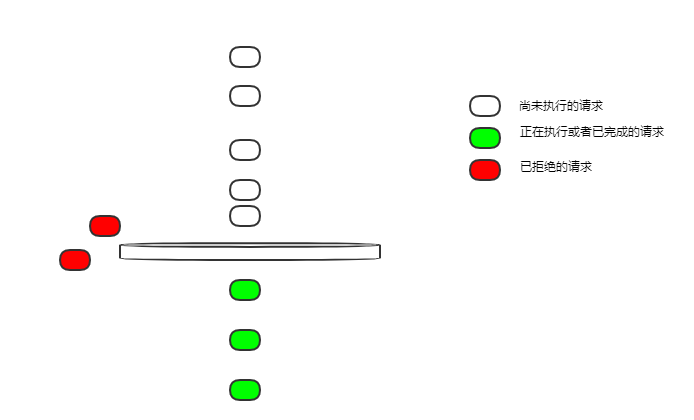

Seau vide

Nous commençons par la configuration de limitation de courant la plus simple :

limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit;

proxy_pass http://login_upstream;

}

}$binary_remote_addr pour la limitation de courant IP du client

zone=ip_limit:10m Le nom de la règle de limitation actuelle est ip_limit, ce qui est autorisé ; 10 Mo d'espace mémoire pour enregistrer l'état limite actuel correspondant à l'IP ; limite La vitesse de streaming est de 10 requêtes par seconde Si 10 requêtes arrivent sur un nginx inactif en même temps, seront-elles toutes exécutées ?

- Les demandes de fuite de seau qui fuit se font à une vitesse uniforme. Comment 10r/s est-il une vitesse constante ? Une requête est divulguée toutes les 100 ms.

- Dans cette configuration, le bucket est vide et toutes les demandes qui ne peuvent pas être divulguées en temps réel seront rejetées.

Donc si 10 demandes arrivent en même temps, une seule demande pourra être exécutée, et les autres seront rejetées. Ce n'est pas très convivial. Dans la plupart des scénarios commerciaux, nous espérons que ces 10 demandes pourront être exécutées.

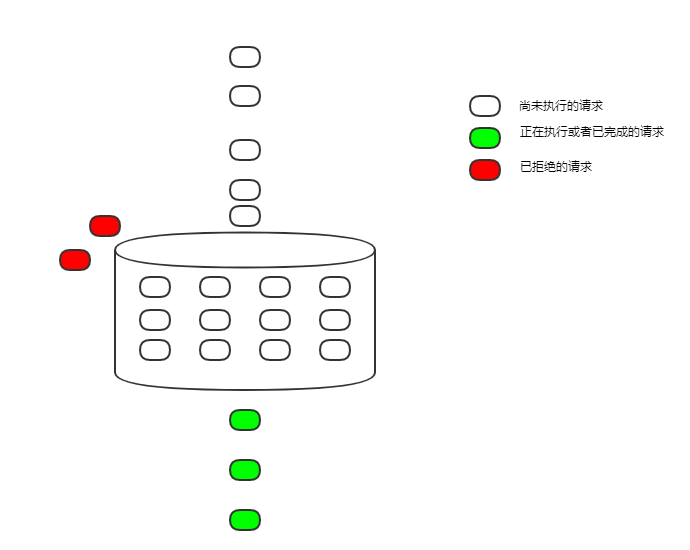

Changeons la configuration pour résoudre le problème de la section précédente

limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit burst=12;

proxy_pass http://login_upstream;

}

}burst=12 La taille du seau qui fuit est fixée à 12

C'est logiquement appelé seau qui fuit, et il est implémenté sous forme de file d'attente fifo, mettant temporairement en cache les requêtes qui ne peuvent pas être exécutées. La vitesse de fuite est toujours de 100 ms par requête, mais les requêtes qui arrivent simultanément et ne peuvent pas être exécutées temporairement peuvent d'abord être mises en cache. Ce n'est que lorsque la file d'attente est pleine que les nouvelles demandes seront refusées.

Bien qu'il ait été exécuté, le délai a été considérablement augmenté en raison de la file d'attente d'exécution, ce qui est encore inacceptable dans de nombreux scénarios.

nodelay

nodelay

Continuez à modifier la configuration pour résoudre le problème d'augmentation du délai causé par un délai trop long

limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit burst=12 nodelay;

proxy_pass http://login_upstream;

}

}nodelay Avancez l'heure de début de l'exécution de la requête. Dans le passé, elle était retardée jusqu'à ce qu'elle s'échappe. Le bucket. Désormais, il n'y a plus de délai. Dès qu'il est placé dans le bucket, il sera exécuté immédiatement ou la demande ne sera pas retardée en raison de la limitation de courant.

Parce que les requêtes s'échappent du bucket à une vitesse constante et que l'espace du bucket est fixe, au final, en moyenne, 5 requêtes sont exécutées par seconde, et l'objectif de limitation de courant est toujours atteint.

Mais cela présente aussi des inconvénients. La limite actuelle est limitée, mais la limite n'est pas si uniforme. En prenant la configuration ci-dessus comme exemple, si 12 requêtes arrivent en même temps, alors ces 12 requêtes peuvent être exécutées immédiatement, et les requêtes suivantes ne peuvent être saisies dans le compartiment qu'à une vitesse constante, et une requête sera exécutée toutes les 100 ms. S'il n'y a aucune requête pendant un certain temps et que le compartiment est vide, 12 requêtes simultanées peuvent être exécutées en même temps.

Dans la plupart des cas, cette limitation de courant inégale n'est pas un gros problème. Cependant, nginx fournit également un paramètre pour contrôler l'exécution simultanée, qui est le nombre de requêtes nodelay. Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit burst=12 delay=4;

proxy_pass http://login_upstream;

}

}

De cette façon, en contrôlant la valeur du paramètre delay, le nombre de requêtes pouvant être exécutées simultanément peut être ajusté pour effectuer les requêtes même et consommer certaines ressources. Encore faut-il contrôler cette quantité dans le service.

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1359

1359

52

52

Comment autoriser l'accès au réseau externe au serveur Tomcat

Apr 21, 2024 am 07:22 AM

Comment autoriser l'accès au réseau externe au serveur Tomcat

Apr 21, 2024 am 07:22 AM

Pour permettre au serveur Tomcat d'accéder au réseau externe, vous devez : modifier le fichier de configuration Tomcat pour autoriser les connexions externes. Ajoutez une règle de pare-feu pour autoriser l'accès au port du serveur Tomcat. Créez un enregistrement DNS pointant le nom de domaine vers l'adresse IP publique du serveur Tomcat. Facultatif : utilisez un proxy inverse pour améliorer la sécurité et les performances. Facultatif : configurez HTTPS pour une sécurité accrue.

Comment exécuter thinkphp

Apr 09, 2024 pm 05:39 PM

Comment exécuter thinkphp

Apr 09, 2024 pm 05:39 PM

Étapes pour exécuter ThinkPHP Framework localement : Téléchargez et décompressez ThinkPHP Framework dans un répertoire local. Créez un hôte virtuel (facultatif) pointant vers le répertoire racine ThinkPHP. Configurez les paramètres de connexion à la base de données. Démarrez le serveur Web. Initialisez l'application ThinkPHP. Accédez à l'URL de l'application ThinkPHP et exécutez-la.

Bienvenue sur nginx !Comment le résoudre ?

Apr 17, 2024 am 05:12 AM

Bienvenue sur nginx !Comment le résoudre ?

Apr 17, 2024 am 05:12 AM

Pour résoudre l'erreur "Bienvenue sur nginx!", vous devez vérifier la configuration de l'hôte virtuel, activer l'hôte virtuel, recharger Nginx, si le fichier de configuration de l'hôte virtuel est introuvable, créer une page par défaut et recharger Nginx, puis le message d'erreur. disparaîtra et le site Web sera affiché normalement.

Comment communiquer entre les conteneurs Docker

Apr 07, 2024 pm 06:24 PM

Comment communiquer entre les conteneurs Docker

Apr 07, 2024 pm 06:24 PM

Il existe cinq méthodes de communication de conteneur dans l'environnement Docker : réseau partagé, Docker Compose, proxy réseau, volume partagé et file d'attente de messages. En fonction de vos besoins d'isolation et de sécurité, choisissez la méthode de communication la plus appropriée, par exemple en utilisant Docker Compose pour simplifier les connexions ou en utilisant un proxy réseau pour augmenter l'isolation.

Comment s'inscrire à phpmyadmin

Apr 07, 2024 pm 02:45 PM

Comment s'inscrire à phpmyadmin

Apr 07, 2024 pm 02:45 PM

Pour vous inscrire à phpMyAdmin, vous devez d'abord créer un utilisateur MySQL et lui accorder des autorisations, puis télécharger, installer et configurer phpMyAdmin, et enfin vous connecter à phpMyAdmin pour gérer la base de données.

Comment déployer le projet nodejs sur le serveur

Apr 21, 2024 am 04:40 AM

Comment déployer le projet nodejs sur le serveur

Apr 21, 2024 am 04:40 AM

Étapes de déploiement de serveur pour un projet Node.js : Préparez l'environnement de déploiement : obtenez l'accès au serveur, installez Node.js, configurez un référentiel Git. Créez l'application : utilisez npm run build pour générer du code et des dépendances déployables. Téléchargez le code sur le serveur : via Git ou File Transfer Protocol. Installer les dépendances : connectez-vous en SSH au serveur et installez les dépendances de l'application à l'aide de npm install. Démarrez l'application : utilisez une commande telle que node index.js pour démarrer l'application ou utilisez un gestionnaire de processus tel que pm2. Configurer un proxy inverse (facultatif) : utilisez un proxy inverse tel que Nginx ou Apache pour acheminer le trafic vers votre application

Comment générer une URL à partir d'un fichier HTML

Apr 21, 2024 pm 12:57 PM

Comment générer une URL à partir d'un fichier HTML

Apr 21, 2024 pm 12:57 PM

La conversion d'un fichier HTML en URL nécessite un serveur Web, ce qui implique les étapes suivantes : Obtenir un serveur Web. Configurez un serveur Web. Téléchargez le fichier HTML. Créez un nom de domaine. Acheminez la demande.

Que faire si l'installation de phpmyadmin échoue

Apr 07, 2024 pm 03:15 PM

Que faire si l'installation de phpmyadmin échoue

Apr 07, 2024 pm 03:15 PM

Étapes de dépannage en cas d'échec de l'installation de phpMyAdmin : Vérifiez la configuration système requise (version PHP, version MySQL, serveur Web) ; activez les extensions PHP (mysqli, pdo_mysql, mbstring, token_get_all) ; vérifiez les paramètres du fichier de configuration (hôte, port, nom d'utilisateur, mot de passe) ; autorisations (propriété du répertoire, autorisations de fichiers) ; vérifier les paramètres du pare-feu (liste blanche des ports du serveur Web) ; consulter les journaux d'erreurs (/var/log/apache2/error.log ou /var/log/nginx/error.log) ; phpMonAdmin