Périphériques technologiques

Périphériques technologiques

IA

IA

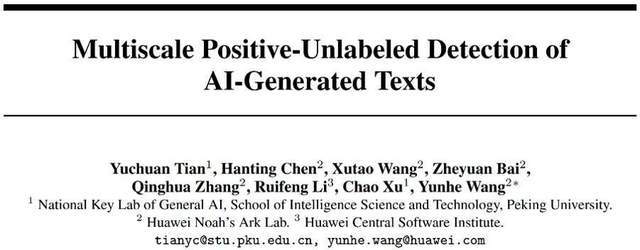

En identifiant la fraude ChatGPT, l'effet surpasse OpenAI : l'Université de Pékin et les détecteurs générés par l'IA de Huawei sont ici

En identifiant la fraude ChatGPT, l'effet surpasse OpenAI : l'Université de Pékin et les détecteurs générés par l'IA de Huawei sont ici

En identifiant la fraude ChatGPT, l'effet surpasse OpenAI : l'Université de Pékin et les détecteurs générés par l'IA de Huawei sont ici

Chronique Cœur de Machine

Département éditorial Heart of Machine

Le taux de réussite des fraudes à l'IA est très élevé. Il y a quelques jours, « 4,3 millions de personnes fraudées en 10 minutes » était un sujet de recherche brûlant. En s’appuyant sur le modèle de langage le plus en vogue, les chercheurs ont récemment exploré une méthode de reconnaissance.

Avec l’avancement continu des grands modèles génératifs, le corpus qu’ils génèrent se rapproche progressivement de celui des humains. Bien que les grands modèles libèrent les mains d'innombrables employés, leur puissante capacité à simuler de fausses maquettes a également été utilisée par certains criminels, provoquant une série de problèmes sociaux :

Des chercheurs de l'Université de Pékin et de Huawei ont proposé un détecteur de texte fiable pour identifier divers corpus générés par l'IA. Selon les différentes caractéristiques des textes longs et courts, une méthode d'entraînement au détecteur de texte généré par l'IA multi-échelle et basée sur l'apprentissage PU est proposée. En améliorant le processus de formation des détecteurs, des améliorations considérables des capacités de détection sur les corpus ChatGPT longs et courts peuvent être obtenues dans les mêmes conditions, résolvant ainsi le problème de la faible précision de la reconnaissance de textes courts par les détecteurs actuels.

Adresse papier :

https://arxiv.org/abs/2305.18149

Code adresse (MindSpore) :

https://github.com/mindspore-lab/mindone/tree/master/examples/detect_chatgpt

Adresse du code (PyTorch) :

https://github.com/YuchuanTian/AIGC_text_detector

Citation

Alors que les effets de génération de grands modèles de langage deviennent de plus en plus réalistes, diverses industries ont besoin de toute urgence d'un détecteur de texte fiable généré par l'IA. Cependant, différents secteurs ont des exigences différentes en matière de corpus de détection. Par exemple, dans le monde universitaire, il est généralement nécessaire de détecter des textes académiques volumineux et complets ; sur les plateformes sociales, les fausses nouvelles relativement courtes et fragmentées doivent être détectées. Cependant, les détecteurs existants ne peuvent souvent pas répondre à divers besoins. Par exemple, certains détecteurs de texte IA traditionnels ont généralement de faibles capacités de prédiction pour des corpus plus courts.

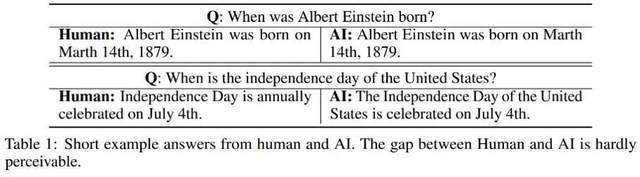

Concernant les différents effets de détection de corpus de différentes longueurs, l'auteur a observé que les textes plus courts générés par l'IA peuvent avoir une certaine « incertitude » dans leur attribution ou, plus crûment, parce que certaines phrases courtes générées par l'IA sont également souvent utilisées par les humains, donc ; il est difficile de définir si le texte court généré par l’IA provient d’humains ou d’IA. Voici quelques exemples d'humains et d'IA répondant à la même question :

On voit à partir de ces exemples qu'il est difficile d'identifier des réponses courtes générées par l'IA : la différence entre ce type de corpus et les humains est trop faible, et il est difficile de juger strictement ses véritables attributs. Par conséquent, il est inapproprié d’annoter simplement des textes courts comme étant humains/IA et d’effectuer une détection de texte selon les problèmes de classification binaire traditionnels.

En réponse à ce problème, cette étude transforme la partie détection de la classification binaire humain/IA en un problème d'apprentissage partiel PU (Positive-Unlabeled), c'est-à-dire que dans des phrases plus courtes, le langage humain est positif (Positive) et le langage machine est de classe Unlabeled. (Sans étiquette), ce qui améliore la fonction de perte d'entraînement. Cette amélioration améliore significativement les performances de classification du détecteur sur différents corpus.

Détails de l'algorithme

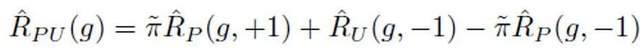

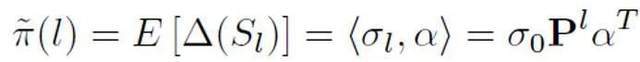

Dans le cadre d'apprentissage PU traditionnel, un modèle de classification binaire ne peut apprendre que sur la base d'échantillons d'entraînement positifs et d'échantillons d'entraînement non étiquetés. Une méthode d'apprentissage PU couramment utilisée consiste à estimer la perte de classification binaire correspondant aux échantillons négatifs en formulant la perte PU :

Parmi eux, représente la perte de classification binaire calculée par les échantillons positifs et les étiquettes positives ; représente la perte de classification binaire calculée en supposant que tous les échantillons non étiquetés sont des étiquettes négatives ; représente la perte de classification binaire calculée en supposant que les échantillons positifs sont des étiquettes négatives ; La probabilité d'échantillons positifs est la proportion estimée d'échantillons positifs dans tous les échantillons PU. Dans l’apprentissage PU traditionnel, le prior est généralement défini sur un hyperparamètre fixe. Cependant, dans le scénario de détection de texte, le détecteur doit traiter divers textes de longueurs différentes ; et pour les textes de longueurs différentes, la proportion estimée d'échantillons positifs parmi tous les échantillons PU de même longueur que l'échantillon est également différente. Par conséquent, cette étude améliore la perte de PU et propose une fonction de perte de PU multi-échelle (MPU) sensible à la longueur.

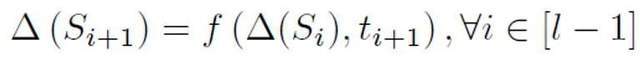

Plus précisément, cette étude propose un modèle récurrent abstrait pour modéliser la détection de textes plus courts. Lorsque la PNL traditionnelle modélise des séquences de processus, elles ont généralement une structure de chaîne de Markov, telle que RNN, LSTM, etc. Le processus de ce type de modèle cyclique peut généralement être compris comme un processus progressivement itératif, c'est-à-dire que la prédiction de chaque sortie de jeton est obtenue en transformant et en fusionnant les résultats de prédiction du jeton précédent et de la séquence précédente avec les résultats de prédiction de cette séquence. jeton. C'est le processus suivant :

Afin d'estimer la probabilité a priori sur la base de ce modèle abstrait, il est nécessaire de supposer que le résultat du modèle est la confiance qu'une certaine phrase est positive, c'est-à-dire la probabilité qu'elle soit jugée comme étant un échantillon prononcé par une personne. On suppose que la taille de la contribution de chaque jeton est l'inverse de la longueur du jeton de phrase, qu'elle est positive, c'est-à-dire sans étiquette, et que la probabilité d'être sans étiquette est bien supérieure à la probabilité d'être positive. Car à mesure que le vocabulaire des grands modèles se rapproche progressivement de celui des humains, la plupart des mots apparaîtront aussi bien dans l’IA que dans les corpus humains. Sur la base de ce modèle simplifié et de la probabilité de jeton positive définie, l'estimation préalable finale est obtenue en trouvant l'espérance totale de la confiance de sortie du modèle dans différentes conditions d'entrée.

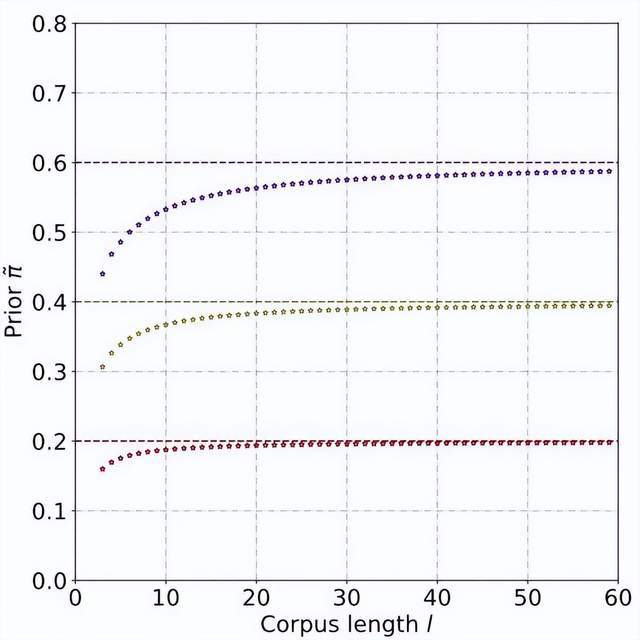

Grâce à des dérivations théoriques et à des expériences, on estime que la probabilité a priori augmente à mesure que la longueur du texte augmente, et finit par se stabiliser. Ce phénomène est également attendu, car à mesure que le texte s'allonge, le détecteur peut capturer plus d'informations, et « l'incertitude source » du texte s'affaiblit progressivement :

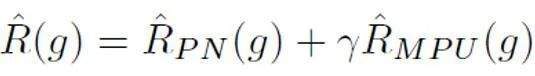

Après cela, pour chaque échantillon positif, la perte de PU est calculée sur la base du prior unique obtenu par la longueur de son échantillon. Enfin, étant donné que les textes plus courts n'ont qu'une certaine « incertitude » (c'est-à-dire que les textes plus courts contiendront également des caractéristiques textuelles de certaines personnes ou de l'IA), la perte binaire et la perte MPU peuvent être pondérées et ajoutées comme objectif d'optimisation final :

De plus, il convient de noter que la perte de MPU s'adapte à des corpus d'entraînement de différentes longueurs. Si les données de formation existantes sont évidemment homogènes et que la majeure partie du corpus est constituée de textes longs et volumineux, la méthode MPU ne peut pas exercer pleinement son efficacité. Afin de diversifier la durée du corpus de formation, cette étude introduit également un module multi-échelle au niveau de la phrase. Ce module couvre de manière aléatoire certaines phrases du corpus de formation et réorganise les phrases restantes tout en conservant l'ordre d'origine. Après une exploitation à plusieurs échelles du corpus de formation, le texte de formation a été considérablement enrichi en longueur, exploitant ainsi pleinement l'apprentissage PU pour la formation au détecteur de texte IA.

Résultats expérimentaux

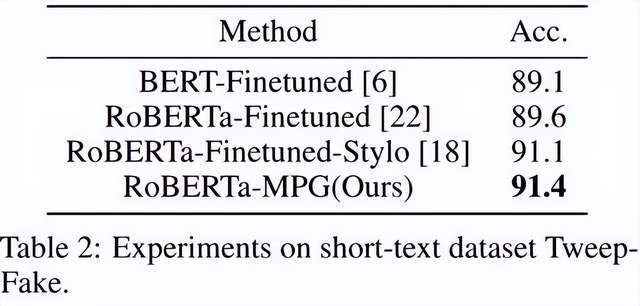

Comme le montre le tableau ci-dessus, l'auteur a d'abord testé l'effet de la perte de MPU sur l'ensemble de données de corpus plus court généré par l'IA, Tweep-Fake. Le corpus de cet ensemble de données est constitué de segments relativement courts sur Twitter. L'auteur remplace également la perte traditionnelle à deux catégories par un objectif d'optimisation contenant la perte de MPU basé sur un réglage fin du modèle de langage traditionnel. Le détecteur de modèle de langage amélioré est plus efficace et surpasse les autres algorithmes de base.

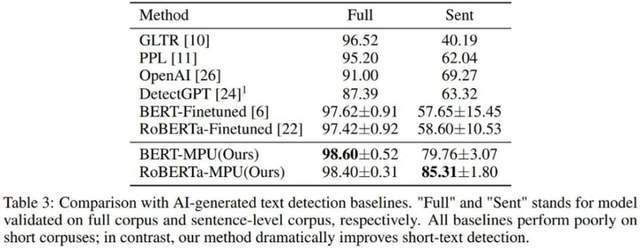

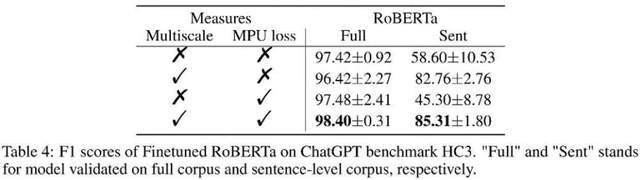

L'auteur a également testé le texte généré par chatGPT. Le détecteur de modèle de langage obtenu grâce à un réglage fin traditionnel a donné de mauvais résultats sur les phrases courtes ; le détecteur obtenu grâce à la formation MPU dans les mêmes conditions a bien fonctionné sur des phrases courtes et a pu une amélioration considérable. ont été obtenus sur l'ensemble du corpus, avec un score F1 augmentant de 1 %, dépassant les algorithmes SOTA tels que OpenAI et DetectGPT.

Comme le montre le tableau ci-dessus, l'auteur a observé le gain d'effet apporté par chaque partie de l'expérience d'ablation. La perte de MPU améliore l'effet de classification des matériaux longs et courts.

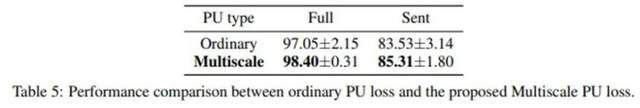

L'auteur a également comparé le PU traditionnel et le PU multi-échelle (MPU). Le tableau ci-dessus montre que l'effet MPU est meilleur et peut mieux s'adapter à la tâche de détection de texte multi-échelle de l'IA.

Résumé

L'auteur a résolu le problème de la reconnaissance de phrases courtes par les détecteurs de texte en proposant une solution basée sur l'apprentissage PU multi-échelle Avec la prolifération des modèles de génération AIGC dans le futur, la détection de ce type de contenu deviendra de plus en plus importante. Cette recherche a fait un grand pas en avant dans la question de la détection de texte par l'IA. On espère que d'autres recherches similaires seront menées à l'avenir pour mieux contrôler le contenu AIGC et empêcher l'abus du contenu généré par l'IA.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1672

1672

14

14

1428

1428

52

52

1332

1332

25

25

1276

1276

29

29

1256

1256

24

24

Comment construire des agents d'IA multimodaux à l'aide d'AGNO Framework?

Apr 23, 2025 am 11:30 AM

Comment construire des agents d'IA multimodaux à l'aide d'AGNO Framework?

Apr 23, 2025 am 11:30 AM

Tout en travaillant sur une IA agentique, les développeurs se retrouvent souvent à naviguer dans les compromis entre la vitesse, la flexibilité et l'efficacité des ressources. J'ai exploré le cadre de l'IA agentique et je suis tombé sur Agno (plus tôt c'était Phi-

Comment ajouter une colonne dans SQL? - Analytique Vidhya

Apr 17, 2025 am 11:43 AM

Comment ajouter une colonne dans SQL? - Analytique Vidhya

Apr 17, 2025 am 11:43 AM

Instruction ALTER TABLE de SQL: Ajout de colonnes dynamiquement à votre base de données Dans la gestion des données, l'adaptabilité de SQL est cruciale. Besoin d'ajuster votre structure de base de données à la volée? L'énoncé de la table alter est votre solution. Ce guide détaille l'ajout de Colu

Openai change de mise au point avec GPT-4.1, priorise le codage et la rentabilité

Apr 16, 2025 am 11:37 AM

Openai change de mise au point avec GPT-4.1, priorise le codage et la rentabilité

Apr 16, 2025 am 11:37 AM

La version comprend trois modèles distincts, GPT-4.1, GPT-4.1 Mini et GPT-4.1 Nano, signalant une évolution vers des optimisations spécifiques à la tâche dans le paysage du modèle grand langage. Ces modèles ne remplacent pas immédiatement les interfaces orientées utilisateur comme

Nouveau cours court sur les modèles d'intégration par Andrew Ng

Apr 15, 2025 am 11:32 AM

Nouveau cours court sur les modèles d'intégration par Andrew Ng

Apr 15, 2025 am 11:32 AM

Déverrouiller la puissance des modèles d'intégration: une plongée profonde dans le nouveau cours d'Andrew Ng Imaginez un avenir où les machines comprennent et répondent à vos questions avec une précision parfaite. Ce n'est pas de la science-fiction; Grâce aux progrès de l'IA, cela devient un R

Simulation et analyse de lancement de fusées à l'aide de Rocketpy - Analytics Vidhya

Apr 19, 2025 am 11:12 AM

Simulation et analyse de lancement de fusées à l'aide de Rocketpy - Analytics Vidhya

Apr 19, 2025 am 11:12 AM

Simuler les lancements de fusée avec Rocketpy: un guide complet Cet article vous guide à travers la simulation des lancements de fusées haute puissance à l'aide de Rocketpy, une puissante bibliothèque Python. Nous couvrirons tout, de la définition de composants de fusée à l'analyse de Simula

Google dévoile la stratégie d'agent la plus complète au cloud prochain 2025

Apr 15, 2025 am 11:14 AM

Google dévoile la stratégie d'agent la plus complète au cloud prochain 2025

Apr 15, 2025 am 11:14 AM

Gemini comme fondement de la stratégie d'IA de Google Gemini est la pierre angulaire de la stratégie d'agent AI de Google, tirant parti de ses capacités multimodales avancées pour traiter et générer des réponses à travers le texte, les images, l'audio, la vidéo et le code. Développé par Deepm

Robots humanoïdes open source que vous pouvez imprimer vous-même: les câlins de visage achètent la robotique du pollen

Apr 15, 2025 am 11:25 AM

Robots humanoïdes open source que vous pouvez imprimer vous-même: les câlins de visage achètent la robotique du pollen

Apr 15, 2025 am 11:25 AM

"Super heureux d'annoncer que nous acquérons une robotique de pollen pour amener les robots open source au monde", a déclaré Hugging Face sur X. "Depuis que Remi Cadene nous a rejoints de Tesla, nous sommes devenus la plate-forme logicielle la plus utilisée pour la robotique ouverte grâce à des remerciements grâce à des remerciements grâce à des remerciements à une robotique ouverte grâce à des remerciements à des remerciements à des remerciements à la robotique ouverte grâce à des remerciements à Gérom

Deepcoder-14b: la compétition open source à O3-MinI et O1

Apr 26, 2025 am 09:07 AM

Deepcoder-14b: la compétition open source à O3-MinI et O1

Apr 26, 2025 am 09:07 AM

Dans un développement significatif pour la communauté de l'IA, Agetica et ensemble AI ont publié un modèle de codage d'IA open source nommé Deepcoder-14b. Offrir des capacités de génération de code à égalité avec des concurrents à source fermée comme OpenAI