À l’ère des grands modèles, qu’est-ce qui est le plus important ?

La réponse donnée par LeCun est : open source.

Lorsque le code du LLaMA de Meta a été divulgué sur GitHub, les développeurs du monde entier ont eu accès au premier LLM de niveau GPT.

Ensuite, divers LLM donnent différents angles à l'open source des modèles d'IA.

LLaMA a ouvert la voie et préparé le terrain pour des modèles tels que Alpac et Vicuna de Stanford, faisant d'eux le leader de l'open source.

A ce moment, le Falcon "Falcon" sortit à nouveau du siège.

"Falcon" a été développé par le Technology Innovation Institute (TII) à Abu Dhabi, aux Émirats arabes unis. En termes de performances, Falcon est plus performant que LLaMA.

Actuellement, "Falcon" a trois versions - 1B, 7B et 40B.

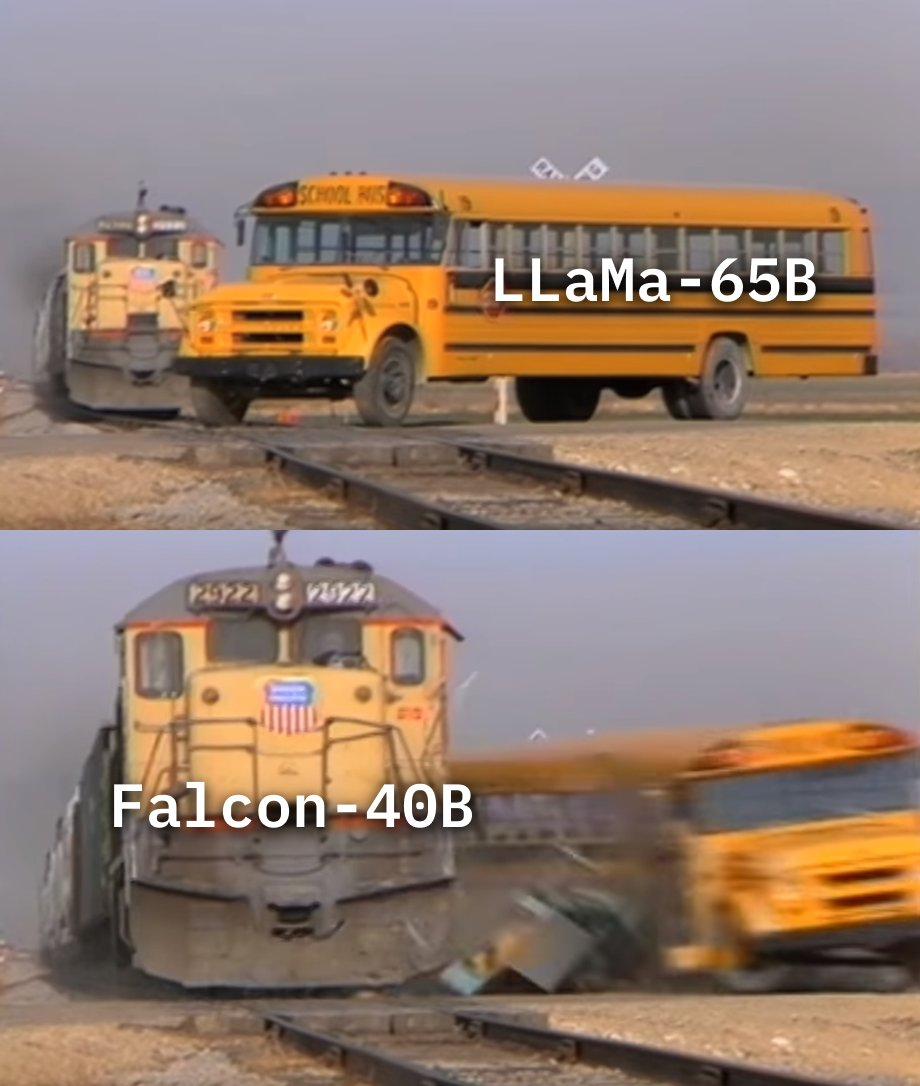

TII a déclaré que Falcon est le modèle de langage open source le plus puissant à ce jour. Sa plus grande version, Falcon 40B, possède 40 milliards de paramètres, ce qui est encore un peu plus petit que LLaMA, qui compte 65 milliards de paramètres.

Bien que l'échelle soit petite, les performances sont élevées.

Faisal Al Bannai, secrétaire général de l'Advanced Technology Research Council (ATRC), estime que la sortie de « Falcon » brisera la méthode d'acquisition du LLM et permettra aux chercheurs et aux entrepreneurs de proposer les cas d'utilisation les plus innovants.

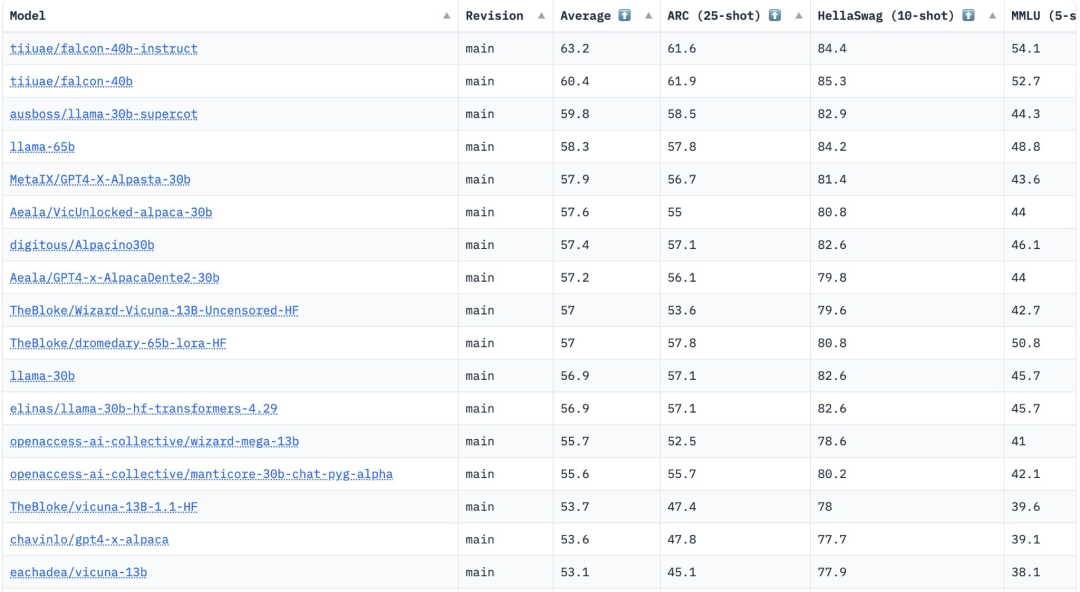

Deux versions de FalconLM, Falcon 40B Instruct et Falcon 40B, se classent parmi les deux premières du classement Hugging Face OpenLLM, tandis que le LLaMA de Meta occupe la troisième place.

Il convient de mentionner que Hugging Face évalue ces modèles à travers quatre références actuelles pour comparer des variétés - AI2 Reasoning Challenge, HellaSwag, MMLU et TruthfulQA.

Bien que l'article "Falcon" n'ait pas encore été rendu public, le Falcon 40B a été largement formé sur un ensemble de données réseau de 1 000 milliards de jetons soigneusement examinés.

Les chercheurs ont révélé que « Falcon » attache une grande importance à l'importance d'atteindre des performances élevées sur des données à grande échelle pendant le processus de formation.

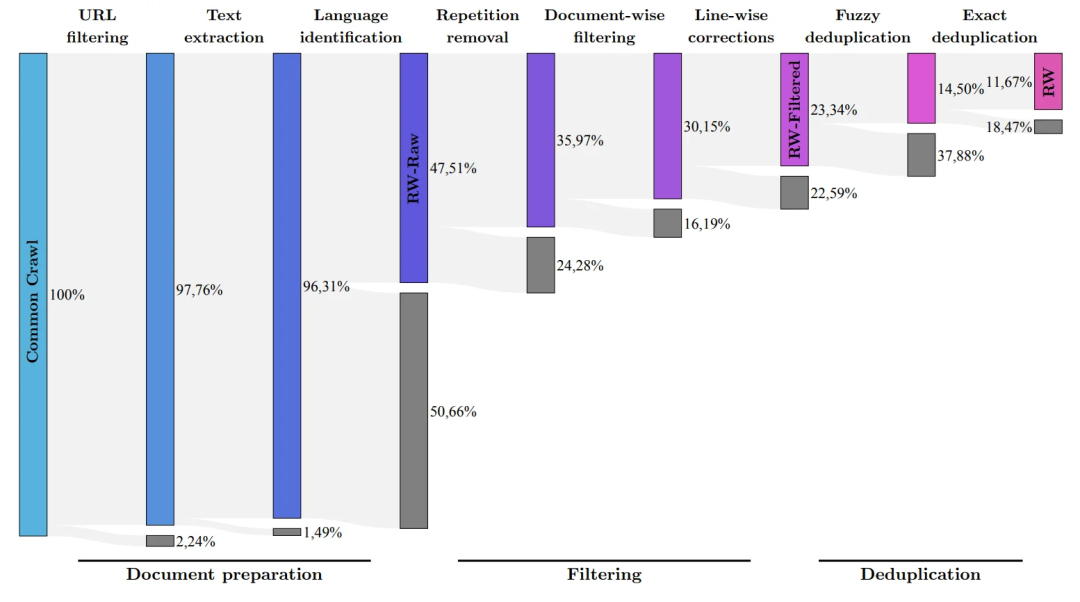

Ce que nous savons tous, c'est que LLM est très sensible à la qualité des données d'entraînement, c'est pourquoi les chercheurs consacrent beaucoup d'efforts à la construction d'un pipeline de données capable d'effectuer un traitement efficace sur des dizaines de milliers de cœurs de processeur.

Le but est d'extraire du contenu de haute qualité d'Internet sur la base du filtrage et de la déduplication.

Actuellement, TII a publié un ensemble de données réseau affiné, qui est un ensemble de données soigneusement filtré et dédupliqué. La pratique a prouvé que c'est très efficace.

Le modèle formé en utilisant uniquement cet ensemble de données peut être à égalité avec d'autres LLM, voire les surpasser en termes de performances. Cela démontre l'excellente qualité et l'influence de "Falcon".

De plus, le modèle Falcon dispose également de capacités multilingues.

Il comprend l'anglais, l'allemand, l'espagnol et le français, et connaît également beaucoup de choses dans certaines petites langues européennes comme le néerlandais, l'italien, le roumain, le portugais, le tchèque, le polonais et le suédois.

Falcon 40B est également le deuxième modèle véritablement open source après la sortie du modèle H2O.ai. Cependant, comme H2O.ai n’a pas été comparé aux autres modèles de ce classement, ces deux modèles ne sont pas encore entrés sur le ring.

En regardant LLaMA, bien que son code soit disponible sur GitHub, ses poids n'ont jamais été open source.

Cela signifie que l'utilisation commerciale de ce modèle est quelque peu restreinte.

De plus, toutes les versions de LLaMA reposent sur la licence LLaMA originale, ce qui rend LLaMA inadaptée aux applications commerciales à petite échelle.

À ce stade, "Falcon" arrive à nouveau en tête.

Falcon est actuellement le seul modèle open source pouvant être utilisé commercialement gratuitement.

Au début, TII exigeait que si Falcon était utilisé à des fins commerciales et générait plus d'un million de dollars de revenus attribuables, une « taxe d'utilisation » de 10 % serait facturée.

Mais il n’a pas fallu longtemps pour que les riches magnats du Moyen-Orient lèvent cette restriction.

Au moins pour l'instant, toute utilisation commerciale et tout réglage fin de Falcon seront gratuits.

Les gens riches ont déclaré qu’ils n’avaient pas besoin de gagner de l’argent grâce à ce modèle pour le moment.

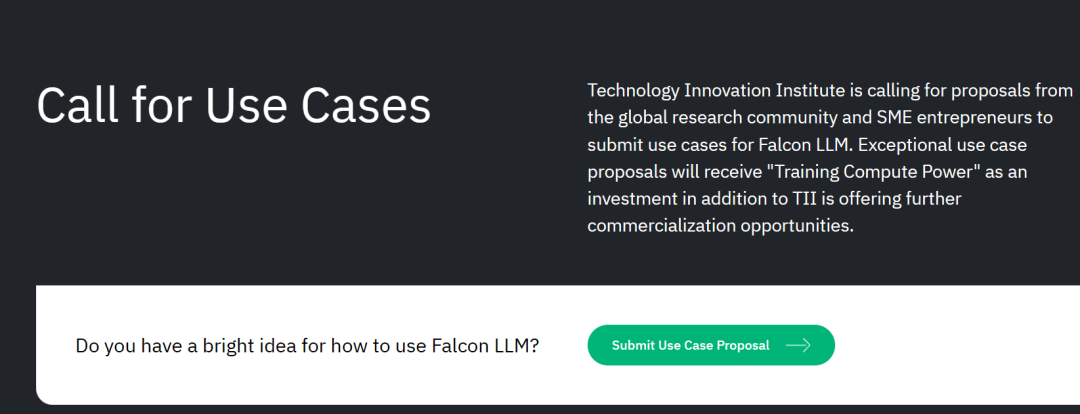

De plus, TII sollicite également des plans de commercialisation du monde entier.

Pour les solutions potentielles de recherche scientifique et de commercialisation, ils fourniront également davantage de « soutien à la puissance de calcul de formation » ou offriront de nouvelles opportunités de commercialisation.

E-mail de soumission du projet : Submissions.falconllm@tii.ae

Cela signifie simplement : tant que le projet est bon, le modèle est libre d'utilisation ! Assez de puissance de calcul ! Si vous n’avez pas assez d’argent, nous pouvons quand même le récupérer pour vous !

Pour les start-ups, il s'agit simplement d'une « solution unique pour l'entrepreneuriat à grande échelle en matière d'IA » du magnat du Moyen-Orient.

Selon l'équipe de développement, un aspect important de l'avantage concurrentiel de FalconLM est la sélection des données d'entraînement.

L'équipe de recherche a développé un processus pour extraire des données de haute qualité à partir d'ensembles de données publics explorés et supprimer les données en double.

Après avoir soigneusement nettoyé le contenu redondant et en double, 5 000 milliards de jetons ont été conservés, soit suffisamment pour entraîner un modèle de langage puissant.

Le 40B Falcon LM utilise 1 000 milliards de jetons pour la formation, et la version 7B du jeton de formation modèle atteint 1 500 milliards.

(L'équipe de recherche vise à filtrer uniquement les données brutes de la plus haute qualité de Common Crawl en utilisant l'ensemble de données RefinedWeb)

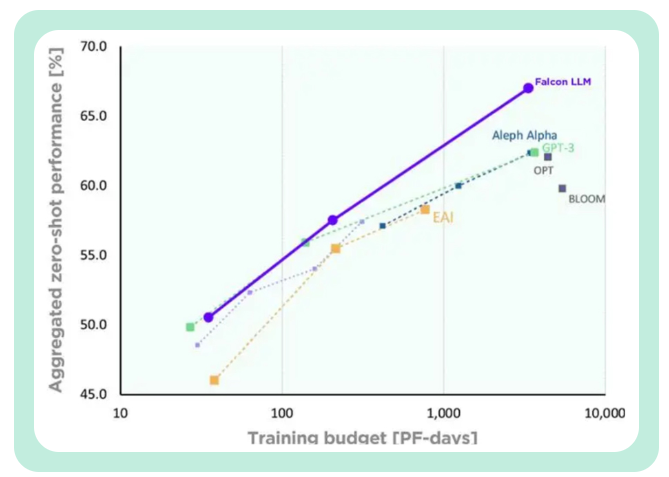

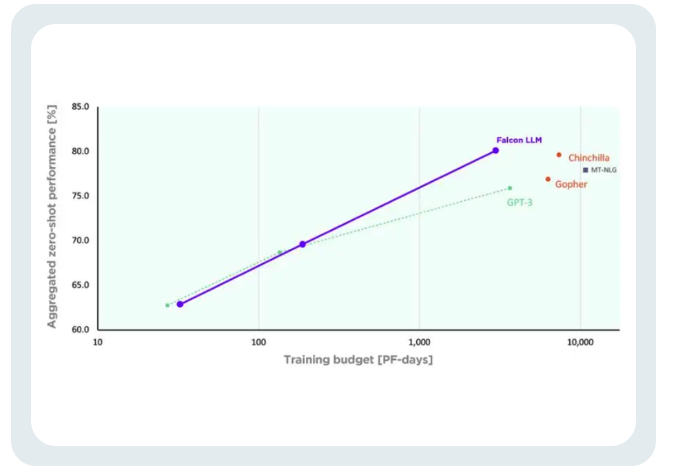

TII a dit, avec GPT-3 par rapport à Falcon, Falcon a obtenu des améliorations significatives de ses performances tout en utilisant seulement 75 % du budget informatique de formation.

et ne nécessite que 20% du temps de calcul lors de l'inférence.

Le coût de formation du Falcon n’équivaut qu’à 40 % du Chinchilla et 80 % du PaLM-62B.

Réussi à utiliser efficacement les ressources informatiques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment installer le pilote d'imprimante sous Linux

Comment installer le pilote d'imprimante sous Linux

Explication détaillée de la classe Symbol dans JS

Explication détaillée de la classe Symbol dans JS

Comment afficher le code source de Tomcat

Comment afficher le code source de Tomcat

La différence entre vscode et vs

La différence entre vscode et vs

Mon ordinateur ne peut pas l'ouvrir en double-cliquant dessus.

Mon ordinateur ne peut pas l'ouvrir en double-cliquant dessus.

Quel logiciel est AE

Quel logiciel est AE

Comment redémarrer le service dans le framework swoole

Comment redémarrer le service dans le framework swoole

Comment intercepter les appels harcelants

Comment intercepter les appels harcelants

Introduction à la différence entre javascript et java

Introduction à la différence entre javascript et java