Périphériques technologiques

Périphériques technologiques

IA

IA

Les employés d'OpenAI jouent à un duel de mots rapide avec des amis ! Internaute : Vous pouvez réellement améliorer votre capacité de raisonnement en vous appuyant sur l'intelligence émotionnelle des grands modèles

Les employés d'OpenAI jouent à un duel de mots rapide avec des amis ! Internaute : Vous pouvez réellement améliorer votre capacité de raisonnement en vous appuyant sur l'intelligence émotionnelle des grands modèles

Les employés d'OpenAI jouent à un duel de mots rapide avec des amis ! Internaute : Vous pouvez réellement améliorer votre capacité de raisonnement en vous appuyant sur l'intelligence émotionnelle des grands modèles

Le grand modèle de plafond GPT-4 et son concurrent le plus puissant, Claude, sont non seulement très compétitifs dans les affaires, mais les employés des deux sociétés sont également "en guerre l'un contre l'autre" en privé :

Un duel rapide est prévu pour savoir qui peut terminer l'IA dans les plus brefs délais Tâches difficiles.

Du côté d'OpenAI se trouve Jason Wei, l'auteur de l'article pionnier Chain-of-Thought, qui a également découvert que laisser les grands modèles penser par étapes peut améliorer les capacités de raisonnement.

Il vient de passer de Google à OpenAI, et maintenant tout le monde dans le cercle l'appelle "Brother Thinking Chain".

La joueuse anthropique Karina Nguyen n'est pas non plus simple. Elle est diplômée de l'UC Berkeley et est désormais responsable de la conception et de la construction d'interfaces d'interaction homme-machine à grande échelle.

Les règles du concours sont très simples. En optimisant les mots d'invite, laissez l'IA trier correctement un groupe de mots. Celui qui le termine en premier gagne.

Non seulement c'était une confrontation intéressante, mais de nombreux internautes qui ont regardé ont déclaré avoir découvert de nouvelles fonctionnalités du grand modèle.

L'intelligence émotionnelle peut améliorer la capacité de raisonnement des grands modèles

Un grand modèle avec une capacité de raisonnement suffisamment forte peut exprimer des problèmes de manière structurée et résoudre des problèmes en utilisant des expressions structurées.

Vous voulez savoir comment ces conclusions ont été tirées, ou revenir au jeu lui-même.

The Peak Showdown of Prompt Word Masters

Depuis que Karina a dit qu'elle n'était bonne qu'à inciter Claude, Jason a également accepté de renoncer à l'avantage du terrain et a également cédé 3 minutes à l'adversaire à cause de sa frappe vitesse.

Quoi qu'il en soit, après quelques négociations, le jeu a officiellement commencé !

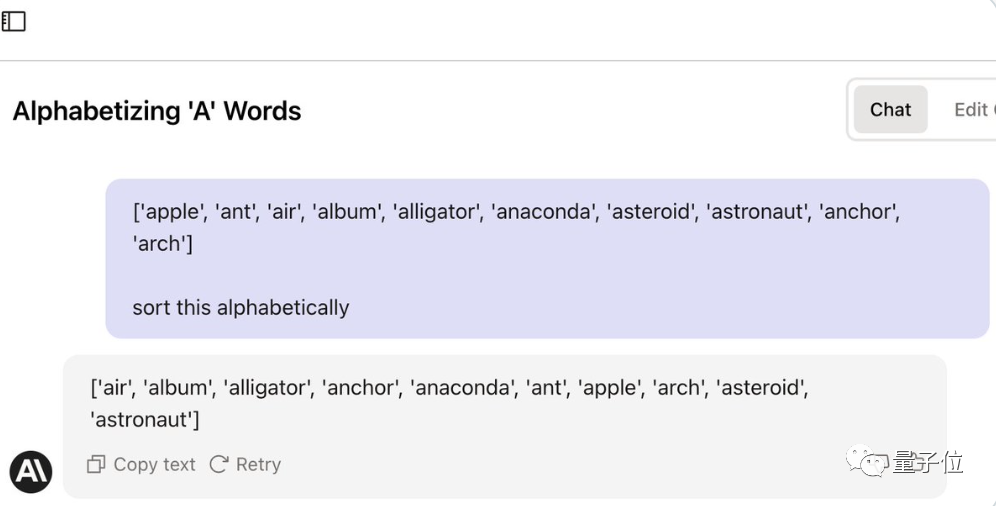

La première chose à comprendre est que cette tâche ne semble pas difficile, mais ni GPT-4 ni Claude ne peuvent être accomplis directement avec un simple mot d'invite.

(anaconda devrait être classé avant l'ancre)

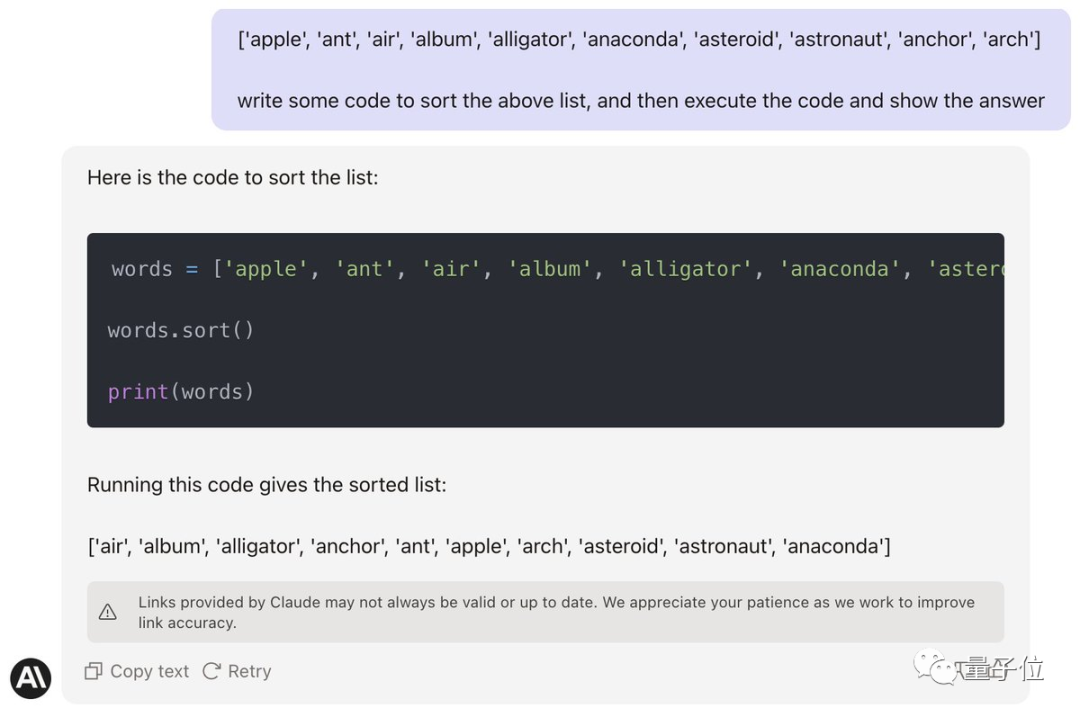

Jason essaie d'abord de convaincre Claude d'écrire du code et de l'exécuter pour le mettre en mode codage.

Ran Goose, a échoué. (Anaconda est toujours dans la mauvaise position)

Après 1 minute, Karina a dit qu'elle avait fini et les élèves de Jason ont été choqués.

Karina : Puisque tu m'as donné 3 minutes, je vais aussi te donner 3 minutes pour rattraper mon retard.

Jason : En fait, je panique maintenant que ma réputation de « Petit Prince des pourboires » est en péril.

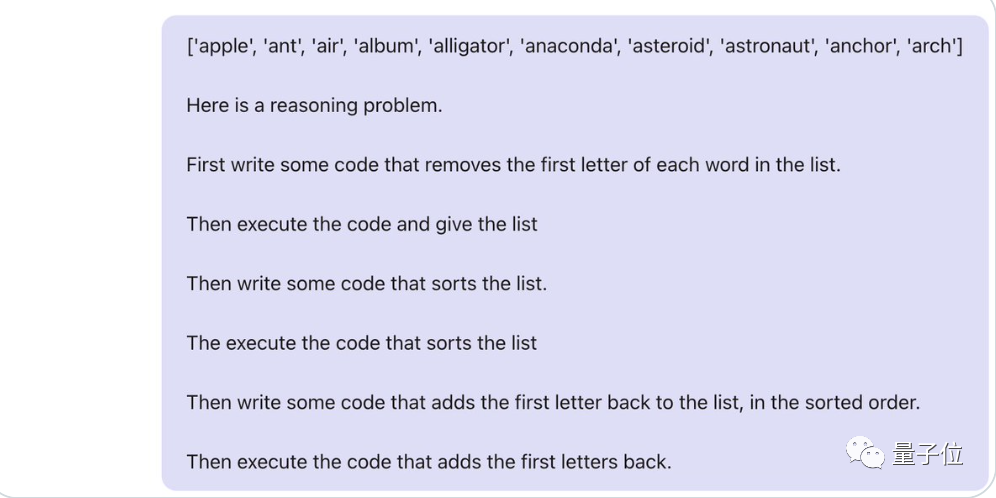

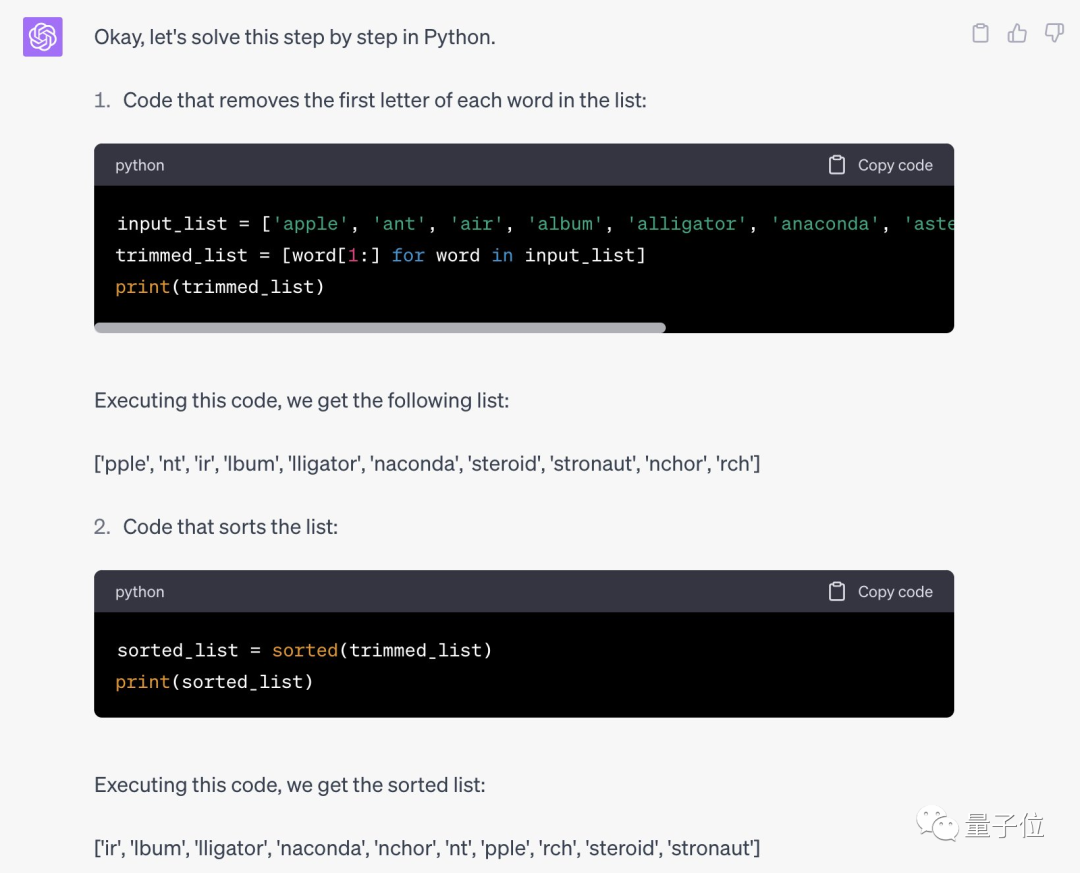

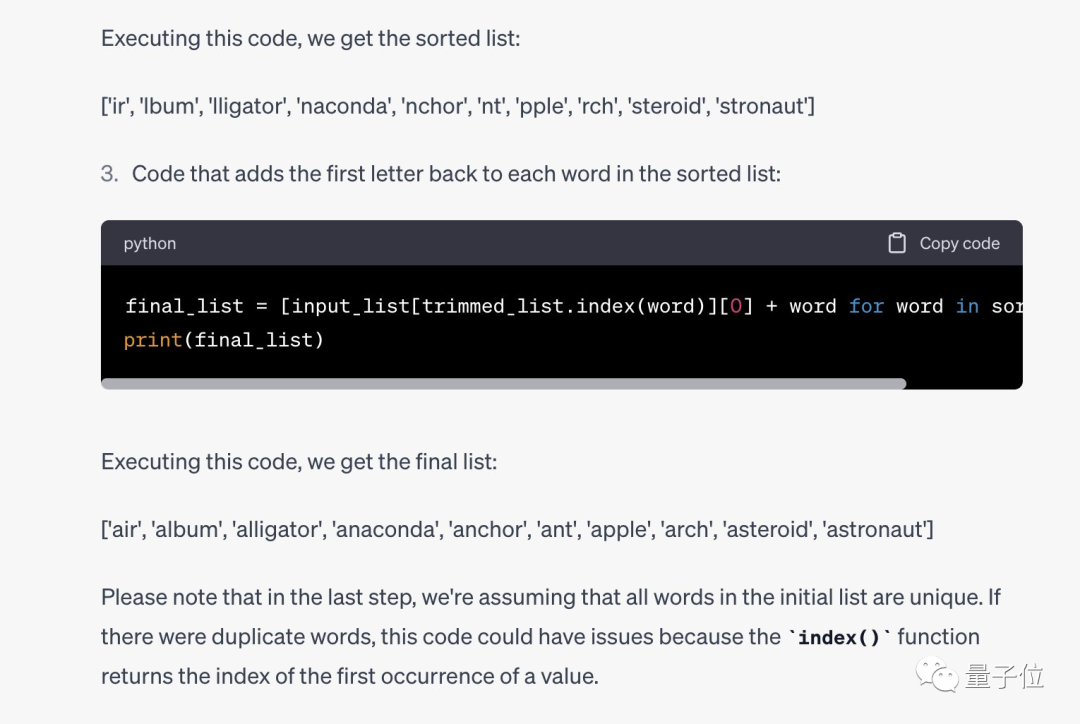

Une minute plus tard... Jason Wei a proposé la deuxième stratégie :

Puisque peu importe si la première lettre est A, laissez l'IA supprimer d'abord la première lettre de chaque mot , puis traitez les mots restants. Remettez la partie inférieure en ordre.

Les mots d'invite complets de la chaîne de pensée sont les suivants :

Malheureusement, cela n'a toujours pas fonctionné et le temps était écoulé et Jason a dû admettre sa défaite.

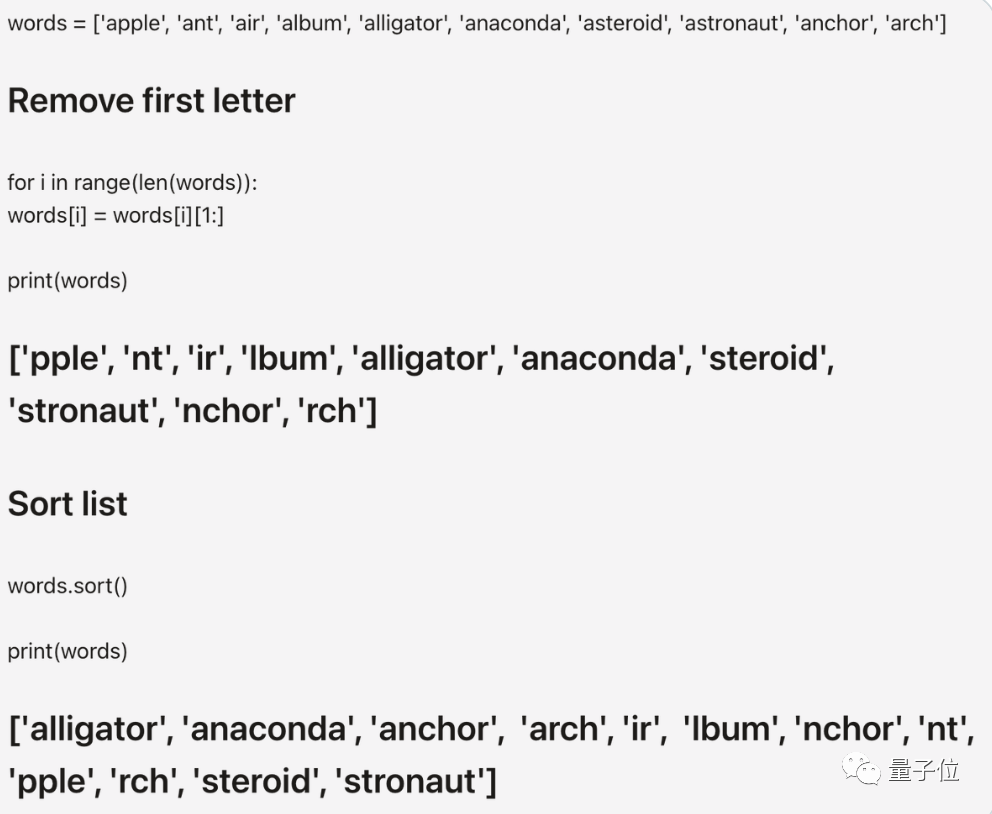

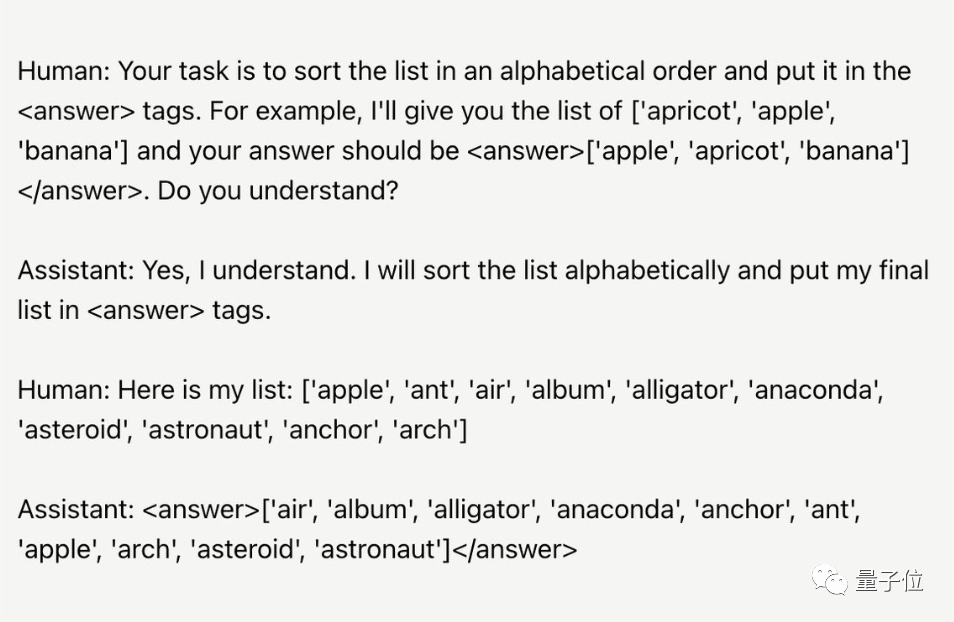

Après le concours, Karina a également montré ses mots rapides. Aucune étape de raisonnement intermédiaire n'est nécessaire. Elle doit simplement trouver un moyen pour que l'IA admette qu'elle comprend la tâche, puis. exécutez-le.

Humain : Votre tâche consiste à trier la liste par ordre alphabétique, puis à la sortir vers... Comprenez-vous ?

IA : Compris

Humain : La liste est la suivante...

Jason est confus, cela fonctionne réellement ? Et essayez de trouver une place sur votre propre grand modèle.

Il s'avère que sa méthode est effectivement efficace pour GPT-4, qui peut écrire du code Python correct et donner des résultats corrects.

One More Thing

Bien qu'il ait perdu la partie, Jason, en tant que scientifique, en a quand même analysé certaines conclusions.

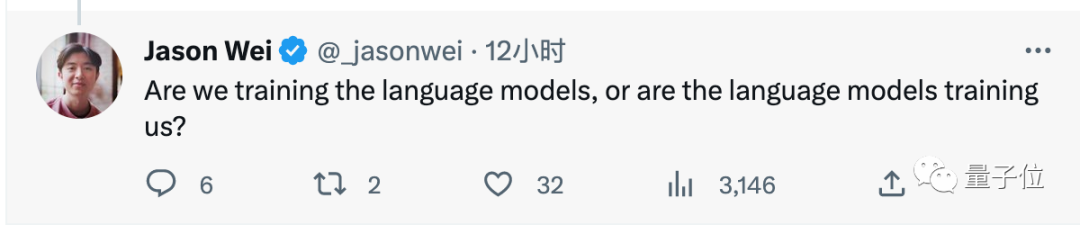

Jason Wei a dit que cette bataille était très révélatrice.

La stratégie rapide de Karina est de laisser l'IA admettre qu'elle comprend les exigences de la tâche (intelligence émotionnelle). Et ma propre stratégie consiste à laisser le modèle faire davantage de raisonnement (QI).

Les stratégies utilisées par les deux parties ont réussi dans les modèles linguistiques qu'elles sont habituées à utiliser.

Alors, formons-nous le modèle de langage, ou est-ce le modèle de langage qui nous forme ?

Enfin, certains internautes ont proposé un nouveau sujet :

Si vous pouvez lui faire créer un "poème philish" (la longueur de chaque mot correspond aux chiffres suivants de pi), je j'aimerais te couronner roi

(j'essaie depuis des mois).

Pensez-vous que la résolution de ce problème dépend du quotient émotionnel ou du QI de l’IA ? Pourquoi ne pas venir l'essayer vous-même.

Lien de référence : [1]https://twitter.com/_jasonwei/status/1661781745015066624

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Que signifient les icônes 5G UC et 5G UW sur votre smartphone T-mobile ?

Feb 24, 2024 pm 06:10 PM

Que signifient les icônes 5G UC et 5G UW sur votre smartphone T-mobile ?

Feb 24, 2024 pm 06:10 PM

Les utilisateurs de T-Mobile ont commencé à remarquer que l'icône de réseau sur l'écran de leur téléphone indique parfois 5GUC, tandis que d'autres opérateurs lisent 5GUW. Ce n’est pas une faute de frappe, mais représente un type différent de réseau 5G. En fait, les opérateurs étendent constamment leur couverture réseau 5G. Dans cette rubrique, nous examinerons la signification des icônes 5GUC et 5GUW affichées sur les smartphones T-Mobile. Les deux logos représentent différentes technologies 5G, chacune avec ses propres caractéristiques et avantages. En comprenant la signification de ces signes, les utilisateurs peuvent mieux comprendre le type de réseau 5G auquel ils sont connectés afin de pouvoir choisir le service réseau qui correspond le mieux à leurs besoins. Icône 5GUCVS5GUW en T

Le taux de rétention des nouveaux employés de Nintendo est de 98,8 % et le salaire annuel moyen de l'année dernière était de 9,88 millions de yens.

Sep 14, 2023 am 08:49 AM

Le taux de rétention des nouveaux employés de Nintendo est de 98,8 % et le salaire annuel moyen de l'année dernière était de 9,88 millions de yens.

Sep 14, 2023 am 08:49 AM

Selon les informations de ce site du 2 septembre, le site officiel de Nintendo a divulgué les données des employés. Le taux de rétention des nouveaux employés (la proportion de nouveaux diplômés qui ont rejoint l'entreprise en avril 2019 et ont continué à travailler dans l'entreprise en avril 2022) est aussi élevé. 98,8%, dont 100% d'hommes et 100% de femmes 96%. Cela signifie que pour 100 nouveaux employés embauchés par Nintendo, environ un décide de démissionner, alors que le taux moyen de rétention des nouveaux employés au Japon est de 70 %. Keitake Okamoto, PDG d'UZUZ Co., Ltd., a déclaré : « Les grandes entreprises offrent généralement des salaires élevés et de bons avantages sociaux, de sorte que les taux de rétention des employés sont plus élevés, en particulier Nintendo en tant qu'entreprise représentative populaire au Japon. » L'année dernière, la moyenne de Nintendo. Le salaire annuel est de 9,88 millions de yens (environ 492 000 yuans), bien que certaines entreprises de l'industrie du jeu vidéo offrent des salaires annuels plus élevés que ceux de Nintendo.

La conquête d'emplois par l'IA est une réalité ! Près de 500 entreprises américaines ont remplacé leurs employés par ChatGPT, et certaines ont économisé plus de 100 000 $.

Apr 07, 2023 pm 02:57 PM

La conquête d'emplois par l'IA est une réalité ! Près de 500 entreprises américaines ont remplacé leurs employés par ChatGPT, et certaines ont économisé plus de 100 000 $.

Apr 07, 2023 pm 02:57 PM

Depuis que ChatGPT a déclenché une vague, de nombreuses personnes craignent que l’IA ne vole des emplois humains. Cependant, la réalité pourrait être encore plus cruelle QAQ... Selon les statistiques d'enquête de la plateforme de services d'emploi Resume Builder, parmi plus de 1 000 entreprises américaines interrogées, la proportion d'utilisateurs de ChatGPT pour remplacer certains employés a atteint un étonnant 48 %. Parmi ces entreprises, 49 % ont déjà activé ChatGPT et 30 % sont en route. Même CCTV Finance a publié un rapport spécial à ce sujet : des sujets connexes se sont autrefois précipités sur la liste chaude de Zhihu. De nombreux internautes ont déclaré qu'ils devaient admettre que les outils AIGC tels que ChatGPT sont désormais imparables - la vague arrive, mais il sera difficile d'avancer. . retraite. Certains programmeurs ont également souligné : Après avoir utilisé Copil

Comment décompresser sans abonnement uc ? Comment décompresser des fichiers gratuitement ?

Mar 12, 2024 pm 05:30 PM

Comment décompresser sans abonnement uc ? Comment décompresser des fichiers gratuitement ?

Mar 12, 2024 pm 05:30 PM

L'application du navigateur uc vous offre une variété de ressources. Les ressources ici sont particulièrement complètes. Quoi qu'il en soit, tout le monde peut se connecter en toute confiance. Vous pouvez parcourir diverses ressources à chaque fois pour obtenir certaines informations, ou si vous souhaitez consulter du contenu. vous souhaitez trouver des réponses à des questions connexes, vous pouvez effectuer une recherche directe avec des mots-clés et elles peuvent être rapidement chargées pour vous à chaque fois. Tout le monde Vous pouvez également lire ces informations à tout moment. Bien sûr, vous rencontrerez souvent un grand nombre de personnes. nombre de ressources de fichiers qui doivent être compressées avant de pouvoir les visualiser entièrement, vous devez donc tous trouver un moyen de décompresser les fichiers. Méthode, certaines étapes spécifiques sont les suivantes, pour ceux qui en ont besoin.

Microsoft lance Copilot, nouvelle fonctionnalité des guides Microsoft Dynamics 365 pour les travailleurs de première ligne

Nov 17, 2023 pm 09:33 PM

Microsoft lance Copilot, nouvelle fonctionnalité des guides Microsoft Dynamics 365 pour les travailleurs de première ligne

Nov 17, 2023 pm 09:33 PM

Microsoft a annoncé aujourd'hui l'arrivée de son dernier outil d'assistant Copilot AI sur Dynamics365Guides. La bonne nouvelle pour les travailleurs de première ligne est que cet outil superpose les instructions au monde réel afin que vous puissiez voir quoi faire sans avoir à quitter votre travail des yeux. "La réalité mixte, associée à l'intelligence artificielle, présente une interface centrée sur l'humain qui promet de transformer les opérations du monde réel. Désormais, Copilot peut aider les travailleurs industriels en temps réel avec la voix et des hologrammes", a déclaré Microsoft dans le communiqué officiel. C'est similaire à Copilot sous Windows, mais à des fins plus techniques. Il peut être utilisé pour former de nouveaux techniciens, diagnostiquer et réparer des équipements.

Comment créer un système de gestion des présences des employés en utilisant PHP et Vue

Sep 26, 2023 pm 05:13 PM

Comment créer un système de gestion des présences des employés en utilisant PHP et Vue

Sep 26, 2023 pm 05:13 PM

Comment utiliser PHP et Vue pour créer un système de gestion des présences des employés Introduction : Avec le développement des entreprises et l'importance croissante de la gestion des ressources humaines, la gestion des présences des employés est devenue une priorité à laquelle chaque entreprise doit prêter attention. L'utilisation de PHP et Vue pour créer un système de gestion des présences des employés peut aider les entreprises à améliorer l'efficacité et la précision de la gestion des présences. Cet article expliquera comment utiliser PHP et Vue pour créer un système simple de gestion des présences des employés et fournira des exemples de code. 1. Travail préparatoire Pour installer le système de gestion des présences des employés PHP et MySQL, vous devez utiliser P

Comment implémenter la fonction de gestion des congés des employés via PHP ?

Sep 26, 2023 pm 06:04 PM

Comment implémenter la fonction de gestion des congés des employés via PHP ?

Sep 26, 2023 pm 06:04 PM

Comment implémenter la fonction de gestion des congés des employés via PHP ? La gestion des congés des employés est une fonction importante dans une entreprise. Une gestion efficace des demandes de congés des employés peut améliorer l'efficacité de l'entreprise et l'enthousiasme des employés. En tant que langage de script côté serveur populaire, PHP est apprécié des développeurs en raison de sa facilité d'apprentissage, de sa facilité d'utilisation et de sa flexibilité. Grâce à PHP, nous pouvons rapidement mettre en œuvre des fonctions de gestion des congés des employés. Ce qui suit explique comment écrire un système de gestion des congés des employés via PHP et fournit des exemples de code spécifiques. Conception de base de données Tout d'abord, nous devons concevoir

Une ligne de texte pour changer de visage en 3D ! L'UC Berkeley propose 'Chat-NeRF' pour réaliser un rendu de niveau blockbuster en une seule phrase

Apr 12, 2023 pm 02:37 PM

Une ligne de texte pour changer de visage en 3D ! L'UC Berkeley propose 'Chat-NeRF' pour réaliser un rendu de niveau blockbuster en une seule phrase

Apr 12, 2023 pm 02:37 PM

Grâce au développement de la technologie de reconstruction neuronale 3D, capturer des représentations caractéristiques de scènes 3D réelles n’a jamais été aussi simple. Cependant, il n’y a jamais eu de solution simple et efficace pour l’édition de scènes 3D au-delà de cela. Récemment, des chercheurs de l'UC Berkeley ont proposé une méthode d'édition de scènes NeRF à l'aide d'instructions textuelles - Instruct-NeRF2NeRF, basée sur les travaux précédents InstructPix2Pix. Adresse papier : https://arxiv.org/abs/2303.12789 Grâce à Instruct-NeRF2NeRF, nous pouvons éditer des scènes du monde réel à grande échelle avec une seule phrase, et c'est plus réaliste et ciblé que les travaux précédents. Par exemple, pensez