Périphériques technologiques

Périphériques technologiques

IA

IA

OpenAI et Google jouent avec leur double standard : former de grands modèles en utilisant les données d'autres personnes, mais sans jamais laisser leurs propres données s'échapper.

OpenAI et Google jouent avec leur double standard : former de grands modèles en utilisant les données d'autres personnes, mais sans jamais laisser leurs propres données s'échapper.

OpenAI et Google jouent avec leur double standard : former de grands modèles en utilisant les données d'autres personnes, mais sans jamais laisser leurs propres données s'échapper.

Dans la nouvelle ère de l’IA générative, les grandes entreprises technologiques poursuivent une stratégie « faites ce que je dis, ne faites pas ce que je fais » lorsqu’il s’agit de consommer du contenu en ligne. Dans une certaine mesure, cette stratégie peut être considérée comme un double standard et un abus du droit de parole.

Dans le même temps, alors que les grands modèles de langage (LLM) deviennent la tendance dominante dans le développement de l'IA, les grandes entreprises et les start-ups n'épargnent aucun effort pour développer leurs propres grands modèles. Parmi eux, les données de formation sont une condition préalable importante à la capacité des grands modèles.

Récemment, selon un rapport d'Insider, OpenAI soutenu par Microsoft, Google et Anthropic soutenus utilisent le contenu en ligne d'autres sites Web ou d'entreprises pour former leurs modèles d'IA générative depuis des années. Tout cela a été réalisé sans demander d’autorisation spécifique et fera partie d’une bataille juridique en cours pour déterminer l’avenir du Web et la manière dont la loi sur le droit d’auteur sera appliquée dans cette nouvelle ère.

Ces grandes entreprises technologiques peuvent prétendre qu'elles font un usage équitable, mais la question de savoir si c'est vraiment le cas est discutable. Mais ils ne laisseront pas leur contenu être utilisé pour former d’autres modèles d’IA. Nous ne pouvons donc pas nous empêcher de nous demander pourquoi ces grandes entreprises technologiques peuvent-elles utiliser le contenu en ligne d’autres entreprises lors de la formation de grands modèles ?

Ces entreprises sont intelligentes, mais aussi très hypocrites

Existe-t-il des preuves solides de l'affirmation selon laquelle les grandes entreprises technologiques utilisent le contenu en ligne d'autres personnes mais ne permettent pas aux autres d'utiliser le leur ? de service et d'utilisation de certains de leurs produits Voir les indices.

Premièrement, regardons Claude, un assistant IA similaire à ChatGPT lancé par Anthropic. Le système peut effectuer des tâches telles que la synthèse, la recherche, l'aide à la création, les questions et réponses et le codage. Il a été à nouveau mis à niveau il y a quelque temps et le jeton de contexte a été étendu à 100 000, ce qui a considérablement accéléré la vitesse de traitement.

Les conditions d'utilisation de Claude sont les suivantes. Vous ne pouvez pas accéder ou utiliser le Service des manières suivantes (dont certaines sont répertoriées ici). Si l'une de ces restrictions est incompatible ou peu claire avec la Politique d'utilisation acceptable, cette dernière prévaudra :

- Développée en collaboration avec notre Tout produit ou service avec lequel le Service est en concurrence, y compris le développement ou la formation de tout algorithme ou modèle d'IA ou d'apprentissage automatique

- Gratter, gratter ou obtenir de toute autre manière des données ou des informations de nos Services sans être autorisé par les Conditions

Adresse des conditions d'utilisation de Claude : https://vault.pactsafe.io/s/9f502c93-cb5c-4571-b205-1e479da61794/legal.html#terms

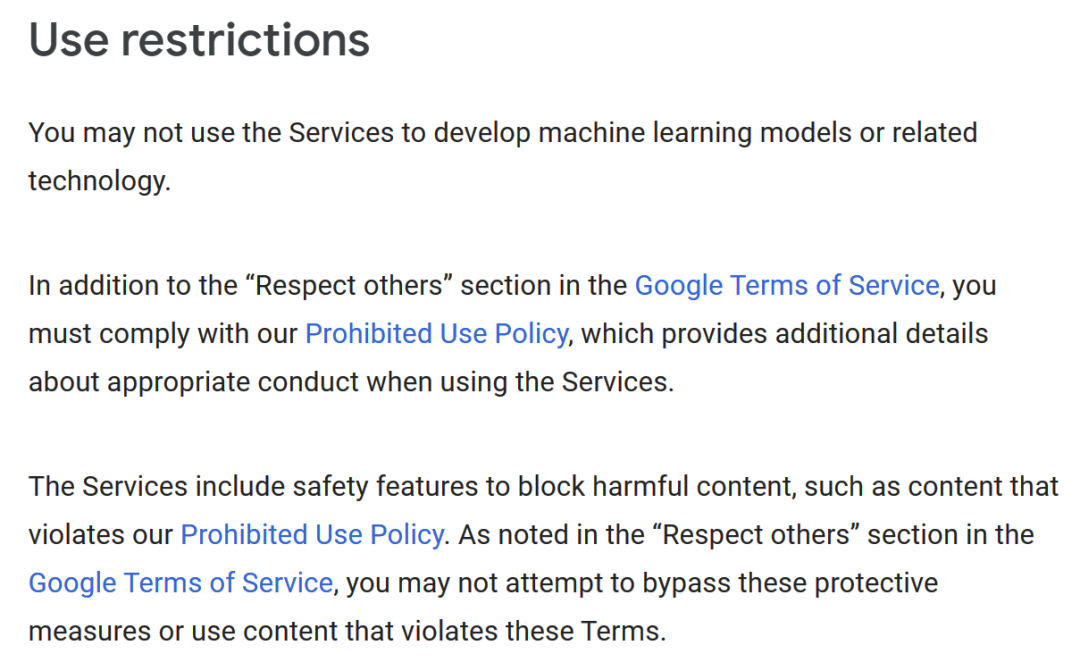

De même, l'IA générative de Google utilise Il en va de même pour les conditions : "Vous ne pouvez pas utiliser le Service pour développer des modèles d'apprentissage automatique ou des technologies associées." com/terms/ Generative-ai

Qu'en est-il des conditions d'utilisation d'OpenAI ? Semblable à Google, "Vous ne pouvez pas utiliser les résultats de ce service pour développer des modèles qui concurrencent OpenAI." -d'utilisation

Qu'en est-il des conditions d'utilisation d'OpenAI ? Semblable à Google, "Vous ne pouvez pas utiliser les résultats de ce service pour développer des modèles qui concurrencent OpenAI." -d'utilisation

Ces entreprises sont intelligentes, elles savent qu'un contenu de haute qualité est essentiel pour former de nouveaux modèles d'IA, il est donc logique de ne pas permettre à d'autres d'utiliser leurs résultats de cette manière. Mais ils n’ont aucun scrupule à utiliser les données d’autres personnes pour former leurs propres modèles. Comment expliquer cela ?

OpenAI, Google et Anthropic ont décliné les demandes de commentaires d'Insider et n'ont pas répondu.

Reddit, Twitter et autres : Assez, c'est assez

En fait, d'autres entreprises n'étaient pas contentes lorsqu'elles ont réalisé ce qui se passait. En avril, Reddit, utilisé depuis des années pour former des modèles d'IA, prévoit de commencer à facturer l'accès à ses données.

Le PDG de Reddit, Steve Huffman, a déclaré : "Le corpus de données de Reddit est très précieux, nous ne pouvons donc pas fournir cette valeur gratuitement aux plus grandes entreprises du monde."

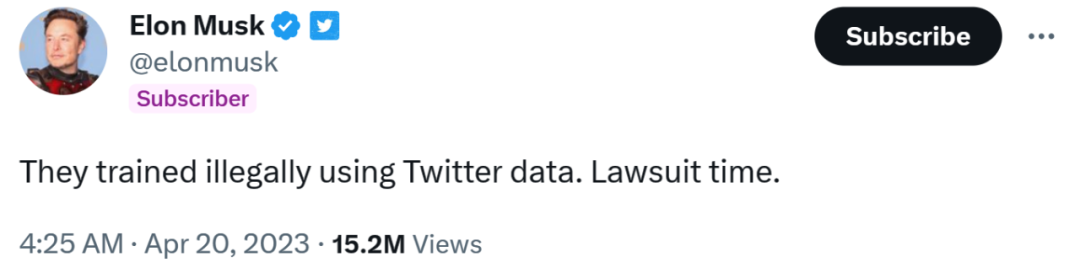

En avril de cette année également, Musk a accusé OpenAI Microsoft, l'un des principaux bailleurs de fonds du procès, a utilisé illégalement les données de Twitter pour former des modèles d'IA. "C'est l'heure du procès", a-t-il tweeté.

Cependant, en réponse au commentaire d'Insider, Microsoft a déclaré qu '"il y a tellement d'erreurs dans cette prémisse que je ne sais même pas par où commencer."

Le PDG d'OpenAI, Sam Altman, a essayé d'explorer. Un nouveau modèle d'IA qui respecte les droits d'auteur pour approfondir ce problème. Selon Axios, il a récemment déclaré : "Nous essayons de développer un nouveau modèle. Si le système d'IA utilise votre contenu ou votre style, vous serez payé pour cela

Sam Altman."

Les éditeurs (y compris les Insiders) auront tous des intérêts particuliers. De plus, certains éditeurs, dont U.S. News Corp., font déjà pression pour que les entreprises technologiques paient pour utiliser leur contenu afin de former des modèles d’IA.

La méthode actuelle de formation des modèles d'IA a "cassé" le réseau

Un ancien cadre de Microsoft a déclaré qu'il devait y avoir un problème avec cela. Steven Sinofsky, vétéran de Microsoft et développeur de logiciels bien connu, estime que la méthode actuelle de formation des modèles d'IA « casse » le réseau.

Steven Sinofsky

Il a écrit sur Twitter : "Dans le passé, les données d'exploration étaient utilisées en échange de taux de clics. Mais maintenant, elles ne sont utilisées que pour former un modèle et n'est pas donné. Les créateurs et les titulaires de droits d'auteur apportent une quelconque valeur. "

Peut-être qu'à mesure que de plus en plus d'entreprises se réveillent, cette utilisation inégale des données à l'ère de l'IA générative sera bientôt modifiée.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Un guide complet pour consulter les journaux GitLab sous Centos System Cet article vous guidera comment afficher divers journaux GitLab dans le système CentOS, y compris les journaux principaux, les journaux d'exception et d'autres journaux connexes. Veuillez noter que le chemin du fichier journal peut varier en fonction de la version Gitlab et de la méthode d'installation. Si le chemin suivant n'existe pas, veuillez vérifier le répertoire d'installation et les fichiers de configuration de GitLab. 1. Afficher le journal GitLab principal Utilisez la commande suivante pour afficher le fichier journal principal de l'application GitLabRails: Commande: sudocat / var / log / gitlab / gitlab-rails / production.log Cette commande affichera le produit

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

Comment faire fonctionner la formation distribuée de Pytorch sur CentOS

Apr 14, 2025 pm 06:36 PM

La formation distribuée par Pytorch sur le système CentOS nécessite les étapes suivantes: Installation de Pytorch: La prémisse est que Python et PIP sont installés dans le système CentOS. Selon votre version CUDA, obtenez la commande d'installation appropriée sur le site officiel de Pytorch. Pour la formation du processeur uniquement, vous pouvez utiliser la commande suivante: pipinstalltorchtorchVisionTorChaudio Si vous avez besoin d'une prise en charge du GPU, assurez-vous que la version correspondante de CUDA et CUDNN est installée et utilise la version Pytorch correspondante pour l'installation. Configuration de l'environnement distribué: la formation distribuée nécessite généralement plusieurs machines ou des GPU multiples uniques. Lieu