Périphériques technologiques

Périphériques technologiques

IA

IA

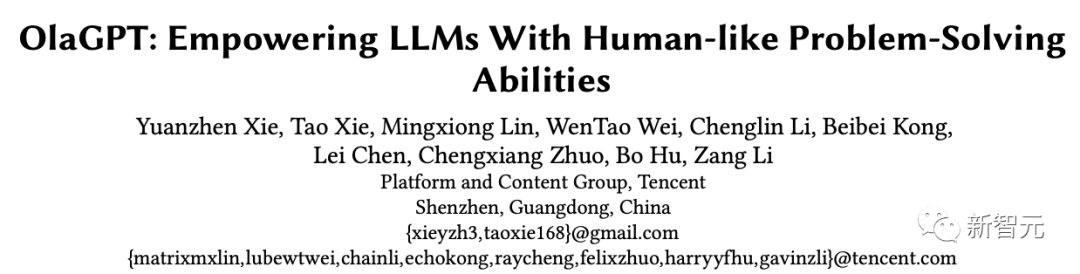

OlaGPT, le premier cadre de pensée qui simule la cognition humaine : six modules améliorent le modèle de langage et augmentent les capacités de raisonnement jusqu'à 85 %

OlaGPT, le premier cadre de pensée qui simule la cognition humaine : six modules améliorent le modèle de langage et augmentent les capacités de raisonnement jusqu'à 85 %

OlaGPT, le premier cadre de pensée qui simule la cognition humaine : six modules améliorent le modèle de langage et augmentent les capacités de raisonnement jusqu'à 85 %

ChatGPT nous a trop choqués lors de sa première sortie. La performance du modèle dans le dialogue était si humaine qu'elle a créé l'illusion que le modèle de langage avait une « capacité de réflexion ».

Cependant, après une compréhension approfondie des modèles de langage, les chercheurs ont progressivement découvert que la reproduction basée sur des modèles de langage à haute probabilité est encore loin de « l'intelligence artificielle générale » attendue.

Dans la plupart des recherches actuelles, les modèles linguistiques à grande échelle génèrent principalement des chaînes de pensée sous la direction d'invites spécifiques pour effectuer des tâches de raisonnement, sans tenir compte du cadre cognitif humain, permettant aux modèles linguistiques de résoudre des problèmes de raisonnement complexes. Il existe toujours un écart important entre les capacités des humains et celles des humains.

Lorsque les humains sont confrontés à des problèmes de raisonnement complexes, ils utilisent généralement diverses capacités cognitives et doivent interagir avec tous les aspects des outils, des connaissances et des informations de l'environnement externe. Les modèles linguistiques peuvent-ils simuler les humains ? résoudre des problèmes complexes ?

La réponse est bien sûr oui ! Le premier modèle OlaGPT qui simule le cadre de traitement cognitif humain est là !

Lien papier : https://arxiv.org/abs/2305.16334

Lien code : https://www .php.cn/link/73a1c863a54653d5e184b790fee14754

OlaGPT comprend plusieurs modules cognitifs, notamment l'attention, la mémoire, le raisonnement, l'apprentissage et les mécanismes de planification et de prise de décision correspondants inspirés de l'apprentissage actif humain, le cadre est également inclus ; est une unité d'apprentissage pour enregistrer les erreurs précédentes et les opinions d'experts, avec une référence dynamique pour améliorer votre capacité à résoudre des problèmes similaires.

L'article décrit également des cadres de raisonnement communs et efficaces permettant aux humains de résoudre des problèmes et conçoit le modèle de chaîne de pensée (CoT) en conséquence ; un mécanisme de prise de décision complet peut maximiser la précision du modèle.

Les résultats expérimentaux obtenus après une évaluation rigoureuse sur plusieurs ensembles de données d'inférence montrent qu'OlaGPT surpasse les précédents benchmarks de pointe et prouve son efficacité.

Simulation de la cognition humaine

Il existe encore un grand écart entre le modèle de langage actuel et l'intelligence artificielle générale attendue, principalement comme suit :

1 Dans certains cas, le contenu généré n'a aucun sens ou s'écarte des préférences de valeurs humaines, et peut même donner des suggestions très dangereuses. La solution actuelle consiste à introduire un apprentissage par renforcement avec retour humain (RLHF) pour effectuer un entraînement sur la sortie du modèle. .

2. Les connaissances du modèle de langage sont limitées aux concepts et faits explicitement mentionnés dans les données de formation.

Lorsqu'ils sont confrontés à des problèmes complexes, les modèles de langage ne peuvent pas s'adapter à des environnements changeants, utiliser les connaissances ou les outils existants, réfléchir aux leçons historiques, décomposer les problèmes et utiliser les humains pour résumer l'évolution à long terme comme les humains. les schémas de pensée (tels que les analogies, le raisonnement inductif, le raisonnement déductif, etc.) pour résoudre des problèmes.

Cependant, il existe encore de nombreux problèmes système liés au fait de laisser les modèles de langage simuler le processus des problèmes de traitement du cerveau humain :

1. cadre cognitif humain, tout en planifiant selon des schémas de raisonnement humain communs d'une manière réalisable ?

2. Comment guider les modèles de langage pour apprendre activement comme les humains, c'est-à-dire apprendre et évoluer à partir d'erreurs historiques ou de solutions expertes à des problèmes difficiles ?

Bien qu'il soit possible de recycler le modèle pour encoder les réponses corrigées, cela est évidemment très coûteux et peu flexible.

3. Comment faire en sorte que les modèles de langage utilisent de manière flexible divers modes de pensée développés par les humains pour améliorer leurs performances de raisonnement ?

Un modèle de pensée fixe et universel est difficile à adapter à différents problèmes. Tout comme lorsque les humains sont confrontés à différents types de problèmes, ils choisissent généralement de manière flexible différentes façons de penser, telles que le raisonnement analogique et le raisonnement déductif. .

OlaGPT

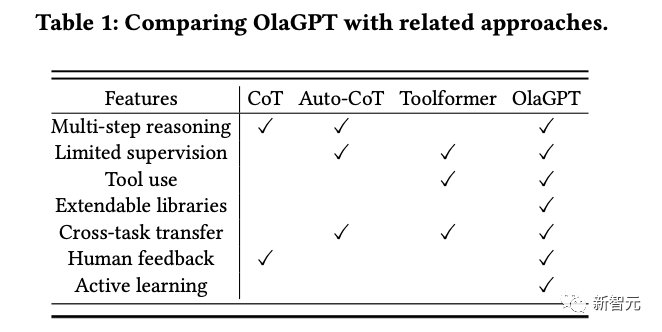

OlaGPT est un framework de résolution de problèmes qui simule la pensée humaine et peut améliorer les capacités des grands modèles de langage.

OlaGPT s'appuie sur la théorie de l'architecture cognitive et modélise les capacités fondamentales du cadre cognitif telles que l'attention, la mémoire, l'apprentissage et le raisonnement, et la sélection d'actions.

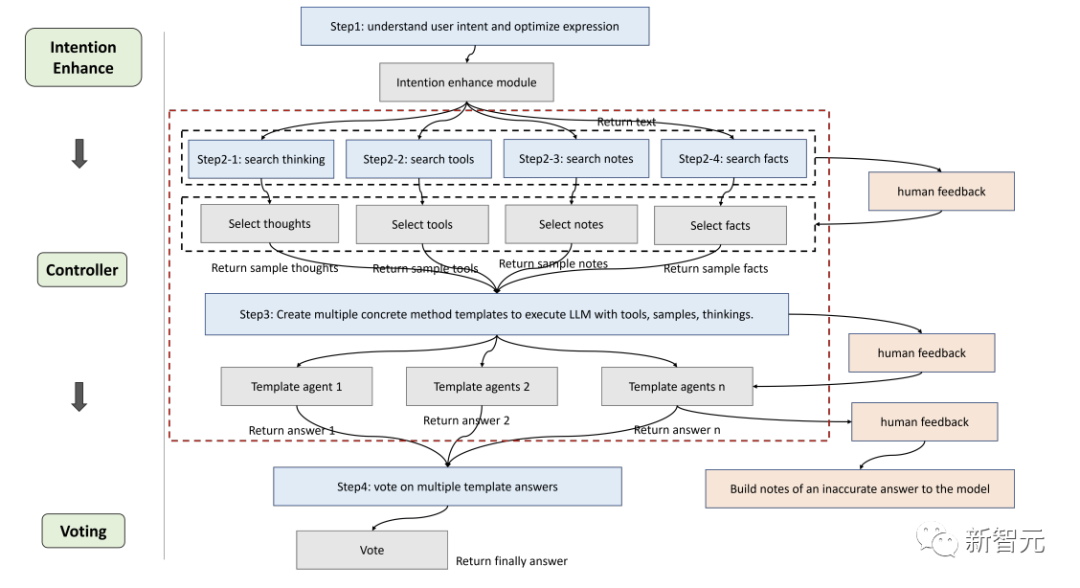

Les chercheurs ont affiné le framework en fonction des besoins d'implémentation spécifiques et ont proposé un processus adapté aux modèles de langage pour résoudre des problèmes complexes, qui comprend spécifiquement six modules : module d'amélioration d'intention (attention), module de mémoire (mémoire), module d'apprentissage actif (apprentissage), module de raisonnement (raisonnement), module contrôleur (sélection d'action) et module de vote.

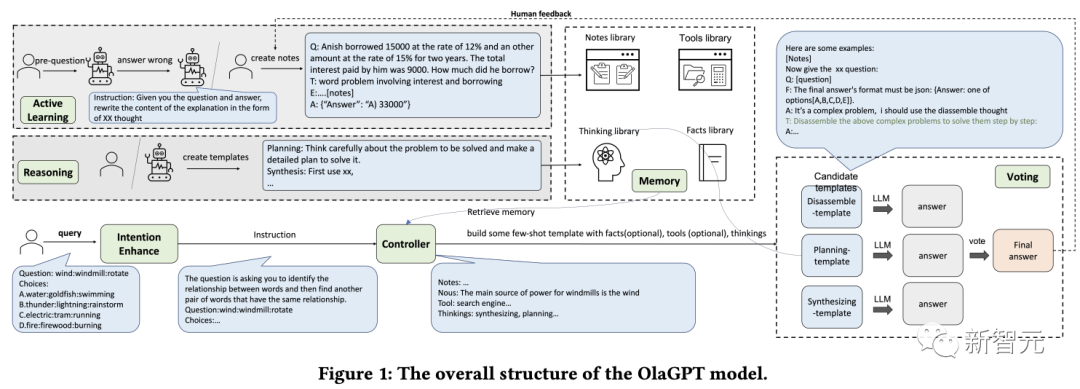

Intention Enhance

L'attention est une partie importante de la cognition humaine, identifiant les informations pertinentes et filtrant les données non pertinentes.

De même, les chercheurs ont conçu un module d'attention correspondant pour le modèle de langage, à savoir l'amélioration de l'intention, qui vise à extraire les informations les plus pertinentes et à établir une association plus forte entre la saisie de l'utilisateur et le modèle de langage du modèle, qui peut être considéré comme un module d'attention. convertisseur optimisé des habitudes d'expression des utilisateurs aux habitudes d'expression du modèle.

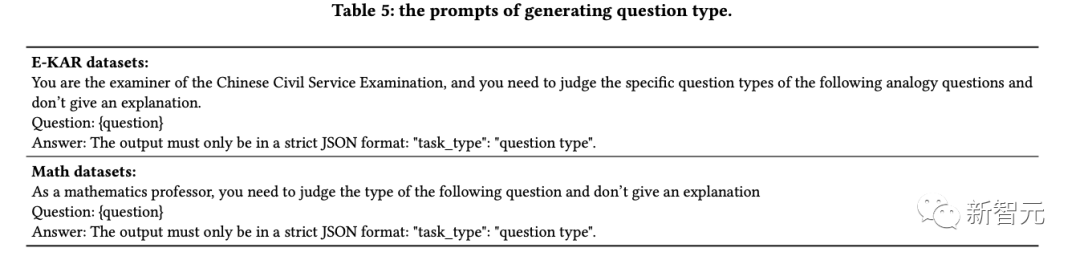

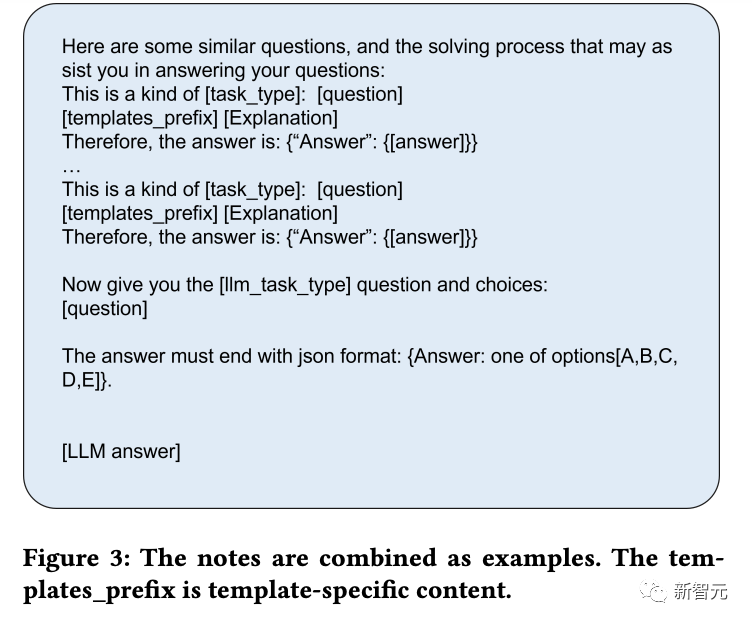

Tout d'abord, obtenez à l'avance les types de questions des LLM grâce à des mots d'invite spécifiques, puis reconstruisez la manière de poser les questions.

Par exemple, ajoutez "Donnez-vous maintenant le XX (type de question), la question et les choix :" au début de la question, afin de faciliter l'analyse, vous devez également ajouter "La réponse doit se terminer par JSON ; format : Réponse :" à l'invite. l'une des options [A, B, C, D, E].」

Mémoire

Le module de mémoire joue un rôle essentiel dans le stockage de diverses informations de la base de connaissances, qui ont été prouvé par la recherche Les modèles de langage actuels sont limités dans la compréhension des dernières données factuelles, tandis que le module de mémoire se concentre sur la consolidation des connaissances qui n'ont pas encore été internalisées par le modèle et sur leur stockage dans une bibliothèque externe en tant que mémoire à long terme.

Les chercheurs ont utilisé la fonction de mémoire de langchain pour la mémoire à court terme, puis ont utilisé la base de données vectorielles basée sur Faiss pour obtenir une mémoire à long terme.

Pendant le processus de requête, sa fonction de recherche peut extraire des connaissances pertinentes de la bibliothèque, couvrant quatre types de bibliothèques de mémoire : faits, outils, notes et réflexion, où les faits sont des informations du monde réel, telles que le bon sens, etc. ; inclure des moteurs de recherche, des calculatrices et Wikipédia, qui peuvent aider les modèles de langage à effectuer des travaux qui ne nécessitent pas d'édition ; les notes enregistrent principalement certains cas difficiles et les étapes pour résoudre des problèmes ; la bibliothèque de réflexion stocke principalement des modèles de réflexion pour la résolution de problèmes humains rédigés par des experts ; Les experts peuvent être des humains ou des modèles.

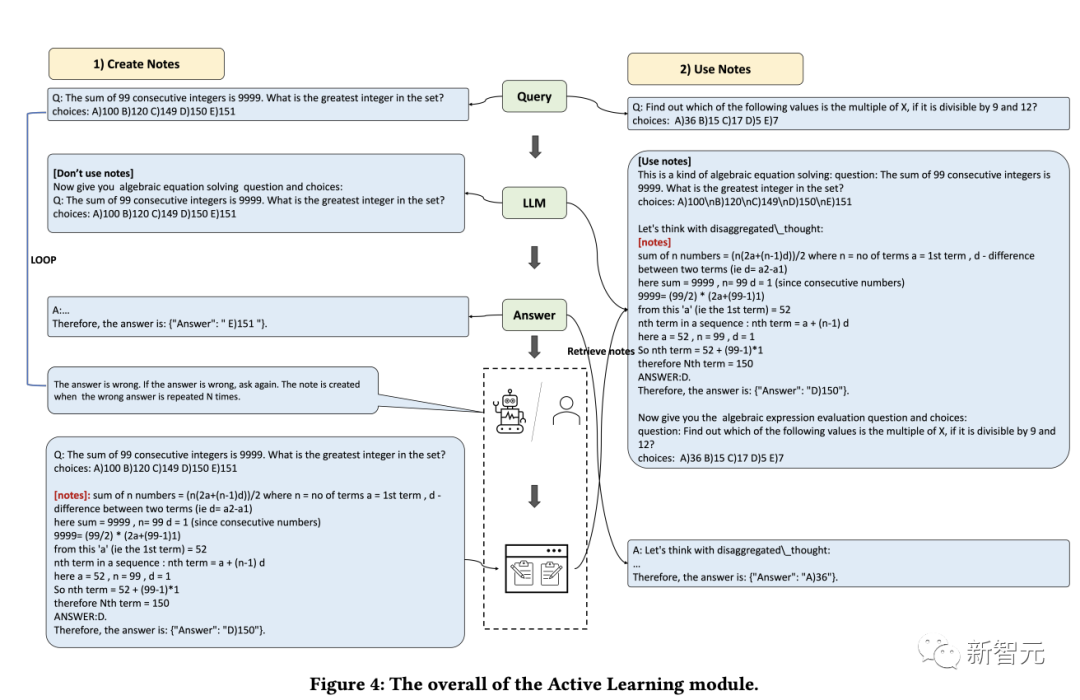

Apprentissage

La capacité d'apprendre est cruciale pour que les humains améliorent continuellement leurs performances personnelles. Essentiellement, toutes les formes d'apprentissage reposent sur l'expérience et les modèles de langage peuvent apprendre des erreurs précédentes, permettant ainsi d'améliorer rapidement leurs capacités de raisonnement.

Tout d'abord, les chercheurs découvrent les problèmes que le modèle de langage ne peut pas résoudre ; puis enregistrent les idées et les explications fournies par les experts dans la bibliothèque de notes et enfin sélectionnent les notes pertinentes pour favoriser l'apprentissage du modèle de langage, afin qu'il puisse être utilisé. peut gérer des problèmes similaires plus efficacement.

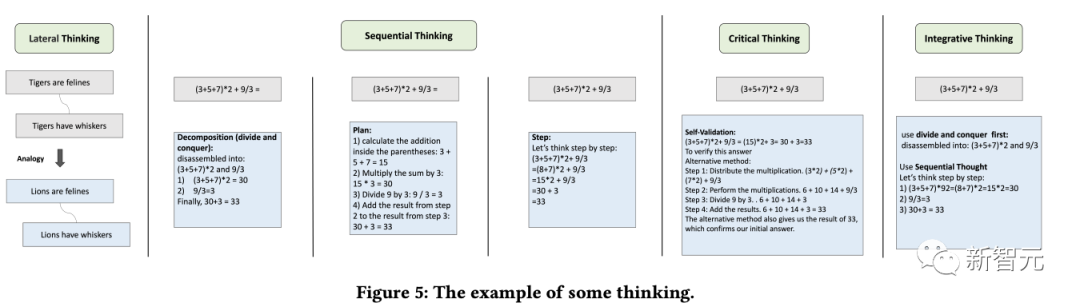

Raisonnement

Le but du module de raisonnement est de créer plusieurs agents basés sur le processus de raisonnement humain, stimulant ainsi la capacité de réflexion potentielle du modèle de langage et résolvant les problèmes de raisonnement.

Ce module combine plusieurs modèles de pensée en référence à des types de pensée spécifiques tels que la pensée latérale, la pensée séquentielle, la pensée critique et la pensée intégrative pour faciliter les tâches de raisonnement.

Contrôleur

Le module contrôleur est principalement utilisé pour gérer les sélections d'actions associées, y compris les tâches de planification interne du modèle (telles que la sélection de certains modules à exécuter) et la sélection parmi des faits, des outils, des notes et des bibliothèques de réflexion.

Les bibliothèques pertinentes sont d'abord récupérées et mises en correspondance, et le contenu récupéré est ensuite intégré dans un agent modèle, obligeant le modèle de langage à fournir des réponses sous un modèle de manière asynchrone, tout comme les humains peuvent avoir des difficultés au début de raisonnement En plus d'identifier toutes les informations pertinentes, il est également difficile de s'attendre à ce qu'un modèle de langage fasse cela en premier lieu.

Par conséquent, la récupération dynamique est mise en œuvre en fonction des questions de l'utilisateur et de la progression du raisonnement intermédiaire, en utilisant la méthode Faiss pour créer des index intégrés pour les quatre bibliothèques ci-dessus, où les stratégies de récupération de chaque bibliothèque sont légèrement différentes.

Vote

Étant donné que différents modèles de réflexion peuvent être plus adaptés à différents types de questions, les chercheurs ont conçu le module de vote pour améliorer la capacité d'étalonnage intégrée entre plusieurs modèles de réflexion et utiliser plusieurs stratégies de vote pour générer les meilleures réponses afin d'améliorer les performances.

Les méthodes de vote spécifiques incluent :

1. Vote sur le modèle de langage : guidez le modèle de langage pour sélectionner la réponse la plus cohérente parmi plusieurs options proposées et fournissez une raison.

2. Vote Regex : utilisez la correspondance exacte d'expressions régulières pour extraire les réponses afin d'obtenir les résultats du vote.

Résultats expérimentaux

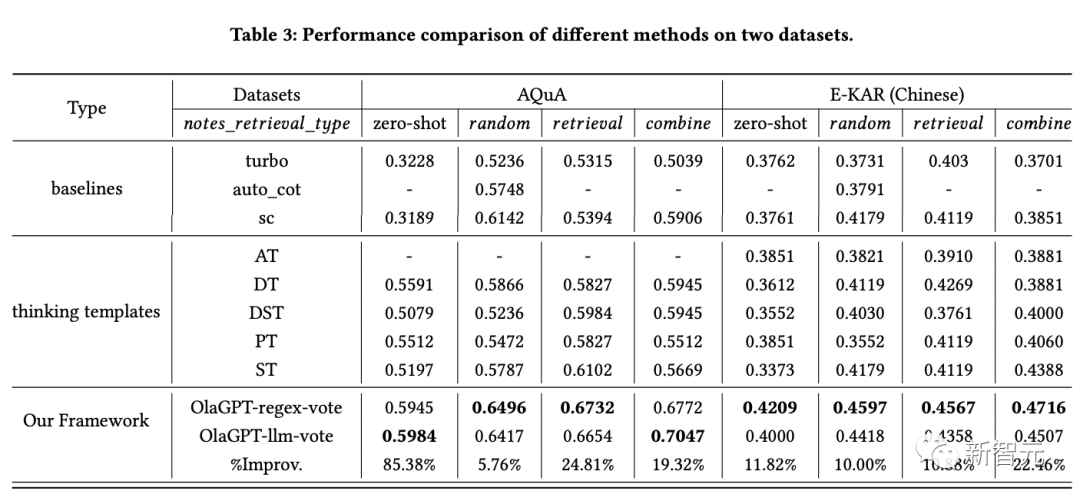

Pour évaluer l'efficacité de ce cadre de modèle de langage amélioré dans les tâches d'inférence, les chercheurs ont mené une comparaison expérimentale complète sur deux types d'ensembles de données d'inférence.

Les résultats le montrent :

1. SC (auto-cohérence) fonctionne mieux que GPT-3.5-turbo, ce qui indique que l'adoption d'une approche d'ensemble contribue dans une certaine mesure à améliorer l'efficacité des projets à grande échelle. modèles .

2. Les performances de la méthode proposée dans l'article dépassent SC, ce qui prouve dans une certaine mesure l'efficacité de la stratégie du modèle de réflexion.

Les réponses aux différents modèles de réflexion montrent des différences considérables, et voter selon différents modèles de réflexion produira en fin de compte de meilleurs résultats que de simplement procéder à plusieurs tours de vote.

3. Différents modèles de réflexion ont des effets différents, et les solutions étape par étape peuvent être plus adaptées aux problèmes de raisonnement.

4. Les performances du module d'apprentissage actif sont nettement meilleures que la méthode à échantillon zéro.

L'inclusion de cas difficiles dans la bibliothèque de notes, l'utilisation de listes aléatoires, de récupération et de combinaisons pour améliorer les performances est une stratégie réalisable.

5. Différents schémas de récupération ont des effets différents sur différents ensembles de données. En général, la stratégie de combinaison donne de meilleurs résultats.

6. La méthode de cet article est évidemment meilleure que les autres solutions, ce qui est dû à la conception raisonnable du cadre global, y compris la conception efficace du module d'apprentissage actif qui réalise l'adaptation aux différents modèles ; les résultats sous différents modèles de réflexion sont différents ; le module contrôleur joue un très bon rôle de contrôle et sélectionne le contenu qui correspond au contenu requis ; la méthode d'intégration des différents modèles de réflexion conçus par le module de vote est efficace ;

Référence :

https://www.php.cn/link/73a1c863a54653d5e184b790fee14754

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un