Périphériques technologiques

Périphériques technologiques

IA

IA

Remplacement de l'API GPT-4 ? Les performances sont comparables et le coût est réduit de 98 %. Stanford a proposé FrugalGPT, mais la recherche a suscité la controverse.

Remplacement de l'API GPT-4 ? Les performances sont comparables et le coût est réduit de 98 %. Stanford a proposé FrugalGPT, mais la recherche a suscité la controverse.

Remplacement de l'API GPT-4 ? Les performances sont comparables et le coût est réduit de 98 %. Stanford a proposé FrugalGPT, mais la recherche a suscité la controverse.

Avec le développement des grands modèles de langage (LLM), l'intelligence artificielle est dans une période de changement explosive. Il est bien connu que le LLM peut être utilisé dans des applications telles que les affaires, la science et la finance, c'est pourquoi de plus en plus d'entreprises (OpenAI, AI21, CoHere, etc.) proposent le LLM comme service de base. Bien que les LLM comme GPT-4 aient atteint des performances sans précédent dans des tâches telles que la réponse aux questions, leur nature à haut débit les rend très coûteux en applications.

Par exemple, ChatGPT coûte plus de 700 000 $ par jour pour fonctionner, tandis que l'utilisation de GPT-4 pour prendre en charge le service client peut coûter à une petite entreprise plus de 21 000 $ par mois. Outre le coût monétaire, l’utilisation des plus grands LLM entraîne des impacts environnementaux et énergétiques importants.

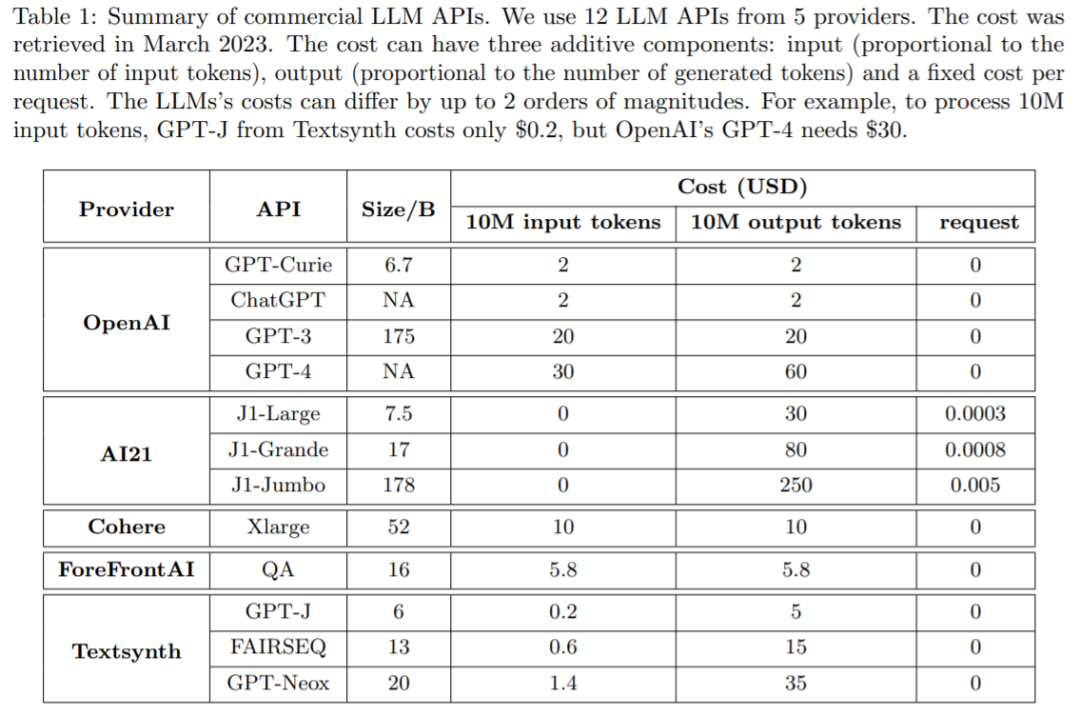

De nombreuses entreprises proposent désormais des services LLM via API, et leurs tarifs varient. Le coût d'utilisation de l'API LLM se compose généralement de trois éléments : 1) le coût de l'invite (proportionnel à la longueur de l'invite), 2) le coût de génération (proportionnel à la durée de la génération) et 3) parfois un prix fixe par requête. frais.

Le tableau 1 ci-dessous compare le coût de 12 LLM commerciaux différents de fournisseurs traditionnels, notamment OpenAI, AI21, CoHere et Textsynth. Leurs coûts diffèrent jusqu'à 2 ordres de grandeur : par exemple, l'invite GPT-4 d'OpenAI coûte 30 $ pour 10 millions de jetons, tandis que GPT-J hébergé par Textsynth ne coûte que 0,20 $.

L'équilibre entre coût et précision est un facteur clé dans la prise de décision, en particulier lors de l'adoption d'une nouvelle technologie. Comment utiliser efficacement le LLM est un défi clé pour les praticiens : si la tâche est relativement simple, alors l'agrégation de plusieurs réponses de GPT-J (qui est 30 fois plus petite que GPT-3) peut obtenir des performances similaires à celles de GPT-3, parvenir à un compromis en termes de coûts et d’environnement. Cependant, sur des tâches plus difficiles, les performances de GPT-J peuvent se dégrader considérablement. Par conséquent, de nouvelles approches sont nécessaires pour utiliser le LLM de manière rentable.

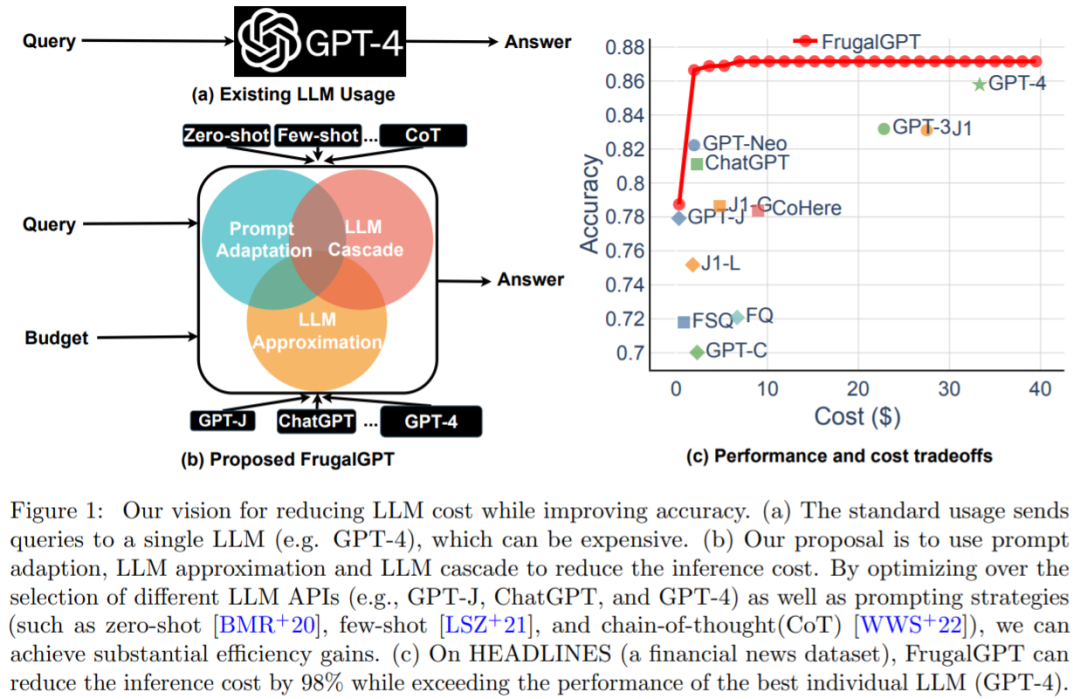

Une étude récente a tenté de proposer une solution à ce problème de coût. Les chercheurs ont montré expérimentalement que FrugalGPT peut rivaliser avec les performances du meilleur LLM individuel (comme le GPT-4), avec une réduction des coûts allant jusqu'à 98 %. , ou Améliorer la précision du meilleur LLM individuel de 4 % au même coût. Des chercheurs de l'Université de Stanford ont examiné l'utilisation d'API LLM telles que GPT-4, ChatGPT, J1-Jumbo) et ont découvert que ces modèles ont des prix différents, le coût peut différer de deux ordres de grandeur, en particulier en utilisant LLM sur de grandes quantités de requêtes et le texte peut être plus cher. Sur cette base, cette étude décrit et discute trois stratégies que les utilisateurs peuvent exploiter pour réduire le coût de l'inférence à l'aide de LLM : 1) une adaptation rapide, 2) une approximation LLM et 3) une mise en cascade LLM. De plus, cette étude propose une instance simple et flexible de LLM en cascade, FrugalGPT, qui apprend quelles combinaisons LLM utiliser dans différentes requêtes pour réduire les coûts et améliorer la précision.

Les idées et les résultats présentés dans cette étude jettent les bases d'une utilisation durable et efficace du LLM. Être capable d’adopter des capacités d’IA plus avancées sans augmenter les budgets pourrait favoriser une adoption plus large de la technologie d’IA dans tous les secteurs, donnant ainsi aux entreprises encore plus petites la possibilité de mettre en œuvre des modèles d’IA sophistiqués dans leurs opérations.

"Le résumé exagère grossièrement le sujet de l'article, et le titre ici est grossièrement trompeur. Ce qu'ils ont fait, c'est concevoir un moyen de réduire le besoin d'une classe de questions couvertes dans l'article. Nombre de appels à des modèles haut de gamme. Il ne s'agit pas d'un remplacement du GPT-4 à un coût de 2 %, ni d'un remplacement du GPT-4 à une précision de 4 %. Il s'agit d'une combinaison de GPT-4 avec des modèles moins chers et une infrastructure de support. Ce qui n'est pas souligné dans le résumé, c'est que cela nécessite la construction d'un modèle personnalisé pour évaluer les résultats, qui est le véritable cœur du mécanisme... Il existe des cas d'utilisation légitimes pour cette méthode, y compris la mise en cache des coûts. résultats. Mais pour la plupart des cas d'utilisation, cela n'est absolument pas pertinent car vous ne disposez pas d'un modèle de notation approprié. Ils n'ont évalué cela que sur trois (petits) ensembles de données et n'ont fourni aucune information sur la fréquence à laquelle FrugalGPT a sélectionné les modèles respectifs. que le modèle plus petit a atteint une précision supérieure à celle du GPT-4, ce qui me rend très sceptique quant à l'article en général. #Comment juger spécifiquement, jetons un coup d'œil au contenu de l'article.

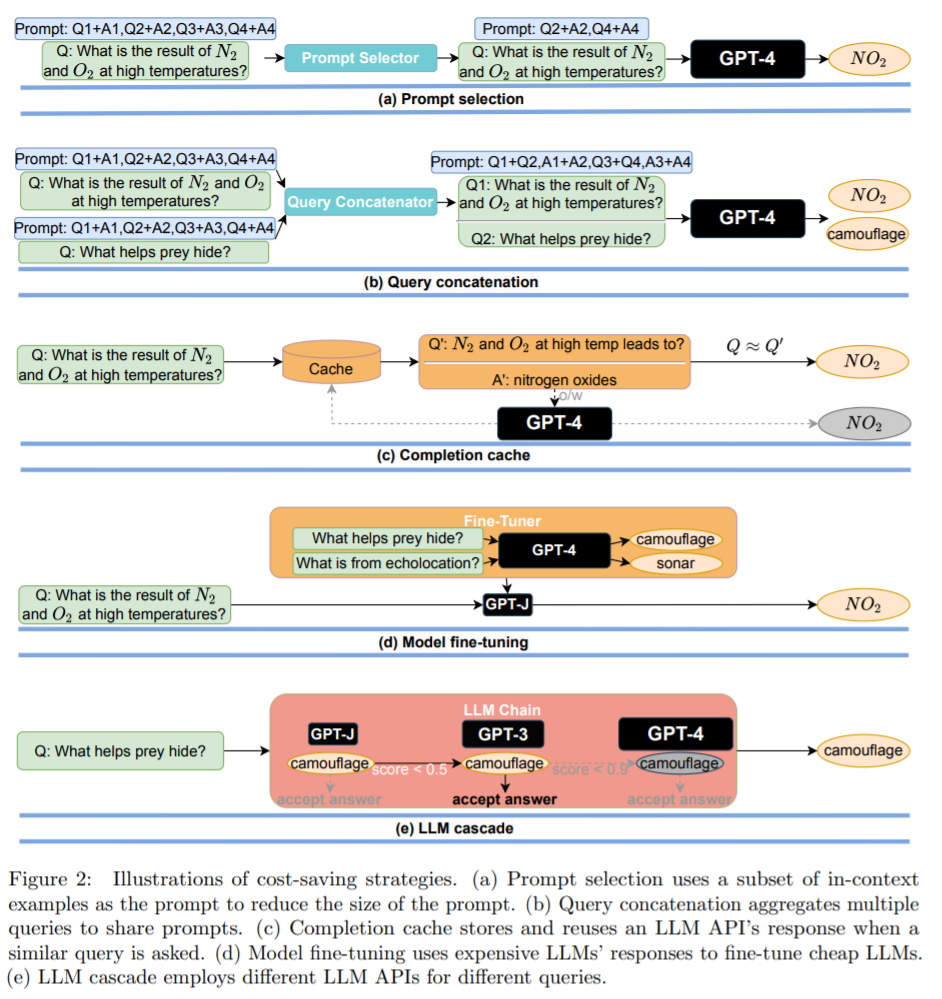

Comment utiliser LLM de manière économique et précise Le prochain article présente comment utiliser efficacement l'API LLM dans le cadre du budget. Comme le montre la figure 1 (b), cette étude discute de trois stratégies de réduction des coûts, à savoir l'adaptation rapide, l'approximation LLM et la cascade LLM.

Le prochain article présente comment utiliser efficacement l'API LLM dans le cadre du budget. Comme le montre la figure 1 (b), cette étude discute de trois stratégies de réduction des coûts, à savoir l'adaptation rapide, l'approximation LLM et la cascade LLM.

Stratégie 1 : adaptation rapide. Le coût des requêtes LLM augmente linéairement avec la taille de l'invite. Par conséquent, une approche raisonnable pour réduire le coût d’utilisation de l’API LLM implique de réduire la taille des invites, un processus que l’étude appelle l’adaptation des invites. La sélection de l'invite est illustrée à la figure 2 (a) : au lieu d'utiliser une invite contenant de nombreux exemples pour démontrer comment effectuer une tâche, il est possible de conserver uniquement un petit sous-ensemble d'exemples dans l'invite. Cela se traduit par des invites plus petites et des coûts inférieurs. Un autre exemple est la concaténation de requêtes (illustré dans la figure 2(b)).

Stratégie 3 : LLM Cascade. Différentes API LLM ont leurs propres forces et faiblesses dans diverses requêtes. Par conséquent, une sélection appropriée du LLM à utiliser peut à la fois réduire les coûts et améliorer les performances. Un exemple de cascade LLM est présenté à la figure 2 (e).

Réduction des coûts et amélioration de la précision  Le chercheur a mené une étude empirique sur la cascade FrugalGPT LLM avec trois objectifs :

Le chercheur a mené une étude empirique sur la cascade FrugalGPT LLM avec trois objectifs :

Comprendre ce qui est appris à travers un exemple simple de cascade LLM

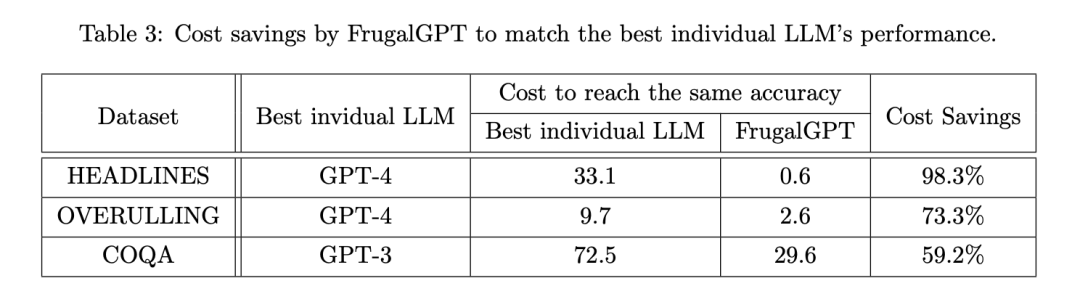

Quantifier les économies de coûts réalisées par FrugalGPT en faisant correspondre les performances de la meilleure API LLM individuelle ;

Mesure le compromis entre performance et coût réalisé par FrugalGPT.

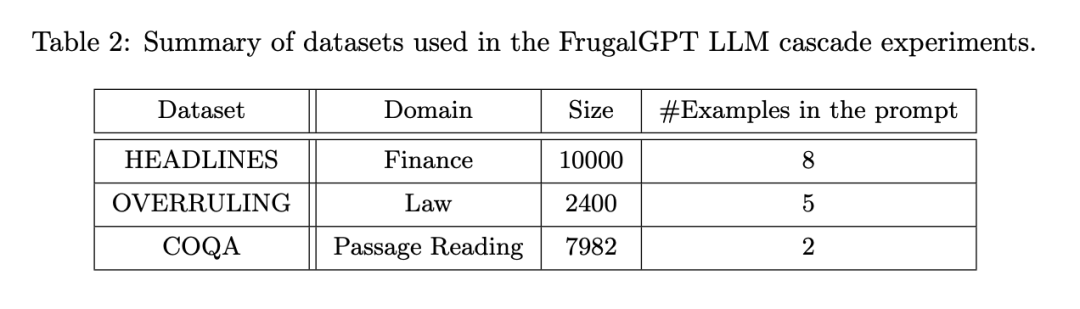

La configuration expérimentale est divisée en plusieurs aspects : API LLM (Tableau 1), tâches, ensembles de données (Tableau 2) et instances FrugalGPT.

FrugalGPT a été développé en plus de l'API ci-dessus et évalué sur une série d'ensembles de données appartenant à différentes tâches. Parmi eux, HEADLINES est un ensemble de données d'actualité financière. L'objectif est de déterminer la tendance du prix de l'or (à la hausse, à la baisse, neutre ou nulle) en lisant les titres de l'actualité financière, ce qui est particulièrement utile pour filtrer les actualités pertinentes sur le marché financier ; un ensemble de données de documents juridiques, dont le but est de déterminer si une phrase donnée est une « annulation », c'est-à-dire qu'elle annule une affaire juridique antérieure ; COQA est un ensemble de données de compréhension écrite développé dans un environnement conversationnel, que les chercheurs ont adapté comme un ensemble de données de compréhension écrite. tâche de réponse aux requêtes.

Ils se concentrent sur la méthode en cascade LLM avec une longueur de cascade de 3 car cela simplifie l'espace d'optimisation et de bons résultats ont été montrés. Chaque ensemble de données est divisé de manière aléatoire en un ensemble de formation pour apprendre la cascade LLM et un ensemble de tests pour l'évaluation.

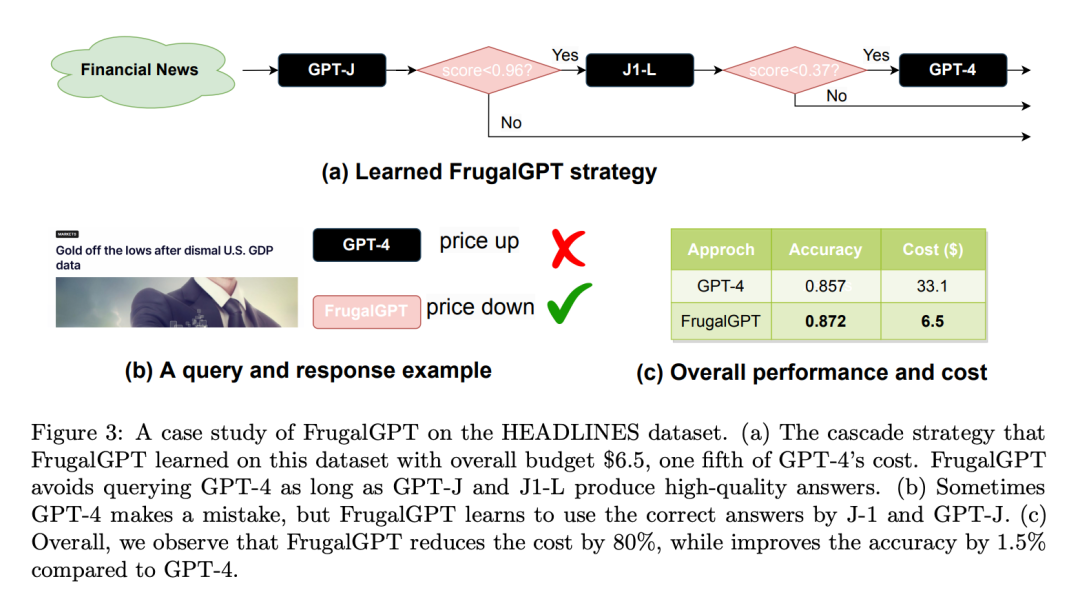

Voici un cas d'ensemble de données HEADLINES étude : fixer le budget à 6,50 $, soit un cinquième du coût du GPT-4. Adoptez DistilBERT [SDCW19] pour la régression comme fonction de notation. Il convient de noter que DistilBERT est beaucoup plus petit que tous les LLM considérés ici et est donc moins cher. Comme le montre la figure 3 (a), le FrugalGPT appris appelle séquentiellement GPT-J, J1-L et GPT-4. Pour toute requête donnée, il extrait d’abord une réponse de GPT-J. Si le score de la réponse est supérieur à 0,96, la réponse est acceptée comme réponse finale. Sinon, J1-L sera interrogé. Si le score de réponse de J1-L est supérieur à 0,37, il est accepté comme réponse finale ; sinon, GPT-4 est invoqué pour obtenir la réponse finale ; Fait intéressant, cette approche surpasse GPT-4 sur de nombreuses requêtes. Par exemple, sur la base du titre du Nasdaq « Les données sur le PIB américain sont lamentables, l'or est hors de son plus bas », FrugalGPT a prédit avec précision que les prix allaient baisser, tandis que GPT-4 a fourni une réponse erronée (comme le montre la figure 3(b)).

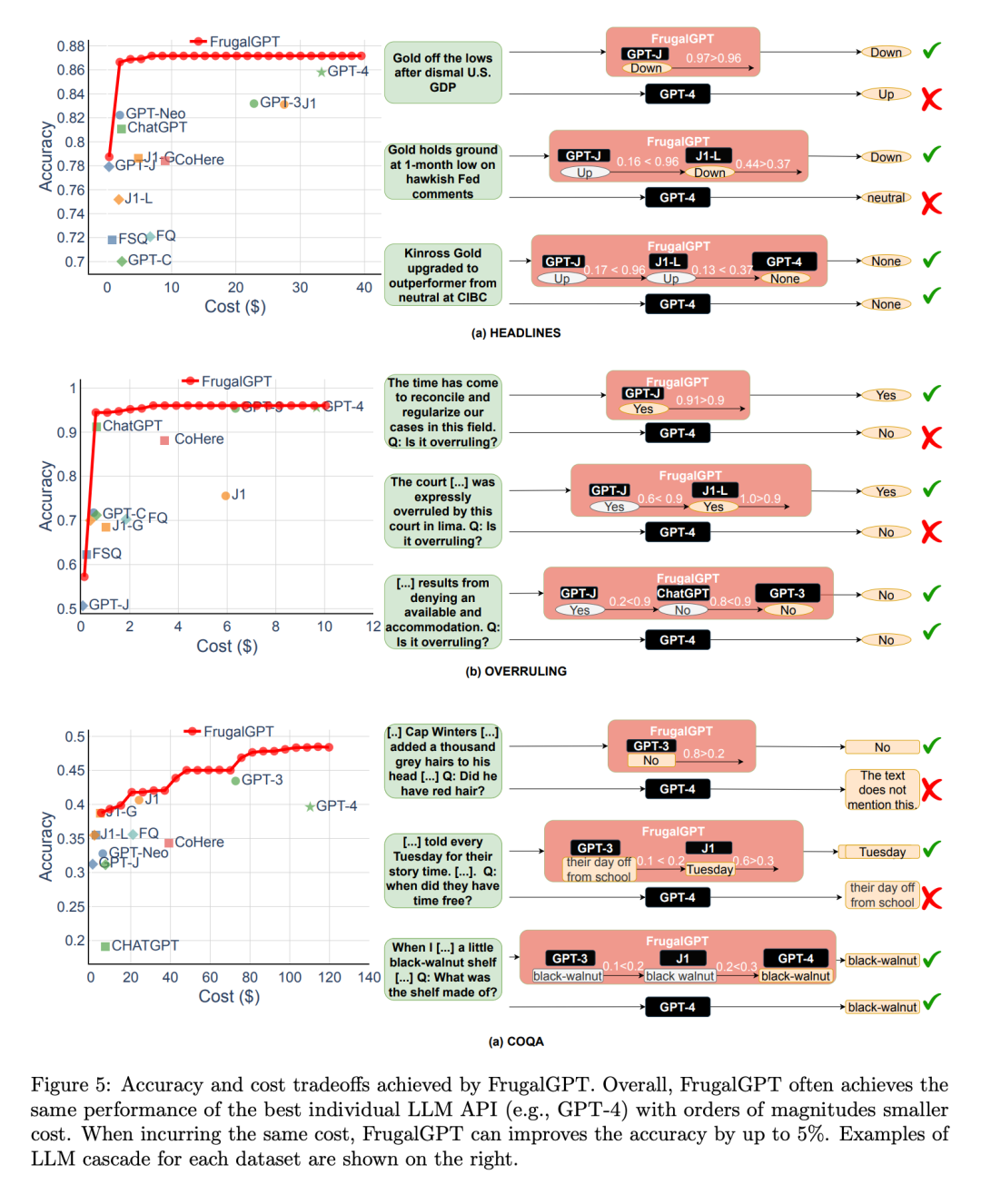

Dans l'ensemble, le résultat de FrugalGPT est à la fois une précision améliorée et une réduction des coûts. Comme le montre la figure 3 (c), le coût est réduit de 80 %, tandis que la précision est même supérieure de 1,5 %. # 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 ## 🎜🎜 # # # # llm de Diversité

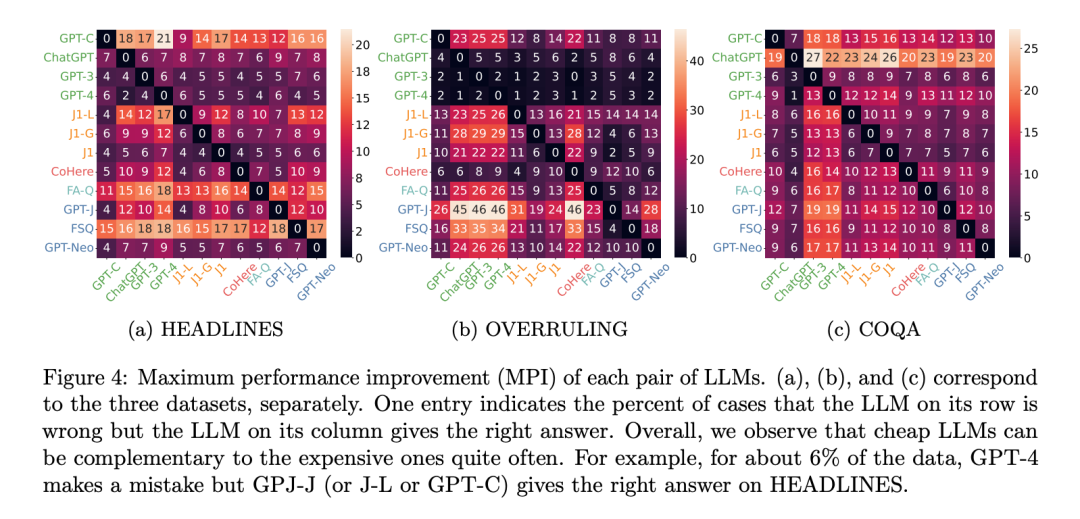

Pourquoi plusieurs API LLM sont-elles susceptibles de produire de meilleures performances que le meilleur LLM unique ? Cela est essentiellement dû à la diversité des générations : même un LLM à faible coût peut parfois répondre correctement à des requêtes qu'un LLM à coût plus élevé ne peut pas répondre. Pour mesurer cette diversité, les chercheurs utilisent l’amélioration maximale des performances, également connue sous le nom de MPI. Le MPI du LLM A par rapport au LLM B est la probabilité que le LLM A produise une réponse correcte et que le LLM B fournisse une réponse incorrecte. Cette métrique mesure essentiellement l'amélioration maximale des performances pouvant être obtenue en appelant LLM A en même temps que LLM B.

Économie de coûts s

Les chercheurs ont ensuite examiné si FrugalGPT pouvait réduire les coûts tout en maintenant la précision, et si oui, de combien. Le tableau 3 montre les économies globales de FrugalGPT, allant de 50 % à 98 %. Cela est possible car FrugalGPT peut identifier les requêtes auxquelles des LLM plus petits peuvent répondre avec précision, et appelle donc uniquement les LLM qui sont rentables. Bien que les LLM puissants mais coûteux, tels que GPT-4, ne soient utilisés que pour les requêtes difficiles détectées par FrugalGPT. Compromis entre performances et coûts Ensuite, les chercheurs ont exploré le compromis entre performances et coûts mis en œuvre par FrugalGPT, comme le montre la figure 5, et ont obtenu plusieurs observations intéressantes. résultats. Tout d'abord, le classement des coûts des différentes API LLM n'est pas fixe. De plus, les API LLM plus coûteuses entraînent parfois des performances moins bonnes que leurs homologues moins chères. Ces observations soulignent l’importance d’une sélection appropriée des API LLM, même en l’absence de contraintes budgétaires. Ensuite, les chercheurs ont également noté que FrugalGPT était capable d'obtenir un compromis performance-coût fluide sur tous les ensembles de données évalués. Cela offre des options flexibles aux utilisateurs de LLM et a le potentiel d'aider les fournisseurs d'API LLM à économiser de l'énergie et à réduire les émissions de carbone. En fait, FrugalGPT peut simultanément réduire les coûts et améliorer la précision, probablement parce que FrugalGPT intègre les connaissances de plusieurs LLM. L'exemple de requête présenté dans la figure 5 explique plus en détail pourquoi FrugalGPT peut améliorer les performances et réduire les coûts en même temps. GPT-4 commet des erreurs sur certaines requêtes, comme le premier exemple de la partie (a), mais certaines API à faible coût fournissent des prédictions correctes. FrugalGPT identifie avec précision ces requêtes et s'appuie entièrement sur des API à faible coût. Par exemple, GPT-4 déduit à tort qu'il n'y a pas de renversement de la déclaration juridique « Il est temps d'harmoniser et de standardiser nos cas dans ce domaine », comme le montre la figure 5(b). Cependant, FrugalGPT accepte les réponses correctes de GPT-J, évite l'utilisation de LLM coûteux et améliore les performances globales. Bien entendu, une seule API LLM n’est pas toujours correcte ; la cascade LLM surmonte ce problème en employant une chaîne d’API LLM. Par exemple, dans le deuxième exemple illustré à la figure 5(a), FrugalGPT découvre que la génération de GPT-J peut être peu fiable et se tourne vers le deuxième LLM de la chaîne, J1-L, pour trouver la bonne réponse. Encore une fois, GPT-4 fournit la mauvaise réponse. FrugalGPT n’est pas parfait et il reste encore beaucoup de marge pour réduire les coûts. Par exemple, dans le troisième exemple de la figure 5 (c), toutes les API LLM de la chaîne donnent la même réponse. Cependant, FrugalGPT ne sait pas si le premier LLM est correct, ce qui nécessite d'interroger tous les LLM de la chaîne. Déterminer comment éviter cela reste une question ouverte. Pour plus de détails sur la recherche, veuillez vous référer à l'article original.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

Ligne de commande de l'arrêt CentOS

Apr 14, 2025 pm 09:12 PM

La commande de fermeture CENTOS est arrêtée et la syntaxe est la fermeture de [options] le temps [informations]. Les options incluent: -H Arrêtez immédiatement le système; -P éteignez l'alimentation après l'arrêt; -r redémarrer; -t temps d'attente. Les temps peuvent être spécifiés comme immédiats (maintenant), minutes (minutes) ou une heure spécifique (HH: mm). Des informations supplémentaires peuvent être affichées dans les messages système.

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Comment vérifier la configuration de CentOS HDFS

Apr 14, 2025 pm 07:21 PM

Guide complet pour vérifier la configuration HDFS dans les systèmes CentOS Cet article vous guidera comment vérifier efficacement la configuration et l'état de l'exécution des HDF sur les systèmes CentOS. Les étapes suivantes vous aideront à bien comprendre la configuration et le fonctionnement des HDF. Vérifiez la variable d'environnement Hadoop: Tout d'abord, assurez-vous que la variable d'environnement Hadoop est correctement définie. Dans le terminal, exécutez la commande suivante pour vérifier que Hadoop est installé et configuré correctement: HadoopVersion Check HDFS Fichier de configuration: Le fichier de configuration de base de HDFS est situé dans le répertoire / etc / hadoop / conf / le répertoire, où Core-site.xml et hdfs-site.xml sont cruciaux. utiliser

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

Quelles sont les méthodes de sauvegarde pour Gitlab sur Centos

Apr 14, 2025 pm 05:33 PM

La politique de sauvegarde et de récupération de GitLab dans le système CentOS afin d'assurer la sécurité et la récupérabilité des données, Gitlab on CentOS fournit une variété de méthodes de sauvegarde. Cet article introduira plusieurs méthodes de sauvegarde courantes, paramètres de configuration et processus de récupération en détail pour vous aider à établir une stratégie complète de sauvegarde et de récupération de GitLab. 1. MANUEL BACKUP Utilisez le Gitlab-RakegitLab: Backup: Créer la commande pour exécuter la sauvegarde manuelle. Cette commande sauvegarde des informations clés telles que le référentiel Gitlab, la base de données, les utilisateurs, les groupes d'utilisateurs, les clés et les autorisations. Le fichier de sauvegarde par défaut est stocké dans le répertoire / var / opt / gitlab / backups. Vous pouvez modifier / etc / gitlab

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Explication détaillée du principe docker

Apr 14, 2025 pm 11:57 PM

Docker utilise les fonctionnalités du noyau Linux pour fournir un environnement de fonctionnement d'application efficace et isolé. Son principe de travail est le suivant: 1. Le miroir est utilisé comme modèle en lecture seule, qui contient tout ce dont vous avez besoin pour exécuter l'application; 2. Le Système de fichiers Union (UnionFS) empile plusieurs systèmes de fichiers, ne stockant que les différences, l'économie d'espace et l'accélération; 3. Le démon gère les miroirs et les conteneurs, et le client les utilise pour l'interaction; 4. Les espaces de noms et les CGROUP implémentent l'isolement des conteneurs et les limitations de ressources; 5. Modes de réseau multiples prennent en charge l'interconnexion du conteneur. Ce n'est qu'en comprenant ces concepts principaux que vous pouvez mieux utiliser Docker.

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Comment est la prise en charge du GPU pour Pytorch sur Centos

Apr 14, 2025 pm 06:48 PM

Activer l'accélération du GPU Pytorch sur le système CentOS nécessite l'installation de versions CUDA, CUDNN et GPU de Pytorch. Les étapes suivantes vous guideront tout au long du processus: CUDA et CUDNN Installation détermineront la compatibilité de la version CUDA: utilisez la commande NVIDIA-SMI pour afficher la version CUDA prise en charge par votre carte graphique NVIDIA. Par exemple, votre carte graphique MX450 peut prendre en charge CUDA11.1 ou plus. Téléchargez et installez Cudatoolkit: visitez le site officiel de Nvidiacudatoolkit et téléchargez et installez la version correspondante selon la version CUDA la plus élevée prise en charge par votre carte graphique. Installez la bibliothèque CUDNN:

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installe MySQL

Apr 14, 2025 pm 08:09 PM

L'installation de MySQL sur CENTOS implique les étapes suivantes: Ajout de la source MySQL YUM appropriée. Exécutez la commande YUM Install MySQL-Server pour installer le serveur MySQL. Utilisez la commande mysql_secure_installation pour créer des paramètres de sécurité, tels que la définition du mot de passe de l'utilisateur racine. Personnalisez le fichier de configuration MySQL selon les besoins. Écoutez les paramètres MySQL et optimisez les bases de données pour les performances.

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Comment afficher les journaux Gitlab sous Centos

Apr 14, 2025 pm 06:18 PM

Un guide complet pour consulter les journaux GitLab sous Centos System Cet article vous guidera comment afficher divers journaux GitLab dans le système CentOS, y compris les journaux principaux, les journaux d'exception et d'autres journaux connexes. Veuillez noter que le chemin du fichier journal peut varier en fonction de la version Gitlab et de la méthode d'installation. Si le chemin suivant n'existe pas, veuillez vérifier le répertoire d'installation et les fichiers de configuration de GitLab. 1. Afficher le journal GitLab principal Utilisez la commande suivante pour afficher le fichier journal principal de l'application GitLabRails: Commande: sudocat / var / log / gitlab / gitlab-rails / production.log Cette commande affichera le produit

Comment choisir la version Pytorch sur Centos

Apr 14, 2025 pm 06:51 PM

Comment choisir la version Pytorch sur Centos

Apr 14, 2025 pm 06:51 PM

Lors de l'installation de Pytorch sur le système CentOS, vous devez sélectionner soigneusement la version appropriée et considérer les facteurs clés suivants: 1. Compatibilité de l'environnement du système: Système d'exploitation: Il est recommandé d'utiliser CentOS7 ou plus. CUDA et CUDNN: La version Pytorch et la version CUDA sont étroitement liées. Par exemple, Pytorch1.9.0 nécessite CUDA11.1, tandis que Pytorch2.0.1 nécessite CUDA11.3. La version CUDNN doit également correspondre à la version CUDA. Avant de sélectionner la version Pytorch, assurez-vous de confirmer que des versions compatibles CUDA et CUDNN ont été installées. Version Python: branche officielle de Pytorch