Périphériques technologiques

Périphériques technologiques

IA

IA

Que peut faire d'autre la PNL ? L'Université Beihang, l'ETH, l'Université des sciences et technologies de Hong Kong, l'Académie chinoise des sciences et d'autres institutions ont publié conjointement un article d'une centaine de pages pour expliquer systématiquement la chaîne technologique post-ChatGPT.

Que peut faire d'autre la PNL ? L'Université Beihang, l'ETH, l'Université des sciences et technologies de Hong Kong, l'Académie chinoise des sciences et d'autres institutions ont publié conjointement un article d'une centaine de pages pour expliquer systématiquement la chaîne technologique post-ChatGPT.

Que peut faire d'autre la PNL ? L'Université Beihang, l'ETH, l'Université des sciences et technologies de Hong Kong, l'Académie chinoise des sciences et d'autres institutions ont publié conjointement un article d'une centaine de pages pour expliquer systématiquement la chaîne technologique post-ChatGPT.

Tout commence avec l'émergence de ChatGPT...

La communauté PNL autrefois paisible a été effrayée par ce "monstre" soudain ! Du jour au lendemain, l'ensemble du cercle de la PNL a subi d'énormes changements. L'industrie a rapidement suivi, les capitaux ont augmenté et la voie de la réplication de ChatGPT a commencé. La communauté universitaire est soudainement tombée dans un état de confusion... Tout le monde a lentement commencé à le faire ; Je crois que "la PNL est résolue!"

Cependant, à en juger par le cercle académique de la PNL qui est encore actif récemment et le flux incessant d'excellents travaux, ce n'est même pas le cas. est devenu réel!"

Au cours des derniers mois, l'Université Beihang, Mila, l'Université des sciences et technologies de Hong Kong, l'ETH Zurich, l'Université de Waterloo, le Dartmouth College, l'Université de Sheffield, l'Académie chinoise des sciences et d'autres institutions ont perfectionné l'article de 110 pages explique systématiquement la chaîne technologique dans l'ère post-ChatGPT : l'interaction.

- Adresse papier : https://arxiv.org/abs/2305.13246

- Ressources du projet : https://github. com /InteractiveNLP-Team

- Industrie : Si les grands modèles présentent des problèmes difficiles à résoudre tels que la factualité et l’actualité, ChatGPT+X peut-il les résoudre ? Même comme les plugins ChatGPT, laissez-le interagir avec des outils pour nous aider à réserver des billets, commander des repas et dessiner des images en une seule étape ! En d’autres termes, nous pouvons atténuer certaines des limitations des grands modèles actuels grâce à certains cadres techniques systématiques.

-

Au monde universitaire : qu'est-ce que la véritable AGI ? En fait, dès 2020, Yoshua Bengio, l'un des trois géants de l'apprentissage profond et lauréat du prix Turing, a décrit un modèle de modèle de langage interactif [1] : un modèle de langage qui peut interagir avec l'environnement et même interagir socialement. avec d’autres agents. Ce n’est qu’ainsi que nous pourrons avoir la représentation sémantique la plus complète du langage. Dans une certaine mesure, l’interaction avec l’environnement et les personnes crée l’intelligence humaine.

Qu'est-ce que l'interaction ?

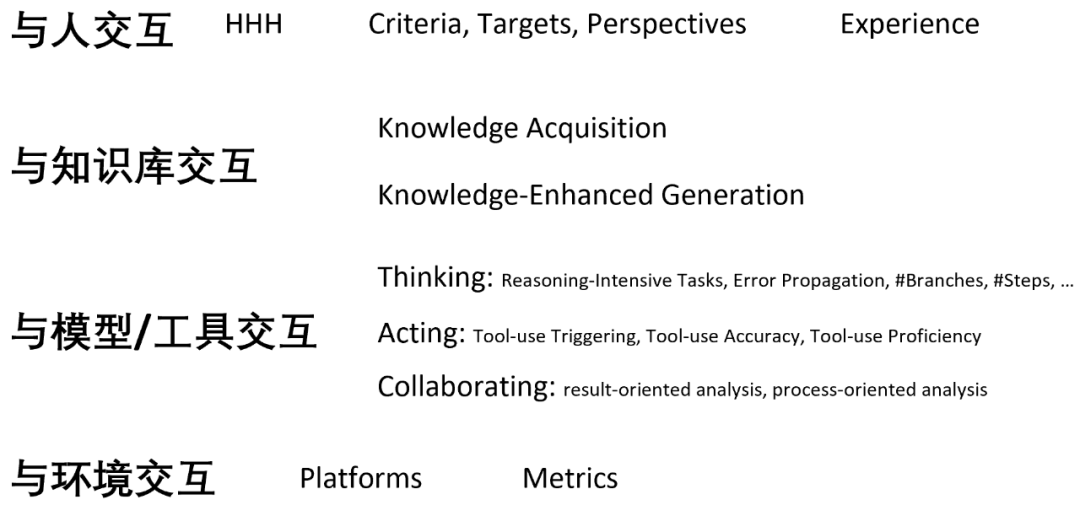

En fait, le concept « d'interaction » n'est pas celui imaginé par les auteurs. Depuis l'avènement de ChatGPT, de nombreux articles ont été publiés sur de nouvelles problématiques dans le monde de la PNL, tels que : Par conséquent, on peut dire que la fonctionnalité « interaction » est l'une des voies de développement technique les plus courantes pour la PNL après ChatGPT ! L'article des auteurs définit et déconstruit systématiquement la « PNL interactive » pour la première fois, et principalement sur la base de la dimension des objets interactifs, discute des avantages et des inconvénients de diverses solutions techniques et considérations d'application de manière aussi complète que possible, notamment : # 🎜🎜#

LM interagit avec les humains pour mieux comprendre et satisfaire les besoins des utilisateurs, Personnaliser les réponses , s'aligner sur les valeurs humaines et améliorer l'expérience utilisateur globale ;

- LM Interagir avec la base de connaissances pour enrichir les connaissances factuelles exprimées dans la langue et améliorer la corrélation du contexte des connaissances des réponses et de manière dynamique exploiter des informations externes pour générer des réponses plus précises ; Les connaissances spécifiques gèrent des sous-tâches spécifiques et favorisent l'émergence de comportements sociaux des agents

- LM interagit avec l'environnement pour apprendre le langage ; représentation de l'entité (fondation du langage) et gérer efficacement les tâches incarnées liées à l'observation de l'environnement telles que le raisonnement, la planification et la prise de décision.

- Ainsi, dans le cadre interactif, le modèle de langage n'est plus le modèle de langage lui-même, mais un modèle de langage qui peut être « observé » et « Des agents basés sur le langage qui peuvent « agir » et « obtenir des commentaires ».

- Interagissant avec un objet, les auteurs l'appellent "XXX-in-the-loop", indiquant que cet objet participe au processus de formation ou d'inférence de modèle de langage, et y participer sous la forme d'une cascade, d'une boucle, d'un feedback ou d'une itération. Interagir avec les gens

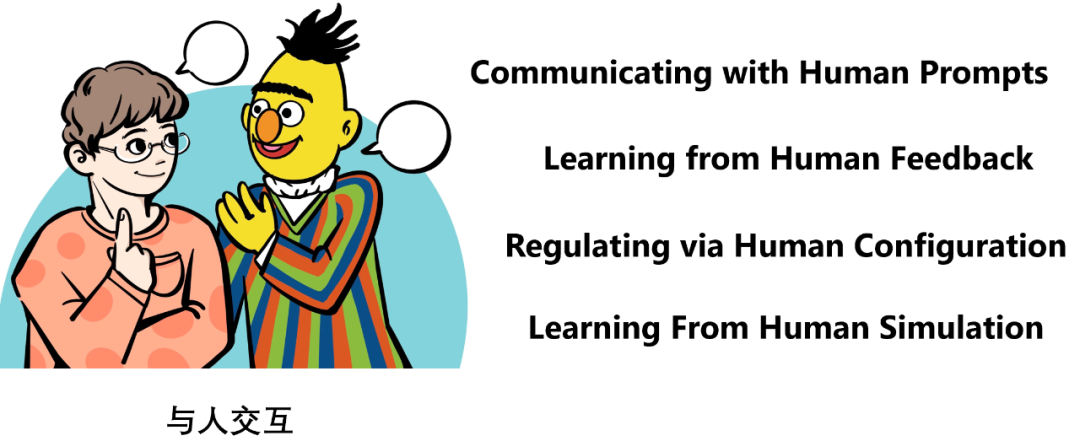

#🎜 🎜 #

Il existe trois façons d'interagir avec les gens : Utiliser les commentaires pour apprendre 🎜#

De plus, afin de garantir un déploiement évolutif, des modèles ou des programmes sont souvent utilisés pour simuler le comportement ou les préférences humaines , c'est-à-dire apprendre à partir de simulations humaines.En général, le problème central à résoudre dans l'interaction humaine est l'alignement, c'est-à-dire comment rendre la réponse du modèle de langage plus conforme aux besoins de l'utilisateur. Il est plus utile, inoffensif et bien fondé, permettant aux utilisateurs d'avoir une meilleure expérience utilisateur, etc.

« Utiliser les invites pour communiquer » se concentre principalement sur la nature continue et en temps réel de l'interaction, c'est-à-dire qu'il met l'accent sur la nature continue de plusieurs cycles de dialogue. Ceci est cohérent avec l’idée de l’IA conversationnelle [8]. Autrement dit, à travers plusieurs cycles de dialogue, laissez l'utilisateur continuer à poser des questions, afin que la réponse du modèle de langage s'aligne lentement sur les préférences de l'utilisateur pendant le dialogue. Cette approche ne nécessite généralement pas d'ajustement des paramètres du modèle pendant l'interaction.

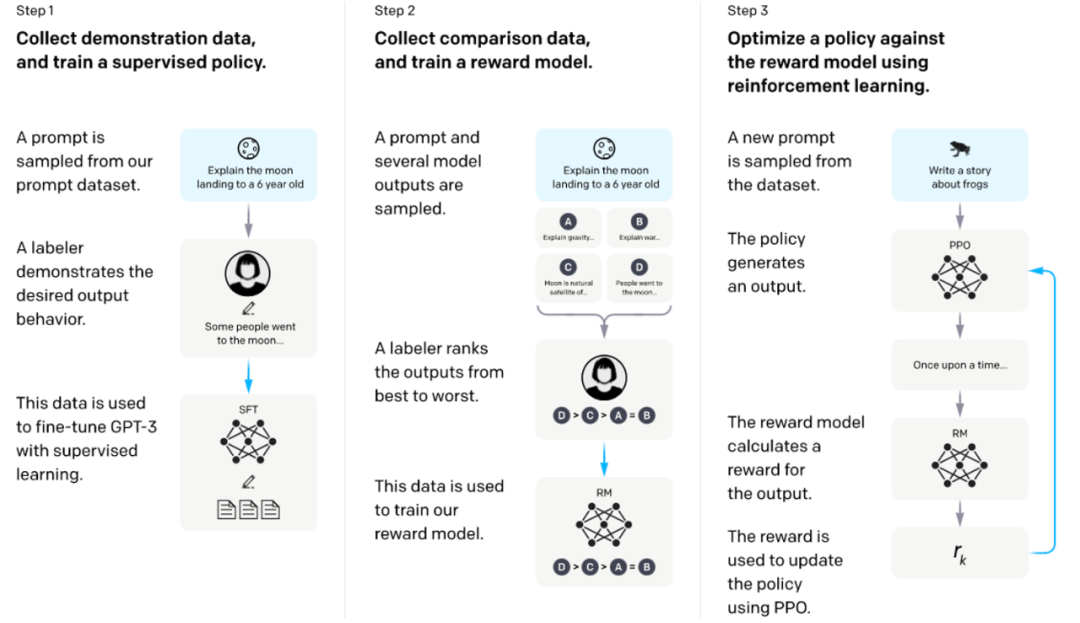

"Apprendre à l'aide du feedback" est actuellement le principal moyen d'alignement, qui consiste à permettre aux utilisateurs de donner un feedback sur la réponse du modèle de langage. Ce feedback peut être une annotation "bonne/mauvaise" décrivant les préférences, ou il peut être naturel. Commentaires plus détaillés sous forme linguistique. Le modèle doit être entraîné pour rendre ces rétroactions aussi élevées que possible. Un exemple typique est RLHF [7] utilisé par InstructGPT. Il utilise d'abord les données de retour de préférence étiquetées par l'utilisateur pour les réponses du modèle afin de former un modèle de récompense, puis utilise ce modèle de récompense pour former un modèle de langage avec un certain algorithme RL afin de maximiser la récompense. (comme indiqué ci-dessous) ).

Former les modèles de langage à suivre les instructions avec des commentaires humains [7]

"Ajuster à l'aide de la configuration" est une méthode interactive spéciale qui permet aux utilisateurs d'ajuster directement les super paramètres du modèle de langage (tels que comme la température), ou la méthode en cascade de modèles de langage, etc. Un exemple typique est les chaînes d'IA de Google [9]. Les modèles de langage avec différentes invites prédéfinies sont connectés les uns aux autres pour former une chaîne de raisonnement pour le traitement des tâches rationalisées. Les utilisateurs peuvent ajuster la méthode de connexion des nœuds de cette chaîne via un glisser-déposer de l'interface utilisateur.

« Apprendre à partir de la simulation humaine » peut favoriser le déploiement à grande échelle des trois méthodes ci-dessus, car, notamment dans le processus de formation, utiliser de vrais utilisateurs est irréaliste. Par exemple, RLHF doit généralement utiliser un modèle de récompense pour simuler les préférences des utilisateurs. Un autre exemple est l'ITG de Microsoft Research [10], qui utilise un modèle Oracle pour simuler le comportement d'édition de l'utilisateur.

Récemment, le professeur Percy Liang de Stanford et d'autres ont construit un système d'évaluation très systématique de l'interaction homme-LM : évaluation de l'interaction modèle homme-langage [11].

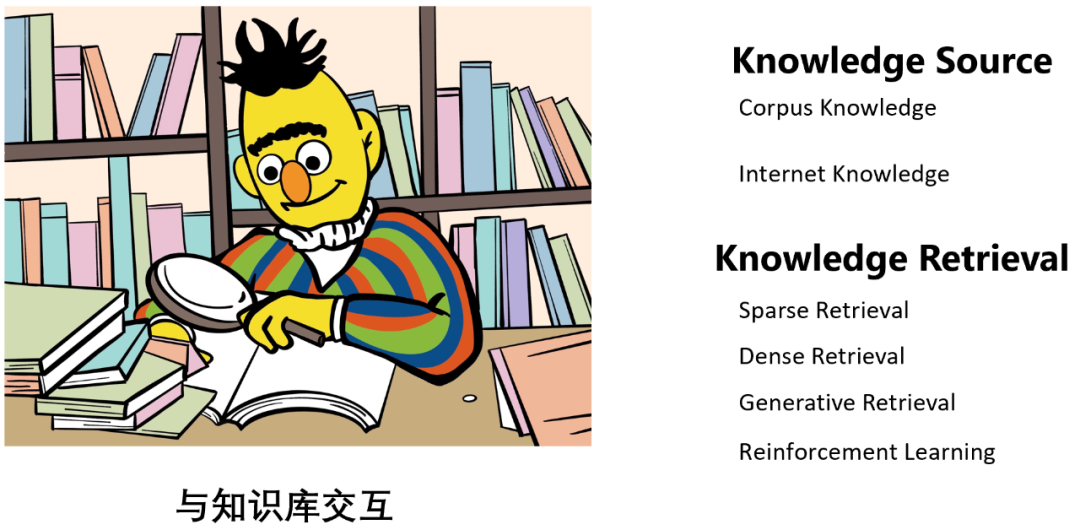

déterminer la source de connaissances supplémentaires : Source de connaissances

- Recherche de connaissances : Connaissance Récupération

- Utiliser les connaissances pour l'amélioration : veuillez vous référer à la section Interaction Message Fusion de cet article pour plus de détails. Je ne le présenterai pas ici.

- En général, l'interaction avec la base de connaissances peut atténuer le phénomène « d'hallucination » du modèle de langage, c'est-à-dire améliorer la factualité et l'exactitude de sa sortie, et peut également contribuer à améliorer l'actualité du modèle de langage. pour aider à compléter les capacités de connaissances du modèle de langage (comme indiqué ci-dessous), etc.

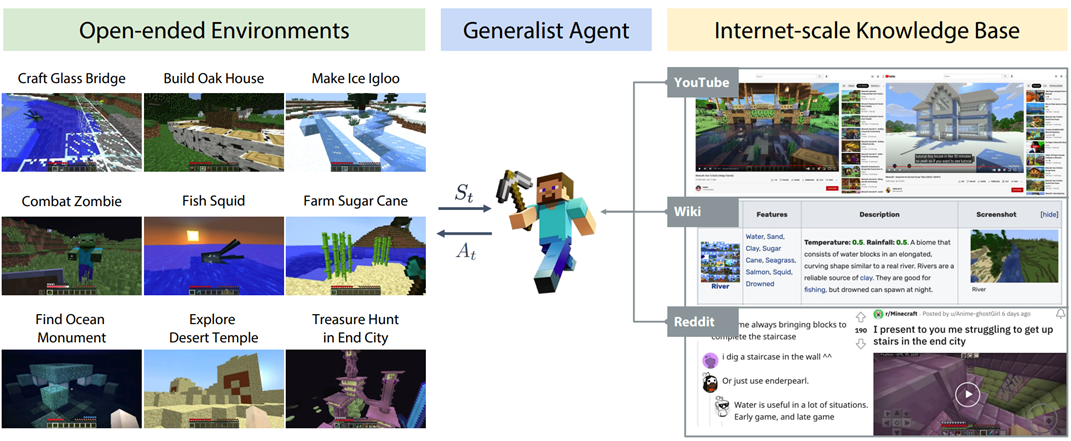

MineDojo [16] : lorsqu'un agent de modèle de langage rencontre une tâche qu'il ne connaît pas, il peut rechercher du matériel d'apprentissage dans la base de connaissances, puis terminer la tâche à l'aide du matériel . « Source de connaissances » est divisée en deux types, l'un est la connaissance de corpus fermé (Corpus Knowledge), comme WikiText, etc. [15] ; connaissances de recherche disponibles pour le moteur [14].

« Knowledge Retrieval » est divisé en quatre méthodes :

- Représentation clairsemée basée sur le langage et récupération clairsemée (récupération clairsemée) de correspondance lexicale : comme la correspondance n-gramme, BM25, etc.

- Récupération dense (récupération dense) basée sur une représentation dense basée sur le langage et une correspondance sémantique : comme l'utilisation d'un modèle à tour unique ou à double tour comme récupérateur, etc.

- Basé sur la recherche générative : il s'agit d'une méthode relativement nouvelle. Le travail représentatif est l'index de recherche différenciable [12] de Google Tay Yi et al., qui enregistre les connaissances sur les paramètres du modèle de langage et les génère directement. après avoir donné une requête. L'identifiant du document ou le contenu du document correspondant à la connaissance. Parce que le modèle de langage est la base de connaissances [13] !

- Basé sur l'apprentissage par renforcement : C'est aussi une méthode relativement avant-gardiste. Les travaux représentatifs tels que WebGPT d'OpenAI [14] utilisent le retour humain pour entraîner le modèle afin de récupérer les connaissances correctes.

Interagir avec des modèles ou des outils

L'objectif principal des modèles de langage interagissant avec des modèles ou des outils est de décomposer des tâches complexes, telles que la décomposition de tâches de raisonnement complexes en plusieurs sous-tâches, ce qui est également une chaîne de la pensée [17]. Différentes sous-tâches peuvent être résolues à l'aide de modèles ou d'outils dotés de différentes capacités. Par exemple, les tâches informatiques peuvent être résolues à l'aide de calculatrices et les tâches de récupération peuvent être résolues à l'aide de modèles de récupération. Par conséquent, ce type d'interaction peut non seulement améliorer les capacités de raisonnement, de planification et de prise de décision du modèle de langage, mais également atténuer les limitations du modèle de langage telles que « l'hallucination » et les résultats inexacts. En particulier, lorsqu'un outil est utilisé pour effectuer une sous-tâche spécifique, il peut avoir un certain impact sur le monde extérieur, comme l'utilisation de l'API WeChat pour publier un cercle d'amis, etc., ce que l'on appelle « orienté outil ». Apprentissage" [ 2].

De plus, il est parfois difficile de décomposer explicitement une tâche complexe. Dans ce cas, vous pouvez attribuer différents rôles ou compétences à différents modèles de langage, puis laisser ces modèles de langage collaborer les uns avec les autres. Au cours du processus de communication, une certaine division du plan de travail se forme implicitement et automatiquement pour décomposer les tâches. Ce type d'interaction peut non seulement simplifier le processus de résolution de tâches complexes, mais également simuler la société humaine et construire une certaine forme de société d'agents intelligents.

Les auteurs rassemblent modèles et outils, principalement parce que les modèles et les outils ne sont pas nécessairement deux catégories distinctes. Par exemple, un outil de moteur de recherche et un modèle de récupération ne sont pas essentiellement différents. Cette essence est définie par les auteurs en utilisant « après la décomposition des tâches, quels types de sous-tâches sont entreprises par quels types d'objets ».

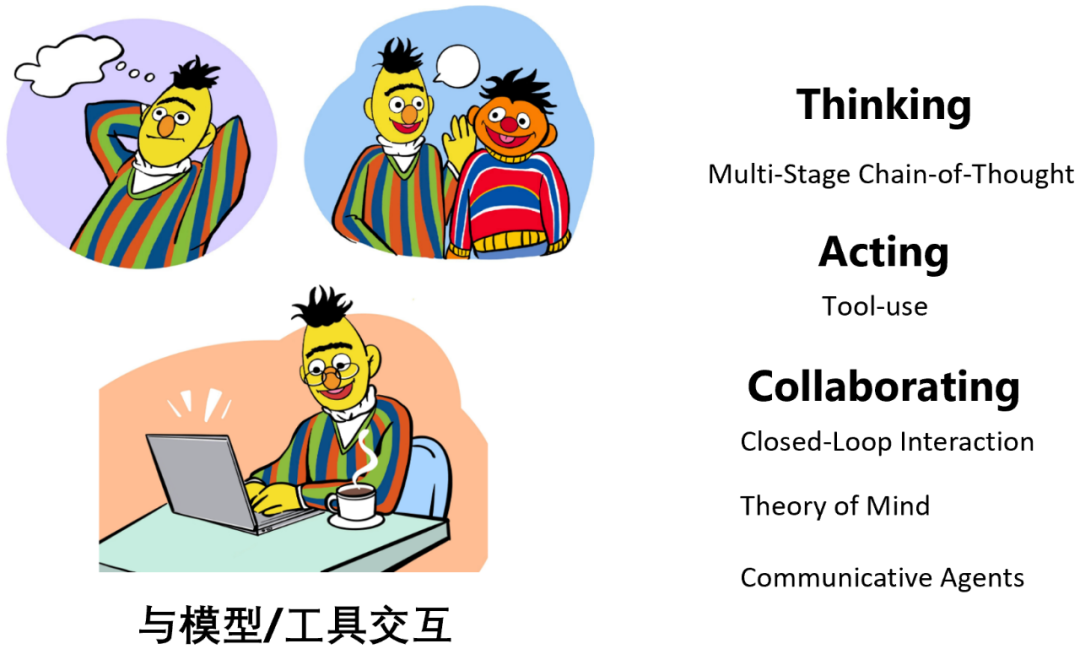

Lorsqu'un modèle de langage interagit avec un modèle ou un outil, il existe trois types d'opérations :

- Penser : le modèle interagit avec lui-même pour effectuer une décomposition et un raisonnement des tâches

- Agir : le modèle appelle ; d'autres modèles, ou outils externes, etc., aident au raisonnement ou ont des effets réels sur le monde extérieur ;

- Collaboration : plusieurs agents modèles de langage communiquent et collaborent entre eux pour accomplir des tâches spécifiques ou simuler le comportement social humain.

Remarque : La réflexion parle principalement de la "Chaîne de pensée à plusieurs étapes", c'est-à-dire : différentes étapes de raisonnement, correspondant à différents appels du modèle de langage (exécution de modèles multiples), au lieu d'exécuter le modèle une seule fois. et la sortie pensée+réponse (exécution d'un modèle unique) comme Vanilla CoT [17]

Cette partie hérite de la méthode d'expression de ReAct [18].

Le travail typique sur la réflexion comprend ReAct [18], Least-to-Most Prompting [19], Self-Ask [20], etc. Par exemple, Least-to-Most Prompting [19] décompose d'abord un problème complexe en plusieurs sous-problèmes de modules simples, puis appelle de manière itérative le modèle de langage pour les résoudre un par un.

Les travaux typiques sur Acting incluent ReAct [18], HuggingGPT [21], Toolformer [22], etc. Par exemple, Toolformer [22] traite le corpus de pré-formation du modèle de langage dans un formulaire avec une invite d'utilisation d'outil. Par conséquent, le modèle de langage formé peut automatiquement appeler le bon outil au bon moment lors de la génération de texte. tels que les moteurs de recherche, les outils de traduction, les outils de gestion du temps, les calculatrices, etc.) résolvent des sous-problèmes spécifiques.

La collaboration comprend principalement :

- Interaction en boucle fermée : comme les modèles socratiques [ 23] etc. , grâce à l'interaction en boucle fermée de grands modèles de langage, de modèles de langage visuel et de modèles de langage audio, certaines tâches complexes d'assurance qualité spécifiques à l'environnement visuel peuvent être réalisées.

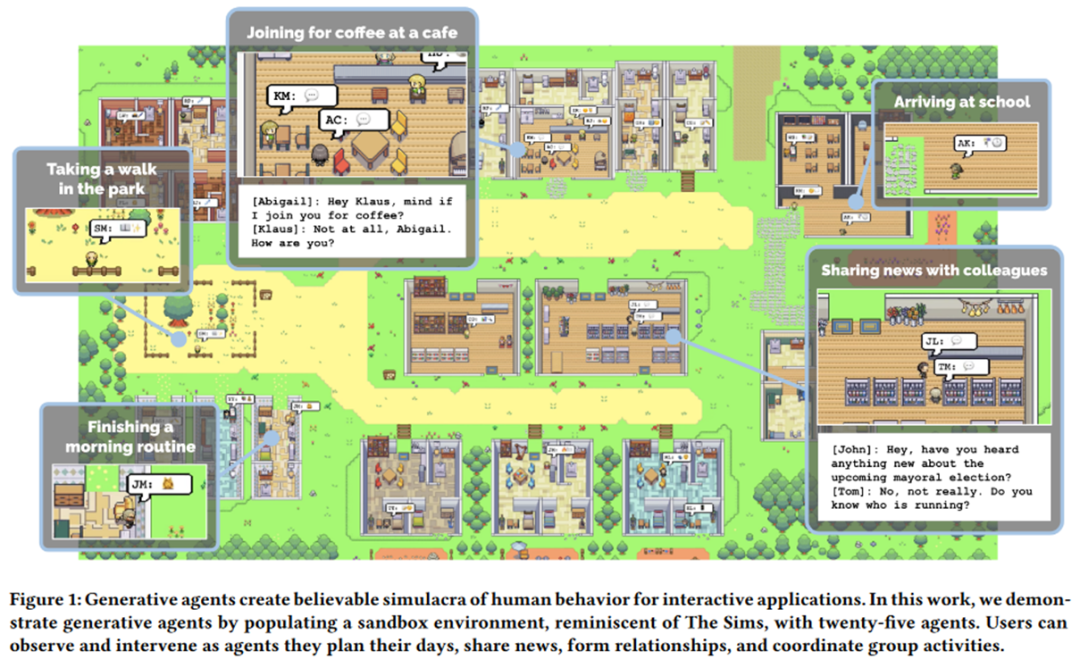

- Théorie de l'esprit : vise à permettre à un agent de comprendre et de prédire l'état d'un autre agent afin de promouvoir une interaction efficace entre eux. Par exemple, l'article exceptionnel de l'EMNLP 2021, MindCraft [24], donne à deux modèles de langage différents des compétences différentes mais complémentaires, leur permettant de collaborer pour accomplir des tâches spécifiques dans le monde MineCraft pendant le processus de communication. Le célèbre professeur Graham Neubig a également récemment accordé une grande attention à cette direction de recherche, comme [25]. L'exemple le plus typique est celui des Agents Génératifs [26] de l'Université de Stanford qui a récemment choqué le monde : en construisant un environnement bac à sable et en permettant à de nombreux agents intelligents injectés d'« âmes » provenant de grands modèles de s'y déplacer librement, ils peuvent spontanément présenter des apparences humaines. Les comportements sociaux, comme discuter et dire bonjour, ont une saveur « du monde occidental » (comme indiqué ci-dessous). De plus, l'ouvrage le plus célèbre est le nouvel ouvrage CAMEL [27] de l'auteur de DeepGCN, qui permet à deux agents habilités par de grands modèles de développer des jeux et même de stocker des actions en train de communiquer entre eux sans nécessiter trop d'intervention humaine. . L'auteur met clairement en avant le concept de « Large Model Society » (LLM Society) dans l'article.

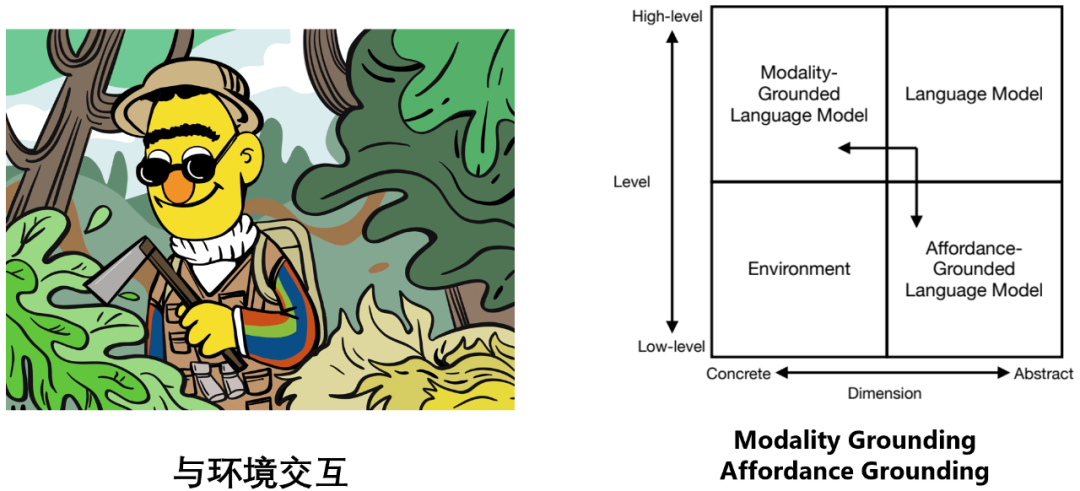

Interagir avec l'environnement

#🎜 🎜 #Les modèles et environnements linguistiques appartiennent à deux quadrants différents : les modèles linguistiques sont construits sur des symboles textuels abstraits et sont bons pour le raisonnement, la planification et la prise de décision de haut niveau. , etc. tâches ; tandis que l'environnement est basé sur des signaux sensoriels spécifiques (tels que des informations visuelles, des informations auditives, etc.), simulant ou se produisant naturellement certaines tâches de bas niveau, telles que l'observation, la rétroaction et la transition d'état). etc. (par exemple : une pomme tombe au sol dans le monde réel, et un « creeper » apparaît devant vous dans le moteur de simulation).

Par conséquent, pour permettre au modèle de langage d'interagir de manière efficace et efficiente avec l'environnement, il comprend principalement deux aspects d'effort : # 🎜 🎜#

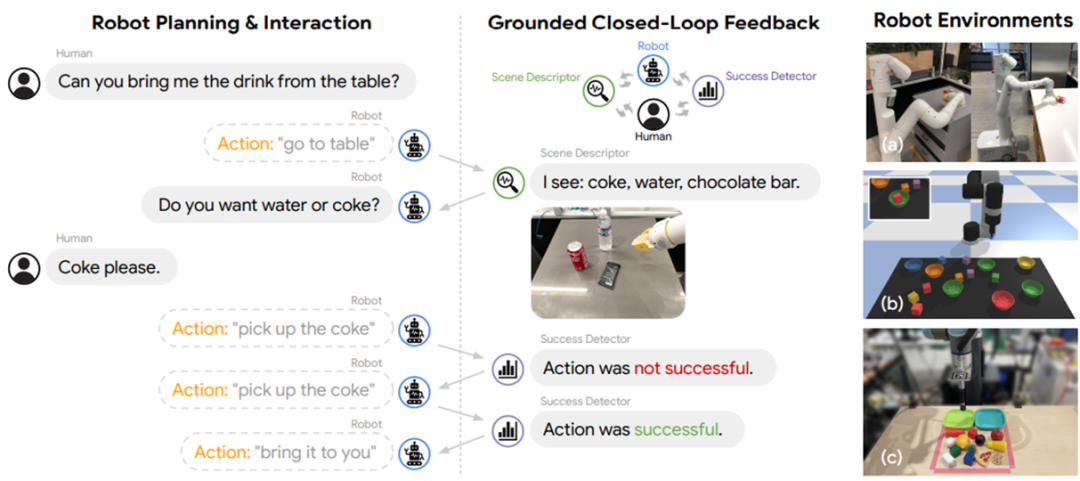

Modality Grounding : permet au modèle de langage de traiter des informations multimodales telles que des images et de l'audio ; Effectuer des actions possibles et appropriées sur des objets possibles et appropriés à l'échelle de la scène spécifique de l'environnement.

- Le modèle le plus typique du Modality Grounding est le modèle de langage visuel. D'une manière générale, cela peut être réalisé en utilisant un modèle à tour unique tel que OFA [28], un modèle à deux tours tel que BridgeTower [29], ou l'interaction d'un modèle de langage et d'un modèle visuel tel que BLIP-2 [30]. Aucun détail supplémentaire ne sera donné ici, les lecteurs peuvent se référer à cet article pour plus de détails.

- Il y a deux considérations principales pour Affordance Grounding, à savoir : comment effectuer (1) la perception à l'échelle de la scène (perception à l'échelle de la scène) dans les conditions d'une tâche donnée , et (2) les actions possibles. Par exemple :

Par exemple, dans la scène de l'image ci-dessus, les tâches données "Veuillez éteindre les lumières du salon" et "Perception de l'échelle de la scène" nous obligent à trouver toutes les lumières avec des cases rouges au lieu des lumières qui sont pas dans le salon mais dans la cuisine avec des boîtes vertes. Les « actions possibles » nous obligent à déterminer les moyens réalisables pour éteindre les lumières. Par exemple, tirer un cordon lumineux nécessite une action de « tirer » et allumer la lumière. et l'arrêt nécessite une action "interrupteur à bascule".

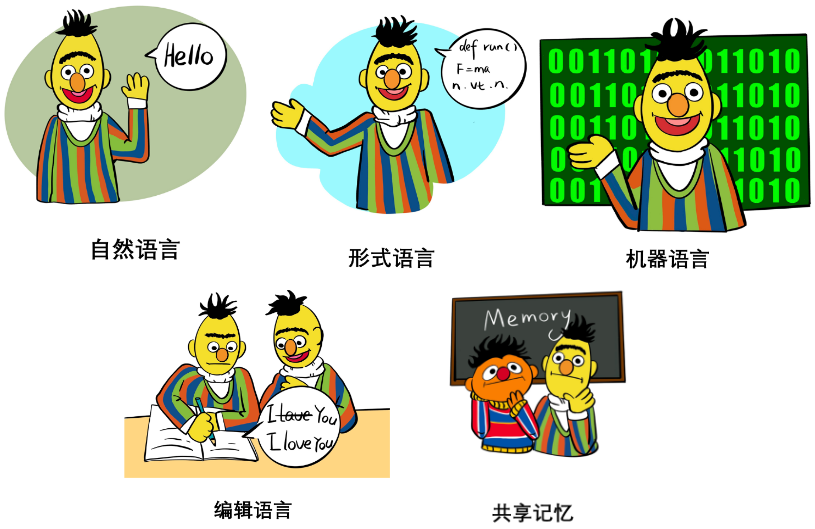

De manière générale, l'Affordance Grounding peut être résolu en utilisant une fonction de valeur qui dépend de l'environnement, telle que SayCan [31], etc., ou un modèle de mise à la terre spécialisé tel que Grounded Decoding [32] peut être utilisé. Il peut même être résolu en interagissant avec des personnes, des modèles, des outils, etc. (comme indiqué ci-dessous). Dans le chapitre Interface d'interaction, les auteurs discutent systématiquement des différents langages d'interaction, des interactions L'utilisation, les avantages et les inconvénients des médias, notamment :

Langage formel : tel que le code, la grammaire, les formules mathématiques, etc. Ses caractéristiques et fonctions en termes d’analyse et de capacité de raisonnement sont principalement discutées.

Langage machine : tels que les invites logicielles, les jetons visuels discrétisés, etc. Ses caractéristiques et fonctions en généralisation, théorie des goulots d'étranglement de l'information, efficacité des interactions, etc. sont principalement discutées.Édition : elle comprend principalement des opérations telles que la suppression, l'insertion, le remplacement et la conservation de texte. Ses principes, son histoire, ses avantages et ses limites actuelles sont discutés.

Mémoire partagée : elle comprend principalement la mémoire dure et la mémoire logicielle. La première enregistre l'état historique dans un journal sous forme de mémoire, et la seconde utilise un module externe de mémoire lisible et inscriptible pour enregistrer les tenseurs. L'article discute des caractéristiques, des fonctions et des limites des deux.

- Comment interagir : méthodes d'interaction

- Le document aborde également de manière complète, détaillée et systématique diverses méthodes d'interaction, notamment :

- Invitation : sans ajuster les paramètres du modèle, le modèle de langage est appelé uniquement via une ingénierie rapide, couvrant l'apprentissage en contexte, la chaîne de pensée, l'utilisation des outils, le niveau. Diverses méthodes telles que le chaînage d'invites sont discutées en détail. Les principes et les fonctions. , diverses astuces et limites de diverses techniques d'invite sont discutées en détail, telles que les considérations de contrôlabilité et de robustesse.

- Réglage fin : ajustez les paramètres du modèle pour permettre au modèle d'apprendre et de se mettre à jour à partir d'informations interactives. Cette section couvre des méthodes telles que le réglage des instructions supervisé, le réglage fin efficace des paramètres, l'apprentissage continu et le réglage fin semi-supervisé. Les principes, fonctions, avantages, considérations liées à une utilisation spécifique et limites de ces méthodes sont discutés en détail. Il comprend également une partie de l'édition des connaissances (c'est-à-dire l'édition des connaissances à l'intérieur du modèle).

- Active Learning : cadre d'algorithme d'apprentissage actif interactif.

- Apprentissage par renforcement : cadre d'algorithme d'apprentissage par renforcement interactif, discute du cadre d'apprentissage par renforcement en ligne, du cadre d'apprentissage par renforcement hors ligne, de l'apprentissage à partir des commentaires humains (RLHF), de l'apprentissage à partir des commentaires sur l'environnement (RLEF), de l'apprentissage à partir des commentaires de l'IA (RLAIF) et bien d'autres. méthodes.

- Apprentissage par imitation : un cadre d'algorithme d'apprentissage par imitation interactif qui traite de l'apprentissage par imitation en ligne, de l'apprentissage par imitation hors ligne, etc.

- Fusion des messages d'interaction : fournit un cadre unifié pour toutes les méthodes d'interaction ci-dessus, en même temps, dans ce cadre, il s'étend vers l'extérieur et discute de différents schémas de fusion de connaissances et d'informations, tels que le schéma de fusion d'attention croisée). schéma de fusion de décodage contraint (décodage contraint), etc.

Autres discussions

Limité par l'espace, cet article ne détaille pas les discussions sur d'autres aspects, tels que l'évaluation, l'application, l'éthique, la sécurité et les orientations de développement futures. Cependant, ces contenus occupent toujours 15 pages dans le texte original de l'article, il est donc recommandé aux lecteurs de consulter plus de détails dans le texte original. Voici un aperçu de ces contenus :

Commentaires sur l'interaction.

La discussion sur l'évaluation dans l'article implique principalement les mots-clés suivants :

Principales applications de la PNL interactive

- Génération de texte contrôlable

- Interaction avec personnes : phénomène d'impression de pensée du RLHF, etc.

- Interaction avec les connaissances : réglage fin axé sur les connaissances [34], etc. Avec l'interaction avec l'environnement : mise à la terre des moyens, etc.

- Enrichissement de contenu : riche en contenu

- Co-création de contenu : création de contenu

- IA incorporée

- Observation et manipulation : bases

- Navigation et exploration : avancé ( par exemple, tâches incarnées à long horizon)

- Tâches multi-rôles : avancées

- Jeu (jeu de texte)

- Plateformes de jeux interactifs contenant du texte : plates-formes de jeux de texte interactifs

- Comment les modèles de langage interactifs jouent à des jeux de texte uniquement : jouer à des jeux de texte uniquement

- Comment les modèles de langage interactifs renforcent jeux contenant des médias textuels : Powering Text-Aided Games

- Autres applications

- Champs, spécialisation des tâches (Spécialisation) : Par exemple, comment créer en fonction d'une interaction spécifique au domaine financier, au domaine médical, etc. modèle de langage cadre.

- Personnalisation et personnalité : par exemple, comment créer un modèle de langage spécifique à l'utilisateur ou ayant une personnalité spécifique basée sur l'interaction.

- Évaluation basée sur un modèle

- Alignement : le problème d'alignement des modèles de langage, comment rendre la sortie du modèle plus inoffensive, plus cohérente avec les valeurs humaines, plus raisonnable, etc. .

- Incarnation sociale : le problème fondamental des modèles de langage, comment promouvoir davantage l'incarnation et la socialisation des modèles de langage.

- Plasticité : La question de la plasticité des modèles de langage, comment assurer la mise à jour continue des connaissances du modèle sans oublier les connaissances précédemment acquises lors du processus de mise à jour.

- Vitesse et efficacité : problèmes tels que la vitesse d'inférence et l'efficacité de la formation des modèles de langage, comment accélérer l'inférence sans affecter les performances et l'efficacité de la formation accélérée.

- Longueur du contexte : la limite de taille de la fenêtre contextuelle du modèle de langage. Comment agrandir la taille de la fenêtre du contexte afin qu'elle puisse gérer un texte plus long.

- Génération de texte long : problème de génération de texte long du modèle de langage. Comment faire en sorte que le modèle de langage conserve d'excellentes performances dans des scénarios de génération de texte extrêmement longs.

- Accessibilité : problèmes d'utilisabilité des modèles de langage. Comment créer des modèles de langage de source fermée à open source, et comment permettre le déploiement de modèles de langage sur des appareils de pointe tels que les systèmes de véhicules et les ordinateurs portables sans perte excessive de performances.

- Analyse : Analyse du modèle linguistique, interprétabilité et autres problèmes. Par exemple, comment prédire les performances du modèle après mise à l'échelle pour guider le développement de grands modèles, comment expliquer le mécanisme interne des grands modèles, etc.

- Créativité : Enjeux créatifs dans les modèles de langage. Comment rendre les modèles de langage plus créatifs, mieux capables d'utiliser des métaphores, des métaphores, etc., et de créer de nouvelles connaissances, etc.

- Évaluation : Comment mieux évaluer les grands modèles généraux, comment évaluer les caractéristiques interactives des modèles de langage, etc.

Éthique et sécurité

discute de l'impact des modèles de langage interactifs sur l'éducation et aborde également les préjugés sociaux, la confidentialité et d'autres questions d'éthique en matière de sécurité.

Orientations et défis futurs du développement

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un