Périphériques technologiques

Périphériques technologiques

IA

IA

Explorez ThinkGPT : la bibliothèque Python de pointe qui transforme l'IA en puissantes machines à penser

Explorez ThinkGPT : la bibliothèque Python de pointe qui transforme l'IA en puissantes machines à penser

Explorez ThinkGPT : la bibliothèque Python de pointe qui transforme l'IA en puissantes machines à penser

ThinkGPT est une bibliothèque Python innovante qui donne accès à de grands modèles de langage afin qu'ils puissent penser, raisonner et agir plus efficacement. Si vous souhaitez intégrer ThinkGPT dans vos scripts Python et profiter de ses fonctionnalités avancées, veuillez lire cet article. Cet article vous guidera à travers les premières étapes d'utilisation de ThinkGPT dans votre projet Python.

Nous explorerons les fonctionnalités principales de ThinkGPT, y compris ses capacités de mémoire avancées, ses mécanismes d'auto-amélioration et ses capacités de raisonnement d'ordre élevé. Vous pourrez découvrir comment cette bibliothèque innovante change le paysage du développement de l'IA et apprendre à exploiter sa puissance pour améliorer vos propres projets.

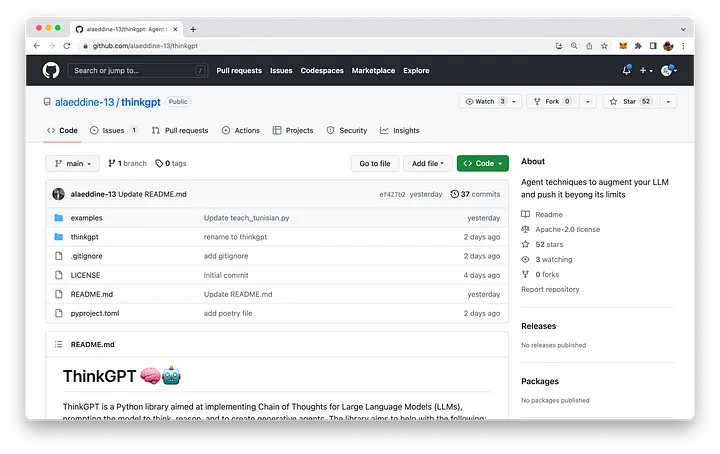

ThinkGPT est hébergé sur GitHub. La base de code peut être trouvée à l'adresse : https://github.com/alaeddine-13/thinkgpt.

Principales fonctionnalités de ThinkGPT

- Mémoire : ThinkGPT permet aux grands modèles de langage (LLM) de mémoriser les expériences et apprendre de nouvelles notions.

- Auto-amélioration : Cette fonctionnalité permet au modèle d'améliorer le contenu généré en répondant aux critiques, en résolvant les problèmes et en affinant sa compréhension.

- Abstraction : LLM est encouragé à généraliser les règles à partir d'exemples ou d'observations, aidant ainsi à créer des connaissances compressées qui correspondent mieux à la longueur limitée du contexte du modèle.

- Inférence : permet à LLM de faire des suppositions éclairées sur la base des informations disponibles.

- Conditions du langage naturel : les utilisateurs peuvent facilement exprimer des tâches et des conditions en langage naturel, permettant aux modèles de prendre des décisions intelligentes.

- Installation facile et API Pythonique : Grâce à DocArray, ThinkGPT propose un processus de configuration extrêmement simple et une API Pythonique.

Installation

L'installation de ThinkGPT est simple et peut être installée à l'aide de pip :

pip install git+https://github.com/alaeddine-13/thinkgpt.git

Cette commande s'installera directement à partir du code GitHub bibliothèque de référentiel ThinkGPT.

La première étape de l'utilisation de ThinkGPT dans les scripts Python

Une fois l'installation terminée, vous pouvez commencer à utiliser ThinkGPT dans les scripts Python. Pour ce faire, importez simplement la classe ThinkGPT depuis le module thinkgpt.llm et créez une nouvelle instance de la classe :

from thinkgpt.llm import ThinkGPT llm = ThinkGPT(model_name="gpt-3.5-turbo")

Cet extrait de code utilise le modèle spécifié (dans ce cas, initialisez une nouvelle instance ThinkGPT pour "gpt-3.5-turbo").

Avec une instance ThinkGPT, vous pouvez désormais utiliser la méthode memorize() pour enseigner de nouveaux concepts ou faits à votre modèle d'IA :

llm.memorize(['DocArray is a library for representing, sending, and storing multi-modal data.'])

Pour rappeler des informations mémorisées, vous pouvez utiliser le Méthode Remember() :

memory = llm.remember('DocArray definition')Une fois que le modèle d'IA a appris certaines informations, vous pouvez utiliser la méthode prédire() pour faire des prédictions ou répondre à des questions basées sur les données mémorisées :

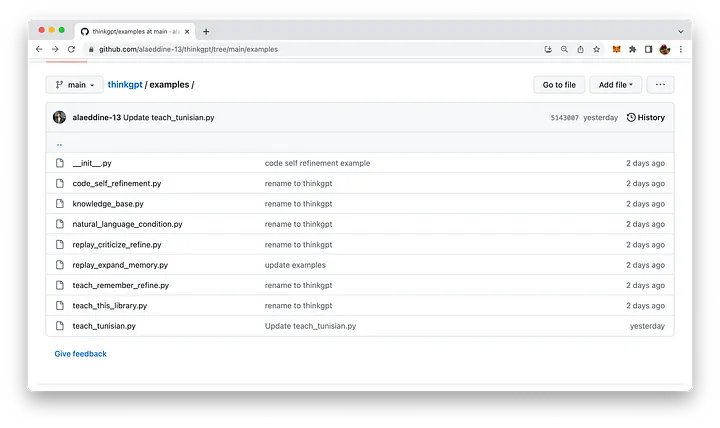

llm.predict('what is DocArray ?', remember=memory)this L'extrait de code utilise la méthode Remember() pour récupérer les informations de mémoire et les renvoie à la méthode Predict() pour répondre à la question. ThinkGPT est livré avec des exemples d'utilisation faciles à comprendre. Le script Python correspondant se trouve dans le dossier exemple de la base de code :

Plongeons dans l'un des exemples fournis : replay_expand_memory .py :

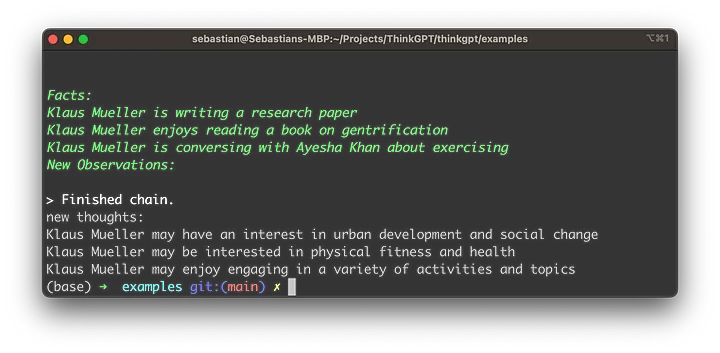

from thinkgpt.llm import ThinkGPT llm = ThinkGPT(model_name="gpt-3.5-turbo") # 加载旧内存 old_memory = [ "Klaus Mueller is writing a research paper", "Klaus Mueller enjoys reading a book on gentrification", "Klaus Mueller is conversing with Ayesha Khan about exercising" ] # 教给LLM旧的记忆 llm.memorize(old_memory) # 在旧记忆的基础上诱发反思 new_observations = llm.infer(facts=llm.remember()) print('new thoughts:') print('\n'.join(new_observations)) llm.memorize(new_observations)- Définissez la variable old_memory, qui contient trois déclarations sur Klaus Mueller, représentant les connaissances antérieures.

- Utilisez la méthode memorize() pour enseigner à un grand modèle de langage (LLM) les informations stockées dans old_memory.

- Appelez la méthode infer() et définissez le paramètre faits sur le résultat de la méthode Remember(). Cela demande à LLM d'induire de nouvelles observations ou pensées basées sur des informations précédemment mémorisées.

- Les observations nouvellement induites sont envoyées à la console sous la balise « nouvelles pensées : ».

- Enfin, la méthode memorize() est à nouveau appelée pour stocker les nouvelles observations dans la mémoire de LLM, lui permettant ainsi de mieux comprendre Klaus Mueller lors des interactions futures.

- Avant d'exécuter le script et de visualiser les résultats, nous devons obtenir la clé API OpenAI et définir la valeur clé de la variable d'environnement correspondante OPENAI_API_KEY.

- Pour obtenir une clé API OpenAI, suivez ces étapes simples :

- 请访问OpenAI网站https://www.openai.com/。

- 如果没有帐户,请注册一个帐户。在首页右上角点击“注册”,并按照注册流程操作。

- 注册或登录后,通过点击页面顶部的“API”或访问https://www.openai.com/api/来导航到API部分。

- 查看可用的API定价计划,并选择适合你需求的计划。某些计划可能提供带有有限使用的免费访问权限,而其他计划根据你的要求和预算提供不同级别的访问权限。

- 选择一个计划后,将提供你的唯一API密钥。请确保保密,因为它授予你的账户使用限制和特权的API访问权限。 在命令行中使用以下命令来设置OpenAI API密钥:

export OPENAI_API_KEY="YOUR OPENAI API KEY"

现在我们已经准备好执行脚本了,只需输入以下命令:

python replay_expand_memory.py

然后,你应该能够看到类似于以下的结果:

总结

ThinkGPT是一款强大的Python库,它通过添加先进的记忆、自我完善、抽象和推理功能,增强了大型语言模型的能力。它对用户友好的安装过程和Pythonic API使它成为许多AI项目的有价值的补充。通过探索本文提供的实际示例,你可以利用ThinkGPT的能力,彻底改变你的AI思考方式、得出结论和采取行动的方式。

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L'IA bouleverse la recherche mathématique ! Le lauréat de la médaille Fields et mathématicien sino-américain a dirigé 11 articles les mieux classés | Aimé par Terence Tao

Apr 09, 2024 am 11:52 AM

L’IA change effectivement les mathématiques. Récemment, Tao Zhexuan, qui a prêté une attention particulière à cette question, a transmis le dernier numéro du « Bulletin de l'American Mathematical Society » (Bulletin de l'American Mathematical Society). En se concentrant sur le thème « Les machines changeront-elles les mathématiques ? », de nombreux mathématiciens ont exprimé leurs opinions. L'ensemble du processus a été plein d'étincelles, intense et passionnant. L'auteur dispose d'une équipe solide, comprenant Akshay Venkatesh, lauréat de la médaille Fields, le mathématicien chinois Zheng Lejun, l'informaticien de l'Université de New York Ernest Davis et de nombreux autres universitaires bien connus du secteur. Le monde de l’IA a radicalement changé. Vous savez, bon nombre de ces articles ont été soumis il y a un an.

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Google est ravi : les performances de JAX surpassent Pytorch et TensorFlow ! Cela pourrait devenir le choix le plus rapide pour la formation à l'inférence GPU

Apr 01, 2024 pm 07:46 PM

Les performances de JAX, promu par Google, ont dépassé celles de Pytorch et TensorFlow lors de récents tests de référence, se classant au premier rang sur 7 indicateurs. Et le test n’a pas été fait sur le TPU présentant les meilleures performances JAX. Bien que parmi les développeurs, Pytorch soit toujours plus populaire que Tensorflow. Mais à l’avenir, des modèles plus volumineux seront peut-être formés et exécutés sur la base de la plate-forme JAX. Modèles Récemment, l'équipe Keras a comparé trois backends (TensorFlow, JAX, PyTorch) avec l'implémentation native de PyTorch et Keras2 avec TensorFlow. Premièrement, ils sélectionnent un ensemble de

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Nouveaux travaux sur la prédiction de séries chronologiques + grand modèle NLP : générer automatiquement des invites implicites pour la prédiction de séries chronologiques

Mar 18, 2024 am 09:20 AM

Nouveaux travaux sur la prédiction de séries chronologiques + grand modèle NLP : générer automatiquement des invites implicites pour la prédiction de séries chronologiques

Mar 18, 2024 am 09:20 AM

Aujourd'hui, j'aimerais partager un travail de recherche récent de l'Université du Connecticut qui propose une méthode pour aligner les données de séries chronologiques avec de grands modèles de traitement du langage naturel (NLP) sur l'espace latent afin d'améliorer les performances de prévision des séries chronologiques. La clé de cette méthode consiste à utiliser des indices spatiaux latents (invites) pour améliorer la précision des prévisions de séries chronologiques. Titre de l'article : S2IP-LLM : SemanticSpaceInformedPromptLearningwithLLMforTimeSeriesForecasting Adresse de téléchargement : https://arxiv.org/pdf/2403.05798v1.pdf 1. Modèle de fond de problème important

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.