Du « Hey Siri » au Metaverse, jusqu'où Apple doit-il aller ?

Dans la vague actuelle de science et de technologie, le concept du Metaverse attire l'attention du monde comme une nouvelle étoile éblouissante avec son imagination et ses possibilités infinies. L’énorme potentiel de développement a attiré des vagues d’entreprises, les unes après les autres, pour se lancer dans le Metaverse.

Parmi ces entreprises, Apple est celle qui a les attentes les plus élevées. Le 6 juin, après sept ans de préparation, Apple a finalement dévoilé officiellement son visiocasque Vision Pro à la WWDC 2023.

Dans un sens, jusqu'où Apple peut aller dans le domaine des appareils XR représente jusqu'où peut aller la frontière technologique actuelle. Cependant, à en juger par la situation actuelle, même si les produits Apple fonctionnent bien à bien des égards, ils sont encore loin des attentes des gens. À partir de nombreuses conceptions et indicateurs, nous pouvons voir les goulots d'étranglement techniques actuels et certains compromis qu'Apple doit faire. Plus important encore, le prix final de Vision Pro s'élève à 3 499 $ US (environ 24 860 RMB). Ce prix signifie que ce produit doit être un « jouet » de niche et ne peut pas entrer dans les foyers des gens ordinaires.

Cours de l'action Apple

Cours de l'action Apple

Alors, à quelle distance sommes-nous du monde idéal du métaverse, et quels problèmes et défis techniques doivent encore être résolus ? Afin de répondre à cette question, Dataman a interviewé Lin Shun, PDG de Cocos, Li Jie, fondateur et PDG de DataMesh, Zhang Xuebing, PDG de Youli Technology, Liang Feng, directeur technique de Yuntian Best-seller, Chen Guo, directeur général adjoint du centre de R&D technologique d'AsiaInfo, Lin Yu, directeur des produits de Mo Universe. et de nombreux autres experts du secteur comprennent les tendances de développement de diverses technologies clés du métaverse. Ensuite, nous combinerons les derniers produits d’affichage de tête XR d’Apple pour explorer en profondeur les dernières tendances de développement et les défis existants dans les quatre domaines technologiques clés que sont l’affichage à proximité, le rendu informatique + le réseau privé 5G, l’interaction perceptuelle et la production de contenu.

Affichage à proximité : le parcours technique du panneau d'affichage est clair et le guide d'ondes optique n'a pas encore touché la "porte"

L'affichage à proximité est la première porte vers le monde du métaverse. À en juger par les produits lancés par Apple cette fois, son Vision Pro est équipé de 12 caméras et d'un écran Micro OLED avec 23 millions de pixels. dépasser ceux des téléviseurs 4K, permettant la visualisation sur un écran de 100 pouces et prenant en charge la visualisation de vidéos 3D. Ceci est considéré comme le niveau le plus élevé actuellement atteint.

Photo du produit Apple Vision Pro

Photo du produit Apple Vision Pro

Alors, quelles sont les technologies clés pour l’ensemble de l’affichage de proximité et quels sont les progrès actuels de l’industrie ? Dans la réalisation du Metaverse, la technologie d’affichage à proximité de l’œil est la clé des avancées matérielles. Il se compose principalement de deux parties : un panneau d'affichage et un système optique (notamment un guide d'onde optique). Ces deux voies techniques présentent encore de nombreuses difficultés techniques à surmonter.

1. Le panneau d'affichage détermine la résolution, la saturation des couleurs et le taux de rafraîchissement. MicroLED a de grands espoirs.

Le panneau d'affichage est un élément important de la technologie d'affichage à proximité de l'œil, qui affecte directement l'expérience visuelle de l'utilisateur dans le métaverse. Les principaux indicateurs techniques du panneau d'affichage incluent la résolution, la saturation des couleurs et le taux de rafraîchissement. L'amélioration de ces indicateurs peut offrir aux utilisateurs une expérience visuelle plus claire, plus riche et plus fluide.

La résolution est l'un des principaux indicateurs du panneau d'affichage, qui détermine directement la capacité d'afficher les détails du métaverse. À ce stade, l'amélioration de la résolution des panneaux se heurte à un goulot d'étranglement technique. Comment augmenter sa résolution tout en garantissant la taille du panneau et la consommation d'énergie est un problème important qui doit être résolu dans la technologie des panneaux d'affichage.

La saturation des couleurs est un autre indicateur important, qui affecte la capacité d'affichage des couleurs du métaverse. À l'heure actuelle, bien que diverses technologies d'affichage aient obtenu de bons résultats en matière d'expression des couleurs, il reste encore un certain chemin à parcourir pour obtenir des couleurs réelles dans le métaverse.

Le taux de rafraîchissement affecte l'expérience visuelle dynamique de l'utilisateur. Un taux de rafraîchissement élevé peut fournir des effets d'animation plus fluides. Cependant, l'augmentation du taux de rafraîchissement augmentera la pression sur le calcul et la consommation d'énergie. Comment réduire la consommation d'énergie tout en augmentant le taux de rafraîchissement est un autre défi technique majeur.

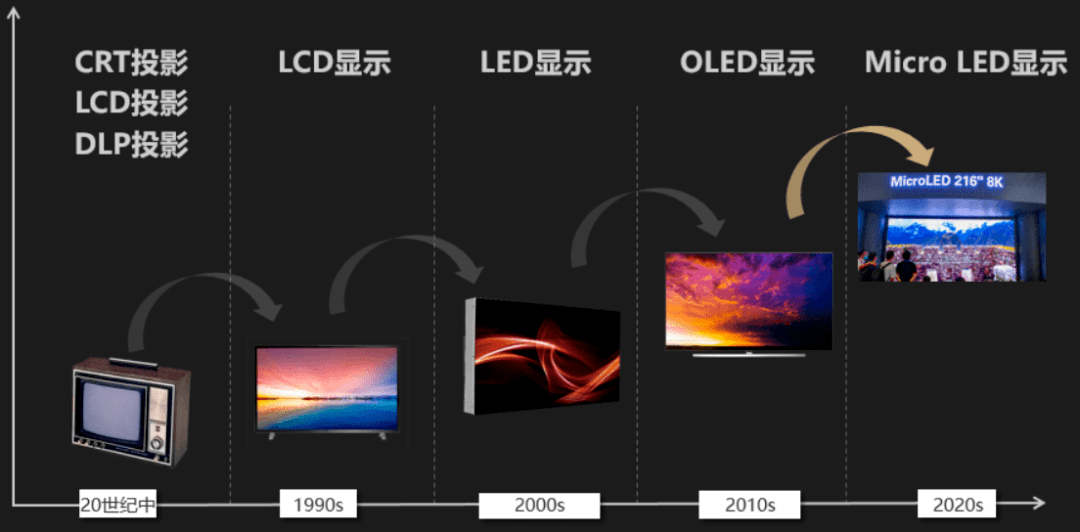

Dans le domaine des panneaux d'affichage, les principales technologies actuelles comprennent l'affichage à cristaux liquides (LCD), la diode électroluminescente organique (OLED) et la micro-LED (Micro-LED). Bien que la technologie LCD soit relativement mature et peu coûteuse, elle est déficiente par rapport aux autres technologies en termes de saturation des couleurs, de contraste et de taux de rafraîchissement, tandis que les écrans OLED doivent résoudre des problèmes de durée de vie et de coût.

Processus de développement des panneaux d'affichage

Processus de développement des panneaux d'affichage

Ces dernières années, la technologie d'affichage MicroLED a reçu une large attention de la part de l'industrie pour ses excellentes performances. Il utilise des LED de niveau micronique comme pixels, ce qui offre non seulement une résolution plus élevée, une gamme de couleurs plus large et un taux de rafraîchissement plus élevé, mais présente également une consommation d'énergie inférieure et une durée de vie plus longue. Cependant, la fabrication de panneaux MicroLED est difficile et coûteuse, en particulier lorsque la taille des pixels est petite et la densité de pixels élevée. Comment parvenir à une production à grande échelle et à haut rendement reste un problème technique clé à résoudre. Cette fois le Vision Pro est équipé d'un écran Micro OLED, mais pour le prix de près de 25 000, je crois que cet écran Micro OLED a beaucoup « apporté ».

2. La maturité de la technologie des guides d'ondes optiques est inférieure à celle des panneaux d'affichage, et son parcours technique et son délai de percée sont incertains.

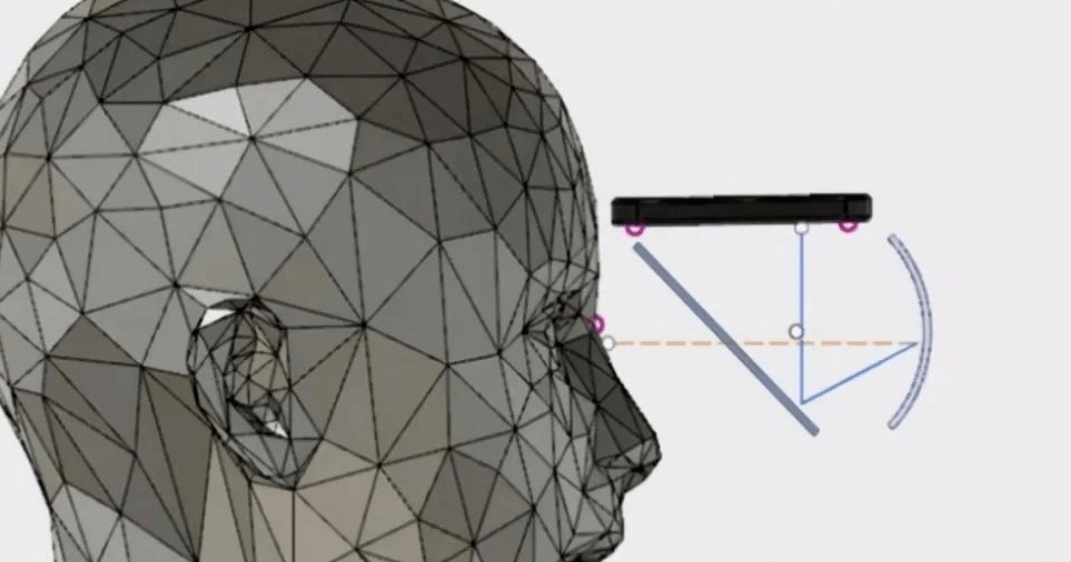

Les systèmes optiques, en particulier les guides d'ondes optiques, sont tout aussi importants pour la technologie d'affichage à proximité de l'œil. Le cœur de la technologie des guides d'ondes optiques consiste à guider la lumière vers la rétine de l'utilisateur, produisant ainsi des images virtuelles dans le champ de vision de l'utilisateur. Le champ de vision est un indicateur important pour mesurer la qualité des guides d'ondes optiques, qui affecte la portée visuelle de l'utilisateur dans le métaverse.

Dans les appareils de réalité augmentée (AR) et de réalité virtuelle (VR), les panneaux d'affichage et les guides d'ondes optiques sont souvent étroitement intégrés. Le panneau d'affichage génère des images, qui sont ensuite introduites dans des guides d'ondes optiques. Le travail du guide d'onde optique est de guider ces images vers les yeux de l'utilisateur, en effectuant éventuellement des ajustements pour améliorer l'expérience visuelle, comme élargir le champ de vision ou ajuster la mise au point de l'image. Le processus peut être simplement imaginé comme une salle de cinéma : le panneau d'affichage est comme le projecteur, qui produit l'image ; et le guide d'ondes optique est comme l'écran de projection, qui reçoit l'image produite par le projecteur et la présente au public (en dans ce cas, le public est constitué des yeux de l’utilisateur).

La technologie des guides d'ondes optiques peut être divisée en plusieurs types différents, notamment les guides d'ondes optiques diffractifs, les guides d'ondes optiques réfractifs et les guides d'ondes optiques holographiques. Parmi eux, le guide d’onde optique de diffraction est actuellement le plus couramment utilisé. Il disperse la lumière entrante sous plusieurs angles via des micro-réseaux, puis utilise la réflexion totale pour guider ces rayons vers la rétine de l'utilisateur. Cette technologie peut fournir un champ de vision plus large et une qualité d’image supérieure, mais elle pose des problèmes en termes d’efficacité lumineuse, de dispersion et de processus de fabrication complexes.

En termes d'efficacité lumineuse, le problème avec les guides d'ondes optiques diffractifs est que seule une partie de la lumière peut être utilisée efficacement et que la majeure partie de la lumière sera dispersée, ce qui entraînera un gaspillage d'énergie. En termes de dispersion, en raison de l'angle de diffraction de la lumière, la lumière de différentes couleurs produira une dispersion après avoir traversé le réseau, affectant la précision des couleurs de l'imagerie. C’est sans aucun doute un gros problème pour les applications qui recherchent un haut degré de réalisme comme le Metaverse.

De plus, la complexité du processus de fabrication se reflète dans les exigences de précision extrêmement élevées. Les micro-réseaux pour guides d'ondes optiques diffractifs doivent être précis au niveau nanométrique, ce qui entraîne des difficultés techniques et une pression sur les coûts extrêmement élevées pendant le processus de production. Pour surmonter ces problèmes, les chercheurs étudient de nouvelles technologies de guides d'ondes optiques, telles que les guides d'ondes optiques réfractifs et les guides d'ondes optiques holographiques. Ces technologies guident la lumière de différentes manières, offrant potentiellement de nouvelles solutions pour surmonter les problèmes des guides d’ondes lumineuses diffractifs. Par exemple, les guides d'ondes optiques holographiques utilisent des images holographiques pour enregistrer et reproduire le front d'onde de la lumière, ce qui peut présenter des avantages en réduisant la dispersion et en améliorant l'efficacité optique.

Cependant, la nouvelle technologie des guides d’ondes optiques présente également ses propres défis. Par exemple, bien que les guides d'ondes optiques réfractifs soient supérieurs aux guides d'ondes optiques diffractifs en termes d'efficacité optique, leur champ de vision est généralement plus petit ; tandis que les guides d'ondes optiques holographiques sont confrontés au problème de savoir comment réaliser une fabrication d'images holographiques à grande échelle et de haute qualité.

De manière générale, bien qu'il y ait encore place à l'amélioration de la technologie des panneaux d'affichage, sa feuille de route technique est relativement certaine et de nouvelles améliorations peuvent être attendues dans les prochaines années. Par rapport à la technologie des panneaux d'affichage, la technologie des guides d'ondes optiques est moins mature, et son itinéraire technique et son délai de percée sont encore incertains. Bien que les principes de base des guides d'ondes optiques aient été compris, comment concevoir et fabriquer des guides d'ondes optiques efficaces, de haute qualité et à faible coût dans des applications pratiques reste un défi technique.

Rendu informatique : GPU + cloud computing + edge computing + 5G peuvent-ils surmonter le goulot d'étranglement de la puissance de calcul ?

Le Metaverse nécessite la construction d'un environnement virtuel immersif parfaitement connecté au monde réel, et le rendu informatique est l'une des technologies clés pour atteindre cet objectif. La tâche du rendu informatique est de convertir le modèle tridimensionnel du monde virtuel et ses matériaux, éclairage et autres attributs en image bidimensionnelle vue par l'utilisateur final. Ce processus nécessite de nombreux calculs, notamment des calculs géométriques, du ray tracing, des calculs d'éclairage, du rendu des matériaux, du post-traitement, etc.

Afin d'améliorer la puissance de calcul de l'appareil, le Vision Pro d'Apple adopte une conception à double puce, comprenant une puce M2 de niveau Mac et une puce de traitement de capteur en temps réel R1. Parmi eux, la puce R1 est principalement responsable de la transmission et du traitement du signal du capteur.

Apple peut concevoir des puces spéciales pour ses propres appareils XR, mais si l'on considère l'ensemble du secteur, quelle puissance de calcul est nécessaire pour obtenir les résultats souhaités ? Nous discuterons ensuite de cette question plus en profondeur.

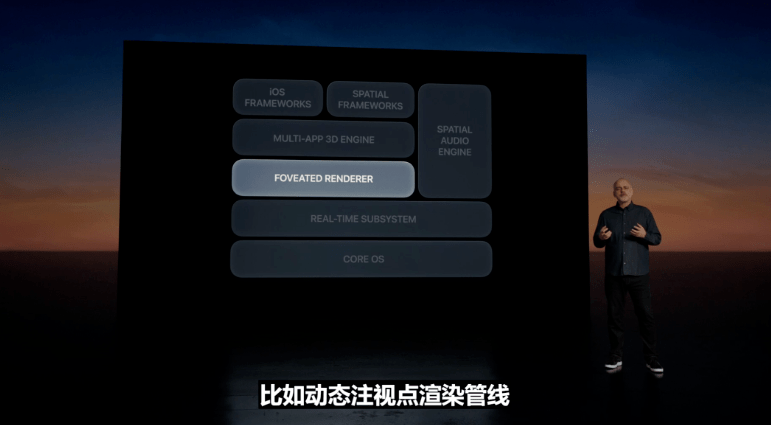

1. Pour mieux réaliser la scène métaverse idéale, chaque appareil XR doit disposer d'au moins un GPU NVIDIA A100.

L'état idéal est d'obtenir un rendu de traçage de rayons complet en temps réel, haute résolution et à fréquence d'images élevée, ce qui nécessite une puissance de calcul extrêmement élevée. Les exigences spécifiques en matière de puissance de calcul dépendent de nombreux facteurs, tels que la complexité du rendu, la résolution, la fréquence d'images, la qualité de l'image, etc. Il existe actuellement certaines technologies permettant de réduire la quantité de calculs. La technologie typique est la technologie de rendu du point de regard. Cette technologie utilise les caractéristiques visuelles de l'œil humain pour effectuer uniquement un rendu de haute précision sur le point de regard et ses zones environnantes, tout en effectuant un rendu faible. -rendu de précision dans d'autres domaines, réduisant efficacement la complexité de la tâche de rendu. Le Vision Pro publié par Apple utilise cette fois la technologie de rendu dynamique à fovéation pour fournir avec précision la qualité d'image maximale à chaque image regardée par les yeux de l'utilisateur.

Présentation du produit Apple Vision Pro

En général, la demande du Metaverse en matière de rendu informatique dépasse de loin les capacités de la technologie existante. En particulier sur les appareils mobiles, il est plus difficile de fournir de la puissance de calcul en raison de problèmes tels que la consommation électrique et la dissipation thermique. Le traitement des données 3D nécessite non seulement une grande quantité de ressources informatiques, mais nécessite également un retour d'information en temps réel ou quasi réel. Cela impose des exigences extrêmement élevées en matière de puissance de calcul et de latence. Les appareils informatiques existants, notamment les GPU et les puces IA de pointe, ne peuvent pas encore répondre pleinement à ces besoins.

Afin d'expliquer plus clairement « l'écart » entre l'offre de puissance de calcul et la demande de puissance de calcul dans le Metaverse, analysons l'offre et la demande de puissance de calcul avec un scénario typique.

Supposons que nous souhaitions obtenir un rendu de traçage de rayons complet avec une résolution 4K (c'est-à-dire 3 840 x 2 160 pixels), 60 images/seconde et un suivi de 100 rayons par pixel. Le traitement d'un rayon nécessite environ 500 opérations en virgule flottante (les données réelles peuvent nécessiter plus).

Ensuite, la puissance de calcul requise = 3 840 pixels x 2 160 pixels x 60 images/seconde x 100 rayons/pixel x 500 opérations à virgule flottante/rayon = 4 976 640 000 000 opérations à virgule flottante/seconde = 25 TFLOPS.

Il convient de noter qu'il s'agit d'une estimation très approximative et que la puissance de calcul réelle requise peut être plus élevée, car dans le rendu par lancer de rayons, en plus du lancer de rayons, il existe de nombreux autres types de calculs, tels que l'ombrage, l'échantillonnage de texture, Transformations géométriques, etc.

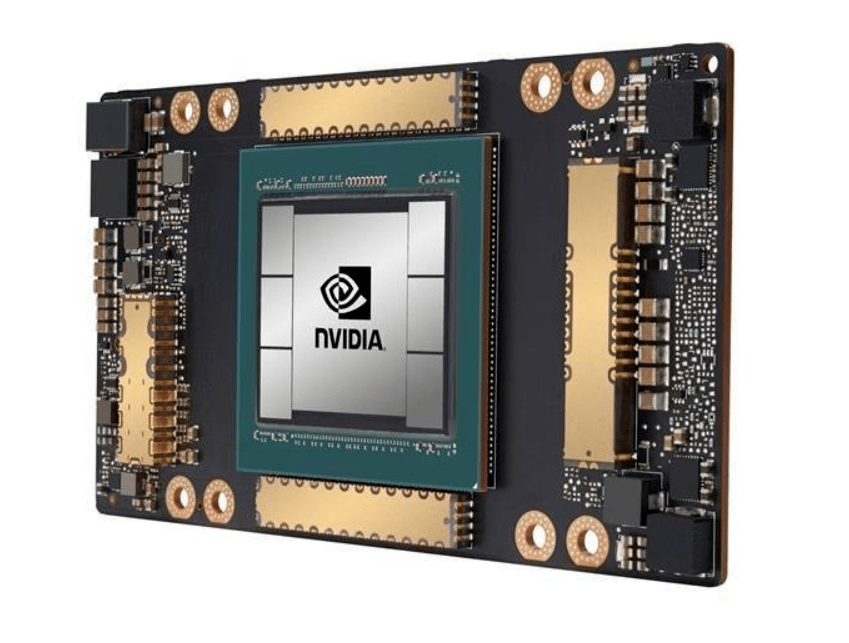

La puissance de calcul maximale de la puce haut de gamme A100 de NVIDIA est de 19,5TFLOPS. Le prix du NVIDIA A100 40G sur JD.com dépasse 60 000 yuans. En d’autres termes, pour obtenir un effet de rendu de scène métaverse idéal, un appareil nécessite au moins une puce A100. Le coût d'une seule puce dépasse 60 000 yuans, le prix de l'équipement XR sera donc encore plus élevé. Au-delà des autres limitations techniques, le prix de cet appareil suffit à dissuader la plupart des consommateurs.

Puce NVIDIA A100

Puce NVIDIA A100

En plus d'améliorer les performances générales du GPU, Matériel dédié au lancer de rayons + optimisation de logiciels spécialisés semble être un moyen important d'améliorer les performances de calcul des applications Metaverse. Pour les applications Metaverse, le lancer de rayons est une tâche informatique importante, c'est pourquoi du matériel de traçage de rayons spécialisé peut être conçu. Un exemple est la série de GPU RTX de NVIDIA, qui comprend des cœurs RT dédiés pour accélérer les calculs de lancer de rayons. Ce type de matériel peut effectuer directement certaines opérations gourmandes en calcul au niveau matériel, telles que le calcul des points d'intersection entre la lumière et les objets de la scène, améliorant ainsi considérablement l'efficacité du calcul. L'optimisation du logiciel de traçage de rayons comprend de meilleurs algorithmes de tri de rayons, des structures de division spatiale plus efficaces, etc.

Actuellement, le calcul et le rendu du métaverse ne peuvent pas être effectués sans le GPU, et il existe deux sources principales de puissance de calcul du GPU, l'une est le GPU local et l'autre est le GPU cloud. Les GPU locaux sont principalement utilisés pour les scènes nécessitant un rendu en temps réel, telles que les jeux et les appareils AR/VR. Le GPU dans le cloud peut être utilisé pour des tâches de rendu plus complexes, telles que les effets spéciaux de films, la visualisation architecturale, etc. Les résultats du rendu dans le cloud sont transmis à l'appareil de l'utilisateur via le réseau.

La solution de rendu informatique idéale devrait être un système de rendu hybride qui intègre les ressources locales et cloud. Ce système devrait être capable de décider intelligemment s'il faut effectuer des tâches de rendu localement ou dans le cloud, et comment attribuer les tâches en fonction de la nature de la tâche, des conditions du réseau, des performances de l'appareil et d'autres facteurs. En outre, ce système devrait également prendre en charge diverses technologies de rendu, telles que le lancer de rayons, l'éclairage en temps réel, l'éclairage global, etc., afin que la technologie de rendu appropriée puisse être sélectionnée en fonction des besoins.

Pour atteindre cet objectif, la transmission de données à haut débit doit être réalisée localement et dans le cloud (ou en périphérie). Alors, quelle est la vitesse Internet requise pour répondre aux exigences du Metaverse ?

2. La 5G est à peine suffisante, mais les progrès de la construction du réseau 5G ne sont pas comme prévu.

Prenons comme exemple les exigences typiques de puissance de calcul du Metaverse ci-dessus (résolution 4K, 60 images/seconde, rendu de traçage de rayons complet avec 100 rayons suivis par pixel) pour voir comment nous pouvons utiliser le cloud (edge) + l'informatique finale Schéma de rendu, comment une grande bande passante réseau est requise.

Si nous simplifions les informations de couleur de chaque pixel à 24 bits (8 bits rouge, 8 bits vert, 8 bits bleu), pour calculer la bande passante réseau requise :

3 840 pixels * 2 160 pixels * 24 bits/pixel * 60 images/seconde = 11 943 936 000 bits = 11,92 Gbit/s.

Le débit de données maximal d'un réseau 5G peut théoriquement atteindre 20 Gbit/s, mais il s'agit de la vitesse maximale dans un environnement de laboratoire idéal. En utilisation réelle, les utilisateurs peuvent généralement s'attendre à des vitesses comprises entre 100 Mbps et 3 Gbps, ce qui est encore loin des exigences réseau du Metaverse. Même le meilleur réseau 5G est à peine utilisable.

Il convient de souligner que même en Chine, qui possède le plus grand nombre de stations de base 5G au monde, les progrès de la construction du réseau 5G ne sont pas très rapides. Selon les calculs, si l’on veut construire un bon réseau 5G, il faut au moins 10 millions de stations de base 5G. Fin février 2023, le nombre total de stations de base 5G dans mon pays atteignait 2,384 millions, et il faudra plusieurs années pour dépasser les 10 millions. En d’autres termes, en termes de construction de réseau, nous ne sommes pas encore prêts pour le Metaverse.

De toute évidence, il existe actuellement des goulots d'étranglement en termes de puissance de calcul et de réseau. Alors, comment briser ce goulot d’étranglement ? À cette fin, Dataman a interrogé plusieurs experts du secteur.

Quant à la question « GPU + cloud computing + edge computing sont-ils la clé d'or pour soulager le goulot d'étranglement de la puissance de calcul du métaverse ? », Zhang Xuebing, PDG de Youli Technology, estime que la collaboration cloud-edge n'est pas un bon moyen de résoudre le problème de la puissance de calcul, " En centralisant la logique de rendu côté serveur, le rendu dans le cloud ne réduit que les problèmes de rendu d'un petit nombre de terminaux sur une période de temps spécifique. La tendance de développement des terminaux est que les configurations sont de plus en plus élevées et plus haut, la puissance de calcul devient plus forte et les ressources de rendu dans le cloud s'accumulent. C'est inefficace du point de vue des coûts et de la concurrence, et cela gaspille la puissance de calcul des appareils locaux. Le rendu de la puissance de calcul local n'a besoin que de résoudre le problème local. goulot d'étranglement de la capacité de rendu pour résoudre plusieurs problèmes de concurrence, tandis que le rendu cloud + edge computing + GPU, mais doit résoudre de nombreux problèmes tels que la concurrence des serveurs, l'équilibrage de charge, la bande passante du réseau de streaming vidéo et les goulots d'étranglement de puissance du cloud computing. le goulot d'étranglement est résolu grâce à l'algorithme de rendu, toute construction de rendu dans le cloud deviendra une chose du passé. Zhang Xuebing a présenté qu'Unitech peut utiliser la puissance de calcul locale pour résoudre le problème de rendu à distance de données tridimensionnelles en ligne massives grâce à sa technologie de rendu en streaming originale développée au niveau national, et ne nécessite pas de cartes graphiques haut de gamme via le rendu CPU, dépassant ainsi le niveau élevé. le coût et les données du rendu cloud. Les faibles goulots d'étranglement de concurrence ont résolu divers problèmes qui ne peuvent pas être résolus dans la logique de rendu cloud traditionnelle.

Liang Feng, le directeur technique le plus vendu de Yuntian, estime qu'à l'ère de la 5G, les scénarios d'applications émergents avec interaction en temps réel et réponse rapide, tels que les jeux cloud et le métaverse, ont connu une croissance exponentielle de la demande de puissance de calcul, en particulier l'intégration accélérée de L'IA et le métaverse, ainsi que le passage progressif du pouvoir du To B au To C, ont laissé une énorme marge de développement de la puissance de calcul si nous voulons véritablement réaliser des applications commerciales à grande échelle et offrir aux utilisateurs une faible latence et une immersion. expérience, la puissance de calcul actuelle est loin d'être suffisante. Avec ses capacités de calcul parallèles uniques et puissantes, le GPU est progressivement devenu une direction importante pour le marché pour explorer et prendre en charge la base de puissance de calcul des scénarios d'applications émergents. L'informatique fournit de nouvelles idées pour la commercialisation à grande échelle d'applications émergentes. L'intégration du cloud et du réseau pour créer un réseau informatique à couverture mondiale est en train de devenir une tendance de développement de l'industrie.Chen Guo, directeur général adjoint du centre de R&D technologique AsiaInfo, partage le même point de vue : « si nous voulons atteindre l'état idéal du métaverse, les ressources informatiques existantes sont loin d'être suffisantes - un rendu visuel ultime, en temps réel. interaction virtuelle et réelle, précise Le raisonnement intelligent met en avant des exigences extrêmement élevées en matière de ressources de puissance de calcul. La future collaboration multi-informatique « cloud-edge-end » répondra mieux aux besoins de puissance de calcul du métaverse en même temps, GPU et. d'autres technologies connexes élimineront également le goulot d'étranglement de la puissance de calcul du Metaverse. La clé - la puissance de calcul du GPU accélère le rendu graphique et fournit des capacités de simulation physique, promouvant la technologie XR pour répondre à l'expérience immersive requise par la technologie AIGC offrant une efficacité élevée ; - des moyens techniques précis et peu coûteux pour construire des scènes Metaverse, favorisant la modélisation rapide de « personnes, lieux et biens » ; le développement de la technologie WebGPU rend possible de véritables applications interactives 3D haute fidélité, ce qui sera grandement améliorez les performances graphiques du navigateur et éliminez le besoin de futures applications Metaverse.

Interaction perceptuelle : la capture interne est le moyen d'interaction le plus naturel dans le métaverseL'interaction perceptuelle est un autre défi majeur dans la construction du métaverse. Pour créer une expérience véritablement immersive, il est nécessaire de garantir que les utilisateurs puissent interagir avec le métaverse de manière naturelle et intuitive, ce qui nécessite de couvrir plusieurs dimensions sensorielles telles que la vue, l'ouïe et le toucher.

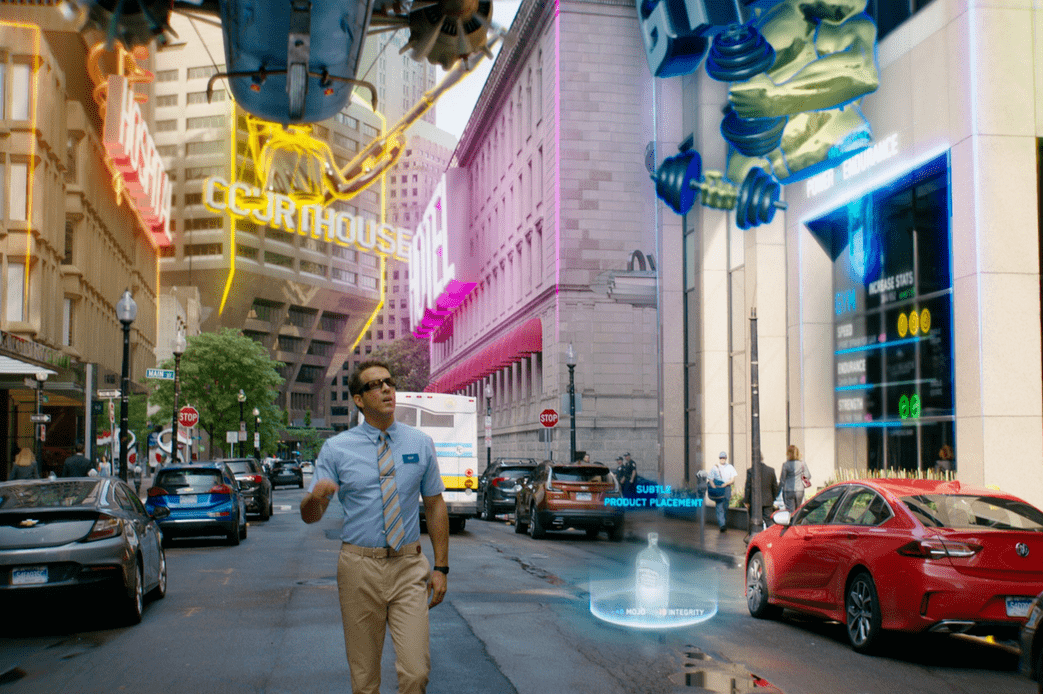

En regardant le produit Vision Pro d’Apple, il utilise une combinaison d’interaction vocale œil-main + les multiples méthodes d’interaction d’Eesight. Il est à noter que Vision Pro n'est pas équipé de poignée, ce qui est très différent des précédents produits XR.

Photo de démonstration du produit Apple Vision Pro

Vision Pro fonctionne grâce à la voix, au suivi oculaire et aux gestes. Les utilisateurs peuvent parcourir les icônes d'application en les regardant, appuyer sur leurs mains pour sélectionner, faire glisser pour faire défiler ou émettre des commandes vocales.

Photo de démonstration du produit Apple Vision Pro

Photo de démonstration du produit Apple Vision Pro

Il convient de souligner que Vision Pro est encore un produit « à terme » et ne sera officiellement lancé qu'au début de l'année prochaine. Par conséquent, il faudra attendre que le produit soit officiellement lancé et que les utilisateurs puissent avoir une réelle perception après l'avoir expérimenté, quelles fonctions peuvent être implémentées dans la vidéo de démonstration et quelle est leur efficacité.

Pour l'interaction perceptuelle, Apple n'a pas divulgué beaucoup de détails techniques. Ensuite, nous analysons les principaux aspects techniques de l’interaction perceptuelle du point de vue de l’industrie. De manière générale, les méthodes d'interaction perceptuelle des appareils XR peuvent être divisées en interaction visuelle, interaction auditive, interaction tactile et interaction gestuelle.

L'interaction visuelle repose principalement sur les technologies de réalité virtuelle (VR) et de réalité augmentée (AR). Il existe déjà des appareils VR et AR matures qui permettent aux utilisateurs de se déplacer et d'observer dans le métaverse à la première personne. Cependant, ces appareils nécessitent souvent le port d’un casque, ce qui pose des défis en termes de confort d’utilisation et d’utilisation à long terme. De plus, comment fournir une résolution visuelle et un champ de vision suffisants pour que les utilisateurs se sentent aussi naturels et réels que dans le monde réel constitue également un défi technique important.

L'interaction auditive repose sur la technologie audio 3D, notamment l'audio spatial et l'audio des objets. Ces technologies créent un champ sonore avec profondeur et direction, permettant aux utilisateurs de déterminer avec précision la source et la distance des sons. Cependant, la technologie audio 3D actuelle est encore difficile à offrir une expérience d’écoute complètement naturelle, notamment lors de la simulation d’environnements sonores complexes et d’effets physiques sonores.

L'interaction tactile est l'un des plus grands défis. Bien qu'il existe divers dispositifs de retour tactile, tels que des poignées vibrantes et des combinaisons haptiques, la puissance et la précision du retour de ces dispositifs ne peuvent pas satisfaire l'expérience tactile du monde réel. Des technologies plus avancées, telles que la stimulation électrique et le retour tactile ultrasonique, sont en cours de développement mais ne sont pas encore matures.

Par rapport aux méthodes ci-dessus, l'interaction gestuelle, en tant que moyen d'interaction intuitif et naturel, est considérée comme un moyen d'interaction idéal dans le métaverse.

Il existe deux liens fondamentaux dans l'interaction gestuelle : la capture et l'analyse. La capture fait référence à la collecte d'informations sur les mouvements de la main de l'utilisateur via diverses technologies, tandis que l'analyse traite ces informations pour identifier des gestes et des mouvements spécifiques.

La technologie de capture est principalement divisée en capture externe et capture interne. La capture externe repose souvent sur des caméras ou des capteurs pour enregistrer la position et le mouvement de la main, comme c'est le cas avec Kinect et Leap Motion de Microsoft. La capture interne utilise des appareils portables, généralement équipés d'une série de capteurs, tels que des accéléromètres, des gyroscopes, des magnétomètres, etc., capables de capturer le déplacement, la rotation et l'accélération de la main dans trois dimensions spatiales.

On peut dire que la capture interne est le moyen d'interaction le plus idéal. Capture interne Étant donné que le capteur est en contact direct avec la main, les informations sur les mouvements de la main peuvent être obtenues de manière stable et précise, quels que soient l'environnement ou les conditions d'éclairage dans lesquels se trouve l'utilisateur. De plus, les dispositifs de capture internes sont généralement petits et faciles à porter, permettant aux utilisateurs d'interagir avec des gestes à tout moment et en tout lieu. Les plus grandes difficultés techniques de la capture interne sont la précision du capteur et les capacités complexes de reconnaissance des gestes. Le mouvement de la main est très complexe. Pour le capturer avec précision et le convertir en mouvements virtuels en temps réel, des exigences élevées sont imposées à la précision et à la vitesse de traitement du capteur. Actuellement, même si la capture interne permet de capturer correctement les mouvements de base de la main, les gestes plus complexes, tels que les minuscules mouvements des doigts, peuvent être difficiles à identifier avec précision. Si le problème de la reconnaissance de haute précision de gestes complexes peut être résolu, la capture interne sera la méthode d'interaction la plus idéale dans le métaverse.

En termes de technologie d'analyse, elle s'appuie principalement sur des algorithmes de vision par ordinateur et d'apprentissage automatique. La vision par ordinateur est utilisée pour traiter des images ou des vidéos obtenues à partir d’appareils de capture afin d’extraire les points clés et les contours de la main. Des algorithmes de machine learning, notamment de deep learning, sont utilisés pour analyser ces données et identifier des gestes spécifiques. En termes de technologie d’analyse, les algorithmes actuels s’appuient principalement sur l’apprentissage profond, qui nécessite une grande quantité de données annotées pour l’entraînement. Cependant, obtenir et étiqueter ces données est très difficile en raison de la complexité et de la diversité des mains.

En plus de la capture et de l'analyse, il y a un autre problème qui doit être résolu : l'interaction avec les objets virtuels, comment permettre aux utilisateurs de saisir, déplacer et manipuler des objets par des gestes dans l'environnement virtuel, et comment fournir aux utilisateurs un retour tactile, tout doit être résolu. Une méthode possible consiste à utiliser un modèle de main virtuelle pour convertir les gestes de l'utilisateur en mouvements de la main virtuelle, puis à laisser la main virtuelle actionner des objets virtuels. Dans le même temps, des technologies de retour tactile plus efficaces, telles que la stimulation électrique et les ultrasons, doivent être étudiées pour fournir aux utilisateurs un retour tactile.

On constate qu'il reste encore une série de problèmes techniques à résoudre en termes d'interaction perceptuelle.

Production de contenu : ChatGPT et AIGC sont devenus la clé pour créer des PNJ intelligents

Apple maîtrise parfaitement la création d'un écosystème de contenu. Lors de cette conférence de lancement de Vision Pro, Apple a également annoncé quelques progrès dans la construction de contenu. Par exemple, Complete HeartX crée un cœur 3D interactif ; JigSpace permet aux concepteurs de revoir visuellement leurs ébauches de conception de courses de F1.

Photo de présentation du produit Vision Pro

Photo de présentation du produit Vision Pro

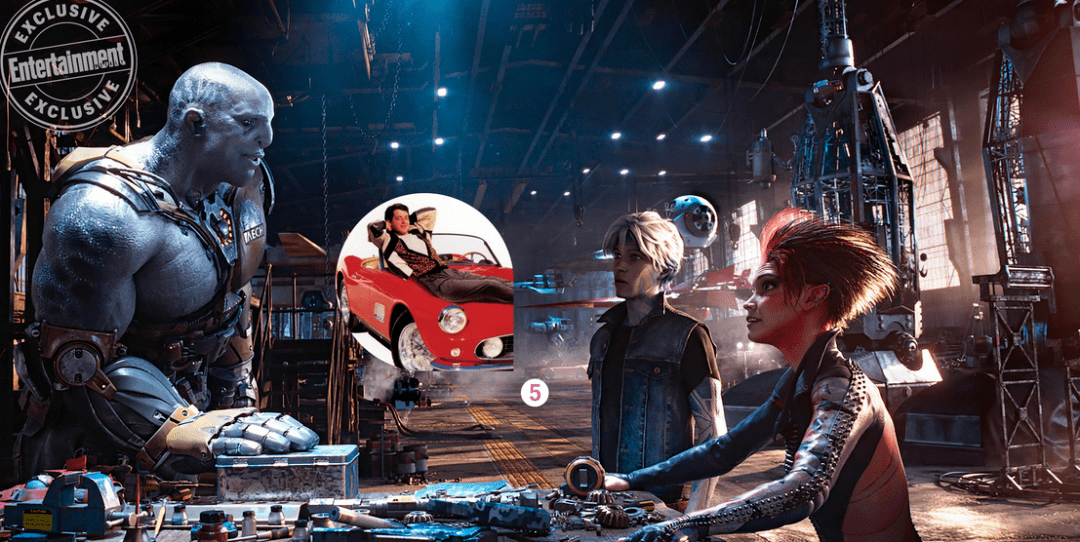

Il convient de souligner que certaines des capacités de production de contenu démontrées par Apple sont encore loin de notre métaverse de contenu idéal. Ce que nous voulons, c'est un métaverse comme "Ready Player One" ou "Runaway Player", et pas seulement de belles "expositions" 3D. Afin d’atteindre cet objectif, nous devons explorer la logique profonde de la production de contenu métaverse.

Dans le métaverse, l'environnement, les représentations virtuelles de personnes et les personnages non-joueurs (PNJ) constituent le contenu principal de ce monde virtuel. Ces trois éléments construisent ensemble la vision du monde et l’histoire du métaverse. L'environnement fournit le contexte physique et culturel du monde virtuel et définit les règles et le fonctionnement du monde virtuel. C'est le fondement du monde virtuel et constitue la dimension spatiale du métaverse. Le représentant virtuel d'une personne, ou personnage de joueur, est l'identité de l'utilisateur et son acteur dans le monde virtuel. Il s'agit d'un outil permettant aux utilisateurs de participer et d'expérimenter le monde virtuel, reflétant leurs souhaits et leurs comportements.

Idéalement, les PNJ peuvent fournir divers personnages et scénarios pour le monde virtuel, enrichissant ainsi le contenu et l'expérience du monde virtuel. Ils sont des moteurs d'activité dans le monde virtuel et peuvent aider les utilisateurs à mieux participer et comprendre le monde virtuel. La plasticité et la créativité des PNJ rendent le scénario du Metaverse possible à l'infini. En interagissant avec les PNJ, les utilisateurs peuvent vivre une variété d'histoires et d'aventures dans le Metaverse. Les représentants virtuels des humains dans le métaverse peuvent obtenir des « privilèges » ou des capacités spéciaux grâce à l'interaction avec les PNJ. Ce « privilège » peut aider les utilisateurs à atteindre leurs objectifs dans le monde virtuel et à améliorer leur identité et leur statut dans le monde virtuel. Par conséquent, les PNJ ne sont pas seulement le moteur de l’histoire du métaverse, mais également un facteur important permettant aux utilisateurs de réussir et de se satisfaire dans le monde virtuel.

Cependant, pour atteindre les objectifs ci-dessus, les PNJ doivent avoir un niveau élevé d'intelligence, ce qui est bien au-delà de la portée des PNJ dans le métaverse actuel. Les PNJ actuels s'appuient principalement sur des dialogues et des comportements prédéfinis, ce qui peut les rendre rigides et manquer de réalisme et de personnalisation lorsqu'ils répondent aux actions des joueurs. Dans le même temps, les PNJ ont également des limites pour faire avancer les intrigues et mener des interactions continues.

Dans ce contexte, le potentiel et les avantages de l'utilisation de la technologie de l'IA, en particulier AIGC et ChatGPT, pour optimiser la production de contenu Metaverse et créer des PNJ intelligents sont particulièrement importants.

Le PDG de Cocos, Lin Shun, estime que la combinaison de l'AIGC et du Metaverse peut considérablement améliorer l'efficacité et la créativité de la génération de contenu. AIGC peut prendre en charge un travail de création de contenu lourd et répétitif, ce qui permet aux développeurs d'économiser du temps et de l'énergie tout en proposant un contenu de jeu plus diversifié et plus riche. Grâce à la technologie d'AIGC, des mondes et des scènes peuvent être générés automatiquement, accélérant le processus de création de contenu du métavers, rendant le monde du métavers plus coloré et répondant aux besoins de diverses formes. Par exemple : en générant automatiquement des tâches et des intrigues pour rendre le contenu du métaverse plus vivant et intéressant ; en générant automatiquement des conceptions de PNJ et de personnages, AIGC peut aider les développeurs à générer diverses images personnalisées de PNJ et de personnages, rendant les personnages du métaverse plus diversifiés et intéressants. Unique ; génère automatiquement des effets sonores et de la musique, des effets sonores réalistes et une musique dynamique, rendant la scène Metaverse plus immersive et immersive.

Lin Shun pense également que l'IA peut fournir des interactions plus réalistes et intelligentes pour les PNJ dans le métaverse. Les PNJ avec des « âmes » peuvent former un monde dynamique dans le métaverse, et les PNJ peuvent réagir en fonction des actions et des décisions du joueur. le monde du jeu plus réaliste et vivant, et favorisant le développement du monde. Ils peuvent comprendre les instructions et les émotions des joueurs grâce au traitement du langage naturel et à la technologie de reconnaissance des émotions, et réagir en conséquence, offrant ainsi une expérience de jeu plus personnalisée et plus riche. L'IA donne aux PNJ une « âme » ou une personnalité plus réaliste. Grâce à la modélisation émotionnelle et aux modèles cognitifs, l'IA peut faire en sorte que les PNJ présentent des états émotionnels, des traits de personnalité et des modèles de comportement complexes, augmentant ainsi le lien émotionnel et l'interaction entre les joueurs et les PNJ.

Lin Yu, directeur des produits de Mo Universe, a exprimé un point de vue similaire. Il estime que « l'AIGC améliorera considérablement l'efficacité de la production du métaverse dans les trois éléments fondamentaux que sont « les personnes, les objets et les scènes ». modélisation d'images humaines numériques En termes de conception, il améliore l'efficacité de la conception ; dans la construction de l'intelligence numérique du cerveau humain, il améliore considérablement le niveau d'intelligence des humains numériques. L'AIGC des images et du contenu vidéo 2D et 3D peut améliorer l'efficacité de la modélisation et conception d'objets et de scènes. Cela peut donner au PNJ un cerveau, ou « âme », et améliorer considérablement le niveau d'intelligence du PNJ. Par exemple, la question et la réponse intelligentes entre le PNJ et l'utilisateur ne sont pas seulement des questions et des réponses textuelles. , mais comprend également des questions et réponses vocales, ainsi que des informations multimodales telles que des images et des vidéos. »

Enfin, le fondateur et PDG de DataMesh, Li Jie, a mentionné que dans le domaine du métaverse d'entreprise, il existe encore un problème de « l'œuf et la poule » qui doit être résolu : un contenu de haute qualité peut attirer les utilisateurs, mais s'il n'y a pas assez d'utilisateurs, il est impossible de générer et de maintenir ce contenu de haute qualité. Il s’agit d’un problème classique d’effet de réseau.

Li Jie estime que dans le cadre du modèle TEMS (Training, Experience, Monitoring and Simulation) du métaverse d'entreprise, une façon possible de résoudre ce problème est de parcourir dans un premier temps les deux aspects de la simulation (Simulation) et de la formation (Formation) du contenu du métaverse. génération. Au début, les entreprises peuvent former et éduquer les employés internes en créant des scénarios de simulation spécifiques, qui peuvent non seulement améliorer les compétences des employés, mais également fournir des utilisateurs actifs et du contenu pour le métaverse.

Au fil du temps, à mesure que les employés s'adapteront et s'appuieront progressivement sur cette nouvelle façon de travailler, la base d'utilisateurs de l'Enterprise Metaverse augmentera, et ces utilisateurs généreront également une grande quantité de données interactives dans le Metaverse. Ces données peuvent être collectées et analysées pour optimiser davantage les fonctions d'expérience et de surveillance et de contrôle du métaverse, formant ainsi un cercle vertueux.

En parlant de l'application tueuse du Metaverse, Li Jie estime que l'application tueuse peut être une solution qui intègre parfaitement les quatre aspects de TEMS. Par exemple, une application capable de simuler des processus métier complexes en temps réel, de fournir un contenu de formation riche et personnalisé, de disposer de fonctions de surveillance et de contrôle efficaces et d'offrir une expérience utilisateur transparente et immersive pourrait être le tueur de l'application Metaverse. De telles applications peuvent non seulement améliorer considérablement l'efficacité de la production et la satisfaction professionnelle des employés, mais également promouvoir l'innovation et le développement continus de l'entreprise.

Ci-dessus, nous avons analysé certains domaines techniques et défis fondamentaux de XR et du Metaverse. Enfin, j'espère que des entreprises comme Apple pourront continuer à surmonter les goulots d'étranglement techniques et à baisser les prix le plus rapidement possible (le prix de plus de 20 000 n'est en effet pas proche des gens), afin que le métaverse coloré comme "Ready Player One" peut arriver le plus tôt possible.

Mais pour être honnête, je ne suis pas optimiste quant au casque XR sorti par Apple cette fois. Apple est une grande entreprise et ses capacités en matière de produits dans le domaine de l'électronique grand public sont également uniques au monde. Cependant, il existe encore des goulots d'étranglement techniques importants dans les secteurs des équipements XR et du Metaverse. Pour surmonter ces goulots d'étranglement, il faut des efforts de l'ensemble du secteur et il est peu probable qu'une seule entreprise puisse les surmonter. Lorsque Apple a lancé l'Iphone, ce n'est pas seulement la faute d'Apple qui a fait entrer l'humanité dans l'ère de l'Internet mobile. En fait, à cette époque, l'humanité était déjà entrée avec un pied dans l'ère de l'Internet mobile, mais les produits Apple étaient les meilleurs et ils récoltaient les plus gros fruits. Imaginez, si notre réseau est toujours bloqué en 2G ou même en 1G, l'iPhone sera-t-il toujours utile ? Apple est formidable, mais quelle que soit la grandeur d’une entreprise, il est impossible de transcender son époque.

D'un point de vue rationnel, il existe encore des défis considérables dans chacun des domaines d'affichage à proximité, de rendu informatique, d'interaction perceptuelle et de production de contenu mentionnés ci-dessus. Même s'il est aussi puissant qu'Apple, il n'a produit que le meilleur produit dans les conditions industrielles existantes, mais il est encore loin de notre idéal métaverse. Il est prévisible que lorsqu'un grand nombre d'utilisateurs expérimenteront réellement Vision Pro, ils auront probablement le sentiment qu'il présente de bonnes conceptions et des avancées par rapport aux produits XR précédents, mais dans l'ensemble, il est encore loin des attentes et comporte de nombreux « grooves ». Par exemple, selon les rapports, la batterie filaire fournie avec le Vision Pro ne peut durer que 2 heures.

Article : Yi Liao Yanyu / Data Monkey

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Tutoriel de téléchargement et d'installation de la version iOS Deepseek

Feb 19, 2025 pm 04:00 PM

Tutoriel de téléchargement et d'installation de la version iOS Deepseek

Feb 19, 2025 pm 04:00 PM

Deepseek Smart AI Téléchargement et Guide d'installation (utilisateurs d'Apple) Deepseek est un puissant outil d'IA. 1. Téléchargez et installez les étapes: ouvrez l'Appstore App Store et entrez "Deepseek" dans la barre de recherche. Vérifiez soigneusement le nom de l'application et les informations du développeur pour vous assurer que la bonne version est téléchargée. Cliquez sur le bouton "Get" sur la page Détails de l'application. Le premier téléchargement peut nécessiter une vérification du mot de passe Appleid. Une fois le téléchargement terminé, vous pouvez l'ouvrir directement. 2. Processus d'enregistrement: Trouvez le portail de connexion / enregistrement dans l'application Deepseek. Il est recommandé de s'inscrire avec un numéro de téléphone portable. Entrez votre numéro de téléphone mobile et recevez le code de vérification. Vérifiez le contrat d'utilisateur,

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé?

Feb 21, 2025 pm 10:57 PM

Pourquoi le lien d'échange de Bybit ne peut-il pas être téléchargé directement et installé? Bybit est un échange de crypto-monnaie qui fournit des services de trading aux utilisateurs. Les applications mobiles de l'échange ne peuvent pas être téléchargées directement via AppStore ou GooglePlay pour les raisons suivantes: 1. La politique de l'App Store empêche Apple et Google d'avoir des exigences strictes sur les types d'applications autorisées dans l'App Store. Les demandes d'échange de crypto-monnaie ne répondent souvent pas à ces exigences car elles impliquent des services financiers et nécessitent des réglementations et des normes de sécurité spécifiques. 2. Conformité des lois et réglementations Dans de nombreux pays, les activités liées aux transactions de crypto-monnaie sont réglementées ou restreintes. Pour se conformer à ces réglementations, l'application ByBit ne peut être utilisée que via des sites Web officiels ou d'autres canaux autorisés

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Version mobile Gateio Trading Plateforme de téléchargement Adresse de téléchargement

Feb 28, 2025 am 10:51 AM

Il est crucial de choisir un canal formel pour télécharger l'application et d'assurer la sécurité de votre compte.

Gate.io Sesame Doad Download Chinois Tutoriel

Feb 28, 2025 am 10:54 AM

Gate.io Sesame Doad Download Chinois Tutoriel

Feb 28, 2025 am 10:54 AM

Cet article vous guidera en détail sur la façon d'accéder au site officiel de Gate.io, de changer la langue chinoise, de vous inscrire ou de vous connecter à votre compte, ainsi que des procédures de téléchargement et d'utilisation de l'application mobile en option, vous aidant facilement à démarrer avec l'échange Gate.io. Pour plus de tutoriels sur l'utilisation de Gate.io en chinois, veuillez continuer à lire.

Comment trouver le lien de téléchargement de OUYI OKX Android et Apple

Feb 21, 2025 pm 05:39 PM

Comment trouver le lien de téléchargement de OUYI OKX Android et Apple

Feb 21, 2025 pm 05:39 PM

OUYI OKX est un échange de crypto-monnaie qui offre aux utilisateurs une expérience de trading sûre et pratique. Les utilisateurs peuvent télécharger les applications mobiles d'Ouyi OKX, y compris les versions Android et Apple via des canaux officiels.

Comment installer et enregistrer une application pour acheter des pièces virtuelles?

Feb 21, 2025 pm 06:00 PM

Comment installer et enregistrer une application pour acheter des pièces virtuelles?

Feb 21, 2025 pm 06:00 PM

Résumé: Cet article vise à guider les utilisateurs sur la façon d'installer et d'enregistrer une application de trading de devises virtuelles sur les appareils Apple. Apple a des réglementations strictes sur les applications de devises virtuelles, les utilisateurs doivent donc prendre des mesures spéciales pour terminer le processus d'installation. Cet article expliquera les étapes requises, y compris le téléchargement de l'application, la création d'un compte et la vérification de votre identité. Suivant le guide de cet article, les utilisateurs peuvent facilement configurer une application de trading de devises virtuelles sur leurs appareils Apple et commencer le trading.

L'impact de la mise à niveau d'Ethereum sur le prix de l'ETH: volatilité à court terme et valeur à long terme

Feb 27, 2025 pm 04:51 PM

L'impact de la mise à niveau d'Ethereum sur le prix de l'ETH: volatilité à court terme et valeur à long terme

Feb 27, 2025 pm 04:51 PM

Il existe deux aspects de la volatilité à court terme et de la valeur à long terme de l'impact de la mise à niveau d'Ethereum sur le prix de l'ETH. À court terme, les attentes du marché avant la mise à niveau affecteront la hausse des prix et la baisse, les problèmes techniques pendant le processus de mise à niveau peuvent entraîner une chute des prix, et après la mise à niveau, le phénomène de «vente d'attentes et d'achat» peut se produire. À long terme, les améliorations réussies amélioreront les performances du réseau, telles que l'augmentation du débit et la réduction des frais de transaction, et l'optimisation des modèles économiques, tels que la déflation, augmentant ainsi la rareté de l'ETH et les augmentations de prix de soutien.

Application Sesame Open Door Exchange Téléchargement officiel Sesame Open Door Exchange Téléchargement officiel

Mar 04, 2025 pm 11:54 PM

Application Sesame Open Door Exchange Téléchargement officiel Sesame Open Door Exchange Téléchargement officiel

Mar 04, 2025 pm 11:54 PM

Les étapes de téléchargement officielles de l'application Sesame Open Exchange couvrent le processus de téléchargement du système Android et iOS, ainsi que des solutions de problèmes courantes, vous aidant à télécharger en toute sécurité et rapidement et à permettre des transactions pratiques de crypto-monnaies.