développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Exemple d'analyse en composantes principales en Python

Exemple d'analyse en composantes principales en Python

Exemple d'analyse en composantes principales en Python

Exemple d'analyse en composantes principales en Python

L'analyse en composantes principales (ACP) est une méthode couramment utilisée pour la réduction de la dimensionnalité des données, qui peut réduire les données de grande dimension à de faibles dimensions, en conservant autant de données. informations de variation que possible. Python fournit de nombreuses bibliothèques et outils pour implémenter PCA. Cet article utilise un exemple pour présenter comment utiliser la bibliothèque sklearn en Python pour implémenter PCA.

Tout d'abord, nous devons préparer un ensemble de données. Cet article utilisera l'ensemble de données Iris, qui contient 150 exemples de données. Chaque échantillon a 4 valeurs de caractéristiques (la longueur et la largeur du calice, la longueur et la largeur des pétales) et une étiquette (le type de fleur d'iris). Notre objectif est de réduire la dimensionnalité de ces quatre caractéristiques et de trouver les composantes principales les plus importantes.

Tout d'abord, nous devons importer les bibliothèques et les ensembles de données nécessaires.

from sklearn.datasets import load_iris from sklearn.decomposition import PCA import matplotlib.pyplot as plt iris = load_iris() X = iris.data y = iris.target

Nous pouvons maintenant créer un objet PCA et l'appliquer.

pca = PCA(n_components=2) X_pca = pca.fit_transform(X)

L'objet PCA définit ici n_components=2, ce qui signifie que nous voulons uniquement afficher nos données traitées sur un plan bidimensionnel. Nous appliquons fit_transform aux données d'origine X et obtenons l'ensemble de données traitées X_pca.

Maintenant, nous pouvons tracer les résultats.

plt.scatter(X_pca[:, 0], X_pca[:, 1], c=y)

plt.xlabel('Component 1')

plt.ylabel('Component 2')

plt.show()Dans cette figure, nous pouvons voir la distribution de l'ensemble de données Iris dans l'espace bidimensionnel après réduction de dimensionnalité. Chaque point représente un échantillon d'une fleur d'iris et la couleur représente le type de fleur d'iris.

Voyons maintenant quels devraient être les principaux ingrédients.

print(pca.components_)

Cela produira deux vecteurs appelés "Composant 1" et "Composant 2".

[[ 0.36158968 -0.08226889 0.85657211 0.35884393]

[-0.65653988 -0.72971237 0.1757674 0.07470647]]

Chaque élément représente le poids d'une caractéristique dans les données d'origine. En d’autres termes, nous pouvons considérer les composantes principales comme des vecteurs utilisés pour combiner linéairement les caractéristiques d’origine. Chaque vecteur du résultat est un vecteur unitaire.

Nous pouvons également examiner la quantité de variance dans les données expliquée par chaque composant.

print(pca.explained_variance_ratio_)

Cette sortie affichera la proportion de la variance dans les données expliquée par chaque composant.

[0.92461621 0.05301557]

On constate que ces deux composantes expliquent au total 94% de la variance des données. Cela signifie que nous pouvons capturer les caractéristiques des données avec une grande précision.

Une chose à noter est que PCA supprimera toutes les fonctionnalités des données d'origine. Par conséquent, si nous devons conserver certaines fonctionnalités, nous devons les supprimer manuellement avant d'appliquer PCA.

Ceci est un exemple de la façon d'implémenter PCA à l'aide de la bibliothèque sklearn en Python. La PCA peut être appliquée à tous les types de données et nous aide à découvrir les composants les plus importants des données de grande dimension. Si vous comprenez le code de cet article, vous pourrez également appliquer la PCA à vos propres ensembles de données.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

Video Face Swap

Échangez les visages dans n'importe quelle vidéo sans effort grâce à notre outil d'échange de visage AI entièrement gratuit !

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Lisez des fichiers CSV et effectuez une analyse de données à l'aide de pandas

Jan 09, 2024 am 09:26 AM

Lisez des fichiers CSV et effectuez une analyse de données à l'aide de pandas

Jan 09, 2024 am 09:26 AM

Pandas est un puissant outil d'analyse de données qui peut facilement lire et traiter différents types de fichiers de données. Parmi eux, les fichiers CSV sont l’un des formats de fichiers de données les plus courants et les plus utilisés. Cet article expliquera comment utiliser Pandas pour lire des fichiers CSV et effectuer une analyse de données, et fournira des exemples de code spécifiques. 1. Importez les bibliothèques nécessaires Tout d'abord, nous devons importer la bibliothèque Pandas et les autres bibliothèques associées qui peuvent être nécessaires, comme indiqué ci-dessous : importpandasaspd 2. Lisez le fichier CSV à l'aide de Pan

Introduction aux méthodes d'analyse des données

Jan 08, 2024 am 10:22 AM

Introduction aux méthodes d'analyse des données

Jan 08, 2024 am 10:22 AM

Méthodes courantes d'analyse des données : 1. Méthode d'analyse comparative ; 2. Méthode d'analyse structurelle ; 3. Méthode d'analyse croisée ; 5. Méthode d'analyse des causes et des effets ; , Méthode d'analyse en composantes principales ; 9. Méthode d'analyse de dispersion ; 10. Méthode d'analyse matricielle. Introduction détaillée : 1. Méthode d'analyse comparative : Analyse comparative de deux ou plusieurs données pour trouver les différences et les modèles ; 2. Méthode d'analyse structurelle : Une méthode d'analyse comparative entre chaque partie de l'ensemble et l'ensemble. , etc.

Utilisation de la fonction sqrt() en Python

Feb 21, 2024 pm 03:09 PM

Utilisation de la fonction sqrt() en Python

Feb 21, 2024 pm 03:09 PM

Exemples d'utilisation et de code de la fonction sqrt() en Python 1. Fonction et introduction de la fonction sqrt() Dans la programmation Python, la fonction sqrt() est une fonction du module mathématique, et sa fonction est de calculer la racine carrée de un numéro. La racine carrée signifie qu'un nombre multiplié par lui-même est égal au carré du nombre, c'est-à-dire x*x=n, alors x est la racine carrée de n. La fonction sqrt() peut être utilisée dans le programme pour calculer la racine carrée. 2. Comment utiliser la fonction sqrt() en Python, sq

11 distributions de base que les data scientists utilisent 95 % du temps

Dec 15, 2023 am 08:21 AM

11 distributions de base que les data scientists utilisent 95 % du temps

Dec 15, 2023 am 08:21 AM

Suite au dernier inventaire des « 11 graphiques de base que les data scientists utilisent 95 % du temps », nous vous présenterons aujourd'hui 11 distributions de base que les data scientists utilisent 95 % du temps. La maîtrise de ces distributions nous aide à comprendre plus profondément la nature des données et à faire des inférences et des prédictions plus précises lors de l'analyse des données et de la prise de décision. 1. Distribution normale La distribution normale, également connue sous le nom de distribution gaussienne, est une distribution de probabilité continue. Il présente une courbe symétrique en forme de cloche avec la moyenne (μ) comme centre et l'écart type (σ) comme largeur. La distribution normale a une valeur d'application importante dans de nombreux domaines tels que les statistiques, la théorie des probabilités et l'ingénierie.

Comment faire du traitement et de la reconnaissance d'images en Python

Oct 20, 2023 pm 12:10 PM

Comment faire du traitement et de la reconnaissance d'images en Python

Oct 20, 2023 pm 12:10 PM

Comment effectuer le traitement et la reconnaissance d'images en Python Résumé : La technologie moderne a fait du traitement et de la reconnaissance d'images un outil important dans de nombreux domaines. Python est un langage de programmation facile à apprendre et à utiliser doté de riches bibliothèques de traitement et de reconnaissance d'images. Cet article expliquera comment utiliser Python pour le traitement et la reconnaissance d'images, et fournira des exemples de code spécifiques. Traitement d'image : le traitement d'image est le processus consistant à effectuer diverses opérations et transformations sur des images pour améliorer la qualité de l'image, extraire des informations des images, etc. Bibliothèque PIL en Python (Pi

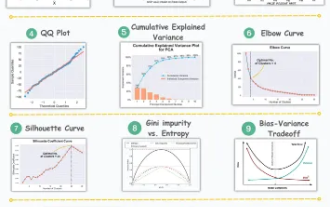

11 visualisations avancées pour l'analyse des données et l'apprentissage automatique

Oct 25, 2023 am 08:13 AM

11 visualisations avancées pour l'analyse des données et l'apprentissage automatique

Oct 25, 2023 am 08:13 AM

La visualisation est un outil puissant pour communiquer des modèles et des relations de données complexes de manière intuitive et compréhensible. Ils jouent un rôle essentiel dans l’analyse des données, fournissant des informations souvent difficiles à discerner à partir de données brutes ou de représentations numériques traditionnelles. La visualisation est cruciale pour comprendre les modèles et les relations de données complexes, et nous présenterons les 11 graphiques les plus importants et incontournables qui aident à révéler les informations contenues dans les données et à rendre les données complexes plus compréhensibles et significatives. 1. KSPlotKSPlot est utilisé pour évaluer les différences de distribution. L'idée principale est de mesurer la distance maximale entre les fonctions de distribution cumulatives (CDF) de deux distributions. Plus la distance maximale est petite, plus ils appartiennent probablement à la même distribution. Par conséquent, il est principalement interprété comme un « système » permettant de déterminer les différences de distribution.

Apprentissage automatique et analyse de données à l'aide du langage Go

Nov 30, 2023 am 08:44 AM

Apprentissage automatique et analyse de données à l'aide du langage Go

Nov 30, 2023 am 08:44 AM

Dans la société intelligente d’aujourd’hui, l’apprentissage automatique et l’analyse des données sont des outils indispensables qui peuvent aider les individus à mieux comprendre et utiliser de grandes quantités de données. Dans ces domaines, le langage Go est également devenu un langage de programmation qui a beaucoup retenu l'attention. Sa rapidité et son efficacité en font le choix de nombreux programmeurs. Cet article explique comment utiliser le langage Go pour l'apprentissage automatique et l'analyse de données. 1. L'écosystème du langage Go d'apprentissage automatique n'est pas aussi riche que Python et R. Cependant, à mesure que de plus en plus de personnes commencent à l'utiliser, certaines bibliothèques et frameworks d'apprentissage automatique

Comment utiliser les interfaces ECharts et PHP pour mettre en œuvre l'analyse des données et la prédiction de graphiques statistiques

Dec 17, 2023 am 10:26 AM

Comment utiliser les interfaces ECharts et PHP pour mettre en œuvre l'analyse des données et la prédiction de graphiques statistiques

Dec 17, 2023 am 10:26 AM

Comment utiliser les interfaces ECharts et PHP pour mettre en œuvre l'analyse des données et la prédiction des graphiques statistiques. L'analyse et la prédiction des données jouent un rôle important dans divers domaines. Elles peuvent nous aider à comprendre les tendances et les modèles de données et fournir des références pour les décisions futures. ECharts est une bibliothèque de visualisation de données open source qui fournit des composants graphiques riches et flexibles capables de charger et de traiter dynamiquement des données à l'aide de l'interface PHP. Cet article présentera la méthode de mise en œuvre de l'analyse et de la prédiction des données de graphiques statistiques basée sur ECharts et l'interface PHP, et fournira