Périphériques technologiques

Périphériques technologiques

IA

IA

Yang Likun, lauréat du prix Turing : L'IA a des capacités de raisonnement logique et de planification limitées et commettra des erreurs factuelles et logiques.

Yang Likun, lauréat du prix Turing : L'IA a des capacités de raisonnement logique et de planification limitées et commettra des erreurs factuelles et logiques.

Yang Likun, lauréat du prix Turing : L'IA a des capacités de raisonnement logique et de planification limitées et commettra des erreurs factuelles et logiques.

Produit par Sohu Technology

Auteur|Zheng Songyi

Le 9 juin, la conférence Zhiyuan sur l'intelligence artificielle 2023 s'est tenue à Pékin. A quatre heures du matin, heure locale en France, Yann LeCun, connu comme l'un des « Trois géants du Deep Learning dans le monde », a prononcé un discours sur la liaison vidéo française à Pékin sur le thème « Vers un grand modèle ». Capable d'apprendre, de raisonner et de planifier" Le discours exprimait une réflexion approfondie sur l'intelligence artificielle.

Sohu Technology a regardé ce discours lors de la conférence Zhiyuan. D'après l'expression souriante de Yang Likun pendant le discours, nous pouvons ressentir l'attitude positive et optimiste de Yang Likun envers le développement de l'intelligence artificielle. Auparavant, lorsque Musk et d'autres avaient signé une lettre commune affirmant que le développement de l'intelligence artificielle entraînerait des risques pour la civilisation humaine, Yang Likun l'avait publiquement réfuté, estimant que l'intelligence artificielle ne s'était pas encore développée au point de constituer une menace sérieuse pour l'humanité. Dans son discours, Yang Likun a une fois de plus souligné que l'intelligence artificielle est contrôlable. Il a déclaré : « La peur est causée par l'attente de résultats négatifs potentiels, tandis que l'exaltation est causée par la prédiction de résultats positifs. Je l'appelle « IA axée sur les objectifs », elle sera contrôlable car nous pouvons lui fixer des objectifs via une fonction de coût, garantissant que ces systèmes ne veulent pas conquérir le monde, mais succombent plutôt à l'humanité et à la sécurité.

Yang Likun a déclaré que l'écart entre l'intelligence artificielle et les humains et les animaux réside dans le raisonnement logique et la planification, qui sont des caractéristiques importantes de l'intelligence. Les grands modèles d'aujourd'hui ne peuvent que « réagir instinctivement ».

"Si vous les entraînez avec un billion ou deux billions de jetons, les performances de la machine sont incroyables, mais finalement la machine fera des erreurs factuelles, des erreurs logiques et leurs capacités de raisonnement sont limitées

."Yang Likun a souligné que les modèles linguistiques basés sur l'auto-supervision ne peuvent pas acquérir de connaissances sur le monde réel. Il pense que les machines ne sont pas très douées pour apprendre par rapport aux humains et aux animaux. Pendant des décennies, la manière de développer des systèmes a été d'utiliser l'apprentissage supervisé, mais l'apprentissage supervisé nécessite trop d'étiquettes, tout apprendre nécessite beaucoup d'essais et les résultats de l'apprentissage par renforcement sont insatisfaisants et font des erreurs. mal, et pas vraiment capable de raisonner ou de planifier.

"Tout comme lorsque nous prononçons un discours, la façon dont nous exprimons un point à un autre et la façon dont nous expliquons les choses est planifiée dans notre cerveau au lieu d'improviser mot par mot. Peut-être qu'à un niveau bas, nous improvisons, mais à un niveau élevé, nous devons planifier, donc le besoin de planification est très évident. Ma prédiction est que dans un laps de temps relativement court, les personnes sensées n'utiliseront certainement pas d'éléments autorégressifs (l'un des modèles de ceux-ci). les systèmes seront bientôt abandonnés car irréparables. »

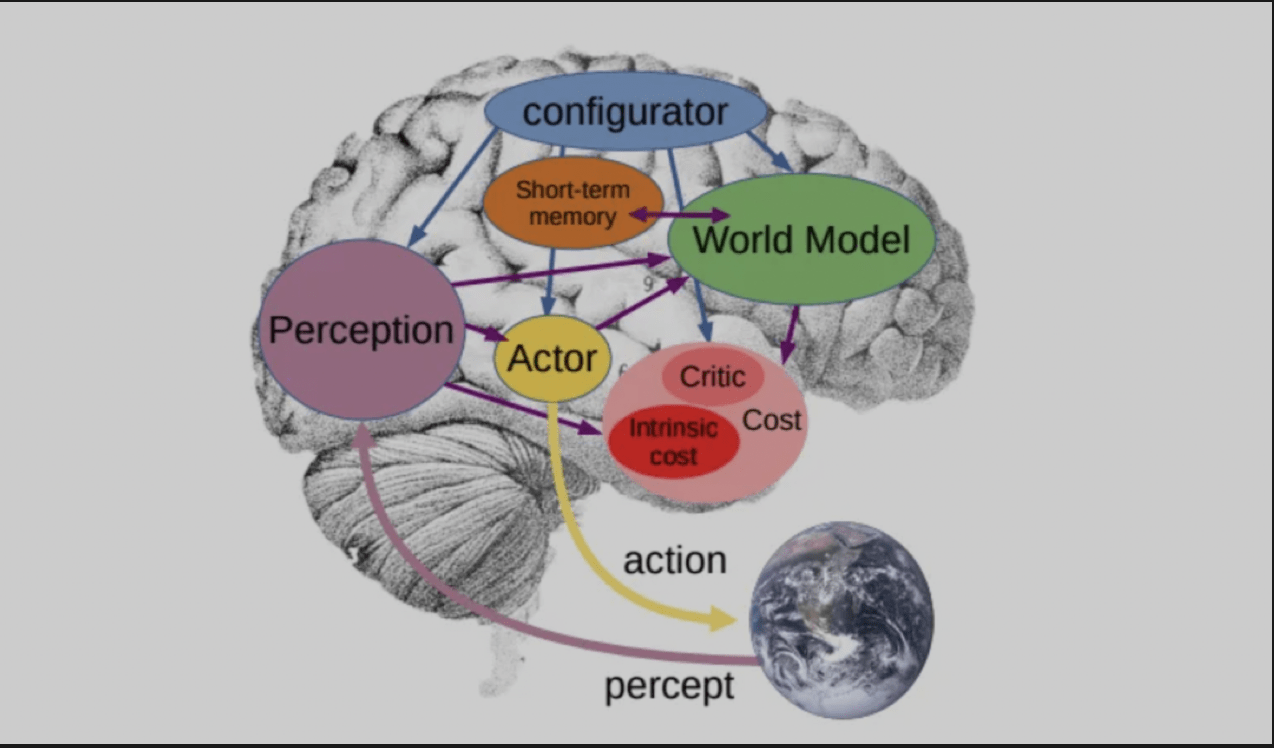

Il a déclaré que pour que le modèle de langage comprenne véritablement la connaissance du monde réel, une nouvelle architecture est nécessaire pour le remplacer, et cette architecture est l'architecture qu'il a proposée dans l'article qu'il a publié il y a un an, "Autonomous Intelligence". . Il s'agit d'une architecture dans laquelle un module de configuration contrôle l'ensemble du système et effectue des prédictions, un raisonnement et une prise de décision basés sur les informations d'entrée. Le « module mondial » a la capacité d’estimer les informations manquantes et de prédire les futures conditions extérieures.

Parlant des défis auxquels l'IA sera confrontée dans les prochaines années, Yang Likun a souligné trois aspects : le premier est d'apprendre le modèle de représentation et de prédiction du monde ; le second est d'apprendre à raisonner, c'est-à-dire d'apprendre à raisonner. utiliser la pensée consciemment et délibérément pour accomplir des tâches ; enfin, un défi consiste à planifier des séquences d'actions complexes en décomposant des tâches complexes en tâches plus simples, en les exécutant de manière hiérarchique.

En parlant de cela, Yang Likun a présenté un autre modèle qu'il a publié dans le journal "World Model", qui peut imaginer une scène et prédire les résultats des actions basées sur la scène. L’objectif est de trouver une séquence d’actions prédite par son propre modèle du monde et minimisant une série de coûts.

Lorsque Yang Likun a été interrogé lors de la séance de questions-réponses sur un débat à venir sur le statut et l'avenir de l'AGI, il a déclaré que le débat tournerait autour de la question de savoir si les systèmes d'intelligence artificielle présentent des risques existentiels pour les humains. Max Tegmark et Yoshua Bengio se rangeront du côté du « oui » en affirmant que les systèmes d’IA puissants peuvent présenter des risques existentiels pour les humains. Et Liqun Yang et Melanie Mitchell seront du côté du « non ».

« Notre argument n’est pas qu’il n’y a pas de risques, mais que ces risques, bien qu’ils existent, peuvent facilement être atténués ou supprimés grâce à une conception minutieuse. »

Yang Likun estime que le système super-intelligent n'a pas encore été développé. Une fois inventé, il sera trop tard pour discuter "si le système super-intelligent peut être rendu sûr pour les humains".

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

J'ai essayé le codage d'ambiance avec Cursor Ai et c'est incroyable!

Mar 20, 2025 pm 03:34 PM

Le codage des ambiances est de remodeler le monde du développement de logiciels en nous permettant de créer des applications en utilisant le langage naturel au lieu de lignes de code sans fin. Inspirée par des visionnaires comme Andrej Karpathy, cette approche innovante permet de dev

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Lunets de février 2025: GPT-4.5, Grok-3 et plus!

Mar 22, 2025 am 10:58 AM

Février 2025 a été un autre mois qui change la donne pour une IA générative, nous apportant certaines des mises à niveau des modèles les plus attendues et de nouvelles fonctionnalités révolutionnaires. De Xai's Grok 3 et Anthropic's Claude 3.7 Sonnet, à Openai's G

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Comment utiliser YOLO V12 pour la détection d'objets?

Mar 22, 2025 am 11:07 AM

Yolo (vous ne regardez qu'une seule fois) a été un cadre de détection d'objets en temps réel de premier plan, chaque itération améliorant les versions précédentes. La dernière version Yolo V12 introduit des progrès qui améliorent considérablement la précision

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o est-il disponible?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 est actuellement disponible et largement utilisé, démontrant des améliorations significatives dans la compréhension du contexte et la génération de réponses cohérentes par rapport à ses prédécesseurs comme Chatgpt 3.5. Les développements futurs peuvent inclure un interg plus personnalisé

Google & # 039; s Gencast: Prévision météorologique avec Mini démo Gencast

Mar 16, 2025 pm 01:46 PM

Google & # 039; s Gencast: Prévision météorologique avec Mini démo Gencast

Mar 16, 2025 pm 01:46 PM

Gencast de Google Deepmind: une IA révolutionnaire pour les prévisions météorologiques Les prévisions météorologiques ont subi une transformation spectaculaire, passant des observations rudimentaires aux prédictions sophistiquées alimentées par l'IA. Gencast de Google Deepmind, un terreau

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

Quelle IA est la meilleure que Chatgpt?

Mar 18, 2025 pm 06:05 PM

L'article traite des modèles d'IA dépassant Chatgpt, comme Lamda, Llama et Grok, mettant en évidence leurs avantages en matière de précision, de compréhension et d'impact de l'industrie. (159 caractères)

O1 vs GPT-4O: le nouveau modèle Openai est-il meilleur que GPT-4O?

Mar 16, 2025 am 11:47 AM

O1 vs GPT-4O: le nouveau modèle Openai est-il meilleur que GPT-4O?

Mar 16, 2025 am 11:47 AM

O1'S O1: Une vague de cadeaux de 12 jours commence par leur modèle le plus puissant à ce jour L'arrivée de décembre apporte un ralentissement mondial, les flocons de neige dans certaines parties du monde, mais Openai ne fait que commencer. Sam Altman et son équipe lancent un cadeau de don de 12 jours

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

Meilleurs générateurs d'art AI (gratuit & amp; payé) pour des projets créatifs

Apr 02, 2025 pm 06:10 PM

L'article passe en revue les meilleurs générateurs d'art AI, discutant de leurs fonctionnalités, de leur aptitude aux projets créatifs et de la valeur. Il met en évidence MidJourney comme la meilleure valeur pour les professionnels et recommande Dall-E 2 pour un art personnalisable de haute qualité.