développement back-end

développement back-end

tutoriel php

tutoriel php

Principe et application du robot d'exploration de données basé sur PHP

Principe et application du robot d'exploration de données basé sur PHP

Principe et application du robot d'exploration de données basé sur PHP

Avec l'avènement de l'ère Internet, les données sont devenues une ressource très importante. Dans de nombreuses applications, telles que la construction de sites Web, le marketing, l'analyse financière et d'autres domaines, l'obtention et l'analyse de données sont devenues une tâche essentielle. Dans le processus d’obtention de données, les robots d’exploration de données sont particulièrement importants. Cet article présentera les principes et les applications des robots d'exploration de données basés sur PHP.

1. La définition et la fonction du robot d'exploration de données

Un robot d'exploration de données, également appelé robot d'exploration Web ou robot d'exploration Web, est un programme qui peut obtenir automatiquement des informations sur Internet et les stocker dans une base de données locale. Il peut trouver des informations précieuses dans une grande quantité de données, obtenir des données intéressantes et les organiser sous une forme utile aux utilisateurs. Les robots d'exploration de données peuvent nous fournir des informations larges et détaillées et constituent un outil important lors de la collecte et de l'analyse des données Internet.

2. Principe du data crawler

Un data crawler est un tout composé de plusieurs composants. Son flux de travail principal comprend les étapes d'obtention de la page, d'analyse de la page, d'extraction des données cibles et de leur stockage local.

- Obtenir la page

La première étape du robot d'exploration de données consiste à obtenir la page HTML originale non traitée en fonction du lien URL du site Web cible. Cette étape est généralement réalisée à l'aide de requêtes HTTP pour simuler une véritable requête Web. Lors de ce processus de requête, nous devons prêter attention au fichier « robots.txt », car ce fichier contient des URL qui peuvent ou non être explorées. Si nous ne respectons pas ces règles, nous risquons d'être soumis à des mesures anti-crawler de la part du site Internet cible.

- Analyser la page

Après avoir obtenu la page HTML, le robot d'exploration de données doit l'analyser pour identifier la structure et les composants de la page afin d'extraire les données requises. Les documents HTML se composent généralement de deux parties : le balisage et le texte. Les robots d'exploration de données doivent utiliser des analyseurs XML ou HTML pour les séparer, les analyser et les encoder.

- Extraire les données cibles et enregistrer

Pendant le processus d'analyse, le robot recherchera les données cibles et utilisera des expressions régulières ou l'apprentissage automatique (comme le traitement du langage naturel) pour analyser le texte afin de trouver les données dont nous avons besoin. Une fois les données trouvées, elles sont enregistrées dans une base de données locale.

3. Scénarios d'application d'exploration de données basés sur PHP

Les robots d'exploration de données fournissent un grand nombre de services d'acquisition et d'analyse de données, et ils sont largement utilisés dans les domaines suivants :

- Études et analyses de marché

Utilisation de l'exploration de données. L'extracteur peut obtenir de nombreuses données de marché utiles, nous permettant de mieux comprendre le marché cible. Les données pouvant être obtenues comprennent des informations telles que le classement des résultats des moteurs de recherche, les tendances du marché, les avis sur les produits, les prix et l'inventaire. Ces données peuvent être comparées à celles des concurrents d'une entreprise et analysées à l'aide de techniques d'apprentissage automatique pour obtenir des informations clés.

- Analyse des médias sociaux

Avec la popularité des plateformes de médias sociaux, de plus en plus d'entreprises commencent à utiliser des robots d'exploration de données pour capturer les données des consommateurs afin de comprendre la perception du public à l'égard de leurs marques. Ces données peuvent être analysées pour améliorer les stratégies marketing, résoudre des problèmes et fournir un meilleur service aux clients.

- Analyse du secteur financier

Sur le marché financier, les robots d'exploration de données peuvent aider les investisseurs et les analystes financiers à obtenir rapidement des données clés, telles que les données de rendement, les tendances du marché et les données sur les événements d'actualité, et à analyser leur impact sur les actions et les marchés. conditions du marché. Le grattoir de données basé sur PHP peut récupérer des données sur des milliers de sites Web financiers et de sources d'information et les stocker dans une base de données locale pour analyse.

4. Résumé

Grâce à l'introduction de cet article, nous pouvons clairement comprendre les principes et les scénarios d'application du robot d'exploration de données basé sur PHP. Pendant le processus d’exploration des données, nous devons prêter attention à la légalité et au caractère normatif. De plus, nous devons déterminer l’étendue des données requises en fonction de l’innovation et des objectifs commerciaux. À l’ère du Big Data, les robots d’exploration de données deviendront l’un des outils les plus importants pour les entreprises et les organisations.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 apporte plusieurs nouvelles fonctionnalités, améliorations de sécurité et de performances avec une bonne quantité de dépréciations et de suppressions de fonctionnalités. Ce guide explique comment installer PHP 8.4 ou mettre à niveau vers PHP 8.4 sur Ubuntu, Debian ou leurs dérivés. Bien qu'il soit possible de compiler PHP à partir des sources, son installation à partir d'un référentiel APT comme expliqué ci-dessous est souvent plus rapide et plus sécurisée car ces référentiels fourniront les dernières corrections de bogues et mises à jour de sécurité à l'avenir.

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler avec la date et l'heure dans cakephp4, nous allons utiliser la classe FrozenTime disponible.

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler sur le téléchargement de fichiers, nous allons utiliser l'assistant de formulaire. Voici un exemple de téléchargement de fichiers.

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP est un framework open source pour PHP. Il vise à faciliter grandement le développement, le déploiement et la maintenance d'applications. CakePHP est basé sur une architecture de type MVC à la fois puissante et facile à appréhender. Modèles, vues et contrôleurs gu

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

Le validateur peut être créé en ajoutant les deux lignes suivantes dans le contrôleur.

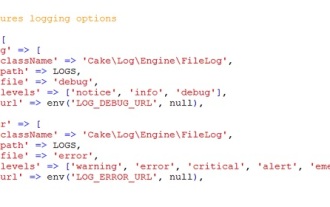

Journalisation CakePHP

Sep 10, 2024 pm 05:26 PM

Journalisation CakePHP

Sep 10, 2024 pm 05:26 PM

Se connecter à CakePHP est une tâche très simple. Il vous suffit d'utiliser une seule fonction. Vous pouvez enregistrer les erreurs, les exceptions, les activités des utilisateurs, les actions entreprises par les utilisateurs, pour tout processus en arrière-plan comme cronjob. La journalisation des données dans CakePHP est facile. La fonction log() est fournie

Comment configurer Visual Studio Code (VS Code) pour le développement PHP

Dec 20, 2024 am 11:31 AM

Comment configurer Visual Studio Code (VS Code) pour le développement PHP

Dec 20, 2024 am 11:31 AM

Visual Studio Code, également connu sous le nom de VS Code, est un éditeur de code source gratuit – ou environnement de développement intégré (IDE) – disponible pour tous les principaux systèmes d'exploitation. Avec une large collection d'extensions pour de nombreux langages de programmation, VS Code peut être c

Guide rapide CakePHP

Sep 10, 2024 pm 05:27 PM

Guide rapide CakePHP

Sep 10, 2024 pm 05:27 PM

CakePHP est un framework MVC open source. Cela facilite grandement le développement, le déploiement et la maintenance des applications. CakePHP dispose d'un certain nombre de bibliothèques pour réduire la surcharge des tâches les plus courantes.