Il y a quelques jours, le PDG d'OpenAI, Sam Altman, a révélé le récent chemin de développement d'OpenAI lors d'une tournée mondiale de discours, qui est principalement divisée en deux étapes. La priorité absolue en 2023 est de lancer GPT-4 moins cher et plus rapide, ainsi que des fenêtres de contexte et des fenêtres de contexte plus longues. plus ; 2024 se concentre sur la multimodalité.

Les objectifs d’OpenAI pour 2023 sont atteints un par un. En seulement quelques mois depuis le lancement de ChatGPT, OpenAI a créé des applications incroyables basées sur des modèles tels que GPT-3.5 Turbo, GPT-4, etc. Le 13 juin, heure locale, OpenAI a publié des appels de fonction et d'autres mises à jour de l'API, notamment :

Appels de fonction

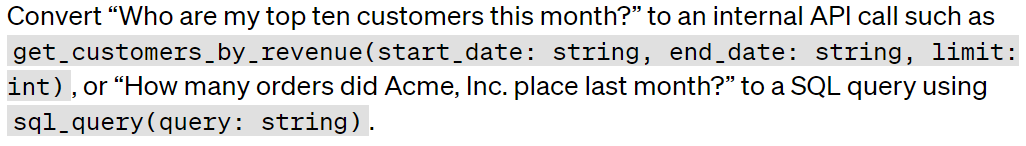

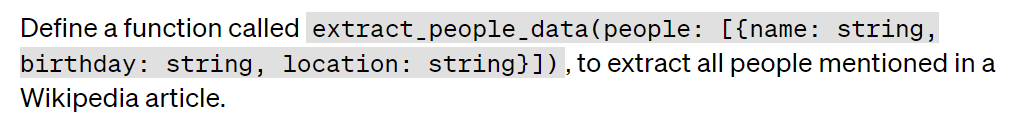

Les développeurs peuvent désormais postuler à gpt-4-0613 et gpt-3.5-turbo-0613 Décrivez les fonctions et laissez le modèle choisir intelligemment de générer un objet JSON contenant les paramètres requis pour appeler ces fonctions. Il s'agit d'une nouvelle façon de connecter de manière plus fiable les fonctionnalités de GPT aux outils et API externes.Le modèle est affiné pour à la fois détecter quand une fonction doit être appelée (en fonction de la saisie de l'utilisateur) et répondre avec un JSON qui correspond à la signature de la fonction. Les appels de fonction permettent aux développeurs d'obtenir des données structurées à partir de modèles de manière plus fiable. Par exemple, un développeur pourrait :

Créer un chatbot qui appelle un outil externe pour répondre aux questions :

Convertissez le langage naturel en appels API ou en requêtes de base de données :

Extraire la structure des données du texte :

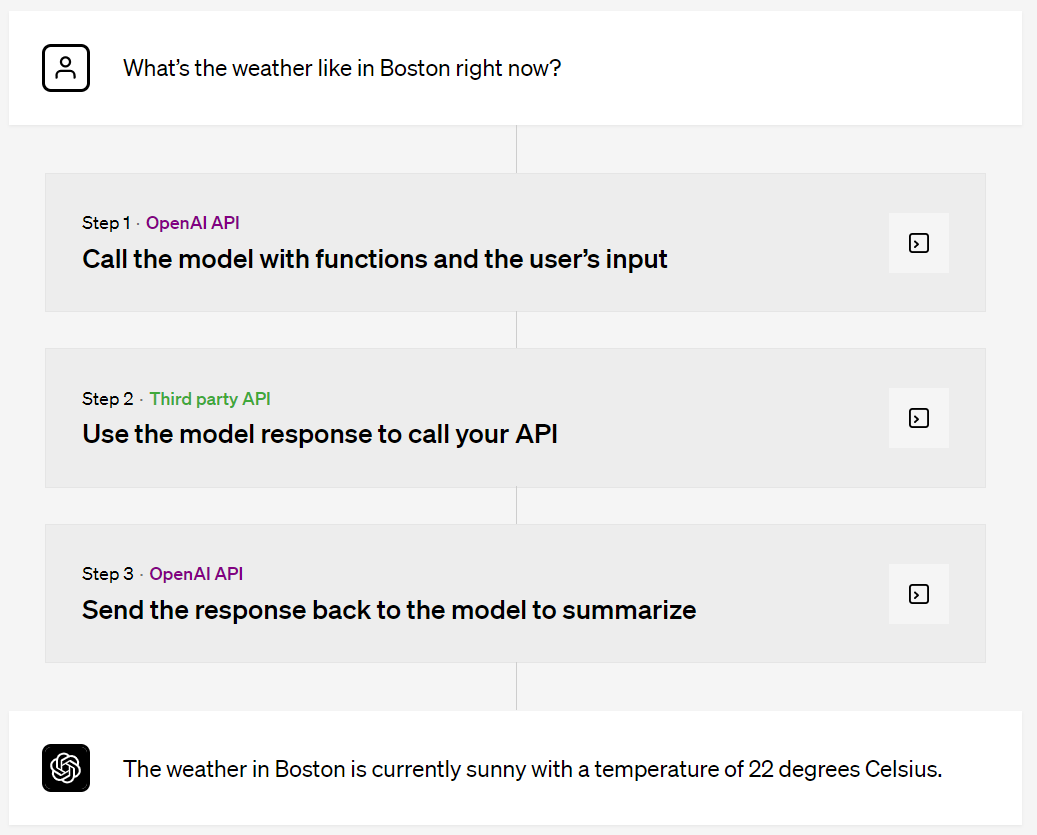

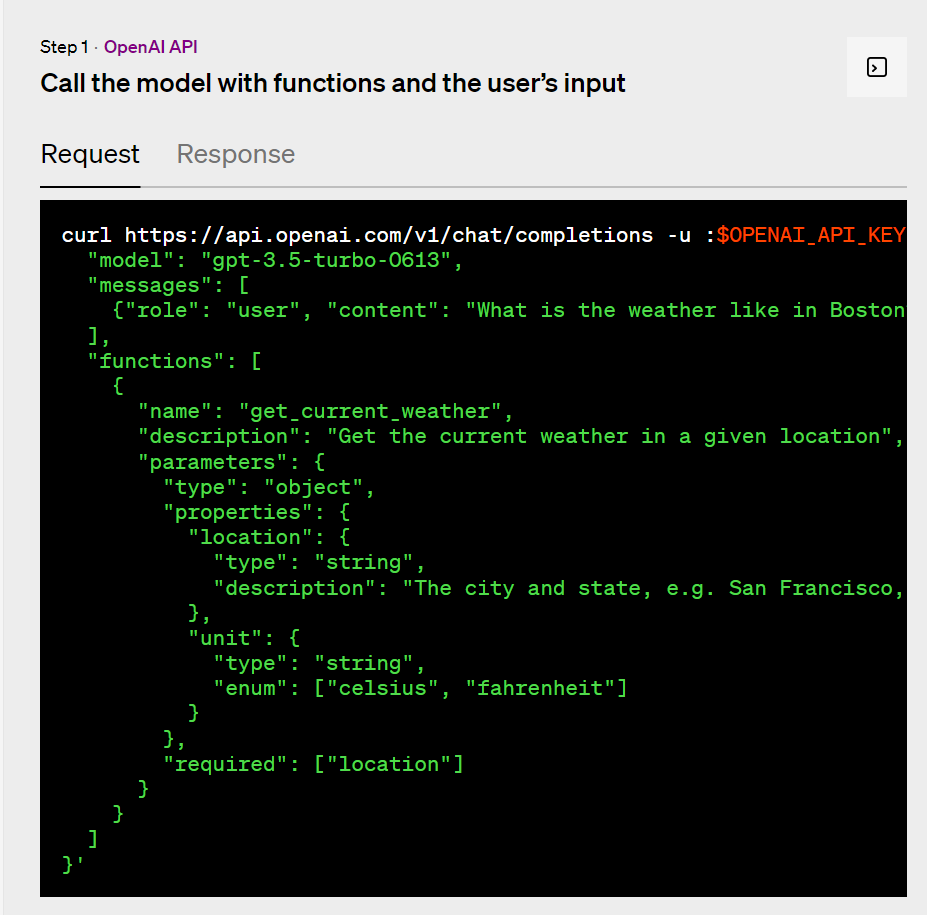

Exemple d'appel de fonction

Par exemple, un utilisateur demande « Quel temps fait-il à Boston actuellement ? » Après une série de traitements, le modèle final affiche la réponse : « Le temps à Boston est actuellement ensoleillé et la température est de 22 degrés Celsius. »

Dépréciation du modèle De plus, les développeurs qui ont besoin d'un temps de transition peuvent continuer à utiliser les anciennes versions des modèles gpt-3.5-turbo-0301, gpt-4-0314 ou gpt-4-32k-0314, mais après le 13 septembre, les requêtes utilisant ces modèles échoueront. Pour plus d'informations sur la dépréciation des modèles, veuillez vous référer à : Requête sur la dépréciation du modèle : https://platform.openai.com/docs/deprecations/ De plus, le prix de cette mise à jour est inférieur, intégration de texte -ada-002 est le modèle d'intégration le plus populaire pour les systèmes d'intégration. Aujourd'hui, son coût est réduit de 75 % pour atteindre 0,0001 $ pour 1 000 jetons. Enfin, il y a GPT-3.5 Turbo auquel tout le monde prête plus d'attention, qui fournit la fonction ChatGPT à des millions d'utilisateurs. Aujourd'hui, le coût du jeton d'entrée de gpt-3.5-turbo est réduit de 25 %. Les développeurs utilisant ce modèle ne paient désormais que 0,0015 USD pour 1 000 jetons d'entrée et 0,002 USD pour 1 000 jetons de sortie, ce qui équivaut à environ 700 pages par dollar.

Nouveau modèle

Nouveau modèle gpt -4-0613 contient une fonction mise à jour et améliorée Appeler le modèle.

Vient ensuite GPT - 3.5 Turbo : gpt-3.5-turbo-0613 contient les mêmes appels de fonction que GPT-4, ainsi qu'une opérabilité plus fiable via les messages système, les développeurs peuvent en profiter Deux fonctionnalités guident plus efficacement la réponse du modèle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment utiliser la fonction choisir

Comment utiliser la fonction choisir

La différence entre php et js

La différence entre php et js

Tutoriel de saisie de symboles pleine largeur

Tutoriel de saisie de symboles pleine largeur

prix BTC aujourd'hui

prix BTC aujourd'hui

Combien de personnes pouvez-vous élever sur Douyin ?

Combien de personnes pouvez-vous élever sur Douyin ?

Le rôle d'isset en php

Le rôle d'isset en php

La fonction du relais intermédiaire

La fonction du relais intermédiaire

Que faire en cas d'erreur de connexion

Que faire en cas d'erreur de connexion

Quel est le format m4a ?

Quel est le format m4a ?