2022 est la période fenêtre pour que la conduite intelligente passe de L2 à L3/L4. De plus en plus de constructeurs automobiles ont commencé à déployer une production de masse de conduite intelligente de plus haut niveau, et l'ère de l'intelligence automobile est tranquillement arrivée.

Avec l'amélioration technique du matériel lidar, la production de masse au niveau des voitures et la réduction des coûts, les fonctions de conduite intelligente de haut niveau ont favorisé la production de masse de lidar dans le domaine des voitures particulières. Une variété de modèles équipés de lidar le feront. sera livré cette année, et 2022 est également connue comme « la première année du lidar sur la route ».

Le Lidar est un capteur utilisé pour obtenir avec précision la position tridimensionnelle des objets. Il s'agit essentiellement de détection et de télémétrie laser. Avec ses excellentes performances en matière de mesure de contour de cible et de détection universelle d’obstacles, il devient la configuration de base de la conduite autonome L4.

Cependant, la portée du lidar (généralement autour de 200 mètres, et les indicateurs des modèles produits en série par différents fabricants varient) se traduit par une plage de perception bien inférieure à celle des capteurs d'image.

Et parce que sa résolution angulaire (généralement 0,1° ou 0,2°) est relativement faible, la résolution du nuage de points est bien inférieure à celle du capteur d'image lors de la détection à longue distance des points projetés sur la cible. peut être extrêmement clairsemé. Je ne peux même pas créer d'image. Pour la détection de cibles de nuages de points, la distance effective du nuage de points que l'algorithme peut réellement utiliser n'est que d'environ 100 mètres.

Les capteurs d'image peuvent acquérir des informations environnantes complexes à des fréquences d'images et des résolutions élevées, et sont bon marché. Plusieurs capteurs avec différents FOV et résolutions peuvent être déployés pour une perception visuelle à différentes distances et plages.

Cependant, le capteur d'image est un capteur passif, avec une perception de profondeur insuffisante et une faible précision de portée, en particulier dans les environnements difficiles, la difficulté d'accomplir les tâches de détection augmentera considérablement.

Face à une lumière forte, un faible éclairage la nuit, de la pluie, de la neige, du brouillard et d'autres environnements météorologiques et lumineux, la conduite intelligente a des exigences élevées en matière d'algorithmes de capteurs. Bien que le lidar ne soit pas sensible à l’influence de la lumière ambiante, la mesure de distance sera fortement affectée par les routes remplies d’eau, les murs de verre, etc.

On constate que les capteurs lidar et d'image ont chacun leurs propres avantages et inconvénients. La plupart des voitures particulières à conduite intelligente de haut niveau choisissent d'intégrer différents capteurs pour compléter les avantages de chacun et s'intégrer de manière redondante.

Une telle solution de détection fusionnée est également devenue l'une des technologies clés pour la conduite autonome de haut niveau.

La fusion des nuages de points et des images appartient au domaine technique de la fusion multicapteur (MSF). Il existe des méthodes aléatoires traditionnelles et des méthodes d'apprentissage profond. selon le niveau d'abstraction du traitement de l'information dans le système de fusion, il est principalement divisé en trois niveaux :

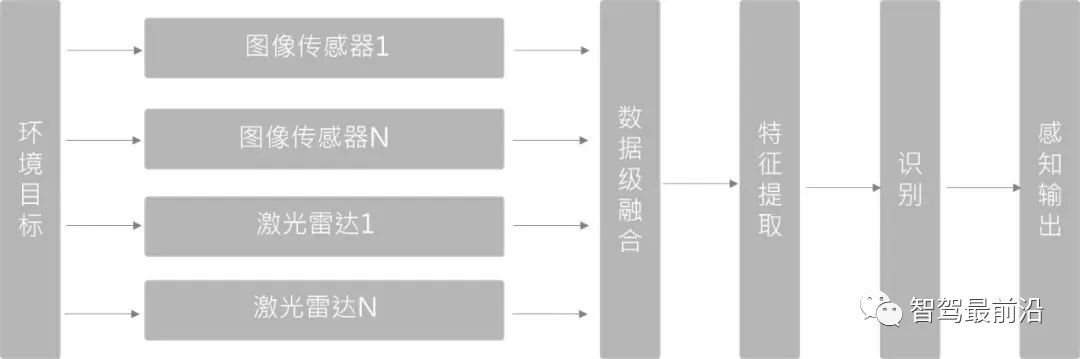

Fusion de la couche de données (Early Fusion)

Fusionnez d'abord les données d'observation du capteur, puis fusionnez les caractéristiques des données fusionnées sont extraites pour identification. Dans la détection de cibles 3D, PointPainting (CVPR20) adopte cette méthode. La méthode PointPainting effectue d'abord une segmentation sémantique sur l'image, mappe les caractéristiques segmentées sur le nuage de points via une matrice de pixels point à image, puis « dessine le point ». Le nuage de points est envoyé au détecteur de nuage de points 3D pour effectuer une régression sur la boîte cible.

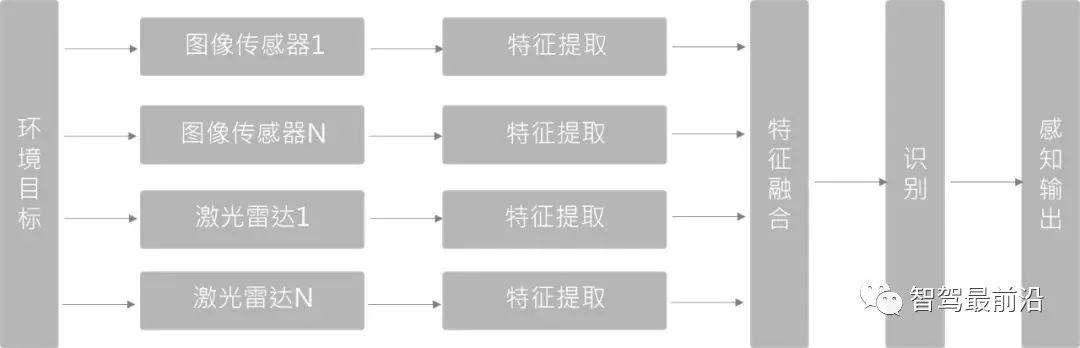

Fusion des couches de caractéristiques (Deep Fusion)

Extrayez d'abord les caractéristiques des données naturelles à partir des données d'observation fournies par chaque capteur, puis identifiez ces caractéristiques après la fusion. Dans la méthode de fusion basée sur l'apprentissage profond, cette méthode utilise des extracteurs de caractéristiques pour les branches de nuage de points et d'image. Les réseaux de la branche d'image et de la branche de nuage de points sont fusionnés sémantiquement niveau par niveau dans le niveau de rétroaction directe pour obtenir des informations multi-échelles. . fusion sémantique.

La méthode de fusion de couches de fonctionnalités basée sur l'apprentissage en profondeur a des exigences élevées en matière de synchronisation spatio-temporelle entre plusieurs capteurs. Une fois que la synchronisation n'est pas bonne, elle affectera directement l'effet de la fusion de fonctionnalités. Dans le même temps, en raison des différences d'échelle et d'angle de vision, il est difficile d'obtenir l'effet 1+1>2 de la fusion des caractéristiques entre le LiDAR et les images.

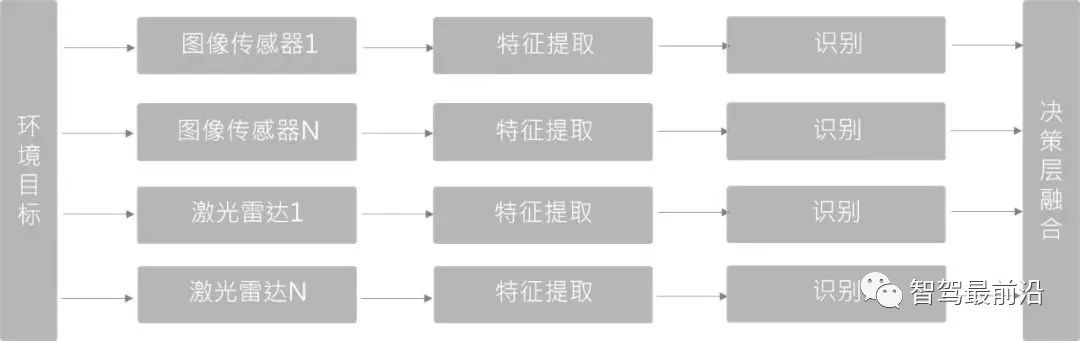

Fusion des couches décisionnelles (Late Fusion)

Par rapport aux deux premières, c'est la méthode de fusion la moins complexe. Il ne fusionne pas au niveau de la couche de données ou de la couche de fonctionnalités, mais il s'agit d'une fusion au niveau de la cible. Différentes structures de réseau de capteurs ne s'affectent pas et peuvent être entraînées et combinées indépendamment.

Étant donné que les deux types de capteurs et de détecteurs fusionnés au niveau de la couche décisionnelle sont indépendants l'un de l'autre, une fois qu'un capteur tombe en panne, le traitement de redondance des capteurs peut toujours être effectué et la robustesse technique est meilleure.

Avec l'itération continue de la technologie de perception lidar et de fusion visuelle, ainsi que l'accumulation continue de scénarios et de cas de connaissances, de plus en plus de solutions informatiques de fusion full-stack sembleront apporter plus d'avantages aux systèmes autonomes. conduire. Un avenir sûr et sécurisé.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Quelles compétences sont nécessaires pour travailler dans l'industrie PHP ?

Quelles compétences sont nécessaires pour travailler dans l'industrie PHP ?

Quelles sont les technologies de sécurité des réseaux ?

Quelles sont les technologies de sécurité des réseaux ?

Que signifie le jeton ?

Que signifie le jeton ?

que signifie pm

que signifie pm

Comment utiliser la sous-intrigue dans Matlab

Comment utiliser la sous-intrigue dans Matlab

Que faire si notepad.exe ne répond pas

Que faire si notepad.exe ne répond pas

Outil de requête de nom de domaine d'enregistrement

Outil de requête de nom de domaine d'enregistrement

Introduction aux noms de domaine de premier niveau couramment utilisés

Introduction aux noms de domaine de premier niveau couramment utilisés