développement back-end

développement back-end

tutoriel php

tutoriel php

Comment gérer l'API d'un grand ensemble de données en PHP

Comment gérer l'API d'un grand ensemble de données en PHP

Comment gérer l'API d'un grand ensemble de données en PHP

En tant que langage back-end populaire, PHP est largement utilisé pour le développement Web et les services API. Cependant, lorsque de grandes quantités de données doivent être traitées, l'efficacité d'exécution de PHP peut être affectée, ce qui entraîne un ralentissement ou un crash de l'application. Par conséquent, dans cet article, nous explorerons les API permettant de gérer de grands ensembles de données en PHP afin de garantir des performances et une fiabilité élevées de l'application.

1. Évitez de charger de gros ensembles de données à la fois

En tant que langage interprété, PHP utilise beaucoup de mémoire. Par conséquent, essayer de charger simultanément une grande quantité de données d’une base de données ou d’un fichier dans la mémoire entraînera de mauvaises performances et peut utiliser beaucoup de ressources sur le serveur. Au lieu de cela, il est recommandé de charger les données par pagination ou par traitement par lots, en chargeant uniquement les blocs de données requis à la fois. Par exemple, dans un service API, vous pouvez configurer des paramètres ou utiliser des en-têtes HTTP pour spécifier la quantité et le numéro de page des données à obtenir avec chaque requête. Cette approche réduit la pression de la mémoire et améliore les performances tout en évitant de renvoyer trop de données dans la réponse.

2. Utiliser la mise en cache

Par rapport à l'obtention de données directement à partir de la base de données ou d'un fichier, la mise en cache peut considérablement accélérer la vitesse de réponse des requêtes API. Habituellement, nous pouvons mettre en cache les données couramment utilisées et rarement modifiées dans la mémoire ou sur le disque, puis les interroger dans l'API. Cela peut réduire autant que possible le nombre de requêtes, réduisant ainsi le temps de réponse du serveur et la consommation de ressources. PHP fournit plusieurs mécanismes de mise en cache, notamment APC, Memcached et Redis.

3. Utilisez des index

Lors du traitement de grands ensembles de données, l'utilisation d'index peut aider à localiser rapidement les données requises. Par exemple, dans une table de base de données, nous pouvons créer des index sur certaines colonnes pour effectuer des requêtes efficaces. Notez que chaque index occupe un espace de stockage supplémentaire, ne créez donc pas d'index pour toutes les colonnes. De plus, lorsque vous utilisez des index, vous devez éviter d’utiliser la correspondance floue, car cela peut entraîner une latence et une surcharge des requêtes accrues.

4. Optimisez les instructions de requête

Lors de l'exécution d'opérations de requête, simplifiez autant que possible les instructions de requête et réduisez les calculs et les opérations de filtrage inutiles. Par exemple, vous pouvez utiliser des fonctions d'agrégation et la clause GROUP BY pour résumer et regrouper les résultats des requêtes, ou utiliser des sous-requêtes pour optimiser les performances. De plus, vous pouvez trier les données avant l'interrogation et utiliser le mot-clé LIMIT pour limiter le nombre de résultats renvoyés.

5. Envisagez d'utiliser une base de données NoSQL

Pour les grands ensembles de données, l'utilisation de bases de données relationnelles traditionnelles peut entraîner une dégradation des performances. À ce stade, vous pouvez envisager d'utiliser une base de données NoSQL. Contrairement aux bases de données traditionnelles, les bases de données NoSQL adoptent une structure non relationnelle et présentent des avantages en termes d'expansion horizontale. Ils peuvent donc traiter rapidement de grandes quantités de données. Par exemple, MongoDB est une base de données NoSQL couramment utilisée qui prend en charge le partitionnement et la réplication pour obtenir une évolutivité horizontale et une haute disponibilité.

6. Utilisez la technologie de programmation asynchrone

Lors du traitement de grandes quantités de données, l'utilisation de la technologie de programmation synchrone peut provoquer un blocage et une augmentation du temps de réponse. Par conséquent, l’utilisation de techniques de programmation asynchrone peut améliorer l’efficacité du traitement de grandes quantités de données. PHP 7 fournit de nouvelles API de programmation asynchrone, notamment des E/S asynchrones et un contrôle de processus asynchrone. De plus, vous pouvez également utiliser des bibliothèques tierces, telles que ReactPHP et Amp, pour implémenter une programmation asynchrone.

En bref, lors du traitement de grandes quantités de données, les programmeurs PHP doivent faire attention à éviter de charger de gros ensembles de données à la fois, à utiliser des caches et des index, à optimiser les instructions de requête, à envisager d'utiliser des bases de données NoSQL, à utiliser la programmation asynchrone. techniques, etc. Ces technologies et méthodes peuvent nous aider à améliorer la vitesse de réponse et la fiabilité des applications lors du traitement du Big Data.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1359

1359

52

52

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 apporte plusieurs nouvelles fonctionnalités, améliorations de sécurité et de performances avec une bonne quantité de dépréciations et de suppressions de fonctionnalités. Ce guide explique comment installer PHP 8.4 ou mettre à niveau vers PHP 8.4 sur Ubuntu, Debian ou leurs dérivés. Bien qu'il soit possible de compiler PHP à partir des sources, son installation à partir d'un référentiel APT comme expliqué ci-dessous est souvent plus rapide et plus sécurisée car ces référentiels fourniront les dernières corrections de bogues et mises à jour de sécurité à l'avenir.

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler avec la date et l'heure dans cakephp4, nous allons utiliser la classe FrozenTime disponible.

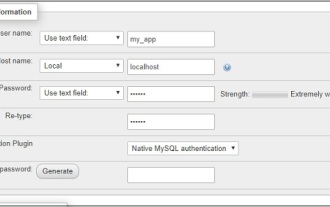

CakePHP travaillant avec la base de données

Sep 10, 2024 pm 05:25 PM

CakePHP travaillant avec la base de données

Sep 10, 2024 pm 05:25 PM

Travailler avec la base de données dans CakePHP est très simple. Nous comprendrons les opérations CRUD (Créer, Lire, Mettre à jour, Supprimer) dans ce chapitre.

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler sur le téléchargement de fichiers, nous allons utiliser l'assistant de formulaire. Voici un exemple de téléchargement de fichiers.

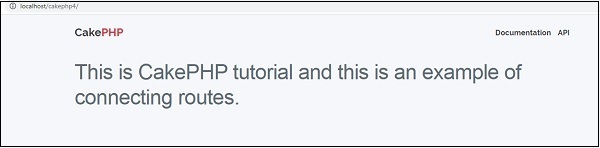

Routage CakePHP

Sep 10, 2024 pm 05:25 PM

Routage CakePHP

Sep 10, 2024 pm 05:25 PM

Dans ce chapitre, nous allons apprendre les sujets suivants liés au routage ?

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP est un framework open source pour PHP. Il vise à faciliter grandement le développement, le déploiement et la maintenance d'applications. CakePHP est basé sur une architecture de type MVC à la fois puissante et facile à appréhender. Modèles, vues et contrôleurs gu

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

Le validateur peut être créé en ajoutant les deux lignes suivantes dans le contrôleur.

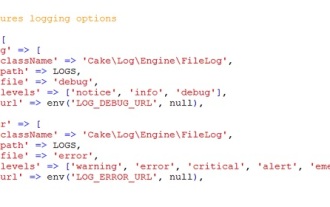

Journalisation CakePHP

Sep 10, 2024 pm 05:26 PM

Journalisation CakePHP

Sep 10, 2024 pm 05:26 PM

Se connecter à CakePHP est une tâche très simple. Il vous suffit d'utiliser une seule fonction. Vous pouvez enregistrer les erreurs, les exceptions, les activités des utilisateurs, les actions entreprises par les utilisateurs, pour tout processus en arrière-plan comme cronjob. La journalisation des données dans CakePHP est facile. La fonction log() est fournie