Créer un robot d'exploration Web simple en utilisant PHP

Avec le développement continu d'Internet, l'accès à l'information est devenu de plus en plus pratique. Cependant, la quantité massive d'informations nous pose également de nombreux problèmes. Comment obtenir efficacement les informations dont nous avons besoin est devenu une tâche très importante. Dans le processus d'automatisation de l'acquisition d'informations, les robots d'exploration Web sont largement utilisés.

Web Crawler est un programme qui obtient automatiquement des informations sur Internet et est souvent utilisé pour des tâches telles que les moteurs de recherche, l'exploration de données et le suivi des prix des matières premières. Le robot d'exploration Web accédera automatiquement au site Web ou à la page Web spécifié, puis analysera les données HTML ou XML pour obtenir les informations requises.

Aujourd'hui, cet article présentera comment créer un robot d'exploration Web simple en utilisant le langage PHP. Avant de commencer, nous devons comprendre les connaissances de base du langage PHP et quelques concepts de base du développement Web.

1. Obtenez la page HTML

La première étape du robot d'exploration Web consiste à obtenir la page HTML. Cette étape peut être réalisée en utilisant les fonctions intégrées de PHP. Par exemple, nous pouvons utiliser la fonction file_get_contents pour obtenir la page HTML d'une adresse URL et l'enregistrer dans une variable. Le code est le suivant :

$url = "https://www.example.com/"; $html = file_get_contents($url);

Dans le code ci-dessus, nous définissons une $url. variable pour stocker l'adresse URL cible, puis utilisez la fonction file_get_contents pour obtenir la page HTML pour cette adresse URL et la stocker dans la variable $html.

2. Analyser la page HTML

Après avoir obtenu la page HTML, nous devons en extraire les informations requises. Les pages HTML sont généralement constituées de balises et d'attributs de balises. Par conséquent, nous pouvons utiliser les fonctions de manipulation DOM intégrées à PHP pour analyser les pages HTML.

Avant d'utiliser la fonction d'opération DOM, nous devons charger la page HTML dans un objet DOMDocument. Le code est le suivant :

$dom = new DOMDocument(); $dom->loadHTML($html);

Dans le code ci-dessus, nous avons créé un. Videz l'objet DOMDocument et utilisez la fonction loadHTML pour charger la page HTML obtenue dans l'objet DOMDocument.

Ensuite, nous pouvons récupérer les balises dans la page HTML via l'objet DOMDocument. Le code est le suivant :

$tags = $dom->getElementsByTagName("tag_name");Dans le code ci-dessus, nous utilisons la fonction getElementsByTagName pour obtenez les balises dans la page HTML. Les balises spécifiées, par exemple, obtenez toutes les balises de lien hypertexte :

$links = $dom->getElementsByTagName("a");Obtenez toutes les balises d'image :

$imgs = $dom->getElementsByTagName("img");Obtenez toutes les balises de paragraphe : #🎜🎜 #

$paras = $dom->getElementsByTagName("p");En plus d'obtenir la balise elle-même, nous devons également analyser les attributs de la balise, par exemple, obtenir l'attribut href de tous les hyperliens : # 🎜🎜#

foreach ($links as $link) {

$href = $link->getAttribute("href");

// do something with $href

}Filtre basé sur le nom de la balise

- Par exemple, nous ne pouvons obtenir que balises de texte :

$texts = $dom->getElementsByTagName("text");Filtrage basé sur les sélecteurs CSS

- L'utilisation des sélecteurs CSS peut facilement localiser les balises requises, par exemple, obtenir tous les noms de classe Balises pour "liste":

$els = $dom->querySelectorAll(".list");Filtrer par mots-clés

- Le filtrage par mots-clés facilite la suppression des informations inutiles, par exemple, supprimez toutes les balises. contenant le mot-clé "advertising":

foreach ($paras as $para) {

if (strpos($para->nodeValue, "广告") !== false) {

$para->parentNode->removeChild($para);

}

}$links_arr = array();

foreach ($links as $link) {

$href = $link->getAttribute("href");

array_push($links_arr, $href);

}Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Configuration du projet CakePHP

Sep 10, 2024 pm 05:25 PM

Configuration du projet CakePHP

Sep 10, 2024 pm 05:25 PM

Dans ce chapitre, nous comprendrons les variables d'environnement, la configuration générale, la configuration de la base de données et la configuration de la messagerie dans CakePHP.

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 apporte plusieurs nouvelles fonctionnalités, améliorations de sécurité et de performances avec une bonne quantité de dépréciations et de suppressions de fonctionnalités. Ce guide explique comment installer PHP 8.4 ou mettre à niveau vers PHP 8.4 sur Ubuntu, Debian ou leurs dérivés. Bien qu'il soit possible de compiler PHP à partir des sources, son installation à partir d'un référentiel APT comme expliqué ci-dessous est souvent plus rapide et plus sécurisée car ces référentiels fourniront les dernières corrections de bogues et mises à jour de sécurité à l'avenir.

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler avec la date et l'heure dans cakephp4, nous allons utiliser la classe FrozenTime disponible.

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler sur le téléchargement de fichiers, nous allons utiliser l'assistant de formulaire. Voici un exemple de téléchargement de fichiers.

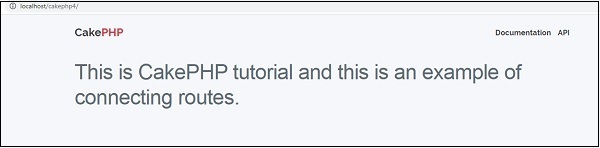

Routage CakePHP

Sep 10, 2024 pm 05:25 PM

Routage CakePHP

Sep 10, 2024 pm 05:25 PM

Dans ce chapitre, nous allons apprendre les sujets suivants liés au routage ?

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP est un framework open source pour PHP. Il vise à faciliter grandement le développement, le déploiement et la maintenance d'applications. CakePHP est basé sur une architecture de type MVC à la fois puissante et facile à appréhender. Modèles, vues et contrôleurs gu

Comment configurer Visual Studio Code (VS Code) pour le développement PHP

Dec 20, 2024 am 11:31 AM

Comment configurer Visual Studio Code (VS Code) pour le développement PHP

Dec 20, 2024 am 11:31 AM

Visual Studio Code, également connu sous le nom de VS Code, est un éditeur de code source gratuit – ou environnement de développement intégré (IDE) – disponible pour tous les principaux systèmes d'exploitation. Avec une large collection d'extensions pour de nombreux langages de programmation, VS Code peut être c

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

Le validateur peut être créé en ajoutant les deux lignes suivantes dans le contrôleur.