Qu'est-ce qu'un robot d'exploration Web

Quand il s'agit de référencement technique, il peut être difficile de comprendre son fonctionnement. Mais il est important d’acquérir le plus de connaissances possible pour optimiser notre site internet et toucher un public plus large. Un outil qui joue un rôle important dans le référencement est le robot d’exploration Web.

Un robot d'exploration Web (également connu sous le nom de web spider) est un robot qui recherche et indexe le contenu sur Internet. Essentiellement, les robots d'exploration Web sont chargés de comprendre le contenu d'une page Web afin de le récupérer lorsqu'une requête est effectuée.

Vous vous demandez peut-être : "Qui gère ces robots d'exploration Web ?"

En règle générale, les robots d'exploration Web sont exploités par des moteurs de recherche avec leurs propres algorithmes. L'algorithme indiquera aux robots d'exploration Web comment trouver des informations pertinentes en réponse aux requêtes de recherche.

Une araignée Web recherchera (explorera) et catégorisera toutes les pages Web sur Internet qu'elle peut trouver et qu'il lui est demandé d'indexer. Ainsi, si vous ne souhaitez pas que votre page soit trouvée sur les moteurs de recherche, vous pouvez demander aux robots d'exploration de ne pas explorer votre page.

Pour ce faire, vous devez télécharger un fichier robots.txt. Essentiellement, le fichier robots.txt indiquera aux moteurs de recherche comment explorer et indexer les pages de votre site Web.

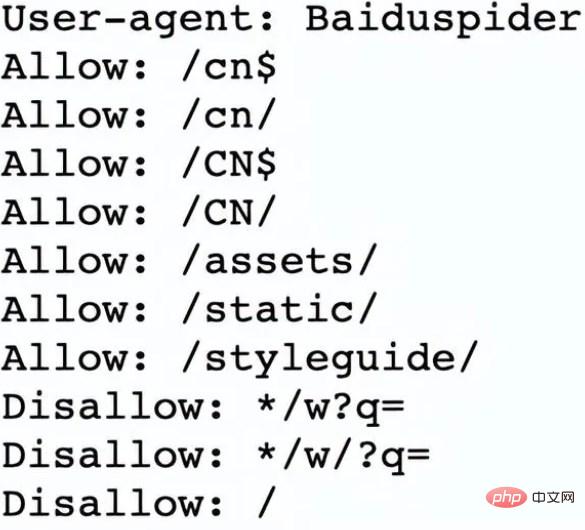

Par exemple, regardons Nike.com/robots.txt

Nike utilise son fichier robots.txt pour déterminer quels liens de son site Web seront explorés et indexés.

Dans cette section du document, il est établi que :

Le robot d'exploration Web Baiduspider a été autorisé à explorer les 7 premiers liens

Il a été interdit au robot d'exploration Web Baiduspider d'explorer les trois liens restants

C'est bon pour Nike Oui, car certaines pages de l'entreprise ne sont pas adaptées à la recherche et les liens non autorisés n'affectent pas leurs pages optimisées qui les aident à se classer dans les moteurs de recherche.

Alors maintenant, nous savons ce que sont les robots d'exploration et comment font-ils leur travail ? Examinons ensuite le fonctionnement des robots d’exploration Web.

Les robots d'exploration Web fonctionnent en découvrant les URL et en affichant et classant les pages Web. Ce faisant, ils trouvent des hyperliens vers d’autres pages Web et les ajoutent à la liste des pages à explorer ensuite. Les robots d'exploration Web sont intelligents et peuvent déterminer l'importance de chaque page Web.

Les robots d'exploration des moteurs de recherche n'exploreront probablement pas l'intégralité d'Internet. Au lieu de cela, il déterminera l'importance de chaque page Web en fonction de facteurs tels que le nombre d'autres pages qui y renvoient, les pages vues et même l'autorité de la marque. Par conséquent, les robots d’exploration Web détermineront les pages à explorer, l’ordre dans lequel les explorer et la fréquence à laquelle ils doivent explorer les mises à jour.

Par exemple, si vous avez une nouvelle page Web ou si des modifications sont apportées à une page Web existante, le robot d'exploration Web enregistrera et mettra à jour l'index. Ou, si vous avez une nouvelle page Web, vous pouvez demander aux moteurs de recherche d'explorer votre site.

Lorsqu'un robot d'exploration Web est sur votre page, il examine la copie et les balises méta, stocke ces informations et les indexe pour que les moteurs de recherche puissent classer les mots-clés.

Avant que l'ensemble du processus ne commence, les robots d'exploration Web examineront votre fichier robots.txt pour voir quelles pages explorer, c'est pourquoi il est si important pour le référencement technique.

En fin de compte, lorsqu'un robot d'exploration Web explore votre page, il détermine si votre page apparaîtra sur la page de résultats de recherche pour votre requête. Il est important de noter que certains robots d'exploration Web peuvent se comporter différemment des autres. Par exemple, certaines personnes peuvent utiliser différents facteurs pour décider quelles pages sont les plus importantes à explorer.

Maintenant que nous comprenons le fonctionnement des robots d'exploration, nous allons expliquer pourquoi ils devraient explorer votre site Web.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment créer une puissante application de robot d'exploration Web à l'aide de React et Python

Sep 26, 2023 pm 01:04 PM

Comment créer une puissante application de robot d'exploration Web à l'aide de React et Python

Sep 26, 2023 pm 01:04 PM

Comment créer une puissante application de robot d'exploration Web à l'aide de React et Python Introduction : Un robot d'exploration Web est un programme automatisé utilisé pour explorer des données Web via Internet. Avec le développement continu d’Internet et la croissance explosive des données, les robots d’exploration Web deviennent de plus en plus populaires. Cet article explique comment utiliser React et Python, deux technologies populaires, pour créer une puissante application de robot d'exploration Web. Nous explorerons les avantages de React en tant que framework front-end et de Python en tant que moteur d'exploration, et fournirons des exemples de code spécifiques. 1. Pour

Comment écrire un robot d'exploration Web simple en utilisant PHP

Jun 14, 2023 am 08:21 AM

Comment écrire un robot d'exploration Web simple en utilisant PHP

Jun 14, 2023 am 08:21 AM

Un robot d'exploration Web est un programme automatisé qui visite automatiquement les sites Web et en analyse les informations. Cette technologie est de plus en plus courante dans le monde Internet d'aujourd'hui et est largement utilisée dans l'exploration de données, les moteurs de recherche, l'analyse des médias sociaux et d'autres domaines. Si vous souhaitez apprendre à écrire un robot d'exploration Web simple à l'aide de PHP, cet article vous fournira des orientations et des conseils de base. Tout d’abord, vous devez comprendre quelques concepts et techniques de base. Cible d'exploration Avant d'écrire un robot, vous devez sélectionner une cible d'exploration. Il peut s'agir d'un site Web spécifique, d'une page Web spécifique ou de l'intégralité d'Internet.

Qu'est-ce qu'un robot d'exploration Web

Jun 20, 2023 pm 04:36 PM

Qu'est-ce qu'un robot d'exploration Web

Jun 20, 2023 pm 04:36 PM

Un robot d'exploration Web (également connu sous le nom d'araignée Web) est un robot qui recherche et indexe le contenu sur Internet. Essentiellement, les robots d'exploration Web sont chargés de comprendre le contenu d'une page Web afin de le récupérer lorsqu'une requête est effectuée.

Développer des robots d'exploration Web et des outils de récupération de données efficaces à l'aide des langages Vue.js et Perl

Jul 31, 2023 pm 06:43 PM

Développer des robots d'exploration Web et des outils de récupération de données efficaces à l'aide des langages Vue.js et Perl

Jul 31, 2023 pm 06:43 PM

Utilisez les langages Vue.js et Perl pour développer des robots d'exploration Web et des outils de récupération de données efficaces. Ces dernières années, avec le développement rapide d'Internet et l'importance croissante des données, la demande de robots d'exploration Web et d'outils de récupération de données a également augmenté. Dans ce contexte, c'est un bon choix de combiner le langage Vue.js et Perl pour développer des robots d'exploration Web et des outils de scraping de données efficaces. Cet article expliquera comment développer un tel outil à l'aide du langage Vue.js et Perl, et joindra des exemples de code correspondants. 1. Introduction au langage Vue.js et Perl

Notes d'étude PHP : robots d'exploration Web et collecte de données

Oct 08, 2023 pm 12:04 PM

Notes d'étude PHP : robots d'exploration Web et collecte de données

Oct 08, 2023 pm 12:04 PM

Notes d'étude PHP : Robot d'exploration Web et collecte de données Introduction : Un robot d'exploration Web est un outil qui explore automatiquement les données d'Internet. Il peut simuler le comportement humain, parcourir les pages Web et collecter les données requises. En tant que langage de script côté serveur populaire, PHP joue également un rôle important dans le domaine des robots d'exploration Web et de la collecte de données. Cet article explique comment écrire un robot d'exploration Web à l'aide de PHP et fournit des exemples de code pratiques. 1. Principes de base des robots d'exploration Web Les principes de base des robots d'exploration Web sont d'envoyer des requêtes HTTP, de recevoir et d'analyser la réponse H du serveur.

Quelles sont les technologies couramment utilisées pour les robots d'exploration Web ?

Nov 10, 2023 pm 05:44 PM

Quelles sont les technologies couramment utilisées pour les robots d'exploration Web ?

Nov 10, 2023 pm 05:44 PM

Les technologies couramment utilisées pour les robots d'exploration Web incluent la technologie de robot d'exploration ciblée, les stratégies d'exploration basées sur l'évaluation des liens, les stratégies d'exploration basées sur l'évaluation du contenu, la technologie d'exploration ciblée, etc. Introduction détaillée : 1. La technologie de robot d'exploration ciblée est un robot d'exploration Web thématique qui ajoute des modules d'évaluation de liens et d'évaluation de contenu. Le point clé de sa stratégie d'exploration est d'évaluer le contenu de la page et l'importance des liens. les documents, qui contiennent de nombreuses informations structurelles, peuvent être utilisés pour évaluer l'importance des liens ; 3. Stratégies d'exploration basées sur l'évaluation du contenu, etc.

Exemple de développement d'un robot d'exploration Web simple PHP

Jun 13, 2023 pm 06:54 PM

Exemple de développement d'un robot d'exploration Web simple PHP

Jun 13, 2023 pm 06:54 PM

Avec le développement rapide d’Internet, les données sont devenues l’une des ressources les plus importantes à l’ère de l’information d’aujourd’hui. En tant que technologie qui obtient et traite automatiquement les données du réseau, les robots d'exploration Web attirent de plus en plus d'attention et d'applications. Cet article explique comment utiliser PHP pour développer un robot d'exploration Web simple et réaliser la fonction d'obtention automatique de données réseau. 1. Présentation de Web Crawler Le robot d'exploration Web est une technologie qui obtient et traite automatiquement les ressources réseau. Son principal processus de travail consiste à simuler le comportement du navigateur, à accéder automatiquement aux adresses URL spécifiées et à extraire toutes les informations.

Comment utiliser PHP et Swoole pour le développement de robots Web à grande échelle ?

Jul 21, 2023 am 09:09 AM

Comment utiliser PHP et Swoole pour le développement de robots Web à grande échelle ?

Jul 21, 2023 am 09:09 AM

Comment utiliser PHP et Swoole pour le développement de robots Web à grande échelle ? Introduction : Avec le développement rapide d'Internet, le Big Data est devenu l'une des ressources importantes de la société d'aujourd'hui. Afin d’obtenir ces précieuses données, des robots d’exploration Web ont vu le jour. Les robots d'exploration Web peuvent visiter automatiquement divers sites Web sur Internet et en extraire les informations requises. Dans cet article, nous explorerons comment utiliser PHP et l'extension swoole pour développer des robots d'exploration Web efficaces et à grande échelle. 1. Comprendre les principes de base des robots d'exploration Web Les principes de base des robots d'exploration Web sont très simples.