Périphériques technologiques

Périphériques technologiques

IA

IA

Plus besoin d'étiqueter les données, la « compréhension 3D » entre dans l'ère de la pré-formation multimodale ! La série ULIP est entièrement open source et actualise SOTA

Plus besoin d'étiqueter les données, la « compréhension 3D » entre dans l'ère de la pré-formation multimodale ! La série ULIP est entièrement open source et actualise SOTA

Plus besoin d'étiqueter les données, la « compréhension 3D » entre dans l'ère de la pré-formation multimodale ! La série ULIP est entièrement open source et actualise SOTA

Les méthodes de pré-formation multimodales stimulent également le développement de l'apprentissage des représentations 3D en alignant des formes 3D, des images 2D et des descriptions linguistiques correspondantes.

Cependant, le cadre de pré-formation multimodal existantles méthodes de collecte de données manquent d'évolutivité, ce qui limite considérablement le potentiel de l'apprentissage multimodal. Le principal goulot d'étranglement réside dans l'évolutivité et l'exhaustivité des modalités linguistiques.

Récemment, Salesforce AI s'est associé à l'Université Stanford et à l'Université du Texas à Austin pour lancer les projets ULIP (CVP R2023) et ULIP-2, qui ouvrent un nouveau chapitre dans la compréhension de la 3D.

Lien papier : https://arxiv.org/pdf/2212.05171.pdf

Lien papier : https://arxiv.org/pdf/2305.08275.pdf

Lien du code : https://github.com/salesforce/ULIP

Les chercheurs ont utilisé une approche unique pour pré-entraîner le modèle à l'aide de nuages de points 3D, d'images et de texte, en les alignant dans un espace de fonctionnalités unifié. . Cette approche permet d'obtenir des résultats de pointe dans les tâches de classification 3D et ouvre de nouvelles possibilités pour les tâches inter-domaines telles que la récupération d'image en 3D.

Et ULIP-2 rend cette pré-formation multimodale possible sans aucune annotation manuelle, ce qui la rend évolutive à grande échelle.

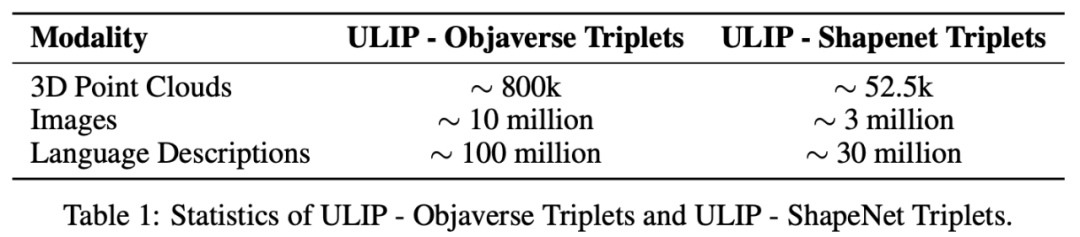

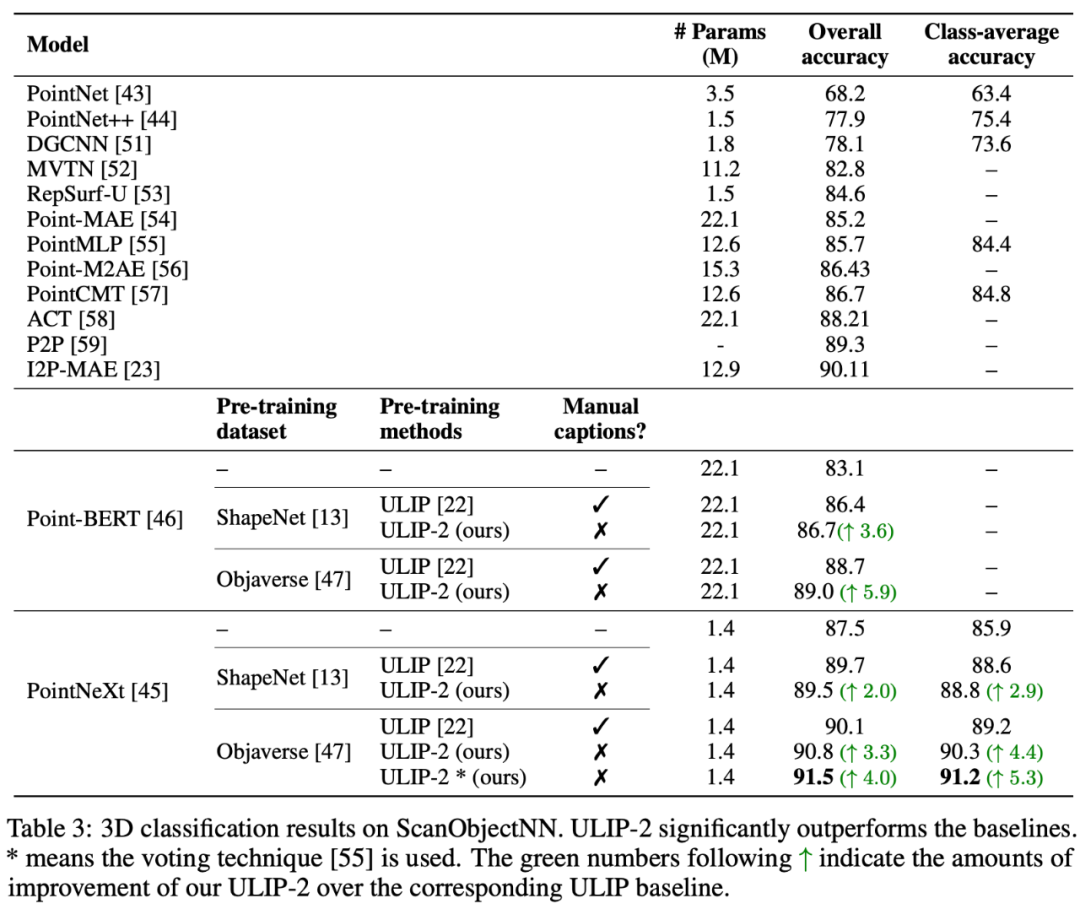

ULIP-2 a obtenu des améliorations significatives des performances sur la classification zéro-shot en aval de ModelNet40, atteignant la précision la plus élevée de 74,0 % sur le benchmark réel ScanObjectNN, il a atteint 91,5 % avec seulement 1,4 million de paramètres. marque une percée dans l'apprentissage de représentations 3D multimodales évolutives sans avoir besoin d'annotation 3D humaine. " ULIP - Objaverse Triplets" et "ULIP - ShapeNet Triplets") sont open source.

Contexte

La compréhension 3D est une partie importante du domaine de l'intelligence artificielle, qui permet aux machines de percevoir et d'interagir dans un espace tridimensionnel comme les humains. Cette capacité a des applications importantes dans des domaines tels que les véhicules autonomes, la robotique, la réalité virtuelle et la réalité augmentée.

Cependant, la compréhension de la 3D a toujours été confrontée à d'énormes défis en raison de la complexité du traitement et de l'interprétation des données 3D, ainsi que du coût de la collecte et de l'annotation des données 3D.

ULIP

Cadre de pré-formation tri-modal et ses tâches en aval

ULIP (déjà accepté par CVPR2023) adopte une approche unique utilisant des nuages de points 3D, des images et du texte est pré -formés sur le modèle pour les aligner dans un espace de représentation unifié.

Cette approche permet d'obtenir des résultats de pointe dans les tâches de classification 3D et ouvre de nouvelles possibilités pour les tâches inter-domaines telles que la récupération d'image en 3D.

Ces encodeurs alignent les caractéristiques des trois modalités dans un espace de représentation unifié, permettant au modèle de comprendre et de classer les objets 3D plus efficacement.

Cet apprentissage amélioré de la représentation 3D améliore non seulement la compréhension du modèle des données 3D, mais rend également possibles des applications multimodales telles que la classification 3D sans plan et la récupération d'image en 3D grâce à l'encodeur 3D. Un contexte multimodal est obtenu.

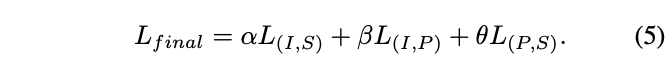

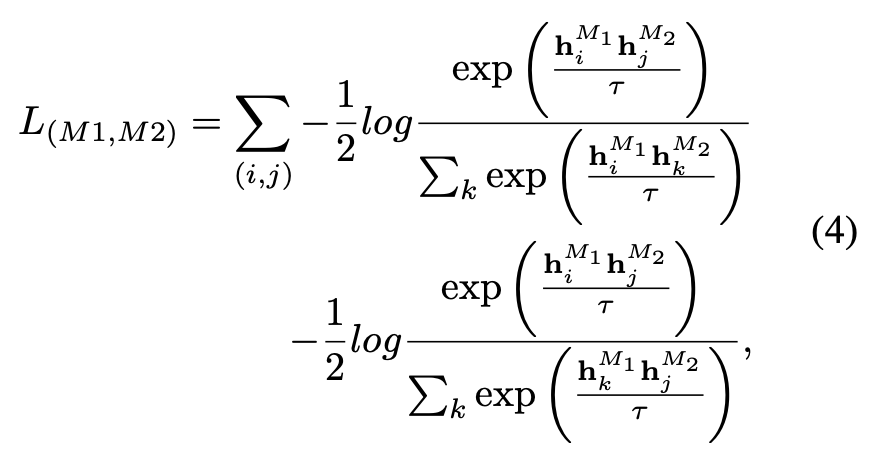

La fonction de perte pré-entraînement de l'ULIP est la suivante :

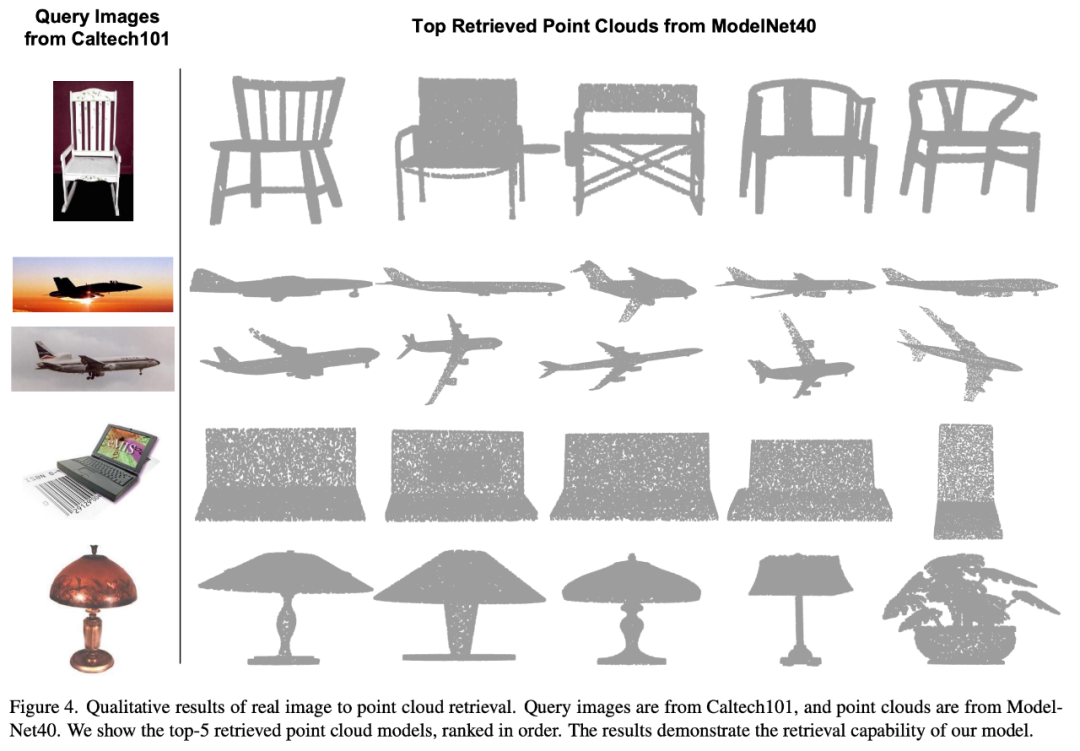

Étonnamment, comparé aux autres modèles 3D récupérés, le premier modèle 3D récupéré a l'apparence la plus proche de l'image de requête.

Par exemple, lorsque nous utilisons des images de différents types d'avions (chasseurs et avions de ligne) pour la récupération (deuxième et troisième lignes), le plus proche récupéré. Le nuage de points 3D préserve toujours les différences subtiles de l’image de requête.

ULIP-2

ULIP -2 Basé sur ULIP, utilisez des modèles multimodaux à grande échelle pour générer des descriptions de langage correspondantes complètes pour les objets 3D, collectant ainsi des données de pré-formation multimodales évolutives sans aucune annotation manuelle, rendant le processus de pré-formation et de post-formation -formation Le modèle est plus efficace et son adaptabilité est renforcée.

ULIP-2 consiste à générer des descriptions multi-angles et dans différents langages pour chaque objet 3D, puis à utiliser ces descriptions pour entraîner le modèle à créer des objets 3D et des images 2D. , Il est aligné sur la description du langage dans l'espace des fonctionnalités.

Ce framework permet la création de grands ensembles de données trimodaux sans annotation manuelle, utilisant ainsi pleinement le potentiel de la pré-formation multimodale.

ULIP-2 a également publié les ensembles de données trimodales à grande échelle générés : "ULIP - Objaverse Triplets" et "ULIP - ShapeNet Triplets".

#🎜🎜 ## 🎜🎜#Résultats expérimentaux La série ULIP a obtenu des résultats étonnants en peaufinant les expériences sur les tâches multimodales en aval et l'expression 3D, en particulier dans ULIP-2 Le pré -la formation peut être réalisée sans aucune annotation manuelle.

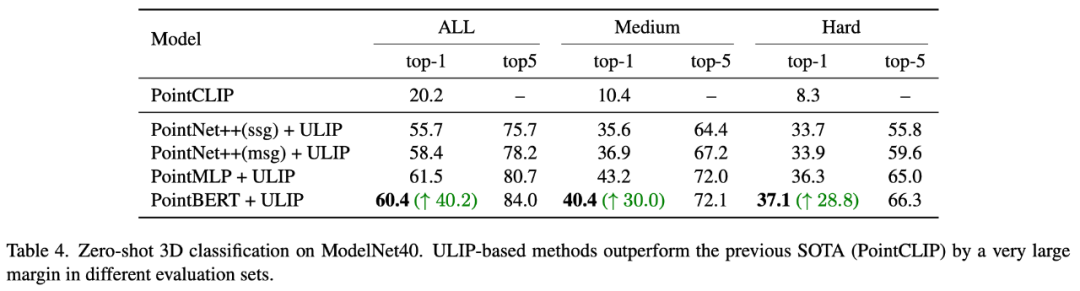

ULIP-2 a obtenu des améliorations significatives (74,0 % de précision top-1) dans la tâche de classification zéro-shot en aval de ModelNet40 sur le benchmark réel ScanObjectNN lors des tests ; , il a atteint une précision globale de 91,5 % en utilisant seulement 1,4 million de paramètres, marquant une percée dans l'apprentissage de représentations 3D multimodales évolutives sans avoir besoin d'annotation 3D manuelle.

Expérience d'ablation

Les deux articles ont mené des expériences d'ablation détaillées.

Les deux articles ont mené des expériences d'ablation détaillées.

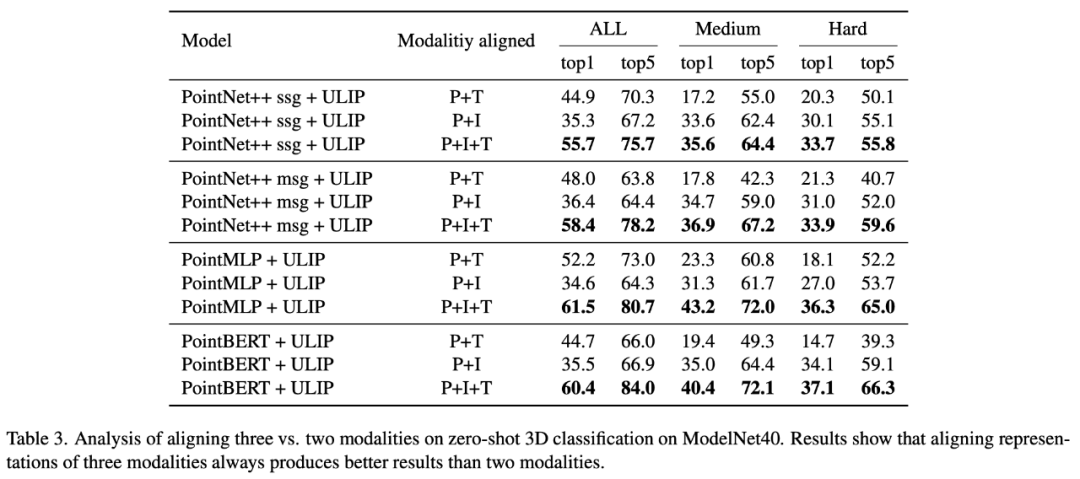

Dans "ULIP : Learning a Unified Representation of Language, Images, and Point Clouds for 3D Understanding", étant donné que le cadre de pré-formation de l'ULIP implique la participation de trois modalités, l'auteur a utilisé des expériences pour explorer s'il fallait aligner seulement deux des Est-il préférable d'aligner un mode ou les trois modes ? Les résultats expérimentaux sont les suivants :

Comme le montrent les résultats expérimentaux, dans différents squelettes 3D, l'alignement de trois modes est plus cohérent que l'alignement. seulement deux Cette modalité est bonne, ce qui prouve également la rationalité du cadre de pré-formation de l'ULIP.

Dans "ULIP-2 : Towards Scalable Multimodal Pre-training for 3D Understanding", l'auteur a exploré l'impact de différents modèles multimodaux à grande échelle sur le cadre pré-entraîné :

.

.

Les résultats expérimentaux montrent que l'effet de la pré-formation du cadre ULIP-2 peut être amélioré avec la mise à niveau du modèle multimodal à grande échelle utilisé, et qu'il présente un certain potentiel de croissance.

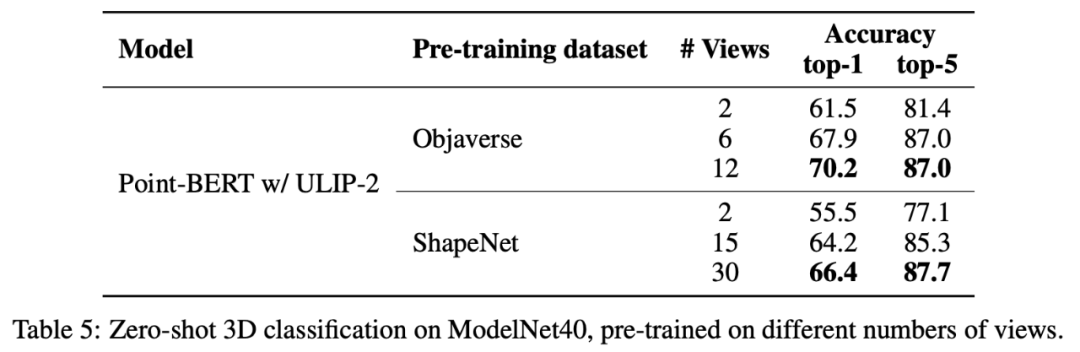

Dans ULIP-2, l'auteur a également exploré comment l'utilisation de différents nombres de vues pour générer l'ensemble de données trimodal affecterait les performances globales de pré-entraînement :

. Résultats expérimentaux Il est montré qu'à mesure que le nombre de vues utilisées augmente, l'effet de la classification zéro du modèle pré-entraîné augmente également.

Cela conforte également le point de l'ULIP-2 selon lequel une description linguistique plus complète et plus diversifiée aura un effet positif sur la pré-formation multimodale.

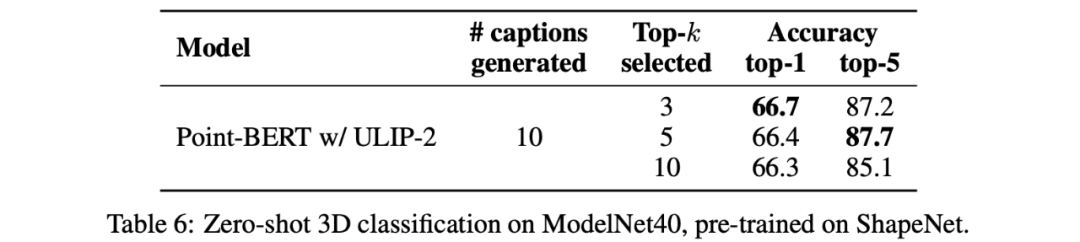

De plus, ULIP-2 a également exploré l'impact de la prise des descriptions linguistiques de différents topk triés par CLIP sur la pré-formation multimodale. Les résultats expérimentaux sont les suivants :

Les résultats expérimentaux. montrent que : Le framework ULIP-2 a un certain degré de robustesse face à différents topk. Top 5 est utilisé comme paramètre par défaut dans l'article.

Conclusion

Le projet ULIP (CVPR2023) et ULIP-2 lancés conjointement par Salesforce AI, l'Université de Stanford et l'Université du Texas à Austin changent le domaine de la compréhension 3D.

ULIP aligne différentes modalités dans un espace unifié, améliorant l'apprentissage des fonctionnalités 3D et permettant des applications multimodales.

ULIP-2 a été développé davantage pour générer des descriptions globales de langage pour les objets 3D, créer et ouvrir la source d'un grand nombre d'ensembles de données trimodaux, et ce processus ne nécessite pas d'annotation manuelle.

Ces projets établissent de nouvelles références en matière de compréhension 3D, ouvrant la voie à un avenir où les machines comprennent véritablement notre monde tridimensionnel.

Équipe

Salesforce AI :

Le Xue, Mingfei Gao, Chen Xing, Ning Yu, Shu Zhang, Junnan Li (Li Junnan), Caiming Xiong (Xiong Caiming), Ran Xu (Xu Ran), Juan Carlos Niebles, Silvio Savarese.

Université de Stanford :

Prof Silvio Savarese, Professeur Juan Carlos Niebles, Professeur Jiajun Wu(Wu Jiajun).

UT Austin :

Prof Roberto Martín-Martín.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Pourquoi le Gaussian Splatting est-il si populaire dans la conduite autonome que le NeRF commence à être abandonné ?

Jan 17, 2024 pm 02:57 PM

Écrit ci-dessus et compréhension personnelle de l'auteur Le Gaussiansplatting tridimensionnel (3DGS) est une technologie transformatrice qui a émergé dans les domaines des champs de rayonnement explicites et de l'infographie ces dernières années. Cette méthode innovante se caractérise par l’utilisation de millions de gaussiennes 3D, ce qui est très différent de la méthode du champ de rayonnement neuronal (NeRF), qui utilise principalement un modèle implicite basé sur les coordonnées pour mapper les coordonnées spatiales aux valeurs des pixels. Avec sa représentation explicite de scènes et ses algorithmes de rendu différenciables, 3DGS garantit non seulement des capacités de rendu en temps réel, mais introduit également un niveau de contrôle et d'édition de scène sans précédent. Cela positionne 3DGS comme un révolutionnaire potentiel pour la reconstruction et la représentation 3D de nouvelle génération. À cette fin, nous fournissons pour la première fois un aperçu systématique des derniers développements et préoccupations dans le domaine du 3DGS.

En savoir plus sur les emojis 3D Fluent dans Microsoft Teams

Apr 24, 2023 pm 10:28 PM

En savoir plus sur les emojis 3D Fluent dans Microsoft Teams

Apr 24, 2023 pm 10:28 PM

N'oubliez pas, surtout si vous êtes un utilisateur de Teams, que Microsoft a ajouté un nouveau lot d'émojis 3DFluent à son application de visioconférence axée sur le travail. Après que Microsoft a annoncé des emojis 3D pour Teams et Windows l'année dernière, le processus a en fait permis de mettre à jour plus de 1 800 emojis existants pour la plate-forme. Cette grande idée et le lancement de la mise à jour des emoji 3DFluent pour les équipes ont été promus pour la première fois via un article de blog officiel. La dernière mise à jour de Teams apporte FluentEmojis à l'application. Microsoft affirme que les 1 800 emojis mis à jour seront disponibles chaque jour.

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

Choisir une caméra ou un lidar ? Une étude récente sur la détection robuste d'objets 3D

Jan 26, 2024 am 11:18 AM

0. Écrit à l'avant&& Compréhension personnelle que les systèmes de conduite autonome s'appuient sur des technologies avancées de perception, de prise de décision et de contrôle, en utilisant divers capteurs (tels que caméras, lidar, radar, etc.) pour percevoir l'environnement et en utilisant des algorithmes et des modèles pour une analyse et une prise de décision en temps réel. Cela permet aux véhicules de reconnaître les panneaux de signalisation, de détecter et de suivre d'autres véhicules, de prédire le comportement des piétons, etc., permettant ainsi de fonctionner en toute sécurité et de s'adapter à des environnements de circulation complexes. Cette technologie attire actuellement une grande attention et est considérée comme un domaine de développement important pour l'avenir des transports. . un. Mais ce qui rend la conduite autonome difficile, c'est de trouver comment faire comprendre à la voiture ce qui se passe autour d'elle. Cela nécessite que l'algorithme de détection d'objets tridimensionnels du système de conduite autonome puisse percevoir et décrire avec précision les objets dans l'environnement, y compris leur emplacement,

CLIP-BEVFormer : superviser explicitement la structure BEVFormer pour améliorer les performances de détection à longue traîne

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer : superviser explicitement la structure BEVFormer pour améliorer les performances de détection à longue traîne

Mar 26, 2024 pm 12:41 PM

Écrit ci-dessus et compréhension personnelle de l'auteur : À l'heure actuelle, dans l'ensemble du système de conduite autonome, le module de perception joue un rôle essentiel. Le véhicule autonome roulant sur la route ne peut obtenir des résultats de perception précis que via le module de perception en aval. dans le système de conduite autonome, prend des jugements et des décisions comportementales opportuns et corrects. Actuellement, les voitures dotées de fonctions de conduite autonome sont généralement équipées d'une variété de capteurs d'informations de données, notamment des capteurs de caméra à vision panoramique, des capteurs lidar et des capteurs radar à ondes millimétriques pour collecter des informations selon différentes modalités afin d'accomplir des tâches de perception précises. L'algorithme de perception BEV basé sur la vision pure est privilégié par l'industrie en raison de son faible coût matériel et de sa facilité de déploiement, et ses résultats peuvent être facilement appliqués à diverses tâches en aval.

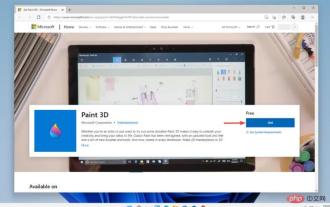

Paint 3D sous Windows 11 : guide de téléchargement, d'installation et d'utilisation

Apr 26, 2023 am 11:28 AM

Paint 3D sous Windows 11 : guide de téléchargement, d'installation et d'utilisation

Apr 26, 2023 am 11:28 AM

Lorsque les rumeurs ont commencé à se répandre selon lesquelles le nouveau Windows 11 était en développement, chaque utilisateur de Microsoft était curieux de savoir à quoi ressemblerait le nouveau système d'exploitation et ce qu'il apporterait. Après de nombreuses spéculations, Windows 11 est là. Le système d'exploitation est livré avec une nouvelle conception et des modifications fonctionnelles. En plus de quelques ajouts, il s’accompagne de fonctionnalités obsolètes et supprimées. L'une des fonctionnalités qui n'existe pas dans Windows 11 est Paint3D. Bien qu'il propose toujours Paint classique, idéal pour les dessinateurs, les griffonneurs et les griffonneurs, il abandonne Paint3D, qui offre des fonctionnalités supplémentaires idéales pour les créateurs 3D. Si vous recherchez des fonctionnalités supplémentaires, nous recommandons Autodesk Maya comme le meilleur logiciel de conception 3D. comme

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Lien du projet écrit devant : https://nianticlabs.github.io/mickey/ Étant donné deux images, la pose de la caméra entre elles peut être estimée en établissant la correspondance entre les images. En règle générale, ces correspondances sont 2D à 2D et nos poses estimées sont à échelle indéterminée. Certaines applications, telles que la réalité augmentée instantanée, à tout moment et en tout lieu, nécessitent une estimation de pose des métriques d'échelle, elles s'appuient donc sur des estimateurs de profondeur externes pour récupérer l'échelle. Cet article propose MicKey, un processus de correspondance de points clés capable de prédire les correspondances métriques dans l'espace d'une caméra 3D. En apprenant la correspondance des coordonnées 3D entre les images, nous sommes en mesure de déduire des métriques relatives.

Obtenez une femme virtuelle en 3D en 30 secondes avec une seule carte ! Text to 3D génère un humain numérique de haute précision avec des détails de pores clairs, se connectant de manière transparente à Maya, Unity et d'autres outils de production.

May 23, 2023 pm 02:34 PM

Obtenez une femme virtuelle en 3D en 30 secondes avec une seule carte ! Text to 3D génère un humain numérique de haute précision avec des détails de pores clairs, se connectant de manière transparente à Maya, Unity et d'autres outils de production.

May 23, 2023 pm 02:34 PM

ChatGPT a injecté une dose de sang de poulet dans l’industrie de l’IA, et tout ce qui était autrefois impensable est devenu aujourd’hui une pratique de base. Le Text-to-3D, qui continue de progresser, est considéré comme le prochain point chaud dans le domaine de l'AIGC après la diffusion (images) et le GPT (texte), et a reçu une attention sans précédent. Non, un produit appelé ChatAvatar a été mis en version bêta publique discrète, recueillant rapidement plus de 700 000 vues et attention, et a été présenté sur Spacesoftheweek. △ChatAvatar prendra également en charge la technologie Imageto3D qui génère des personnages stylisés en 3D à partir de peintures originales à perspective unique/multi-perspective générées par l'IA. Le modèle 3D généré par la version bêta actuelle a reçu une large attention.

'La machine la plus importante jamais construite', Alan Turing et la Machine de Turing

Jun 25, 2023 pm 07:42 PM

'La machine la plus importante jamais construite', Alan Turing et la Machine de Turing

Jun 25, 2023 pm 07:42 PM

L'informatique est un concept familier que la plupart d'entre nous comprennent intuitivement. Prenons la fonction f(x)=x+3 comme exemple. Lorsque x vaut 3, f(3)=3+3. La réponse est 6, très simple. Évidemment, cette fonction est calculable. Mais certaines fonctions ne sont pas si simples, et déterminer si elles peuvent être calculées n’est pas trivial, ce qui signifie qu’elles ne mèneront peut-être jamais à une réponse définitive. En 1928, les mathématiciens allemands David Hilbert et Wilhelm Ackermann proposèrent un problème appelé Entscheidungsproblem (c'est-à-dire « problème de décision »). Au fil du temps, la question qu'ils posent mènera à d'éventuelles