Périphériques technologiques

Périphériques technologiques

IA

IA

Meta lance un modèle d'IA audio qui simule la parole d'une personne réelle en seulement 2 secondes

Meta lance un modèle d'IA audio qui simule la parole d'une personne réelle en seulement 2 secondes

Meta lance un modèle d'IA audio qui simule la parole d'une personne réelle en seulement 2 secondes

Récemment, Meta a publié le modèle Voicebox AI, qui présente des avantages significatifs en matière de simulation audio.

Il est rapporté que Voicebox n'a besoin que d'un échantillon audio de 2 secondes pour identifier avec précision les détails audio et le timbre, et les convertir en sortie vocale en fonction des résultats du texte.

Voicebox est un modèle d'IA génératif qui facilite l'édition audio, l'échantillonnage et le style.

Cette technologie peut être utilisée pour aider les créateurs à éditer facilement des pistes audio à l'avenir, en même temps, elle peut également aider les personnes dont les cordes vocales sont endommagées et les aider à « sonner » à nouveau. Permet aux personnes malvoyantes d'entendre les messages écrits de leurs amis par le biais du son, tout en permettant aux gens de parler n'importe quelle langue étrangère avec leur propre voix.

En même temps, il peut également remplir automatiquement le contenu manquant en fonction du contenu précédent et suivant du clip vocal.

Selon Meta, Voicebox peut fournir des effets vocaux naturels et réalistes pour les assistants IA ou les PNJ dans le futur métaverse, améliorant considérablement l'immersion des utilisateurs lors de son utilisation.

La polyvalence de Voicebox prend en charge une variété de tâches, notamment :

Synthèse contextuelle de synthèse vocale : en utilisant des échantillons audio aussi courts que deux secondes, Voicebox peut faire correspondre les styles audio et les utiliser pour la génération de synthèse vocale.

Édition vocale et réduction du bruit : Voicebox peut recréer des parties de discours interrompues par du bruit ou remplacer des mots mal prononcés sans avoir à réenregistrer l'intégralité du discours. Par exemple, vous pouvez identifier un segment de discours interrompu par un chien qui aboie, le recadrer, puis demander à Voicebox de régénérer le segment, comme une gomme pour l'édition audio.

Conversion multilingue : lorsqu'elle reçoit un échantillon du discours d'une personne et un texte en anglais, français, allemand, espagnol, polonais ou portugais, Voicebox peut générer une lecture de texte dans l'une de ces langues, même si l'échantillon de discours et le texte sont différents. langue. À l'avenir, les gens pourront utiliser cette fonctionnalité pour communiquer de manière plus naturelle et authentique, même s'ils ne comprennent pas les langues.

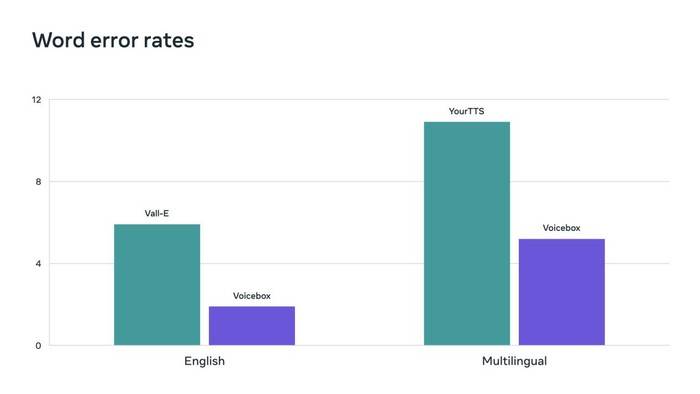

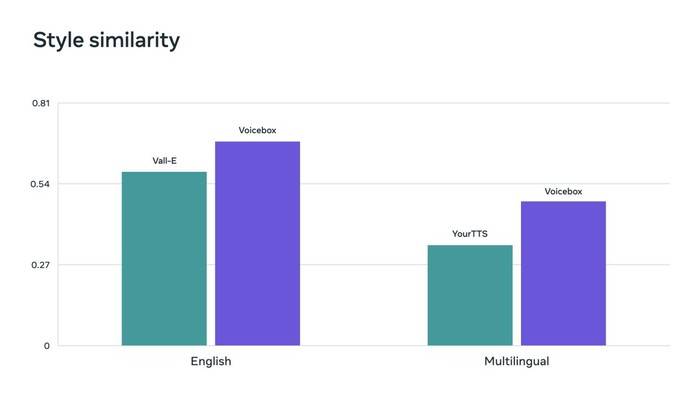

Flow matching est une méthode utilisée par Voicebox qui s'est avérée efficace pour améliorer les performances des modèles de diffusion. Voicebox surpasse VALL-E, le modèle anglais de pointe actuel, en termes d'intelligibilité (taux d'erreur de mot de 5,9 % contre 1,9 %) et de similarité audio (0,580 contre 0,681), tout en étant 20 fois plus rapide. Pour le transfert de styles multilingues, Voicebox surpasse YourTTS, réduisant le taux d'erreur de mot moyen de 10,9 % à 5,2 % et améliorant la similarité audio de 0,335 à 0,481.

Voicebox obtient de nouveaux résultats de pointe, surpassant Vall-E et YourTTS en termes de taux d'erreur de mots.

Voicebox obtient également des résultats de pointe en matière de mesures de similarité de style audio dans les benchmarks anglais et multilingues respectivement.

Il convient de mentionner que Meta est actuellement conscient du préjudice potentiel qui existe lorsque Voicebox est utilisé dans le domaine de la contrefaçon, ils recherchent donc un moyen de faire la distinction entre la parole réelle et la parole générée par Voicebox.

Jusqu'à ce qu'une solution soit trouvée, Meta ne divulguera pas le modèle Voicebox AI au public pour éviter tout préjudice inutile.

Commentaire de l'éditeur : L'IA a désormais été appliquée dans divers domaines. En tant que premier modèle multifonctionnel et efficace permettant de généraliser avec succès des tâches, je pense que Voicebox peut inaugurer une nouvelle ère d'IA de génération vocale. Si Meta ne parvient pas à lutter efficacement contre la fraude audio, la technologie Voicebox peut être désactivée.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

L'événement Meta Connect 2024 est prévu du 25 au 26 septembre et lors de cet événement, la société devrait dévoiler un nouveau casque de réalité virtuelle abordable. Selon la rumeur, il s'agirait du Meta Quest 3S, le casque VR serait apparemment apparu sur la liste FCC. Cela suggère

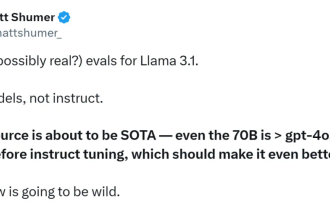

Le premier modèle open source à dépasser le niveau GPT4o ! Llama 3.1 fuite : 405 milliards de paramètres, liens de téléchargement et cartes de modèles sont disponibles

Jul 23, 2024 pm 08:51 PM

Le premier modèle open source à dépasser le niveau GPT4o ! Llama 3.1 fuite : 405 milliards de paramètres, liens de téléchargement et cartes de modèles sont disponibles

Jul 23, 2024 pm 08:51 PM

Préparez votre GPU ! Llama3.1 est finalement apparu, mais la source n'est pas officielle de Meta. Aujourd'hui, la nouvelle divulguée du nouveau grand modèle Llama est devenue virale sur Reddit. En plus du modèle de base, elle comprend également des résultats de référence de 8B, 70B et le paramètre maximum de 405B. La figure ci-dessous montre les résultats de comparaison de chaque version de Llama3.1 avec OpenAIGPT-4o et Llama38B/70B. On peut voir que même la version 70B dépasse GPT-4o sur plusieurs benchmarks. Source de l'image : https://x.com/mattshumer_/status/1815444612414087294 Évidemment, version 3.1 de 8B et 70

Six façons rapides de découvrir le nouveau Llama 3 !

Apr 19, 2024 pm 12:16 PM

Six façons rapides de découvrir le nouveau Llama 3 !

Apr 19, 2024 pm 12:16 PM

Hier soir, Meta a publié les modèles Llama38B et 70B. Le modèle optimisé pour les instructions Llama3 est affiné et optimisé pour les cas d'utilisation de dialogue/chat et surpasse de nombreux modèles de chat open source existants dans les benchmarks courants. Par exemple, Gemma7B et Mistral7B. Le modèle Llama+3 améliore les données et l'échelle et atteint de nouveaux sommets. Il a été formé sur plus de 15 000 jetons de données sur deux clusters GPU 24 000 personnalisés récemment publiés par Meta. Cet ensemble de données de formation est 7 fois plus grand que Llama2 et contient 4 fois plus de code. Cela porte la capacité du modèle Llama au niveau le plus élevé actuel, qui prend en charge des longueurs de texte supérieures à 8 Ko, soit le double de celle de Llama2. sous

Llama3 arrive soudainement ! La communauté open source est à nouveau en ébullition : l'ère de l'accès gratuit aux modèles de niveau GPT4 est arrivée

Apr 19, 2024 pm 12:43 PM

Llama3 arrive soudainement ! La communauté open source est à nouveau en ébullition : l'ère de l'accès gratuit aux modèles de niveau GPT4 est arrivée

Apr 19, 2024 pm 12:43 PM

Llama3 est là ! Tout à l'heure, le site officiel de Meta a été mis à jour et le responsable a annoncé les versions de Llama à 38 milliards et 70 milliards de paramètres. Et c'est un SOTA open source après son lancement : les métadonnées officielles montrent que les versions Llama38B et 70B surpassent tous les adversaires dans leurs échelles de paramètres respectives. Le modèle 8B surpasse Gemma7B et Mistral7BInstruct sur de nombreux benchmarks tels que MMLU, GPQA et HumanEval. Le modèle 70B a surpassé le populaire poulet frit Claude3Sonnet et a fait des allers-retours avec le GeminiPro1.5 de Google. Dès que le lien Huggingface est sorti, la communauté open source est redevenue enthousiasmée. Les étudiants aveugles aux yeux perçants ont également découvert immédiatement

Le modèle le plus puissant Llama 3.1 405B est officiellement lancé, Zuckerberg : l'Open source mène une nouvelle ère

Jul 24, 2024 pm 08:23 PM

Le modèle le plus puissant Llama 3.1 405B est officiellement lancé, Zuckerberg : l'Open source mène une nouvelle ère

Jul 24, 2024 pm 08:23 PM

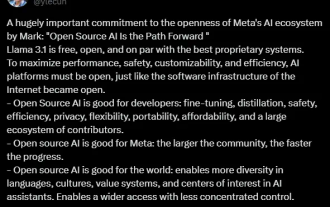

Tout à l'heure, le très attendu Llama 3.1 est officiellement sorti ! Meta a officiellement déclaré que "l'open source mène une nouvelle ère". Sur le blog officiel, Meta a déclaré : « Jusqu'à aujourd'hui, les grands modèles de langage open source étaient pour la plupart à la traîne des modèles fermés en termes de fonctionnalités et de performances. Nous inaugurons désormais une nouvelle ère dirigée par l'open source. Nous avons rendu public MetaLlama3.1405B. , qui, selon nous, est le modèle de base open source le plus grand et le plus puissant au monde, à ce jour, le nombre total de téléchargements de toutes les versions de Llama a dépassé les 300 millions de fois, et nous venons de commencer, le fondateur et PDG de Meta, Zuckerberg. article long "OpenSourceAIIsthePathForward",

Que signifie MÉTA ?

Mar 05, 2024 pm 12:18 PM

Que signifie MÉTA ?

Mar 05, 2024 pm 12:18 PM

META fait généralement référence à un monde virtuel ou à une plateforme appelée Metaverse. Le métaverse est un monde virtuel construit par des humains à l’aide de la technologie numérique qui reflète ou transcende le monde réel et peut interagir avec le monde réel. C’est un espace de vie numérique doté d’un nouveau système social.

Il est prévu qu'en 2024, Meta envisage de lancer un prototype révolutionnaire de lunettes AR appelé 'Orion'.

Jan 04, 2024 pm 09:35 PM

Il est prévu qu'en 2024, Meta envisage de lancer un prototype révolutionnaire de lunettes AR appelé 'Orion'.

Jan 04, 2024 pm 09:35 PM

Selon les informations du 24 décembre, Meta, une entreprise technologique ayant une énorme influence dans l'industrie des médias sociaux, place désormais ses fortes attentes sur les lunettes de réalité augmentée (RA), une technologie considérée comme la plate-forme informatique de nouvelle génération. Récemment, le directeur technique de Meta, Andrew Bosworth, a révélé dans une interview que la société devrait lancer un prototype avancé de lunettes AR nommé « Orion » en 2024. Depuis longtemps, Meta investit dans la technologie AR autant que dans d’autres domaines. Ils ont investi d’énormes sommes d’argent, s’élevant à des milliards de dollars, dans le but de créer un produit révolutionnaire comparable à l’iPhone. Bien qu'ils aient annoncé l'année dernière la fin des projets de production de masse des lunettes Orion,

Un analyste discute du prix de lancement du casque VR Meta Quest 3S

Aug 27, 2024 pm 09:35 PM

Un analyste discute du prix de lancement du casque VR Meta Quest 3S

Aug 27, 2024 pm 09:35 PM

Plus d'un an s'est écoulé depuis la sortie initiale du Quest 3 par Meta (499,99 $ sur Amazon). Depuis lors, Apple a commercialisé le Vision Pro, considérablement plus cher, tandis que Byte Dance a dévoilé le Pico 4 Ultra en Chine. Cependant, il y a