développement back-end

développement back-end

Tutoriel Python

Tutoriel Python

Conseils d'optimisation Scrapy : Comment réduire l'exploration des URL en double et améliorer l'efficacité

Conseils d'optimisation Scrapy : Comment réduire l'exploration des URL en double et améliorer l'efficacité

Conseils d'optimisation Scrapy : Comment réduire l'exploration des URL en double et améliorer l'efficacité

Scrapy est un puissant framework d'exploration Python qui peut être utilisé pour obtenir de grandes quantités de données à partir d'Internet. Cependant, lors du développement de Scrapy, nous rencontrons souvent le problème de l'exploration des URL en double, ce qui fait perdre beaucoup de temps et de ressources et affecte l'efficacité. Cet article présentera quelques techniques d'optimisation de Scrapy pour réduire l'exploration des URL en double et améliorer l'efficacité des robots d'exploration Scrapy.

1. Utilisez les attributs start_urls et Allowed_domains

Dans le robot d'exploration Scrapy, vous pouvez utiliser l'attribut start_urls pour spécifier les URL qui doivent être explorées. Dans le même temps, vous pouvez également utiliser l'attribut Allowed_domains pour spécifier les noms de domaine que le robot d'exploration peut explorer. L'utilisation de ces deux attributs peut aider Scrapy à filtrer rapidement les URL qui n'ont pas besoin d'être explorées, économisant ainsi du temps et des ressources tout en améliorant l'efficacité.

2. Utilisez Scrapy-Redis pour implémenter l'exploration distribuée

Lorsqu'un grand nombre d'URL doivent être explorées, l'exploration sur une seule machine est inefficace, vous pouvez donc envisager d'utiliser la technologie d'exploration distribuée. Scrapy-Redis est un plug-in pour Scrapy qui utilise la base de données Redis pour mettre en œuvre une exploration distribuée et améliorer l'efficacité des robots Scrapy. En définissant les paramètres REDIS_HOST et REDIS_PORT dans le fichier settings.py, vous pouvez spécifier l'adresse et le numéro de port de la base de données Redis à laquelle Scrapy-Redis se connecte pour réaliser une analyse distribuée.

3. Utilisez la technologie d'exploration incrémentielle

Dans le développement du robot Scrapy, nous rencontrons souvent des situations où nous devons explorer la même URL à plusieurs reprises, ce qui entraînera une perte importante de temps et de ressources. Par conséquent, des techniques d’exploration incrémentielle peuvent être utilisées pour réduire les explorations répétées. L'idée de base de la technologie d'exploration incrémentielle est la suivante : enregistrez l'URL analysée et, lors de l'analyse suivante, vérifiez si la même URL a été explorée en fonction de l'enregistrement. Si elle a été explorée, ignorez-la. De cette façon, l’exploration des URL en double peut être réduite et l’efficacité améliorée.

4. Utilisez un middleware pour filtrer les URL en double

En plus de la technologie d'exploration incrémentielle, vous pouvez également utiliser un middleware pour filtrer les URL en double. Le middleware de Scrapy est un processeur personnalisé Lors de l'exécution du robot d'exploration Scrapy, les demandes et les réponses peuvent être traitées via le middleware. Nous pouvons implémenter la déduplication d'URL en écrivant un middleware personnalisé. Parmi elles, la méthode de déduplication la plus couramment utilisée consiste à utiliser la base de données Redis pour enregistrer une liste d'URL qui ont été analysées et à interroger la liste pour déterminer si l'URL a été analysée.

5. Utilisez DupeFilter pour filtrer les URL en double

En plus du middleware personnalisé, Scrapy fournit également un filtre de déduplication intégré DupeFilter, qui peut réduire efficacement l'exploration des URL en double. DupeFilter hache chaque URL et enregistre les valeurs de hachage uniques en mémoire. Par conséquent, pendant le processus d'exploration, seules les URL avec des valeurs de hachage différentes seront explorées. L'utilisation de DupeFilter ne nécessite pas de prise en charge supplémentaire du serveur Redis et constitue une méthode légère de filtrage d'URL en double.

Résumé :

Dans le développement des robots Scrapy, l'exploration des URL en double est un problème courant. Diverses techniques d'optimisation doivent être utilisées pour réduire l'exploration des URL en double et améliorer l'efficacité des robots Scrapy. Cet article présente certaines techniques d'optimisation courantes de Scrapy, notamment l'utilisation des attributs start_urls et Allowed_domains, l'utilisation de Scrapy-Redis pour implémenter l'analyse distribuée, l'utilisation de la technologie d'analyse incrémentielle, l'utilisation d'un middleware personnalisé pour filtrer les URL en double et l'utilisation du DupeFilter intégré pour filtrer les URL en double. . Les lecteurs peuvent choisir des méthodes d'optimisation appropriées en fonction de leurs propres besoins pour améliorer l'efficacité des robots Scrapy.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1359

1359

52

52

Quelle est la différence entre HTML et URL

Mar 06, 2024 pm 03:06 PM

Quelle est la différence entre HTML et URL

Mar 06, 2024 pm 03:06 PM

Différences : 1. Différentes définitions, l'URL est un localisateur de ressources uniforme et le HTML est un langage de balisage hypertexte ; 2. Il peut y avoir plusieurs URL dans un HTML, mais une seule page HTML peut exister dans une URL. 3. HTML fait référence à ; une page Web, et l'url fait référence à l'adresse du site Web.

Interprétation approfondie : Pourquoi Laravel est-il aussi lent qu'un escargot ?

Mar 07, 2024 am 09:54 AM

Interprétation approfondie : Pourquoi Laravel est-il aussi lent qu'un escargot ?

Mar 07, 2024 am 09:54 AM

Laravel est un framework de développement PHP populaire, mais il est parfois critiqué pour sa lenteur comme un escargot. Qu'est-ce qui cause exactement la vitesse insatisfaisante de Laravel ? Cet article fournira une explication détaillée des raisons pour lesquelles Laravel est aussi lent qu'un escargot sous plusieurs aspects, et la combinera avec des exemples de code spécifiques pour aider les lecteurs à mieux comprendre ce problème. 1. Problèmes de performances des requêtes ORM Dans Laravel, ORM (Object Relational Mapping) est une fonctionnalité très puissante qui permet

Discussion sur la stratégie d'optimisation gc de Golang

Mar 06, 2024 pm 02:39 PM

Discussion sur la stratégie d'optimisation gc de Golang

Mar 06, 2024 pm 02:39 PM

Le garbage collection (GC) de Golang a toujours été un sujet brûlant parmi les développeurs. En tant que langage de programmation rapide, le garbage collector intégré de Golang peut très bien gérer la mémoire, mais à mesure que la taille du programme augmente, certains problèmes de performances surviennent parfois. Cet article explorera les stratégies d'optimisation GC de Golang et fournira quelques exemples de code spécifiques. La collecte des déchets dans le garbage collector de Golang Golang est basée sur un balayage de marque simultané (concurrentmark-s

Optimisation des programmes C++ : techniques de réduction de la complexité temporelle

Jun 01, 2024 am 11:19 AM

Optimisation des programmes C++ : techniques de réduction de la complexité temporelle

Jun 01, 2024 am 11:19 AM

La complexité temporelle mesure le temps d'exécution d'un algorithme par rapport à la taille de l'entrée. Les conseils pour réduire la complexité temporelle des programmes C++ incluent : le choix des conteneurs appropriés (tels que vecteur, liste) pour optimiser le stockage et la gestion des données. Utilisez des algorithmes efficaces tels que le tri rapide pour réduire le temps de calcul. Éliminez les opérations multiples pour réduire le double comptage. Utilisez des branches conditionnelles pour éviter les calculs inutiles. Optimisez la recherche linéaire en utilisant des algorithmes plus rapides tels que la recherche binaire.

Décoder les goulots d'étranglement des performances de Laravel : les techniques d'optimisation entièrement révélées !

Mar 06, 2024 pm 02:33 PM

Décoder les goulots d'étranglement des performances de Laravel : les techniques d'optimisation entièrement révélées !

Mar 06, 2024 pm 02:33 PM

Décoder les goulots d'étranglement des performances de Laravel : les techniques d'optimisation entièrement révélées ! Laravel, en tant que framework PHP populaire, offre aux développeurs des fonctions riches et une expérience de développement pratique. Cependant, à mesure que la taille du projet augmente et que le nombre de visites augmente, nous pouvons être confrontés au défi des goulots d'étranglement en matière de performances. Cet article approfondira les techniques d'optimisation des performances de Laravel pour aider les développeurs à découvrir et à résoudre les problèmes de performances potentiels. 1. Optimisation des requêtes de base de données à l'aide du chargement différé d'Eloquent Lorsque vous utilisez Eloquent pour interroger la base de données, évitez

Le goulot d'étranglement des performances de Laravel révélé : la solution d'optimisation révélée !

Mar 07, 2024 pm 01:30 PM

Le goulot d'étranglement des performances de Laravel révélé : la solution d'optimisation révélée !

Mar 07, 2024 pm 01:30 PM

Le goulot d'étranglement des performances de Laravel révélé : la solution d'optimisation révélée ! Avec le développement de la technologie Internet, l’optimisation des performances des sites Web et des applications est devenue de plus en plus importante. En tant que framework PHP populaire, Laravel peut être confronté à des goulots d'étranglement en termes de performances pendant le processus de développement. Cet article explorera les problèmes de performances que les applications Laravel peuvent rencontrer et fournira des solutions d'optimisation et des exemples de code spécifiques afin que les développeurs puissent mieux résoudre ces problèmes. 1. Optimisation des requêtes de base de données Les requêtes de base de données sont l'un des goulots d'étranglement de performances courants dans les applications Web. exister

Comment détecter une URL avec une expression régulière dans Golang ?

May 31, 2024 am 10:32 AM

Comment détecter une URL avec une expression régulière dans Golang ?

May 31, 2024 am 10:32 AM

Les étapes pour détecter les URL dans Golang à l'aide d'expressions régulières sont les suivantes : Compilez le modèle d'expression régulière à l'aide de regexp.MustCompile(pattern). Le modèle doit correspondre aux paramètres de protocole, de nom d'hôte, de port (facultatif), de chemin (facultatif) et de requête (facultatif). Utilisez regexp.MatchString(pattern,url) pour détecter si l'URL correspond au modèle.

Comment optimiser les éléments de démarrage du système WIN7

Mar 26, 2024 pm 06:20 PM

Comment optimiser les éléments de démarrage du système WIN7

Mar 26, 2024 pm 06:20 PM

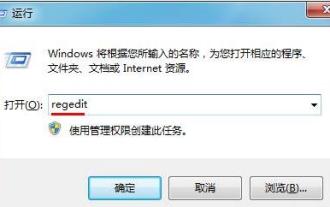

1. Appuyez sur la combinaison de touches (touche Win + R) sur le bureau pour ouvrir la fenêtre d'exécution, puis entrez [regedit] et appuyez sur Entrée pour confirmer. 2. Après avoir ouvert l'éditeur de registre, nous cliquons pour développer [HKEY_CURRENT_USERSoftwareMicrosoftWindowsCurrentVersionExplorer], puis voyons s'il y a un élément Sérialiser dans le répertoire. Sinon, nous pouvons cliquer avec le bouton droit sur Explorateur, créer un nouvel élément et le nommer Sérialiser. 3. Cliquez ensuite sur Sérialiser, puis cliquez avec le bouton droit sur l'espace vide dans le volet de droite, créez une nouvelle valeur de bit DWORD (32) et nommez-la Étoile.