Périphériques technologiques

Périphériques technologiques

IA

IA

Pourquoi le grand modèle de l'institut de recherche sur l'IA le plus puissant de Chine est-il en retard ?

Pourquoi le grand modèle de l'institut de recherche sur l'IA le plus puissant de Chine est-il en retard ?

Pourquoi le grand modèle de l'institut de recherche sur l'IA le plus puissant de Chine est-il en retard ?

Produit par Huxiu Technology Group

Auteur|Qi Jian

Éditeur|Chen Yifan

Image d'en-tête|FlagStudio

"Est-ce qu'OpenAI ouvrira à nouveau les grands modèles open source ?"

Lorsque Zhang Hongjiang, président de l'Institut de recherche Zhiyuan, a interrogé Sam Altman, PDG d'OpenAI, qui a assisté en ligne à la conférence Zhiyuan 2023, sur les problèmes de l'open source, Sam Altman a souri et a déclaré : OpenAI ouvrira plus de codes à l'avenir, mais il y a pas de chronologie Open source spécifique.

Une telle discussion vient de l'un des sujets de cette conférence de sagesse - Grands modèles open source.

Le 9 juin, la Conférence Zhiyuan 2023 s'est tenue à Pékin et tous les sièges étaient pleins. Sur le site de la conférence, des mots liés à l'IA tels que « puissance de calcul », « grand modèle » et « écologie » sont apparus de temps en temps dans les discussions des participants, ainsi que de diverses entreprises de cette chaîne industrielle.

Lors de cette conférence, l'Institut de recherche Zhiyuan a publié le logiciel open source complet Wu Dao 3.0. Y compris La série visuelle de grands modèles "Vision", la série de langages de grands modèles "Sky Eagle" et le système original d'évaluation de grands modèles "Libra".

L'Open source des grands modèles signifie rendre le code du modèle public pour que les développeurs d'IA puissent l'étudier. Le modèle de langage de couche de base « Sky Eagle » dans Wu Dao 3.0 est toujours un modèle disponible dans le commerce, et tout le monde peut utiliser ce grand modèle gratuitement.

Actuellement, les partenaires approfondis de Microsoft OpenAI, Google et BAAI sont les trois institutions à la pointe du domaine de l'intelligence artificielle. « Dans une récente interview, le président de Microsoft, Brad Smith, a mentionné BAAI, l'institution de recherche sur l'IA « la plus puissante » de Chine, aussi célèbre qu'OpenAI et Google. Cette institution est l'Institut de recherche sur l'intelligence artificielle Zhiyuan de Pékin. , la conférence sur l'intelligence artificielle organisée par cet institut est une référence en matière de tendances du secteur

.Chiyuan Research Institute, hautement reconnu par le président de Microsoft, a lancé le projet de grand modèle d'IA « Enlightenment » dès octobre 2020 et a publié deux versions du modèle Enlightenment 1.0 et 2.0. L'échelle des paramètres officiellement annoncée d'Enlightenment 2.0 atteint 1,7 billion. À cette époque, cela ne faisait qu’un an qu’OpenAI avait publié le modèle GPT-3 de 175 milliards de paramètres.

Cependant, un tel pionnier des grands modèles d'IA a été extrêmement discret lors de l'engouement pour les grands modèles d'IA au cours des six derniers mois.

Alors que de grands modèles émergent les uns après les autres parmi les grands fabricants et les start-ups, Zhiyuan est resté « silencieux » envers le monde extérieur pendant plus de trois mois, à l'exception de « SegGPT » qui est entré en collision avec l'IA découpée « SAM » de Meta au début. Avril , presque aucune information sur le grand modèle d'IA n'a été révélée au public.

À cet égard, de nombreuses personnes à l'intérieur et à l'extérieur de l'industrie de l'IA se posent des questions. Pourquoi l'Institut de recherche Zhiyuan, leader dans le domaine des grands modèles d'IA, semble-t-il être en retard dans l'apogée des grands modèles ?

Le modèle open source va-t-il détruire les douves d’OpenAI ?

"Bien que la concurrence pour les grands modèles soit désormais féroce, ni OpenAI ni Google n'ont de fossé, car l'open source est en plein essor dans le domaine des grands modèles d'IA

."Dans un document divulgué par Google, les chercheurs internes de Google estiment que les modèles open source pourraient conduire l'avenir du développement de grands modèles. Le document mentionnait que « Les modèles open source ont des itérations plus rapides, une plus grande personnalisation et bien plus encore. Il y a de la confidentialité et les gens gagneront ». Ne payez pas pour des modèles restreints alors que les alternatives gratuites et sans restriction sont de qualité égale » C'est peut-être l'une des raisons pour lesquelles Intelligent Source a choisi de développer de grands modèles open source.

À l'heure actuelle, il n'existe pas beaucoup de grands modèles commerciaux open source. L'Institut de recherche Zhiyuan a mené une enquête sur certains des grands modèles d'IA qui ont été publiés. Parmi les 39 grands modèles de langage open source publiés à l'étranger, 16 sont disponibles dans le commerce. . Parmi les 28 grands modèles linguistiques publiés en Chine, 11 au total sont des modèles open source, mais un seul d'entre eux est un modèle open source et disponible dans le commerce.

Le grand modèle de langage publié cette fois par Zhiyuan est un modèle open source et disponible dans le commerce. C'est également l'un des rares modèles de grand langage open source actuellement disponibles pour un usage commercial. Cela détermine également qu'un tel modèle doit être plus prudent avant. le libérer.

« En ce qui concerne Zhiyuan, nous ne voulons certainement pas que le modèle open source soit trop laid, nous le publierons donc avec prudence. Un chercheur en IA présent à la conférence de Zhiyuan a déclaré que les modèles open source devront inévitablement l'être. » vérifié à plusieurs reprises et avoir des bugs détectés par un grand nombre de développeurs Afin de garantir la qualité du modèle open source, les progrès de la recherche et du développement de Zhiyuan peuvent avoir été ralentis par « l'open source ».

Huang Tiejun, président de l'Institut de recherche Zhiyuan, estime que l'open source actuel et l'ouverture des grands modèles sur le marché chinois sont loin d'être suffisants. « Nous devrions renforcer davantage l'open source et l'open source et l'open source sont également des compétitions. . S'il existe de très bons standards et de bons algorithmes, proposez-les pour évaluation. Ce n'est qu'en comparant que vous pourrez prouver votre niveau technique ”

.Il y a un manque de transparence lorsque les fabricants nationaux lancent de grands modèles, et beaucoup de gens doutent que ces fabricants aient véritablement mené une recherche et un développement indépendants. Certaines personnes disent qu'elles appellent ChatGPT via l'API, tandis que d'autres disent qu'elles sont formées à l'aide du modèle LLaMA divulgué par les données de réponse Meta + ChatGPT. Le modèle open source coupe ces doutes de la source.

Cependant, Le modèle open source et l’amélioration de la transparence technique ne visent pas à prouver son innocence, mais à réellement « concentrer les efforts pour faire de grandes choses ». Selon les données de Zhiyuan, le coût quotidien de la formation du Tianying Big Language Model est supérieur à 100 000 yuans. Dans le cadre de la tendance générale de la « guerre des centaines de modèles » ou même de la « guerre des milliers de modèles » nationale, de nombreuses industries mènent. un grand nombre de formations répétées inutiles, entraînant des dépenses répétées, peuvent être astronomiques.

Les modèles open source peuvent réduire les formations répétées. Pour les entreprises ayant des besoins en modèles, Utiliser directement de grands modèles d'IA open source et disponibles dans le commerce et les combiner avec leurs propres données pour la formation peut être la meilleure solution pour la mise en œuvre de l'IA et les applications industrielles.

Une autre considération de l'open source est d'accumuler des utilisateurs et des développeurs dès le début afin de construire un bon écosystème et de parvenir à une commercialisation future. Un fondateur d'une grande entreprise de modèles nationale a déclaré à Huxiu : « Les GPT-1 et GPT-2 d'OpenAI sont tous deux de grands modèles open source. Il s'agit d'accumuler des utilisateurs et d'améliorer la reconnaissance du modèle une fois que les capacités du modèle GPT-3 seront pleinement exploitées. Show, la commercialisation deviendra l'accent et ce modèle sera progressivement fermé. Par conséquent, le modèle open source ne sera généralement pas autorisé à la commercialisation. "

Mais évidemment, en tant qu'institution de recherche à but non lucratif, Zhiyuan n'a aucune considération commerciale lorsqu'il s'agit de problèmes open source. Pour Zhiyuan, en termes de modèles open source, d'une part, il espère promouvoir la recherche scientifique et l'innovation dans l'industrie des grands modèles d'IA et accélérer la mise en œuvre industrielle en ouvrant l'open source tels que les modèles sous-jacents. D'un autre côté, vous souhaiterez peut-être également accumuler davantage de commentaires d'utilisateurs basés sur des modèles open source et améliorer la convivialité des grands modèles en ingénierie.

Cependant, les modèles open source ne sont pas « parfaits ».Le directeur technique de l'IA d'une grande usine a déclaré à Huxiu que le marché actuel de commercialisation des grands modèles d'IA peut être divisé en trois niveaux. Le premier niveau est destiné aux principaux acteurs pleinement capables de développer eux-mêmes des modèles, et le deuxième niveau est destiné aux principaux acteurs. ceux qui ont besoin de développer des modèles basés sur des besoins spécifiques.Pour les entreprises qui forment des modèles propriétaires basés sur des scénarios, la troisième couche est destinée aux clients de petite et moyenne taille qui n'ont besoin que de capacités générales de modèle et peuvent utiliser des appels API pour répondre à leurs besoins.

Dans ce contexte, les modèles open source peuvent aider les principaux acteurs dotés de capacités d'auto-recherche à économiser beaucoup de temps et d'argent dans le développement de modèles. Mais pour les entreprises de deuxième et troisième rang, elles doivent mettre en place leurs propres équipes techniques pour former et affiner les modèles. Pour de nombreuses entreprises ayant moins de compétences techniques, cela rendra le processus de mise en œuvre plus compliqué et plus ouvert. la source semble avoir le sentiment que « les choses gratuites sont les plus chères ».

Cette « illumination » n’est plus cette « illumination »

L'Enlightenment 3.0 de Zhiyuan est une série de modèles à grande échelle entièrement repenséeC'est aussi l'une des raisons de sa « sortie tardive ». Puisque nous avons déjà les bases d'Enlightenment 2.0, pourquoi Zhiyuan a-t-il besoin de développer un nouveau système de modèles ?

D'une part, il s'agit de l'ajustement de l'orientation technique du modèle, et d'autre part, cela est dû au « remplacement » des données d'entraînement sous-jacentes du modèle."Wudao 2.0 sera développé en 2021, donc qu'il s'agisse d'un modèle de langage (comme GLM) ou d'un modèle de graphe vincentien (comme CogView), l'architecture algorithmique sur laquelle il est basé est désormais relativement précoce. Dans le passé Depuis environ un an, les architectures de modèles dans des domaines connexes ont subi davantage de vérifications ou d'évolutions. Par exemple, l'architecture uniquement de décodeur utilisée dans les modèles de langage a prouvé qu'avec des données de meilleure qualité, de meilleurs résultats peuvent être obtenus dans les modèles de base avec des paramètres à grande échelle. . Performances de génération. Dans le modèle de graphe de texte, nous sommes passés à la diffusion pour davantage d'innovation. Ainsi, dans Wu Dao 3.0, nous avons adopté ces architectures mises à jour pour le modèle de langage à grande échelle et le modèle de génération de graphe de texte à grande échelle

" Lin Yonghua, adjoint. directeur et ingénieur en chef de l'Institut de recherche Zhiyuan, a déclaré que sur la base de la recherche de modèles passés, Wu Dao 3.0 a été reconstruit dans de nombreuses directions.De plus, Wudao 3.0 a également optimisé et mis à niveau de manière approfondie les données de formation du modèle sous-jacent. Les données chinoises Wudao mises à jour ont été utilisées dans les données de formation, y compris de 2021 à aujourd'hui, et ont fait l'objet d'un nettoyage de qualité plus strict ; d'autre part, un grand nombre de chinois de haute qualité ont augmenté, y compris des livres, de la littérature chinoise, etc. De plus, des ensembles de données de code de haute qualité ont été ajoutés, de sorte que le modèle de base a également subi de grands changements.

Les données de formation du modèle sous-jacentes ne sont pas chinoises, ce qui entraîne des problèmes de compréhension du chinois pour de nombreux modèles nationaux. De nombreux modèles d’IA à grande échelle dans le pays et à l’étranger utilisent des données open source massives provenant de l’étranger pour la formation. Les principales sources incluent le célèbre ensemble de données open source Common Crawl.

Zhiyuan a analysé 1 million de données de pages Web Common Crawl et39 052 pages Web chinoises ont pu être extraites. Du point de vue des sources de sites Web, il existe 25 842 sites Web capables d'extraire le chinois, dont seulement 4 522 ont une adresse IP en Chine continentale, soit seulement 17 %.

Cela réduit non seulement considérablement l'exactitude des données chinoises, mais réduit également la sécurité."Le corpus utilisé pour former le modèle de base affectera largement la conformité, la sécurité et les valeurs générées par les applications AIGC, les modèles affinés et autres contenus. " Lin Yonghua a déclaré que la capacité chinoise du modèle de base de Tianying n'est pas une. traduction simple, mais suffisante Une grande partie des connaissances chinoises sont « intégrées dans ce modèle ». 99 % de ses données Internet chinoises proviennent de sites Web nationaux, et les entreprises peuvent organiser en toute sécurité une formation continue sur cette base.

Dans le même temps, grâce à une grande quantité de traitement et de nettoyage raffinés des données et des chiffres, un modèle avec des performances identiques, voire meilleures, peut être formé avec une petite quantité de données. Ces données peuvent même être aussi faibles que 30 % ou. 40 % de la quantité de données Continuez ou dépassez les modèles open source existants.Maintenant, il semble que cette voie pourrait être une meilleure solution pour Zhiyuan. Car en termes de données de formation, Zhiyuan présente des lacunes par rapport aux constructeurs Internet. Les grandes sociétés Internet disposent de riches données sur les interactions des utilisateurs et d'une grande quantité de données sur les droits d'auteur pour la formation. Il n'y a pas si longtemps, Alibaba Damo Academy vient de publier un ensemble de données de langage vidéo, Youku-mPLUG, dans lequel tout le contenu provient de Youku, une plateforme vidéo appartenant à Alibaba.

Étant donné que

Zhiyuan ne dispose pas d'une base d'utilisateurs approfondie, en termes de données de formation, il ne peut obtenir l'autorisation que par négociation avec le titulaire des droits d'auteur, et les collecter et les accumuler petit à petit grâce à certains projets de données de bien-être public.

Cependant, à l'heure actuelle, l'ensemble de données chinoises de Zhiyuan ne peut être que partiellement open source. La raison principale est que les droits d'auteur des données chinoises sont dispersés entre les mains de diverses institutions. Actuellement, les données de formation de Zhiyuan sont obtenues grâce à la coordination de plusieurs parties. Modèles open source. Recherche en libre accès. La plupart des données ne peuvent être appliquées qu'aux modèles de Zhiyuan et n'ont pas le droit d'être utilisées à des fins secondaires."

Il est absolument nécessaire en Chine d'établir une alliance industrielle pour les ensembles de données, d'unir les détenteurs de droits d'auteur et de mener une planification unifiée des données de formation pour l'intelligence artificielle, mais cela nécessite la sagesse d'une conception de haut niveau. " a déclaré Lin Yonghua à Huxiu. .

Académie militaire de Whampoa dans l'industrie nationale du grand modèleEnlightenment 3.0 raconte une histoire différente de Enlightenment 2.0, et les changements dans l'équipe R&D en font partie. En tant que pionnier de l'industrie des grands modèles d'IA, l'Institut de recherche Zhiyuan est comme l'Académie militaire de Whampoa des grands modèles d'IA nationaux.

Des universitaires de Zhiyuan aux ingénieurs de base, ils sont tous devenus populaires dans l'industrie dans l'engouement actuel pour les grands modèles. L'équipe originale de Zhiyuan a également incubé plusieurs grandes équipes entrepreneuriales modèles.

Avant Wudao 3.0, une grande série de modèles était une combinaison de résultats de recherche publiés conjointement par plusieurs laboratoires externes, mais cette fois, Wudao 3.0 est une série de modèles entièrement auto-développés par l'équipe Zhiyuan.Le modèle Wudao 2.0 est sorti en 2021, comprenant Wenyuan, Wenlan, Wenhui et Wensu. Parmi eux, les deux modèles de base ont été réalisés par deux laboratoires de l'Université Tsinghua. Aujourd'hui, les deux équipes ont fondé leurs propres sociétés et développé leurs propres produits indépendants sous la direction de la recherche et du développement de CPM et GLM.

Parmi eux, le Laboratoire d'ingénierie des connaissances (KEG) de l'Université Tsinghua, la principale équipe de R&D de GLM, a lancé le modèle open source ChatGLM-6B avec Zhipu AI, qui a été largement reconnu par l'industrie, la principale équipe de R&D du département CPM ; d'informatique de l'Université Tsinghua Shenyan Technology, qui est composé de certains membres du Laboratoire de traitement du langage naturel et d'informatique des humanités sociales (THUNLP), a été favorisé par diverses capitales depuis sa création il y a un an lors des deux cycles de financement de cette année. , Tencent Investment, Sequoia China et Qiji Chuangtan et d'autres fonds.

Une personne proche de l'Institut de recherche Zhiyuan a déclaré à Huxiu :

Depuis l'essor des modèles nationaux d'IA à grande échelle, l'équipe Zhiyuan est devenue une « cible de chasse » dans la guerre des talents « L'ensemble de l'équipe R&D a été ciblée par d'autres entreprises ou. chasseurs de têtes."

Dans l'industrie nationale actuelle des grands modèles d'IA, ce qui manque le plus, c'est l'argent, et ce qui manque le plus, ce sont les gens. Recherchez ChatGPT sur les trois plateformes de Liepin, Maimai et BOSS Zhipin. Le salaire mensuel pour les postes titulaires d'une maîtrise et d'un doctorat est généralement supérieur à 30 000, et le plus élevé est de 90 000. "Les grandes entreprises informatiques ne profitent pas beaucoup en termes de salaire. La recherche et le développement de grands modèles d'IA se font tous à un niveau élevé, et le salaire offert par les startups peut être plus compétitif." , a déclaré à Huxiu que la guerre des talents deviendra de plus en plus féroce dans l'industrie de l'IA.« Le double salaire n'est pas du tout compétitif de l'avis de nombreux employés de Zhiyuan, car maintenant ils débauchent des gens avec un salaire cinq fois, voire dix fois supérieur, peu importe votre idéal et la manière dont vous planifiez l'avenir. être difficile. Résistez à la tentation d'un salaire annuel de plus d'un million. " Une personne proche de Zhiyuan a déclaré à Huxiu :

Puisque Zhiyuan est une institution de recherche à but non lucratif, le niveau de salaire est difficile à égaler celui des grandes sociétés Internet ou des startups. de grandes quantités de capital derrière eux par rapport à.

Grâce à la chasse de têtes, Huxiu a appris que le salaire de départ des experts en traitement du langage naturel dépasse actuellement le million. Pour certains salariés aux longues années d’activité et aux bas salaires, il est difficile de ne pas hésiter face à plusieurs fois leur salaire.Cependant, à en juger par les données publiques actuelles de l'Institut de recherche Zhiyuan, la plupart des chefs d'équipe de projet principaux de l'Institut de recherche Zhiyuan sont toujours responsables des projets de recherche et développement de l'Institut de recherche Zhiyuan à temps plein.

«

Les modèles de Wu Dao 3.0 sont tous développés par les propres chercheurs de Zhiyuan, notamment Tianying, Libra et Vision. » Lin Yonghua a déclaré que la force actuelle de R&D de l'Institut de recherche de Zhiyuan a toujours été la meilleure de l'industrie.

Les gens qui changent et veulent changer le monde sont tous sur l'application Huxiu

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

L'application de grands modèles Tencent Yuanbao est en ligne ! Hunyuan est mis à niveau pour créer un assistant IA complet pouvant être transporté n'importe où

Jun 09, 2024 pm 10:38 PM

L'application de grands modèles Tencent Yuanbao est en ligne ! Hunyuan est mis à niveau pour créer un assistant IA complet pouvant être transporté n'importe où

Jun 09, 2024 pm 10:38 PM

Le 30 mai, Tencent a annoncé une mise à niveau complète de son modèle Hunyuan. L'application « Tencent Yuanbao » basée sur le modèle Hunyuan a été officiellement lancée et peut être téléchargée sur les magasins d'applications Apple et Android. Par rapport à la version de l'applet Hunyuan lors de la phase de test précédente, Tencent Yuanbao fournit des fonctionnalités de base telles que la recherche IA, le résumé IA et l'écriture IA pour les scénarios d'efficacité du travail ; pour les scénarios de la vie quotidienne, le gameplay de Yuanbao est également plus riche et fournit de multiples fonctionnalités d'application IA. , et de nouvelles méthodes de jeu telles que la création d'agents personnels sont ajoutées. « Tencent ne s'efforcera pas d'être le premier à créer un grand modèle. » Liu Yuhong, vice-président de Tencent Cloud et responsable du grand modèle Tencent Hunyuan, a déclaré : « Au cours de l'année écoulée, nous avons continué à promouvoir les capacités de Tencent. Grand modèle Tencent Hunyuan. Dans la technologie polonaise riche et massive dans des scénarios commerciaux tout en obtenant un aperçu des besoins réels des utilisateurs.

Lancement du grand modèle Bytedance Beanbao, le service d'IA complet Volcano Engine aide les entreprises à se transformer intelligemment

Jun 05, 2024 pm 07:59 PM

Lancement du grand modèle Bytedance Beanbao, le service d'IA complet Volcano Engine aide les entreprises à se transformer intelligemment

Jun 05, 2024 pm 07:59 PM

Tan Dai, président de Volcano Engine, a déclaré que les entreprises qui souhaitent bien mettre en œuvre de grands modèles sont confrontées à trois défis clés : l'effet de modèle, le coût d'inférence et la difficulté de mise en œuvre : elles doivent disposer d'un bon support de base de grands modèles pour résoudre des problèmes complexes, et elles doivent également avoir une inférence à faible coût. Les services permettent d'utiliser largement de grands modèles, et davantage d'outils, de plates-formes et d'applications sont nécessaires pour aider les entreprises à mettre en œuvre des scénarios. ——Tan Dai, président de Huoshan Engine 01. Le grand modèle de pouf fait ses débuts et est largement utilisé. Le polissage de l'effet de modèle est le défi le plus critique pour la mise en œuvre de l'IA. Tan Dai a souligné que ce n'est que grâce à une utilisation intensive qu'un bon modèle peut être poli. Actuellement, le modèle Doubao traite 120 milliards de jetons de texte et génère 30 millions d'images chaque jour. Afin d'aider les entreprises à mettre en œuvre des scénarios de modèles à grande échelle, le modèle à grande échelle beanbao développé indépendamment par ByteDance sera lancé à travers le volcan.

Grâce à la technologie Shengteng AI, le modèle de transport Qinling·Qinchuan aide Xi'an à construire un centre d'innovation en matière de transport intelligent

Oct 15, 2023 am 08:17 AM

Grâce à la technologie Shengteng AI, le modèle de transport Qinling·Qinchuan aide Xi'an à construire un centre d'innovation en matière de transport intelligent

Oct 15, 2023 am 08:17 AM

« Une complexité élevée, une fragmentation élevée et des domaines interdomaines » ont toujours été les principaux problèmes sur la voie de la mise à niveau numérique et intelligente du secteur des transports. Récemment, le « modèle de trafic Qinling·Qinchuan » avec une échelle de paramètres de 100 milliards, construit conjointement par China Science Vision, le gouvernement du district de Xi'an Yanta et le centre informatique d'intelligence artificielle du futur de Xi'an, est orienté vers le domaine des transports intelligents. et fournit des services à Xi'an et ses environs. La région créera un pivot pour l'innovation en matière de transport intelligent. Le « modèle de trafic Qinling·Qinchuan » combine les données écologiques massives du trafic local de Xi'an dans des scénarios ouverts, l'algorithme avancé original développé indépendamment par China Science Vision et la puissante puissance de calcul de l'IA Shengteng du futur centre informatique d'intelligence artificielle de Xi'an pour fournir la surveillance du réseau routier, les scénarios de transport intelligents tels que la commande d'urgence, la gestion de la maintenance et les déplacements publics entraînent des changements numériques et intelligents. La gestion du trafic présente des caractéristiques différentes selon les villes, et le trafic sur différentes routes

Découverte du framework d'inférence de grands modèles NVIDIA : TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

Découverte du framework d'inférence de grands modèles NVIDIA : TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

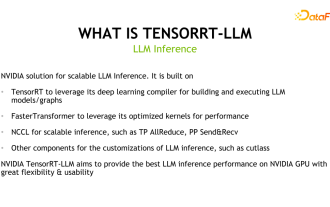

1. Positionnement du produit TensorRT-LLM TensorRT-LLM est une solution d'inférence évolutive développée par NVIDIA pour les grands modèles de langage (LLM). Il crée, compile et exécute des graphiques de calcul basés sur le cadre de compilation d'apprentissage en profondeur TensorRT et s'appuie sur l'implémentation efficace des noyaux dans FastTransformer. De plus, il utilise NCCL pour la communication entre les appareils. Les développeurs peuvent personnaliser les opérateurs pour répondre à des besoins spécifiques en fonction du développement technologique et des différences de demande, comme le développement de GEMM personnalisés basés sur le coutelas. TensorRT-LLM est la solution d'inférence officielle de NVIDIA, engagée à fournir des performances élevées et à améliorer continuellement sa praticité. TensorRT-LL

Référence GPT-4 ! Le grand modèle Jiutian de China Mobile a passé le double enregistrement

Apr 04, 2024 am 09:31 AM

Référence GPT-4 ! Le grand modèle Jiutian de China Mobile a passé le double enregistrement

Apr 04, 2024 am 09:31 AM

Selon des informations du 4 avril, l'Administration du cyberespace de Chine a récemment publié une liste de grands modèles enregistrés, et le « Grand modèle d'interaction du langage naturel Jiutian » de China Mobile y a été inclus, indiquant que le grand modèle Jiutian AI de China Mobile peut officiellement fournir des informations artificielles génératives. services de renseignement vers le monde extérieur. China Mobile a déclaré qu'il s'agit du premier modèle à grande échelle développé par une entreprise centrale à avoir réussi à la fois le double enregistrement national « Enregistrement du service d'intelligence artificielle générative » et le double enregistrement « Enregistrement de l'algorithme de service de synthèse profonde domestique ». Selon les rapports, le grand modèle d'interaction en langage naturel de Jiutian présente les caractéristiques de capacités, de sécurité et de crédibilité améliorées de l'industrie, et prend en charge la localisation complète. Il a formé plusieurs versions de paramètres telles que 9 milliards, 13,9 milliards, 57 milliards et 100 milliards. et peut être déployé de manière flexible dans le Cloud, la périphérie et la fin sont des situations différentes

Nouveau benchmark de test publié, le Llama 3 open source le plus puissant est gêné

Apr 23, 2024 pm 12:13 PM

Nouveau benchmark de test publié, le Llama 3 open source le plus puissant est gêné

Apr 23, 2024 pm 12:13 PM

Si les questions du test sont trop simples, les meilleurs étudiants et les mauvais étudiants peuvent obtenir 90 points, et l'écart ne peut pas être creusé... Avec la sortie plus tard de modèles plus puissants tels que Claude3, Llama3 et même GPT-5, l'industrie est en besoin urgent d'un modèle de référence plus difficile et différencié. LMSYS, l'organisation à l'origine du grand modèle Arena, a lancé la référence de nouvelle génération, Arena-Hard, qui a attiré une large attention. Il existe également la dernière référence pour la force des deux versions affinées des instructions Llama3. Par rapport à MTBench, qui avait des scores similaires auparavant, la discrimination Arena-Hard est passée de 22,6 % à 87,4 %, ce qui est plus fort et plus faible en un coup d'œil. Arena-Hard est construit à partir de données humaines en temps réel provenant de l'arène et a un taux de cohérence de 89,1 % avec les préférences humaines.

Pratique avancée du graphe de connaissances industrielles

Jun 13, 2024 am 11:59 AM

Pratique avancée du graphe de connaissances industrielles

Jun 13, 2024 am 11:59 AM

1. Introduction au contexte Tout d’abord, présentons l’historique du développement de la technologie Yunwen. Yunwen Technology Company... 2023 est la période où les grands modèles prédominent. De nombreuses entreprises pensent que l'importance des graphiques a été considérablement réduite après les grands modèles et que les systèmes d'information prédéfinis étudiés précédemment ne sont plus importants. Cependant, avec la promotion du RAG et la prévalence de la gouvernance des données, nous avons constaté qu'une gouvernance des données plus efficace et des données de haute qualité sont des conditions préalables importantes pour améliorer l'efficacité des grands modèles privatisés. Par conséquent, de plus en plus d'entreprises commencent à y prêter attention. au contenu lié à la construction des connaissances. Cela favorise également la construction et le traitement des connaissances à un niveau supérieur, où de nombreuses techniques et méthodes peuvent être explorées. On voit que l'émergence d'une nouvelle technologie ne détruit pas toutes les anciennes technologies, mais peut également intégrer des technologies nouvelles et anciennes.

Xiaomi Byte unit ses forces ! Un grand modèle de l'accès de Xiao Ai à Doubao : déjà installé sur les téléphones mobiles et SU7

Jun 13, 2024 pm 05:11 PM

Xiaomi Byte unit ses forces ! Un grand modèle de l'accès de Xiao Ai à Doubao : déjà installé sur les téléphones mobiles et SU7

Jun 13, 2024 pm 05:11 PM

Selon les informations du 13 juin, selon le compte public « Volcano Engine » de Byte, l'assistant d'intelligence artificielle de Xiaomi « Xiao Ai » a conclu une coopération avec Volcano Engine. Les deux parties réaliseront une expérience interactive d'IA plus intelligente basée sur le grand modèle beanbao. . Il est rapporté que le modèle beanbao à grande échelle créé par ByteDance peut traiter efficacement jusqu'à 120 milliards de jetons de texte et générer 30 millions de contenus chaque jour. Xiaomi a utilisé le grand modèle Doubao pour améliorer les capacités d'apprentissage et de raisonnement de son propre modèle et créer un nouveau « Xiao Ai Classmate », qui non seulement saisit plus précisément les besoins des utilisateurs, mais offre également une vitesse de réponse plus rapide et des services de contenu plus complets. Par exemple, lorsqu'un utilisateur pose une question sur un concept scientifique complexe, &ldq