Périphériques technologiques

Périphériques technologiques

IA

IA

Basé sur la technologie d'étalonnage de la théorie de l'information, CML rend l'apprentissage automatique multimodal plus fiable

Basé sur la technologie d'étalonnage de la théorie de l'information, CML rend l'apprentissage automatique multimodal plus fiable

Basé sur la technologie d'étalonnage de la théorie de l'information, CML rend l'apprentissage automatique multimodal plus fiable

L'apprentissage automatique multimodal a fait des progrès impressionnants dans divers scénarios. Cependant, la fiabilité des modèles d’apprentissage multimodaux manque de recherches approfondies. "L'information est l'élimination de l'incertitude." L'intention initiale de l'apprentissage automatique multimodal est cohérente avec cela : des modalités supplémentaires peuvent rendre les prédictions plus précises et plus fiables. Cependant, l'article « Calibrating Multimodal Learning » récemment publié à l'ICML2023 a révélé que les méthodes d'apprentissage multimodales actuelles violent cette hypothèse de fiabilité et a effectué une analyse et des corrections détaillées.

Photos

Photos

- Papier Arxiv : https://arxiv.org/abs/2306.01265

- Code GitHub https://github.com /QingyangZhang/CML

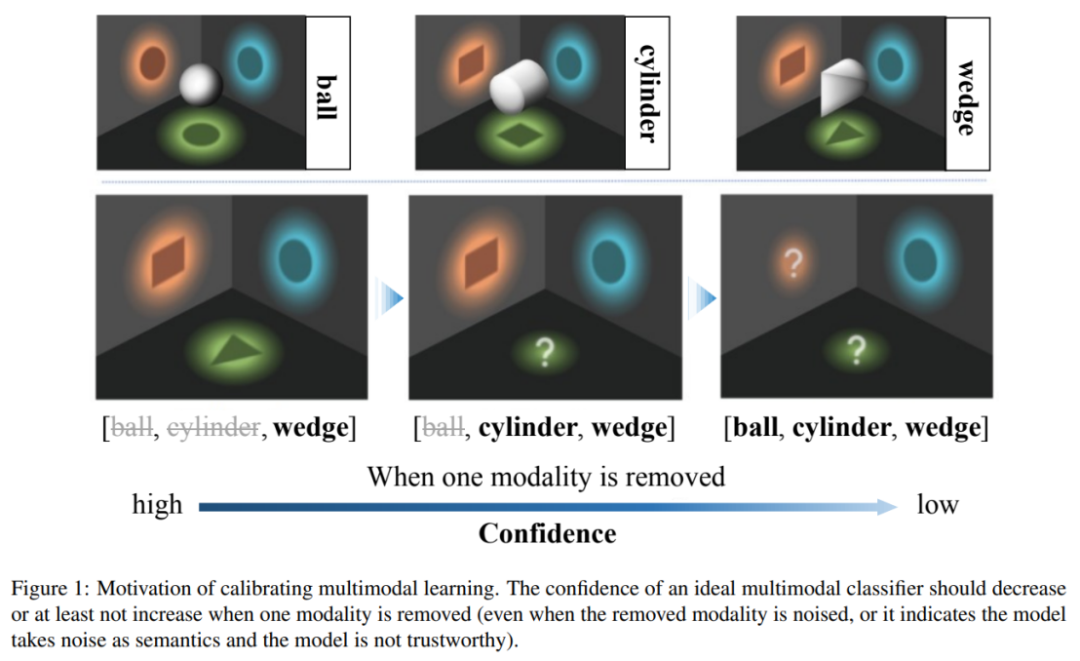

La méthode de classification multimodale actuelle a une confiance peu fiable, c'est-à-dire que lorsque certains modes sont supprimés, le modèle peut produire une confiance plus élevée, ce qui viole la théorie de l'information « l'information est éliminée ». le principe de base. Pour résoudre ce problème, cet article propose la méthode Calibrating Multimodal Learning. Cette méthode peut être déployée dans différents paradigmes d’apprentissage multimodal pour améliorer la rationalité et la crédibilité des modèles d’apprentissage multimodaux.

Pictures

Pictures

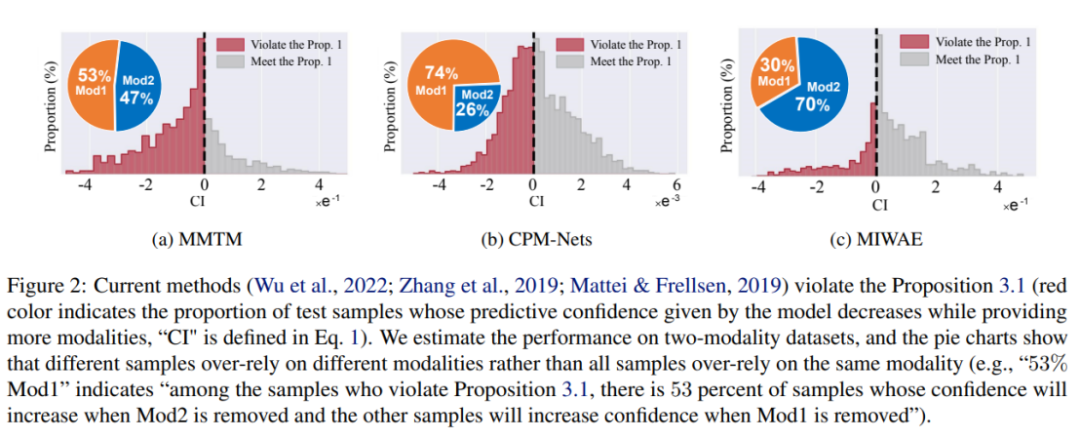

Ce travail souligne que les méthodes d'apprentissage multimodal actuelles ont des problèmes de confiance de prédiction peu fiables, et que les modèles d'apprentissage automatique multimodaux existants ont tendance à s'appuyer sur des modalités partielles pour estimer la confiance. L’étude a notamment révélé que la confiance dans les estimations du modèle actuel augmente lorsque certains modes sont endommagés. Pour résoudre ce problème déraisonnable, les auteurs proposent un principe d’apprentissage multimodal intuitif : lorsque la modalité est supprimée, la confiance dans la prédiction du modèle ne devrait pas augmenter. Cependant, les modèles actuels ont tendance à croire et à se laisser influencer par un sous-ensemble de modalités, plutôt que de considérer toutes les modalités de manière équitable. Cela affecte encore davantage la robustesse du modèle, c'est-à-dire que le modèle est facilement affecté lorsque certains modes sont endommagés.

Pour résoudre les problèmes ci-dessus, certaines méthodes adoptent actuellement des méthodes d'étalonnage d'incertitude existantes, telles que l'échelle de température ou les méthodes d'apprentissage bayésien. Ces méthodes peuvent construire des estimations de confiance plus précises que les méthodes traditionnelles de formation/inférence. Cependant, ces méthodes ne font correspondre que l'estimation de la confiance du résultat final de la fusion avec la précision et ne prennent pas explicitement en compte la relation entre la quantité d'informations modales et la confiance. Par conséquent, elles ne peuvent pas essentiellement améliorer la crédibilité du modèle d'apprentissage multimodal.

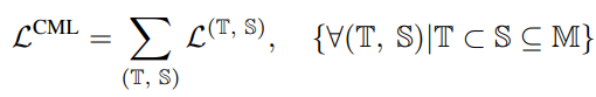

L'auteur propose une nouvelle technique de régularisation appelée « Calibrating Multimodal Learning (CML) ». Cette technique renforce la relation de correspondance entre la confiance des prédictions du modèle et le contenu de l'information en ajoutant un terme de pénalité pour assurer la cohérence entre la confiance de la prédiction et le contenu de l'information. Cette technique est basée sur l’intuition naturelle selon laquelle lorsqu’une modalité est supprimée, la confiance dans la prédiction devrait diminuer (au moins elle ne devrait pas augmenter), ce qui peut intrinsèquement améliorer l’étalonnage de la confiance. Plus précisément, un terme de régularisation simple est proposé pour forcer le modèle à apprendre une relation d'ordre intuitive en ajoutant une pénalité aux échantillons dont la confiance de prédiction augmente lorsqu'une modalité est supprimée :

La contrainte ci-dessus est une perte régulière, qui apparaît comme une pénalité lorsque l'information modale est supprimée et que la confiance augmente.

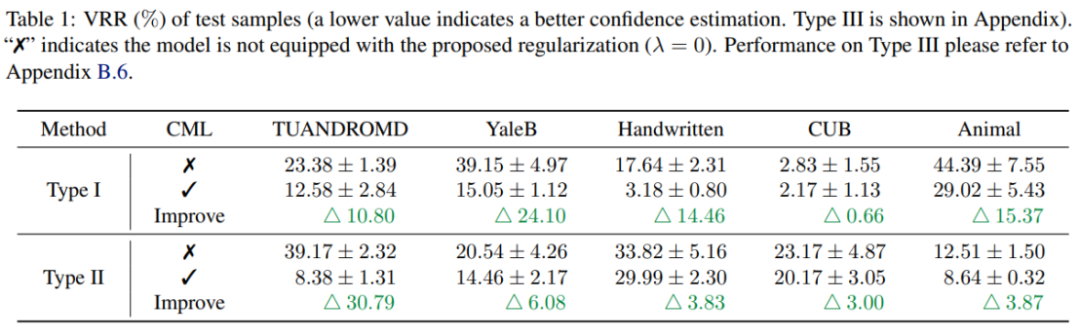

Les résultats expérimentaux montrent que la régularisation CML peut améliorer considérablement la fiabilité de la confiance de prédiction des méthodes d'apprentissage multimodales existantes. De plus, CML peut améliorer la précision de la classification et la robustesse du modèle.

L'apprentissage automatique multimodal a fait des progrès significatifs dans divers scénarios, mais la fiabilité des modèles d'apprentissage automatique multimodal reste un problème qui doit être résolu. Grâce à des recherches empiriques approfondies, cet article révèle que les méthodes de classification multimodales actuelles présentent le problème d'une confiance de prédiction peu fiable et violent les principes de la théorie de l'information. Pour résoudre ce problème, les chercheurs ont proposé la technique de régularisation CML, qui peut être déployée de manière flexible sur les modèles existants et améliorer les performances en termes d'étalonnage de la confiance, d'exactitude de la classification et de robustesse du modèle. On pense que cette nouvelle technologie jouera un rôle important dans le futur apprentissage multimodal et améliorera la fiabilité et la praticité de l’apprentissage automatique.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

1359

1359

52

52

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Cet article vous amènera à comprendre SHAP : explication du modèle pour l'apprentissage automatique

Jun 01, 2024 am 10:58 AM

Dans les domaines de l’apprentissage automatique et de la science des données, l’interprétabilité des modèles a toujours été au centre des préoccupations des chercheurs et des praticiens. Avec l'application généralisée de modèles complexes tels que l'apprentissage profond et les méthodes d'ensemble, la compréhension du processus décisionnel du modèle est devenue particulièrement importante. Explainable AI|XAI contribue à renforcer la confiance dans les modèles d'apprentissage automatique en augmentant la transparence du modèle. L'amélioration de la transparence des modèles peut être obtenue grâce à des méthodes telles que l'utilisation généralisée de plusieurs modèles complexes, ainsi que les processus décisionnels utilisés pour expliquer les modèles. Ces méthodes incluent l'analyse de l'importance des caractéristiques, l'estimation de l'intervalle de prédiction du modèle, les algorithmes d'interprétabilité locale, etc. L'analyse de l'importance des fonctionnalités peut expliquer le processus de prise de décision du modèle en évaluant le degré d'influence du modèle sur les fonctionnalités d'entrée. Estimation de l’intervalle de prédiction du modèle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Implémentation d'algorithmes d'apprentissage automatique en C++ : défis et solutions courants

Jun 03, 2024 pm 01:25 PM

Les défis courants rencontrés par les algorithmes d'apprentissage automatique en C++ incluent la gestion de la mémoire, le multithread, l'optimisation des performances et la maintenabilité. Les solutions incluent l'utilisation de pointeurs intelligents, de bibliothèques de threads modernes, d'instructions SIMD et de bibliothèques tierces, ainsi que le respect des directives de style de codage et l'utilisation d'outils d'automatisation. Des cas pratiques montrent comment utiliser la bibliothèque Eigen pour implémenter des algorithmes de régression linéaire, gérer efficacement la mémoire et utiliser des opérations matricielles hautes performances.

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

IA explicable : Expliquer les modèles IA/ML complexes

Jun 03, 2024 pm 10:08 PM

Traducteur | Revu par Li Rui | Chonglou Les modèles d'intelligence artificielle (IA) et d'apprentissage automatique (ML) deviennent aujourd'hui de plus en plus complexes, et le résultat produit par ces modèles est une boîte noire – impossible à expliquer aux parties prenantes. L'IA explicable (XAI) vise à résoudre ce problème en permettant aux parties prenantes de comprendre comment fonctionnent ces modèles, en s'assurant qu'elles comprennent comment ces modèles prennent réellement des décisions et en garantissant la transparence des systèmes d'IA, la confiance et la responsabilité pour résoudre ce problème. Cet article explore diverses techniques d'intelligence artificielle explicable (XAI) pour illustrer leurs principes sous-jacents. Plusieurs raisons pour lesquelles l’IA explicable est cruciale Confiance et transparence : pour que les systèmes d’IA soient largement acceptés et fiables, les utilisateurs doivent comprendre comment les décisions sont prises

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Surpassant largement le DPO : l'équipe de Chen Danqi a proposé une optimisation simple des préférences SimPO et a également affiné le modèle open source 8B le plus puissant.

Jun 01, 2024 pm 04:41 PM

Afin d'aligner les grands modèles de langage (LLM) sur les valeurs et les intentions humaines, il est essentiel d'apprendre les commentaires humains pour garantir qu'ils sont utiles, honnêtes et inoffensifs. En termes d'alignement du LLM, une méthode efficace est l'apprentissage par renforcement basé sur le retour humain (RLHF). Bien que les résultats de la méthode RLHF soient excellents, certains défis d’optimisation sont impliqués. Cela implique de former un modèle de récompense, puis d'optimiser un modèle politique pour maximiser cette récompense. Récemment, certains chercheurs ont exploré des algorithmes hors ligne plus simples, dont l’optimisation directe des préférences (DPO). DPO apprend le modèle politique directement sur la base des données de préférence en paramétrant la fonction de récompense dans RLHF, éliminant ainsi le besoin d'un modèle de récompense explicite. Cette méthode est simple et stable

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Aucune donnée OpenAI requise, rejoignez la liste des grands modèles de code ! UIUC publie StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

À la pointe de la technologie logicielle, le groupe de l'UIUC Zhang Lingming, en collaboration avec des chercheurs de l'organisation BigCode, a récemment annoncé le modèle de grand code StarCoder2-15B-Instruct. Cette réalisation innovante a permis une percée significative dans les tâches de génération de code, dépassant avec succès CodeLlama-70B-Instruct et atteignant le sommet de la liste des performances de génération de code. Le caractère unique de StarCoder2-15B-Instruct réside dans sa stratégie d'auto-alignement pur. L'ensemble du processus de formation est ouvert, transparent et complètement autonome et contrôlable. Le modèle génère des milliers d'instructions via StarCoder2-15B en réponse au réglage fin du modèle de base StarCoder-15B sans recourir à des annotations manuelles coûteuses.

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

Yolov10 : explication détaillée, déploiement et application en un seul endroit !

Jun 07, 2024 pm 12:05 PM

1. Introduction Au cours des dernières années, les YOLO sont devenus le paradigme dominant dans le domaine de la détection d'objets en temps réel en raison de leur équilibre efficace entre le coût de calcul et les performances de détection. Les chercheurs ont exploré la conception architecturale de YOLO, les objectifs d'optimisation, les stratégies d'expansion des données, etc., et ont réalisé des progrès significatifs. Dans le même temps, le recours à la suppression non maximale (NMS) pour le post-traitement entrave le déploiement de bout en bout de YOLO et affecte négativement la latence d'inférence. Dans les YOLO, la conception de divers composants manque d’une inspection complète et approfondie, ce qui entraîne une redondance informatique importante et limite les capacités du modèle. Il offre une efficacité sous-optimale et un potentiel d’amélioration des performances relativement important. Dans ce travail, l'objectif est d'améliorer encore les limites d'efficacité des performances de YOLO à la fois en post-traitement et en architecture de modèle. à cette fin

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

Cinq écoles d'apprentissage automatique que vous ne connaissez pas

Jun 05, 2024 pm 08:51 PM

L'apprentissage automatique est une branche importante de l'intelligence artificielle qui donne aux ordinateurs la possibilité d'apprendre à partir de données et d'améliorer leurs capacités sans être explicitement programmés. L'apprentissage automatique a un large éventail d'applications dans divers domaines, de la reconnaissance d'images et du traitement du langage naturel aux systèmes de recommandation et à la détection des fraudes, et il change notre façon de vivre. Il existe de nombreuses méthodes et théories différentes dans le domaine de l'apprentissage automatique, parmi lesquelles les cinq méthodes les plus influentes sont appelées les « Cinq écoles d'apprentissage automatique ». Les cinq grandes écoles sont l’école symbolique, l’école connexionniste, l’école évolutionniste, l’école bayésienne et l’école analogique. 1. Le symbolisme, également connu sous le nom de symbolisme, met l'accent sur l'utilisation de symboles pour le raisonnement logique et l'expression des connaissances. Cette école de pensée estime que l'apprentissage est un processus de déduction inversée, à travers les connaissances existantes.