Périphériques technologiques

Périphériques technologiques

IA

IA

Pour les grands modèles d'IA, Tencent Cloud a dévoilé pour la première fois l'intégralité de son réseau informatique haute performance Xingmai qu'il a lui-même développé.

Pour les grands modèles d'IA, Tencent Cloud a dévoilé pour la première fois l'intégralité de son réseau informatique haute performance Xingmai qu'il a lui-même développé.

Pour les grands modèles d'IA, Tencent Cloud a dévoilé pour la première fois l'intégralité de son réseau informatique haute performance Xingmai qu'il a lui-même développé.

L'épidémie d'AIGC pose non seulement des défis en matière de puissance de calcul, mais impose également des exigences sans précédent au réseau.

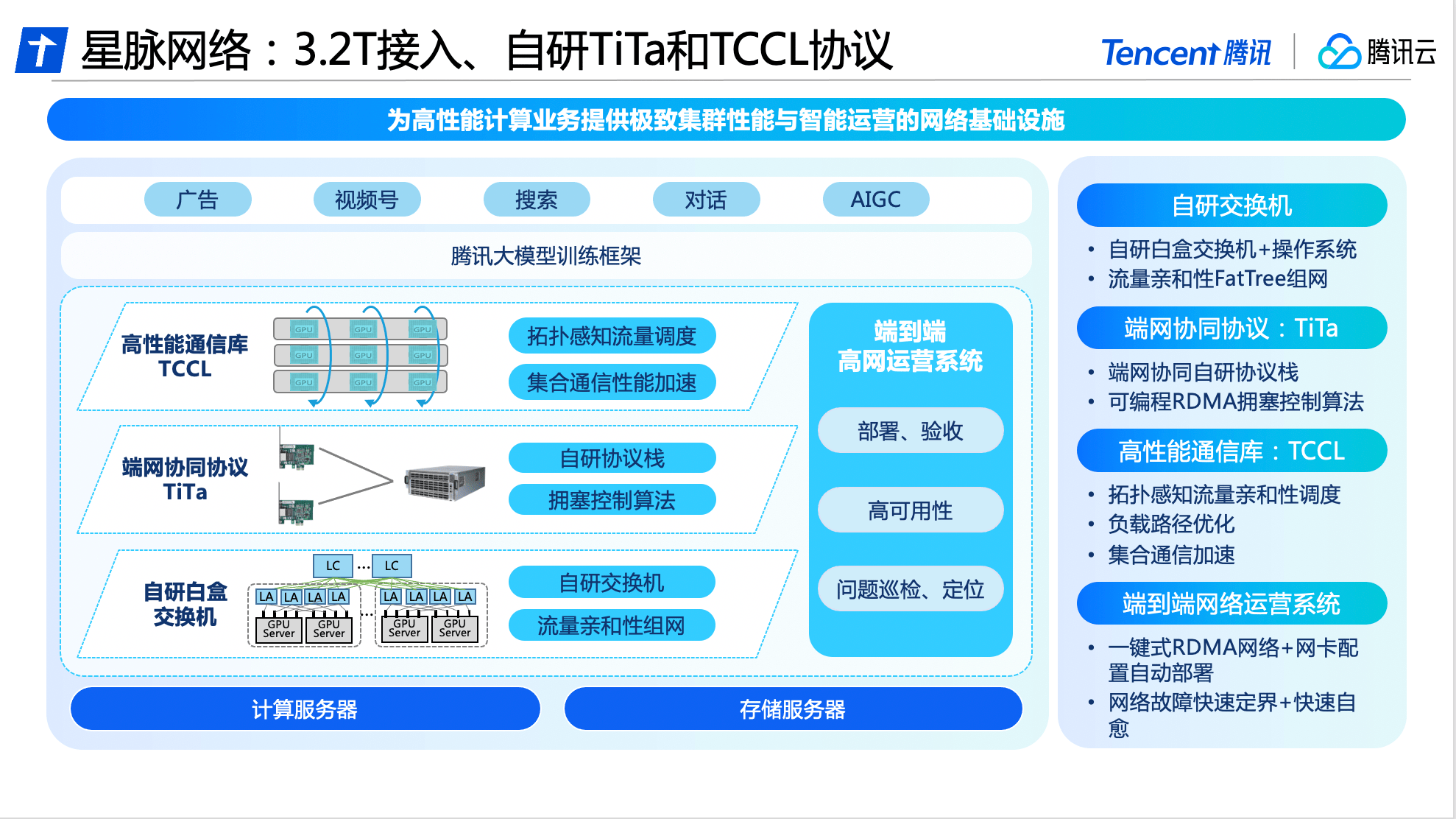

Le 26 juin, Tencent Cloud a dévoilé pour la première fois son réseau informatique haute performance Xingmai auto-développé : le réseau Xingmai possède la bande passante de communication 3,2T la plus élevée du secteur, ce qui peut augmenter l'utilisation du GPU de 40 % et économiser 30 % à 60 %. des modèles. Les coûts de formation apportent une amélioration des performances de communication 10 fois supérieure aux grands modèles d'IA. Le cluster informatique de nouvelle génération HCC de Tencent Cloud peut prendre en charge une énorme échelle informatique de plus de 100 000 cartes.

Wang Yachen, vice-président de Tencent Cloud, a déclaré : « Le réseau Xingmai est né pour les grands modèles. Les services réseau hautes performances qu'il fournit avec une large bande passante, une utilisation élevée et une perte de paquets nulle aideront à briser le goulot d'étranglement de la puissance de calcul et à libérer davantage Potentiel de l'IA, améliorez considérablement l'efficacité de la formation des grands modèles d'entreprise et accélérez la mise à niveau itérative et la mise en œuvre de la technologie des grands modèles sur le cloud.

Construisez un réseau haute performance dédié aux grands modèles et augmentez l'utilisation du GPU de 40%

La popularité de l’AIGC a entraîné une augmentation du nombre de grands paramètres de modèles d’IA, passant de centaines de millions à des milliards. Afin de prendre en charge la formation à grande échelle de données massives, un grand nombre de serveurs forment un cluster informatique via des réseaux à haut débit et sont interconnectés pour effectuer ensemble des tâches de formation.Au contraire, plus le cluster GPU est grand, plus la perte de communication supplémentaire est importante. Un grand cluster ne signifie pas une grande puissance de calcul. L’ère des grands modèles d’IA a posé des défis importants au réseau, notamment des exigences élevées en matière de bande passante, une utilisation élevée et l’absence de perte d’informations.

La bande passante du réseau traditionnel à bas débit ne peut pas satisfaire les grands modèles avec des centaines de milliards ou des milliards de paramètres. Au cours du processus de formation, la proportion de communication peut atteindre 50 %. Dans le même temps, les protocoles réseau traditionnels peuvent facilement entraîner une congestion du réseau, une latence élevée et une perte de paquets, et seulement 0,1 % de la perte de paquets réseau peut entraîner une perte de 50 % de la puissance de calcul, entraînant finalement un gaspillage important de ressources de puissance de calcul.

Basé sur des capacités complètes d'auto-recherche, Tencent Cloud a réalisé des mises à niveau logicielles et matérielles et des innovations dans les commutateurs, les protocoles de communication, les bibliothèques de communication et les systèmes d'exploitation, et est le premier à lancer le grand modèle dédié hautes performances, leader du secteur. réseau - Réseau Xingmai.

En termes de logiciel, le protocole réseau TiTa développé par Tencent Cloud adopte une technologie avancée de contrôle et de gestion de la congestion, qui peut surveiller et ajuster la congestion du réseau en temps réel, répondre aux besoins de communication entre un grand nombre de nœuds de serveur et assurer un échange de données fluide. et une faible latence. Obtenez une perte de paquets nulle sous une charge élevée, ce qui permet à l'efficacité de la communication du cluster d'atteindre plus de 90 %.

De plus, Tencent Cloud a également conçu une bibliothèque de communication collective haute performance TCCL pour Xingmai Network et l'a intégrée dans des solutions personnalisées, permettant au système d'obtenir une perception de la qualité du réseau au niveau de la microseconde. En utilisant un mécanisme de planification dynamique pour allouer raisonnablement les canaux de communication, les interruptions de formation dues à des problèmes de réseau peuvent être efficacement évitées et les retards de communication peuvent être réduits de 40 %.

La disponibilité du réseau détermine également la stabilité informatique de l'ensemble du cluster. Afin d'assurer la haute disponibilité du réseau Xingmai, Tencent Cloud a développé un système d'exploitation réseau complet de bout en bout grâce à la surveillance tridimensionnelle du réseau d'extrémité et au système de positionnement intelligent, les problèmes de réseau d'extrémité sont automatiquement délimités. et analysé, de sorte que le temps global de dépannage puisse être raccourci. Le niveau jour est réduit au niveau minute. Après améliorations, le temps de déploiement global du système de formation de modèles à grande échelle a été réduit à 4,5 jours, garantissant une précision à 100 % de la configuration de base.

Après trois générations d'évolution technologique, nous avons profondément cultivé et étudié l'intégration des logiciels et du matériel

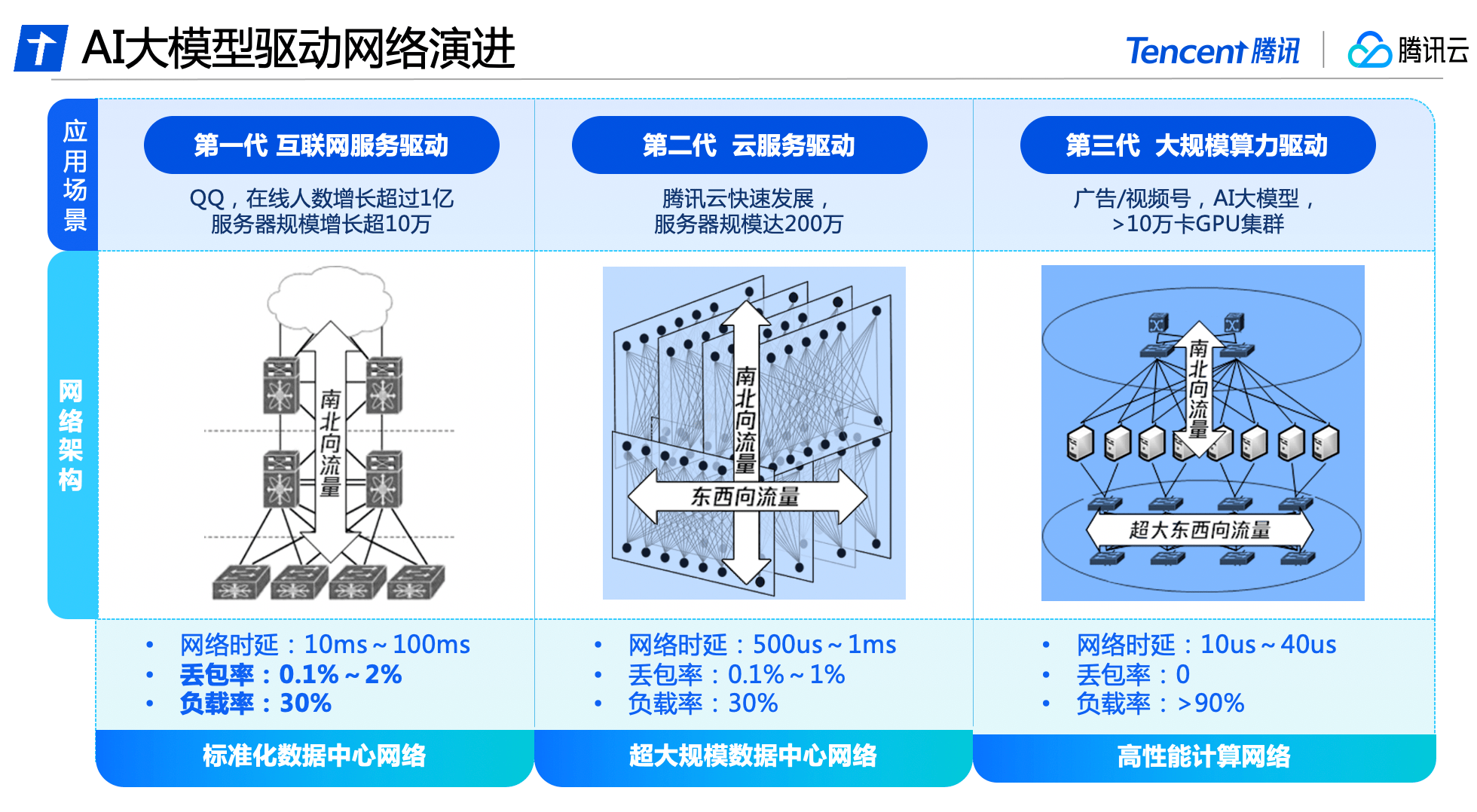

Derrière la mise à niveau complète du réseau Xingmai se trouve le résultat de trois générations d'évolution technologique du réseau de centres de données de Tencent.

Avec l'essor du Big Data et du cloud computing, le trafic est-ouest entre les serveurs a progressivement augmenté et les locataires du cloud ont créé des exigences de virtualisation et d'isolation pour le réseau. L'architecture du réseau du centre de données a progressivement évolué vers une architecture de réseau cloud qui transporte à la fois le trafic nord-sud et est-ouest. Tencent Cloud a construit un équipement réseau et un système de gestion entièrement développés pour créer un réseau de centre de données à très grande échelle. avec près de 2 millions de serveurs.

Tencent Cloud a été le premier à lancer un réseau informatique haute performance en Chine pour répondre aux besoins des grands modèles d'IA, et a adopté une architecture de séparation pour le trafic est-ouest et nord-sud. Il a construit une architecture de réseau indépendante avec une bande passante ultra-large qui répond aux caractéristiques du trafic de formation de l'IA et coopère avec des installations logicielles et matérielles auto-développées pour obtenir une contrôlabilité indépendante de l'ensemble du système et répondre aux nouveaux besoins de super puissance de calcul pour le réseau. performance.

Récemment, Tencent Cloud a lancé une nouvelle génération de cluster de calcul haute performance HCC, basé sur le réseau haute performance Xingmai. Il peut atteindre une bande passante d'interconnexion ultra-élevée de 3,2 T et les performances de puissance de calcul sont 3 fois supérieures à celles de la puissance de calcul. génération précédente. Il est conçu pour la formation de grands modèles d’IA. Base de réseau fiable et performante.

À l'avenir, Tencent Cloud continuera d'investir dans la recherche et le développement de technologies de base pour fournir un support technique solide à la transformation numérique et intelligente de diverses industries.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Les grands modèles d'IA sont très chers et seules les grandes entreprises et les super riches peuvent les utiliser avec succès

Apr 15, 2023 pm 07:34 PM

Les grands modèles d'IA sont très chers et seules les grandes entreprises et les super riches peuvent les utiliser avec succès

Apr 15, 2023 pm 07:34 PM

L'incendie de ChatGPT a déclenché une nouvelle vague d'engouement pour l'IA. Cependant, l'industrie estime généralement que lorsque l'IA entre dans l'ère des grands modèles, seules les grandes entreprises et les entreprises très riches peuvent se permettre l'IA, car la création de grands modèles d'IA coûte très cher. . La première est que cela coûte cher en termes de calcul. Avi Goldfarb, professeur de marketing à l'Université de Toronto, a déclaré : « Si vous souhaitez démarrer une entreprise, développer vous-même un grand modèle de langage et le calculer vous-même, le coût est trop élevé. OpenAI est très cher, coûtant des milliards de dollars. " L'informatique en location sera certainement beaucoup moins chère, mais les entreprises doivent toujours payer des frais élevés à AWS et à d'autres sociétés. Deuxièmement, les données coûtent cher. Les modèles de formation nécessitent des quantités massives de données, parfois les données sont facilement disponibles et parfois non. Des données comme CommonCrawl et LAION peuvent être gratuites

Comment construire un système de gouvernance des données orienté IA ?

Apr 12, 2024 pm 02:31 PM

Comment construire un système de gouvernance des données orienté IA ?

Apr 12, 2024 pm 02:31 PM

Ces dernières années, avec l'émergence de nouveaux modèles technologiques, la valorisation des scénarios d'application dans diverses industries et l'amélioration des effets produits grâce à l'accumulation de données massives, les applications de l'intelligence artificielle ont rayonné dans des domaines tels que la consommation et Internet. aux industries traditionnelles telles que l’industrie manufacturière, l’énergie et l’électricité. La maturité de la technologie de l'intelligence artificielle et son application dans les entreprises de divers secteurs dans les principaux maillons des activités de production économique telles que la conception, l'approvisionnement, la production, la gestion et les ventes s'améliorent constamment, accélérant la mise en œuvre et la couverture de l'intelligence artificielle dans tous les maillons, et l'intégrer progressivement à l'activité principale, afin d'améliorer le statut industriel ou d'optimiser l'efficacité opérationnelle, et d'étendre davantage ses propres avantages. La mise en œuvre à grande échelle d'applications innovantes de la technologie de l'intelligence artificielle a favorisé le développement vigoureux du marché de l'intelligence Big Data et a également injecté une vitalité au marché dans les services sous-jacents de gouvernance des données. Avec le big data, le cloud computing et l'informatique

Vulgarisation scientifique : Qu'est-ce qu'un grand modèle d'IA ?

Jun 29, 2023 am 08:37 AM

Vulgarisation scientifique : Qu'est-ce qu'un grand modèle d'IA ?

Jun 29, 2023 am 08:37 AM

Les grands modèles d’IA font référence à des modèles d’intelligence artificielle entraînés à l’aide de données à grande échelle et d’une puissance de calcul puissante. Ces modèles ont généralement un haut degré de précision et de capacités de généralisation et peuvent être appliqués à divers domaines tels que le traitement du langage naturel, la reconnaissance d'images, la reconnaissance vocale, etc. La formation de grands modèles d'IA nécessite une grande quantité de données et de ressources informatiques, et il est généralement nécessaire d'utiliser un cadre informatique distribué pour accélérer le processus de formation. Le processus de formation de ces modèles est très complexe et nécessite une recherche approfondie et une optimisation de la distribution des données, de la sélection des fonctionnalités, de la structure du modèle, etc. Les grands modèles d'IA ont un large éventail d'applications et peuvent être utilisés dans divers scénarios, tels que le service client intelligent, les maisons intelligentes, la conduite autonome, etc. Dans ces applications, les grands modèles d’IA peuvent aider les utilisateurs à effectuer diverses tâches plus rapidement et plus précisément, et à améliorer l’efficacité du travail.

Comment développer des fonctions de calcul haute performance à l'aide de Redis et TypeScript

Sep 20, 2023 am 11:21 AM

Comment développer des fonctions de calcul haute performance à l'aide de Redis et TypeScript

Sep 20, 2023 am 11:21 AM

Présentation de l'utilisation de Redis et TypeScript pour développer des fonctions de calcul hautes performances : Redis est un système de stockage de structure de données en mémoire open source offrant des performances et une évolutivité élevées. TypeScript est un sur-ensemble de JavaScript qui fournit un système de types et une meilleure prise en charge des outils de développement. En combinant Redis et TypeScript, nous pouvons développer des fonctions informatiques efficaces pour traiter de grands ensembles de données et exploiter pleinement les capacités de stockage et de calcul de la mémoire de Redis. Cet article vous montrera comment

À l'ère des grands modèles d'IA, les nouvelles bases de stockage de données favorisent la transition vers l'intelligence numérique de l'éducation et de la recherche scientifique

Jul 21, 2023 pm 09:53 PM

À l'ère des grands modèles d'IA, les nouvelles bases de stockage de données favorisent la transition vers l'intelligence numérique de l'éducation et de la recherche scientifique

Jul 21, 2023 pm 09:53 PM

L'IA générative (AIGC) a ouvert une nouvelle ère d'intelligence artificielle générale. La concurrence autour des grands modèles est devenue spectaculaire. L'infrastructure informatique est le principal objectif de la concurrence, et la prise de pouvoir devient de plus en plus un consensus industriel. Dans la nouvelle ère, les grands modèles passent d'une modalité unique à une multimodalité, la taille des paramètres et des ensembles de données d'entraînement augmente de façon exponentielle et les données massives non structurées nécessitent en même temps la prise en charge de capacités de charge mixtes hautes performances ; gourmand en données Le nouveau paradigme gagne en popularité et les scénarios d'application tels que le calcul intensif et le calcul haute performance (HPC) évoluent en profondeur. Les bases de stockage de données existantes ne sont plus en mesure de répondre aux besoins en constante évolution. Si la puissance de calcul, les algorithmes et les données constituent la « troïka » qui conduit le développement de l'intelligence artificielle, alors dans le contexte d'énormes changements dans l'environnement externe, les trois doivent de toute urgence retrouver un dynamisme

Né pour l'IA : Samsung annonce qu'il mettra en production la mémoire vidéo HBM4 en 2025, en compétition pour le leadership dans le calcul haute performance

Oct 13, 2023 pm 02:17 PM

Né pour l'IA : Samsung annonce qu'il mettra en production la mémoire vidéo HBM4 en 2025, en compétition pour le leadership dans le calcul haute performance

Oct 13, 2023 pm 02:17 PM

L'augmentation rapide de la puissance de calcul de l'IA ces dernières années a fait des cartes informatiques une nouvelle cible pour les grands fabricants de matériel. En particulier, les cartes informatiques lancées par des sociétés comme NVIDIA sont rares en plus des puissants GPU de NVIDIA, y compris les fabricants de stockage Samsung tels que. Hynix et Hynix ne veulent pas non plus manquer ce festin de l'IA, en particulier les cartes informatiques hautes performances qui nécessitent une mémoire graphique haute performance qu'elles produisent. Actuellement, un cadre supérieur dans le domaine du stockage de Samsung a publié un document indiquant que Samsung envisage de le faire. produire en masse la dernière mémoire en 2025. Mémoire vidéo HBM4, dépassant ainsi Hynix. En 2016, Samsung a officiellement lancé la production en série de mémoire vidéo HBM. Par rapport à la mémoire vidéo GDDR, la mémoire vidéo HBM a une bande passante plus grande, permettant ainsi une transmission de plus hautes performances. Sur le marché grand public, les Radeon d'AMD

Vivo lance un modèle d'IA polyvalent auto-développé - Blue Heart Model

Nov 01, 2023 pm 02:37 PM

Vivo lance un modèle d'IA polyvalent auto-développé - Blue Heart Model

Nov 01, 2023 pm 02:37 PM

Vivo a publié sa matrice de grands modèles d'intelligence artificielle générale auto-développée - le modèle Blue Heart lors de la conférence des développeurs 2023 le 1er novembre. Vivo a annoncé que le modèle Blue Heart lancerait 5 modèles avec différents niveaux de paramètres, respectivement. : milliards, dizaines de milliards et centaines de milliards, couvrant les scénarios de base, et ses capacités de modèle occupent une position de leader dans l'industrie. Vivo estime qu'un bon grand modèle auto-développé doit répondre aux cinq exigences suivantes : des fonctions complètes à grande échelle, des algorithmes puissants, une évolution sûre et fiable, indépendante, et doit être largement open source. Le contenu réécrit est le suivant : Parmi eux. , le premier est le modèle Blue Heart Model 7B, qui est un modèle de niveau 7 milliards, conçu pour fournir un double service pour les téléphones mobiles et le cloud. Vivo a déclaré que ce modèle peut être utilisé dans des domaines tels que la compréhension du langage et la création de textes.

En ce qui concerne le cerveau humain, apprendre à oublier améliorera-t-il les grands modèles d'IA ?

Mar 12, 2024 pm 02:43 PM

En ce qui concerne le cerveau humain, apprendre à oublier améliorera-t-il les grands modèles d'IA ?

Mar 12, 2024 pm 02:43 PM

Récemment, une équipe d’informaticiens a développé un modèle d’apprentissage automatique plus flexible et plus résilient, capable d’oublier périodiquement des informations connues, une fonctionnalité que l’on ne trouve pas dans les modèles de langage à grande échelle existants. Les mesures réelles montrent que dans de nombreux cas, la « méthode d'oubli » est très efficace dans l'entraînement et que le modèle d'oubli sera plus performant. Jea Kwon, ingénieur en IA à l'Institut des sciences fondamentales de Corée, a déclaré que ces nouvelles recherches signifiaient des progrès significatifs dans le domaine de l'IA. L'efficacité de la formation par « méthode d'oubli » est très élevée. La plupart des moteurs de langage d'IA grand public actuels utilisent la technologie des réseaux neuronaux artificiels. Chaque « neurone » de cette structure de réseau est en réalité une fonction mathématique. Ils sont connectés les uns aux autres pour recevoir et transmettre des informations.