Dans le monde magique d'AIGC, on peut changer et combiner les images que l'on veut en "glissant" sur l'image. Par exemple, laissez un lion tourner la tête et ouvrir la gueule :

La recherche pour obtenir cet effet vient de L'article "Drag", dirigé par l'auteur chinois Your GAN, a été publié le mois dernier et a été accepté par la conférence SIGGRAPH 2023.

Plus d'un mois s'est écoulé et l'équipe de recherche a récemment publié le code officiel. En seulement trois jours, le nombre d'étoiles a dépassé les 23 000, ce qui montre sa popularité.

Photo

Photo

Adresse GitHub : https://github.com/XingangPan/ DragGAN

Par coïncidence, une autre recherche similaire aujourd'hui - DragDiffusion est apparue aux yeux des gens. Le précédent DragGAN implémentait une édition d'image interactive basée sur des points et obtenait des effets d'édition de précision au niveau des pixels. Cependant, DragGAN présente également des inconvénients. Il est basé sur un réseau contradictoire génératif (GAN), et sa polyvalence est limitée par la capacité du modèle GAN pré-entraîné.

Dans une nouvelle recherche, plusieurs chercheurs de l'Université nationale de Singapour et ByteDance ont étendu ce type de cadre d'édition à un modèle de diffusion, en proposant DragDiffusion. Ils exploitent des modèles de diffusion pré-entraînés à grande échelle pour améliorer considérablement l’applicabilité de l’édition interactive basée sur des points dans des scénarios réels.

Bien que la plupart des méthodes actuelles d'édition d'images basées sur la diffusion conviennent à l'intégration de texte, DragDiffusion optimise la représentation latente de diffusion pour obtenir un contrôle spatial précis.

Photo

Photo

Les chercheurs ont déclaré que le modèle de diffusion génère des images de manière itérative L'optimisation "en une étape" de la représentation latente de diffusion suffit à générer des résultats cohérents, permettant à DragDiffusion de réaliser efficacement un montage de haute qualité.

Ils ont mené des expériences approfondies dans divers scénarios difficiles (tels que plusieurs objets, différentes catégories d'objets) pour vérifier la plasticité et la polyvalence de DragDiffusion. Le code correspondant sera également publié bientôt,

Voyons comment fonctionne DragDiffusion.

Tout d'abord, nous voulons relever la tête du chaton dans l'image ci-dessous. Il suffit à l'utilisateur de faire glisser le point rouge vers le point bleu.

Ensuite, nous voulons rendre la montagne un peu plus haute, pas de problème, faites glisser le rouge Les points clés sont ça suffit :

Picture

Picture

J'ai toujours envie de tourner la sculpture tête, il suffit de la faire glisser :

J'ai toujours envie de tourner la sculpture tête, il suffit de la faire glisser :

Picture

Picture

#🎜🎜 # Laisse les fleurs sur le rivage fleurit plus largement :

Laisse les fleurs sur le rivage fleurit plus largement :

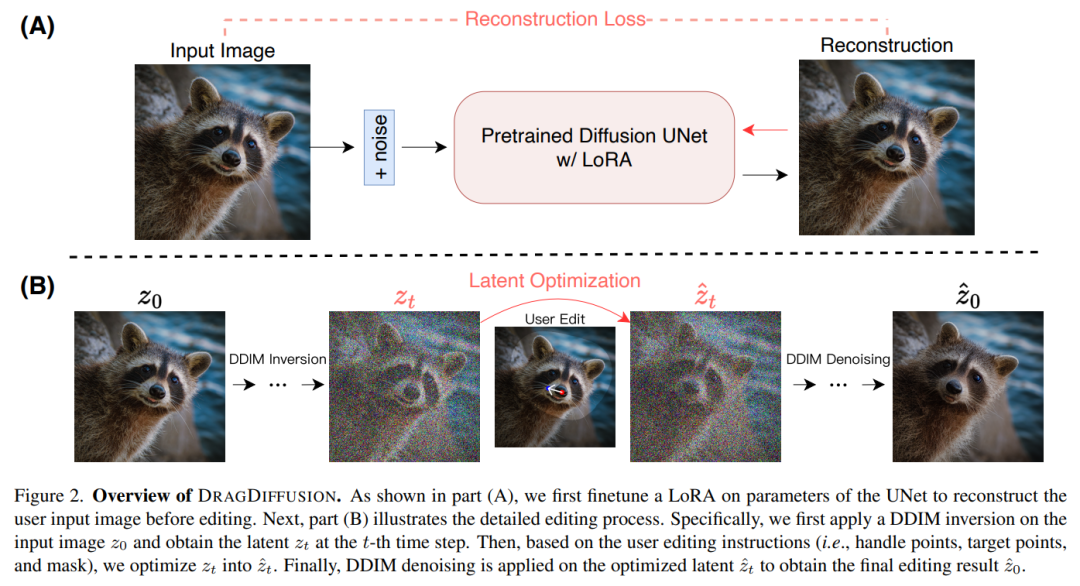

Pour atteindre cet objectif, la recherche a d'abord affiné LoRA sur la base du modèle de diffusion pour reconstruire l'image saisie par l'utilisateur. Cela garantit que les styles des images d’entrée et de sortie restent cohérents.

Ensuite, les chercheurs ont utilisé l'inversion DDIM (qui est une méthode pour explorer la transformation inverse et le fonctionnement de l'espace latent du modèle de diffusion) sur l'image d'entrée pour obtenir la variable latente de diffusion à une étape spécifique.

Pendant le processus d'édition, le chercheur a utilisé à plusieurs reprises la supervision de mouvement et le suivi de points pour optimiser la variable latente de diffusion précédemment obtenue à l'étape t, « faisant ainsi glisser » le contenu du point de traitement vers l'emplacement cible. Le processus d'édition applique également un terme de régularisation pour garantir que les zones non masquées de l'image restent inchangées.

Enfin, utilisez DDIM pour débruiter les variables latentes optimisées à l'étape t afin d'obtenir les résultats édités. L'aperçu général est le suivant :

Images

Images

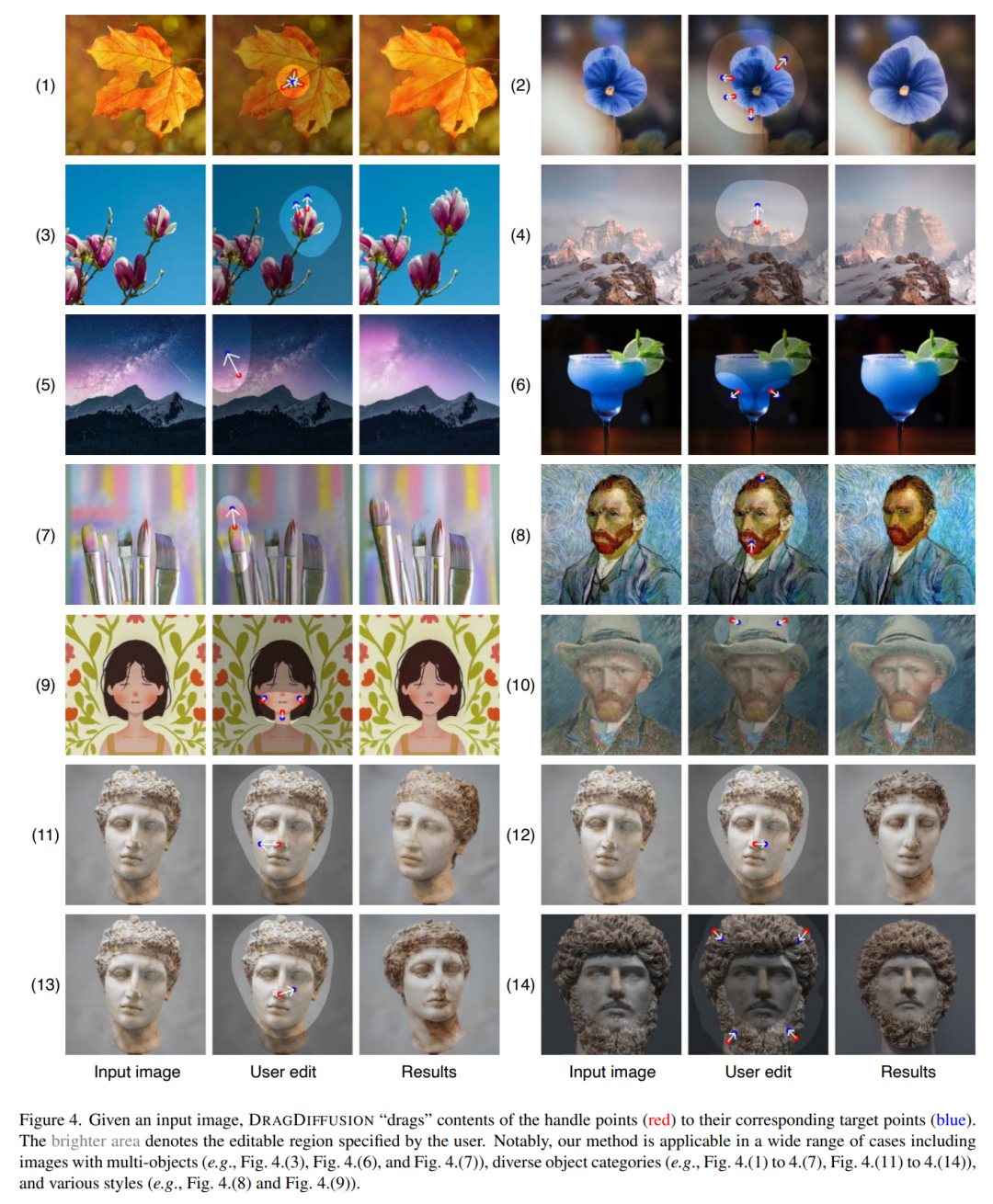

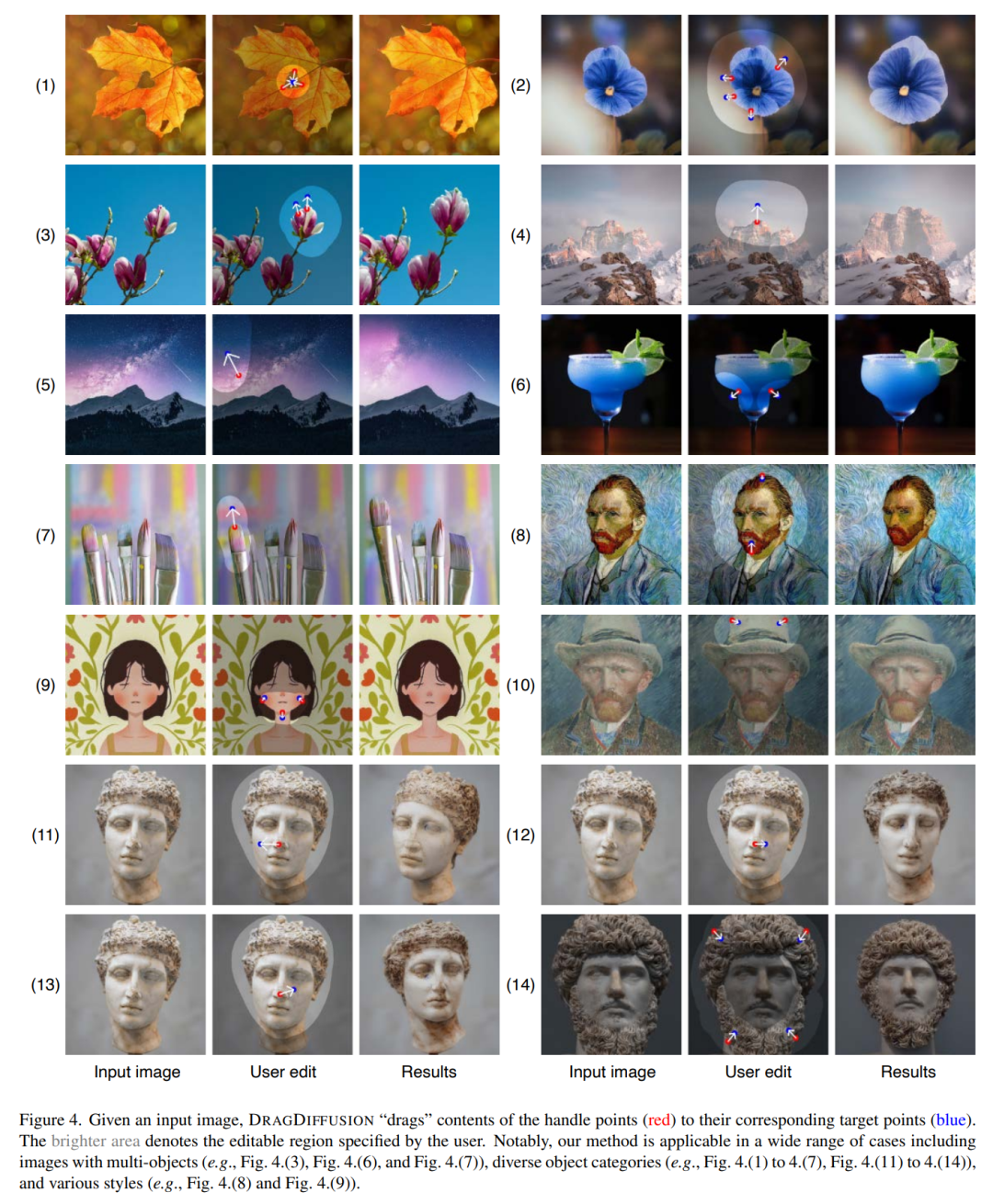

À partir d'une image d'entrée, DRAGDIFFUSION "fait glisser" le contenu des points clés (rouge) vers le point cible correspondant (couleur bleue) . Par exemple, sur la photo (1), retournez la tête du chiot, sur la photo (7), fermez la gueule du tigre, etc.

Photos

Photos

Voici d'autres exemples de démos. Comme le montre la figure (4), agrandissez le sommet de la montagne, la figure (7) agrandissez la pointe du stylo, etc.

Photos

Photos

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Comment modifier le texte dans l'image

Comment modifier le texte dans l'image

Que faire si l'image intégrée ne s'affiche pas complètement

Que faire si l'image intégrée ne s'affiche pas complètement

Comment faire apparaître les images ppt une par une

Comment faire apparaître les images ppt une par une

Comment faire une image ronde en ppt

Comment faire une image ronde en ppt

logiciel

logiciel

MySQL crée une procédure stockée

MySQL crée une procédure stockée

Quelle est la balise article utilisée pour définir ?

Quelle est la balise article utilisée pour définir ?

méthode d'ouverture du fichier caj

méthode d'ouverture du fichier caj