Périphériques technologiques

Périphériques technologiques

IA

IA

Nouvelle recherche menée par l'équipe de Tian Yuandong : réglage fin

Nouvelle recherche menée par l'équipe de Tian Yuandong : réglage fin

Nouvelle recherche menée par l'équipe de Tian Yuandong : réglage fin

Alors que chacun continue de mettre à niveau et d'itérer ses propres grands modèles, la capacité du LLM (Large Language Model) à traiter les fenêtres contextuelles est également devenue un indicateur d'évaluation important.

Par exemple, gpt-3.5-turbo d'OpenAI fournit une option de fenêtre contextuelle de 16 000 jetons, et AnthropicAI a augmenté la capacité de traitement des jetons de Claude à 100 000. Quel est le concept d'une grande fenêtre contextuelle de traitement de modèle ? Par exemple, GPT-4 prend en charge 32 000 jetons, ce qui signifie que GPT-4 peut mémoriser jusqu'à environ 50 pages de contenu lors de la conversation ou de la génération. texte.

De manière générale, la capacité des grands modèles de langage à gérer la taille de la fenêtre contextuelle est prédéterminée. Par exemple, la taille du jeton d'entrée du modèle LLaMA publié par Meta AI doit être inférieure à 2048.

Cependant, dans des applications telles que mener de longues conversations, résumer de longs documents ou exécuter des plans à long terme, la limite de fenêtre contextuelle prédéfinie est souvent dépassée et, par conséquent, les LLM capables de gérer des fenêtres contextuelles plus longues sont plus populaires.

Mais cela se heurte à un nouveau problème. Former un LLM avec une longue fenêtre contextuelle à partir de zéro nécessite beaucoup d'investissement. Cela nous amène naturellement à la question : pouvons-nous étendre la fenêtre contextuelle des LLM pré-formés existants ?

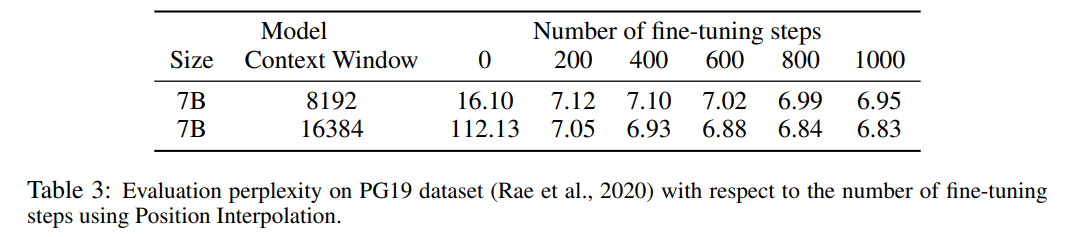

Une approche simple consiste à affiner le Transformer pré-entraîné existant pour obtenir une fenêtre contextuelle plus longue. Cependant, les résultats empiriques montrent que les modèles ainsi formés s’adaptent très lentement aux longues fenêtres contextuelles. Après 10 000 lots de formation, l'augmentation de la fenêtre de contexte effective est encore très faible, seulement de 2 048 à 2 560 (comme le montre le tableau 4 de la section expérimentale). Cela suggère que cette approche est inefficace pour s’adapter à des fenêtres contextuelles plus longues.

Dans cet article, des chercheurs de Meta ont présenté Position Interpolation (PI) pour étendre la fenêtre contextuelle de certains LLM pré-entraînés existants (y compris LLaMA). Les résultats montrent que la fenêtre contextuelle LLaMA évolue de 2 000 à 32 000 avec moins de 1 000 étapes de réglage précis.

Photos

Photos

Adresse papier : https://arxiv.org/pdf/2306.15595.pdf

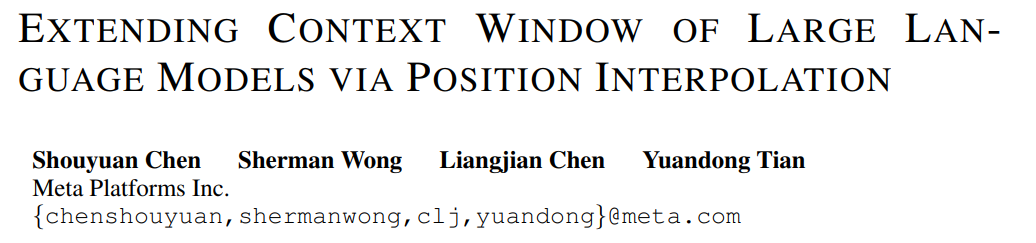

L'idée clé de cette recherche n'est pas d'effectuer une extrapolation, mais de réduire directement la position index, Faire en sorte que l'index de position maximum corresponde à la limite de la fenêtre contextuelle de la phase de pré-entraînement. En d’autres termes, afin de prendre en charge davantage de jetons d’entrée, cette étude interpole les codages de position à des positions entières adjacentes, en tirant parti du fait que les codages de position peuvent être appliqués à des positions non entières, par opposition à une extrapolation au-delà des positions entraînées. cette dernière peut conduire à des valeurs catastrophiques. La méthode PI étend la taille de la fenêtre contextuelle des LLM pré-entraînés basés sur RoPE (Rotation Positional Encoding) tels que LLaMA jusqu'à 32 768 avec un réglage fin minimal (dans les 1 000 étapes). Cette recherche fonctionne bien sur une variété de tâches qui nécessitent un contexte long, y compris la récupération, la modélisation du langage et la synthèse de documents longs du LLaMA 7B au 65B. Dans le même temps, le modèle étendu par PI conserve une qualité relativement bonne dans sa fenêtre contextuelle d'origine.

Méthode

RoPE est présente dans les grands modèles de langage tels que LLaMA, ChatGLM-6B et PaLM que nous connaissons. Cette méthode a été proposée par Su Jianlin et d'autres de Zhuiyi Technology et est implémentée via l'absolu. encodage. Encodage de position relative.

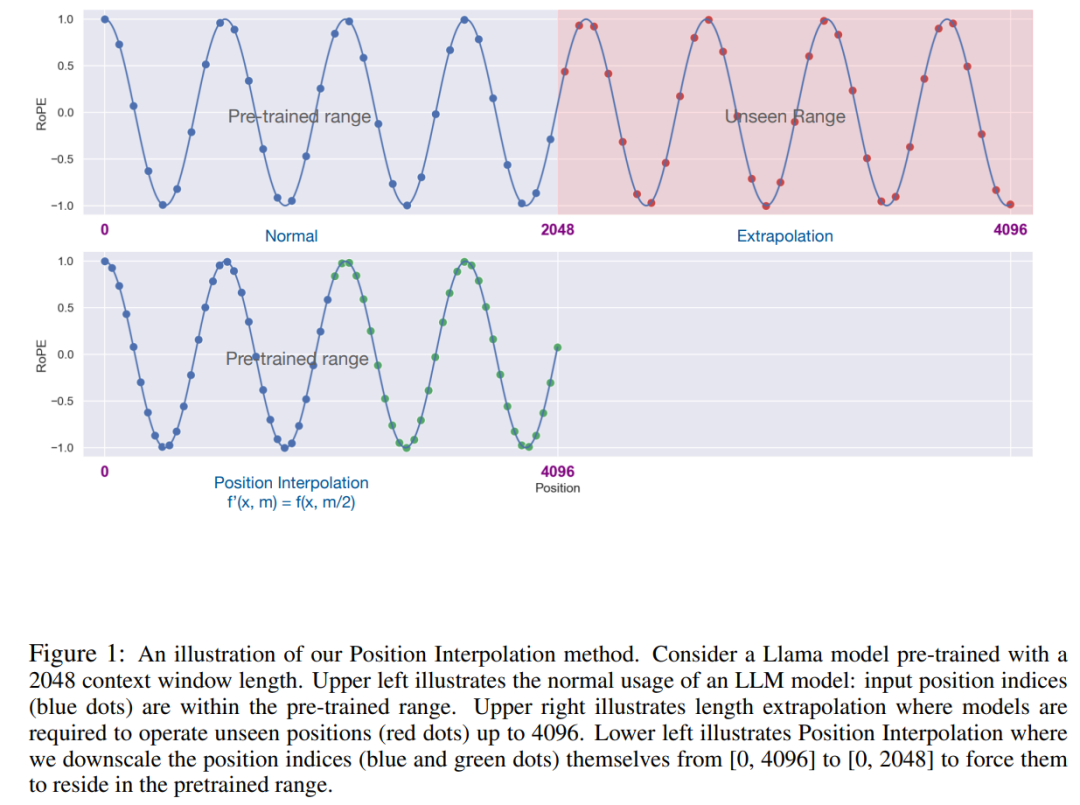

Bien que le score d'attention dans RoPE ne dépende que de la position relative, ses performances d'extrapolation ne sont pas bonnes. En particulier, lors d'une mise à l'échelle directe vers des fenêtres contextuelles plus grandes, la perplexité peut atteindre des nombres très élevés (c'est-à-dire > 10 ^ 3).

Cet article utilise la méthode d'interpolation de position, et sa comparaison avec la méthode d'extrapolation est la suivante. En raison de la fluidité des fonctions de base ϕ_j, l’interpolation est plus stable et ne conduit pas à des valeurs aberrantes.

Picture

Cette étude a remplacé RoPE f par f′ et a obtenu la formule suivante

Picture

Picture

Cette étude appelle la conversion par interpolation positionnelle d'encodage positionnel. Cette étape réduit l'indice de position de [0, L′ ) à [0, L) pour correspondre à la plage d'index d'origine avant le calcul de RoPE. Par conséquent, en entrée de RoPE, la distance relative maximale entre deux jetons quelconques a été réduite de L ′ à L . En alignant la plage d'indices de position et les distances relatives avant et après l'expansion, l'impact sur les calculs du score d'attention dû à l'expansion de la fenêtre contextuelle est atténué, ce qui facilite l'adaptation du modèle.

Il convient de noter que la méthode de redimensionnement de l'indice de position n'introduit pas de poids supplémentaires et ne modifie en aucune façon l'architecture du modèle.

Expériences

Cette étude démontre que l'interpolation positionnelle peut effectivement étendre la fenêtre contextuelle jusqu'à 32 fois la taille d'origine, et que cette expansion peut être réalisée en seulement quelques centaines d'étapes de formation.

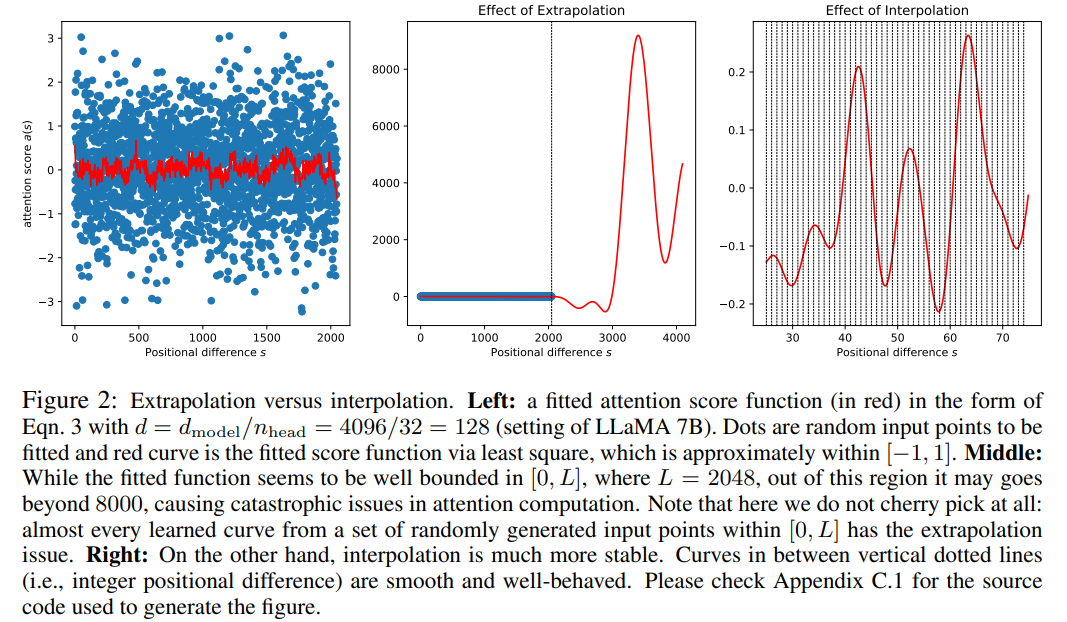

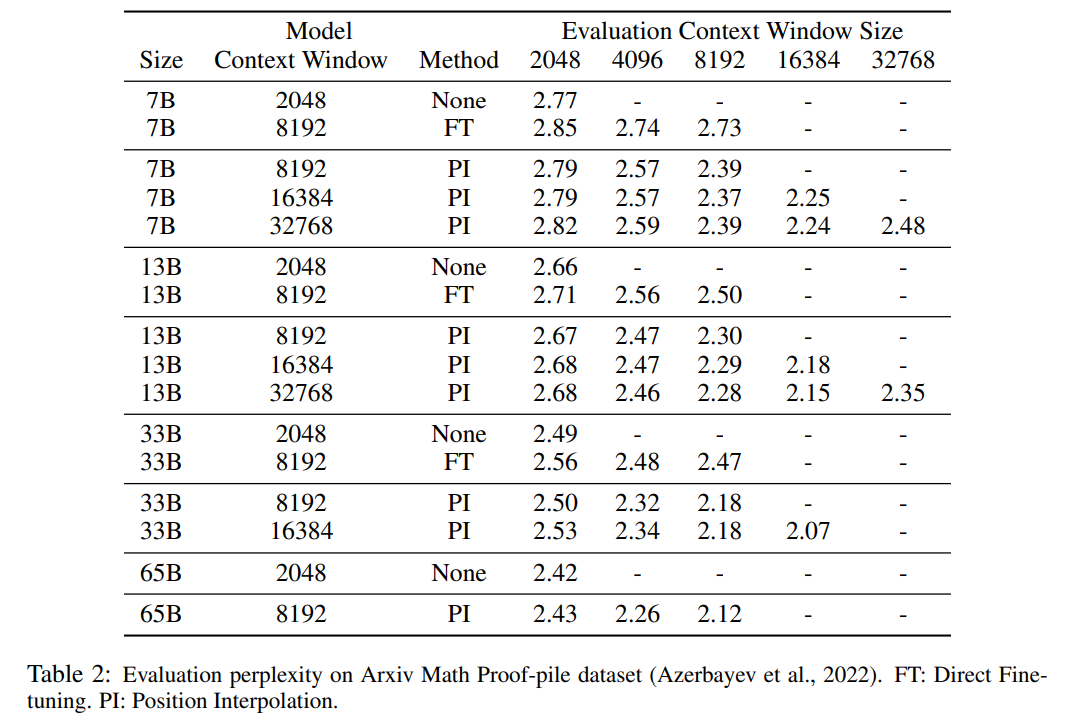

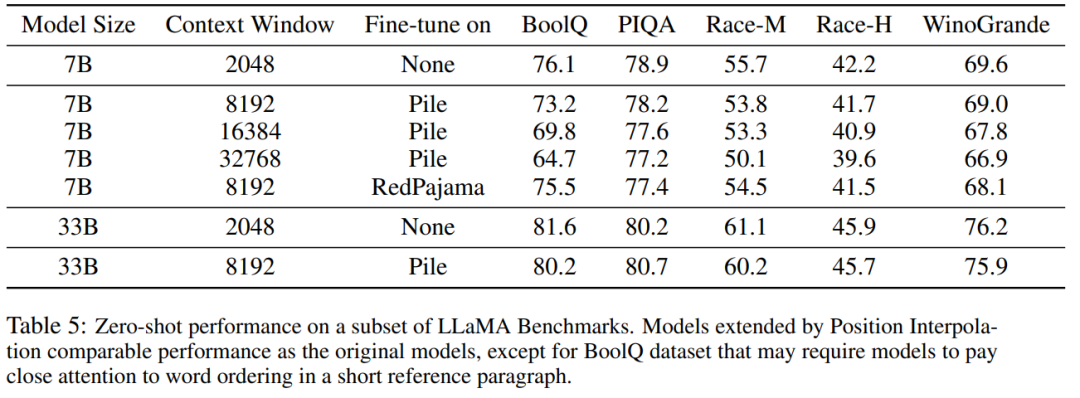

Le Tableau 1 et le Tableau 2 rendent compte de la perplexité du modèle PI et du modèle de base sur les ensembles de données PG-19 et Arxiv Math Proof-pile. Les résultats montrent que le modèle étendu à l’aide de la méthode PI améliore considérablement la perplexité pour des fenêtres contextuelles de plus grande taille.

Le Tableau 3 rapporte la relation entre la perplexité et le nombre d'étapes de réglage fin lors de l'extension du modèle LLaMA 7B à 8 192 et 16 384 tailles de fenêtre contextuelle à l'aide de la méthode PI sur l'ensemble de données PG19.

Les résultats montrent que sans réglage fin (le nombre d'étapes est de 0), le modèle peut démontrer certaines capacités de modélisation du langage. Par exemple, lorsque la fenêtre contextuelle est étendue à 8192, la perplexité est moindre. supérieur à 20 (par rapport à Ci-dessous, la perplexité de la méthode d'extrapolation directe est supérieure à 10^3). À 200 étapes, la perplexité du modèle dépasse celle du modèle d'origine avec une taille de fenêtre contextuelle de 2 048, ce qui indique que le modèle est capable d'utiliser efficacement des séquences plus longues pour la modélisation du langage que le paramètre pré-entraîné. À 1000 pas, on peut constater une amélioration constante du modèle et atteindre une meilleure perplexité.

Photos

Photos

Le tableau ci-dessous montre que le modèle étendu par PI atteint avec succès l'objectif de mise à l'échelle en termes de taille efficace de la fenêtre contextuelle, c'est-à-dire qu'après seulement 200 étapes de réglage fin, la taille effective de la fenêtre contextuelle atteint la valeur maximale, cohérente sur les tailles de modèle 7B et 33B et jusqu'à 32 768 fenêtres contextuelles. En revanche, la taille effective de la fenêtre de contexte du modèle LLaMA étendue uniquement par un réglage fin direct n'a augmenté que de 2 048 à 2 560, sans aucun signe d'augmentation accélérée significative de la taille de la fenêtre, même après plus de 10 000 étapes de réglage fin.

Photos

Photos

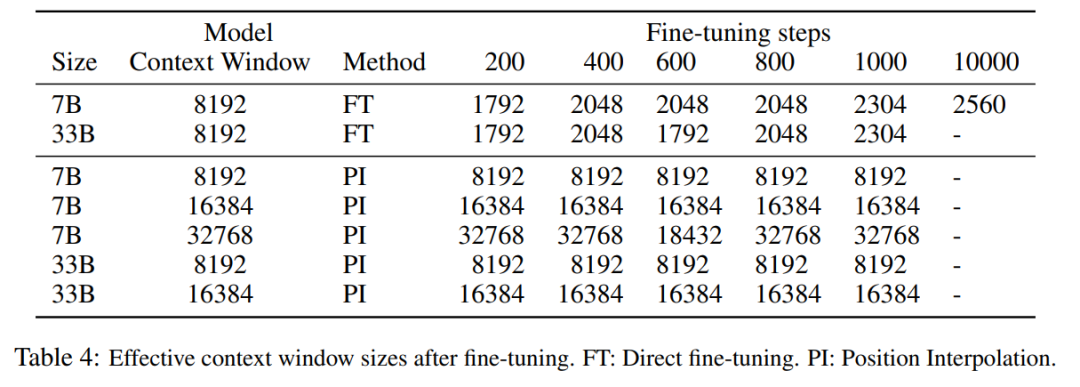

Le tableau 5 montre que le modèle étendu à 8192 produit des résultats comparables sur la tâche de référence originale, qui a été conçue pour des fenêtres de contexte plus petites, pour les tailles de modèle 7B et 33B, la dégradation dans la tâche de référence atteint jusqu'à 2%.

Images

Images

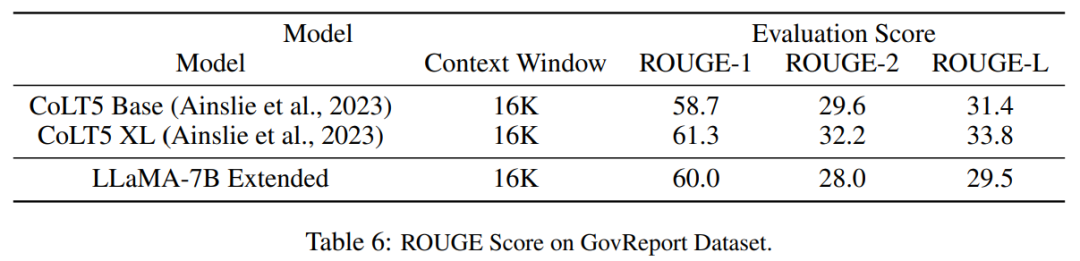

Le tableau 6 montre que le modèle PI avec 16384 fenêtres contextuelles peut gérer efficacement les tâches de résumé de texte long.

photos

photos

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Le modèle MoE open source le plus puissant au monde est ici, avec des capacités chinoises comparables à celles du GPT-4, et le prix ne représente que près d'un pour cent de celui du GPT-4-Turbo.

May 07, 2024 pm 04:13 PM

Imaginez un modèle d'intelligence artificielle qui non seulement a la capacité de surpasser l'informatique traditionnelle, mais qui permet également d'obtenir des performances plus efficaces à moindre coût. Ce n'est pas de la science-fiction, DeepSeek-V2[1], le modèle MoE open source le plus puissant au monde est ici. DeepSeek-V2 est un puissant mélange de modèle de langage d'experts (MoE) présentant les caractéristiques d'une formation économique et d'une inférence efficace. Il est constitué de 236B paramètres, dont 21B servent à activer chaque marqueur. Par rapport à DeepSeek67B, DeepSeek-V2 offre des performances plus élevées, tout en économisant 42,5 % des coûts de formation, en réduisant le cache KV de 93,3 % et en augmentant le débit de génération maximal à 5,76 fois. DeepSeek est une entreprise explorant l'intelligence artificielle générale

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Bonjour, Atlas électrique ! Le robot Boston Dynamics revient à la vie, des mouvements étranges à 180 degrés effraient Musk

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas entre officiellement dans l’ère des robots électriques ! Hier, l'Atlas hydraulique s'est retiré "en larmes" de la scène de l'histoire. Aujourd'hui, Boston Dynamics a annoncé que l'Atlas électrique était au travail. Il semble que dans le domaine des robots humanoïdes commerciaux, Boston Dynamics soit déterminé à concurrencer Tesla. Après la sortie de la nouvelle vidéo, elle a déjà été visionnée par plus d’un million de personnes en seulement dix heures. Les personnes âgées partent et de nouveaux rôles apparaissent. C'est une nécessité historique. Il ne fait aucun doute que cette année est l’année explosive des robots humanoïdes. Les internautes ont commenté : Les progrès des robots ont fait ressembler la cérémonie d'ouverture de cette année à des êtres humains, et le degré de liberté est bien plus grand que celui des humains. Mais n'est-ce vraiment pas un film d'horreur ? Au début de la vidéo, Atlas est allongé calmement sur le sol, apparemment sur le dos. Ce qui suit est à couper le souffle

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

KAN, qui remplace MLP, a été étendu à la convolution par des projets open source

Jun 01, 2024 pm 10:03 PM

Plus tôt ce mois-ci, des chercheurs du MIT et d'autres institutions ont proposé une alternative très prometteuse au MLP – KAN. KAN surpasse MLP en termes de précision et d’interprétabilité. Et il peut surpasser le MLP fonctionnant avec un plus grand nombre de paramètres avec un très petit nombre de paramètres. Par exemple, les auteurs ont déclaré avoir utilisé KAN pour reproduire les résultats de DeepMind avec un réseau plus petit et un degré d'automatisation plus élevé. Plus précisément, le MLP de DeepMind compte environ 300 000 paramètres, tandis que le KAN n'en compte qu'environ 200. KAN a une base mathématique solide comme MLP est basé sur le théorème d'approximation universelle, tandis que KAN est basé sur le théorème de représentation de Kolmogorov-Arnold. Comme le montre la figure ci-dessous, KAN a

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

Les robots Tesla travaillent dans les usines, Musk : Le degré de liberté des mains atteindra 22 cette année !

May 06, 2024 pm 04:13 PM

La dernière vidéo du robot Optimus de Tesla est sortie, et il peut déjà fonctionner en usine. À vitesse normale, il trie les batteries (les batteries 4680 de Tesla) comme ceci : Le responsable a également publié à quoi cela ressemble à une vitesse 20 fois supérieure - sur un petit "poste de travail", en sélectionnant et en sélectionnant et en sélectionnant : Cette fois, il est publié L'un des points forts de la vidéo est qu'Optimus réalise ce travail en usine, de manière totalement autonome, sans intervention humaine tout au long du processus. Et du point de vue d'Optimus, il peut également récupérer et placer la batterie tordue, en se concentrant sur la correction automatique des erreurs : concernant la main d'Optimus, le scientifique de NVIDIA Jim Fan a donné une évaluation élevée : la main d'Optimus est l'un des robots à cinq doigts du monde. le plus adroit. Ses mains ne sont pas seulement tactiles

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

FisheyeDetNet : le premier algorithme de détection de cible basé sur une caméra fisheye

Apr 26, 2024 am 11:37 AM

La détection de cibles est un problème relativement mature dans les systèmes de conduite autonome, parmi lesquels la détection des piétons est l'un des premiers algorithmes à être déployés. Des recherches très complètes ont été menées dans la plupart des articles. Cependant, la perception de la distance à l’aide de caméras fisheye pour une vue panoramique est relativement moins étudiée. En raison de la distorsion radiale importante, la représentation standard du cadre de délimitation est difficile à mettre en œuvre dans les caméras fisheye. Pour alléger la description ci-dessus, nous explorons les conceptions étendues de boîtes englobantes, d'ellipses et de polygones généraux dans des représentations polaires/angulaires et définissons une métrique de segmentation d'instance mIOU pour analyser ces représentations. Le modèle fisheyeDetNet proposé avec une forme polygonale surpasse les autres modèles et atteint simultanément 49,5 % de mAP sur l'ensemble de données de la caméra fisheye Valeo pour la conduite autonome.

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

Un nouveau casque VR Meta Quest 3S abordable apparaît sur FCC, suggérant un lancement imminent

Sep 04, 2024 am 06:51 AM

L'événement Meta Connect 2024 est prévu du 25 au 26 septembre et lors de cet événement, la société devrait dévoiler un nouveau casque de réalité virtuelle abordable. Selon la rumeur, il s'agirait du Meta Quest 3S, le casque VR serait apparemment apparu sur la liste FCC. Cela suggère

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Les dernières nouvelles de l'Université d'Oxford ! Mickey : correspondance d'images 2D en 3D SOTA ! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Lien du projet écrit devant : https://nianticlabs.github.io/mickey/ Étant donné deux images, la pose de la caméra entre elles peut être estimée en établissant la correspondance entre les images. En règle générale, ces correspondances sont 2D à 2D et nos poses estimées sont à échelle indéterminée. Certaines applications, telles que la réalité augmentée instantanée, à tout moment et en tout lieu, nécessitent une estimation de pose des métriques d'échelle, elles s'appuient donc sur des estimateurs de profondeur externes pour récupérer l'échelle. Cet article propose MicKey, un processus de correspondance de points clés capable de prédire les correspondances métriques dans l'espace d'une caméra 3D. En apprenant la correspondance des coordonnées 3D entre les images, nous sommes en mesure de déduire des métriques relatives.

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Une seule carte exécute Llama 70B plus rapidement que deux cartes, Microsoft vient de mettre le FP6 dans l'Open source A100 |

Apr 29, 2024 pm 04:55 PM

Le FP8 et la précision de quantification inférieure en virgule flottante ne sont plus le « brevet » du H100 ! Lao Huang voulait que tout le monde utilise INT8/INT4, et l'équipe Microsoft DeepSpeed a commencé à exécuter FP6 sur A100 sans le soutien officiel de NVIDIA. Les résultats des tests montrent que la quantification FP6 de la nouvelle méthode TC-FPx sur A100 est proche ou parfois plus rapide que celle de INT4, et a une précision supérieure à celle de cette dernière. En plus de cela, il existe également une prise en charge de bout en bout des grands modèles, qui ont été open source et intégrés dans des cadres d'inférence d'apprentissage profond tels que DeepSpeed. Ce résultat a également un effet immédiat sur l'accélération des grands modèles : dans ce cadre, en utilisant une seule carte pour exécuter Llama, le débit est 2,65 fois supérieur à celui des cartes doubles. un