Opération et maintenance

Opération et maintenance

exploitation et maintenance Linux

exploitation et maintenance Linux

Configurer les systèmes Linux pour prendre en charge le traitement et l'analyse du Big Data

Configurer les systèmes Linux pour prendre en charge le traitement et l'analyse du Big Data

Configurer les systèmes Linux pour prendre en charge le traitement et l'analyse du Big Data

Configurer le système Linux pour prendre en charge le traitement et l'analyse du Big Data

Résumé : Avec l'avènement de l'ère du Big Data, la demande de traitement et d'analyse du Big Data augmente. Cet article décrit comment configurer des applications et des outils sur un système Linux pour prendre en charge le traitement et l'analyse du Big Data, et fournit des exemples de code correspondants.

Mots clés : système Linux, big data, traitement, analyse, configuration, exemples de code

Introduction : Le Big data, en tant que technologie émergente de gestion et d'analyse de données, a été largement utilisé dans divers domaines. Afin de garantir l'efficacité et la fiabilité du traitement et de l'analyse du Big Data, il est très essentiel de configurer correctement le système Linux.

1. Installez le système Linux

Tout d'abord, nous devons installer correctement un système Linux. Les distributions Linux courantes incluent Ubuntu, Fedora, etc. Vous pouvez choisir une distribution Linux appropriée en fonction de vos propres besoins. Pendant le processus d'installation, il est recommandé de sélectionner la version du serveur pour permettre une configuration plus détaillée une fois l'installation du système terminée.

2. Mettez à jour le système et installez les logiciels nécessaires

Après avoir terminé l'installation du système, vous devez mettre à jour le système et installer certains logiciels nécessaires. Tout d'abord, exécutez la commande suivante dans le terminal pour mettre à jour le système :

sudo apt update sudo apt upgrade

Ensuite, installez OpenJDK (Java Development Kit), car la plupart des applications de traitement et d'analyse de Big Data sont développées sur la base de Java :

sudo apt install openjdk-8-jdk

Après l'installation, vous pouvez vérifier si Java est installé avec succès en exécutant la commande suivante :

java -version

Si les informations sur la version Java sont affichées, l'installation est réussie.

3. Configurer Hadoop

Hadoop est un framework de traitement de Big Data open source qui peut gérer des ensembles de données extrêmement volumineux. Voici les étapes pour configurer Hadoop :

Téléchargez Hadoop et décompressez-le :

wget https://www.apache.org/dist/hadoop/common/hadoop-3.3.0.tar.gz tar -xzvf hadoop-3.3.0.tar.gz

Copier après la connexionConfigurez les variables d'environnement :

Ajoutez le contenu suivant au fichier~/.bashrc:~/.bashrc文件中:export HADOOP_HOME=/path/to/hadoop-3.3.0 export PATH=$PATH:$HADOOP_HOME/bin

Copier après la connexion保存文件后,运行以下命令使配置生效:

source ~/.bashrc

Copier après la connexionCopier après la connexion配置Hadoop的核心文件:

进入Hadoop的解压目录,编辑etc/hadoop/core-site.xml文件,添加以下内容:<configuration> <property> <name>fs.defaultFS</name> <value>hdfs://localhost:9000</value> </property> </configuration>

Copier après la connexion接着,编辑

etc/hadoop/hdfs-site.xml文件,添加以下内容:<configuration> <property> <name>dfs.replication</name> <value>1</value> </property> </configuration>

Copier après la connexion保存文件后,执行以下命令格式化Hadoop的文件系统:

hdfs namenode -format

Copier après la connexion最后,启动Hadoop:

start-dfs.sh

Copier après la connexion四、配置Spark

Spark是一个快速、通用的大数据处理和分析引擎,可以与Hadoop一起使用。下面是配置Spark的步骤:下载Spark并解压缩:

wget https://www.apache.org/dist/spark/spark-3.1.2/spark-3.1.2-bin-hadoop3.2.tgz tar -xzvf spark-3.1.2-bin-hadoop3.2.tgz

Copier après la connexion配置环境变量:

将下面的内容添加到~/.bashrc文件中:export SPARK_HOME=/path/to/spark-3.1.2-bin-hadoop3.2 export PATH=$PATH:$SPARK_HOME/bin

Copier après la connexion保存文件后,运行以下命令使配置生效:

source ~/.bashrc

Copier après la connexionCopier après la connexion配置Spark的核心文件:

进入Spark的解压目录,将conf/spark-env.sh.template文件复制一份并重命名为conf/spark-env.sh。编辑conf/spark-env.sh文件,添加以下内容:export JAVA_HOME=/path/to/jdk1.8.0_* export HADOOP_HOME=/path/to/hadoop-3.3.0 export SPARK_MASTER_HOST=localhost export SPARK_MASTER_PORT=7077 export SPARK_WORKER_CORES=4 export SPARK_WORKER_MEMORY=4g

Copier après la connexion其中,

JAVA_HOME需要设置为Java的安装路径,HADOOP_HOME需要设置为Hadoop的安装路径,SPARK_MASTER_HOST设置为当前机器的IP地址。

保存文件后,启动Spark:

start-master.sh

运行以下命令查看Spark的Master地址:

cat $SPARK_HOME/logs/spark-$USER-org.apache.spark.deploy.master*.out | grep 'Starting Spark master'

启动Spark Worker:

start-worker.sh spark://<master-ip>:<master-port>

其中,<master-ip>为Spark的Master地址中的IP地址,<master-port>rrreee

rrreee

🎜🎜Configurez le fichier core de Hadoop : 🎜Entrez dans le répertoire de décompression de Hadoop, éditez leetc/hadoop/core-site.xml et ajoutez le contenu suivant : 🎜rrreee🎜Ensuite, éditez le fichier etc/hadoop/hdfs-site.xml et ajoutez le contenu suivant : 🎜rrreee🎜Après avoir enregistré le fichier, exécutez la commande suivante pour formater le système de fichiers Hadoop : 🎜rrreee🎜 Enfin, démarrez Hadoop : 🎜rrreee🎜 IV Configurer Spark🎜Spark est un moteur de traitement et d'analyse de Big Data rapide et polyvalent qui peut être utilisé avec Hadoop. Voici les étapes pour configurer Spark : 🎜🎜🎜🎜Téléchargez Spark et décompressez-le : 🎜rrreee🎜🎜🎜Configurez les variables d'environnement : 🎜Ajoutez le contenu suivant au fichier ~/.bashrc : 🎜rrreee🎜 Après avoir enregistré le fichier, exécutez la commande suivante pour rendre la configuration effective : 🎜rrreee🎜🎜🎜Configurez les fichiers principaux de Spark : 🎜Entrez dans le répertoire de décompression Spark et copiez le conf/spark-env.sh.template file Et renommez-le en conf/spark-env.sh. Modifiez le fichier conf/spark-env.sh et ajoutez le contenu suivant : 🎜rrreee🎜Parmi eux, JAVA_HOME doit être défini sur le chemin d'installation de Java, HADOOP_HOME Il doit être défini sur le chemin d'installation de Hadoop et SPARK_MASTER_HOST est défini sur l'adresse IP de la machine actuelle. 🎜🎜🎜Après avoir enregistré le fichier, démarrez Spark : 🎜rrreee🎜Exécutez la commande suivante pour afficher l'adresse principale de Spark : 🎜rrreee🎜Démarrez Spark Worker : 🎜rrreee🎜 Parmi eux, <master-ip> est l'adresse IP dans l'adresse principale de Spark et <master-port> est le numéro de port dans l'adresse principale de Spark. 🎜🎜Résumé : Cet article explique comment configurer un système Linux pour prendre en charge les applications et les outils de traitement et d'analyse du Big Data, notamment Hadoop et Spark. En configurant correctement le système Linux, l'efficacité et la fiabilité du traitement et de l'analyse du Big Data peuvent être améliorées. Les lecteurs peuvent pratiquer la configuration et l'application des systèmes Linux sur la base des directives et des exemples de codes contenus dans cet article. 🎜Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Lisez des fichiers CSV et effectuez une analyse de données à l'aide de pandas

Jan 09, 2024 am 09:26 AM

Lisez des fichiers CSV et effectuez une analyse de données à l'aide de pandas

Jan 09, 2024 am 09:26 AM

Pandas est un puissant outil d'analyse de données qui peut facilement lire et traiter différents types de fichiers de données. Parmi eux, les fichiers CSV sont l’un des formats de fichiers de données les plus courants et les plus utilisés. Cet article expliquera comment utiliser Pandas pour lire des fichiers CSV et effectuer une analyse de données, et fournira des exemples de code spécifiques. 1. Importez les bibliothèques nécessaires Tout d'abord, nous devons importer la bibliothèque Pandas et les autres bibliothèques associées qui peuvent être nécessaires, comme indiqué ci-dessous : importpandasaspd 2. Lisez le fichier CSV à l'aide de Pan

Introduction aux méthodes d'analyse des données

Jan 08, 2024 am 10:22 AM

Introduction aux méthodes d'analyse des données

Jan 08, 2024 am 10:22 AM

Méthodes courantes d'analyse des données : 1. Méthode d'analyse comparative ; 2. Méthode d'analyse structurelle ; 3. Méthode d'analyse croisée ; 5. Méthode d'analyse des causes et des effets ; , Méthode d'analyse en composantes principales ; 9. Méthode d'analyse de dispersion ; 10. Méthode d'analyse matricielle. Introduction détaillée : 1. Méthode d'analyse comparative : Analyse comparative de deux ou plusieurs données pour trouver les différences et les modèles ; 2. Méthode d'analyse structurelle : Une méthode d'analyse comparative entre chaque partie de l'ensemble et l'ensemble. , etc.

Traitement du Big Data en technologie C++ : Comment utiliser des bases de données graphiques pour stocker et interroger des données graphiques à grande échelle ?

Jun 03, 2024 pm 12:47 PM

Traitement du Big Data en technologie C++ : Comment utiliser des bases de données graphiques pour stocker et interroger des données graphiques à grande échelle ?

Jun 03, 2024 pm 12:47 PM

La technologie C++ peut gérer des données graphiques à grande échelle en exploitant les bases de données graphiques. Les étapes spécifiques incluent : la création d'une instance TinkerGraph, l'ajout de sommets et d'arêtes, la formulation d'une requête, l'obtention de la valeur du résultat et la conversion du résultat en liste.

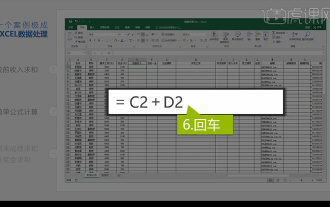

Analyse de données Excel intégrée

Mar 21, 2024 am 08:21 AM

Analyse de données Excel intégrée

Mar 21, 2024 am 08:21 AM

1. Dans cette leçon, nous expliquerons l'analyse intégrée des données Excel. Nous la compléterons à travers un cas. Ouvrez le support de cours et cliquez sur la cellule E2 pour saisir la formule. 2. Nous sélectionnons ensuite la cellule E53 pour calculer toutes les données suivantes. 3. Ensuite, nous cliquons sur la cellule F2, puis nous entrons la formule pour la calculer. De même, en faisant glisser vers le bas, nous pouvons calculer la valeur souhaitée. 4. Nous sélectionnons la cellule G2, cliquons sur l'onglet Données, cliquez sur Validation des données, sélectionnons et confirmons. 5. Utilisons la même méthode pour remplir automatiquement les cellules ci-dessous qui doivent être calculées. 6. Ensuite, nous calculons le salaire réel et sélectionnons la cellule H2 pour saisir la formule. 7. Ensuite, nous cliquons sur le menu déroulant des valeurs pour cliquer sur d'autres nombres.

Quels sont les sites Web d'analyse de données recommandés ?

Mar 13, 2024 pm 05:44 PM

Quels sont les sites Web d'analyse de données recommandés ?

Mar 13, 2024 pm 05:44 PM

Recommandé : 1. Forum d'analyse des données commerciales ; 2. Forum économique de l'Assemblée populaire nationale – Domaine de l'économétrie et des statistiques ; 4. Forum d'apprentissage et d'échange sur l'exploration de données ; . Analyse des données ; 8. Institut de recherche sur l'exploration de données ; 9. S-PLUS, R Statistics Forum.

Traitement du Big Data en technologie C++ : Comment utiliser la technologie de traitement de flux pour traiter les flux de Big Data ?

Jun 01, 2024 pm 10:34 PM

Traitement du Big Data en technologie C++ : Comment utiliser la technologie de traitement de flux pour traiter les flux de Big Data ?

Jun 01, 2024 pm 10:34 PM

La technologie de traitement de flux est utilisée pour le traitement du Big Data. Le traitement de flux est une technologie qui traite les flux de données en temps réel. En C++, Apache Kafka peut être utilisé pour le traitement de flux. Le traitement de flux fournit un traitement des données en temps réel, une évolutivité et une tolérance aux pannes. Cet exemple utilise ApacheKafka pour lire les données d'un sujet Kafka et calculer la moyenne.

Apprenez à utiliser la bibliothèque numpy pour l'analyse de données et le calcul scientifique

Jan 19, 2024 am 08:05 AM

Apprenez à utiliser la bibliothèque numpy pour l'analyse de données et le calcul scientifique

Jan 19, 2024 am 08:05 AM

Avec l’avènement de l’ère de l’information, l’analyse des données et le calcul scientifique sont devenus une partie importante de domaines de plus en plus nombreux. Dans ce processus, l’utilisation d’ordinateurs pour le traitement et l’analyse des données est devenue un outil indispensable. En Python, la bibliothèque numpy est un outil très important, qui nous permet de traiter et d'analyser les données plus efficacement et d'obtenir des résultats plus rapidement. Cet article présentera les fonctions courantes et l'utilisation de numpy, et donnera quelques exemples de code spécifiques pour vous aider à apprendre en profondeur. Installation de la bibliothèque numpy

Traitement du Big Data en technologie C++ : Comment réaliser une fouille de texte et une analyse Big Data efficaces ?

Jun 02, 2024 am 10:39 AM

Traitement du Big Data en technologie C++ : Comment réaliser une fouille de texte et une analyse Big Data efficaces ?

Jun 02, 2024 am 10:39 AM

C++ joue un rôle essentiel dans l'exploration de texte et l'analyse de données, en fournissant des moteurs d'exploration de texte efficaces et des capacités de traitement pour les tâches d'analyse complexes. En termes d'exploration de texte : C++ peut créer un moteur d'exploration de texte pour extraire des informations à partir de données textuelles ; en termes d'analyse de données volumineuses : C++ convient aux tâches d'analyse complexes de traitement d'énormes ensembles de données et peut calculer des statistiques telles que la moyenne et l'écart type. . Cas pratique : une entreprise de vente au détail a utilisé un moteur d'exploration de texte développé en C++ pour analyser les avis des clients et découvrir des informations sur la qualité des produits, le service client et les délais de livraison.