Périphériques technologiques

Périphériques technologiques

IA

IA

Étendre la longueur du contexte à 256 Ko, la version contextuelle illimitée de LongLLaMA arrive-t-elle ?

Étendre la longueur du contexte à 256 Ko, la version contextuelle illimitée de LongLLaMA arrive-t-elle ?

Étendre la longueur du contexte à 256 Ko, la version contextuelle illimitée de LongLLaMA arrive-t-elle ?

En février de cette année, Meta a publié la série de modèles de langage à grande échelle LLaMA, qui a promu avec succès le développement de robots de discussion open source. Parce que LLaMA a moins de paramètres que de nombreux grands modèles précédemment publiés (le nombre de paramètres varie de 7 milliards à 65 milliards), mais a de meilleures performances. Par exemple, le plus grand modèle LLaMA avec 65 milliards de paramètres est comparable au Chinchilla-70B et au PaLM de Google. -540B, tant de chercheurs étaient enthousiasmés dès sa sortie.

Cependant, LLaMA n'est autorisé à être utilisé que par des chercheurs universitaires, limitant ainsi l'application commerciale du modèle.

Par conséquent, les chercheurs ont commencé à rechercher les LLaMA pouvant être utilisés à des fins commerciales. Le projet OpenLLaMA initié par Hao Liu, doctorant à l'UC Berkeley, est l'une des copies open source les plus populaires de LLaMA, qui utilise. exactement le même LLaMA que le LLaMA original Pour les hyperparamètres de prétraitement et de formation, on peut dire qu'OpenLLaMA suit complètement les étapes de formation de LLaMA. Plus important encore, le modèle est disponible dans le commerce.

OpenLLaMA est formé sur l'ensemble de données RedPajama publié par Together Company. Il existe trois versions de modèle, à savoir 3B, 7B et 13B. Ces modèles ont été formés avec des jetons 1T. Les résultats montrent que les performances d'OpenLLaMA sont comparables, voire supérieures, à celles du LLaMA original dans plusieurs tâches.

En plus de publier constamment de nouveaux modèles, les chercheurs explorent constamment la capacité du modèle à gérer les jetons.

Il y a quelques jours, les dernières recherches de l'équipe de Tian Yuandong ont étendu le contexte LLaMA à 32K avec moins de 1000 étapes de réglage fin. En remontant plus loin, GPT-4 prend en charge 32 000 jetons (ce qui équivaut à 50 pages de texte), Claude peut gérer 100 000 jetons (à peu près l'équivalent de résumer la première partie de "Harry Potter" en un clic) et ainsi de suite.

Maintenant, un nouveau grand modèle de langage basé sur OpenLLaMA arrive, qui étend la longueur du contexte à 256 000 jetons et même plus. La recherche a été réalisée conjointement par IDEAS NCBR, l'Académie polonaise des sciences, l'Université de Varsovie et Google DeepMind.

Pictures

Pictures

LongLLaMA est basé sur OpenLLaMA et la méthode de réglage fin utilise FOT (Focused Transformer). Cet article montre que FOT peut être utilisé pour affiner de grands modèles déjà existants afin d'étendre la longueur de leur contexte.

L'étude utilise les modèles OpenLLaMA-3B et OpenLLaMA-7B comme point de départ et les affine à l'aide de FOT. Les modèles résultants, appelés LONGLLAMA, sont capables d'extrapoler au-delà de la longueur de leur contexte de formation (même jusqu'à 256 000) et de maintenir leurs performances sur des tâches à contexte court.

- Adresse du projet : https://github.com/CStanKonrad/long_llama

- Adresse papier : https://arxiv.org/pdf/2307.03170.pdf

Quelqu'un a décrit cette recherche Pour le version contextuelle illimitée d'OpenLLaMA, avec FOT, le modèle peut être facilement extrapolé à des séquences plus longues. Par exemple, un modèle formé sur des jetons de 8K peut être facilement extrapolé à une taille de fenêtre de 256K.

Pictures

Pictures

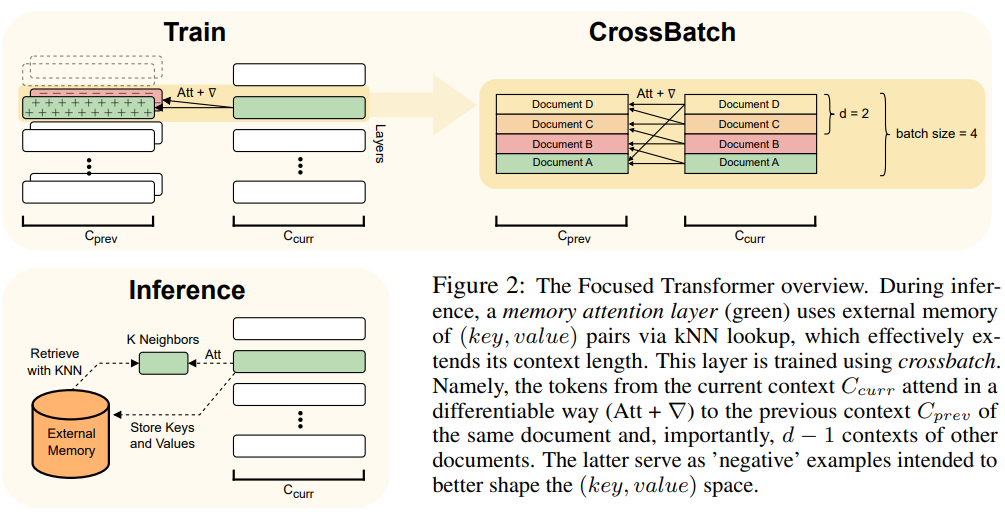

Cet article utilise la méthode FOT, qui est une extension plug-and-play du modèle Transformer et peut être utilisée pour former de nouveaux modèles ou affiner des modèles plus grands existants avec des contextes plus longs.

Pour y parvenir, FOT utilise une couche d'attention mémoire et un processus de formation par lots :

- La couche d'attention mémoire permet au modèle de récupérer des informations de la mémoire externe au moment de l'inférence, étendant ainsi efficacement le contexte ;

- Le processus de formation cross-batch fait que le modèle a tendance à apprendre (clé, valeur) des représentations très faciles à utiliser pour mémoriser les couches d'attention.

Pour un aperçu de l'architecture FOT, voir Figure 2 :

Photos

Photos

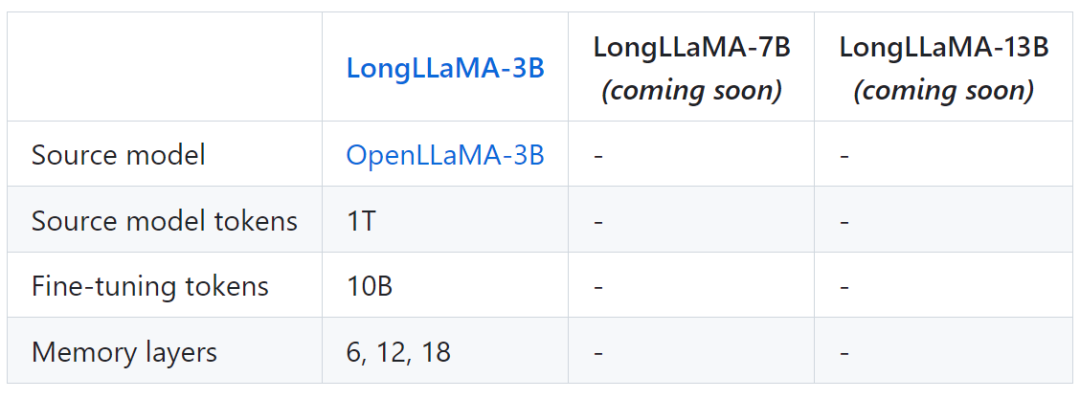

Le tableau suivant montre quelques informations sur le modèle pour LongLLaMA :

Photos

Photos

Enfin, le Le projet fournit également des résultats de comparaison entre LongLLaMA et le modèle OpenLLaMA original.

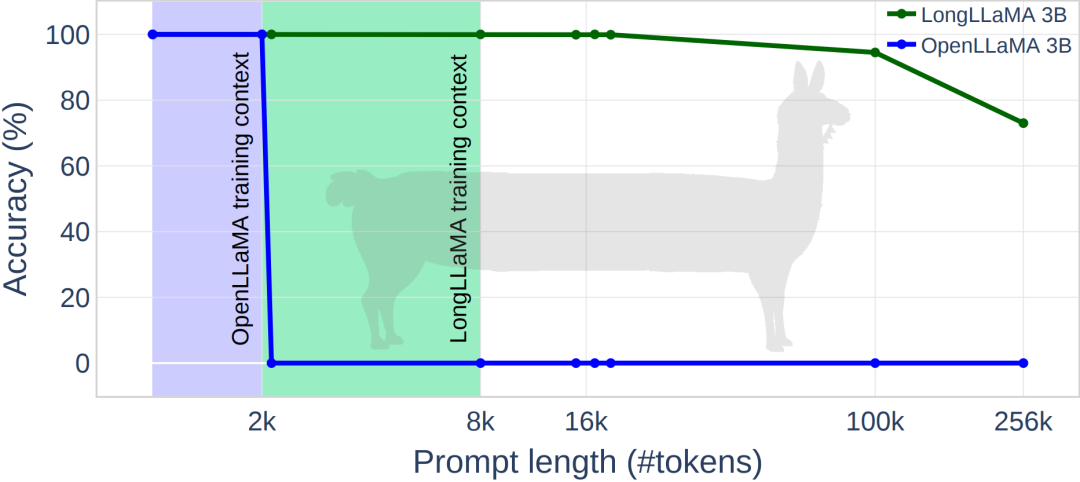

L'image ci-dessous montre quelques résultats expérimentaux de LongLLaMA Sur la tâche de récupération de mot de passe, LongLLaMA a obtenu de bonnes performances. Plus précisément, le modèle LongLLaMA 3B a largement dépassé la longueur de son contexte d'entraînement de 8 K, atteignant une précision de 94,5 % pour 100 000 jetons et une précision de 73 % pour 256 000 jetons.

Photos

Photos

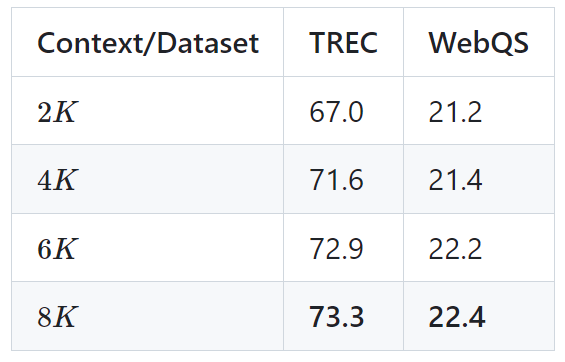

Le tableau suivant montre les résultats du modèle LongLLaMA 3B sur deux tâches en aval (classification des questions TREC et réponse aux questions WebQS). Les résultats montrent que les performances de LongLLaMA s'améliorent considérablement lors de l'utilisation d'un contexte long.

Image

Image

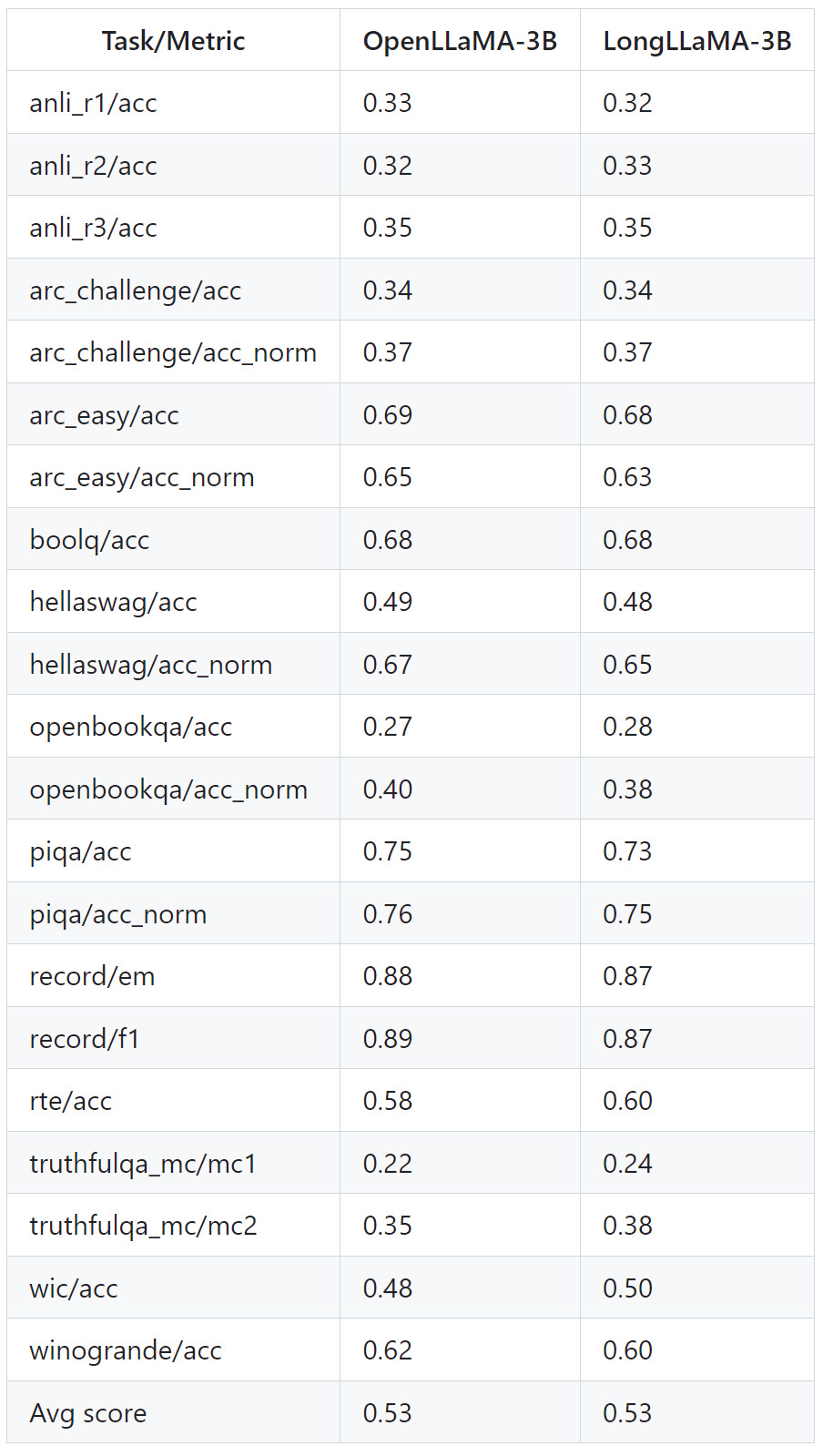

Le tableau ci-dessous montre comment LongLLaMA fonctionne bien même sur des tâches qui ne nécessitent pas de contexte long. Les expériences comparent LongLLaMA et OpenLLaMA dans un environnement sans échantillon.

Photos

Photos

Pour plus de détails, veuillez vous référer au document et au projet originaux.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Sujets chauds

Les derniers classements des dix principaux échanges d'applications de monnaie virtuelle dans le cercle de devises 2025

Mar 27, 2025 pm 07:27 PM

Les derniers classements des dix principaux échanges d'applications de monnaie virtuelle dans le cercle de devises 2025

Mar 27, 2025 pm 07:27 PM

Les dix principales applications de trading de devises virtuelles en 2025 sont les suivantes: 1. Okx, 2. Binance, 3. Gate.io, 4. Bybit, 5. Kraken, 6. Kucoin, 7. Bitget, 8. Htx, 9. Mexc, 10. Coinbase. Ce classement est basé sur des évaluations complètes telles que la sécurité, la liquidité, l'expérience utilisateur et la richesse des fonctionnalités.

Un résumé des dix principaux applications d'applications d'échange de devises virtuelles numériques en 2025

Mar 27, 2025 pm 07:18 PM

Un résumé des dix principaux applications d'applications d'échange de devises virtuelles numériques en 2025

Mar 27, 2025 pm 07:18 PM

Les dix principales applications de trading de devises virtuelles numériques en 2025 sont les suivantes: 1. Okx, 2. Binance, 3. Gate.io, 4. Bybit, 5. Kraken, 6. Kucoin, 7. Bitget, 8. Htx, 9. Mexc, 10. Coinbase. Ce classement est basé sur des évaluations complètes telles que la sécurité, la liquidité, l'expérience utilisateur et la richesse des fonctionnalités.

Quels échanges publient des nouvelles pi

Mar 28, 2025 pm 03:33 PM

Quels échanges publient des nouvelles pi

Mar 28, 2025 pm 03:33 PM

PI Network n'a pas encore officiellement lancé le commerce sur les bourses grand public. En 2024, PI est toujours au stade de la fermeture du réseau principal, et seuls certains échanges de petite et moyenne taille fournissent des transactions IOU. Le fonctionnaire n'autorise aucune transaction. Il est recommandé d'exploiter les canaux officiels et d'attendre que le réseau principal s'ouvre et échange sur des échanges conformes.

TOP10 plate-forme d'échange de devises virtuels sûrs et faciles à utiliser

Mar 27, 2025 pm 07:06 PM

TOP10 plate-forme d'échange de devises virtuels sûrs et faciles à utiliser

Mar 27, 2025 pm 07:06 PM

Les dix principales applications de trading de devises virtuelles en 2025 sont les suivantes: 1. Okx, 2. Binance, 3. Gate.io, 4. Bybit, 5. Kraken, 6. Kucoin, 7. Bitget, 8. Htx, 9. Mexc, 10. Coinbase. Ce classement est basé sur des évaluations complètes telles que la sécurité, la liquidité, l'expérience utilisateur et la richesse des fonctionnalités.

Comment résoudre le problème de l'interface tiers renvoyant 403 dans l'environnement Node.js?

Mar 31, 2025 pm 11:27 PM

Comment résoudre le problème de l'interface tiers renvoyant 403 dans l'environnement Node.js?

Mar 31, 2025 pm 11:27 PM

Résolvez le problème de l'interface tiers renvoyant 403 dans l'environnement Node.js. Lorsque nous utilisons Node.js pour appeler des interfaces tierces, nous rencontrons parfois une erreur de 403 à partir de l'interface renvoyant 403 ...

Que les échanges prennent en charge HECO

Mar 28, 2025 pm 03:36 PM

Que les échanges prennent en charge HECO

Mar 28, 2025 pm 03:36 PM

Depuis 2024, les principaux échanges qui soutiennent toujours la chaîne HECO ou les jetons HECO: 1. HTX (anciennement Huobi Huobi), soutient officiellement la chaîne HECO USDT et le trading de jetons; 2. MDEX, basé sur HECO DEX, prend en charge le trading de jetons de chaîne HECO; 3. Gate.io, soutient la réapprovisionnement et le retrait de certains jetons de chaîne HECO; 4. Kucoin, certains jetons de chaîne HECO peuvent encore être échangés; 5. Les échanges décentralisés tels que Pancakeswap et UNISWAP doivent réprimer les transactions, faire attention à la faible liquidité de la chaîne HECO et la migration du projet.

Dans Laravel, comment gérer la situation où les codes de vérification ne sont pas envoyés par e-mail?

Mar 31, 2025 pm 11:48 PM

Dans Laravel, comment gérer la situation où les codes de vérification ne sont pas envoyés par e-mail?

Mar 31, 2025 pm 11:48 PM

La méthode de traitement de l'échec de l'e-mail de Laravel à envoyer le code de vérification est d'utiliser Laravel ...

Comment définir automatiquement les autorisations d'UnixSocket après le redémarrage du système?

Mar 31, 2025 pm 11:54 PM

Comment définir automatiquement les autorisations d'UnixSocket après le redémarrage du système?

Mar 31, 2025 pm 11:54 PM

Comment définir automatiquement les autorisations d'UnixSocket après le redémarrage du système. Chaque fois que le système redémarre, nous devons exécuter la commande suivante pour modifier les autorisations d'UnixSocket: sudo ...