Périphériques technologiques

Périphériques technologiques

IA

IA

Il peut saisir des fragments de verre et des objets transparents sous-marins. Tsinghua a proposé un cadre universel de saisie d'objets transparents avec un taux de réussite très élevé.

Il peut saisir des fragments de verre et des objets transparents sous-marins. Tsinghua a proposé un cadre universel de saisie d'objets transparents avec un taux de réussite très élevé.

Il peut saisir des fragments de verre et des objets transparents sous-marins. Tsinghua a proposé un cadre universel de saisie d'objets transparents avec un taux de réussite très élevé.

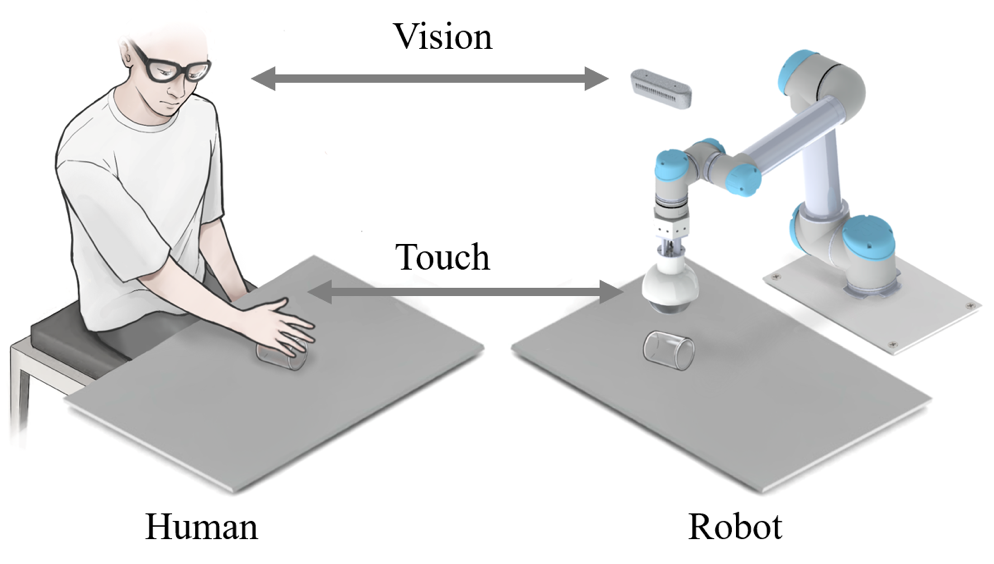

La perception et la préhension d'objets transparents dans des environnements complexes sont des problèmes reconnus dans le domaine de la robotique et de la vision par ordinateur. Récemment, une équipe et des collaborateurs de l'école supérieure internationale de Shenzhen de l'université Tsinghua ont proposé un cadre de saisie d'objet transparent par fusion visuelle-tactile, basé sur une caméra RVB et une griffe mécanique TaTa avec des capacités de détection tactile, et utilise sim2real pour réaliser la détection de position de préhension. d'objets transparents. Ce cadre peut non seulement résoudre le problème de la saisie d'objets transparents irréguliers tels que des fragments de verre, mais également résoudre les problèmes de saisie de tas de sable superposés, empilés, inégaux et même d'objets transparents sous-marins très dynamiques.

Images

Images

Les objets transparents sont largement utilisés dans la vie en raison de leur beauté, de leur simplicité et d'autres caractéristiques. Par exemple, on peut les voir dans les cuisines, les magasins et les usines. Bien que les objets transparents soient courants, leur saisie est un problème très difficile pour les robots. Il y a trois raisons principales :

images

images

1 Il n'a pas ses propres attributs de texture. Les informations sur la surface des objets transparents changent avec le changement de l'environnement, et la texture produite est principalement causée par la réfraction et la réflexion de la lumière, ce qui apporte de grandes difficultés à la détection des objets transparents.

2. L'annotation d'ensembles de données transparents est plus difficile que l'annotation d'objets ordinaires. Dans les scènes réelles, il est parfois difficile pour les humains de distinguer les objets transparents tels que le verre, et encore moins d'étiqueter les images d'objets transparents.

3. La surface des objets transparents est lisse, et même un petit écart dans la position de saisie peut conduire à l'échec de la tâche de saisie.

Par conséquent, comment résoudre le problème de la capture d'objets transparents dans diverses scènes complexes avec le moins de coûts possible est devenu une question très importante dans le domaine de la recherche sur les objets transparents. Récemment, l'équipe de perception intelligente et de robotique de l'école supérieure internationale de Shenzhen de l'université Tsinghua a proposé un cadre de saisie d'objets transparents basé sur la fusion visuelle et tactile pour réaliser la détection et la saisie d'objets transparents. Cette méthode a non seulement un taux de réussite de saisie très élevé, mais peut également être adaptée à la saisie d'objets transparents dans diverses scènes complexes.

Photos

Photos

Veuillez consulter le lien suivant : https://ieeexplore.ieee.org/document/10175024

Professeur associé Ding Wenbo de la Shenzhen International Graduate School de l'Université Tsinghua, auteur correspondant du journal, a déclaré : « Les robots sont dans le domaine des services à domicile a montré une grande valeur d'application, mais la plupart des robots actuels se concentrent sur un seul domaine. La proposition d'un modèle de préhension de robot universel apportera une énorme promotion à la promotion et l'application de la technologie robotique. Bien que nous le soyons. Les objets transparents sont utilisés comme objet de recherche, mais ce cadre peut être facilement étendu aux tâches de saisie d'objets courants dans la vie "

Chercheur Liu Houde, l'auteur correspondant de l'article. et l'école supérieure internationale de Shenzhen de l'université Tsinghua, a déclaré : « Dans les scènes familiales. L'environnement non structuré pose de grands défis à l'application pratique des robots. Nous intégrons la vision et la perception tactile pour simuler davantage le processus de perception lorsque les humains interagissent avec le monde extérieur, offrant ainsi plus stabilité pour les applications robotiques dans des scénarios complexes. En plus d'intégrer la vision et le toucher, le cadre que nous avons proposé peut également être étendu à davantage de modalités telles que l'audition. Pour cette tâche, en plus de détecter la position de l'objet pendant le processus de saisie, la position et l'angle de saisie doivent également être pris en compte. Actuellement, la plupart des travaux de saisie d'objets transparents sont effectués sur un plan avec un arrière-plan simple, mais dans la vraie vie, la plupart des scènes ne seront pas aussi idéales que notre environnement expérimental. Certaines scènes spéciales, comme les fragments de verre, les tas, les chevauchements, les ondulations, le sable et les scènes sous-marines, sont plus difficiles.

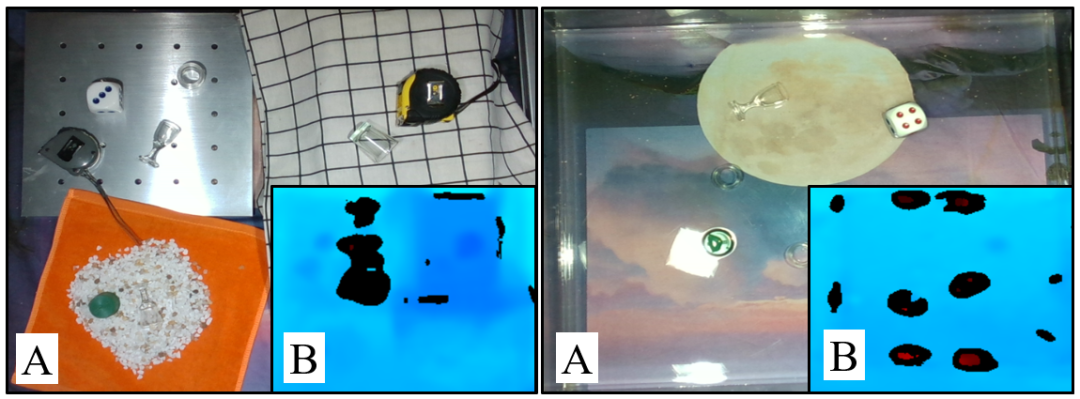

- Tout d'abord, les fragments de verre sont des objets sans modèle fixe. En raison de leurs formes aléatoires et changeantes, ils imposent des exigences élevées en matière de polyvalence du réseau de préhension et des outils de préhension.

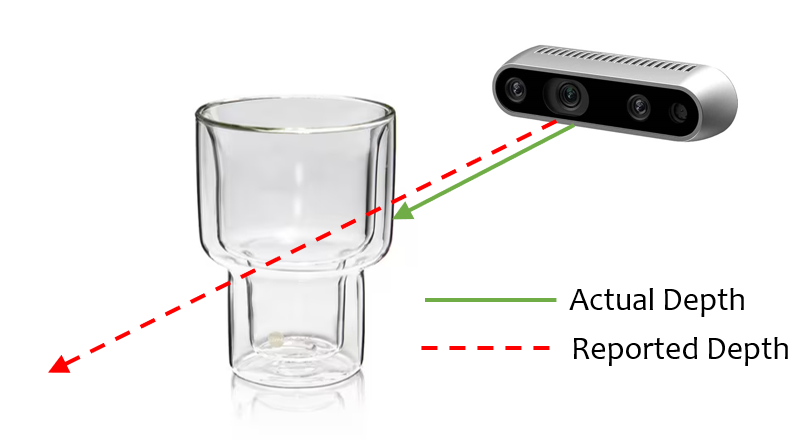

- Deuxièmement, saisir des objets transparents sur des plans ondulés est également un défi. Comme le montre la figure ci-dessous, d'une part, les informations de profondeur des objets transparents sont difficiles à obtenir avec précision, et d'autre part, la scène ondulée présente des ombres, des chevauchements et des zones de réflexion, ce qui pose davantage de défis à la détection. d'objets transparents.

- Troisièmement, en raison des propriétés optiques similaires de l'eau et des objets transparents, saisir des objets transparents dans des scènes sous-marines est également un défi. Même avec une caméra de profondeur, les objets transparents ne peuvent pas être détectés avec précision dans l'eau, et la situation s'aggrave lorsqu'ils sont éclairés par une lumière provenant de différentes directions.

Images

Images

Conception d'algorithme

Images

Images

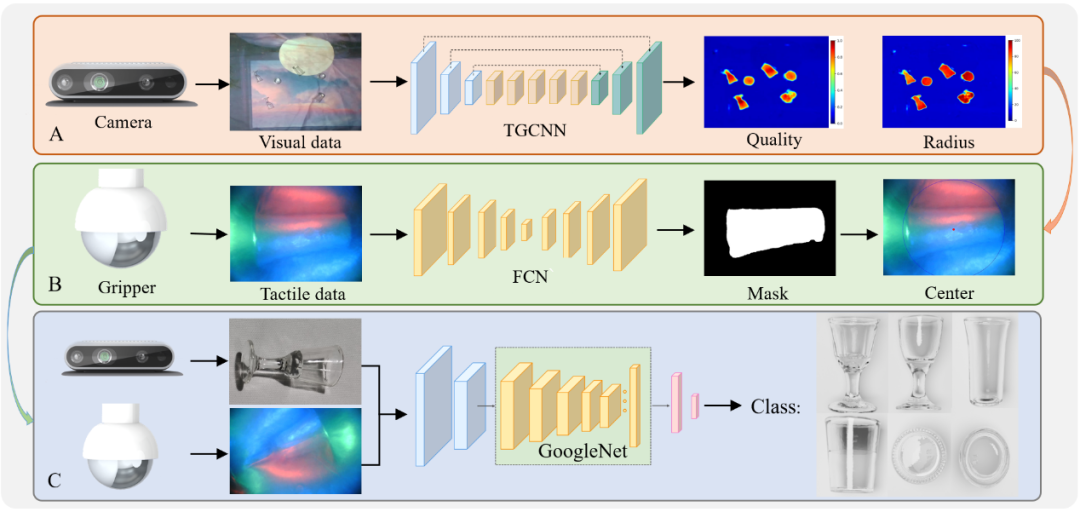

La conception de l'algorithme de préhension est présentée dans la figure Afin de réaliser la préhension d'objets transparents, nous avons proposé séparément la détection de la position de préhension d'objets transparents. algorithme, algorithme d'extraction d'informations tactiles et algorithme de classification de fusion visuo-tactile. Afin de réduire le coût d'étiquetage de l'ensemble de données, nous avons utilisé Blender pour créer un ensemble de données synthétiques récupérant des objets transparents multi-arrière-plans SimTrans12K, qui contient 12 000 images synthétiques et 160 images réelles. En plus de l'ensemble de données, nous proposons également une méthode d'annotation de masque gaussien pour les propriétés optiques uniques des objets transparents. Puisque nous utilisons la pince Jamming comme exécuteur, nous proposons un réseau de préhension spécialisé TGCNN, qui peut obtenir de bons résultats de détection après un entraînement sur l'ensemble de données synthétiques.

Grasping Framework

Nous avons intégré les algorithmes ci-dessus pour compléter la saisie d'objets transparents dans différents scénarios, ce qui constitue la stratégie de saisie de niveau supérieur de notre cadre de fusion visuel-touch. Nous décomposons une tâche de préhension en trois sous-tâches, à savoir la classification des objets, la détection de la position de préhension et la détection de la hauteur de préhension. Chaque sous-tâche peut être accomplie par la vue, le toucher ou la fusion vue-toucher.

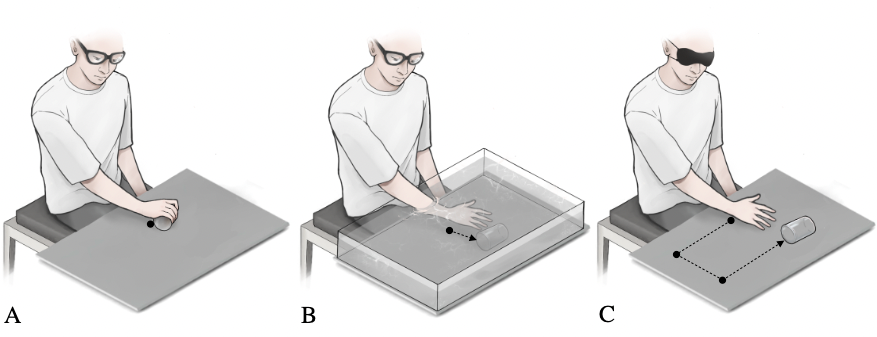

Semblable au comportement humain lors de la préhension, lorsque la vision peut obtenir directement la position précise d'un objet, nous pouvons contrôler la main pour atteindre directement l'objet et terminer la saisie, comme le montre la figure ci-dessous (A). Lorsque la vision ne peut pas obtenir avec précision les informations de position d'un objet, après avoir utilisé la vision pour estimer la position de l'objet, nous utiliserons la fonction de détection tactile de la main pour ajuster lentement la position de préhension jusqu'à ce que l'objet soit contacté et que la position de préhension appropriée soit atteint, comme le montre la figure ci-dessous (B). Pour saisir un objet dans des conditions de vision limitées, comme le montre la figure ci-dessous (C), nous utiliserons les riches nerfs tactiles de la main pour rechercher dans la portée possible de la cible jusqu'à ce que le contact avec l'objet soit établi, bien que cela soit très inefficace. , Mais c'est une méthode efficace pour résoudre la saisie d'objets dans ces scénarios spéciaux.

Images

Images

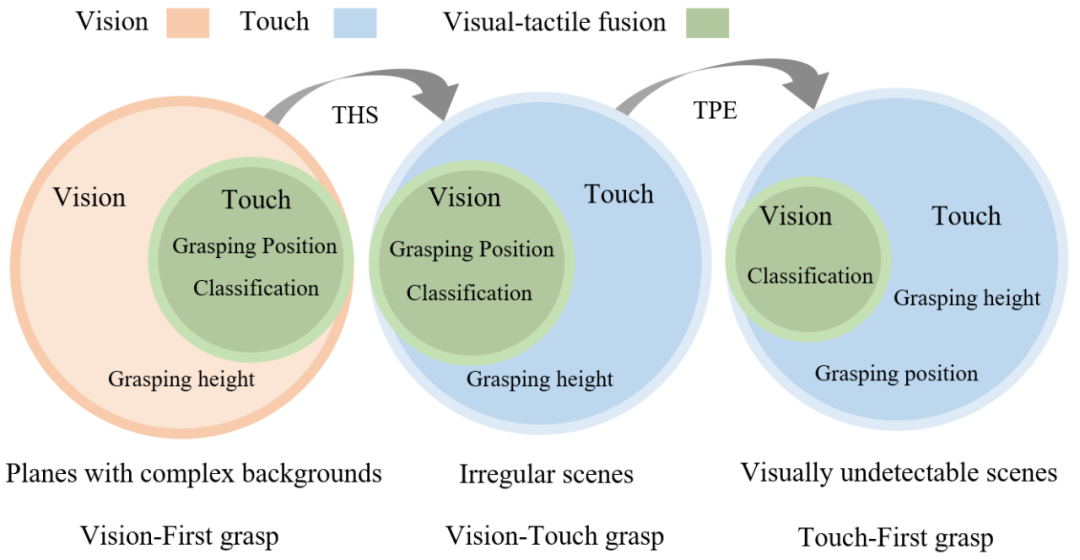

Inspirés par les stratégies de préhension humaines, nous divisons les tâches de préhension des objets transparents en trois types : les plans avec des arrière-plans complexes, les scènes irrégulières et les scènes qui ne peuvent pas être détectées visuellement, comme indiqué ci-dessous. Dans le premier type, la vision joue un rôle clé, et nous définissons la méthode de saisie dans ce scénario comme une méthode de saisie axée sur la vision. Dans le deuxième type, la vision et le toucher peuvent fonctionner ensemble, et nous définissons la méthode de saisie dans ce scénario comme une saisie visuo-tactile. Dans ce dernier type, la vision peut échouer et le toucher devient dominant dans la tâche. Nous définissons la méthode de saisie dans ce scénario comme une méthode de saisie axée sur le toucher.

Photos

Photos

Le processus de la méthode de préhension axée sur la vision est illustré dans la figure ci-dessous. Tout d'abord, TGCNN est utilisé pour obtenir la position de préhension et la hauteur, puis les informations tactiles sont utilisées pour calibrer la position de préhension. , et enfin l'algorithme de fusion visuel-tactile est utilisé pour la classification. La préhension visuo-tactile est basée sur la précédente et y ajoute le module THS, qui permet d'utiliser le sens du toucher pour obtenir la hauteur de l'objet. L’approche de préhension haptique d’abord a été complétée par un module TPE qui utilise le sens du toucher pour obtenir la position des objets transparents.

Vérification expérimentale

Afin de vérifier l'efficacité du cadre et de l'algorithme proposés, nous avons mené un grand nombre d'expériences de vérification.

Tout d'abord, afin de tester l'efficacité de notre ensemble de données d'objets transparents, de notre méthode d'annotation et de notre réseau de détection de position de préhension, nous avons mené des expériences de détection de données synthétiques et des expériences de détection de position de préhension d'objets transparents sous différents arrière-plans et luminosités. Deuxièmement, afin de vérifier l'efficacité du cadre de saisie par fusion visuo-tactile, nous avons conçu une expérience de saisie de classification d'objets transparente et une expérience de saisie de fragments transparents. Troisièmement, nous avons conçu une expérience de saisie d'objets transparents dans des scènes irrégulières et visuellement restreintes pour tester l'efficacité du cadre après l'ajout des modules THS et TPE.

Résumé

Pour résoudre le problème difficile de la détection, de la saisie et de la classification des objets transparents, cette étude propose un cadre de fusion visuel-haptique basé sur un ensemble de données synthétiques. Premièrement, le moteur de simulation Blender est utilisé pour restituer des ensembles de données synthétiques au lieu d’ensembles de données annotés manuellement.

De plus, le masque gaussien est utilisé à la place de la méthode d'annotation binaire traditionnelle pour rendre la génération des positions de saisie plus précise. Afin de détecter la position de préhension des objets transparents, l'auteur a proposé un algorithme appelé TGCNN et a mené plusieurs expériences comparatives. Les résultats montrent que même si seuls des ensembles de données synthétiques sont utilisés pour la formation, l'algorithme peut fonctionner correctement sur différents arrière-plans et éclairages. conditions pour obtenir une bonne détection.

Considérant les difficultés de préhension causées par les limitations de la détection visuelle, cette étude propose une méthode d'étalonnage tactile combinée à la pince souple TaTa pour améliorer le taux de réussite de la préhension en ajustant la position de préhension avec des informations tactiles. Par rapport à la saisie visuelle pure, cette méthode améliore le taux de réussite de la saisie de 36,7 %.

Pour résoudre le problème de la classification des objets transparents dans des scènes complexes, cette étude propose une méthode de classification des objets transparents basée sur la fusion vision-tactile, qui améliore la précision de 39,1 % par rapport à la classification basée uniquement sur la vision.

De plus, pour obtenir une préhension d'objet transparente dans des scènes irrégulières et visuellement indétectables, cette étude propose des modules THS et TPE, qui peuvent compenser le problème de préhension d'objet transparent en l'absence d'information visuelle. Les chercheurs ont systématiquement conçu un grand nombre d'expériences pour vérifier l'efficacité du cadre proposé dans des scènes complexes telles que diverses superpositions, chevauchements, ondulations, zones sableuses et scènes sous-marines. L'étude estime que le cadre proposé peut également être appliqué à la détection d'objets dans des environnements à faible visibilité, tels que la fumée et l'eau trouble, où la perception tactile peut compenser le manque de détection visuelle et améliorer la précision de la classification grâce à la fusion visuelle-tactile.

À propos de l'auteur

L'instructeur du projet de saisie d'objets transparents par fusion visuelle et tactile est Ding Wenbo. Il est actuellement professeur agrégé à la Shenzhen International Graduate School de l'Université Tsinghua et dirige la perception intelligente. et groupe de recherche en robotique. Ses intérêts de recherche portent principalement sur le traitement du signal, l’apprentissage automatique, les appareils portables, l’interaction flexible homme-machine et la perception des machines. Il a auparavant obtenu une licence et un doctorat du Département de génie électronique de l'Université Tsinghua, et a été chercheur postdoctoral à l'Institut de technologie de Géorgie sous la tutelle de l'académicien Wang Zhonglin. Il a remporté de nombreux prix tels que le Prix Spécial de l'Université Tsinghua, la Médaille d'Or du 47ème Salon International des Inventions de Genève, le Prix Commémoratif IEEE Scott Helt, le Deuxième Prix du Natural Science Award de la China Electronics Society, etc. et a travaillé dans Nature Communications, Science Advances, Energy and Environmental Science, Advanced Energy. Il a publié plus de 70 articles dans des revues faisant autorité dans les domaines des matériaux, IEEE TRO/RAL et d'autres domaines, a été cité plus de 6 000 fois par Google. Scholar, et a autorisé plus de 10 brevets en Chine et aux États-Unis. Il est rédacteur associé de la revue internationale faisant autorité sur le traitement du signal, Digital Signal Processing, rédacteur invité en chef du numéro spécial de l'IEEE JSTSP sur la perception des robots et membre du comité technique des systèmes de traitement du signal appliqué de l'IEEE Signal Processing Society.

Page d'accueil du groupe de recherche : http://ssr-group.net/.

De gauche à droite : Shoujie Li, Haixin Yu, Houde Liu

Les co-auteurs de l'article sont Shoujie Li (étudiant en doctorat à l'Université Tsinghua) et Haixin Yu (étudiant en maîtrise à l'Université Tsinghua). Les auteurs correspondants sont Wenbo Ding et Houde Liu. Les autres auteurs incluent Linqi Ye (Université de Shanghai) et. Chongkun Xia (Université Tsinghua), Xueqian Wang (Université Tsinghua), Xiao-Ping Zhang (Université Tsinghua). Parmi eux, les principales directions de recherche de Shoujie Li sont la préhension des robots, la perception tactile et l'apprentissage profond. En tant que premier auteur, il a publié de nombreux articles dans des revues et conférences faisant autorité en matière de robotique et de contrôle telles que Soft Robotics, TRO, RAL, ICRA, IROS, etc. ., et a autorisé 10 brevets d'invention. Les projets restants ont remporté 10 prix de concours provinciaux et ministériels. Les résultats de recherche pertinents ont été sélectionnés comme premier auteur dans le cadre des « Mécanismes exceptionnels et finalistes du document de conception de l'ICRA 2022 ». Bourse d'études et bourse nationale de l'Université Tsinghua.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Comment implémenter le tri des fichiers par Debian Readdir

Apr 13, 2025 am 09:06 AM

Dans Debian Systems, la fonction ReadDir est utilisée pour lire le contenu du répertoire, mais l'ordre dans lequel il revient n'est pas prédéfini. Pour trier les fichiers dans un répertoire, vous devez d'abord lire tous les fichiers, puis les trier à l'aide de la fonction QSORT. Le code suivant montre comment trier les fichiers de répertoire à l'aide de ReadDir et QSort dans Debian System: # include # include # include # include # include // Fonction de comparaison personnalisée, utilisée pour qsortintCompare (constvoid * a, constvoid * b) {returnstrcmp (* (

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Comment optimiser les performances de Debian Readdir

Apr 13, 2025 am 08:48 AM

Dans Debian Systems, les appels du système ReadDir sont utilisés pour lire le contenu des répertoires. Si ses performances ne sont pas bonnes, essayez la stratégie d'optimisation suivante: simplifiez le nombre de fichiers d'annuaire: divisez les grands répertoires en plusieurs petits répertoires autant que possible, en réduisant le nombre d'éléments traités par appel ReadDir. Activer la mise en cache de contenu du répertoire: construire un mécanisme de cache, mettre à jour le cache régulièrement ou lorsque le contenu du répertoire change et réduire les appels fréquents à Readdir. Les caches de mémoire (telles que Memcached ou Redis) ou les caches locales (telles que les fichiers ou les bases de données) peuvent être prises en compte. Adoptez une structure de données efficace: si vous implémentez vous-même la traversée du répertoire, sélectionnez des structures de données plus efficaces (telles que les tables de hachage au lieu de la recherche linéaire) pour stocker et accéder aux informations du répertoire

Comment définir le niveau de journal Debian Apache

Apr 13, 2025 am 08:33 AM

Comment définir le niveau de journal Debian Apache

Apr 13, 2025 am 08:33 AM

Cet article décrit comment ajuster le niveau de journalisation du serveur Apacheweb dans le système Debian. En modifiant le fichier de configuration, vous pouvez contrôler le niveau verbeux des informations de journal enregistrées par Apache. Méthode 1: Modifiez le fichier de configuration principal pour localiser le fichier de configuration: le fichier de configuration d'Apache2.x est généralement situé dans le répertoire / etc / apache2 /. Le nom de fichier peut être apache2.conf ou httpd.conf, selon votre méthode d'installation. Modifier le fichier de configuration: Ouvrez le fichier de configuration avec les autorisations racine à l'aide d'un éditeur de texte (comme Nano): Sutonano / etc / apache2 / apache2.conf

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Comment Debian OpenSSL empêche les attaques de l'homme au milieu

Apr 13, 2025 am 10:30 AM

Dans Debian Systems, OpenSSL est une bibliothèque importante pour le chiffrement, le décryptage et la gestion des certificats. Pour empêcher une attaque d'homme dans le milieu (MITM), les mesures suivantes peuvent être prises: utilisez HTTPS: assurez-vous que toutes les demandes de réseau utilisent le protocole HTTPS au lieu de HTTP. HTTPS utilise TLS (Protocole de sécurité de la couche de transport) pour chiffrer les données de communication pour garantir que les données ne sont pas volées ou falsifiées pendant la transmission. Vérifiez le certificat de serveur: vérifiez manuellement le certificat de serveur sur le client pour vous assurer qu'il est digne de confiance. Le serveur peut être vérifié manuellement via la méthode du délégué d'URLSession

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Méthode d'installation du certificat de Debian Mail Server SSL

Apr 13, 2025 am 11:39 AM

Les étapes pour installer un certificat SSL sur le serveur de messagerie Debian sont les suivantes: 1. Installez d'abord la boîte à outils OpenSSL, assurez-vous que la boîte à outils OpenSSL est déjà installée sur votre système. Si ce n'est pas installé, vous pouvez utiliser la commande suivante pour installer: Sudoapt-getUpDaSuDoapt-getInstallOpenSSL2. Générer la clé privée et la demande de certificat Suivant, utilisez OpenSSL pour générer une clé privée RSA 2048 bits et une demande de certificat (RSE): OpenSS

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

Comment Debian Readdir s'intègre à d'autres outils

Apr 13, 2025 am 09:42 AM

La fonction ReadDir dans le système Debian est un appel système utilisé pour lire le contenu des répertoires et est souvent utilisé dans la programmation C. Cet article expliquera comment intégrer ReadDir avec d'autres outils pour améliorer sa fonctionnalité. Méthode 1: combinant d'abord le programme de langue C et le pipeline, écrivez un programme C pour appeler la fonction readdir et sortir le résultat: # include # include # include # includeIntmain (intargc, char * argv []) {dir * dir; structDirent * entrée; if (argc! = 2) {

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

Conseils de configuration du pare-feu Debian Mail Server

Apr 13, 2025 am 11:42 AM

La configuration du pare-feu d'un serveur de courrier Debian est une étape importante pour assurer la sécurité du serveur. Voici plusieurs méthodes de configuration de pare-feu couramment utilisées, y compris l'utilisation d'iptables et de pare-feu. Utilisez les iptables pour configurer le pare-feu pour installer iptables (sinon déjà installé): Sudoapt-getUpDaSuDoapt-getinstalliptableView Règles actuelles iptables: Sudoiptable-L Configuration

Comment apprendre Debian Syslog

Apr 13, 2025 am 11:51 AM

Comment apprendre Debian Syslog

Apr 13, 2025 am 11:51 AM

Ce guide vous guidera pour apprendre à utiliser Syslog dans Debian Systems. Syslog est un service clé dans les systèmes Linux pour les messages du système de journalisation et du journal d'application. Il aide les administrateurs à surveiller et à analyser l'activité du système pour identifier et résoudre rapidement les problèmes. 1. Connaissance de base de Syslog Les fonctions principales de Syslog comprennent: la collecte et la gestion des messages journaux de manière centralisée; Prise en charge de plusieurs formats de sortie de journal et des emplacements cibles (tels que les fichiers ou les réseaux); Fournir des fonctions de visualisation et de filtrage des journaux en temps réel. 2. Installer et configurer syslog (en utilisant RSYSLOG) Le système Debian utilise RSYSLOG par défaut. Vous pouvez l'installer avec la commande suivante: SudoaptupDatesud