Périphériques technologiques

Périphériques technologiques

IA

IA

Intel Zhang Yu : Edge computing joue un rôle important dans l'ensemble de l'écosystème de l'IA

Intel Zhang Yu : Edge computing joue un rôle important dans l'ensemble de l'écosystème de l'IA

Intel Zhang Yu : Edge computing joue un rôle important dans l'ensemble de l'écosystème de l'IA

[Lin Mengxue, journaliste scientifique et technologique du réseau mondial] Actuellement, l'IA générative et les grands modèles deviennent populaires partout dans le monde. Lors de la Conférence mondiale sur l'intelligence artificielle 2023 (WAIC 2023) qui vient de se dérouler, divers fabricants ont lancé un « centenaire ». "Model War", selon les statistiques incomplètes du comité d'organisation, un total de plus de 30 grandes plates-formes modèles ont été publiées et dévoilées, 60 % des stands hors ligne ont démontré l'introduction et l'application pertinentes de la technologie d'IA générative, et 80 % des les participants ont discuté du contenu autour des grands modèles. Le modèle s'étend.

Lors du WAIC 2023, Zhang Yu, ingénieur en chef principal en IA d'Intel Corporation et directeur de la technologie de la division Network and Edge Chine, a estimé que le facteur central favorisant le développement de ce cycle d'intelligence artificielle est en fait l'amélioration continue de l'informatique, de la communication et technologies de stockage. Dans l’ensemble de l’écosystème de l’IA, qu’il s’agisse de modèles à grande échelle ou de fusion d’IA, la périphérie joue un rôle crucial.

Zhang Yu a déclaré : « Avec la transformation numérique de l'industrie, les demandes des gens en matière de connexions agiles, d'intelligence commerciale et applicative en temps réel ont favorisé le développement de l'intelligence artificielle de pointe. Cependant, la plupart des applications actuelles de l'intelligence artificielle de pointe sont toujours d'actualité. l'étape d'inférence de périphérie. En d'autres termes, nous devons utiliser une grande quantité de données et une énorme puissance de calcul pour former un modèle dans le centre de données, et nous poussons les résultats de la formation vers le front-end pour effectuer une opération d'inférence. le modèle d'utilisation actuel pour la mise en œuvre de l'intelligence artificielle à la périphérie »

.« Ce modèle limitera inévitablement la fréquence des mises à jour des modèles, mais nous avons également constaté que de nombreuses industries intelligentes ont en fait des demandes de mises à jour de modèles. La conduite autonome doit pouvoir s'adapter aux différentes conditions routières et être adaptée aux habitudes de conduite des différentes. Cependant, lorsque nous formons un modèle dans une usine automobile, il existe souvent certaines différences entre les données de formation utilisées et les données générées lors de la conduite dynamique. Cette différence affecte la capacité de généralisation du modèle, c'est-à-dire aux nouvelles conditions routières. la capacité de s’adapter à de nouveaux comportements de conduite. Nous devons continuellement former et optimiser le modèle à la pointe pour faire progresser ce processus », a-t-il déclaré.

Par conséquent, Zhang Yu a proposé que la deuxième étape du développement de l'intelligence artificielle soit l'étape de formation de pointe. « Si nous voulons mettre en œuvre la formation de pointe, nous avons besoin de moyens et d'outils plus automatisés pour mener à bien un processus de développement complet, de l'annotation des données à la formation des modèles, en passant par le déploiement des modèles. » Il a déclaré que la prochaine direction de développement de l'intelligence artificielle de pointe devrait être celle-ci. est un apprentissage indépendant.

Dans le processus de développement actuel, l'intelligence artificielle de pointe est également confrontée à de nombreux défis. Selon Zhang Yu, outre les défis de la formation de pointe, il existe également des défis liés à l'équipement de pointe. "Étant donné que la consommation d'énergie que la puissance de calcul fournie peut supporter est souvent limitée, la manière de mettre en œuvre le raisonnement et la formation de pointe avec des ressources limitées impose des exigences plus élevées en termes de performances et de consommation d'énergie de la puce." la fragmentation des appareils de pointe est très évidente, et la manière d'utiliser les logiciels pour réaliser la migration entre différentes plates-formes met également en avant davantage d'exigences.

De plus, le développement de l'intelligence artificielle est étroitement lié à la puissance de calcul, et derrière la puissance de calcul se cache une énorme base de données face à des actifs de données massifs, la manière de protéger les données est devenue un sujet brûlant dans le développement de l'intelligence artificielle. intelligence. Une fois l’IA déployée en périphérie, ces modèles échapperont au contrôle du fournisseur de services. Comment pouvons-nous protéger le modèle à ce moment-là ? Et il est nécessaire d’obtenir de bons effets de protection pendant le stockage et le fonctionnement. Tels sont les défis auxquels est confrontée l’intelligence artificielle de pointe. »

"Intel est une société de données et nos produits couvrent tous les aspects de l'informatique, de la communication et du stockage. En termes d'informatique, Intel propose une variété de produits, notamment des CPU, des GPU, des FPGA et diverses puces d'accélération d'intelligence artificielle. , pour répondre aux attentes des utilisateurs. différentes exigences en matière de puissance de calcul. Par exemple, en termes de grands modèles d'intelligence artificielle, le produit Gaudi2 lancé par Habana d'Intel est le seul produit du secteur qui affiche d'excellentes performances dans la formation de grands modèles, la suite d'outils de déploiement d'apprentissage en profondeur OpenVINO fournie par. Intel peut déployer rapidement les modèles conçus et formés par les développeurs sur le cadre ouvert d'intelligence artificielle sur différentes plates-formes matérielles pour effectuer des opérations d'inférence. »

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Processeur Intel Core Ultra 9 285K exposé : le score de fonctionnement multicœur CineBench R23 est 18 % supérieur à celui du i9-14900K

Jul 25, 2024 pm 12:25 PM

Processeur Intel Core Ultra 9 285K exposé : le score de fonctionnement multicœur CineBench R23 est 18 % supérieur à celui du i9-14900K

Jul 25, 2024 pm 12:25 PM

Selon les informations de ce site Web du 25 juillet, la source Jaykihn a publié un tweet sur la plate-forme X hier (24 juillet), partageant les données de score de fonctionnement du processeur de bureau Intel Core Ultra9285K "ArrowLake-S". mieux que le Core 14900K 18% plus rapide. Ce site a cité le contenu du tweet. La source a partagé les scores des versions ES2 et QS du processeur Intel Core Ultra9285K et les a comparés avec le processeur Core i9-14900K. Selon les rapports, le TD d'ArrowLake-SQS lors de l'exécution de charges de travail telles que CinebenchR23, Geekbench5, SpeedoMeter, WebXPRT4 et CrossMark

Intel annonce la carte réseau Wi-Fi 7 BE201 et prend en charge l'interface CNVio3

Jun 07, 2024 pm 03:34 PM

Intel annonce la carte réseau Wi-Fi 7 BE201 et prend en charge l'interface CNVio3

Jun 07, 2024 pm 03:34 PM

Selon les informations de ce site du 1er juin, Intel a mis à jour le document d'assistance le 27 mai et a annoncé les détails du produit de la carte réseau Wi-Fi7 (802.11be) BE201 nommée « Fillmore Peak2 ». Source de l'image ci-dessus : site Web Benchlife Remarque : contrairement aux BE200 et BE202 existants qui utilisent l'interface PCIe/USB, le BE201 prend en charge la dernière interface CNVio3. Les principales spécifications de la carte réseau BE201 sont similaires à celles de la BE200. Elle prend en charge le streaming 2x2TX/RX, prend en charge 2,4 GHz, 5 GHz et 6 GHz. La vitesse maximale du réseau peut atteindre 5 Gbit/s, ce qui est bien inférieur au débit standard maximum de 40 Gbit/s. /s. BE201 prend également en charge Bluetooth 5.4 et Bluetooth LE.

Processeur Intel N250 basse consommation exposé : 4 cœurs, 4 threads, fréquence de 1,2 GHz

Jun 03, 2024 am 10:26 AM

Processeur Intel N250 basse consommation exposé : 4 cœurs, 4 threads, fréquence de 1,2 GHz

Jun 03, 2024 am 10:26 AM

Selon les informations de ce site du 16 mai, la source @InstLatX64 a récemment tweeté qu'Intel se prépare à lancer une nouvelle série N250 "TwinLake" de processeurs basse consommation pour remplacer la série N200 "AlderLake-N". Source : videocardz Les processeurs de la série N200 sont populaires dans les ordinateurs portables à faible coût, les clients légers, les systèmes embarqués, les terminaux libre-service et de point de vente, les NAS et l'électronique grand public. "TwinLake" est le nom de code de la nouvelle série de processeurs, qui est quelque peu similaire au processeur monopuce Dies utilisant une configuration de bus en anneau (RingBus), mais avec un cluster E-core pour compléter la puissance de calcul. Les captures d'écran jointes à ce site sont les suivantes : Exploitation minière AlderLake-N

MSI lance la nouvelle mini console MS-C918 avec processeur Intel Alder Lake-N N100

Jul 03, 2024 am 11:33 AM

MSI lance la nouvelle mini console MS-C918 avec processeur Intel Alder Lake-N N100

Jul 03, 2024 am 11:33 AM

Ce site Web a rapporté le 3 juillet que afin de répondre aux besoins diversifiés des entreprises modernes, MSIIPC, une filiale de MSI, a récemment lancé le MS-C918, un mini-hôte industriel. Aucun prix public n'a encore été trouvé. Le MS-C918 est destiné aux entreprises qui se concentrent sur la rentabilité, la facilité d'utilisation et la portabilité. Il est spécialement conçu pour les environnements non critiques et offre une garantie de durée de vie de 3 ans. Le MS-C918 est un ordinateur industriel portable utilisant le processeur Intel AlderLake-NN100, spécialement conçu pour les solutions à très faible consommation. Les principales fonctions et caractéristiques du MS-C918 attachées à ce site sont les suivantes : Taille compacte : 80 mm x 80 mm x 36 mm, taille de la paume, facile à utiliser et cachée derrière l'écran. Fonction d'affichage : via 2 HDMI2.

ASUS publie une mise à jour du BIOS pour les cartes mères Z790 afin d'atténuer les problèmes d'instabilité avec les processeurs Intel Core de 13e et 14e génération

Aug 09, 2024 am 12:47 AM

ASUS publie une mise à jour du BIOS pour les cartes mères Z790 afin d'atténuer les problèmes d'instabilité avec les processeurs Intel Core de 13e et 14e génération

Aug 09, 2024 am 12:47 AM

Selon des informations publiées sur ce site Web le 8 août, MSI et ASUS ont lancé aujourd'hui une version bêta du BIOS contenant la mise à jour du microcode 0x129 pour certaines cartes mères Z790 en réponse aux problèmes d'instabilité des processeurs de bureau Intel Core de 13e et 14e génération. Le premier lot de cartes mères ASUS à fournir des mises à jour du BIOS comprend : ROGMAXIMUSZ790HEROBetaBios2503ROGMAXIMUSZ790DARKHEROBetaBios1503ROGMAXIMUSZ790HEROBTFBetaBios1503ROGMAXIMUSZ790HEROEVA-02 version commune BetaBios2503ROGMAXIMUSZ790A

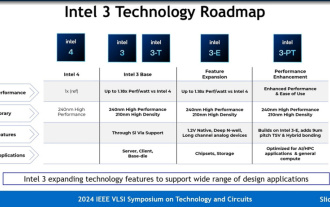

Intel explique en détail le processus Intel 3 : appliquer davantage de lithographie EUV, augmentant la fréquence de la même consommation d'énergie jusqu'à 18 %

Jun 19, 2024 pm 10:53 PM

Intel explique en détail le processus Intel 3 : appliquer davantage de lithographie EUV, augmentant la fréquence de la même consommation d'énergie jusqu'à 18 %

Jun 19, 2024 pm 10:53 PM

Selon les informations de ce site du 19 juin, dans le cadre des activités du séminaire IEEEVLSI 2024, Intel a récemment présenté les détails techniques du nœud de processus Intel3 sur son site officiel. La dernière génération de technologie de transistor FinFET d'Intel est la dernière génération de technologie de transistor FinFET d'Intel. Par rapport à Intel4, elle a ajouté des étapes pour utiliser EUV. Il s'agira également d'une famille de nœuds qui fournira des services de fonderie pendant longtemps, y compris Intel3 de base et trois variantes. nœuds. Parmi eux, Intel3-E prend en charge nativement la haute tension de 1,2 V, ce qui convient à la fabrication de modules analogiques ; tandis que le futur Intel3-PT améliorera encore les performances globales et prendra en charge un TSV à pas de 9 µm plus fin et une liaison hybride. Intel affirme que comme son

Spécifications du processeur mobile Intel Panther Lake exposées : jusqu'à '4+8+4' processeur 16 cœurs, écran 12 cœurs Xe3

Jul 18, 2024 pm 04:43 PM

Spécifications du processeur mobile Intel Panther Lake exposées : jusqu'à '4+8+4' processeur 16 cœurs, écran 12 cœurs Xe3

Jul 18, 2024 pm 04:43 PM

Selon l'actualité de ce site le 16 juillet, suite à la révélation des spécifications du processeur de bureau ArrowLake et du processeur de bureau BartlettLake, le blogueur @jaykihn0 a publié tôt le matin les spécifications des versions mobiles U et H du processeur Intel PantherLake. Le processeur mobile Panther Lake devrait s'appeler la série Core Ultra300 et sera disponible dans les versions suivantes : PTL-U : 4P+0E+4LPE+4Xe, 15WPL1PTL-H : 4P+8E+4LPE+12Xe, 25WPL1PTL-H : 4P+8E+4LPE+ 4Xe, 25WPL1 Le blogueur a également publié la version à écran nucléaire 12Xe du processeur PantherLake.

Le 6700E fait ses débuts en Chine le 6 juin, Intel lance officiellement les processeurs de la série Xeon 6

Jun 06, 2024 am 10:51 AM

Le 6700E fait ses débuts en Chine le 6 juin, Intel lance officiellement les processeurs de la série Xeon 6

Jun 06, 2024 am 10:51 AM

Ce site a rapporté le 4 juin qu'Intel prévoyait de lancer une nouvelle génération de processeurs Xeon par lots d'ici le premier trimestre de l'année prochaine, parmi lesquels le Xeon 6700E sera lancé en Chine le 6 juin. Intel prévoit de lancer le Xeon 6900P « Granite Rapids » sur le marché international au troisième trimestre 2024, avec jusqu'à 128 cœurs ; et le Xeon 6900E « Sierra Forest » au premier trimestre 2025, avec jusqu'à 288 cœurs. La série « Xeon 6 » est divisée en séries E et P : Série P La série P est principalement destinée aux charges de travail gourmandes en calcul et en IA telles que le calcul haute performance, les bases de données et l'analyse, l'intelligence artificielle, le réseau, la périphérie et l'infrastructure/stockage. , avec jusqu'à 128 cœurs de performances personnels, dont 6900P/