développement back-end

développement back-end

tutoriel php

tutoriel php

PHP et phpSpider : Comment gérer le blocage anti-crawler ?

PHP et phpSpider : Comment gérer le blocage anti-crawler ?

PHP et phpSpider : Comment gérer le blocage anti-crawler ?

PHP et phpSpider : Comment gérer le blocage anti-crawler ?

Introduction :

Avec le développement rapide d'Internet, la demande de big data augmente également. En tant qu'outil d'exploration des données, un robot d'exploration peut extraire automatiquement les informations requises des pages Web. Cependant, en raison de l'existence de robots d'exploration, de nombreux sites Web ont adopté divers mécanismes anti-crawler, tels que des codes de vérification, des restrictions IP, la connexion au compte, etc., afin de protéger leurs propres intérêts. Cet article explique comment utiliser PHP et phpSpider pour gérer ces mécanismes de blocage.

1. Comprendre le mécanisme anti-crawler

1.1 Code de vérification

Le code de vérification est un mécanisme anti-crawler couramment utilisé sur les sites Web. Il affiche des caractères ou des images difficiles à reconnaître à l'utilisateur et oblige l'utilisateur à saisir le code. corriger le code de vérification avant de pouvoir continuer à accéder au site Web. Déchiffrer le CAPTCHA est un défi pour les robots d'exploration. Vous pouvez utiliser des outils tiers, tels que Tesseract OCR, pour convertir l'image du code de vérification en texte afin de reconnaître automatiquement le code de vérification.

1.2 Restrictions IP

Afin d'empêcher les robots d'exploration de visiter le site Web trop fréquemment, de nombreux sites Web imposeront des restrictions en fonction des adresses IP. Lorsqu’une adresse IP lance trop de requêtes sur une courte période de temps, le site Web considère l’adresse IP comme un robot et la bloque. Afin de contourner les restrictions IP, vous pouvez utiliser un serveur proxy pour simuler différents accès utilisateur en changeant d'adresse IP.

1.3 Connexion au compte

Certains sites Web exigent que les utilisateurs se connectent avant de pouvoir afficher ou extraire des données. Il s'agit également d'un mécanisme anti-crawler courant. Afin de résoudre ce problème, vous pouvez utiliser une méthode de connexion simulée et utiliser un robot pour remplir automatiquement le nom d'utilisateur et le mot de passe pour l'opération de connexion. Une fois connecté avec succès, le robot d’exploration peut accéder au site Web comme un utilisateur normal et obtenir les données requises.

2. Utilisez phpSpider pour gérer les mécanismes de blocage

phpSpider est un framework de robots open source basé sur PHP. Il fournit de nombreuses fonctions puissantes qui peuvent nous aider à gérer divers mécanismes anti-crawler.

2.1 Crackez le code de vérification

4eefdb80e7cc0eaace93a5cc9547b338

?>

Comme indiqué ci-dessus, en utilisant la bibliothèque GuzzleHttp pour envoyer une requête POST, nous pouvons simuler la connexion au site Web. Une fois la connexion réussie, continuez à accéder aux données nécessitant une connexion.

Résumé :

En apprenant les principes du mécanisme anti-crawler et en utilisant les fonctions associées du framework phpSpider, nous pouvons gérer efficacement le mécanisme de blocage du site Web, obtenant ainsi en douceur les données requises. Nous devons cependant veiller à respecter les règles d’utilisation du site et à ne pas porter atteinte aux droits d’autrui. Les reptiles sont une arme à double tranchant et ce n’est que lorsqu’ils sont utilisés de manière raisonnable et légale qu’ils peuvent maximiser leur valeur.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 apporte plusieurs nouvelles fonctionnalités, améliorations de sécurité et de performances avec une bonne quantité de dépréciations et de suppressions de fonctionnalités. Ce guide explique comment installer PHP 8.4 ou mettre à niveau vers PHP 8.4 sur Ubuntu, Debian ou leurs dérivés. Bien qu'il soit possible de compiler PHP à partir des sources, son installation à partir d'un référentiel APT comme expliqué ci-dessous est souvent plus rapide et plus sécurisée car ces référentiels fourniront les dernières corrections de bogues et mises à jour de sécurité à l'avenir.

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler avec la date et l'heure dans cakephp4, nous allons utiliser la classe FrozenTime disponible.

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP est un framework open source pour PHP. Il vise à faciliter grandement le développement, le déploiement et la maintenance d'applications. CakePHP est basé sur une architecture de type MVC à la fois puissante et facile à appréhender. Modèles, vues et contrôleurs gu

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler sur le téléchargement de fichiers, nous allons utiliser l'assistant de formulaire. Voici un exemple de téléchargement de fichiers.

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

Le validateur peut être créé en ajoutant les deux lignes suivantes dans le contrôleur.

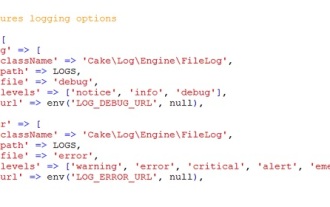

Journalisation CakePHP

Sep 10, 2024 pm 05:26 PM

Journalisation CakePHP

Sep 10, 2024 pm 05:26 PM

Se connecter à CakePHP est une tâche très simple. Il vous suffit d'utiliser une seule fonction. Vous pouvez enregistrer les erreurs, les exceptions, les activités des utilisateurs, les actions entreprises par les utilisateurs, pour tout processus en arrière-plan comme cronjob. La journalisation des données dans CakePHP est facile. La fonction log() est fournie

Comment configurer Visual Studio Code (VS Code) pour le développement PHP

Dec 20, 2024 am 11:31 AM

Comment configurer Visual Studio Code (VS Code) pour le développement PHP

Dec 20, 2024 am 11:31 AM

Visual Studio Code, également connu sous le nom de VS Code, est un éditeur de code source gratuit – ou environnement de développement intégré (IDE) – disponible pour tous les principaux systèmes d'exploitation. Avec une large collection d'extensions pour de nombreux langages de programmation, VS Code peut être c

Guide rapide CakePHP

Sep 10, 2024 pm 05:27 PM

Guide rapide CakePHP

Sep 10, 2024 pm 05:27 PM

CakePHP est un framework MVC open source. Cela facilite grandement le développement, le déploiement et la maintenance des applications. CakePHP dispose d'un certain nombre de bibliothèques pour réduire la surcharge des tâches les plus courantes.