Imaginez que vous assistez à un cocktail animé rempli de conversations animées et de bruits de verres qui tintent.

En ce moment, vous êtes un observateur tranquille, vous cachant joyeusement dans un coin. Pourtant, même sans être au centre d'une fête, vous pouvez facilement comprendre les relations sociales entre différentes personnes, comprendre ce qui se passe et même déchiffrer les messages sociaux manifestes et cachés en lisant les signaux verbaux et non verbaux des gens.

Et si un LLM pouvait reproduire ce niveau de compétences sociales ? Non, c'est ce qu'est Koko Mind.

Ouvrez simplement une vidéo et le modèle commencera à analyser l'expression du personnage et à tirer des conclusions sur l'émotion du personnage.

Ensuite, vous pouvez également poser des questions dans la barre d'invite à droite pour laisser l'IA analyser plus en détail le courant sous-jacent des énigmes sociales dans la vidéo.

(Soyons honnêtes, c'est difficile pour certaines personnes)

Photos

Photos

Koko Mind contient 150 interactions sociales multipartites complexes et des questions et réponses en texte libre.

Pour garantir la diversité et l'évolutivité des données et éviter la contamination des données, toutes les interactions sociales, questions et réponses sont générées par GPT-4 et ensuite vérifiées par des experts humains.

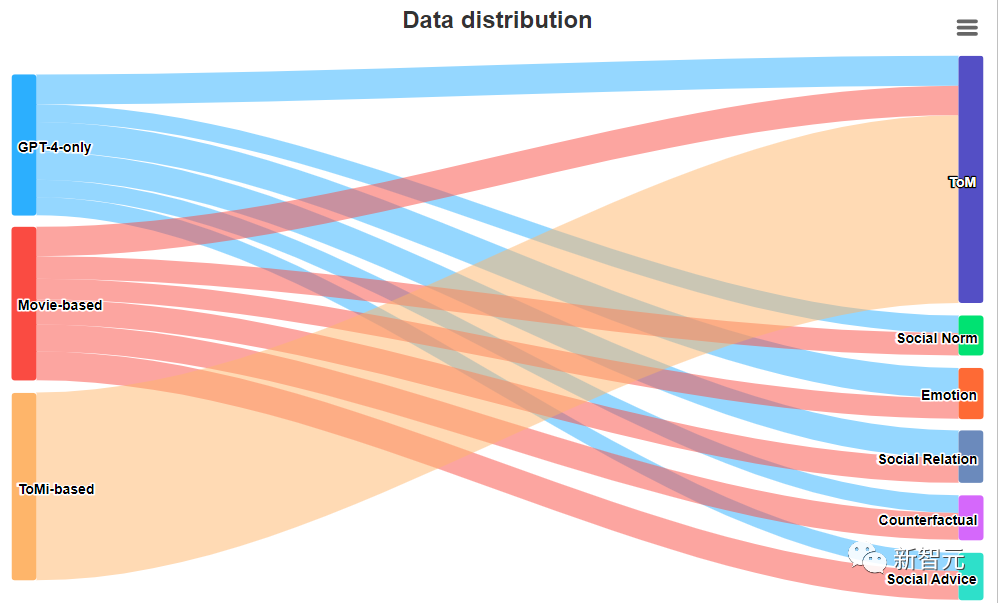

Les données d'analyse sont basées sur trois sources différentes :

Les proportions des trois sources de données sont les suivantes :

Photos

Photos

Pour chaque interaction sociale, les chercheurs poseront diverses questions pour explorer les aspects suivants étroitement liés à la compréhension sociale.

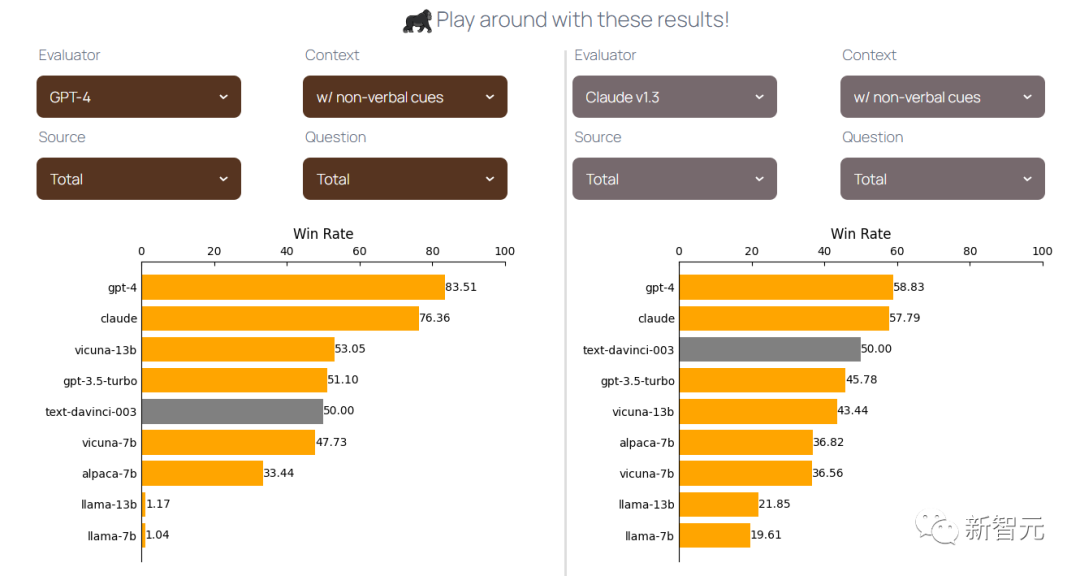

Les chercheurs ont utilisé text-davinci-003 comme référence pour évaluer différents modèles après AlpacaEval.

Dans lequel les chercheurs ont supprimé les indices non verbaux entre parenthèses du contexte (par exemple boire nerveusement du café, etc.).

Voici quelques points à retenir intéressants :

(Une explication possible est que GPT-4 est un modèle multimodal qui peut mieux comprendre des informations non verbales supplémentaires.)

Dans un article de blog, les chercheurs ont dessiné des tableaux permettant de voir clairement les performances. de chaque modèle.

Photos

Photos

Les résultats, bien qu'excitants à bien des égards, présentent également certaines limites. Premièrement, Koko Mind est relativement petit, ce qui peut limiter la large applicabilité et l'exhaustivité des conclusions des chercheurs.

Deuxièmement, toutes les interactions dans Koko Mind sont générées par GPT-4 et nécessitent une vérification manuelle, ce qui rend l'ensemble de données difficile à étendre.

De plus, bien que Koko Mind fournisse des réponses vérifiées par des humains dans l'ensemble de données, les chercheurs n'ont pas utilisé ces réponses comme référence lors de l'évaluation, et comme ces réponses ont été générées par GPT-4, elles peuvent être biaisées en faveur de GPT-4. .

Les recherches futures pourraient se concentrer sur la manière d'évaluer des modèles avec des réponses de référence générées par des machines et validées par l'homme.

Bien sûr, malgré les limites d'une sorte ou d'une autre, les chercheurs considèrent toujours Koko Mind comme un tremplin pour de futures recherches liées à l'intelligence sociale, aux modèles de langage multimodaux, etc.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

que signifie la concentration

que signifie la concentration

Tutoriel de création de tableaux de documents Word

Tutoriel de création de tableaux de documents Word

Utilisation de la suppression de base de données

Utilisation de la suppression de base de données

Comment supprimer des personnes de la liste noire sur WeChat

Comment supprimer des personnes de la liste noire sur WeChat

Comment réparer LSP

Comment réparer LSP

Qu'est-ce qu'un serveur de noms de domaine racine

Qu'est-ce qu'un serveur de noms de domaine racine

Comment utiliser la fonction fit en Python

Comment utiliser la fonction fit en Python

Solution à l'invite d'écran noir de l'ordinateur manquant avec le système d'exploitation

Solution à l'invite d'écran noir de l'ordinateur manquant avec le système d'exploitation

Les principaux dangers des virus chevaux de Troie

Les principaux dangers des virus chevaux de Troie