Concentration élevée L'urgence et la réponse rapide correspondent à deux indicateurs clés de l'optimisation des performances : Débit et Latence

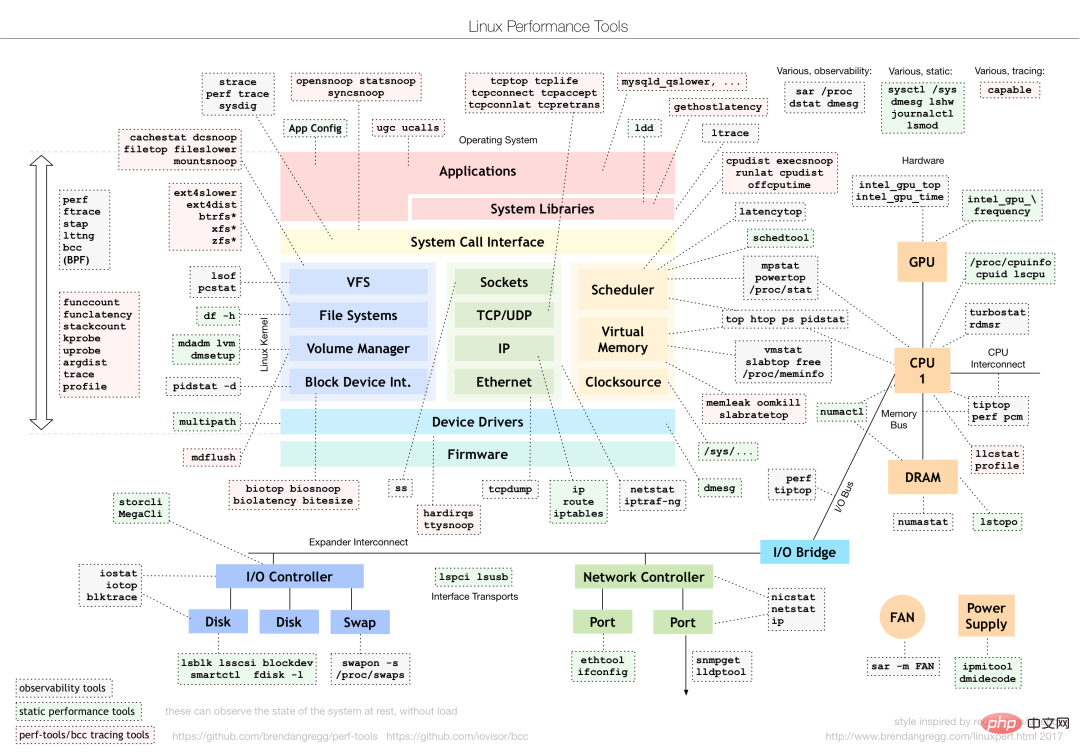

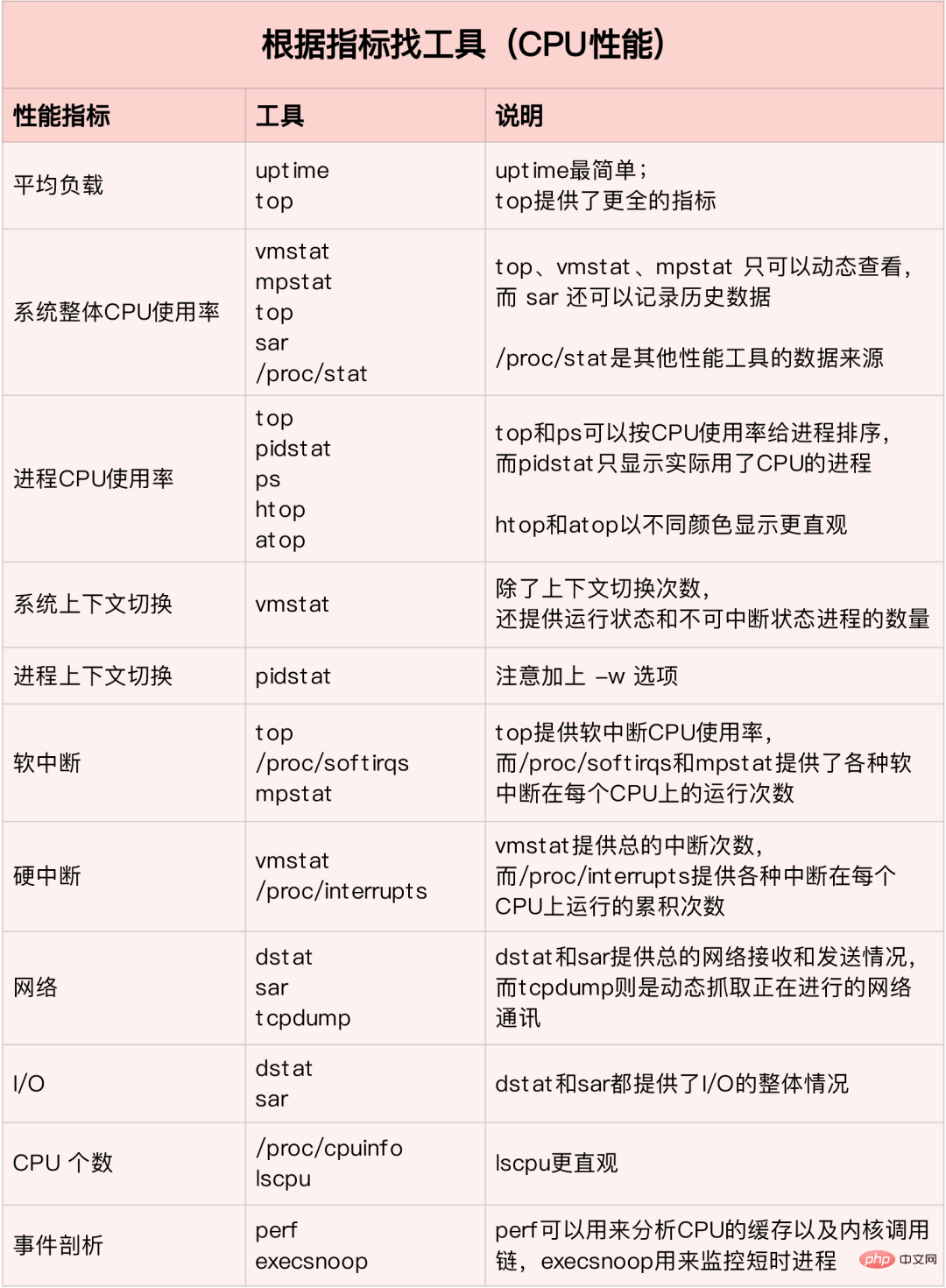

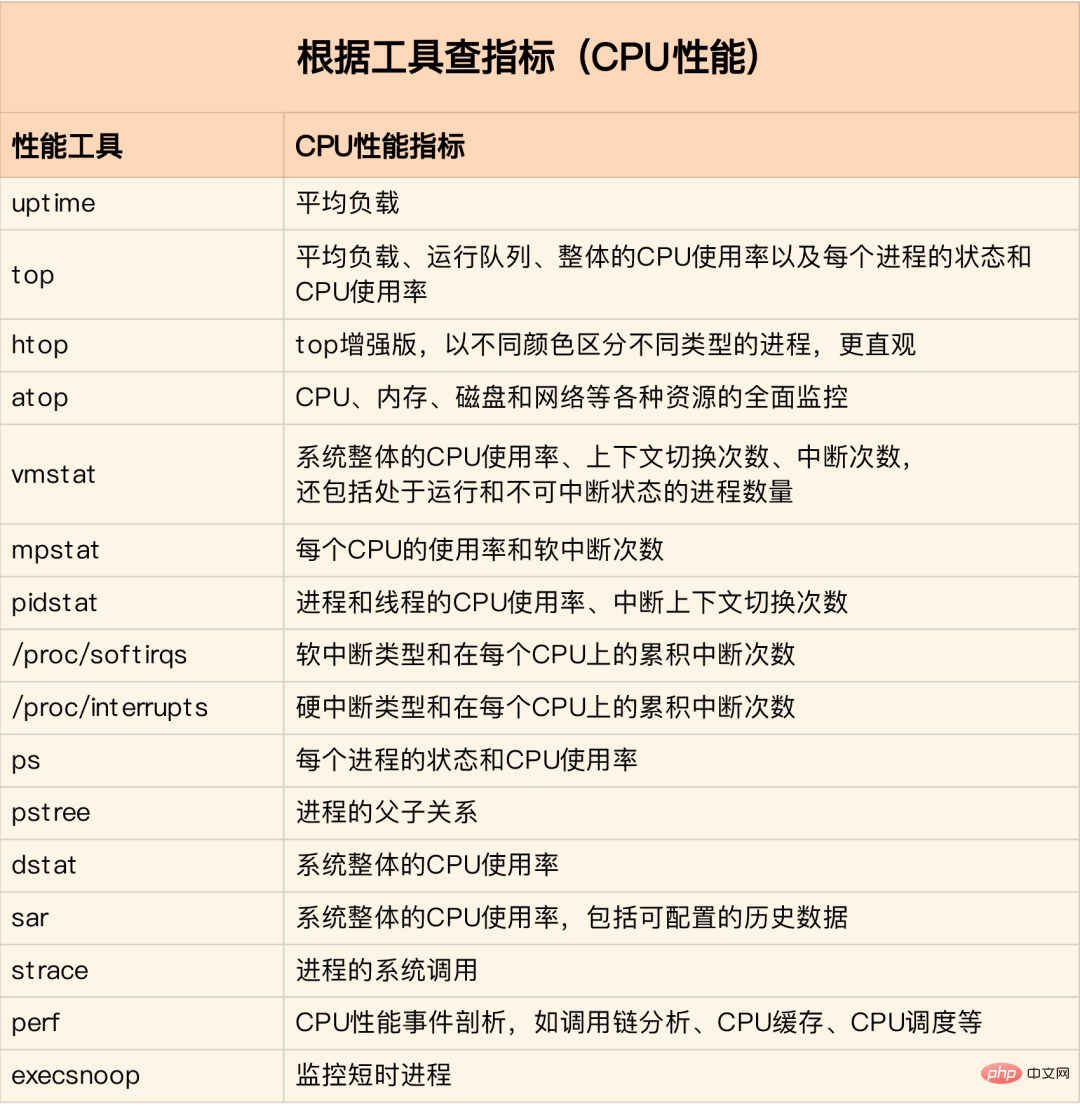

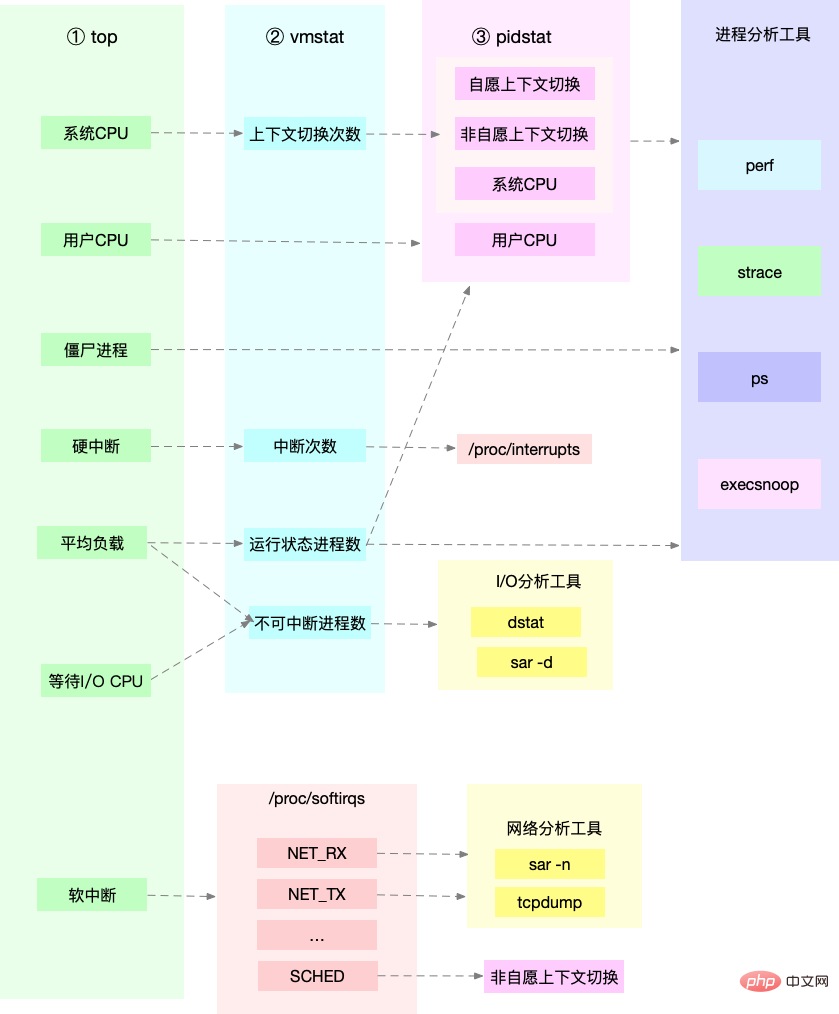

Pour différents problèmes de performances, différents outils d'analyse des performances doivent être sélectionnés. Les éléments suivants sont les outils de performances Linux couramment utilisés et les types correspondants de problèmes de performances analysés.

Charge moyenne : Le processus moyen du système dans un état exécutable et un état ininterrompu dans un nombre d'unités de temps, qui est le nombre moyen de processus actifs. Cela n’est pas directement lié à l’utilisation du processeur telle que nous l’entendons traditionnellement.

Le processus ininterruptible est un processus qui se trouve dans un processus critique dans l'état du noyau (comme la réponse d'E/S commune en attente du périphérique). L'état ininterruptible est en fait un mécanisme de protection du système pour les processus et les périphériques matériels.

Dans l'environnement de production réel, surveillez la charge moyenne du système et jugez la tendance des changements de charge en fonction des données historiques. Lorsqu’il y a une tendance évidente à la hausse de la charge, effectuez une analyse et une enquête en temps opportun. Bien sûr, vous pouvez également définir un seuil (comme lorsque la charge moyenne est supérieure à 70% du nombre de CPU)

Dans le vrai travail, on confond souvent les notions de charge moyenne et d'utilisation du CPU. les deux ne sont pas complètement équivalents :

Lorsque la charge moyenne du processeur est élevée, il se peut que le processeur soit causé par des processus intensifs ou des E/S occupées. Lors d'une analyse spécifique, vous pouvez combiner l'outil mpstat/pidstat pour vous aider à analyser la source de charge

Le changement de contexte CPU consiste à enregistrer le contexte CPU (registre CPU et PC) de la tâche précédente, puis à charger la nouvelle tâche. contexte à ces registres et au compteur de programme, et passe enfin à l'emplacement indiqué par le compteur de programme pour exécuter la nouvelle tâche. Parmi eux, le contexte enregistré sera stocké dans le noyau du système et chargé à nouveau lorsque la tâche sera reprogrammée pour exécution afin de garantir que l'état d'origine de la tâche ne soit pas affecté.

Selon le type de tâche, la commutation de contexte CPU est divisée en :

Commutation de contexte de processus Le processus ux suit Les autorisations de niveau divisent l'espace d'exécution d'un processus dans l'espace noyau et l'espace utilisateur. La transition du mode utilisateur au mode noyau doit être effectuée via des appels système.Le processus d'appel système n'implique pas de ressources en mode utilisateur de processus telles que la mémoire virtuelle, et ne change pas non plus de processus. Cela diffère du changement de contexte de processus au sens traditionnel du terme. C'est pourquoi l'appel système est souvent appelé commutateur de mode privilégié .

Les processus sont gérés et planifiés par le noyau, et le changement de contexte de processus ne peut se produire qu'en mode noyau. Par conséquent, par rapport aux appels système, avant de sauvegarder l'état du noyau et les registres du processeur du processus en cours, la mémoire virtuelle et la pile du processus doivent d'abord être enregistrées. Après avoir chargé l'état du noyau du nouveau processus, la mémoire virtuelle et la pile utilisateur du processus doivent être actualisées.

Le processus n'a besoin de changer de contexte que lorsqu'il est programmé pour s'exécuter sur le processeur. Il existe les scénarios suivants : les tranches de temps du processeur sont allouées à tour de rôle, des ressources système insuffisantes entraînent le blocage du processus, le processus se bloque activement pendant le processus. fonction de veille et processus hautement prioritaires Tranche de temps de préemption, lorsque le matériel s'interrompt, le processus sur le processeur est suspendu et exécute à la place le service d'interruption dans le noyau.

Le changement de contexte de thread est divisé en deux types :

Le changement de thread dans le même processus consomme moins de ressources, ce qui est également l'avantage du multi-thread.

Le changement de contexte d'interruption n'implique pas l'état utilisateur du processus, donc le contexte d'interruption inclut uniquement l'état nécessaire à l'exécution du programme de service d'interruption d'état du noyau (registres CPU, pile du noyau, interruption matérielle paramètres, etc).

La priorité du traitement des interruptions est supérieure à celle du processus, donc le changement de contexte d'interruption et le changement de contexte de processus ne se produiront pas en même temps

Docker+K8s+Jenkins, informations vidéo complètes sur la technologie grand public

Vous pouvez vérifier la situation globale de changement de contexte du système via vmstat

vmstat 5 #每隔5s输出一组数据 procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu----- r b swpd free buff cache si so bi bo in cs us sy id wa st 1 0 0 103388 145412 511056 0 0 18 60 1 1 2 1 96 0 0 0 0 0 103388 145412 511076 0 0 0 2 450 1176 1 1 99 0 0 0 0 0 103388 145412 511076 0 0 0 8 429 1135 1 1 98 0 0 0 0 0 103388 145412 511076 0 0 0 0 431 1132 1 1 98 0 0 0 0 0 103388 145412 511076 0 0 0 10 467 1195 1 1 98 0 0 1 0 0 103388 145412 511076 0 0 0 2 426 1139 1 0 99 0 0 4 0 0 95184 145412 511108 0 0 0 74 500 1228 4 1 94 0 0 0 0 0 103512 145416 511076 0 0 0 455 723 1573 12 3 83 2 0

Pour afficher les détails de chaque processus, vous devez utiliser pidstat pour afficher le changement de contexte de chaque processus

pidstat -w 5 14时51分16秒 UID PID cswch/s nvcswch/s Command 14时51分21秒 0 1 0.80 0.00 systemd 14时51分21秒 0 6 1.40 0.00 ksoftirqd/0 14时51分21秒 0 9 32.67 0.00 rcu_sched 14时51分21秒 0 11 0.40 0.00 watchdog/0 14时51分21秒 0 32 0.20 0.00 khugepaged 14时51分21秒 0 271 0.20 0.00 jbd2/vda1-8 14时51分21秒 0 1332 0.20 0.00 argusagent 14时51分21秒 0 5265 10.02 0.00 AliSecGuard 14时51分21秒 0 7439 7.82 0.00 kworker/0:2 14时51分21秒 0 7906 0.20 0.00 pidstat 14时51分21秒 0 8346 0.20 0.00 sshd 14时51分21秒 0 20654 9.82 0.00 AliYunDun 14时51分21秒 0 25766 0.20 0.00 kworker/u2:1 14时51分21秒 0 28603 1.00 0.00 python3

vmstat 1 1 #首先获取空闲系统的上下文切换次数 sysbench --threads=10 --max-time=300 threads run #模拟多线程切换问题 vmstat 1 1 #新终端观察上下文切换情况 此时发现cs数据明显升高,同时观察其他指标: r列: 远超系统CPU个数,说明存在大量CPU竞争 us和sy列:sy列占比80%,说明CPU主要被内核占用 in列: 中断次数明显上升,说明中断处理也是潜在问题

说明运行/等待CPU的进程过多,导致大量的上下文切换,上下文切换导致系统的CPU占用率高

pidstat -w -u 1 #查看到底哪个进程导致的问题

从结果中看出是sysbench导致CPU使用率过高,但是pidstat输出的上下文次数加起来也并不多。分析sysbench模拟的是线程的切换,因此需要在pidstat后加-t参数查看线程指标。

另外对于中断次数过多,我们可以通过/proc/interrupts文件读取

watch -d cat /proc/interrupts

发现次数变化速度最快的是重调度中断(RES),该中断用来唤醒空闲状态的CPU来调度新的任务运行。分析还是因为过多任务的调度问题,和上下文切换分析一致。

Linux作为多任务操作系统,将CPU时间划分为很短的时间片,通过调度器轮流分配给各个任务使用。为了维护CPU时间,Linux通过事先定义的节拍率,触发时间中断,并使用全局变了jiffies记录开机以来的节拍数。时间中断发生一次该值+1.

CPU使用率,除了空闲时间以外的其他时间占总CPU时间的百分比。可以通过/proc/stat中的数据来计算出CPU使用率。因为/proc/stat时开机以来的节拍数累加值,计算出来的是开机以来的平均CPU使用率,一般意义不大。可以间隔取一段时间的两次值作差来计算该段时间内的平均CPU使用率。性能分析工具给出的都是间隔一段时间的平均CPU使用率,要注意间隔时间的设置。

CPU使用率可以通过top 或 ps来查看。分析进程的CPU问题可以通过perf,它以性能事件采样为基础,不仅可以分析系统的各种事件和内核性能,还可以用来分析指定应用程序的性能问题。

perf top / perf record / perf report (-g 开启调用关系的采样)

sudo docker run --name nginx -p 10000:80 -itd feisky/nginx sudo docker run --name phpfpm -itd --network container:nginx feisky/php-fpm ab -c 10 -n 100 http://XXX.XXX.XXX.XXX:10000/ #测试Nginx服务性能

发现此时每秒可承受请求给长少,此时将测试的请求数从100增加到10000。在另外一个终端运行top查看每个CPU的使用率。发现系统中几个php-fpm进程导致CPU使用率骤升。

接着用perf来分析具体是php-fpm中哪个函数导致该问题。

perf top -g -p XXXX #对某一个php-fpm进程进行分析

发现其中sqrt和add_function占用CPU过多, 此时查看源码找到原来是sqrt中在发布前没有删除测试代码段,存在一个百万次的循环导致。将该无用代码删除后发现nginx负载能力明显提升

sudo docker run --name nginx -p 10000:80 -itd feisky/nginx:sp sudo docker run --name phpfpm -itd --network container:nginx feisky/php-fpm:sp ab -c 100 -n 1000 http://XXX.XXX.XXX.XXX:10000/ #并发100个请求测试

实验结果中每秒请求数依旧不高,我们将并发请求数降为5后,nginx负载能力依旧很低。

此时用top和pidstat发现系统CPU使用率过高,但是并没有发现CPU使用率高的进程。

出现这种情况一般时我们分析时遗漏的什么信息,重新运行top命令并观察一会。发现就绪队列中处于Running状态的进行过多,超过了我们的并发请求次数5. 再仔细查看进程运行数据,发现nginx和php-fpm都处于sleep状态,真正处于运行的却是几个stress进程。

下一步就利用pidstat分析这几个stress进程,发现没有任何输出。用ps aux交叉验证发现依旧不存在该进程。说明不是工具的问题。再top查看发现stress进程的进程号变化了,此时有可能时以下两种原因导致:

可以通过pstree来查找 stress的父进程,找出调用关系。

pstree | grep stress

发现是php-fpm调用的该子进程,此时去查看源码可以看出每个请求都会调用一个stress命令来模拟I/O压力。之前top显示的结果是CPU使用率升高,是否真的是由该stress命令导致的,还需要继续分析。代码中给每个请求加了verbose=1的参数后可以查看stress命令的输出,在中断测试该命令结果显示stress命令运行时存在因权限问题导致的文件创建失败的bug。

此时依旧只是猜测,下一步继续通过perf工具来分析。性能报告显示确实时stress占用了大量的CPU,通过修复权限问题来优化解决即可.

对于不可中断状态,一般都是在很短时间内结束,可忽略。但是如果系统或硬件发生故障,进程可能会保持不可中断状态很久,甚至系统中出现大量不可中断状态,此时需注意是否出现了I/O性能问题。

僵尸进程一般多进程应用容易遇到,父进程来不及处理子进程状态时子进程就提前退出,此时子进程就变成了僵尸进程。大量的僵尸进程会用尽PID进程号,导致新进程无法建立。

sudo docker run --privileged --name=app -itd feisky/app:iowait ps aux | grep '/app'

可以看到此时有多个app进程运行,状态分别时Ss+和D+。其中后面s表示进程是一个会话的领导进程,+号表示前台进程组。

其中进程组表示一组相互关联的进程,子进程是父进程所在组的组员。会话指共享同一个控制终端的一个或多个进程组。

用top查看系统资源发现:1)平均负载在逐渐增加,且1分钟内平均负载达到了CPU个数,说明系统可能已经有了性能瓶颈;2)僵尸进程比较多且在不停增加;3)us和sys CPU使用率都不高,iowait却比较高;4)每个进程CPU使用率也不高,但有两个进程处于D状态,可能在等待IO。

分析目前数据可知:iowait过高导致系统平均负载升高,僵尸进程不断增长说明有程序没能正确清理子进程资源。

用dstat来分析,因为它可以同时查看CPU和I/O两种资源的使用情况,便于对比分析。

dstat 1 10 #间隔1秒输出10组数据

可以看到当wai(iowait)升高时磁盘请求read都会很大,说明iowait的升高和磁盘的读请求有关。接下来分析到底时哪个进程在读磁盘。

之前top查看的处于D状态的进程号,用pidstat -d -p XXX 展示进程的I/O统计数据。发现处于D状态的进程都没有任何读写操作。在用pidstat -d 查看所有进程的I/O统计数据,看到app进程在进行磁盘读操作,每秒读取32MB的数据。进程访问磁盘必须使用系统调用处于内核态,接下来重点就是找到app进程的系统调用。

sudo strace -p XXX #对app进程调用进行跟踪

报错没有权限,因为已经时root权限了。所以遇到这种情况,首先要检查进程状态是否正常。ps命令查找该进程已经处于Z状态,即僵尸进程。

这种情况下top pidstat之类的工具无法给出更多的信息,此时像第5篇一样,用perf record -d和perf report进行分析,查看app进程调用栈。

看到app确实在通过系统调用sys_read()读取数据,并且从new_sync_read和blkdev_direct_IO看出进程时进行直接读操作,请求直接从磁盘读,没有通过缓存导致iowait升高。

通过层层分析后,root cause是app内部进行了磁盘的直接I/O。然后定位到具体代码位置进行优化即可。

Après l'optimisation ci-dessus, iowait a considérablement diminué, mais le nombre de processus zombies continue d'augmenter. Tout d'abord, localisez le processus parent du processus zombie. Utilisez pstree -aps XXX pour imprimer l'arborescence des appels du processus zombie et constatez que le processus parent est le processus d'application.

Vérifiez le code de l'application pour voir si la fin du processus enfant est gérée correctement (si wait()/waitpid() est appelé, si une fonction de traitement du signal SIGCHILD est enregistrée, etc.).

Lorsque vous rencontrez une augmentation de l'iowait, utilisez d'abord des outils tels que dstat et pidstat pour confirmer s'il y a un problème d'E/S de disque, puis découvrez quels processus sont à l'origine de l'E/S si vous ne pouvez pas utiliser strace. pour analyser directement l'appel de processus, vous pouvez utiliser l'outil perf pour l'analyser.

Pour le problème zombie, utilisez pstree pour trouver le processus parent, puis regardez le code source pour vérifier la logique de traitement pour la fin du processus enfant.

Utilisation du processeur

Changement de contexte de processus

Y compris la commutation volontaire lorsque les ressources ne peuvent pas être obtenues et la commutation involontaire lorsque le système force la planification. La commutation de contexte elle-même est une fonction essentielle pour garantir le fonctionnement normal de Linux. Une commutation excessive consommera le temps CPU du processus en cours d'exécution d'origine dans le registre. Noyau et mémoire virtuelle et autres sauvegardes et récupérations de données. De plus, parcourez les coulisses du programmeur de comptes publics Xiaole pour répondre aux « questions d'entretien » et obtenez un coffret cadeau surprise.

Taux de réussite du cache CPU

Réutilisation du cache CPU, plus le taux de réussite est élevé, meilleures sont les performances Parmi eux, L1/L2 est couramment utilisé en monocœur et L3 est utilisé en multi. -core

"Outils de performances" pid après avoir jugé la charge, les statistiques vérifient chacun. Processeurs et utilisation du processeur par processus. Découvrez les processus provoquant une charge moyenne plus élevéeTrouvez le bon outil en fonction de différents indicateurs de performance :

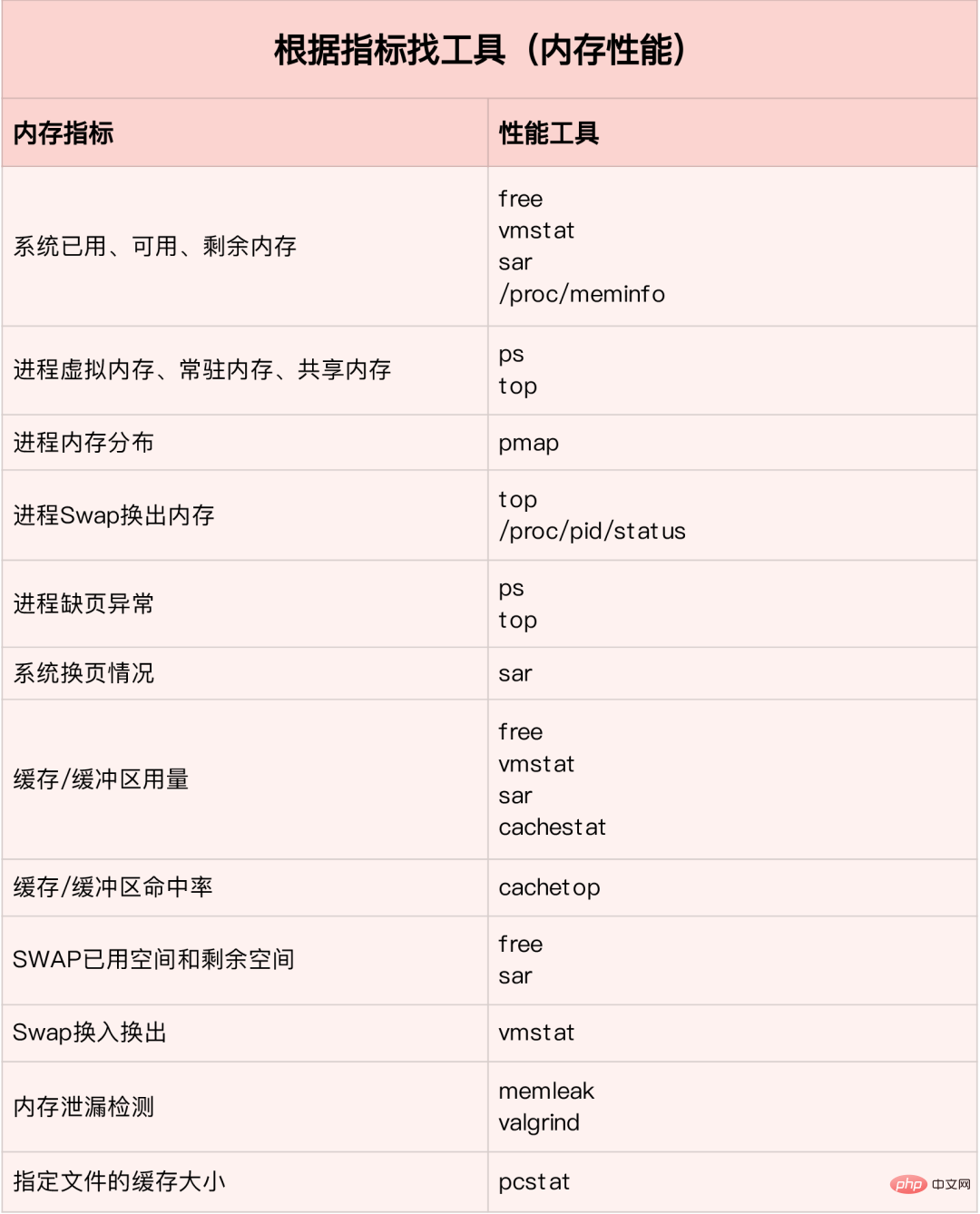

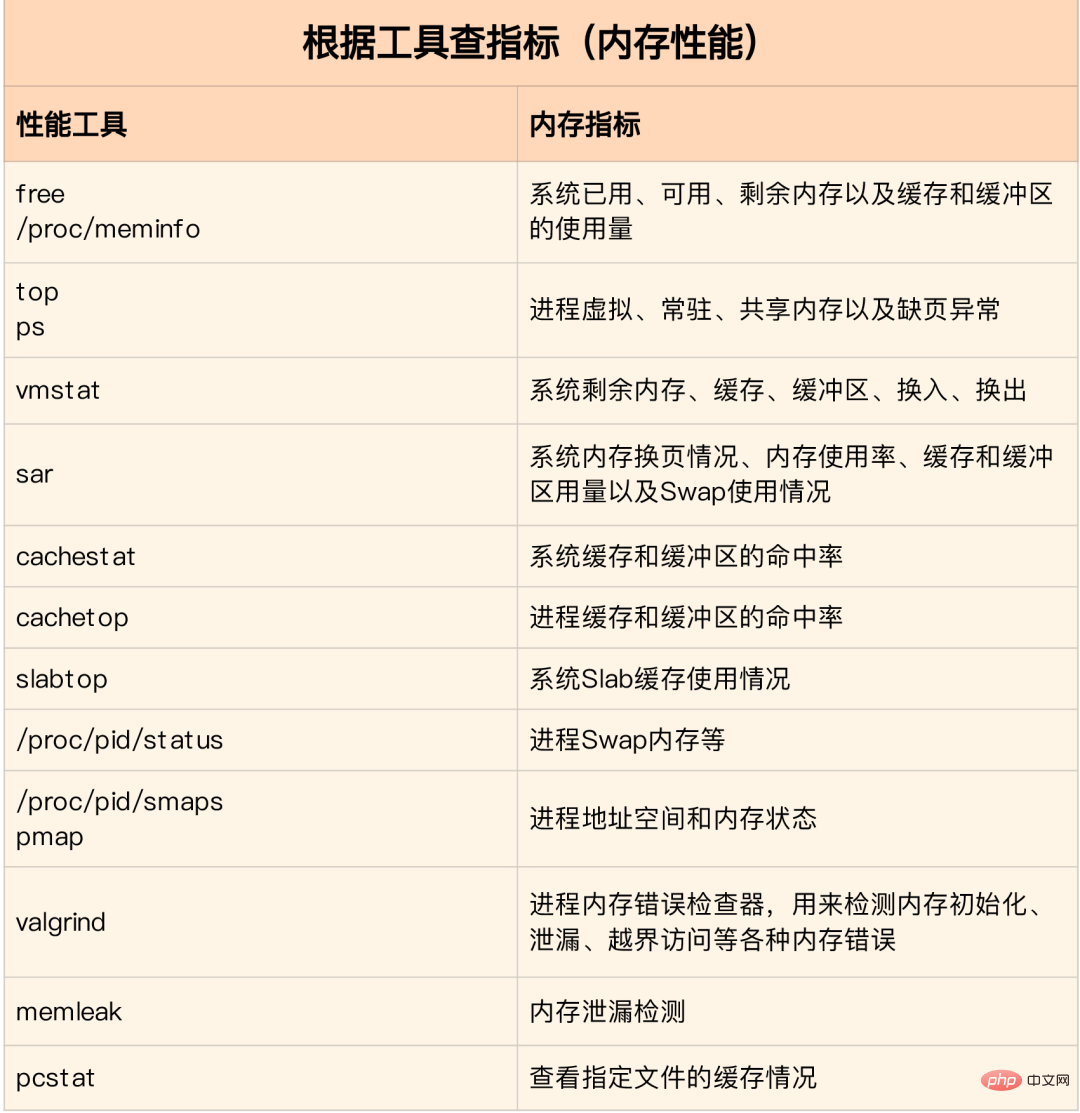

Dans un environnement de production, les développeurs n'ont souvent pas l'autorisation d'installer de nouveaux packages d'outils et ne peuvent que maximiser l'utilisation des outils déjà installés dans le système. Par conséquent, il est nécessaire de comprendre ce que certains indicateurs analysent. les outils peuvent fournir.

Exécutez d'abord plusieurs outils qui prennent en charge plus d'indicateurs, tels que top/vmstat/pidstat. En fonction de leur sortie, vous pouvez déterminer de quel type de problème de performances il s'agit. Après avoir localisé le processus, utilisez strace/perf pour analyser la situation d'appel pour une analyse plus approfondie. Si elle est causée par une interruption logicielle, utilisez /proc/softirqs

.

Optimisation des applications

TPS, La différence et compréhension du QPS et du débit du système

QPS(TPS)

Nombre de concurrences

Temps de réponse

QPS(TPS)=Nombre de concurrences/temps de réponse moyen

Serveur de requêtes utilisateur

Traitement interne du serveur

Le serveur le renvoie au client

Le QPS est similaire au TPS, mais une visite sur une page forme un TPS, mais une requête de page peut inclure plusieurs requêtes au serveur, qui peut être compté Entrez plusieurs QPS

Taux de requêtes QPS (Queries Per Second) par seconde, le nombre de requêtes auxquelles un serveur peut répondre par seconde.

TPS (Transactions Per Second), les résultats des tests logiciels

Débit du système, comprenant plusieurs paramètres importants :

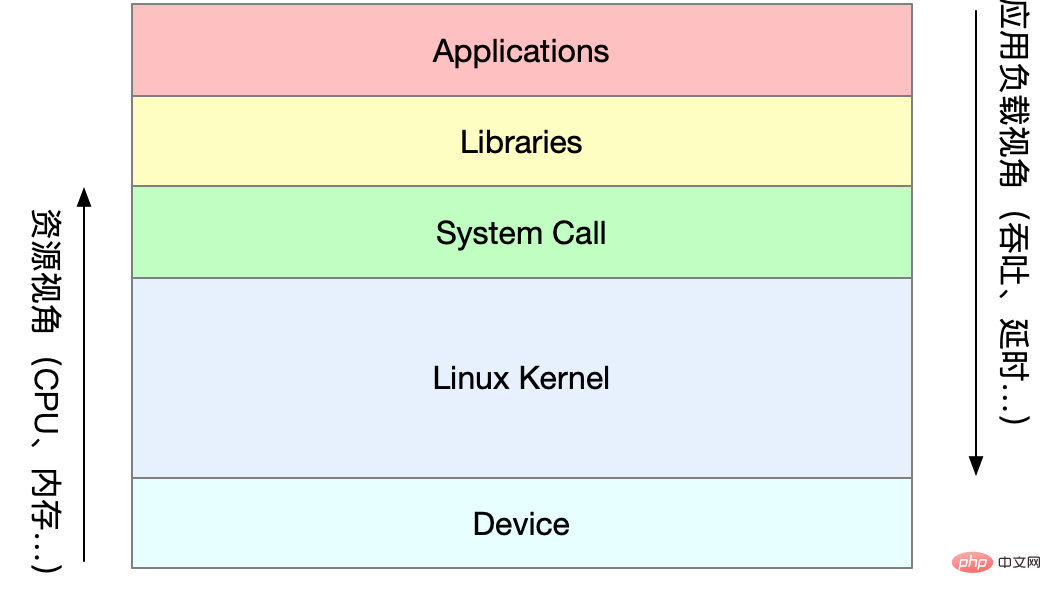

Seul le noyau le peut. accéder directement à la mémoire physique. Le noyau Linux fournit un espace d'adressage virtuel indépendant pour chaque processus, et cet espace d'adressage est continu. De cette manière, le processus peut facilement accéder à la mémoire (mémoire virtuelle).

L'intérieur de l'espace d'adressage virtuel est divisé en deux parties : l'espace noyau et l'espace utilisateur. La plage de l'espace d'adressage des processeurs avec différentes longueurs de mots est différente. L'espace du noyau système 32 bits occupe 1G et l'espace utilisateur occupe 3G. L'espace noyau et l'espace utilisateur des systèmes 64 bits sont tous deux de 128T, occupant respectivement les parties les plus hautes et les plus basses de l'espace mémoire, et la partie médiane n'est pas définie.

Toute la mémoire virtuelle ne se verra pas attribuer de mémoire physique, seule celle réellement utilisée. La mémoire physique allouée est gérée via le mappage de mémoire. Afin de compléter le mappage de la mémoire, le noyau maintient une table de pages pour chaque processus afin d'enregistrer la relation de mappage entre les adresses virtuelles et les adresses physiques. La table des pages est en fait stockée dans l'unité de gestion de mémoire du processeur MMU, et le processeur peut directement connaître la mémoire accessible via le matériel.

Lorsque l'adresse virtuelle à laquelle le processus accède est introuvable dans la table des pages, le système génère une exception de défaut de page, entre dans l'espace du noyau pour allouer de la mémoire physique, met à jour la table des pages du processus, puis retourne dans l'espace utilisateur. pour reprendre le fonctionnement du procédé.

MMU gère la mémoire en unités de pages, avec une taille de page de 4 Ko. Afin de résoudre le problème du trop grand nombre d'entrées dans la table de pages, Linux fournit les mécanismes de Table de pages multi-niveaux et HugePage.

La mémoire de l'espace utilisateur est divisée en cinq segments de mémoire différents de bas en haut :

malloc correspond à l'appel système :

Le cache du premier peut réduire l'apparition d'exceptions de faute de page et améliorer l'efficacité de l'accès à la mémoire. Cependant, comme la mémoire n'est pas restituée au système, des allocations/libérations fréquentes de mémoire entraîneront une fragmentation de la mémoire lorsque la mémoire est occupée.

Ce dernier est directement renvoyé au système une fois libéré, donc une exception de défaut de page se produira à chaque fois que mmap se produira. Lorsque le travail de mémoire est occupé, des allocations de mémoire fréquentes entraîneront un grand nombre d'exceptions de fautes de page, augmentant ainsi la charge de gestion du noyau.

Les deux appels ci-dessus n'attribuent pas réellement de mémoire. Ces mémoires n'entrent dans le noyau que via des exceptions de faute de page lorsqu'elles sont accédées pour la première fois et sont allouées par le noyau

.Lorsque la mémoire est limitée, le système récupère la mémoire des manières suivantes :

Cache de recyclage : l'algorithme LRU récupère les pages de mémoire les moins récemment utilisées

; Recyclage est peu fréquent Accès à la mémoire : écrivez la mémoire rarement utilisée sur le disque via la partition d'échange

Tuez le processus : mécanisme de protection du noyau OOM (plus le processus consomme de mémoire, plus le oom_score est grand et plus le CPU est important qu'il occupe, plus le oom_score est petit. Vous pouvez passer /proc ajuster manuellement oom_adj)

.echo -16 > /proc/$(pidof XXX)/oom_adj

free来查看整个系统的内存使用情况

top/ps来查看某个进程的内存使用情况

buffer est un cache de données de disque, le cache est un cache de données de fichiers, ils sont utilisés à la fois dans les demandes de lecture et dans les demandes d'écriture

Taux de réussite du cache fait référence au nombre de requêtes pour obtenir des données directement via le cache, représentant le pourcentage de toutes les requêtes. Plus le taux de réussite est élevé, plus les avantages apportés par le cache sont importants et meilleures sont les performances de l'application.

Après avoir installé le package bcc, vous pouvez surveiller les accès en lecture et en écriture du cache via cachestat et cachetop.

安装pcstat后可以查看文件在内存中的缓存大小以及缓存比例

#首先安装Go export GOPATH=~/go export PATH=~/go/bin:$PATH go get golang.org/x/sys/unix go ge github.com/tobert/pcstat/pcstat

dd if=/dev/sda1 of=file bs=1M count=512 #生产一个512MB的临时文件 echo 3 > /proc/sys/vm/drop_caches #清理缓存 pcstat file #确定刚才生成文件不在系统缓存中,此时cached和percent都是0 cachetop 5 dd if=file of=/dev/null bs=1M #测试文件读取速度 #此时文件读取性能为30+MB/s,查看cachetop结果发现并不是所有的读都落在磁盘上,读缓存命中率只有50%。 dd if=file of=/dev/null bs=1M #重复上述读文件测试 #此时文件读取性能为4+GB/s,读缓存命中率为100% pcstat file #查看文件file的缓存情况,100%全部缓存

cachetop 5 sudo docker run --privileged --name=app -itd feisky/app:io-direct sudo docker logs app #确认案例启动成功 #实验结果表明每读32MB数据都要花0.9s,且cachetop输出中显示1024次缓存全部命中

但是凭感觉可知如果缓存命中读速度不应如此慢,读次数时1024,页大小为4K,五秒的时间内读取了1024*4KB数据,即每秒0.8MB,和结果中32MB相差较大。说明该案例没有充分利用缓存,怀疑系统调用设置了直接I/O标志绕过系统缓存。因此接下来观察系统调用.

strace -p $(pgrep app) #strace 结果可以看到openat打开磁盘分区/dev/sdb1,传入参数为O_RDONLY|O_DIRECT

这就解释了为什么读32MB数据那么慢,直接从磁盘读写肯定远远慢于缓存。找出问题后我们再看案例的源代码发现flags中指定了直接IO标志。删除该选项后重跑,验证性能变化。

Pour les applications, l'allocation et le recyclage dynamiques de la mémoire sont un module fonctionnel logique central et complexe. Divers « accidents » se produiront dans le processus de gestion de la mémoire :

La répartition de la mémoire virtuelle de bas en haut est segment en lecture seule, segment de données, tas, segment de mappage de mémoire et pile cinq parties. Parmi eux, ceux qui peuvent provoquer des fuites de mémoire sont :

Les fuites de mémoire sont plus nocives. Ces mémoires oubliées ne sont pas seulement utilisées par. applications Ils ne peuvent pas y accéder eux-mêmes et le système ne peut pas les attribuer à nouveau à d'autres applications. Les fuites de mémoire s'accumulent et même épuisent la mémoire du système

Pré-installer systat, docker, bcc

.sudo docker run --name=app -itd feisky/app:mem-leak sudo docker logs app vmstat 3

可以看到free在不断下降,buffer和cache基本保持不变。说明系统的内存一致在升高。但并不能说明存在内存泄漏。此时可以通过memleak工具来跟踪系统或进程的内存分配/释放请求。另外,搜索公众号Linux就该这样学后台回复“git书籍”,获取一份惊喜礼包。

/usr/share/bcc/tools/memleak -a -p $(pidof app)

从memleak输出可以看到,应用在不停地分配内存,并且这些分配的地址并没有被回收。通过调用栈看到是fibonacci函数分配的内存没有释放。定位到源码后查看源码来修复增加内存释放函数即可.

系统内存资源紧张时通过内存回收和OOM杀死进程来解决。其中可回收内存包括:

L'essence de l'échange est d'utiliser un morceau d'espace disque ou un fichier local comme mémoire, y compris deux processus d'échange et d'échange :

Comment Linux mesure-t-il si les ressources mémoire sont limitées ?

Récupération directe de la mémoire Nouvelle allocation de mémoire de gros blocs demandée, mais mémoire restante insuffisante. A ce moment, le système récupérera une partie de la mémoire

kswapd0 Le thread du noyau récupère régulièrement de la mémoire. Afin de mesurer l'utilisation de la mémoire, trois seuils de pages_min, pages_low et pages_high sont définis et des opérations de recyclage de mémoire sont effectuées en fonction de ceux-ci.

Mémoire restante < pages_min, la mémoire disponible pour le processus est épuisée, seul le noyau peut allouer de la mémoire

pages_min < est élevé, kswapd0 effectue le recyclage de la mémoire jusqu'à ce que la mémoire restante > pages_high

pages_low < mémoire restante <

剩余内存 > pages_high,说明剩余内存较多,无内存压力

pages_low = pages_min 5 / 4 pages_high = pages_min 3 / 2

很多情况下系统剩余内存较多,但SWAP依旧升高,这是由于处理器的NUMA架构。

在NUMA架构下多个处理器划分到不同的Node,每个Node都拥有自己的本地内存空间。在分析内存的使用时应该针对每个Node单独分析

numactl --hardware #查看处理器在Node的分布情况,以及每个Node的内存使用情况

内存三个阈值可以通过/proc/zoneinfo来查看,该文件中还包括活跃和非活跃的匿名页/文件页数。

Lorsqu'un nœud manque de mémoire, le système peut rechercher des ressources libres auprès d'autres nœuds ou récupérer de la mémoire dans la mémoire locale. Ajustez via /proc/sys/vm/zone_raclaim_mode.

Pendant le processus de recyclage lui-même, Linux ajuste l'activité d'utilisation de Swap en fonction de l'option /proc/sys/vm/swapiness, de 0 à 100. Plus la valeur est grande, plus activement. Swap est utilisé, c'est-à-dire que plus il est enclin à utiliser Swap pour recycler des pages anonymes ; plus la valeur est petite, plus Swap est utilisé passivement, c'est-à-dire plus il est probable qu'il recycle les pages de fichiers.

注意:这只是调整Swap积极程度的权重,即使设置为0,当剩余内存+文件页小于页高阈值时,还是会发生Swap。

free #首先通过free查看swap使用情况,若swap=0表示未配置Swap #先创建并开启swap fallocate -l 8G /mnt/swapfile chmod 600 /mnt/swapfile mkswap /mnt/swapfile swapon /mnt/swapfile free #再次执行free确保Swap配置成功 dd if=/dev/sda1 of=/dev/null bs=1G count=2048 #模拟大文件读取 sar -r -S 1 #查看内存各个指标变化 -r内存 -S swap #根据结果可以看出,%memused在不断增长,剩余内存kbmemfress不断减少,缓冲区kbbuffers不断增大,由此可知剩余内存不断分配给了缓冲区 #一段时间之后,剩余内存很小,而缓冲区占用了大部分内存。此时Swap使用之间增大,缓冲区和剩余内存只在小范围波动 停下sar命令 cachetop5 #观察缓存 #可以看到dd进程读写只有50%的命中率,未命中数为4w+页,说明正式dd进程导致缓冲区使用升高 watch -d grep -A 15 ‘Normal’ /proc/zoneinfo #观察内存指标变化 #发现升级内存在一个小范围不停的波动,低于页低阈值时会突然增大到一个大于页高阈值的值

说明剩余内存和缓冲区的波动变化正是由于内存回收和缓存再次分配的循环往复。有时候Swap用的多,有时候缓冲区波动更多。此时查看swappiness值为60,是一个相对中和的配置,系统会根据实际运行情况来选去合适的回收类型.

Indicateurs de mémoire système

Mémoire utilisée/mémoire restante : fichier de lecture du disque Le cache des pages , la partie récupérable dans l'allocateur de dalleTrouvez le bon outil en fonction de différents indicateurs de performances :

indicateurs de performance inclus dans l'outil d'analyse de la mémoire:

Exécutez généralement en premier plusieurs outils de performances avec une couverture relativement large, tels que free, top, vmstat, pidstat, etc.

Idées d'optimisation courantes :

La commande vmstat est la plus courante L'outil de surveillance Linux/Unix peut afficher la valeur d'état du serveur à un intervalle de temps donné, y compris l'utilisation du processeur du serveur , l'utilisation de la mémoire, l'état d'échange de mémoire virtuelle et l'état de lecture et d'écriture des E/S.可以看到整个机器的CPU,内存,IO的使用情况,而不是单单看到各个进程的CPU使用率和内存使用率(使用场景不一样)。

vmstat 2 procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu----- r b swpd free buff cache si so bi bo in cs us sy id wa st 1 0 0 1379064 282244 11537528 0 0 3 104 0 0 3 0 97 0 0 0 0 0 1372716 282244 11537544 0 0 0 24 4893 8947 1 0 98 0 0 0 0 0 1373404 282248 11537544 0 0 0 96 5105 9278 2 0 98 0 0 0 0 0 1374168 282248 11537556 0 0 0 0 5001 9208 1 0 99 0 0 0 0 0 1376948 282248 11537564 0 0 0 80 5176 9388 2 0 98 0 0 0 0 0 1379356 282256 11537580 0 0 0 202 5474 9519 2 0 98 0 0 1 0 0 1368376 282256 11543696 0 0 0 0 5894 8940 12 0 88 0 0 1 0 0 1371936 282256 11539240 0 0 0 10554 6176 9481 14 1 85 1 0 1 0 0 1366184 282260 11542292 0 0 0 7456 6102 9983 7 1 91 0 0 1 0 0 1353040 282260 11556176 0 0 0 16924 7233 9578 18 1 80 1 0 0 0 0 1359432 282260 11549124 0 0 0 12576 5495 9271 7 0 92 1 0 0 0 0 1361744 282264 11549132 0 0 0 58 8606 15079 4 2 95 0 0 1 0 0 1367120 282264 11549140 0 0 0 2 5716 9205 8 0 92 0 0 0 0 0 1346580 282264 11562644 0 0 0 70 6416 9944 12 0 88 0 0 0 0 0 1359164 282264 11550108 0 0 0 2922 4941 8969 3 0 97 0 0 1 0 0 1353992 282264 11557044 0 0 0 0 6023 8917 15 0 84 0 0 # 结果说明 - r 表示运行队列(就是说多少个进程真的分配到CPU),我测试的服务器目前CPU比较空闲,没什么程序在跑,当这个值超过了CPU数目,就会出现CPU瓶颈了。这个也和top的负载有关系,一般负载超过了3就比较高,超过了5就高,超过了10就不正常了,服务器的状态很危险。top的负载类似每秒的运行队列。如果运行队列过大,表示你的CPU很繁忙,一般会造成CPU使用率很高。 - b 表示阻塞的进程,这个不多说,进程阻塞,大家懂的。 - swpd 虚拟内存已使用的大小,如果大于0,表示你的机器物理内存不足了,如果不是程序内存泄露的原因,那么你该升级内存了或者把耗内存的任务迁移到其他机器。 - free 空闲的物理内存的大小,我的机器内存总共8G,剩余3415M。 - buff Linux/Unix系统是用来存储,目录里面有什么内容,权限等的缓存,我本机大概占用300多M - cache cache直接用来记忆我们打开的文件,给文件做缓冲,我本机大概占用300多M(这里是Linux/Unix的聪明之处,把空闲的物理内存的一部分拿来做文件和目录的缓存,是为了提高 程序执行的性能,当程序使用内存时,buffer/cached会很快地被使用。) - si 每秒从磁盘读入虚拟内存的大小,如果这个值大于0,表示物理内存不够用或者内存泄露了,要查找耗内存进程解决掉。我的机器内存充裕,一切正常。 - so 每秒虚拟内存写入磁盘的大小,如果这个值大于0,同上。 - bi 块设备每秒接收的块数量,这里的块设备是指系统上所有的磁盘和其他块设备,默认块大小是1024byte,我本机上没什么IO操作,所以一直是0,但是我曾在处理拷贝大量数据(2-3T)的机器上看过可以达到140000/s,磁盘写入速度差不多140M每秒 - bo 块设备每秒发送的块数量,例如我们读取文件,bo就要大于0。bi和bo一般都要接近0,不然就是IO过于频繁,需要调整。 - in 每秒CPU的中断次数,包括时间中断 - cs 每秒上下文切换次数,例如我们调用系统函数,就要进行上下文切换,线程的切换,也要进程上下文切换,这个值要越小越好,太大了,要考虑调低线程或者进程的数目,例如在apache和nginx这种web服务器中,我们一般做性能测试时会进行几千并发甚至几万并发的测试,选择web服务器的进程可以由进程或者线程的峰值一直下调,压测,直到cs到一个比较小的值,这个进程和线程数就是比较合适的值了。系统调用也是,每次调用系统函数,我们的代码就会进入内核空间,导致上下文切换,这个是很耗资源,也要尽量避免频繁调用系统函数。上下文切换次数过多表示你的CPU大部分浪费在上下文切换,导致CPU干正经事的时间少了,CPU没有充分利用,是不可取的。 - us 用户CPU时间,我曾经在一个做加密解密很频繁的服务器上,可以看到us接近100,r运行队列达到80(机器在做压力测试,性能表现不佳)。 - sy 系统CPU时间,如果太高,表示系统调用时间长,例如是IO操作频繁。 - id 空闲CPU时间,一般来说,id + us + sy = 100,一般我认为id是空闲CPU使用率,us是用户CPU使用率,sy是系统CPU使用率。 - wt 等待IO CPU时间

pidstat主要用于监控全部或指定进程占用系统资源的情况,如CPU,内存、设备IO、任务切换、线程等。

使用方法:

Comptez l'utilisation des E/S

1.pidstat -d 1 10 03:02:02 PM UID PID kB_rd/s kB_wr/s kB_ccwr/s Command 03:02:03 PM 0 816 0.00 918.81 0.00 jbd2/vda1-8 03:02:03 PM 0 1007 0.00 3.96 0.00 AliYunDun 03:02:03 PM 997 7326 0.00 1904.95 918.81 java 03:02:03 PM 997 8539 0.00 3.96 0.00 java 03:02:03 PM 0 16066 0.00 35.64 0.00 cmagent 03:02:03 PM UID PID kB_rd/s kB_wr/s kB_ccwr/s Command 03:02:04 PM 0 816 0.00 1924.00 0.00 jbd2/vda1-8 03:02:04 PM 997 7326 0.00 11156.00 1888.00 java 03:02:04 PM 997 8539 0.00 4.00 0.00 java

2、统计CPU使用情况

# 统计CPU pidstat -u 1 10 03:03:33 PM UID PID %usr %system %guest %CPU CPU Command 03:03:34 PM 0 2321 3.96 0.00 0.00 3.96 0 ansible 03:03:34 PM 0 7110 0.00 0.99 0.00 0.99 4 pidstat 03:03:34 PM 997 8539 0.99 0.00 0.00 0.99 5 java 03:03:34 PM 984 15517 0.99 0.00 0.00 0.99 5 java 03:03:34 PM 0 24406 0.99 0.00 0.00 0.99 5 java 03:03:34 PM 0 32158 3.96 0.00 0.00 3.96 2 ansible

3. Statistiques d'utilisation de la mémoire

# 统计内存 pidstat -r 1 10 Average: UID PID minflt/s majflt/s VSZ RSS %MEM Command Average: 0 1 0.20 0.00 191256 3064 0.01 systemd Average: 0 1007 1.30 0.00 143256 22720 0.07 AliYunDun Average: 0 6642 0.10 0.00 6301904 107680 0.33 java Average: 997 7326 10.89 0.00 13468904 8395848 26.04 java Average: 0 7795 348.15 0.00 108376 1233 0.00 pidstat Average: 997 8539 0.50 0.00 8242256 2062228 6.40 java Average: 987 9518 0.20 0.00 6300944 1242924 3.85 java Average: 0 10280 3.70 0.00 807372 8344 0.03 aliyun-service Average: 984 15517 0.40 0.00 6386464 1464572 4.54 java Average: 0 16066 236.46 0.00 2678332 71020 0.22 cmagent Average: 995 20955 0.30 0.00 6312520 1408040 4.37 java Average: 995 20956 0.20 0.00 6093764 1505028 4.67 java Average: 0 23936 0.10 0.00 5302416 110804 0.34 java Average: 0 24406 0.70 0.00 10211672 2361304 7.32 java Average: 0 26870 1.40 0.00 1470212 36084 0.11 promtail

4、查看具体进程使用情况

pidstat -T ALL -r -p 20955 1 10 03:12:16 PM UID PID minflt/s majflt/s VSZ RSS %MEM Command 03:12:17 PM 995 20955 0.00 0.00 6312520 1408040 4.37 java 03:12:16 PM UID PID minflt-nr majflt-nr Command 03:12:17 PM 995 20955 0 0 java

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!