développement back-end

développement back-end

tutoriel php

tutoriel php

Meilleures pratiques et partage d'expériences dans le développement de reptiles PHP

Meilleures pratiques et partage d'expériences dans le développement de reptiles PHP

Meilleures pratiques et partage d'expériences dans le développement de reptiles PHP

Bonnes pratiques et partage d'expériences dans le développement de robots PHP

Cet article partagera les meilleures pratiques et expériences dans le développement de robots PHP, ainsi que quelques exemples de code. Un robot d'exploration est un programme automatisé utilisé pour extraire des informations utiles des pages Web. Dans le processus de développement actuel, nous devons réfléchir à la manière de réaliser une exploration efficace et d'éviter d'être bloqué par le site Web. Certaines considérations importantes seront partagées ci-dessous.

1. Définissez raisonnablement l'intervalle de requête du robot

Lors du développement d'un robot, nous devons définir l'intervalle de requête de manière raisonnable. Car envoyer des requêtes trop fréquemment peut amener le serveur à bloquer notre adresse IP et même à faire pression sur le site Web cible. De manière générale, envoyer 2 à 3 requêtes par seconde est un choix plus sûr. Vous pouvez utiliser la fonction sleep() pour implémenter des délais entre les requêtes.

sleep(1); // 设置请求间隔为1秒

2. Utilisez un en-tête User-Agent aléatoire

En définissant l'en-tête User-Agent, nous pouvons simuler l'envoi de requêtes par le navigateur pour éviter d'être reconnu comme un robot par le site Web cible. Dans chaque requête, nous pouvons choisir un en-tête User-Agent différent pour augmenter la diversité des requêtes.

$userAgents = [

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/93.0.4577.82 Safari/537.36',

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/94.0.4606.71 Safari/537.36',

'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/95.0.4638.54 Safari/537.36',

];

$randomUserAgent = $userAgents[array_rand($userAgents)];

$headers = [

'User-Agent: ' . $randomUserAgent,

];3. Gérer les mécanismes anti-exploration des sites Web

Afin d'éviter d'être explorés, de nombreux sites Web adopteront certains mécanismes anti-exploration, tels que des codes de vérification, des interdictions d'adresse IP, etc. Avant l'exploration, nous pouvons d'abord vérifier s'il existe des informations anti-exploration pertinentes dans la page Web. Si tel est le cas, nous devons écrire le code correspondant pour le traitement.

4. Utilisez la bibliothèque HTTP appropriée

En PHP, il existe une variété de bibliothèques HTTP parmi lesquelles choisir, telles que cURL, Guzzle, etc. Nous pouvons choisir la bibliothèque appropriée pour envoyer des requêtes HTTP et traiter les réponses en fonction de nos besoins.

// 使用cURL库发送HTTP请求 $ch = curl_init(); curl_setopt($ch, CURLOPT_URL, 'https://www.example.com'); curl_setopt($ch, CURLOPT_RETURNTRANSFER, true); $response = curl_exec($ch); curl_close($ch);

5. Utilisation raisonnable du cache

L'exploration des données est une tâche fastidieuse. Afin d'améliorer l'efficacité, vous pouvez utiliser le cache pour enregistrer les données explorées et éviter les demandes répétées. Nous pouvons utiliser des outils de mise en cache tels que Redis et Memcached, ou enregistrer des données dans des fichiers.

// 使用Redis缓存已经爬取的数据

$redis = new Redis();

$redis->connect('127.0.0.1', 6379);

$response = $redis->get('https://www.example.com');

if (!$response) {

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, 'https://www.example.com');

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

$response = curl_exec($ch);

curl_close($ch);

$redis->set('https://www.example.com', $response);

}

echo $response;6. Gestion des exceptions et des erreurs

Dans le développement de robots d'exploration, nous devons gérer diverses exceptions et erreurs, telles que l'expiration du délai de connexion réseau, les erreurs de requête HTTP, etc. Vous pouvez utiliser des instructions try-catch pour intercepter les exceptions et les gérer en conséquence.

try {

// 发送HTTP请求

// ...

} catch (Exception $e) {

echo 'Error: ' . $e->getMessage();

}7. Utilisez DOM pour analyser le HTML

Pour les robots qui ont besoin d'extraire des données du HTML, vous pouvez utiliser l'extension DOM de PHP pour analyser le HTML et localiser rapidement et précisément les données requises.

$dom = new DOMDocument();

$dom->loadHTML($response);

$xpath = new DOMXpath($dom);

$elements = $xpath->query('//div[@class="example"]');

foreach ($elements as $element) {

echo $element->nodeValue;

}Résumé :

Dans le développement de robots d'exploration PHP, nous devons définir l'intervalle de requête de manière raisonnable, utiliser des en-têtes User-Agent aléatoires, gérer le mécanisme anti-exploration du site Web, choisir la bibliothèque HTTP appropriée, utiliser le cache de manière raisonnable et gérer les exceptions et erreurs et utilisez DOM pour analyser le HTML. Ces bonnes pratiques et expériences peuvent nous aider à développer des robots d'exploration efficaces et fiables. Bien sûr, il existe d’autres astuces et techniques à explorer et à essayer, et j’espère que cet article vous a été inspirant et utile.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

Guide d'installation et de mise à niveau de PHP 8.4 pour Ubuntu et Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 apporte plusieurs nouvelles fonctionnalités, améliorations de sécurité et de performances avec une bonne quantité de dépréciations et de suppressions de fonctionnalités. Ce guide explique comment installer PHP 8.4 ou mettre à niveau vers PHP 8.4 sur Ubuntu, Debian ou leurs dérivés. Bien qu'il soit possible de compiler PHP à partir des sources, son installation à partir d'un référentiel APT comme expliqué ci-dessous est souvent plus rapide et plus sécurisée car ces référentiels fourniront les dernières corrections de bogues et mises à jour de sécurité à l'avenir.

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Date et heure de CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler avec la date et l'heure dans cakephp4, nous allons utiliser la classe FrozenTime disponible.

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

Discuter de CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP est un framework open source pour PHP. Il vise à faciliter grandement le développement, le déploiement et la maintenance d'applications. CakePHP est basé sur une architecture de type MVC à la fois puissante et facile à appréhender. Modèles, vues et contrôleurs gu

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Téléchargement de fichiers CakePHP

Sep 10, 2024 pm 05:27 PM

Pour travailler sur le téléchargement de fichiers, nous allons utiliser l'assistant de formulaire. Voici un exemple de téléchargement de fichiers.

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

CakePHP créant des validateurs

Sep 10, 2024 pm 05:26 PM

Le validateur peut être créé en ajoutant les deux lignes suivantes dans le contrôleur.

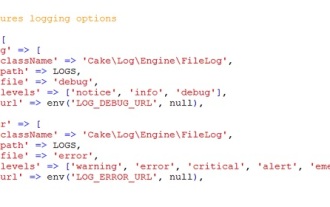

Journalisation CakePHP

Sep 10, 2024 pm 05:26 PM

Journalisation CakePHP

Sep 10, 2024 pm 05:26 PM

Se connecter à CakePHP est une tâche très simple. Il vous suffit d'utiliser une seule fonction. Vous pouvez enregistrer les erreurs, les exceptions, les activités des utilisateurs, les actions entreprises par les utilisateurs, pour tout processus en arrière-plan comme cronjob. La journalisation des données dans CakePHP est facile. La fonction log() est fournie

Comment configurer Visual Studio Code (VS Code) pour le développement PHP

Dec 20, 2024 am 11:31 AM

Comment configurer Visual Studio Code (VS Code) pour le développement PHP

Dec 20, 2024 am 11:31 AM

Visual Studio Code, également connu sous le nom de VS Code, est un éditeur de code source gratuit – ou environnement de développement intégré (IDE) – disponible pour tous les principaux systèmes d'exploitation. Avec une large collection d'extensions pour de nombreux langages de programmation, VS Code peut être c

Guide rapide CakePHP

Sep 10, 2024 pm 05:27 PM

Guide rapide CakePHP

Sep 10, 2024 pm 05:27 PM

CakePHP est un framework MVC open source. Cela facilite grandement le développement, le déploiement et la maintenance des applications. CakePHP dispose d'un certain nombre de bibliothèques pour réduire la surcharge des tâches les plus courantes.