Périphériques technologiques

Périphériques technologiques

IA

IA

La légende des statistiques C.R. Rao est décédé. Il a été témoin de l'histoire centenaire des statistiques.

La légende des statistiques C.R. Rao est décédé. Il a été témoin de l'histoire centenaire des statistiques.

La légende des statistiques C.R. Rao est décédé. Il a été témoin de l'histoire centenaire des statistiques.

Le légendaire maître des statistiques C. R. Rao est décédé à l'âge de 102 ans

Tous ceux qui ont étudié les statistiques connaîtront son nom -

L'inégalité Cramér-Rao porte son nom et celui de Harald Cramér

Une phrase qu'il a écrite sur la page de titre de « Statistiques et vérité » est largement diffusé dans le monde chinois :

En dernière analyse, toute connaissance est histoire

Au sens abstrait, toute science est mathématique ;

Dans un monde rationnel, tous les jugements sont statistiques.

De 1920 à 2023, la vie du professeur Rao a été presque synchronisée avec toute l'histoire du développement des statistiques modernes

En 2021, un article publié dans la "International Statistical Review" a évalué sa vie comme "statistiques" Un siècle d'apprentissage ”

Sa carrière est étroitement liée à l'histoire des statistiques modernes, couvrant le développement de l'ère de Pearson et Fisher à l'ère du big data et de l'intelligence artificielle

Statisticien légendaire

Rao M. est né en Inde en Septembre 1920

Sa carrière dans les statistiques débute dans les années 1940 : il obtient d'abord une maîtrise en mathématiques de l'Université d'Andhra et une maîtrise en statistiques de l'Université de Calcutta en 1943, puis part à Cambridge, en Angleterre, pour étudier un doctorat à King's. Collège, Université, sous la tutelle de Ronald Fisher, l'un des fondateurs de la statistique moderne. Au début, Rao avait déjà fait preuve d'un talent extraordinaire

En 1943, il réussit sa thèse de maîtrise en statistiques à l'Université de Calcutta avec un score de 87%. Ce record n'a pas encore été battu par l'Université de Calcutta. Le critique a également évalué cet article comme "niveau doctorat"

En 1945, Rao, qui n'avait que 25 ans à l'époque, a publié un article statistique important "Achievable Accuracy in Information and Statistical Parameter Estimation"

Dans ce 10- page papier, Rao a prouvé l'

inégalité de Cramér-Raoet le théorème de Rao-Blackwell. Ces deux éléments constituent des éléments importants de la méthodologie statistique moderne. L'inégalité de Cramér-Rao fournit une limite inférieure de l'erreur pour une estimation non biaisée des paramètres, fournissant une référence pour les performances de l'estimateur. La variance de tout estimateur ne peut pas être inférieure à cette limite inférieure

Le théorème de Rao-Blackwell décrit comment transformer une estimation approximative arbitraire en une estimation optimisée par le critère d'erreur quadratique moyenne ou des critères similaires. L'idée principale est d'utiliser les informations efficaces contenues dans les données pour l'estimation. Par rapport à l'utilisation directe de toutes les données, l'effet est meilleur

Cet article pose également le cadre de la théorie de la géométrie de l'information. La géométrie de l'information est largement utilisée dans la recherche actuelle sur l'intelligence artificielle et a également été utilisée pour la mesure du boson de Higgs dans le Grand collisionneur de hadrons

Plus précisément :

Rao a introduit les distributions de probabilité dans l'espace des paramètres Le concept de distance ou de divergence entre.- Considérez la famille paramétrée comme une variété riemannienne et la matrice d'information de Fisher comme un tenseur métrique riemannien.

- Proposition d'utiliser la distance de Fisher-Rao pour mesurer la différence entre deux distributions de probabilité.

- Cet article est l'un des premiers travaux à appliquer les méthodes de géométrie différentielle aux modèles probabilistes.

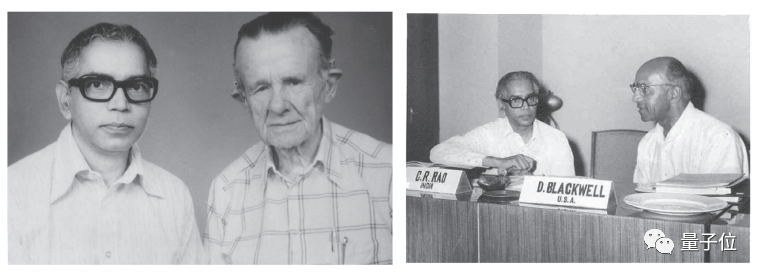

Le contenu qui doit être réécrit est : la photo de Rao avec Cramér et Blackwell

Le contenu qui doit être réécrit est : la photo de Rao avec Cramér et Blackwell

En 1946, Rao part à Cambridge et devient un disciple de Fisher. En 1948, sous la direction de Fisher, il propose le fameux «

Score Test(Score Test) ».

Le test de score est l'une des trois principales méthodes de test d'hypothèses statistiques, qui évalue les contraintes des paramètres statistiques en fonction du gradient de la fonction de vraisemblance. Par rapport au test de Wald et au test du rapport de vraisemblance, son principal avantage réside dans la commodité du calcul

Pour les statisticiens d'aujourd'hui, le test de score peut être considéré comme une connaissance statistique de base essentielle

C'est cette année, 102 ans Le professeur Rao a remporté le Prix international de statistique, la plus haute distinction en statistique.

La raison de ce prix est la suivante : Son travail il y a plus de 70 ans a toujours un impact profond sur la communauté scientifique.

Son article de 1945, publié dans le Bulletin de la Calcutta Mathematical Society, démontrait trois résultats fondamentaux qui ont ouvert la voie aux statistiques modernes et fourni des outils statistiques largement utilisés dans la communauté scientifique aujourd'hui.Il est à noter qu'il a formé plus de 50 médecins au cours de sa vie. Parmi eux se trouvent Dabeeru C. Rao, directeur du département de biostatistique de la faculté de médecine de l'Université de Washington, membre de l'American Statistical Association, et la statisticienne indienne Debabrata Basu. Ils étaient tous ses étudiants. n'a pas complètement pris sa retraite. Il était professeur émérite à l'Université d'État de Pennsylvanie et professeur de recherche à l'Université de Buffalo

One More Thing

À l'âge de 100 ans, C. R. Rao a apporté de légères modifications à la célèbre phrase mentionnée au début

Quand. Les médias indiens l'ont cité comme disant, la dernière phrase est devenue : "Toutes les méthodes d'acquisition de connaissances sont essentiellement des statistiques."

Toutes les méthodes d'acquisition de connaissances peuvent essentiellement être résumées comme des statistiques

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Outils d'IA chauds

Undresser.AI Undress

Application basée sur l'IA pour créer des photos de nu réalistes

AI Clothes Remover

Outil d'IA en ligne pour supprimer les vêtements des photos.

Undress AI Tool

Images de déshabillage gratuites

Clothoff.io

Dissolvant de vêtements AI

AI Hentai Generator

Générez AI Hentai gratuitement.

Article chaud

Outils chauds

Bloc-notes++7.3.1

Éditeur de code facile à utiliser et gratuit

SublimeText3 version chinoise

Version chinoise, très simple à utiliser

Envoyer Studio 13.0.1

Puissant environnement de développement intégré PHP

Dreamweaver CS6

Outils de développement Web visuel

SublimeText3 version Mac

Logiciel d'édition de code au niveau de Dieu (SublimeText3)

Qu'est-ce que l'algorithme EM en Python ?

Jun 05, 2023 am 08:51 AM

Qu'est-ce que l'algorithme EM en Python ?

Jun 05, 2023 am 08:51 AM

L'algorithme EM en Python est une méthode itérative basée sur l'estimation du maximum de vraisemblance, couramment utilisée pour les problèmes d'estimation de paramètres dans l'apprentissage non supervisé. Cet article présentera la définition, les principes de base, les scénarios d'application et l'implémentation Python de l'algorithme EM. 1. Définition de l'algorithme EM L'algorithme EM est l'abréviation de Expectation-maximizationAlgorithm. Il s'agit d'un algorithme itératif conçu pour résoudre l'estimation du maximum de vraisemblance compte tenu des données observées. Dans l’algorithme EM, il faut

La légende des statistiques C.R. Rao est décédé. Il a été témoin de l'histoire centenaire des statistiques.

Sep 11, 2023 pm 01:05 PM

La légende des statistiques C.R. Rao est décédé. Il a été témoin de l'histoire centenaire des statistiques.

Sep 11, 2023 pm 01:05 PM

Le légendaire maître des statistiques C.R. Rao est décédé à l'âge de 102 ans. Tous ceux qui ont étudié les statistiques connaissent son nom - l'inégalité Cramér-Rao porte son nom et celui d'Harald Cramér pour son travail dans "Statistiques et vérité". La phrase écrite sur la page de titre est largement diffusée dans le monde chinois : En dernière analyse, toute connaissance est histoire au sens abstrait, toute science est mathématique dans le monde rationnel, tout jugement est statistique ; De 1920 à 2023, la vie du professeur Rao a été presque synchronisée avec toute l'histoire du développement des statistiques modernes. En 2021, un article publié dans la « Revue statistique internationale » a évalué sa vie comme « un siècle de carrière et d'aujourd'hui ».

Démonstration de la règle 68-95-99.7 dans les statistiques à l'aide de Python

Sep 05, 2023 pm 01:33 PM

Démonstration de la règle 68-95-99.7 dans les statistiques à l'aide de Python

Sep 05, 2023 pm 01:33 PM

Les statistiques nous fournissent des outils puissants pour analyser et comprendre les données. L’un des concepts de base des statistiques est la règle 68-95-99,7, également connue sous le nom de règle empirique ou règle des trois sigma. Cette règle nous permet de faire des déductions importantes sur la distribution des données en fonction de leur écart type. Dans cet article de blog, nous explorerons la règle 68-95-99.7 et montrerons comment l'appliquer à l'aide de Python. Présentation de la règle 68-95-99,7 La règle 68-95-99,7 permet d'estimer le pourcentage de données dans une distribution normale qui se situe dans un certain écart type par rapport à la moyenne. Selon cette règle, environ 68 % des données se situent dans un écart type de la moyenne. Environ 95 % des données se situent à moins de deux écarts types de la moyenne. À propos

Explication détaillée de l'algorithme EM en Python

Jun 09, 2023 pm 10:25 PM

Explication détaillée de l'algorithme EM en Python

Jun 09, 2023 pm 10:25 PM

L'algorithme EM est un algorithme couramment utilisé dans l'apprentissage statistique et est largement utilisé dans divers domaines. En tant qu'excellent langage de programmation, Python présente de grands avantages dans la mise en œuvre de l'algorithme EM. Cet article présentera en détail l'algorithme EM en Python. Tout d’abord, nous devons comprendre ce qu’est l’algorithme EM. Le nom complet de l'algorithme EM est Expectation-MaximizationAlgorithm. Il s'agit d'un algorithme itératif souvent utilisé pour résoudre l'estimation de paramètres contenant des variables cachées ou des données manquantes.

Algorithmes de régression couramment utilisés et leurs caractéristiques dans les applications d'apprentissage automatique

Nov 29, 2023 pm 05:29 PM

Algorithmes de régression couramment utilisés et leurs caractéristiques dans les applications d'apprentissage automatique

Nov 29, 2023 pm 05:29 PM

La régression est l'un des outils les plus puissants en statistique. Les algorithmes d'apprentissage supervisé d'apprentissage automatique sont divisés en deux types : les algorithmes de classification et les algorithmes de régression. Les algorithmes de régression sont utilisés pour la prédiction de distribution continue et peuvent prédire des données continues plutôt que de simples étiquettes de catégories discrètes. L'analyse de régression est largement utilisée dans le domaine de l'apprentissage automatique, comme la prévision des ventes de produits, du flux de trafic, des prix des logements et des conditions météorologiques. L'algorithme de régression est un algorithme d'apprentissage automatique couramment utilisé pour établir la relation entre la variable indépendante X et. la variable dépendante Y. Du point de vue de l'apprentissage automatique, il est utilisé pour créer un modèle d'algorithme (fonction) afin d'obtenir la relation de mappage entre l'attribut X et l'étiquette Y. Au cours du processus d'apprentissage, l'algorithme essaie de trouver la meilleure relation de paramètres afin que le degré d'ajustement soit le meilleur. Dans l'algorithme de régression, le résultat final de l'algorithme (fonction) est un continu.

Conseils pour l'analyse des écarts en Python

Jun 10, 2023 pm 02:15 PM

Conseils pour l'analyse des écarts en Python

Jun 10, 2023 pm 02:15 PM

Python est l'un des langages de programmation les plus populaires aujourd'hui et un langage largement utilisé dans le domaine de la science des données et de l'analyse statistique. En analyse statistique, l'analyse de la variance est une technique très courante qui peut être utilisée pour étudier l'impact de différents facteurs sur les variables. Cet article explique comment utiliser Python pour effectuer une analyse de variance. Qu'est-ce que l'analyse de variance ? L'analyse de variance (ANOVA) est une méthode d'analyse statistique utilisée pour analyser les différences entre des variables continues sur une ou plusieurs variables catégorielles. il

L'apprentissage automatique peut-il vraiment produire des décisions intelligentes ?

May 17, 2023 am 08:16 AM

L'apprentissage automatique peut-il vraiment produire des décisions intelligentes ?

May 17, 2023 am 08:16 AM

Après trois ans, nous avons achevé en 2022 le chef-d'œuvre "" de Judea Pearl, lauréate du Turing Award, professeur d'informatique à l'Université de Californie à Los Angeles, académicien de la National Academy of Sciences, et connu comme le "Père de Réseaux bayésiens" Causalité : modèles, raisonnement et inférence. La première édition originale de ce livre a été rédigée en 2000. Elle a créé de nouvelles idées et méthodes d'analyse causale et d'inférence. Elle a reçu de nombreux éloges dès sa publication et a favorisé de nouveaux développements dans les domaines de la science des données, de l'intelligence artificielle et de l'apprentissage automatique. , l’analyse causale et d’autres domaines, qui ont eu un grand impact sur le monde universitaire. Plus tard, la deuxième édition a été révisée en 2009 et le contenu a été considérablement modifié en fonction des nouveaux développements de la recherche causale à cette époque. La version originale anglaise du livre que nous traduisons actuellement a été publiée en 2009. Jusqu'à présent, elle a

Le producteur de 'Black Mirror' utilise l'IA pour écrire des scripts et les résultats ressemblent à de la merde Auteur de 'Arrival': L'IA n'est pour le moment que des statistiques appliquées

Jun 07, 2023 pm 01:21 PM

Le producteur de 'Black Mirror' utilise l'IA pour écrire des scripts et les résultats ressemblent à de la merde Auteur de 'Arrival': L'IA n'est pour le moment que des statistiques appliquées

Jun 07, 2023 pm 01:21 PM

Le producteur de "Black Mirror" a utilisé l'IA pour écrire des scripts, et le résultat était comme de la merde. Auteur de "Arrival": L'IA n'est qu'une statistique appliquée pour le moment Charlie Bullock Time Network News La popularité de ChatGPT cette année a rendu l'intelligence artificielle (IA) ) remplacer les humains dans l'écriture de scripts, un sujet brûlant Sujet : Récemment, le producteur de "Black Mirror", Charlie Bullock, a déclaré aux médias étrangers qu'il avait déjà utilisé ChatGPT pour écrire un épisode du script "Black Mirror", et que le résultat était "comme de la merde". De plus, Jiang Fengnan, l'auteur original de "Arrival", a également déclaré que le ChatGPT actuel n'est que des statistiques appliquées et non du tout une intelligence artificielle. Charlie Bullock a entré les mots « générer un script Black Mirror » dans ChatGPT, puis le soi-disant script sera généré. Bullock a déclaré : « Cela semble raisonnable à première vue, mais au deuxième coup d'œil, c'est une merde. est-ce que c'est

Le contenu qui doit être réécrit est : la photo de Rao avec Cramér et Blackwell

Le contenu qui doit être réécrit est : la photo de Rao avec Cramér et Blackwell